Was ist der Faltungskern?

Der Faltungskern ist ein mathematisches Werkzeug in einem Faltungs-Neuronalen Netzwerk. Es handelt sich um eine kleine Matrix, die zur Durchführung von Faltungsoperationen an Eingabedaten verwendet wird. Faltungs-Neuronale Netze extrahieren Merkmale aus Eingabedaten durch Faltungskerne. Durch Anpassen der Parameter des Faltungskerns kann das Netzwerk nach und nach abstraktere und erweiterte Funktionen erlernen. Die Größe und Form des Faltungskerns kann entsprechend den Eigenschaften der Aufgabe und den Eingabedaten angepasst werden. Der Faltungskern wird normalerweise automatisch vom neuronalen Netzwerk gelernt, kann aber auch manuell entworfen und angepasst werden.

Wie bestimmt man den Faltungskern?

Die Bestimmung des Faltungskerns wird normalerweise durch das Training neuronaler Netze erreicht. Während des Trainingsprozesses passt das Netzwerk automatisch die Gewichte und Verzerrungen des Faltungskerns an, sodass das Netzwerk Merkmale der Eingabedaten besser extrahieren und klassifizieren kann. Durch die Überwachung der Leistungsindikatoren des Netzwerks, wie z. B. Genauigkeit und Verlustfunktionswerte, kann die Wirkung des Faltungskerns bewertet und nach Bedarf angepasst werden. Dieser automatische Anpassungsmechanismus ermöglicht es dem neuronalen Netzwerk, sich an verschiedene Aufgaben und Datensätze anzupassen und dadurch die Leistung und Generalisierungsfähigkeit des Modells zu verbessern.

Neben dem Training des neuronalen Netzwerks kann die Bestimmung des Faltungskerns auch manuell entworfen und angepasst werden. In diesem Fall müssen Größe und Form des Faltungskerns basierend auf der spezifischen Aufgabe und den Dateneigenschaften ausgewählt werden. Im Allgemeinen können kleinere Faltungskerne feinkörnigere Merkmale extrahieren, zum Extrahieren von Merkmalen auf hoher Ebene sind jedoch mehr Faltungsschichten erforderlich. Im Gegenteil, größere Faltungskerne können High-Level-Features schneller extrahieren, allerdings auf Kosten bestimmter Detailinformationen. Daher erfordert die Wahl der Größe des Faltungskerns einen Kompromiss zwischen der Komplexität der Aufgabe und den Eigenschaften der Daten. Für Bilderkennungsaufgaben können beispielsweise kleinere Faltungskerne subtile Textur- und Formmerkmale im Bild erfassen, während größere Faltungskerne die Form und Kontur des gesamten Objekts schneller identifizieren können. Daher ist es beim Entwurf eines Faltungs-Neuronalen Netzwerks erforderlich, eine geeignete Faltungskerngröße basierend auf bestimmten Aufgaben und Dateneigenschaften auszuwählen, um die effektivsten Merkmale zu extrahieren.

Größe des Faltungskerns

Die Größe des Faltungskerns wird entsprechend der Aufgabe und den Dateneigenschaften angepasst. In Faltungs-Neuronalen Netzen bezieht sich die Größe des Faltungskerns im Allgemeinen auf die Breite und Höhe. Die Größe des Faltungskerns ist sowohl für die Netzwerkleistung als auch für die Recheneffizienz wichtig. Kleinere Faltungskerne können feinkörnige Merkmale extrahieren, zum Extrahieren von Merkmalen auf hoher Ebene sind jedoch mehr Faltungsschichten erforderlich. Größere Faltungskerne können Merkmale auf hoher Ebene schneller extrahieren, es gehen jedoch einige detaillierte Informationen verloren. Daher erfordert die Wahl der Faltungskerngröße einen Kompromiss zwischen Aufgaben- und Dateneigenschaften.

Die Beziehung zwischen der Anzahl der Faltungskerne und der Anzahl der Eingabe- und Ausgabekanäle

Im Faltungs-Neuronalen Netzwerk kann die Anzahl der Ausgabedatenkanäle C_out der Faltungsschicht durch die folgende Formel ausgedrückt werden: C_out = C_in * K

C_out=K

Volume Die Produktoperation muss sicherstellen, dass die Eingabedaten und die Anzahl der Kanäle des Faltungskerns übereinstimmen, dh C_in und K sind gleich oder C_in ist ein ganzzahliges Vielfaches von K. Dies liegt daran, dass die Faltungsoperation für jeden Kanal separat ausgeführt wird und jeder Faltungskern nur die Daten eines Kanals verarbeiten kann. Wenn die Anzahl der Kanäle der Eingabedaten nicht mit der Anzahl der Faltungskerne übereinstimmt, muss die Anzahl der Kanäle angepasst werden. Dies kann durch Hinzufügen einer entsprechenden Anzahl erweiterter Faltungskerne oder durch Anpassen der Anzahl der Kanäle erreicht werden. Dadurch wird sichergestellt, dass jeder Kanal die korrekten Faltungsberechnungsergebnisse erhalten kann.

In der Faltungsschicht besteht jeder Faltungskern aus einem Satz lernbarer Gewichtsparameter und einem Bias-Parameter, die zur Durchführung von Faltungsberechnungen an den Eingabedaten verwendet werden. Die Anzahl und Größe der Faltungskerne wirkt sich auf das Empfangsfeld und die Merkmalsextraktionsfähigkeiten der Faltungsschicht aus. Daher können wir entsprechend den Anforderungen spezifischer Aufgaben die Anzahl und Größe der Faltungskerne entwerfen und anpassen, um die Leistung des Modells zu verbessern.

Das Verhältnis zwischen der Anzahl der Faltungskerne und der Anzahl der Eingabe- und Ausgabekanäle muss entsprechend der Netzwerkstruktur und den Aufgabenanforderungen angepasst werden, sie müssen jedoch übereinstimmen.

Woher kommen die Parameter im Faltungskern?

Die Parameter im Faltungskern werden durch das Training neuronaler Netze erhalten. Während des Trainings des neuronalen Netzwerks lernt das neuronale Netzwerk automatisch die Parameter innerhalb des Faltungskerns und passt sie an, sodass das Netzwerk die Merkmale der Eingabedaten besser extrahieren und klassifizieren kann. Insbesondere passt das neuronale Netzwerk die Gewichte und Bias innerhalb des Faltungskerns basierend auf dem Fehler zwischen den Eingabedaten und den Zielausgabedaten an, um den Fehler zu minimieren. Dieser Prozess wird normalerweise mithilfe des Backpropagation-Algorithmus implementiert.

In einem Faltungs-Neuronalen Netzwerk umfassen die Parameter innerhalb des Faltungskerns Gewichte und Verzerrungen. Das Gewicht wird verwendet, um das Ausgabeergebnis der Faltungsoperation zu berechnen, und die Vorspannung wird verwendet, um den Offset des Ausgabeergebnisses anzupassen. Während des Trainingsprozesses passt das neuronale Netzwerk diese Parameter automatisch an, um Fehler zu minimieren und die Leistung des Netzwerks zu verbessern. Im Allgemeinen gilt: Je mehr Parameter im Faltungskern vorhanden sind, desto stärker ist die Ausdrucksfähigkeit des Netzwerks, aber es bringt auch einen höheren Rechen- und Speicheraufwand mit sich. Daher müssen die Parameter innerhalb des Faltungskerns basierend auf spezifischen Aufgaben und Dateneigenschaften gewichtet und ausgewählt werden.

Sind Faltungskerne und Filter das gleiche Konzept?

Faltungskerne und Filter können bis zu einem gewissen Grad als ähnliche Konzepte angesehen werden, sie beziehen sich jedoch speziell auf unterschiedliche Operationen und Anwendungen.

Der Faltungskern ist eine Matrix für Faltungsoperationen, die normalerweise in Faltungsschichten in Faltungs-Neuronalen Netzen verwendet wird. Bei der Faltungsoperation beginnt der Faltungskern in der oberen linken Ecke der Eingabedaten, gleitet in einer bestimmten Schrittgröße und Richtung und führt an jeder Position Faltungsberechnungen für die Daten durch, um schließlich die Ausgabedaten zu erhalten. Faltungskerne können verwendet werden, um verschiedene Merkmale der Eingabedaten zu extrahieren, wie z. B. Kanten, Textur usw.

Filter bezieht sich normalerweise auf den Filter in der digitalen Signalverarbeitung, der zum Filtern von Signalen verwendet wird. Filter können Signale nach Frequenzeigenschaften filtern. Beispielsweise kann ein Tiefpassfilter Hochfrequenzsignale entfernen, ein Hochpassfilter kann Niederfrequenzsignale entfernen und ein Bandpassfilter kann Signale innerhalb eines bestimmten Frequenzbereichs zurückhalten . Filter können auf Audio-, Bild-, Video- und andere Signalverarbeitungsbereiche angewendet werden.

Kurz gesagt, Faltungskerne und Filter beinhalten beide Matrixoperationen und Merkmalsextraktion, aber ihr Anwendungsbereich und ihre spezifischen Implementierungsmethoden sind unterschiedlich.

Das obige ist der detaillierte Inhalt vonWas ist der Faltungskern?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1677

1677

14

14

1431

1431

52

52

1334

1334

25

25

1280

1280

29

29

1257

1257

24

24

Entdecken Sie die Konzepte, Unterschiede, Vor- und Nachteile von RNN, LSTM und GRU

Jan 22, 2024 pm 07:51 PM

Entdecken Sie die Konzepte, Unterschiede, Vor- und Nachteile von RNN, LSTM und GRU

Jan 22, 2024 pm 07:51 PM

In Zeitreihendaten gibt es Abhängigkeiten zwischen Beobachtungen, sie sind also nicht unabhängig voneinander. Herkömmliche neuronale Netze behandeln jedoch jede Beobachtung als unabhängig, was die Fähigkeit des Modells zur Modellierung von Zeitreihendaten einschränkt. Um dieses Problem zu lösen, wurde das Recurrent Neural Network (RNN) eingeführt, das das Konzept des Speichers einführte, um die dynamischen Eigenschaften von Zeitreihendaten zu erfassen, indem Abhängigkeiten zwischen Datenpunkten im Netzwerk hergestellt werden. Durch wiederkehrende Verbindungen kann RNN frühere Informationen an die aktuelle Beobachtung weitergeben, um zukünftige Werte besser vorherzusagen. Dies macht RNN zu einem leistungsstarken Werkzeug für Aufgaben mit Zeitreihendaten. Aber wie erreicht RNN diese Art von Gedächtnis? RNN realisiert das Gedächtnis durch die Rückkopplungsschleife im neuronalen Netzwerk. Dies ist der Unterschied zwischen RNN und herkömmlichen neuronalen Netzwerken.

Berechnung von Gleitkommaoperanden (FLOPS) für neuronale Netze

Jan 22, 2024 pm 07:21 PM

Berechnung von Gleitkommaoperanden (FLOPS) für neuronale Netze

Jan 22, 2024 pm 07:21 PM

FLOPS ist einer der Standards zur Bewertung der Computerleistung und dient zur Messung der Anzahl der Gleitkommaoperationen pro Sekunde. In neuronalen Netzen wird FLOPS häufig verwendet, um die Rechenkomplexität des Modells und die Nutzung von Rechenressourcen zu bewerten. Es ist ein wichtiger Indikator zur Messung der Rechenleistung und Effizienz eines Computers. Ein neuronales Netzwerk ist ein komplexes Modell, das aus mehreren Neuronenschichten besteht und für Aufgaben wie Datenklassifizierung, Regression und Clustering verwendet wird. Das Training und die Inferenz neuronaler Netze erfordert eine große Anzahl von Matrixmultiplikationen, Faltungen und anderen Rechenoperationen, sodass die Rechenkomplexität sehr hoch ist. Mit FLOPS (FloatingPointOperationsperSecond) kann die Rechenkomplexität neuronaler Netze gemessen werden, um die Effizienz der Rechenressourcennutzung des Modells zu bewerten. FLOP

Eine Fallstudie zur Verwendung des bidirektionalen LSTM-Modells zur Textklassifizierung

Jan 24, 2024 am 10:36 AM

Eine Fallstudie zur Verwendung des bidirektionalen LSTM-Modells zur Textklassifizierung

Jan 24, 2024 am 10:36 AM

Das bidirektionale LSTM-Modell ist ein neuronales Netzwerk, das zur Textklassifizierung verwendet wird. Unten finden Sie ein einfaches Beispiel, das zeigt, wie bidirektionales LSTM für Textklassifizierungsaufgaben verwendet wird. Zuerst müssen wir die erforderlichen Bibliotheken und Module importieren: importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

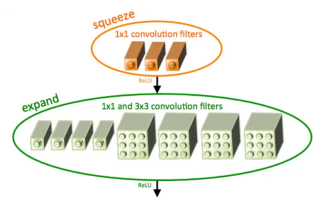

Einführung in SqueezeNet und seine Eigenschaften

Jan 22, 2024 pm 07:15 PM

Einführung in SqueezeNet und seine Eigenschaften

Jan 22, 2024 pm 07:15 PM

SqueezeNet ist ein kleiner und präziser Algorithmus, der eine gute Balance zwischen hoher Genauigkeit und geringer Komplexität schafft und sich daher ideal für mobile und eingebettete Systeme mit begrenzten Ressourcen eignet. Im Jahr 2016 schlugen Forscher von DeepScale, der University of California, Berkeley und der Stanford University SqueezeNet vor, ein kompaktes und effizientes Faltungs-Neuronales Netzwerk (CNN). In den letzten Jahren haben Forscher mehrere Verbesserungen an SqueezeNet vorgenommen, darunter SqueezeNetv1.1 und SqueezeNetv2.0. Verbesserungen in beiden Versionen erhöhen nicht nur die Genauigkeit, sondern senken auch die Rechenkosten. Genauigkeit von SqueezeNetv1.1 im ImageNet-Datensatz

Vergleichen Sie die Ähnlichkeiten, Unterschiede und Beziehungen zwischen erweiterter Faltung und atröser Faltung

Jan 22, 2024 pm 10:27 PM

Vergleichen Sie die Ähnlichkeiten, Unterschiede und Beziehungen zwischen erweiterter Faltung und atröser Faltung

Jan 22, 2024 pm 10:27 PM

Dilatierte Faltung und erweiterte Faltung sind häufig verwendete Operationen in Faltungs-Neuronalen Netzen. In diesem Artikel werden ihre Unterschiede und Beziehungen im Detail vorgestellt. 1. Erweiterte Faltung Die erweiterte Faltung, auch als erweiterte Faltung oder erweiterte Faltung bekannt, ist eine Operation in einem Faltungs-Neuronalen Netzwerk. Es handelt sich um eine Erweiterung, die auf der herkömmlichen Faltungsoperation basiert und das Empfangsfeld des Faltungskerns durch Einfügen von Löchern in den Faltungskern erhöht. Auf diese Weise kann das Netzwerk ein breiteres Spektrum an Funktionen besser erfassen. Die erweiterte Faltung wird im Bereich der Bildverarbeitung häufig verwendet und kann die Leistung des Netzwerks verbessern, ohne die Anzahl der Parameter und den Rechenaufwand zu erhöhen. Durch die Erweiterung des Empfangsfelds des Faltungskerns kann die erweiterte Faltung die globalen Informationen im Bild besser verarbeiten und dadurch den Effekt der Merkmalsextraktion verbessern. Die Hauptidee der erweiterten Faltung besteht darin, einige einzuführen

Twin Neural Network: Prinzip- und Anwendungsanalyse

Jan 24, 2024 pm 04:18 PM

Twin Neural Network: Prinzip- und Anwendungsanalyse

Jan 24, 2024 pm 04:18 PM

Das Siamese Neural Network ist eine einzigartige künstliche neuronale Netzwerkstruktur. Es besteht aus zwei identischen neuronalen Netzen mit denselben Parametern und Gewichten. Gleichzeitig teilen die beiden Netzwerke auch die gleichen Eingabedaten. Dieses Design wurde von Zwillingen inspiriert, da die beiden neuronalen Netze strukturell identisch sind. Das Prinzip des siamesischen neuronalen Netzwerks besteht darin, bestimmte Aufgaben wie Bildabgleich, Textabgleich und Gesichtserkennung durch den Vergleich der Ähnlichkeit oder des Abstands zwischen zwei Eingabedaten auszuführen. Während des Trainings versucht das Netzwerk, ähnliche Daten benachbarten Regionen und unterschiedliche Daten entfernten Regionen zuzuordnen. Auf diese Weise kann das Netzwerk lernen, verschiedene Daten zu klassifizieren oder abzugleichen, um entsprechende Ergebnisse zu erzielen

Bildrauschen mithilfe von Faltungs-Neuronalen Netzen

Jan 23, 2024 pm 11:48 PM

Bildrauschen mithilfe von Faltungs-Neuronalen Netzen

Jan 23, 2024 pm 11:48 PM

Faltungs-Neuronale Netze eignen sich gut für Aufgaben zur Bildrauschunterdrückung. Es nutzt die erlernten Filter, um das Rauschen zu filtern und so das Originalbild wiederherzustellen. In diesem Artikel wird die Methode zur Bildentrauschung basierend auf einem Faltungs-Neuronalen Netzwerk ausführlich vorgestellt. 1. Überblick über das Convolutional Neural Network Das Convolutional Neural Network ist ein Deep-Learning-Algorithmus, der eine Kombination aus mehreren Faltungsschichten, Pooling-Schichten und vollständig verbundenen Schichten verwendet, um Bildmerkmale zu lernen und zu klassifizieren. In der Faltungsschicht werden die lokalen Merkmale des Bildes durch Faltungsoperationen extrahiert und so die räumliche Korrelation im Bild erfasst. Die Pooling-Schicht reduziert den Rechenaufwand durch Reduzierung der Feature-Dimension und behält die Hauptfeatures bei. Die vollständig verbundene Schicht ist für die Zuordnung erlernter Merkmale und Beschriftungen zur Implementierung der Bildklassifizierung oder anderer Aufgaben verantwortlich. Das Design dieser Netzwerkstruktur macht das Faltungs-Neuronale Netzwerk für die Bildverarbeitung und -erkennung nützlich.

Kausales Faltungs-Neuronales Netzwerk

Jan 24, 2024 pm 12:42 PM

Kausales Faltungs-Neuronales Netzwerk

Jan 24, 2024 pm 12:42 PM

Das kausale Faltungs-Neuronale Netzwerk ist ein spezielles Faltungs-Neuronales Netzwerk, das für Kausalitätsprobleme in Zeitreihendaten entwickelt wurde. Im Vergleich zu herkömmlichen Faltungs-Neuronalen Netzen bieten kausale Faltungs-Neuronale Netze einzigartige Vorteile bei der Beibehaltung der kausalen Beziehung von Zeitreihen und werden häufig bei der Vorhersage und Analyse von Zeitreihendaten verwendet. Die Kernidee des kausalen Faltungs-Neuronalen Netzwerks besteht darin, Kausalität in die Faltungsoperation einzuführen. Herkömmliche Faltungs-Neuronale Netze können gleichzeitig Daten vor und nach dem aktuellen Zeitpunkt wahrnehmen, bei der Vorhersage von Zeitreihen kann dies jedoch zu Informationsverlustproblemen führen. Da die Vorhersageergebnisse zum aktuellen Zeitpunkt durch die Daten zu zukünftigen Zeitpunkten beeinflusst werden. Das kausale Faltungs-Neuronale Netzwerk löst dieses Problem. Es kann nur den aktuellen Zeitpunkt und frühere Daten wahrnehmen, aber keine zukünftigen Daten.