Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die groß angelegte Rangliste der Inferenzkosten, angeführt von Jia Yangqings hoher Effizienz, wird veröffentlicht

Die groß angelegte Rangliste der Inferenzkosten, angeführt von Jia Yangqings hoher Effizienz, wird veröffentlicht

Die groß angelegte Rangliste der Inferenzkosten, angeführt von Jia Yangqings hoher Effizienz, wird veröffentlicht

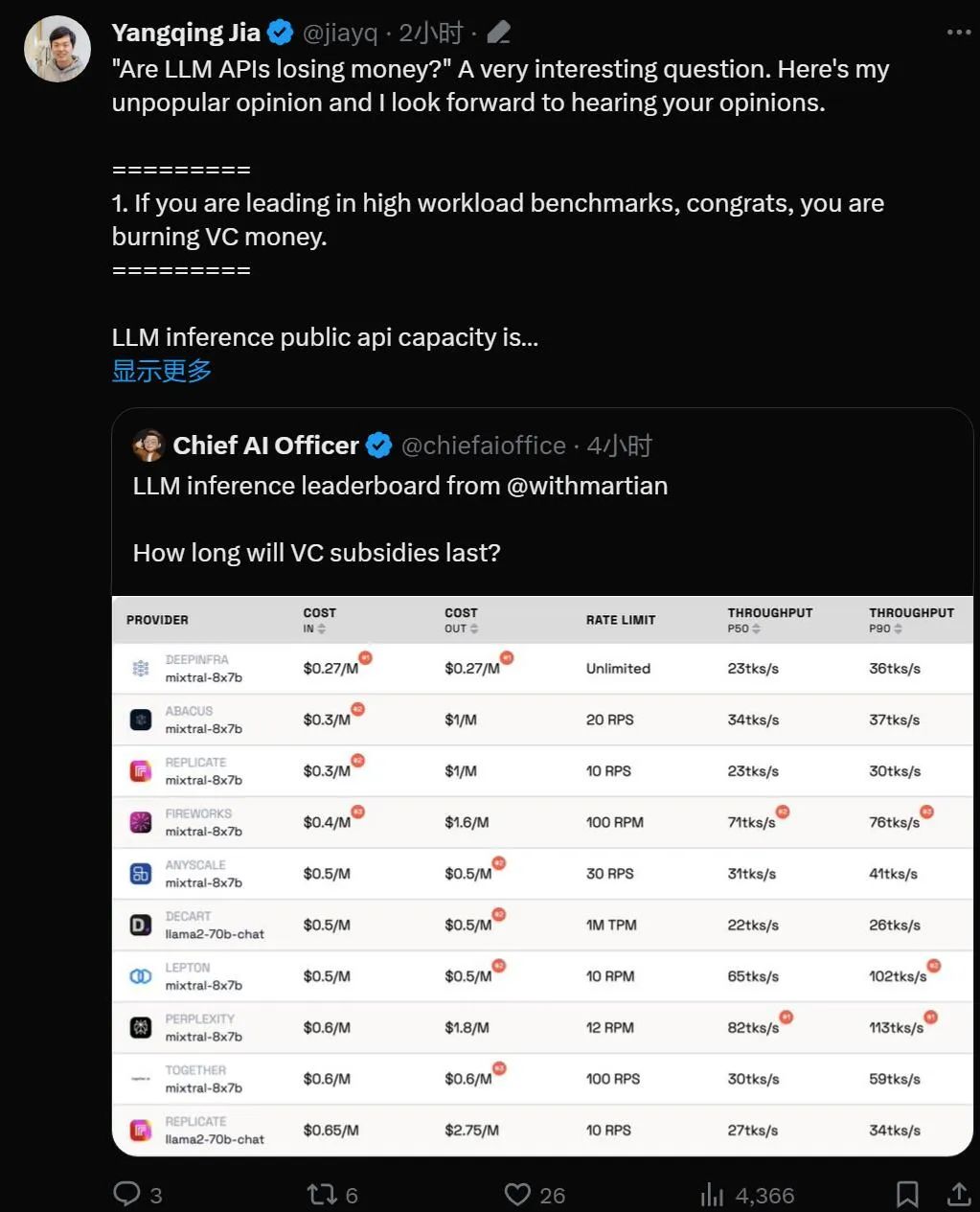

„Sind große Modell-APIs ein verlustbringendes Geschäft?“

Mit der Einführung der Technologie für große Sprachmodelle haben viele Technologieunternehmen große Modell-APIs für Entwickler eingeführt. Allerdings kommen wir nicht umhin, uns zu fragen, ob ein auf großen Modellen basierendes Geschäft überlebensfähig ist, insbesondere wenn man bedenkt, dass OpenAI täglich 700.000 US-Dollar verbrennt.

Diesen Donnerstag hat das KI-Startup Martian es sorgfältig für uns berechnet.

Ranking-Link: https://leaderboard.withmartian.com/

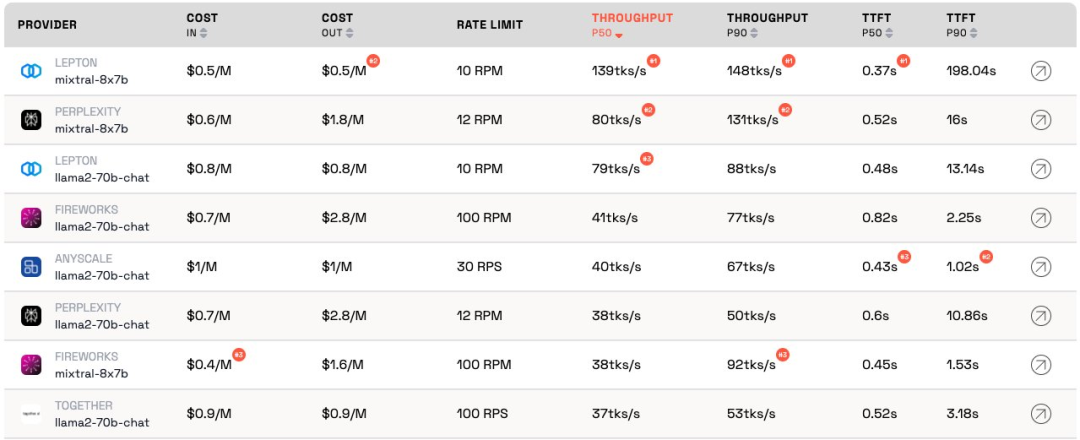

Das LLM Inference Provider Leaderboard ist ein Open-Source-Ranking von API-Inferenzprodukten für große Modelle. Es bewertet die Kosten und Ratengrenzen , Durchsatz und P50- und P90-TTFT für die öffentlichen Endpunkte Mixtral-8x7B und Llama-2-70B-Chat jedes Anbieters Bei den Kosten gibt es erhebliche Unterschiede im Durchsatz und bei der Ratenbegrenzung. Diese Unterschiede übersteigen den 5-fachen Kostenunterschied, den 6-fachen Durchsatzunterschied und noch größere Unterschiede bei den Ratenbegrenzungen. Die Auswahl verschiedener APIs ist für die Erzielung der besten Leistung von entscheidender Bedeutung, auch wenn dies nur ein Teil des Geschäftsbetriebs ist.

Laut aktuellem Ranking weist der von Anyscale bereitgestellte Dienst den besten Durchsatz bei mittlerer Dienstlast von Llama-2-70B auf. Bei großen Servicelasten schnitt Together AI mit P50- und P90-Durchsatz auf Llama-2-70B und Mixtral-8x7B am besten ab.

Darüber hinaus zeigte Jia Yangqings LeptonAI den besten Durchsatz bei der Bewältigung kleiner Aufgabenlasten mit kurzen Eingabe- und langen Ausgabe-Cues. Sein P50-Durchsatz von 130 tks/s ist der schnellste unter den Modellen, die derzeit von allen Herstellern auf dem Markt angeboten werden.

Jia Yangqing, ein bekannter KI-Wissenschaftler und Gründer von Lepton AI, kommentierte unmittelbar nach der Veröffentlichung der Rangliste. Mal sehen, was er sagte.

Jia Yangqing erläuterte zunächst den aktuellen Stand der Branche im Bereich der künstlichen Intelligenz, bekräftigte dann die Bedeutung von Benchmark-Tests und wies schließlich darauf hin, dass LeptonAI Benutzern dabei helfen wird, die beste grundlegende KI-Strategie zu finden.

1. Große Modell-API „verbrennt Geld“

Wenn das Modell in Benchmarks mit hoher Arbeitsbelastung führt, dann herzlichen Glückwunsch, es verbrennt „Geld“.

LLM Über die Kapazität einer öffentlichen API nachzudenken ist wie die Führung eines Restaurants: Sie haben einen Koch und müssen den Kundenverkehr schätzen. Einen Koch zu engagieren, kostet Geld. Latenz und Durchsatz können als „wie schnell Sie für Kunden kochen können“ verstanden werden. Für ein vernünftiges Geschäft braucht man eine „angemessene“ Anzahl an Köchen. Mit anderen Worten: Sie möchten in der Lage sein, den normalen Verkehr zu transportieren, und keine plötzlichen Verkehrsstöße, die innerhalb von Sekunden auftreten. Ein Verkehrsanstieg bedeutet Warten, sonst hat der „Koch“ nichts zu tun.

In der Welt der künstlichen Intelligenz spielt die GPU die Rolle des „Kochs“. Die Grundlasten sind stoßartig. Bei geringer Auslastung wird die Grundlast in den normalen Datenverkehr eingemischt und die Messungen liefern eine genaue Darstellung der Leistung des Dienstes unter aktueller Auslastung.

Szenarien mit hoher Servicelast sind interessant, weil sie zu Unterbrechungen führen. Der Benchmark wird nur ein paar Mal pro Tag/Woche ausgeführt, es handelt sich also nicht um den regelmäßigen Datenverkehr, den man erwarten sollte. Stellen Sie sich vor, 100 Leute strömen in ein lokales Restaurant, um zu sehen, wie schnell der Koch kocht. Das Ergebnis wäre großartig. Um die Terminologie der Quantenphysik zu übernehmen, nennt man dies den „Beobachtereffekt“. Je stärker die Störung (also je größer die Burst-Belastung) ist, desto geringer ist die Genauigkeit. Mit anderen Worten: Wenn Sie einen Dienst plötzlich stark auslasten und feststellen, dass der Dienst sehr schnell reagiert, wissen Sie, dass der Dienst über ziemlich viel ungenutzte Kapazität verfügt. Wenn Sie als Investor diese Situation sehen, sollten Sie sich fragen: Ist diese Art der Geldverbrennung verantwortungsvoll?

2. Das Modell wird irgendwann eine ähnliche Leistung erzielen

Der Bereich der künstlichen Intelligenz liebt Wettbewerbe, was in der Tat interessant ist. Alle sind sich schnell auf die gleiche Lösung einig und Nvidia gewinnt am Ende immer aufgrund der GPU. Dies ist großartigen Open-Source-Projekten zu verdanken, vLLM ist ein großartiges Beispiel. Das bedeutet, dass Sie als Anbieter, wenn Ihr Modell deutlich schlechter abschneidet als andere, leicht aufholen können, indem Sie sich Open-Source-Lösungen ansehen und gutes Engineering anwenden. 3. „Als Kunde sind mir die Kosten des Anbieters egal“ Für KI-Anwendungsentwickler haben wir Glück: Es gibt immer API-Anbieter, die bereit sind, „Geld zu verbrennen“. Die KI-Branche verbrennt Geld, um Traffic zu gewinnen, und der nächste Schritt besteht darin, sich um die Gewinne zu sorgen. Benchmarking ist eine mühsame und fehleranfällige Aufgabe. Im Guten wie im Schlechten kommt es normalerweise vor, dass die Gewinner Sie loben und die Verlierer Ihnen die Schuld geben. Dies war bei der letzten Runde der Benchmarks für Faltungs-Neuronale Netze der Fall. Es ist keine leichte Aufgabe, aber Benchmarking wird uns dabei helfen, das nächste Zehnfache der KI-Infrastruktur zu erreichen. Basierend auf dem Framework für künstliche Intelligenz und der Cloud-Infrastruktur hilft LeptonAI Benutzern, die beste KI-Grundstrategie zu finden.

Das obige ist der detaillierte Inhalt vonDie groß angelegte Rangliste der Inferenzkosten, angeführt von Jia Yangqings hoher Effizienz, wird veröffentlicht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

CentOS8 startet SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 startet SSH

Apr 14, 2025 pm 09:00 PM

Der Befehl zum Neustart des SSH -Dienstes lautet: SystemCTL Neustart SSHD. Detaillierte Schritte: 1. Zugriff auf das Terminal und eine Verbindung zum Server; 2. Geben Sie den Befehl ein: SystemCTL Neustart SSHD; 1. Überprüfen Sie den Dienststatus: SystemCTL -Status SSHD.

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Pytorch Distributed Training on CentOS -System erfordert die folgenden Schritte: Pytorch -Installation: Die Prämisse ist, dass Python und PIP im CentOS -System installiert sind. Nehmen Sie abhängig von Ihrer CUDA -Version den entsprechenden Installationsbefehl von der offiziellen Pytorch -Website ab. Für CPU-Schulungen können Sie den folgenden Befehl verwenden: PipinstallTorChTorChVisionTorChaudio Wenn Sie GPU-Unterstützung benötigen, stellen Sie sicher, dass die entsprechende Version von CUDA und CUDNN installiert ist und die entsprechende Pytorch-Version für die Installation verwenden. Konfiguration der verteilten Umgebung: Verteiltes Training erfordert in der Regel mehrere Maschinen oder mehrere Maschinen-Mehrfach-GPUs. Ort