Java

Java

javaLernprogramm

javaLernprogramm

Echtzeit-Datenübertragung: Zwei Lösungen zur Auswahl zwischen Flume und Kafka

Echtzeit-Datenübertragung: Zwei Lösungen zur Auswahl zwischen Flume und Kafka

Echtzeit-Datenübertragung: Zwei Lösungen zur Auswahl zwischen Flume und Kafka

Flume und Kafka: Zwei Optionen für die Echtzeit-Datenübertragung

Übersicht

Flume und Kafka sind beide Open-Source-Plattformen für die Echtzeit-Datenübertragung. Sie alle zeichnen sich durch hohen Durchsatz, geringe Latenz und Zuverlässigkeit aus. Allerdings gibt es einige Unterschiede in der Gestaltung und Umsetzung.

Flume

Flume ist ein verteiltes, zuverlässiges und skalierbares Protokollerfassungs-, Aggregations- und Übertragungssystem. Es unterstützt mehrere Datenquellen, einschließlich Dateien, Syslog, Taildir, Exec und HTTP. Flume unterstützt außerdem mehrere Datenformate, darunter Text, JSON und Avro.

Die Architektur von Flume ist in der folgenden Abbildung dargestellt:

[Bild]

Zu den Komponenten von Flume gehören:

- Quelle: Die Quellkomponente ist für das Sammeln von Daten aus der Datenquelle verantwortlich.

- Kanal: Die Kanalkomponente ist für die Speicherung und Übertragung von Daten verantwortlich.

- Sink: Die Sink-Komponente ist für das Senden von Daten an das Zielsystem verantwortlich.

Die Konfigurationsdatei von Flume lautet wie folgt:

# Name the agent a1.sources = r1 # Describe the source r1.type = exec r1.command = tail -F /var/log/messages # Describe the sink s1.type = hdfs s1.hdfs.path = hdfs://namenode:8020/flume/logs # Use a channel which buffers events in memory c1.type = memory c1.capacity = 1000 c1.transactionCapacity = 100 # Bind the source and sink to the channel a1.channels = c1 c1.sinks = s1

Kafka

Kafka ist ein verteiltes, skalierbares und fehlertolerantes Nachrichtensystem. Es unterstützt mehrere Nachrichtenformate, einschließlich Text, JSON und Avro. Kafka unterstützt außerdem mehrere Clientsprachen, darunter Java, Python, C++ und Go.

Die Architektur von Kafka ist in der folgenden Abbildung dargestellt:

[Bild]

Zu den Komponenten von Kafka gehören:

- Produzent: Die Produzentenkomponente ist für das Senden von Daten an den Kafka-Cluster verantwortlich.

- Broker: Die Broker-Komponente ist für die Speicherung und Weiterleitung von Daten verantwortlich.

- Consumer: Die Consumer-Komponente ist für das Lesen von Daten aus dem Kafka-Cluster verantwortlich.

Kafkas Konfigurationsdatei sieht so aus:

# Create a topic named "my-topic" with 3 partitions and a replication factor of 2 kafka-topics --create --topic my-topic --partitions 3 --replication-factor 2 # Start a Kafka producer kafka-console-producer --topic my-topic # Start a Kafka consumer kafka-console-consumer --topic my-topic --from-beginning

Vergleich

Flume und Kafka sind beide hervorragende Plattformen für die Echtzeit-Datenübertragung. Sie alle zeichnen sich durch hohen Durchsatz, geringe Latenz und Zuverlässigkeit aus. Allerdings gibt es einige Unterschiede in der Gestaltung und Umsetzung.

Flume ist ein verteiltes, zuverlässiges und skalierbares Protokollerfassungs-, Aggregations- und Übertragungssystem. Es unterstützt mehrere Datenquellen und Datenformate. Die Konfigurationsdateien von Flume sind einfach zu verstehen und einfach zu verwenden.

Kafka ist ein verteiltes, skalierbares und fehlertolerantes Nachrichtensystem. Es unterstützt mehrere Nachrichtenformate und Clientsprachen. Die Konfigurationsdatei von Kafka ist relativ komplex und erfordert einen gewissen Lernaufwand.

Fazit

Sowohl Flume als auch Kafka sind hervorragende Plattformen für die Echtzeit-Datenübertragung. Sie alle zeichnen sich durch hohen Durchsatz, geringe Latenz und Zuverlässigkeit aus. Allerdings gibt es einige Unterschiede in der Gestaltung und Umsetzung.

Flume eignet sich besser für die Protokollsammlung, -aggregation und -übertragung. Kafka eignet sich besser für Nachrichten.

Codebeispiel

Hier ist ein Codebeispiel, das Flume zum Sammeln und Übertragen von Protokollen verwendet:

# Create a Flume agent

agent = AgentBuilder.newInstance().build()

# Create a source

source = ExecSourceBuilder.newInstance().setCommand("tail -F /var/log/messages").build()

# Create a channel

channel = MemoryChannelBuilder.newInstance().setCapacity(1000).setTransactionCapacity(100).build()

# Create a sink

sink = HDFSSinkBuilder.newInstance().setBasePath("hdfs://namenode:8020/flume/logs").build()

# Add the source, channel, and sink to the agent

agent.addSource("r1", source)

agent.addChannel("c1", channel)

agent.addSink("s1", sink)

# Start the agent

agent.start()Hier ist ein Codebeispiel, das Kafka zum Senden und Empfangen von Nachrichten verwendet:

# Create a Kafka producer

producer = KafkaProducerBuilder.newInstance()

.setBootstrapServers("localhost:9092")

.setValueSerializer(StringSerializer.class)

.build()

# Create a Kafka consumer

consumer = KafkaConsumerBuilder.newInstance()

.setBootstrapServers("localhost:9092")

.setValueDeserializer(StringDeserializer.class)

.setGroupId("my-group")

.build()

# Subscribe the consumer to the topic

consumer.subscribe(Arrays.asList("my-topic"))

# Send a message to the topic

producer.send(new ProducerRecord<>("my-topic", "Hello, world!"));

# Receive messages from the topic

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

System.out.println(record.value());

}

}Das obige ist der detaillierte Inhalt vonEchtzeit-Datenübertragung: Zwei Lösungen zur Auswahl zwischen Flume und Kafka. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

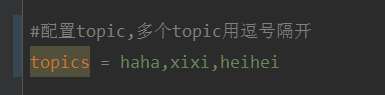

So geben Sie mit @KafkaListener in Springboot + Kafka dynamisch mehrere Themen an

May 20, 2023 pm 08:58 PM

So geben Sie mit @KafkaListener in Springboot + Kafka dynamisch mehrere Themen an

May 20, 2023 pm 08:58 PM

Erklären Sie, dass es sich bei diesem Projekt um ein Springboot+Kafak-Integrationsprojekt handelt und daher die Kafak-Verbrauchsanmerkung @KafkaListener in Springboot verwendet. Konfigurieren Sie zunächst mehrere durch Kommas getrennte Themen in application.properties. Methode: Verwenden Sie den SpEl-Ausdruck von Spring, um Themen wie folgt zu konfigurieren: @KafkaListener(topics="#{’${topics}’.split(',')}"), um das Programm auszuführen. Der Konsolendruckeffekt ist wie folgt

So implementieren Sie eine Echtzeit-Aktienanalyse mit PHP und Kafka

Jun 28, 2023 am 10:04 AM

So implementieren Sie eine Echtzeit-Aktienanalyse mit PHP und Kafka

Jun 28, 2023 am 10:04 AM

Mit der Entwicklung des Internets und der Technologie sind digitale Investitionen zu einem Thema mit zunehmender Besorgnis geworden. Viele Anleger erforschen und studieren weiterhin Anlagestrategien in der Hoffnung, eine höhere Kapitalrendite zu erzielen. Im Aktienhandel ist die Aktienanalyse in Echtzeit für die Entscheidungsfindung sehr wichtig, und der Einsatz der Kafka-Echtzeit-Nachrichtenwarteschlange und der PHP-Technologie ist ein effizientes und praktisches Mittel. 1. Einführung in Kafka Kafka ist ein von LinkedIn entwickeltes verteiltes Publish- und Subscribe-Messagingsystem mit hohem Durchsatz. Die Hauptmerkmale von Kafka sind

PHP und WebSocket: Best Practices für die Echtzeit-Datenübertragung

Dec 18, 2023 pm 02:10 PM

PHP und WebSocket: Best Practices für die Echtzeit-Datenübertragung

Dec 18, 2023 pm 02:10 PM

PHP und WebSocket: Best-Practice-Methoden für die Echtzeit-Datenübertragung Einführung: Bei der Entwicklung von Webanwendungen ist die Echtzeit-Datenübertragung eine sehr wichtige technische Anforderung. Das herkömmliche HTTP-Protokoll ist ein Anforderungs-Antwort-Modellprotokoll und kann keine Datenübertragung in Echtzeit effektiv erreichen. Um den Anforderungen der Echtzeit-Datenübertragung gerecht zu werden, wurde das WebSocket-Protokoll entwickelt. WebSocket ist ein Vollduplex-Kommunikationsprotokoll, das eine Möglichkeit zur Vollduplex-Kommunikation über eine einzelne TCP-Verbindung bietet. Im Vergleich zu H

Vergleichende Analyse der Kafka-Visualisierungstools: Wie wählt man das am besten geeignete Tool aus?

Jan 05, 2024 pm 12:15 PM

Vergleichende Analyse der Kafka-Visualisierungstools: Wie wählt man das am besten geeignete Tool aus?

Jan 05, 2024 pm 12:15 PM

Wie wählt man das richtige Kafka-Visualisierungstool aus? Vergleichende Analyse von fünf Tools Einführung: Kafka ist ein leistungsstarkes verteiltes Nachrichtenwarteschlangensystem mit hohem Durchsatz, das im Bereich Big Data weit verbreitet ist. Mit der Popularität von Kafka benötigen immer mehr Unternehmen und Entwickler ein visuelles Tool zur einfachen Überwachung und Verwaltung von Kafka-Clustern. In diesem Artikel werden fünf häufig verwendete Kafka-Visualisierungstools vorgestellt und ihre Merkmale und Funktionen verglichen, um den Lesern bei der Auswahl des Tools zu helfen, das ihren Anforderungen entspricht. 1. KafkaManager

Fünf Auswahlmöglichkeiten an Visualisierungstools zur Erkundung von Kafka

Feb 01, 2024 am 08:03 AM

Fünf Auswahlmöglichkeiten an Visualisierungstools zur Erkundung von Kafka

Feb 01, 2024 am 08:03 AM

Fünf Optionen für Kafka-Visualisierungstools ApacheKafka ist eine verteilte Stream-Verarbeitungsplattform, die große Mengen an Echtzeitdaten verarbeiten kann. Es wird häufig zum Aufbau von Echtzeit-Datenpipelines, Nachrichtenwarteschlangen und ereignisgesteuerten Anwendungen verwendet. Die Visualisierungstools von Kafka können Benutzern dabei helfen, Kafka-Cluster zu überwachen und zu verwalten und Kafka-Datenflüsse besser zu verstehen. Im Folgenden finden Sie eine Einführung in fünf beliebte Kafka-Visualisierungstools: ConfluentControlCenterConfluent

Wie installiere ich Apache Kafka unter Rocky Linux?

Mar 01, 2024 pm 10:37 PM

Wie installiere ich Apache Kafka unter Rocky Linux?

Mar 01, 2024 pm 10:37 PM

Um ApacheKafka auf RockyLinux zu installieren, können Sie die folgenden Schritte ausführen: Aktualisieren Sie das System: Stellen Sie zunächst sicher, dass Ihr RockyLinux-System auf dem neuesten Stand ist. Führen Sie den folgenden Befehl aus, um die Systempakete zu aktualisieren: sudoyumupdate Java installieren: ApacheKafka hängt von Java ab, also von Ihnen Sie müssen zuerst JavaDevelopmentKit (JDK) installieren. OpenJDK kann mit dem folgenden Befehl installiert werden: sudoyuminstalljava-1.8.0-openjdk-devel Herunterladen und dekomprimieren: Besuchen Sie die offizielle Website von ApacheKafka (), um das neueste Binärpaket herunterzuladen. Wählen Sie eine stabile Version

Die Praxis von Go-Zero und Kafka+Avro: Aufbau eines leistungsstarken interaktiven Datenverarbeitungssystems

Jun 23, 2023 am 09:04 AM

Die Praxis von Go-Zero und Kafka+Avro: Aufbau eines leistungsstarken interaktiven Datenverarbeitungssystems

Jun 23, 2023 am 09:04 AM

In den letzten Jahren haben mit dem Aufkommen von Big Data und aktiven Open-Source-Communities immer mehr Unternehmen begonnen, nach leistungsstarken interaktiven Datenverarbeitungssystemen zu suchen, um den wachsenden Datenanforderungen gerecht zu werden. In dieser Welle von Technologie-Upgrades werden Go-Zero und Kafka+Avro von immer mehr Unternehmen beachtet und übernommen. go-zero ist ein auf der Golang-Sprache entwickeltes Microservice-Framework. Es zeichnet sich durch hohe Leistung, Benutzerfreundlichkeit, einfache Erweiterung und einfache Wartung aus und soll Unternehmen dabei helfen, schnell effiziente Microservice-Anwendungssysteme aufzubauen. sein schnelles Wachstum

Vertiefendes Verständnis des zugrunde liegenden Implementierungsmechanismus der Kafka-Nachrichtenwarteschlange

Feb 01, 2024 am 08:15 AM

Vertiefendes Verständnis des zugrunde liegenden Implementierungsmechanismus der Kafka-Nachrichtenwarteschlange

Feb 01, 2024 am 08:15 AM

Überblick über die zugrunde liegenden Implementierungsprinzipien der Kafka-Nachrichtenwarteschlange Kafka ist ein verteiltes, skalierbares Nachrichtenwarteschlangensystem, das große Datenmengen verarbeiten kann und einen hohen Durchsatz und eine geringe Latenz aufweist. Kafka wurde ursprünglich von LinkedIn entwickelt und ist heute ein Top-Level-Projekt der Apache Software Foundation. Architektur Kafka ist ein verteiltes System, das aus mehreren Servern besteht. Jeder Server wird als Knoten bezeichnet und jeder Knoten ist ein unabhängiger Prozess. Knoten werden über ein Netzwerk verbunden, um einen Cluster zu bilden. K