Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Entscheidungskollaboration zwischen Mensch und KI: Formulierung, Erklärung und Bewertung von Entscheidungsproblemen

Entscheidungskollaboration zwischen Mensch und KI: Formulierung, Erklärung und Bewertung von Entscheidungsproblemen

Entscheidungskollaboration zwischen Mensch und KI: Formulierung, Erklärung und Bewertung von Entscheidungsproblemen

In Bereichen wie künstlicher Intelligenz und Datenvisualisierung ist es ein wichtiges Forschungsziel, wie die Informationsanzeige genutzt werden kann, um Menschen dabei zu helfen, bessere Entscheidungen zu treffen. Allerdings besteht derzeit kein klarer Konsens über die Definition von Entscheidungsproblemen und die Gestaltung von Experimenten zur Beurteilung der menschlichen Entscheidungsleistung. In einem kürzlich erschienenen Artikel wird eine Definition eines Entscheidungsproblems vorgeschlagen, die auf statistischer Entscheidungstheorie und Informationsökonomie basiert, und einen Rahmen für die Bewertung des Verlusts menschlicher Entscheidungsleistung bereitstellt. In diesem Artikel wird dieses Papier interpretiert und seine Auswirkungen auf die Weiterentwicklung der Forschung zur Entscheidungsfindung untersucht.

In dem Artikel „Decision Theoretic Foundations for Experiments Evaluating Human Decisions“ stellen drei amerikanische Experten eine Informationsschnittstelle zur Verfügung, die der Entscheidungsfindung dabei helfen soll, ein gemeinsames Ziel für die Forschung in den Bereichen Human-Centered Artificial Intelligence (HCAI), Visualisierung und verwandten Bereichen zu erreichen . Diese Experten argumentieren, dass Visualisierungsforscher die Entscheidungsunterstützung als wichtiges Ziel der Datenvisualisierung betonen. Gleichzeitig wird in der auf den Menschen ausgerichteten künstlichen Intelligenz die empirische Forschung zum menschlichen Entscheidungsverhalten auch weithin als „Bewertung der Wirksamkeit der Technologie der künstlichen Intelligenz bei der Unterstützung der Entscheidungsfindung und Entwicklung eines grundlegenden Verständnisses dafür, wie Menschen mit künstlicher Intelligenz interagieren“ angesehen „Entscheidungen treffen“ – notwendige Inhalte. Ziel dieser Studien ist es, die Genauigkeit und Effizienz der Entscheidungsfindung zu verbessern, eine gute Interaktion zwischen künstlicher Intelligenz und menschlichen Entscheidungsträgern sicherzustellen und den Menschen eine bessere Entscheidungsunterstützung zu bieten.

Sie glauben, dass durch die Untersuchung der Informationsdarstellung menschlicher Entscheidungsfindung ein minimaler Satz theoretischer Verpflichtungen klar definiert werden kann, wodurch die Möglichkeit geboten wird, normatives Verhalten für die Aufgabe zu bestimmen. Glücklicherweise können die bestehende statistische Entscheidungstheorie und die Theorie des erwarteten Nutzens dieser Herausforderung begegnen und einen streng abgeleiteten und allgemein anwendbaren Rahmen für die Untersuchung der Entscheidungsfindung bereitstellen. Darüber hinaus bietet die Entwicklung der Informationsökonomie auch Lösungen für die Formalisierung von Informationsstrukturen für Entscheidungsprobleme, bei denen es um die Gestaltung von Visualisierungs- und Interpretationsmöglichkeiten für Modellvorhersagen gehen kann.

Sie synthetisieren eine allgemein anwendbare Definition wohldefinierter Entscheidungsprobleme aus der statistischen Entscheidungstheorie und Informationsökonomie und inspirieren den Wert dieses Ansatzes in HCAI und verwandter Entscheidungsforschung über eine datengesteuerte Schnittstelle. Ihr erster Beitrag bestand darin, den minimalen Satz von Komponenten festzulegen und zu motivieren, die für ein Entscheidungsproblem definiert werden müssen, um optimale Entscheidungen zu identifizieren und so Verzerrungen in der menschlichen Entscheidungsfindung zu identifizieren. Mithilfe des Konzepts rationaler Bayesianischer Agenten zeigen sie, dass Leistungseinbußen nur dann berücksichtigt werden können, wenn Forschungsteilnehmer theoretisch in der Lage sind, aus den von ihnen bereitgestellten Informationen normative Entscheidungen abzuleiten. Sie fanden heraus, dass in einer Stichprobe von 46 bestehenden Studien 35 Studien prädiktive Darstellungen verwendeten, um Rückschlüsse auf menschliche Entscheidungsdefizite zu ziehen, aber nur 6 davon (17 %) waren explizite Studienaufgaben, da den Teilnehmern genügend Informationen gegeben wurden, die zumindest in Prinzip, kann die beste Entscheidung bestimmen. Anhand von Beispielen veranschaulichen sie die epistemologischen Risiken dieser Schlussfolgerungen und geben Experimentatoren Vorschläge zur Verbesserung der Interpretierbarkeit ihrer Ergebnisse.

Hintergrund des Autors des Artikels

Der Titel dieses Artikels lautet „Entscheidungstheoretische Grundlagen für Experimente zur Bewertung menschlicher Entscheidungen“. Er wurde gemeinsam von Jessica Hullman, Alex Kale und Jason Hartline, drei Computerautoren, geschrieben Wissenschaftler der Northwestern University in den Vereinigten Staaten. Veröffentlicht auf arXiv am 25. Januar 2024 (Papieradresse: https://arxiv.org/abs/2401.15106). Diese drei Autoren sind bekannte Wissenschaftler auf den Gebieten künstliche Intelligenz, Datenvisualisierung, Mensch-Computer-Interaktion usw. Ihre Forschungsergebnisse wurden in führenden akademischen Konferenzen und Fachzeitschriften wie ACM CHI, ACM CSCW, IEEE VIS und ACM veröffentlicht EC usw. Ihre Forschungsinteressen konzentrieren sich hauptsächlich auf die Frage, wie künstliche Intelligenz und Datenvisualisierung eingesetzt werden können, um Menschen dabei zu helfen, komplexe Unsicherheitsthemen wie Risikobewertung, Vorhersage, Empfehlung usw. zu verstehen und Entscheidungen darüber zu treffen.

Der Hauptbeitrag des Papiers

gibt eine Definition eines allgemeinen Entscheidungsproblems, einschließlich Elementen wie Aktionsraum, Zustandsraum, Bewertungsregeln, vorherige Überzeugungen, Datengenerierungsmodelle und Signalisierungsstrategien, und erklärt wie man diese Elemente nutzt, um optimale Aktionen und den erwarteten Nutzen zu bestimmen.

Schlagen Sie einen Rahmen zur Bewertung menschlicher Leistungsverluste bei der Entscheidungsfindung vor, einschließlich vier potenzieller Verlustquellen, einschließlich vorheriger Verluste, Empfangsverluste, Aktualisierungsverluste und Optimierungsverluste, und untersuchen Sie, wie diese Verluste durch experimentelles Design und Ergebnisse geschätzt und analysiert werden können .

In den letzten Jahren haben Forscher die durch künstliche Intelligenz unterstützte Entscheidungsfindung kodiert und ausgewertet, und die Ergebnisse zeigten, dass nur eine kleine Anzahl von Studien (etwa 17 %) genügend Informationen lieferten, um den Teilnehmern die Festlegung normativer Entscheidungen zu ermöglichen. Stattdessen leiden die meisten Studien (ungefähr 83 %) an unklaren und unvollständigen Entscheidungsproblemen, was zu unzuverlässigen Schlussfolgerungen über menschliche Entscheidungsverzerrungen und -fehler führt.

Theoretische Grundlagen und Methode

Die theoretischen Grundlagen dieser Arbeit stammen hauptsächlich aus der statistischen Entscheidungstheorie und der Informationsökonomie. Die statistische Entscheidungstheorie untersucht Methoden zum Treffen optimaler Entscheidungen unter Unsicherheit und konzentriert sich dabei auf die Beziehung zwischen den Präferenzen, Überzeugungen und Handlungen von Entscheidungsträgern sowie darauf, wie Daten und Informationen genutzt werden können, um Überzeugungen zu aktualisieren und Handlungen auszuwählen. Die Informationsökonomie untersucht die Auswirkungen von Informationen auf wirtschaftliches Verhalten und wirtschaftliche Ergebnisse und konzentriert sich dabei auf die Produktions-, Verbreitungs- und Konsummechanismen von Informationen sowie auf die Auswirkungen asymmetrischer, unvollständiger und unzuverlässiger Informationen auf Markt und Gesellschaft. Diese beiden Disziplinen bilden eine wichtige theoretische Grundlage für die Arbeit und helfen uns, die Rolle und die Auswirkungen von Entscheidungsprozessen und Informationen in der Wirtschaft tiefgreifend zu verstehen.

Die Methode dieser Arbeit basiert hauptsächlich auf der Bayes'schen Theorie und der Erwartungsnutzentheorie. Die Bayes'sche Theorie ist eine Wahrscheinlichkeitstheorie, die zur Beschreibung und Begründung von Unsicherheiten verwendet wird und sich auf die Berechnung späterer Überzeugungen auf der Grundlage früherer Überzeugungen und Beobachtungsdaten konzentriert, d. h. der Wahrscheinlichkeit, dass eine bestimmte Hypothese oder ein bestimmtes Ereignis unter bestimmten Datenbedingungen eintritt. Die Erwartungsnutzentheorie ist eine Theorie zur Bewertung riskanter Entscheidungen, die sich auf die Berechnung des Erwartungsnutzens konzentriert, einem gewichteten Durchschnitt des in verschiedenen Staaten erzeugten Nutzens auf der Grundlage von Nutzenfunktionen und Wahrscheinlichkeitsverteilungen. Dieser Ansatz kombiniert Bayesianisches Denken und Nutzenbewertung, um Entscheidungsträgern angesichts der Unsicherheit optimale Entscheidungen zu ermöglichen.

Definition des Entscheidungsproblems

Sie definieren ein Entscheidungsproblem und das entsprechende optimale Verhaltenskriterium, um die Leistungseinbuße relativ zu diesem Kriterium zu bestimmen. Ihre Definition zielt auf die kontrollierte Bewertung menschlichen Verhaltens, also auf die Untersuchung normativer Entscheidungsfindung. Diese Art der evaluativen Forschung erfordert die Fähigkeit, grundlegende Fakten über den Zustand zu ermitteln, zu dem die Forschungsteilnehmer befragt werden. Verhaltensdaten (die durch Menschen oder Simulationen generiert werden können) werden unter kontrollierten Bedingungen gesammelt mit dem Ziel, das durch die Informationsbereitstellung hervorgerufene Verhalten zu verstehen. Solche Studien werden häufig verwendet, um die Qualität der menschlichen Leistung in bestimmten Situationen zu beschreiben (z. B. das Ausmaß, in dem Menschen Entscheidungen auf der Grundlage von Anzeigen in strategischen Kontexten treffen) und um verschiedene unterstützende Elemente entsprechend der menschlichen Leistung einzuordnen (z. B. verschiedene Visualisierungen oder künstliche Intelligenz). ).

Berechnung optimaler Aktionen und des erwarteten Nutzens

Bei einem wie oben definierten Entscheidungsproblem gehen sie dazu davon aus, dass der Agent konsistente Präferenzen hat und die optimale Entscheidung zwischen Aktionen unter unsicheren Ergebnismitteln trifft, um normative ( „optimale“) Entscheidungen. Sie können daher die Leistung der Versuchsteilnehmer als Versuch interpretieren, dieses Kriterium zu erfüllen und Fehlerquellen (Leistungsverluste) zu identifizieren.

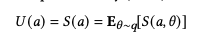

Dazu gehen sie zunächst davon aus, dass die Präferenzen des Agenten durch eine Bewertungsregel zusammengefasst werden können. Gehen Sie davon aus, dass er die Aktion auswählt, die seinen erwarteten Nutzen (Score) maximiert:

Das Bild

Das Bild

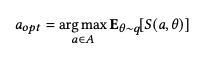

beschreibt die Glaubensverteilung des Agenten, also die Wahrscheinlichkeitsverteilung des Zustands der Welt, an den das Subjekt glaubt. Wir können die optimale Aktion als diejenige definieren, die den erwarteten Nutzen des Agenten maximiert:

Bild

Bild

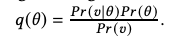

Um die optimale Entscheidung für die Entscheidungsaufgabe zu berechnen, definieren sie zunächst den Agenten in der Gleichung aus π: Pr (θ) oder p(θ) wie oben beschrieben. Immer wenn eine Signalisierungsstrategie π(θ |u) nicht direkt durch das Signal anzeigt, aber θ informiert, gehen wir davon aus, dass die Agenten nach dem Erkennen des Signals die Bayes-Regel verwenden, um ihre Reaktion auf das Signal basierend auf ihrem Wissen über das Signal vorherzusagen Datengenerierendes Modell Die vorherige Annahme des Summenzustands wird auf die hintere Annahme aktualisiert π:

Bild

Bild

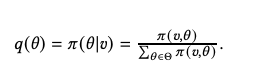

u ist ein Normalisierungsfaktor. Beachten Sie, dass die Definition in Gleichung 3 impliziert, dass q(θ) berechnet wird, damit der Agent es weiß.

Bild

Bild

Angesichts dieser hinteren Überzeugungen verwenden wir Gleichung 2, um die Aktion S zu bestimmen, die von einem vollkommen rationalen Agenten gewählt wird, um seinen erwarteten Nutzen zu maximieren.

Das Computer-Framework des Autors bietet ein nützliches Werkzeug für die Entscheidungszusammenarbeit zwischen Mensch und künstlicher Intelligenz, das dabei helfen kann, das menschliche Entscheidungsverhalten und die Auswirkungen zu analysieren und zu verbessern sowie die Qualität und Zufriedenheit der menschlichen Entscheidungsfindung zu verbessern. Ihr Rechenrahmen bietet außerdem einen inspirierenden und innovativen Raum für die Erweiterung und Vertiefung von Entscheidungstheorien und -methoden und kann mehr Entscheidungsfaktoren und -mechanismen sowie mehr Entscheidungsmodelle und -strategien erforschen.

Bewertung menschlicher Leistungseinbußen bei der Entscheidungsfindung

Die Hauptmotivationen für die Verwendung des oben genannten Rahmenwerks sind erkenntnistheoretischer Natur und beziehen sich auf unser Wissen über experimentelle Ergebnisse. Um Reaktionen auf Entscheidungsprobleme in menschlichen Entscheidungsexperimenten als Beweis für fehlerhafte Entscheidungsprozesse zu interpretieren, muss das Experiment den Teilnehmern ausreichende Informationen liefern, um grundsätzlich die normativen Entscheidungen zu bestimmen, anhand derer ihr Verhalten beurteilt wird. Mit anderen Worten: Bietet das Experiment den Teilnehmern genügend Informationen, um ihr Verständnis des Entscheidungsproblems mit seiner normativen Interpretation in Einklang zu bringen?

Sie fanden heraus, dass neuronale Netzwerkmodelle bestehende psychologische Forschung reproduzieren und übertreffen können, wie etwa die Prospect-Theorie, umweltbasierte Modelle, Hybridmodelle usw. Das neuronale Netzwerkmodell kann basierend auf unterschiedlichen Annahmen automatisch verschiedene Risikowahrnehmungsfunktionen und die Gewichtungen zwischen ihnen lernen. Die Autoren stellten außerdem fest, dass die Funktionen der menschlichen Risikowahrnehmung nichtlinear und szenarioabhängig sind und dass zwischen Wahrscheinlichkeit und Rendite eine voneinander abhängige Beziehung besteht. Diese Ergebnisse verdeutlichen, dass menschliche Risikoentscheidungen äußerst komplex sind und nicht auf einfache Annahmen zurückgeführt werden können.

Die Autoren verwendeten eine einfache Metrik, um das Ausmaß des menschlichen Leistungsverlusts bei der Entscheidungsfindung zu messen, das ist der durchschnittliche Unterschied zwischen der menschlichen Entscheidung und der optimalen Wahl. Die Autoren stellten fest, dass der Leistungsverlust bei der menschlichen Entscheidungsfindung in den verschiedenen Szenarien erheblich schwankte und zwischen 0,01 und 0,5 lag. Die Autoren fanden außerdem heraus, dass der Verlust menschlicher Entscheidungskompetenz positiv mit dem Vorhersagefehler des neuronalen Netzwerkmodells korreliert, d. h. je schwieriger es für das neuronale Netzwerkmodell ist, menschliche Entscheidungen vorherzusagen, desto größer ist der Verlust menschlicher Fähigkeiten Entscheidungsleistung. Dies zeigt, dass das neuronale Netzwerkmodell die Merkmale der menschlichen Risikowahrnehmung sowie die Irrationalität und Inkonsistenz menschlicher Risikoentscheidungen effektiv erfassen kann.

Der Bewertungsrahmen des Autors bietet ein nützliches Werkzeug für die Entscheidungszusammenarbeit zwischen Menschen und künstlicher Intelligenz, das dabei helfen kann, menschliches Entscheidungsverhalten und -effekte zu analysieren und zu verbessern sowie die Qualität und Zufriedenheit der menschlichen Entscheidungsfindung zu verbessern. Der Bewertungsrahmen des Autors bietet außerdem einen inspirierenden und innovativen Raum für die Erweiterung und Vertiefung von Entscheidungstheorien und -methoden und ermöglicht die Erforschung weiterer Entscheidungsfaktoren und -mechanismen sowie weiterer Entscheidungsmodelle und -strategien.

Empirische Analyse und Ergebnisse

Die empirische Analyse dieser Arbeit kodiert und bewertet hauptsächlich die Forschung zu künstlicher Intelligenz-unterstützter Entscheidungsfindung in den letzten Jahren, um zu testen, ob diese Studien mit dem Rahmen der Entscheidungstheorie konsistent sind und ob sie für die menschliche Entscheidungsfindung von Nutzen sind. Es wurde eine vernünftige Schlussfolgerung über die Mängel oder Verluste gezogen. Der Autor wählte zufällig 46 Studien aus der Literaturrecherche von Lai et al. aus, die zwischen 2018 und 2021 auf ACM- oder ACL-Konferenzen veröffentlicht wurden und Experimente zur künstlichen Intelligenz-gestützten Entscheidungsfindung bei Klassifizierungs- oder Regressionsproblemen beinhalteten.

Die Autoren kodierten diese Studien nach den folgenden drei Aspekten.

Anwendbarkeit des entscheidungstheoretischen Rahmens: ob es einen realen Zustand gibt, der bestimmt werden kann, und ob mit dem Zustand ein Gewinn oder Verlust verbunden ist.

Bewertung menschlicher Entscheidungsfindung: Ob es eine Bewertung oder Beurteilung der Leistung oder Qualität menschlicher Entscheidungsfindung gibt, z. B. Hinweis auf das Phänomen der übermäßigen oder unzureichenden Abhängigkeit von künstlicher Intelligenz oder Spekulationen darüber Ursachen oder Einflussfaktoren menschlicher Entscheidungsfindung.

Klarheit des Entscheidungsproblems: Ob den Teilnehmern ausreichende Informationen zur Verfügung gestellt werden, um normative Entscheidungen zu identifizieren, einschließlich Aktionsraum, Zustandsraum, Bewertungsregeln, vorherige Überzeugungen, Datengenerierungsmodelle, Signalisierungsstrategien usw.

Die Kodierungsergebnisse des Autors zeigen, dass 11 Studien (24 %) Aufgaben haben, die keinen bestimmbaren realen Zustand haben, wie z. B. subjektive Musik- oder Filmempfehlung oder Emotionserkennung. Diese Studien sind nicht für den Rahmen der Entscheidungstheorie geeignet. Die verbleibenden 35 Studien (76 %) bewerteten oder beurteilten die Leistung oder Qualität menschlicher Entscheidungsfindung, aber nur 6 Studien (17 %) lieferten den Teilnehmern genügend Informationen, um normative Entscheidungen zu identifizieren, während die anderen 29 Studien (83 %) hatten unklare und unvollständige Entscheidungsprobleme, was zu unzuverlässigen Schlussfolgerungen über Vorurteile und Fehler in der menschlichen Entscheidungsfindung führte. Der Autor liefert auch eine detaillierte Analyse und Diskussion der spezifischen Probleme und Verbesserungsmethoden dieser Studien, wie z. B. mangelnde Kommunikation früherer Überzeugungen, mangelnde Berechnung späterer Überzeugungen, mangelnde Motivation und fehlender Vergleich der Bewertungsregeln usw. Der Autor ist der Ansicht, dass diese Probleme alle auf die unzureichende Definition und Kommunikation von Entscheidungsproblemen durch die Forscher sowie auf ihr unklares Verständnis der Beziehung zwischen der experimentellen Welt und der tatsächlichen Welt zurückzuführen sind. Der Autor empfiehlt, dass Forscher bei der Gestaltung von Experimenten den Rahmen der Entscheidungstheorie vollständig berücksichtigen und den Teilnehmern und Lesern alle notwendigen Komponenten des Entscheidungsproblems klar kommunizieren sollten, um das menschliche Entscheidungsverhalten effektiv zu bewerten und zu verbessern.

Zukünftige Arbeit

Die Einschränkungen dieses Papiers ergeben sich hauptsächlich aus den Herausforderungen und der Kritik an der Erwartungsnutzentheorie und normativen Methoden. Die Erwartungsnutzentheorie ist eine auf Rationalität und Optimierung basierende Entscheidungstheorie, die davon ausgeht, dass Entscheidungsträger über umfassende Informationen und Rechenleistung sowie konsistente und stabile Präferenzen verfügen. Allerdings treffen diese Annahmen in der realen Welt oft nicht zu. Das menschliche Entscheidungsverhalten kann durch kognitive, emotionale, soziale, moralische und andere Faktoren beeinflusst werden, was zu Abweichungen von den Vorhersagen der Erwartungsnutzentheorie führt. Der normative Ansatz ist ein werte- und zielbasierter Ansatz zur Entscheidungsfindung, der davon ausgeht, dass der Entscheidungsträger ein klares Wertziel und eine Möglichkeit hat, die Auswirkungen verschiedener Handlungen auf das Wertziel zu bewerten. Diese Annahmen treffen jedoch oft nicht auf die reale Welt zu, wo menschliche Werte vielfältig, dynamisch und mehrdeutig sein können und mit den Werten anderer Menschen oder der Gesellschaft in Konflikt stehen oder mit diesen harmonieren können. Daher sind der Rahmen und die Methoden dieses Papiers möglicherweise nicht für einige subjektive, komplexe und multiobjektive Entscheidungsprobleme geeignet und ignorieren möglicherweise auch den inhärenten Wert und die Bedeutung einiger menschlicher Entscheidungen.

Zukünftige Arbeiten werden vor allem in den folgenden vier Aspekten erweitert und vertieft.

Erkunden Sie andere Entscheidungstheorien und -methoden wie Verhaltensökonomie, Multi-Attribut-Utility-Theorie, Multi-Kriterien-Entscheidungsanalyse usw., um das tatsächliche Entscheidungsverhalten und die Präferenzen des Menschen besser zu beschreiben und zu bewerten.

Untersuchen Sie verschiedene Informationsanzeige- und Interaktionsmethoden wie natürliche Sprache, Grafiken, Ton, Berührung usw., um die verschiedenen Komponenten von Entscheidungsproblemen besser zu vermitteln und zu erklären und die menschlichen Informationsempfangs- und -verarbeitungsfähigkeiten zu verbessern .

Probieren Sie verschiedene Anreiz- und Feedbackmechanismen wie Belohnungen, Strafen, Glaubwürdigkeit, Reputation, sozialen Einfluss usw. aus, um die Motivation und Beteiligung der Menschen bei der Entscheidungsfindung besser zu stimulieren und aufrechtzuerhalten sowie das Lernen und Lernen der menschlichen Entscheidungsfindung zu verbessern Verbesserungsmöglichkeiten.

Erweitern Sie verschiedene KI- und menschliche Kooperationsmodi wie Unterstützung, Vorschlag, Agentur, Verhandlung, Koordination usw., um die Vor- und Nachteile von KI und Menschen besser auszugleichen und zu nutzen und die Leistung von KI und menschlichem Vertrauen zu verbessern und Zufriedenheit.

Bedeutung und Wert

Dieses Papier bietet Forschern in den Bereichen künstliche Intelligenz, Datenvisualisierung, Mensch-Computer-Interaktion und anderen Bereichen einen klaren und organisierten Rahmen für die Definition und Bewertung von Entscheidungsproblemen, um das Design zu verbessern und analysieren Sie Experimente zur Entscheidungszusammenarbeit zwischen menschlicher und künstlicher Intelligenz.

Bietet Forschern in den Bereichen künstliche Intelligenz, Datenvisualisierung, Mensch-Computer-Interaktion und anderen Bereichen eine objektive und strenge Methode zur Bewertung und Analyse von Leistungsverlusten bei der Entscheidungsfindung, um die Zusammenarbeit bei der Entscheidungsfindung zwischen Menschen und künstlicher Intelligenz besser zu identifizieren und zu verbessern Intelligenz, Wirkung und Qualität. Sie bieten eine kritische und reflektierende Perspektive auf die Kommunikation und Interpretation von Entscheidungsproblemen, um die Probleme und Herausforderungen der Zusammenarbeit von Mensch und KI bei der Entscheidungsfindung besser zu verstehen und zu kommunizieren. Sie bieten auch eine inspirierende und innovative Richtung zur Erweiterung und Vertiefung von Entscheidungsproblemen, um die Möglichkeiten und das Potenzial der Entscheidungszusammenarbeit zwischen Menschen und künstlicher Intelligenz besser zu erkunden und zu entdecken.

Zusammenfassung und Ausblick

Das Papier schlägt eine Definition von Entscheidungsproblemen auf der Grundlage statistischer Entscheidungstheorie und Informationsökonomie sowie einen Rahmen zur Bewertung des Verlusts menschlicher Entscheidungsleistung vor. Ihr Zweck besteht darin, Forschern in den Bereichen künstliche Intelligenz, Datenvisualisierung, Mensch-Computer-Interaktion und anderen Bereichen einen klaren und organisierten Leitfaden und eine Referenz zur Verfügung zu stellen, um Experimente zur Entscheidungszusammenarbeit zwischen Menschen und künstlicher Intelligenz besser zu entwerfen und zu analysieren. Sie kodierten und bewerteten relevante Studien der letzten Jahre und stellten fest, dass nur ein kleiner Teil der Studien den Teilnehmern ausreichende Informationen zur Identifizierung normativer Entscheidungen lieferte, während die meisten Studien unter unklaren und unvollständigen Entscheidungsproblemen litten, was zu Schlussfolgerungen über Vorurteile und Fehler bei menschlichen Entscheidungen führte. Herstellung sind unzuverlässig. Wir empfehlen Forschern, bei der Gestaltung von Experimenten den Rahmen der Entscheidungstheorie vollständig zu berücksichtigen und den Teilnehmern und Lesern alle notwendigen Komponenten des Entscheidungsproblems klar zu kommunizieren, um menschliches Entscheidungsverhalten effektiv zu bewerten und zu verbessern.

Der Autor ist sich auch der Einschränkungen des Rahmenwerks und der Methoden sowie der Notwendigkeit zukünftiger Arbeiten bewusst. Ihre Rahmenwerke und Methoden basieren auf der Erwartungsnutzentheorie und normativen Methoden, die auch einige Herausforderungen und Kritikpunkte mit sich bringen, wie zum Beispiel, dass sie nicht mit tatsächlichen menschlichen Entscheidungsverhaltensweisen und -präferenzen vereinbar sind und den intrinsischen Wert und die Bedeutung menschlicher Entscheidungsfindung ignorieren. Ihre Frameworks und Methoden sind möglicherweise auch für einige subjektive, komplexe, multiobjektive Entscheidungsprobleme nicht geeignet und decken möglicherweise nicht alle Möglichkeiten und Potenziale der Entscheidungszusammenarbeit zwischen Menschen und künstlicher Intelligenz ab. Daher besteht unsere zukünftige Arbeit hauptsächlich darin, die folgenden Aspekte zu erweitern und zu vertiefen: Erforschung anderer Entscheidungstheorien und -methoden, Untersuchung verschiedener Informationsanzeige- und Interaktionsmethoden, Untersuchung verschiedener Anreiz- und Feedbackmechanismen, Untersuchung verschiedener künstlicher Intelligenz und menschlicher Kooperationsmodi. (ENDE)

Referenz: https://arxiv.org/abs/2401.15106

Das obige ist der detaillierte Inhalt vonEntscheidungskollaboration zwischen Mensch und KI: Formulierung, Erklärung und Bewertung von Entscheidungsproblemen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laraveleloquent-Modellab Abruf: Das Erhalten von Datenbankdaten Eloquentorm bietet eine prägnante und leicht verständliche Möglichkeit, die Datenbank zu bedienen. In diesem Artikel werden verschiedene eloquente Modellsuchtechniken im Detail eingeführt, um Daten aus der Datenbank effizient zu erhalten. 1. Holen Sie sich alle Aufzeichnungen. Verwenden Sie die Methode All (), um alle Datensätze in der Datenbanktabelle zu erhalten: UseApp \ Models \ post; $ posts = post :: all (); Dies wird eine Sammlung zurückgeben. Sie können mit der Foreach-Schleife oder anderen Sammelmethoden auf Daten zugreifen: foreach ($ postas $ post) {echo $ post->