Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

LLaVA-1.6, das mit Gemini Pro gleichzieht und die Argumentations- und OCR-Fähigkeiten verbessert, ist zu leistungsstark

LLaVA-1.6, das mit Gemini Pro gleichzieht und die Argumentations- und OCR-Fähigkeiten verbessert, ist zu leistungsstark

LLaVA-1.6, das mit Gemini Pro gleichzieht und die Argumentations- und OCR-Fähigkeiten verbessert, ist zu leistungsstark

Im April letzten Jahres veröffentlichten Forscher der University of Wisconsin-Madison, Microsoft Research und der Columbia University gemeinsam LLaVA (Large Language and Vision Assistant). Obwohl LLaVA nur mit einem kleinen multimodalen Befehlsdatensatz trainiert wird, zeigt es bei einigen Proben sehr ähnliche Inferenzergebnisse wie GPT-4. Im Oktober brachten sie dann LLaVA-1.5 auf den Markt, das den SOTA in 11 Benchmarks mit einfachen Modifikationen am ursprünglichen LLaVA aktualisierte. Die Ergebnisse dieses Upgrades sind sehr aufregend und bringen neue Durchbrüche auf dem Gebiet der multimodalen KI-Assistenten.

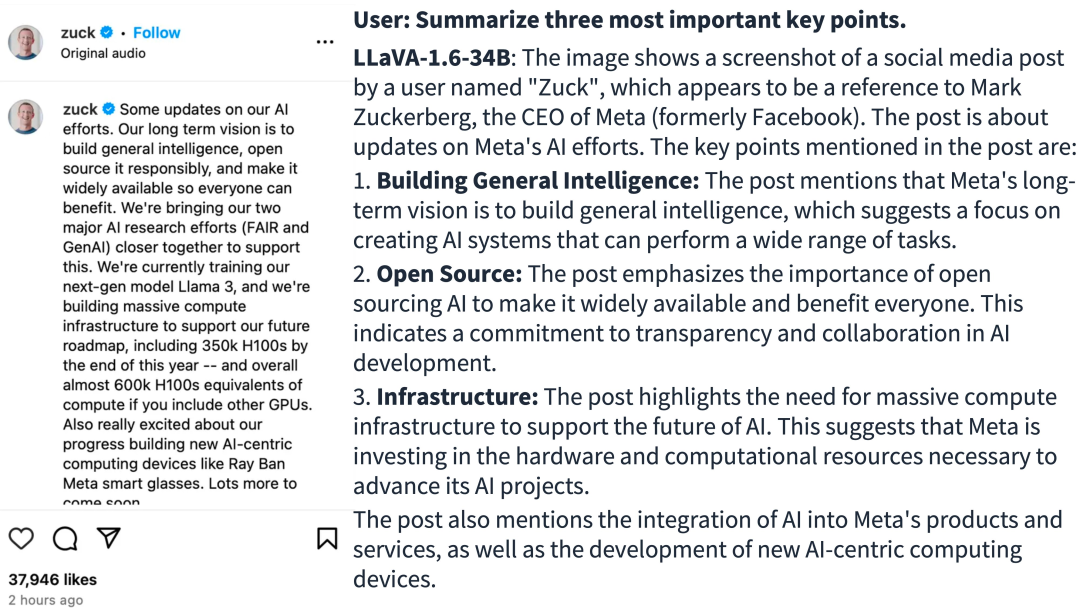

Das Forschungsteam kündigte die Einführung der LLaVA-1.6-Version an, die zu erheblichen Leistungsverbesserungen in den Bereichen Argumentation, OCR und Weltwissen geführt hat. Diese Version von LLaVA-1.6 übertrifft in mehreren Benchmarks sogar den Gemini Pro.

- Demo-Adresse: https://llava.hliu.cc/

- Projektadresse: https://github.com/haotian-liu/LLaVA

Im Vergleich zu LLaVA-1.5 weist LLaVA-1.6 die folgenden Verbesserungen auf:

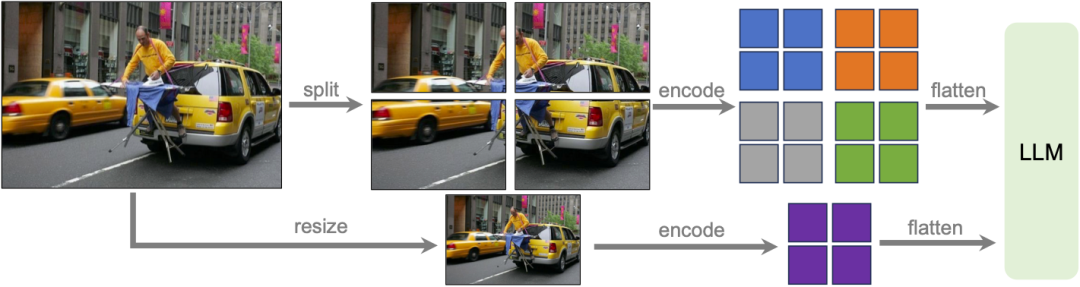

- Erhöht die Auflösung des Eingabebilds um das Vierfache, unterstützt drei Seitenverhältnisse, bis zu 672x672, 336x1344, 1344x336 Auflösung. Dadurch kann LLaVA-1.6 mehr visuelle Details erfassen.

- LLaVA-1.6 erhält bessere visuelle Argumentation und OCR-Fähigkeiten durch verbesserte visuelle Anweisungen zur Anpassung der Datenmischung.

- Bessere visuelle Dialoge, mehr Szenen, die verschiedene Anwendungen abdecken. LLaVA-1.6 beherrscht mehr Weltwissen und verfügt über bessere logische Denkfähigkeiten.

- Verwenden Sie SGLang für eine effiziente Bereitstellung und Inferenz.

Bildquelle: https://twitter.com/imhaotian/status/1752621754273472927

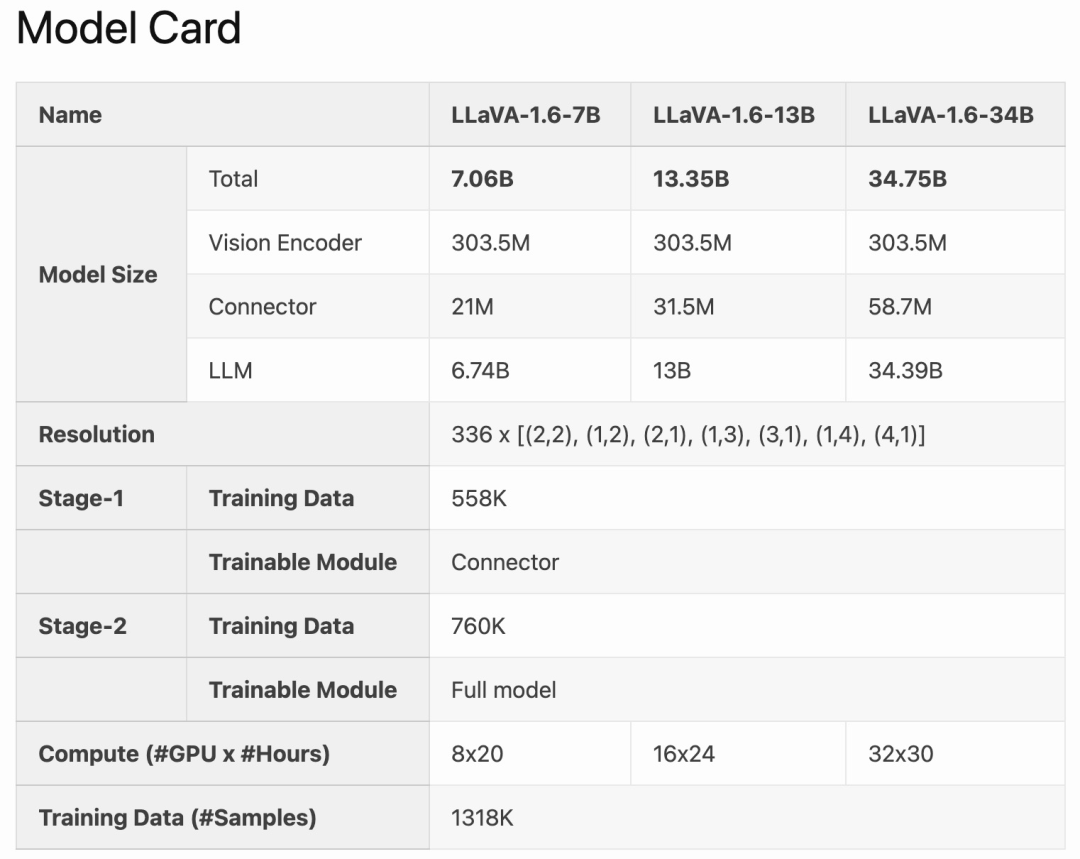

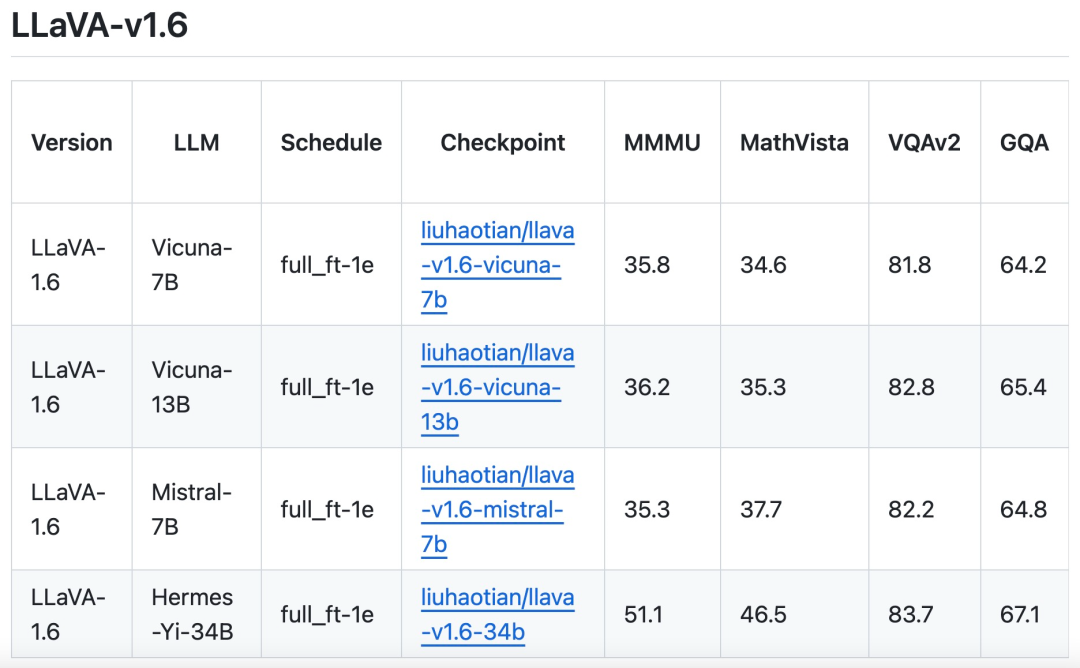

LLaVA-1.6 ist auf Basis von LLaVA-1.5 verfeinert und optimiert. Es behält das einfache Design und die effizienten Datenverarbeitungsfunktionen von LLaVA-1.5 bei und verwendet weiterhin weniger als 1 Million visuelle Befehlsoptimierungsbeispiele. Durch den Einsatz von 32 A100-Grafikkarten wurde das größte 34B-Modell in etwa einem Tag trainiert. Darüber hinaus nutzt LLaVA-1.6 1,3 Millionen Datenproben und die Kosten für Rechen-/Trainingsdaten betragen nur das 100- bis 1000-fache der Kosten anderer Methoden. Diese Verbesserungen machen LLaVA-1.6 zu einer effizienteren und kostengünstigeren Version.

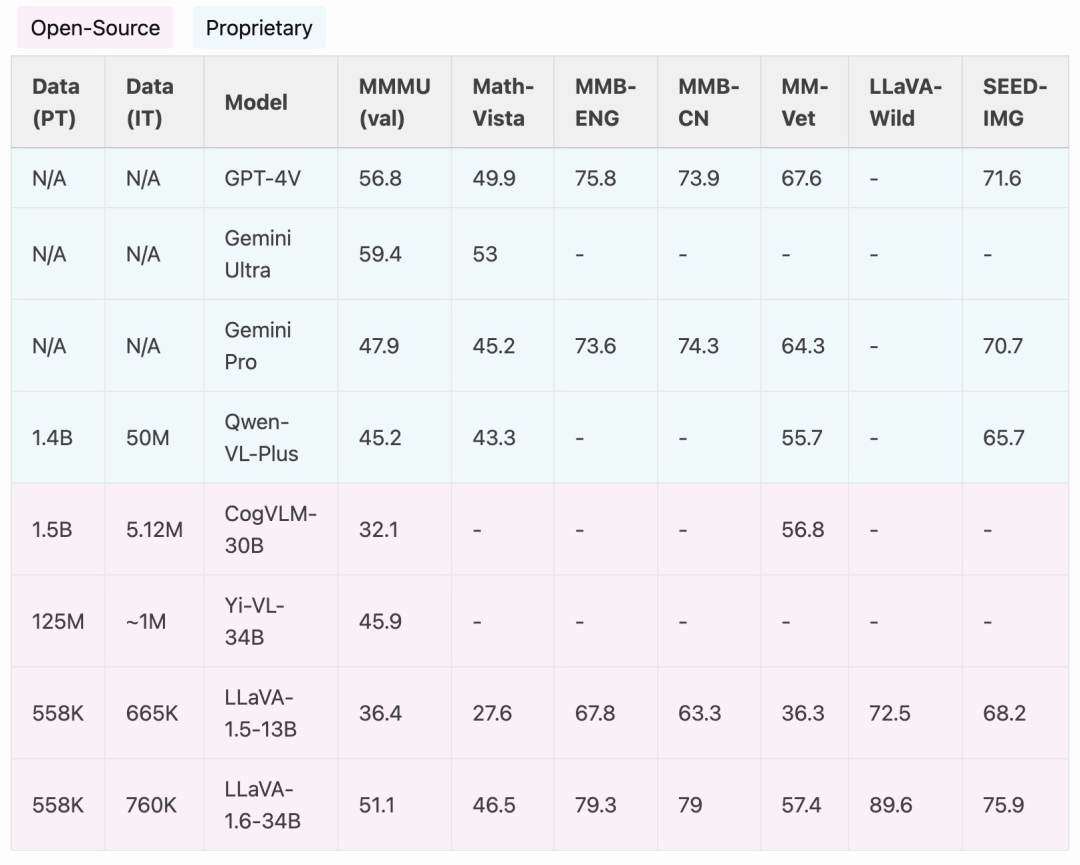

Im Vergleich zu Open-Source-LMMs wie CogVLM oder Yi-VL erreicht LLaVA-1.6 SOTA-Leistung. Im Vergleich zu kommerziellen Produkten ist LLaVA-1.6 mit Gemini Pro vergleichbar und in ausgewählten Benchmarks besser als Qwen-VL-Plus.

Es ist erwähnenswert, dass LLaVA-1.6 starke chinesische Zero-Shot-Fähigkeiten aufweist und SOTA-Leistung beim multimodalen Benchmark MMBench-CN erreicht.

Methodenverbesserungen

Dynamische hohe Auflösung

Das Forschungsteam hat das LLaVA-1.6-Modell mit hoher Auflösung entworfen, um seine Dateneffizienz aufrechtzuerhalten. Durch die Bereitstellung hochauflösender Bilder und detailgetreuer Darstellungen verbessert sich die Fähigkeit des Modells, komplexe Details in Bildern wahrzunehmen, deutlich. Es reduziert die Halluzination des Modells, wenn es mit Bildern mit niedriger Auflösung konfrontiert wird, d. h. das Erraten des imaginären visuellen Inhalts.

Datenmischung

Hochwertige Benutzeranweisungsdaten. Die in der Studie definierte Definition qualitativ hochwertiger visueller Anweisungen zur Befolgung von Daten hängt von zwei Hauptkriterien ab: erstens von der Vielfalt der Aufgabenanweisungen, die eine angemessene Darstellung des breiten Spektrums an Benutzerabsichten gewährleisten, die in realen Szenarien, insbesondere während, auftreten können die Modellbereitstellungsphase. Zweitens ist die Priorisierung der Antworten von entscheidender Bedeutung, um positives Benutzerfeedback einzuholen.

Daher wurden in der Studie zwei Datenquellen berücksichtigt:

Vorhandene GPT-V-Daten (LAION-GPT-V und ShareGPT-4V);

Um einen besseren visuellen Dialog in mehr Szenarien weiter zu fördern, sammelte das Forschungsteam einen kleinen 15K-Datensatz zur Optimierung visueller Anweisungen, der verschiedene Anwendungen abdeckte, sorgfältig gefilterte Proben, die möglicherweise Datenschutzprobleme haben oder schädlich sein könnten, und generierte mithilfe von GPT-4V eine Reaktion.

Multimodale Dokument-/Diagrammdaten. (1) Entfernen Sie TextCap aus den Trainingsdaten, da das Forschungsteam erkannt hat, dass TextCap denselben Trainingsbildsatz wie TextVQA verwendet. Dies ermöglichte es dem Forschungsteam, die Zero-Shot-OCR-Fähigkeiten des Modells bei der Bewertung von TextVQA besser zu verstehen. Um die OCR-Fähigkeiten des Modells aufrechtzuerhalten und weiter zu verbessern, wurde in dieser Studie TextCap durch DocVQA und SynDog-EN ersetzt. (2) Mit Qwen-VL-7B-Chat fügt diese Studie außerdem ChartQA, DVQA und AI2D hinzu, um Diagramme und Diagramme besser zu verstehen.

Das Forschungsteam gab außerdem an, dass es zusätzlich zu Vicuna-1.5 (7B und 13B) auch die Einführung weiterer LLM-Lösungen in Betracht zieht, darunter Mistral-7B und Nous-Hermes-2-Yi-34B, um LLaVA zu ermöglichen Unterstützen Sie ein breiteres Benutzerspektrum und mehr Szenen.

Das obige ist der detaillierte Inhalt vonLLaVA-1.6, das mit Gemini Pro gleichzieht und die Argumentations- und OCR-Fähigkeiten verbessert, ist zu leistungsstark. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Kürzlich wurde die Militärwelt von der Nachricht überwältigt: US-Militärkampfflugzeuge können jetzt mithilfe von KI vollautomatische Luftkämpfe absolvieren. Ja, erst kürzlich wurde der KI-Kampfjet des US-Militärs zum ersten Mal der Öffentlichkeit zugänglich gemacht und sein Geheimnis gelüftet. Der vollständige Name dieses Jägers lautet „Variable Stability Simulator Test Aircraft“ (VISTA). Er wurde vom Minister der US-Luftwaffe persönlich geflogen, um einen Eins-gegen-eins-Luftkampf zu simulieren. Am 2. Mai startete US-Luftwaffenminister Frank Kendall mit einer X-62AVISTA auf der Edwards Air Force Base. Beachten Sie, dass während des einstündigen Fluges alle Flugaktionen autonom von der KI durchgeführt wurden! Kendall sagte: „In den letzten Jahrzehnten haben wir über das unbegrenzte Potenzial des autonomen Luft-Luft-Kampfes nachgedacht, aber es schien immer unerreichbar.“ Nun jedoch,