Mistral-Medium ist versehentlich ausgelaufen? Bisher nur über die API verfügbar, Leistung kommt GPT-4 nahe.

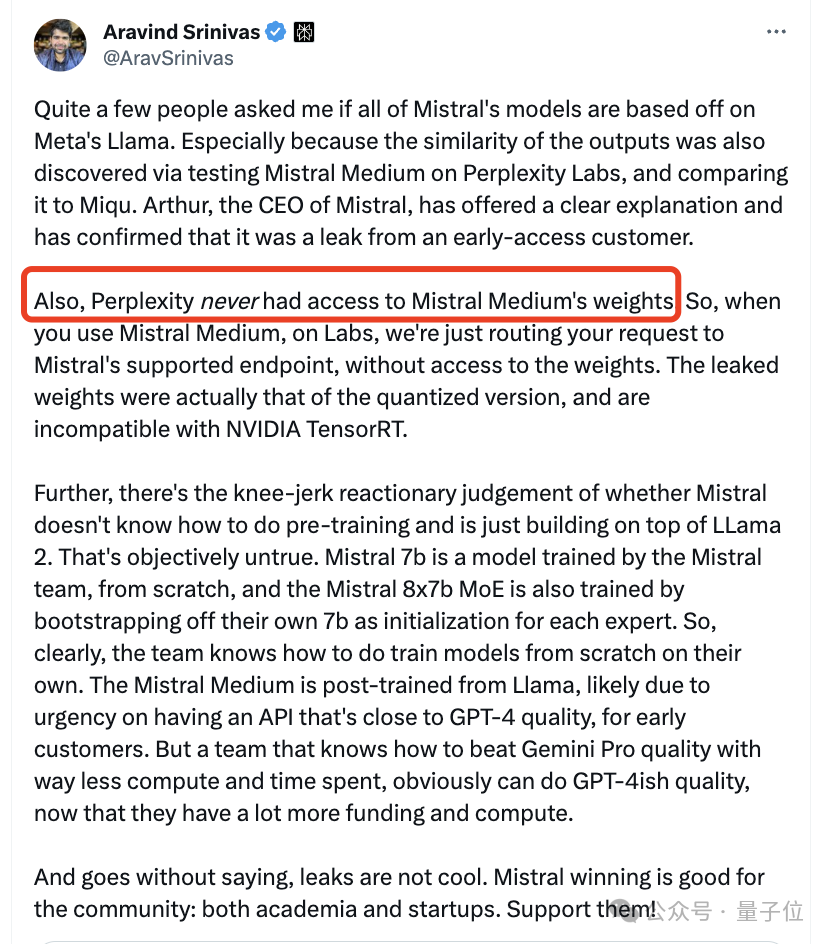

Die neueste Aussage des CEO: Es stimmt, es wurde von einem frühen Kundenmitarbeiter durchgesickert. Aber immer noch gesagt: Bleiben Sie dran.

Bilder

Bilder

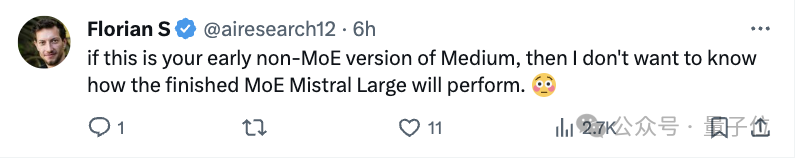

Mit anderen Worten, diese Version ist noch alt und die tatsächliche Leistung der Version wird besser sein.

In den letzten zwei Tagen ist dieses mysteriöse Model namens „Miqu“ zu einem heißen Thema in der großen Model-Community geworden. Viele Leute vermuten auch, dass es sich hierbei um eine verfeinerte Version von LIama handelt.

Bilder

Bilder

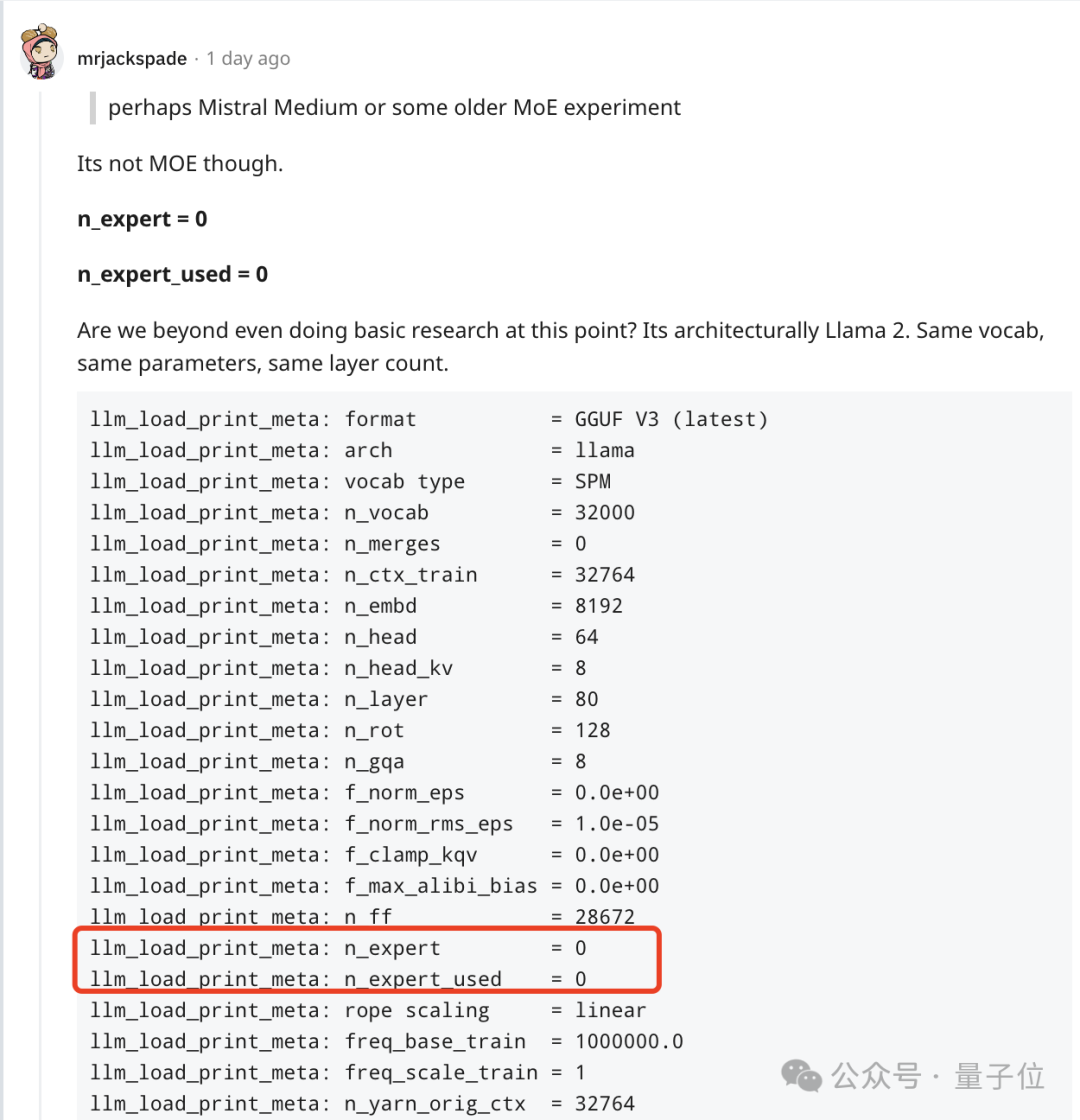

Der CEO von Mistral erklärte, dass sie Mistral Medium umgeschult und es basierend auf Llama 2 verbessert haben. Dies dient dazu, frühen Kunden so schnell wie möglich eine API bereitzustellen, die der Leistung von GPT-4 nahe kommt. Die Vorbereitungsarbeiten wurden am Tag der Freigabe von Mistral 7B abgeschlossen.

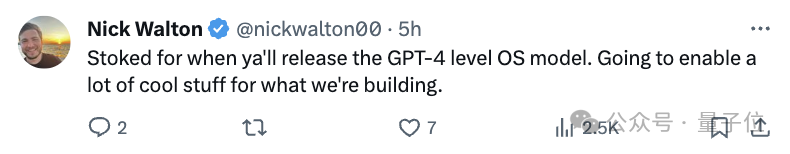

Nachdem die Wahrheit ans Licht gekommen ist, hält sich der CEO immer noch geheim und viele Internetnutzer stechen erwartungsvoll in die Hände.

Bilder

Bilder

Bilder

Bilder

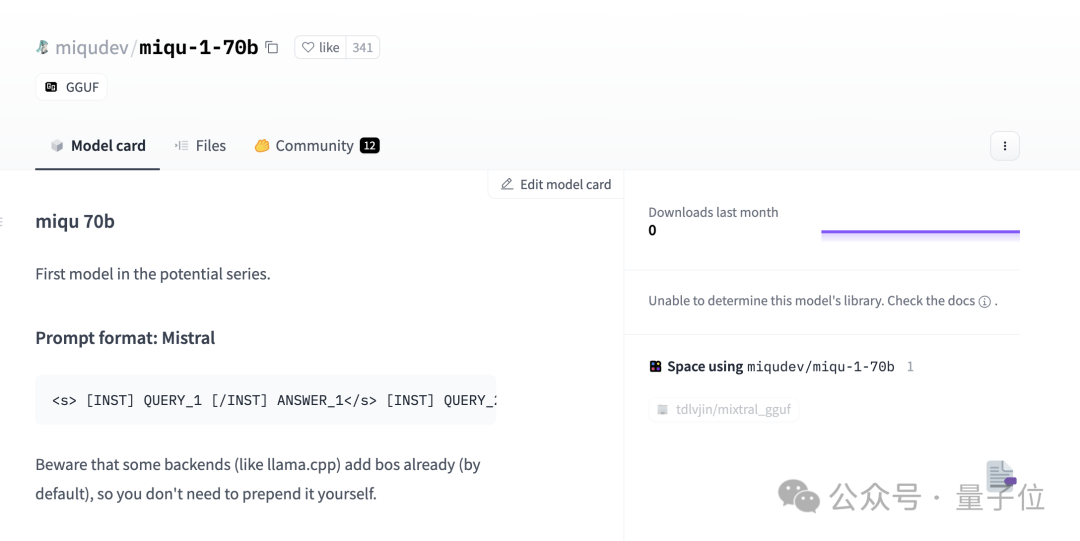

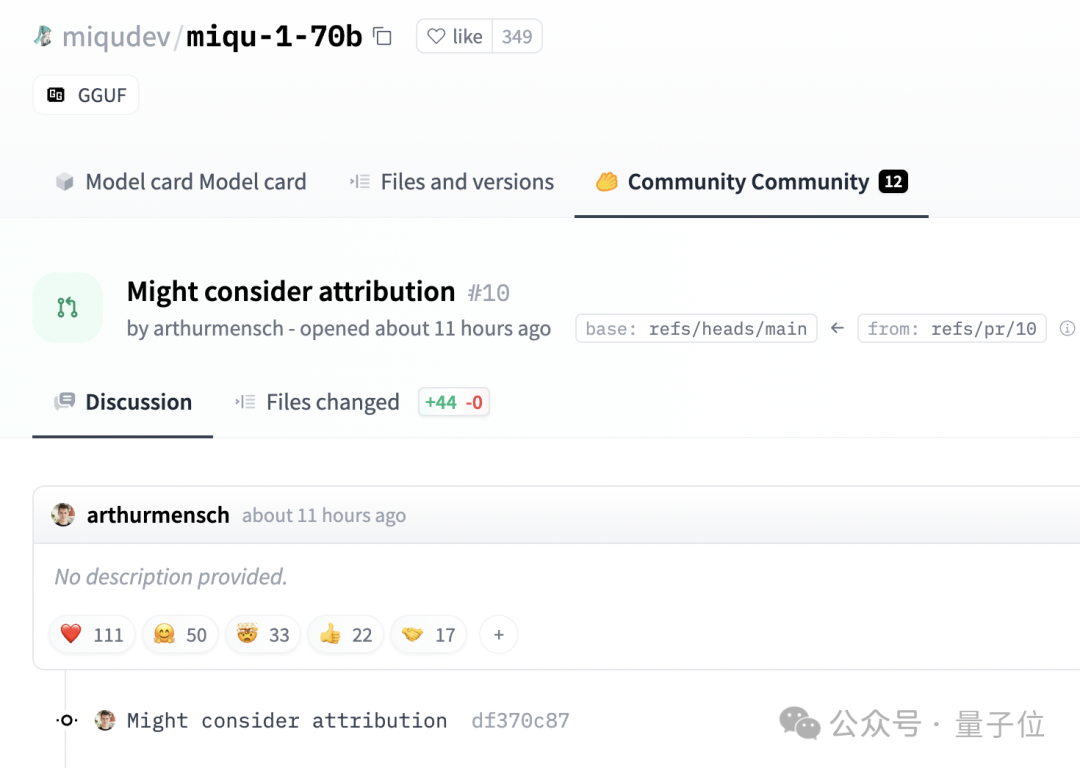

Lassen Sie uns den gesamten Vorfall noch einmal Revue passieren lassen. Am 28. Januar veröffentlichte ein mysteriöser Benutzer namens Miqu Dev eine Reihe von Dateien „miqu-1-70b“ auf HuggingFace.

Bilder

Bilder

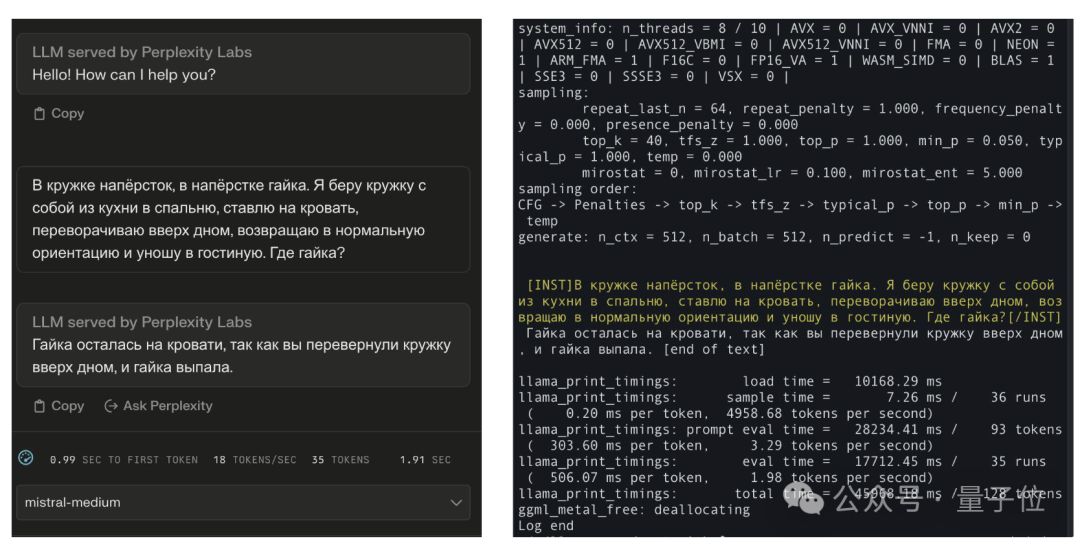

Das Dokument besagt, dass das „Eingabeaufforderungsformat“ und die Benutzerinteraktionsmethoden des neuen LLM mit denen von Mistral identisch sind.

Am selben Tag veröffentlichte ein anonymer Benutzer auf 4chan einen Link zur miqu-1-70b-Datei.

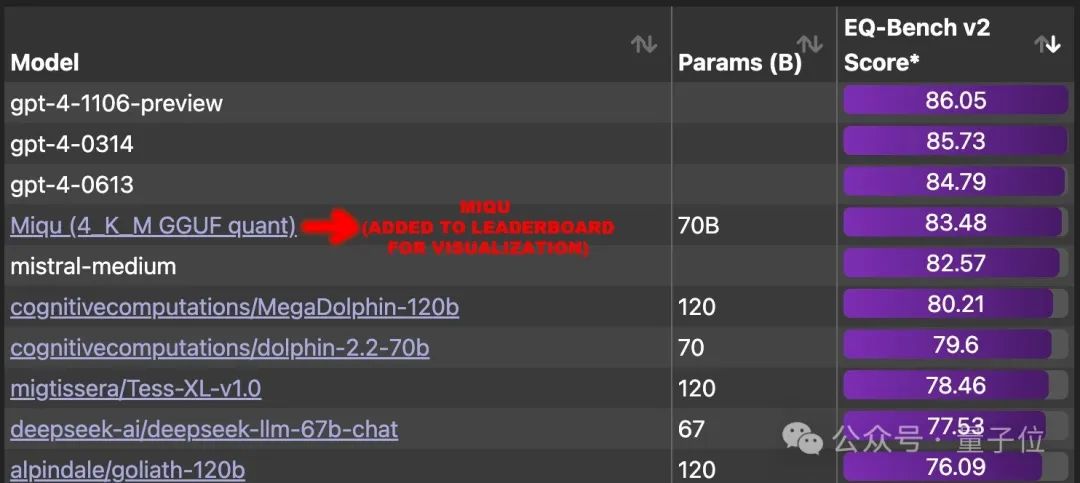

Einige Internetnutzer bemerkten dieses mysteriöse Modell und begannen, einige Benchmark-Tests durchzuführen.

Die Ergebnisse sind erstaunlich, es erreicht im EQ-Bench (lokale Bewertung) einen Wert von 83,5 und übertrifft damit alle anderen großen Modelle der Welt außer GPT-4.

Eine Zeit lang forderten Internetnutzer dringend, dieses große Modell in die Rangliste aufzunehmen und herauszufinden, welches wahre Modell dahinter steckt. Es gibt drei Hauptverdachtsrichtungen: Bilder

Bilder

Bilder

Bilder

Mistral-Modell der frühen Nicht-MoE-Version.

Bilder

Bilder

Bilder

Bilder

Bilder

Bilder

Bilder

Bilder

Interessanterweise hat Mensch nicht darum gebeten, dass der Beitrag auf HuggingFace entfernt wird.

Bilder

Bilder

Hinterlassen Sie stattdessen einen Kommentar mit dem Text: Namensnennungsprobleme können berücksichtigt werden.

Referenzlinks:

[1]https://www.reddit.com/r/LocalLLaMA/comments/1af4fbg/llm_comparisontest_miqu170b/

[2]https://twitter.com/teortaxesTex/status/1752427812466593975

[3]https://twitter.com/N8Programs/status/1752441060133892503

[4]https://twitter.com/AravSrinivas/status/1752803571035504858

Das obige ist der detaillierte Inhalt vonEin mit GPT-4 vergleichbares Open-Source-Modell ist durchgesickert! Der Mistral-Chef hat gerade bestätigt: Die offizielle Version wird noch stärker sein. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Lösungen für unbekannte Software-Ausnahmen in Computeranwendungen

Lösungen für unbekannte Software-Ausnahmen in Computeranwendungen

Komplementalgorithmus für negative Zahlen

Komplementalgorithmus für negative Zahlen

Verwendung der Rowcount-Funktion

Verwendung der Rowcount-Funktion

Datenbank-Er-Diagramm

Datenbank-Er-Diagramm

So überprüfen Sie tote Links auf Websites

So überprüfen Sie tote Links auf Websites

So stellen Sie aus dem Papierkorb geleerte Dateien wieder her

So stellen Sie aus dem Papierkorb geleerte Dateien wieder her

Die Rolle der klonbaren Schnittstelle

Die Rolle der klonbaren Schnittstelle

So verwenden Sie die magnetische Btbook-Suche

So verwenden Sie die magnetische Btbook-Suche