Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

selten! Wird Apples Open-Source-Bildbearbeitungstool MGIE auf dem iPhone verfügbar sein?

selten! Wird Apples Open-Source-Bildbearbeitungstool MGIE auf dem iPhone verfügbar sein?

selten! Wird Apples Open-Source-Bildbearbeitungstool MGIE auf dem iPhone verfügbar sein?

Ein Foto aufnehmen, einen Textbefehl eingeben und Ihr Telefon beginnt automatisch mit der Retusche des Fotos?

Diese magische Funktion stammt von Apples neuem Open-Source-Bildbearbeitungstool „MGIE“.

Entfernen Sie Personen im Hintergrund.

Pizza auf dem Tisch hinzufügen. Einerseits kann KI durch multimodale große Modelle (MLLM) Bilder als Eingabe nehmen und visuelle Wahrnehmungsreaktionen bereitstellen, wodurch eine natürlichere Bildbearbeitung erreicht wird. Andererseits sorgt die anweisungenbasierte Bearbeitungstechnologie dafür, dass der Bearbeitungsprozess nicht mehr auf detaillierte Beschreibungen oder Bereichsmasken angewiesen ist, sondern ermöglicht es Benutzern, direkt Anweisungen zu erteilen, um Bearbeitungsmethoden und -ziele auszudrücken. Diese Methode ist sehr praktisch, da sie eher der intuitiven Art des Menschen entspricht. Durch diese innovativen Technologien wird KI nach und nach zum rechten Assistenten der Menschen im Bereich der Bildbearbeitung.

Basierend auf der Inspiration der oben genannten Technologie schlug Apple MGIE (MLLM-Guided Image Editing) vor und nutzte MLLM, um das Problem unzureichender Anleitungsanweisungen zu lösen.

Papiertitel: Guiding Instruction-based Image Editing via Multimodal Large Language Models

Papiertitel: Guiding Instruction-based Image Editing via Multimodal Large Language Models

- Papierlink: https://openreview.net/pdf?id=S1RKWSyZ2Y

- Projekthomepage: https ://mllm-ie.github.io/

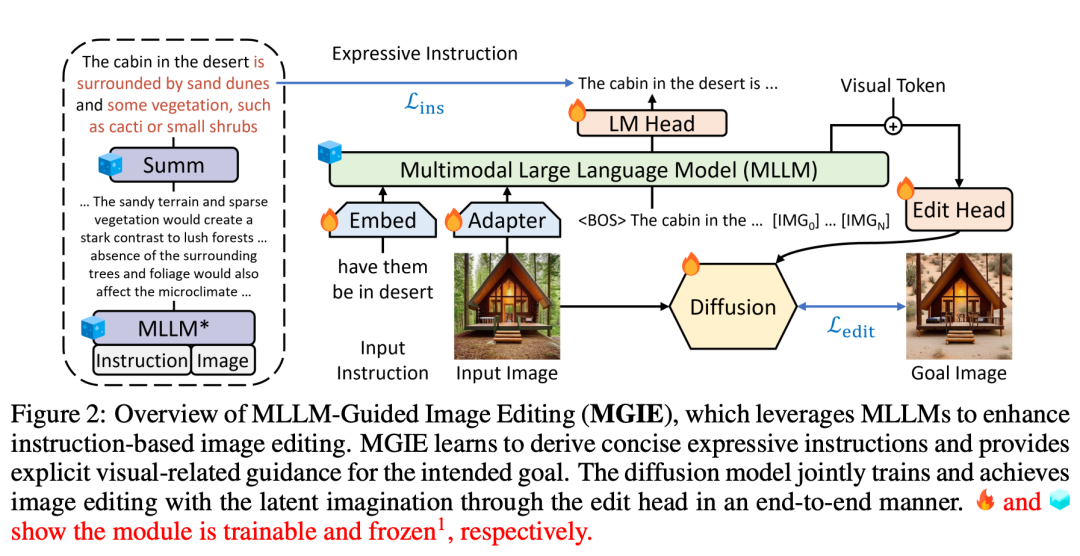

- MGIE (Mind-Guided Image Editing) besteht aus MLLM (Mind-Language Linking Model) und Diffusionsmodell, wie in Abbildung 2 dargestellt. MLLM lernt, sich prägnante Ausdrucksanweisungen anzueignen und bietet klare, visuell relevante Anleitungen. Das Diffusionsmodell führt die Bildbearbeitung unter Verwendung der latenten Vorstellungskraft des beabsichtigten Ziels durch und wird durch End-to-End-Training synchron aktualisiert. Auf diese Weise kann MGIE von der inhärenten visuellen Ableitung profitieren und mehrdeutige menschliche Anweisungen auflösen, was zu einer sinnvollen Bearbeitung führt.

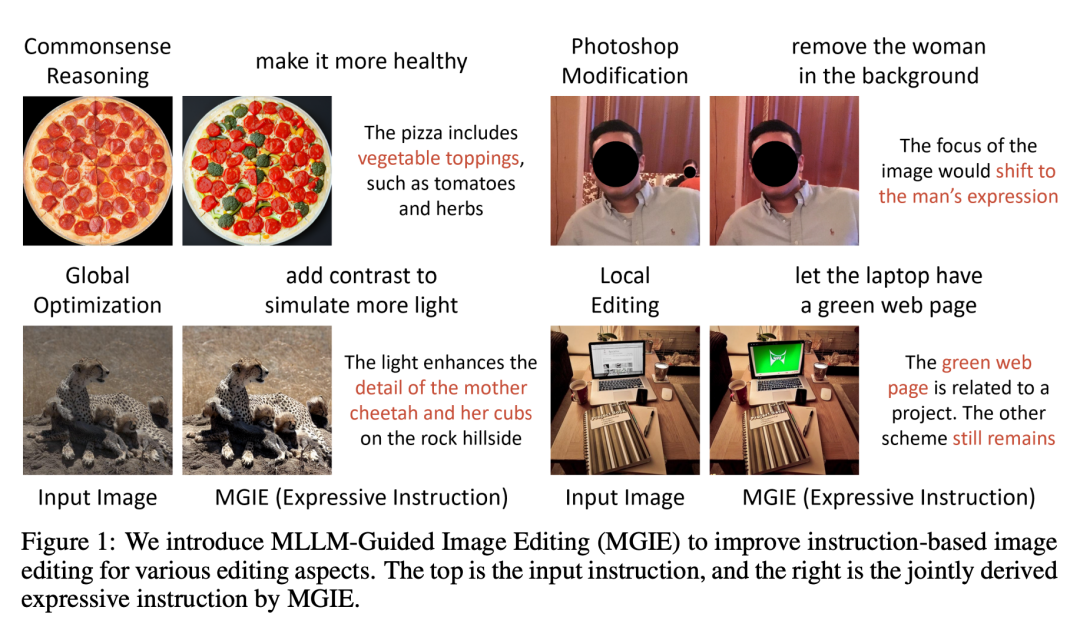

Anleitung durch menschliche Anweisungen kann MGIE Photoshop-ähnliche Modifikationen, globale Fotooptimierung und lokale Objektmodifikationen durchführen. Nehmen Sie das Bild unten als Beispiel. Es ist schwierig, die Bedeutung von „gesund“ ohne zusätzlichen Kontext zu erfassen, aber MGIE kann „Gemüsebelag“ genau mit Pizza in Verbindung bringen und es entsprechend den menschlichen Erwartungen bearbeiten.

Anleitung durch menschliche Anweisungen kann MGIE Photoshop-ähnliche Modifikationen, globale Fotooptimierung und lokale Objektmodifikationen durchführen. Nehmen Sie das Bild unten als Beispiel. Es ist schwierig, die Bedeutung von „gesund“ ohne zusätzlichen Kontext zu erfassen, aber MGIE kann „Gemüsebelag“ genau mit Pizza in Verbindung bringen und es entsprechend den menschlichen Erwartungen bearbeiten.

Das erinnert uns an den „Ehrgeiz“, den Cook vor nicht allzu langer Zeit in der Telefonkonferenz zum Ausdruck brachte: „Ich denke, Apple hat große Chancen in der generativen KI, aber mehr möchte ich nicht sagen.“ Details.“ Zu den von ihm offengelegten Informationen gehört, dass Apple aktiv generative KI-Softwarefunktionen entwickelt und diese Funktionen später im Jahr 2024 für Kunden verfügbar sein werden.

Das erinnert uns an den „Ehrgeiz“, den Cook vor nicht allzu langer Zeit in der Telefonkonferenz zum Ausdruck brachte: „Ich denke, Apple hat große Chancen in der generativen KI, aber mehr möchte ich nicht sagen.“ Details.“ Zu den von ihm offengelegten Informationen gehört, dass Apple aktiv generative KI-Softwarefunktionen entwickelt und diese Funktionen später im Jahr 2024 für Kunden verfügbar sein werden.

In Kombination mit einer Reihe theoretischer Forschungsergebnisse zur generativen KI, die Apple in letzter Zeit veröffentlicht hat, scheinen wir uns auf die neuen KI-Funktionen zu freuen, die Apple als nächstes veröffentlichen wird.

Papierdetails

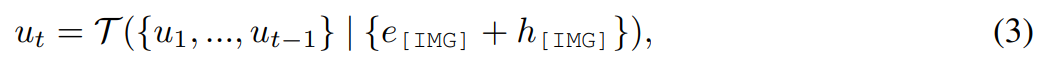

Die in dieser Studie vorgeschlagene MGIE-Methode kann das Eingabebild V durch eine gegebene Anweisung X in ein Zielbild  umwandeln. Für diese ungenauen Anweisungen führt MLLM in MGIE eine Lernableitung durch, um präzise Ausdrucksanweisungen ε zu erhalten. Um eine Brücke zwischen Sprache und visuellen Modalitäten zu schlagen, fügten die Forscher nach ε außerdem ein spezielles Token [IMG] hinzu und verwendeten den Bearbeitungskopf (Edit Head)

umwandeln. Für diese ungenauen Anweisungen führt MLLM in MGIE eine Lernableitung durch, um präzise Ausdrucksanweisungen ε zu erhalten. Um eine Brücke zwischen Sprache und visuellen Modalitäten zu schlagen, fügten die Forscher nach ε außerdem ein spezielles Token [IMG] hinzu und verwendeten den Bearbeitungskopf (Edit Head)  , um sie umzuwandeln. Die transformierten Informationen dienen im MLLM als zugrunde liegende visuelle Vorstellungskraft und steuern das Diffusionsmodell, um die gewünschten Bearbeitungsziele zu erreichen. MGIE ist dann in der Lage, visuell ansprechende Fuzzy-Befehle zu verstehen, um eine sinnvolle Bildbearbeitung durchzuführen (das Architekturdiagramm ist in Abbildung 2 oben dargestellt).

, um sie umzuwandeln. Die transformierten Informationen dienen im MLLM als zugrunde liegende visuelle Vorstellungskraft und steuern das Diffusionsmodell, um die gewünschten Bearbeitungsziele zu erreichen. MGIE ist dann in der Lage, visuell ansprechende Fuzzy-Befehle zu verstehen, um eine sinnvolle Bildbearbeitung durchzuführen (das Architekturdiagramm ist in Abbildung 2 oben dargestellt).

Durch die Ausrichtung von Funktionen und die Anpassung von Anweisungen ist MLLM in der Lage, visuell relevante Antworten über modale Wahrnehmungen hinweg bereitzustellen. Für die Bildbearbeitung verwendet die Studie die Eingabeaufforderung „Wie wird dieses Bild aussehen, wenn [Anweisung]“ als Spracheingabe für das Bild und leitet detaillierte Erläuterungen zu den Bearbeitungsbefehlen ab. Allerdings sind diese Erklärungen oft zu langwierig und täuschen sogar die Absicht des Benutzers vor. Um eine prägnantere Beschreibung zu erhalten, wendet diese Studie einen vorab trainierten Summierer an, damit MLLM lernen kann, eine zusammenfassende Ausgabe zu generieren. Dieser Prozess lässt sich wie folgt zusammenfassen:

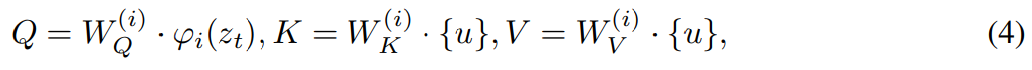

Die Studie verwendet einen Bearbeitungskopf

, um [IMG] in tatsächliche visuelle Anleitung umzuwandeln. wobei  ein Sequenz-zu-Sequenz-Modell ist, das kontinuierliche visuelle Token von MLLM semantisch bedeutsamen latenten U = {u_1, u_2, ..., u_L} zuordnet und als redaktioneller Leitfaden dient:

ein Sequenz-zu-Sequenz-Modell ist, das kontinuierliche visuelle Token von MLLM semantisch bedeutsamen latenten U = {u_1, u_2, ..., u_L} zuordnet und als redaktioneller Leitfaden dient:

Um den Prozess der Steuerung der Bildbearbeitung durch visuelle Vorstellungskraft U zu erreichen, erwägt diese Studie die Verwendung eines Diffusionsmodells

Um den Prozess der Steuerung der Bildbearbeitung durch visuelle Vorstellungskraft U zu erreichen, erwägt diese Studie die Verwendung eines Diffusionsmodells

, das zwar einen Variational Autoencoder (VAE) einschließt, aber auch die Entrauschungsdiffusion im Latentraumproblem lösen kann.

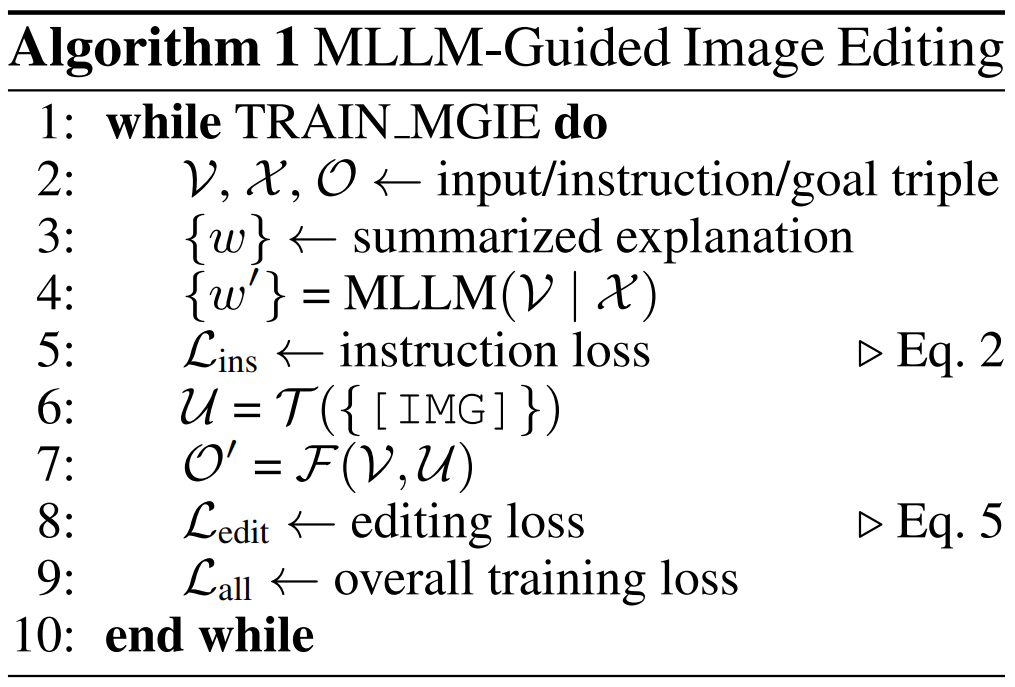

Algorithmus 1 zeigt den MGIE-Lernprozess. MLLM leitet kompakte Anweisungen ε über Befehlsverluste L_ins ab. Mit der zugrunde liegenden Vorstellungskraft von [IMG] transformiert

Algorithmus 1 zeigt den MGIE-Lernprozess. MLLM leitet kompakte Anweisungen ε über Befehlsverluste L_ins ab. Mit der zugrunde liegenden Vorstellungskraft von [IMG] transformiert

seine Modalität und führt  , um das resultierende Bild zu synthetisieren. Der Bearbeitungsverlust L_edit wird für das Diffusionstraining verwendet. Da die meisten Gewichte eingefroren werden können (Selbstaufmerksamkeitsblock innerhalb von MLLM), wird ein parametereffizientes End-to-End-Training erreicht.

, um das resultierende Bild zu synthetisieren. Der Bearbeitungsverlust L_edit wird für das Diffusionstraining verwendet. Da die meisten Gewichte eingefroren werden können (Selbstaufmerksamkeitsblock innerhalb von MLLM), wird ein parametereffizientes End-to-End-Training erreicht.

Experimentelle Auswertung

Experimentelle Auswertung

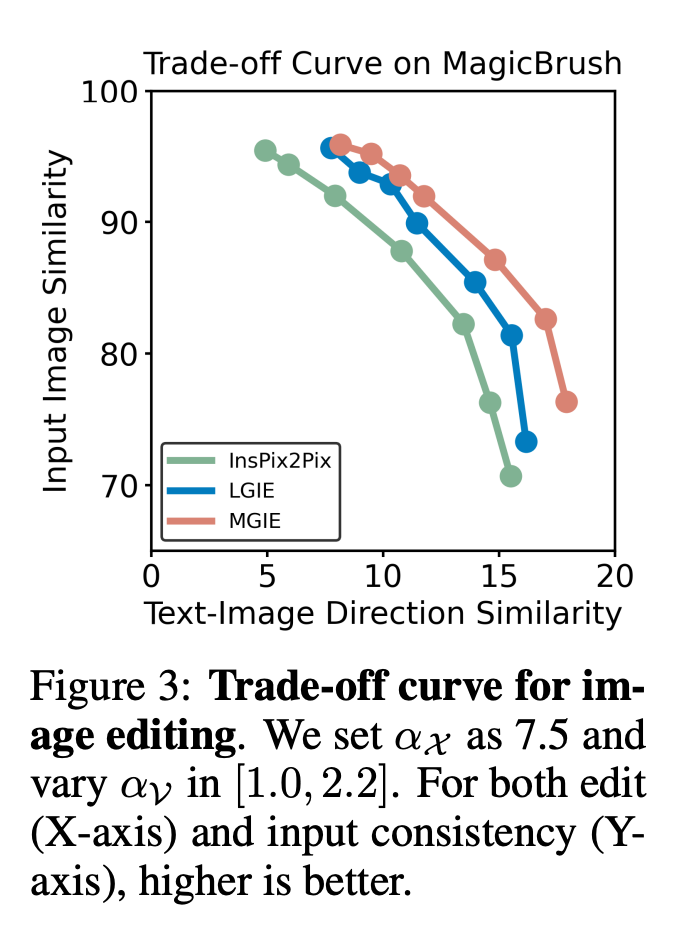

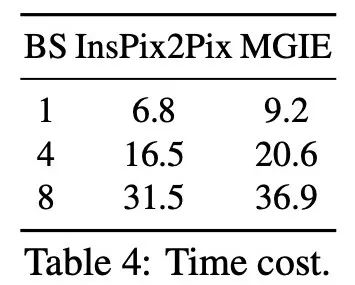

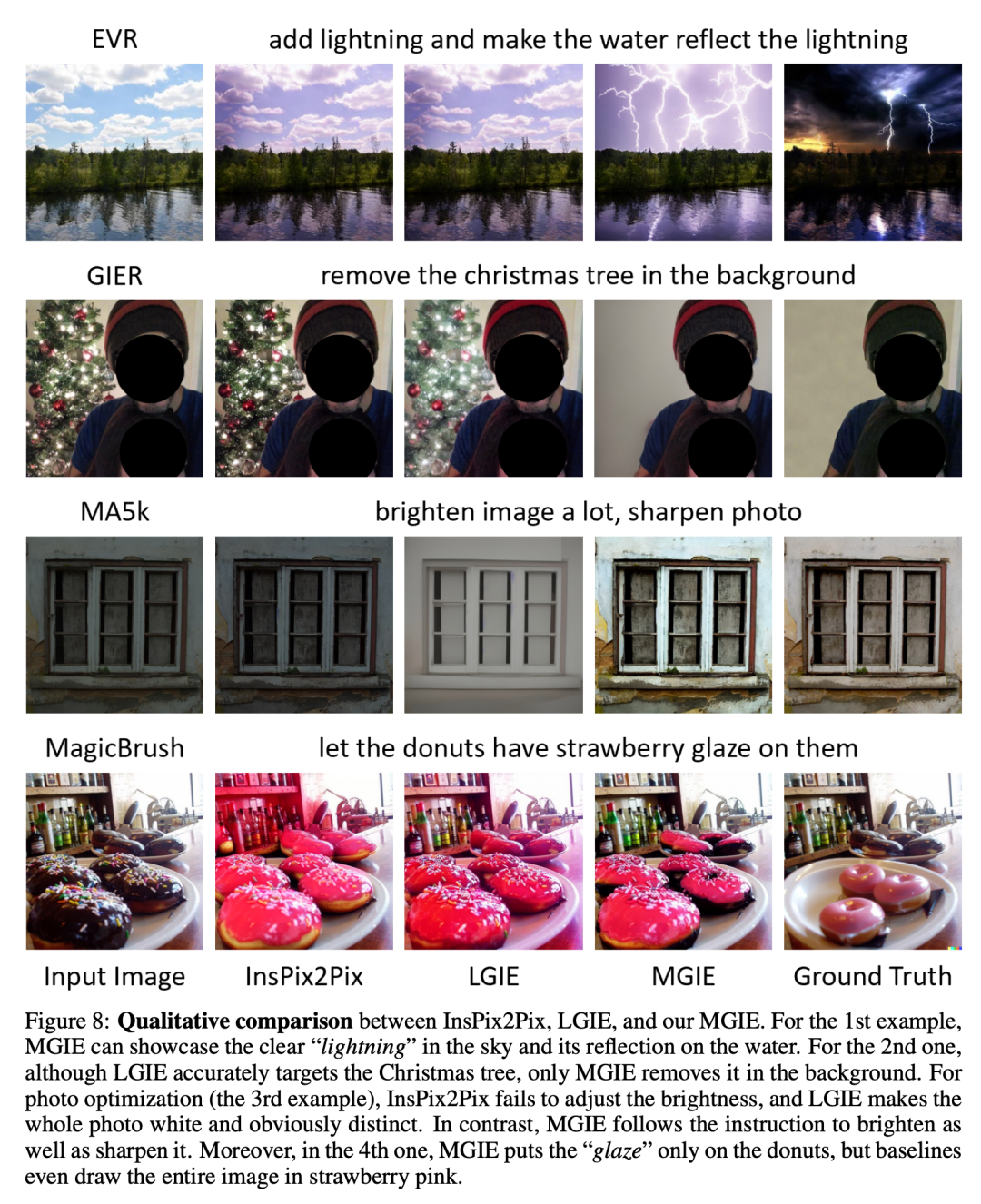

Für Eingabebilder Vergleich zwischen verschiedenen Methoden unter denselben Anweisungen, z. B. lautet die erste Befehlszeile „Tag in Nacht verwandeln“:

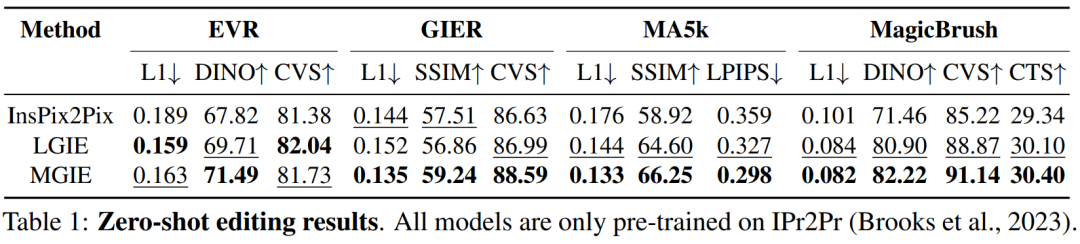

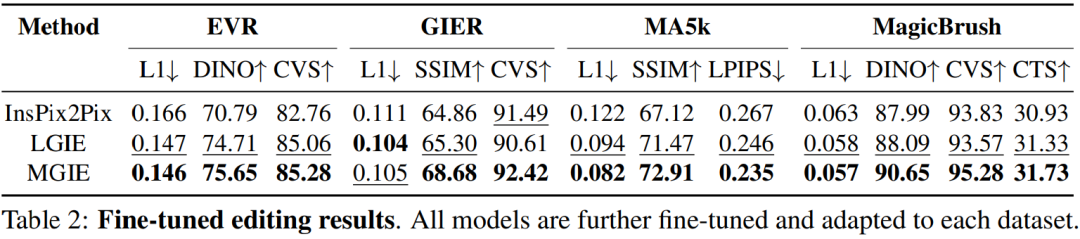

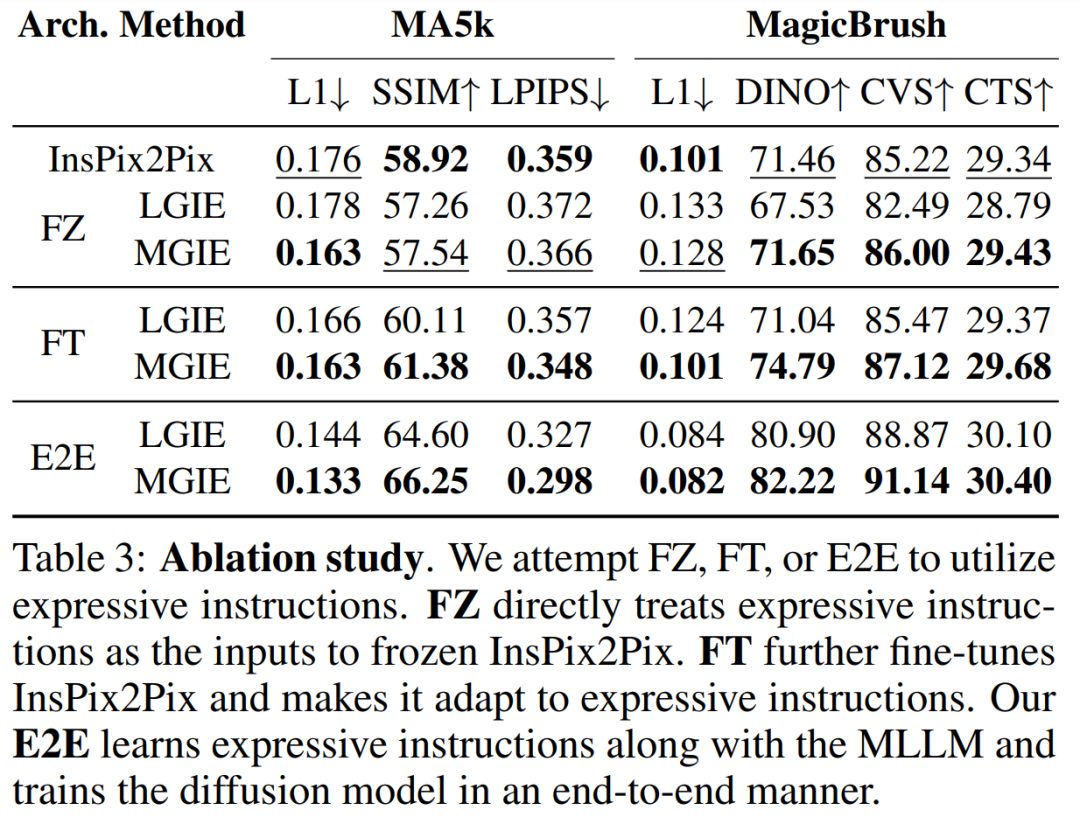

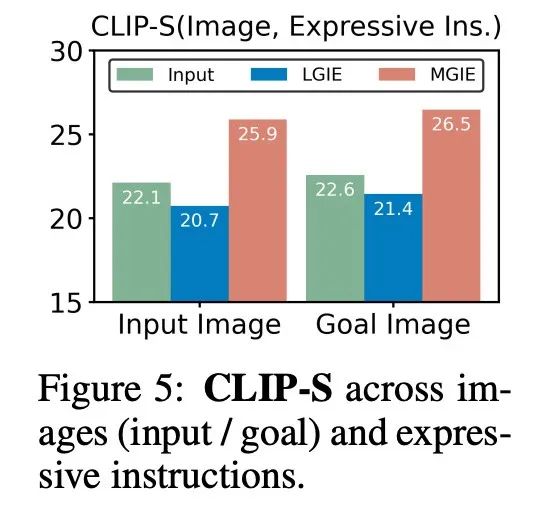

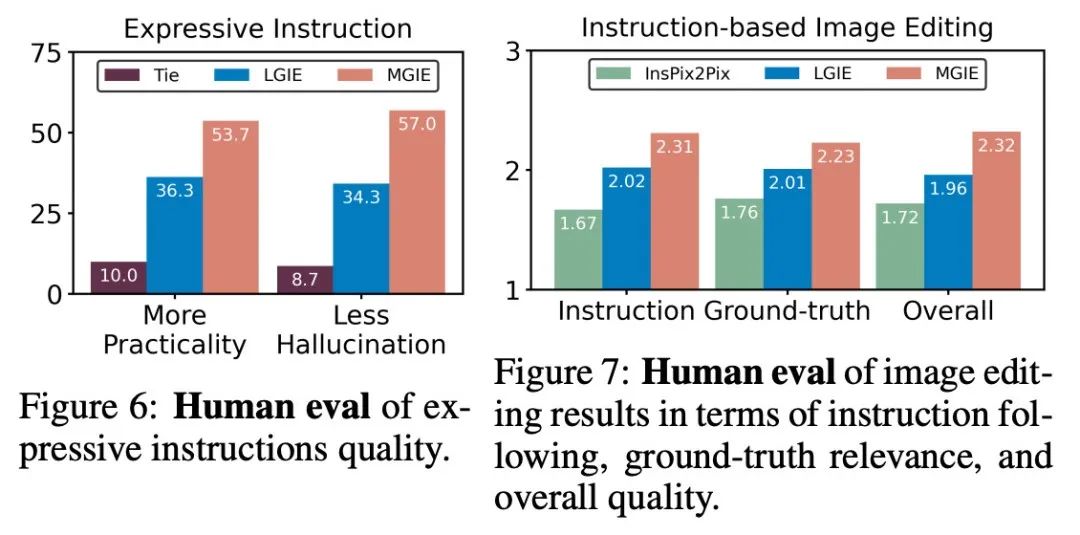

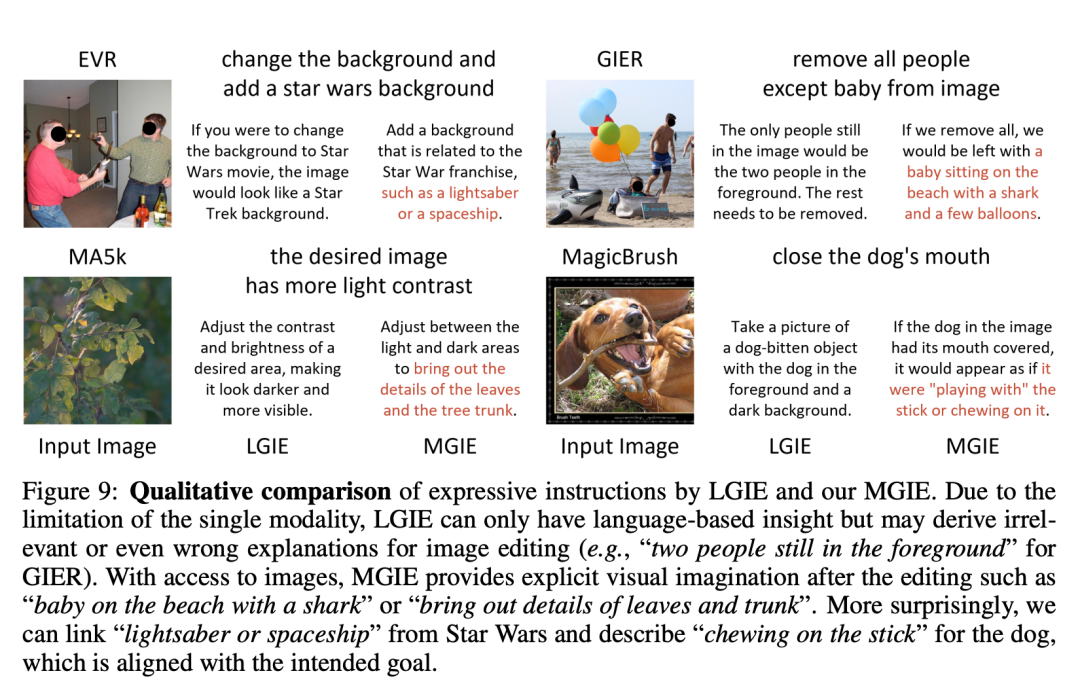

Tabelle 1 zeigt die Zero-Shot-Bearbeitungsergebnisse des Modells, das nur auf dem Datensatz IPr2Pr trainiert wurde. Bei EVR und GIER mit Photoshop-Änderungen entsprachen die Bearbeitungsergebnisse eher der Bootstrapping-Absicht (z. B. erreichte LGIE auf EVR einen höheren CVS von 82,0). Für die globale Bildoptimierung auf MA5k ist InsPix2Pix aufgrund des Mangels an relevanten Trainingstripeln ungeeignet. LGIE und MGIE können durch das Erlernen von LLM detaillierte Erklärungen liefern, LGIE ist jedoch immer noch auf seine einzelne Modalität beschränkt. Durch den Zugriff auf das Bild kann MGIE explizite Anweisungen ableiten, z. B. welche Bereiche aufgehellt oder welche Objekte klarer dargestellt werden sollen, was zu erheblichen Leistungsverbesserungen führt (z. B. höhere SSIM-Werte von 66,3 und niedrigere Fotoentfernung von 0,3). Ähnliche Ergebnisse wurden bei MagicBrush gefunden. MGIE erzielt auch die beste Leistung durch präzise visuelle Bilder und die Modifikation bestimmter Ziele als Ziele (z. B. höhere visuelle Ähnlichkeit von 82,2 DINO und höhere globale Untertitelausrichtung von 30,4 CTS). Um die anweisungsbasierte Bildbearbeitung für bestimmte Zwecke zu untersuchen, optimiert Tabelle 2 das Modell für jeden Datensatz. Bei EVR und GIER wurden alle Modelle verbessert, wenn sie an Bearbeitungsaufgaben im Photoshop-Stil angepasst wurden. MGIE übertrifft LGIE in allen Aspekten der Bearbeitung durchweg. Dies zeigt auch, dass das Erlernen der Verwendung ausdrucksstarker Anweisungen die Bildbearbeitung effektiv verbessern kann und dass die visuelle Wahrnehmung eine entscheidende Rolle dabei spielt, explizite Anleitungen für eine maximale Verbesserung zu erhalten. Kompromiss zwischen α_X und α_V. Die Bildbearbeitung hat zwei Ziele: das Ziel als Anweisung zu manipulieren und den Rest des Eingabebildes beizubehalten. Abbildung 3 zeigt die Kompromisskurve zwischen Anweisung (α_X) und Eingabekonsistenz (α_V). In dieser Studie wurde α_X auf 7,5 festgelegt und α_V variierte im Bereich [1,0, 2,2]. Je größer α_V ist, desto ähnlicher ist das Bearbeitungsergebnis der Eingabe, aber desto weniger konsistent ist es mit der Anweisung. Die X-Achse berechnet die Richtungsähnlichkeit des CLIP, d. h. wie konsistent die Bearbeitungsergebnisse mit den Anweisungen sind; die Y-Achse ist die Merkmalsähnlichkeit zwischen dem visuellen CLIP-Encoder und dem Eingabebild. Mit spezifischen Ausdrucksanweisungen übertreffen die Experimente InsPix2Pix in allen Einstellungen. Darüber hinaus kann MGIE durch explizite, visuell relevante Anleitung lernen, um eine Gesamtverbesserung zu erreichen. Dies unterstützt robuste Verbesserungen, unabhängig davon, ob eine größere Eingabe oder Bearbeitungsrelevanz erforderlich ist. Ablationsforschung Darüber hinaus führten die Forscher auch Ablationsexperimente durch und berücksichtigten dabei die Leistung verschiedener Architekturen FZ, FT und E2E beim Ausdrücken von Anweisungen. Die Ergebnisse zeigen, dass MGIE LGIE in FZ, FT und E2E durchweg übertrifft. Dies deutet darauf hin, dass ausdrucksstarke Anweisungen mit kritischer visueller Wahrnehmung über alle Ablationseinstellungen hinweg einen konsistenten Vorteil haben. Warum ist MLLM-Bootstrapping sinnvoll? Abbildung 5 zeigt die CLIP-Score-Werte zwischen Eingabe- oder Ground-Truth-Zielbildern und Ausdrucksanweisungen. Ein höherer CLIP-S-Score für das Eingabebild zeigt an, dass die Anweisungen für die Bearbeitungsquelle relevant sind, während eine bessere Ausrichtung am Zielbild klare, relevante Bearbeitungsanweisungen liefert. Wie gezeigt ist MGIE konsistenter mit der Eingabe/dem Ziel, was erklärt, warum seine ausdrucksstarken Anweisungen hilfreich sind. Mit einer klaren Beschreibung der erwarteten Ergebnisse kann MGIE die größten Verbesserungen bei der Bildbearbeitung erzielen. Menschliche Bewertung. Neben automatischen Indikatoren führten die Forscher auch manuelle Auswertungen durch. Abbildung 6 zeigt die Qualität der generierten Ausdrucksanweisungen und Abbildung 7 vergleicht die Bildbearbeitungsergebnisse von InsPix2Pix, LGIE und MGIE im Hinblick auf die Befehlsfolge, die Relevanz der Grundwahrheit und die Gesamtqualität. Inferenzeffizienz. Obwohl MGIE bei der Bildbearbeitung auf MLLM setzt, führt es nur prägnante Ausdrucksanweisungen ein (weniger als 32 Token), sodass die Effizienz mit InsPix2Pix vergleichbar ist. Tabelle 4 listet die Kosten für die Inferenzzeit auf der NVIDIA A100-GPU auf. Für eine einzelne Eingabe kann MGIE die Bearbeitungsaufgabe in 10 Sekunden abschließen. Bei höherer Datenparallelität ist die erforderliche Zeit ähnlich (37 Sekunden bei einer Stapelgröße von 8). Der gesamte Vorgang kann mit nur einer GPU (40 GB) durchgeführt werden. Qualitativer Vergleich. Abbildung 8 zeigt einen visuellen Vergleich aller verwendeten Datensätze und Abbildung 9 vergleicht weiter die Ausdrucksanweisungen für LGIE oder MGIE. Auf der Projekthomepage stellt der Forscher außerdem weitere Demos zur Verfügung (https://mllm-ie.github.io/). Weitere Forschungsdetails finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonselten! Wird Apples Open-Source-Bildbearbeitungstool MGIE auf dem iPhone verfügbar sein?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

So schreiben Sie Oracle -Datenbankanweisungen

Apr 11, 2025 pm 02:42 PM

So schreiben Sie Oracle -Datenbankanweisungen

Apr 11, 2025 pm 02:42 PM

Der Kern von Oracle SQL -Anweisungen ist ausgewählt, einfügen, aktualisiert und löschen sowie die flexible Anwendung verschiedener Klauseln. Es ist wichtig, den Ausführungsmechanismus hinter der Aussage wie die Indexoptimierung zu verstehen. Zu den erweiterten Verwendungen gehören Unterabfragen, Verbindungsabfragen, Analysefunktionen und PL/SQL. Häufige Fehler sind Syntaxfehler, Leistungsprobleme und Datenkonsistenzprobleme. Best Practices für Leistungsoptimierung umfassen die Verwendung geeigneter Indizes, die Vermeidung von Auswahl *, optimieren Sie, wo Klauseln und gebundene Variablen verwenden. Das Beherrschen von Oracle SQL erfordert Übung, einschließlich des Schreibens von Code, Debuggen, Denken und Verständnis der zugrunde liegenden Mechanismen.

Hinzufügen, Ändern und Löschen von MySQL Data Table Field Operation Operation Guide, addieren, ändern und löschen

Apr 11, 2025 pm 05:42 PM

Hinzufügen, Ändern und Löschen von MySQL Data Table Field Operation Operation Guide, addieren, ändern und löschen

Apr 11, 2025 pm 05:42 PM

Feldbetriebshandbuch in MySQL: Felder hinzufügen, ändern und löschen. Feld hinzufügen: Alter table table_name hinzufügen column_name data_type [nicht null] [Standard default_value] [Primärschlüssel] [auto_increment] Feld ändern: Alter table table_name Ändern Sie Column_Name Data_type [nicht null] [diffault default_value] [Primärschlüssel] [Primärschlüssel]

Detaillierte Erläuterung verschachtelter Abfrageinstanzen in der MySQL -Datenbank

Apr 11, 2025 pm 05:48 PM

Detaillierte Erläuterung verschachtelter Abfrageinstanzen in der MySQL -Datenbank

Apr 11, 2025 pm 05:48 PM

Verschachtelte Anfragen sind eine Möglichkeit, eine andere Frage in eine Abfrage aufzunehmen. Sie werden hauptsächlich zum Abrufen von Daten verwendet, die komplexe Bedingungen erfüllen, mehrere Tabellen assoziieren und zusammenfassende Werte oder statistische Informationen berechnen. Beispiele hierfür sind zu findenen Mitarbeitern über den überdurchschnittlichen Löhnen, das Finden von Bestellungen für eine bestimmte Kategorie und die Berechnung des Gesamtbestellvolumens für jedes Produkt. Beim Schreiben verschachtelter Abfragen müssen Sie folgen: Unterabfragen schreiben, ihre Ergebnisse in äußere Abfragen schreiben (auf Alias oder als Klauseln bezogen) und optimieren Sie die Abfrageleistung (unter Verwendung von Indizes).

Was sind die Integritätsbeschränkungen von Oracle -Datenbanktabellen?

Apr 11, 2025 pm 03:42 PM

Was sind die Integritätsbeschränkungen von Oracle -Datenbanktabellen?

Apr 11, 2025 pm 03:42 PM

Die Integritätsbeschränkungen von Oracle -Datenbanken können die Datengenauigkeit sicherstellen, einschließlich: nicht Null: Nullwerte sind verboten; Einzigartig: Einzigartigkeit garantieren und einen einzelnen Nullwert ermöglichen; Primärschlüssel: Primärschlüsselbeschränkung, Stärkung der einzigartigen und verboten Nullwerte; Fremdschlüssel: Verwalten Sie die Beziehungen zwischen Tabellen, Fremdschlüssel beziehen sich auf Primärtabellen -Primärschlüssel. Überprüfen Sie: Spaltenwerte nach Bedingungen begrenzen.

Was macht Oracle?

Apr 11, 2025 pm 06:06 PM

Was macht Oracle?

Apr 11, 2025 pm 06:06 PM

Oracle ist das weltweit größte Softwareunternehmen für Datenbankverwaltungssystem (DBMS). Zu den Hauptprodukten gehören die folgenden Funktionen: Entwicklungstools für relationale Datenbankverwaltungssysteme (Oracle Database) (Oracle Apex, Oracle Visual Builder) Middleware (Oracle Weblogic Server, Oracle Soa Suite) Cloud -Dienst (Oracle Cloud Infrastructure) Analyse und Business Intelligence (Oracle Analytic

Wie Tomcat -Protokolle bei der Fehlerbehebung bei Speicherlecks helfen

Apr 12, 2025 pm 11:42 PM

Wie Tomcat -Protokolle bei der Fehlerbehebung bei Speicherlecks helfen

Apr 12, 2025 pm 11:42 PM

Tomcat -Protokolle sind der Schlüssel zur Diagnose von Speicherleckproblemen. Durch die Analyse von Tomcat -Protokollen können Sie Einblicke in das Verhalten des Speicherverbrauchs und des Müllsammlung (GC) erhalten und Speicherlecks effektiv lokalisieren und auflösen. Hier erfahren Sie, wie Sie Speicherlecks mit Tomcat -Protokollen beheben: 1. GC -Protokollanalyse zuerst aktivieren Sie eine detaillierte GC -Protokollierung. Fügen Sie den Tomcat-Startparametern die folgenden JVM-Optionen hinzu: -xx: printgCDetails-xx: printgCDatESTAMPS-XLOGGC: GC.Log Diese Parameter generieren ein detailliertes GC-Protokoll (GC.Log), einschließlich Informationen wie GC-Typ, Recycling-Objektgröße und Zeit. Analyse gc.log

Was sind die Systementwicklungstools für Oracle -Datenbanken?

Apr 11, 2025 pm 03:45 PM

Was sind die Systementwicklungstools für Oracle -Datenbanken?

Apr 11, 2025 pm 03:45 PM

Zu den Oracle -Datenbankentwicklungs -Tools gehören nicht nur SQL*Plus, sondern auch die folgenden Tools: PL/SQL Developer: Paid Tool, bietet Code -Bearbeitungs-, Debugging- und Datenbankverwaltungsfunktionen und unterstützt das Hervorheben und automatische Abschluss des Syntax -Codes. Toad for Oracle: Bezahltes Tool, das PL/SQL-Entwickler-ähnliche Funktionen sowie zusätzliche Funktionen zur Überwachung der Datenbankleistung und der SQL-Optimierungsfunktionen bietet. SQL Developer: Oracys offizielles kostenloses Tool, das grundlegende Funktionen für Code -Bearbeitung, Debugging und Datenbankmanagement bietet, geeignet für Entwickler mit begrenzten Budgets. DataGrip: Jetbrains

So konfigurieren Sie das Debian Apache -Protokollformat

Apr 12, 2025 pm 11:30 PM

So konfigurieren Sie das Debian Apache -Protokollformat

Apr 12, 2025 pm 11:30 PM

In diesem Artikel wird beschrieben, wie das Protokollformat von Apache auf Debian -Systemen angepasst wird. Die folgenden Schritte führen Sie durch den Konfigurationsprozess: Schritt 1: Greifen Sie auf die Apache -Konfigurationsdatei zu. Die Haupt -Apache -Konfigurationsdatei des Debian -Systems befindet sich normalerweise in /etc/apache2/apache2.conf oder /etc/apache2/httpd.conf. Öffnen Sie die Konfigurationsdatei mit Root -Berechtigungen mit dem folgenden Befehl: Sudonano/etc/apache2/apache2.conf oder sudonano/etc/apache2/httpd.conf Schritt 2: Definieren Sie benutzerdefinierte Protokollformate, um zu finden oder zu finden oder