Scrapy lernen: Grundlagen bis Fortgeschrittene

Scrapy-Installations-Tutorial: Vom Einstieg bis zur Beherrschung sind spezifische Codebeispiele erforderlich

Einführung:

Scrapy ist ein leistungsstarkes Python-Open-Source-Webcrawler-Framework, das zum Crawlen von Webseiten, zum Extrahieren von Daten sowie zum Durchführen von Datenbereinigung und -persistenz verwendet werden kann Warten Sie auf eine Reihe von Aufgaben. Dieser Artikel führt Sie Schritt für Schritt durch den Scrapy-Installationsprozess und stellt spezifische Codebeispiele bereit, die Ihnen dabei helfen, von den ersten Schritten bis zur Beherrschung des Scrapy-Frameworks zu gelangen.

1. Scrapy installieren

Um Scrapy zu installieren, stellen Sie zunächst sicher, dass Sie Python und pip installiert haben. Öffnen Sie dann ein Befehlszeilenterminal und geben Sie den folgenden Befehl zur Installation ein:

pip install scrapy

Der Installationsvorgang kann einige Zeit dauern, bitte haben Sie etwas Geduld. Wenn Sie Berechtigungsprobleme haben, versuchen Sie, dem Befehl sudo voranzustellen. sudo。

二、创建Scrapy项目

安装完成后,我们可以使用Scrapy的命令行工具创建一个新的Scrapy项目。在命令行终端中,进入您想要创建项目的目录,并执行以下命令:

scrapy startproject tutorial

这将在当前目录下创建一个名为"tutorial"的Scrapy项目文件夹。进入该文件夹,我们可以看到如下的目录结构:

tutorial/

scrapy.cfg

tutorial/

__init__.py

items.py

middlewares.py

pipelines.py

settings.py

spiders/

__init__.py其中,scrapy.cfg是Scrapy项目的配置文件,tutorial文件夹是我们自己的代码文件夹。

三、定义爬虫

在Scrapy中,我们使用爬虫(spider)来定义抓取网页和提取数据的规则。在spiders目录下创建一个新的Python文件,命名为quotes_spider.py(可以根据实际需求自行命名),然后使用以下代码定义一个简单的爬虫:

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = [

'http://quotes.toscrape.com/page/1/',

]

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

next_page = response.css('li.next a::attr(href)').get()

if next_page is not None:

yield response.follow(next_page, self.parse)在上述代码中,我们创建了一个名为QuotesSpider的爬虫。其中,name属性是爬虫的名称,start_urls属性是我们希望抓取的第一个页面的URL,parse方法是爬虫默认的解析方法,用于解析网页和提取数据。

四、运行爬虫

在命令行终端中,进入项目的根目录下(即tutorial文件夹),并执行以下命令来启动爬虫并开始抓取数据:

scrapy crawl quotes

爬虫将会开始抓取初始URL中的页面,并根据我们定义的规则进行解析和提取数据。

五、保存数据

一般情况下,我们会将抓取到的数据进行保存。在Scrapy中,我们可以使用Item Pipeline来实现数据的清洗、处理和存储。在pipelines.py文件中,添加以下代码:

import json

class TutorialPipeline:

def open_spider(self, spider):

self.file = open('quotes.json', 'w')

def close_spider(self, spider):

self.file.close()

def process_item(self, item, spider):

line = json.dumps(dict(item)) + "

"

self.file.write(line)

return item

在上述代码中,我们创建了一个名为TutorialPipeline的Item Pipeline。其中,open_spider方法在爬虫启动时会被调用,用于初始化文件;close_spider方法在爬虫结束时会被调用,用于关闭文件;process_item方法会对每个抓取到的数据项进行处理和保存。

六、配置Scrapy项目

在settings.py文件中,可以对Scrapy项目进行各种配置。以下是一些常用的配置项:

-

ROBOTSTXT_OBEY:是否遵守robots.txt协议; -

USER_AGENT:设置用户代理,在爬虫中可以模拟不同的浏览器; -

ITEM_PIPELINES:启用和配置Item Pipeline; DOWNLOAD_DELAY2. Erstellen Sie ein Scrapy-Projekt

rrreee

Dadurch wird ein Scrapy-Projektordner mit dem Namen „tutorial“ im aktuellen Verzeichnis erstellt. Wenn wir den Ordner betreten, sehen wir die folgende Verzeichnisstruktur:

scrapy.cfg die Konfigurationsdatei des Scrapy-Projekts und der Ordner tutorial unser Eigener Code-Ordner. 🎜🎜3. Crawler definieren🎜In Scrapy verwenden wir Spider, um Regeln für das Crawlen von Webseiten und das Extrahieren von Daten zu definieren. Erstellen Sie eine neue Python-Datei im Verzeichnis spiders, nennen Sie sie quotes_spider.py (Sie können sie entsprechend Ihren tatsächlichen Anforderungen benennen) und verwenden Sie dann den folgenden Code, um eine zu definieren einfacher Crawler: 🎜 rrreee🎜Im obigen Code haben wir eine Spinne namens QuotesSpider erstellt. Darunter ist das Attribut name der Name des Crawlers, das Attribut start_urls ist die URL der ersten Seite, die wir crawlen möchten, und das Attribut parse code>-Methode ist die Standardmethode für den Crawler. Die Parsing-Methode wird zum Parsen von Webseiten und zum Extrahieren von Daten verwendet. 🎜🎜4. Führen Sie den Crawler aus. 🎜Geben Sie im Befehlszeilenterminal das Stammverzeichnis des Projekts ein (d. h. den Ordner <code>tutorial) und führen Sie den folgenden Befehl aus, um den Crawler zu starten und mit dem Crawlen der Daten zu beginnen: 🎜rrreee🎜 Der Crawler beginnt mit dem Crawlen der Seite in der ursprünglichen URL und analysiert und extrahiert Daten gemäß den von uns definierten Regeln. 🎜🎜5. Daten speichern🎜Unter normalen Umständen speichern wir die erfassten Daten. In Scrapy können wir Item Pipeline verwenden, um Daten zu bereinigen, zu verarbeiten und zu speichern. Fügen Sie in der Datei pipelines.py den folgenden Code hinzu: 🎜rrreee🎜Im obigen Code haben wir eine Item-Pipeline mit dem Namen TutorialPipeline erstellt. Unter anderem wird die Methode open_spider aufgerufen, wenn der Crawler mit der Initialisierung der Datei beginnt; die Methode close_spider wird aufgerufen, wenn der Crawler endet, um die Datei zu schließen; process_item Die Methode verarbeitet und speichert jedes erfasste Datenelement. 🎜🎜6. Konfigurieren Sie das Scrapy-Projekt🎜In der Datei settings.py können Sie verschiedene Konfigurationen für das Scrapy-Projekt konfigurieren. Im Folgenden sind einige häufig verwendete Konfigurationselemente aufgeführt: 🎜-

ROBOTSTXT_OBEY: ob das robots.txt-Protokoll eingehalten werden soll 🎜 -

USER_AGENT: Legen Sie fest Benutzeragent, im Crawler können verschiedene Browser simuliert werden; 🎜 -

ITEM_PIPELINES: Item Pipeline aktivieren und konfigurieren; 🎜 -

DOWNLOAD_DELAY: Downloadverzögerung festlegen, um Fehler zu vermeiden Schäden an der Zielwebsite. Übermäßiger Druck. 🎜🎜🎜 7. Zusammenfassung 🎜Durch die oben genannten Schritte haben wir die Installation und Verwendung von Scrapy abgeschlossen. Ich hoffe, dass dieser Artikel Ihnen dabei helfen kann, sich von den ersten Schritten an mit dem Scrapy-Framework vertraut zu machen. Wenn Sie mehr über die erweiterten Funktionen und die Verwendung von Scrapy erfahren möchten, lesen Sie bitte die offizielle Scrapy-Dokumentation und üben und erkunden Sie anhand tatsächlicher Projekte. Ich wünsche Ihnen viel Erfolg in der Welt der Reptilien! 🎜

Das obige ist der detaillierte Inhalt vonScrapy lernen: Grundlagen bis Fortgeschrittene. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Ein Diffusionsmodell-Tutorial, das Ihre Zeit wert ist, von der Purdue University

Apr 07, 2024 am 09:01 AM

Ein Diffusionsmodell-Tutorial, das Ihre Zeit wert ist, von der Purdue University

Apr 07, 2024 am 09:01 AM

Diffusion kann nicht nur besser imitieren, sondern auch „erschaffen“. Das Diffusionsmodell (DiffusionModel) ist ein Bilderzeugungsmodell. Im Vergleich zu bekannten Algorithmen wie GAN und VAE im Bereich der KI verfolgt das Diffusionsmodell einen anderen Ansatz. Seine Hauptidee besteht darin, dem Bild zunächst Rauschen hinzuzufügen und es dann schrittweise zu entrauschen. Das Entrauschen und Wiederherstellen des Originalbilds ist der Kernbestandteil des Algorithmus. Der endgültige Algorithmus ist in der Lage, aus einem zufälligen verrauschten Bild ein Bild zu erzeugen. In den letzten Jahren hat das phänomenale Wachstum der generativen KI viele spannende Anwendungen in der Text-zu-Bild-Generierung, Videogenerierung und mehr ermöglicht. Das Grundprinzip dieser generativen Werkzeuge ist das Konzept der Diffusion, ein spezieller Sampling-Mechanismus, der die Einschränkungen bisheriger Methoden überwindet.

Generieren Sie PPT mit einem Klick! Kimi: Lassen Sie zuerst die „PPT-Wanderarbeiter' populär werden

Aug 01, 2024 pm 03:28 PM

Generieren Sie PPT mit einem Klick! Kimi: Lassen Sie zuerst die „PPT-Wanderarbeiter' populär werden

Aug 01, 2024 pm 03:28 PM

Kimi: In nur einem Satz, in nur zehn Sekunden ist ein PPT fertig. PPT ist so nervig! Um ein Meeting abzuhalten, benötigen Sie einen PPT; um einen wöchentlichen Bericht zu schreiben, müssen Sie einen PPT vorlegen, auch wenn Sie jemanden des Betrugs beschuldigen PPT. Das College ähnelt eher dem Studium eines PPT-Hauptfachs. Man schaut sich PPT im Unterricht an und macht PPT nach dem Unterricht. Als Dennis Austin vor 37 Jahren PPT erfand, hatte er vielleicht nicht damit gerechnet, dass PPT eines Tages so weit verbreitet sein würde. Wenn wir über unsere harte Erfahrung bei der Erstellung von PPT sprechen, treiben uns Tränen in die Augen. „Es dauerte drei Monate, ein PPT mit mehr als 20 Seiten zu erstellen, und ich habe es Dutzende Male überarbeitet. Als ich das PPT sah, musste ich mich übergeben.“ war PPT.“ Wenn Sie ein spontanes Meeting haben, sollten Sie es tun

Alle CVPR 2024-Auszeichnungen bekannt gegeben! Fast 10.000 Menschen nahmen offline an der Konferenz teil und ein chinesischer Forscher von Google gewann den Preis für den besten Beitrag

Jun 20, 2024 pm 05:43 PM

Alle CVPR 2024-Auszeichnungen bekannt gegeben! Fast 10.000 Menschen nahmen offline an der Konferenz teil und ein chinesischer Forscher von Google gewann den Preis für den besten Beitrag

Jun 20, 2024 pm 05:43 PM

Am frühen Morgen des 20. Juni (Pekinger Zeit) gab CVPR2024, die wichtigste internationale Computer-Vision-Konferenz in Seattle, offiziell die besten Beiträge und andere Auszeichnungen bekannt. In diesem Jahr wurden insgesamt 10 Arbeiten ausgezeichnet, darunter zwei beste Arbeiten und zwei beste studentische Arbeiten. Darüber hinaus gab es zwei Nominierungen für die beste Arbeit und vier Nominierungen für die beste studentische Arbeit. Die Top-Konferenz im Bereich Computer Vision (CV) ist die CVPR, die jedes Jahr zahlreiche Forschungseinrichtungen und Universitäten anzieht. Laut Statistik wurden in diesem Jahr insgesamt 11.532 Arbeiten eingereicht, von denen 2.719 angenommen wurden, was einer Annahmequote von 23,6 % entspricht. Laut der statistischen Analyse der CVPR2024-Daten des Georgia Institute of Technology befassen sich die meisten Arbeiten aus Sicht der Forschungsthemen mit der Bild- und Videosynthese und -generierung (Imageandvideosyn

Fünf Programmiersoftware für den Einstieg in das Erlernen der C-Sprache

Feb 19, 2024 pm 04:51 PM

Fünf Programmiersoftware für den Einstieg in das Erlernen der C-Sprache

Feb 19, 2024 pm 04:51 PM

Als weit verbreitete Programmiersprache ist die C-Sprache eine der grundlegenden Sprachen, die für diejenigen erlernt werden müssen, die sich mit Computerprogrammierung befassen möchten. Für Anfänger kann das Erlernen einer neuen Programmiersprache jedoch etwas schwierig sein, insbesondere aufgrund des Mangels an entsprechenden Lernwerkzeugen und Lehrmaterialien. In diesem Artikel werde ich fünf Programmiersoftware vorstellen, die Anfängern den Einstieg in die C-Sprache erleichtert und Ihnen einen schnellen Einstieg ermöglicht. Die erste Programmiersoftware war Code::Blocks. Code::Blocks ist eine kostenlose integrierte Open-Source-Entwicklungsumgebung (IDE) für

PyCharm Community Edition-Installationsanleitung: Beherrschen Sie schnell alle Schritte

Jan 27, 2024 am 09:10 AM

PyCharm Community Edition-Installationsanleitung: Beherrschen Sie schnell alle Schritte

Jan 27, 2024 am 09:10 AM

Schnellstart mit PyCharm Community Edition: Detailliertes Installations-Tutorial, vollständige Analyse Einführung: PyCharm ist eine leistungsstarke integrierte Python-Entwicklungsumgebung (IDE), die einen umfassenden Satz an Tools bereitstellt, mit denen Entwickler Python-Code effizienter schreiben können. In diesem Artikel wird die Installation der PyCharm Community Edition im Detail vorgestellt und spezifische Codebeispiele bereitgestellt, um Anfängern den schnellen Einstieg zu erleichtern. Schritt 1: PyCharm Community Edition herunterladen und installieren Um PyCharm verwenden zu können, müssen Sie es zunächst von der offiziellen Website herunterladen

Eine Pflichtlektüre für technische Anfänger: Analyse der Schwierigkeitsgrade von C-Sprache und Python

Mar 22, 2024 am 10:21 AM

Eine Pflichtlektüre für technische Anfänger: Analyse der Schwierigkeitsgrade von C-Sprache und Python

Mar 22, 2024 am 10:21 AM

Titel: Ein Muss für technische Anfänger: Schwierigkeitsanalyse der C-Sprache und Python, die spezifische Codebeispiele erfordert. Im heutigen digitalen Zeitalter ist Programmiertechnologie zu einer immer wichtigeren Fähigkeit geworden. Ob Sie in Bereichen wie Softwareentwicklung, Datenanalyse, künstliche Intelligenz arbeiten oder einfach nur aus Interesse Programmieren lernen möchten, die Wahl einer geeigneten Programmiersprache ist der erste Schritt. Unter vielen Programmiersprachen sind C-Sprache und Python zwei weit verbreitete Programmiersprachen, jede mit ihren eigenen Merkmalen. In diesem Artikel werden die Schwierigkeitsgrade der C-Sprache und von Python analysiert

Von Bare-Metal bis hin zu einem großen Modell mit 70 Milliarden Parametern finden Sie hier ein Tutorial und gebrauchsfertige Skripte

Jul 24, 2024 pm 08:13 PM

Von Bare-Metal bis hin zu einem großen Modell mit 70 Milliarden Parametern finden Sie hier ein Tutorial und gebrauchsfertige Skripte

Jul 24, 2024 pm 08:13 PM

Wir wissen, dass LLM auf großen Computerclustern unter Verwendung umfangreicher Daten trainiert wird. Auf dieser Website wurden viele Methoden und Technologien vorgestellt, die den LLM-Trainingsprozess unterstützen und verbessern. Was wir heute teilen möchten, ist ein Artikel, der tief in die zugrunde liegende Technologie eintaucht und vorstellt, wie man einen Haufen „Bare-Metals“ ohne Betriebssystem in einen Computercluster für das LLM-Training verwandelt. Dieser Artikel stammt von Imbue, einem KI-Startup, das allgemeine Intelligenz durch das Verständnis der Denkweise von Maschinen erreichen möchte. Natürlich ist es kein einfacher Prozess, einen Haufen „Bare Metal“ ohne Betriebssystem in einen Computercluster für das Training von LLM zu verwandeln, aber Imbue hat schließlich erfolgreich ein LLM mit 70 Milliarden Parametern trainiert der Prozess akkumuliert

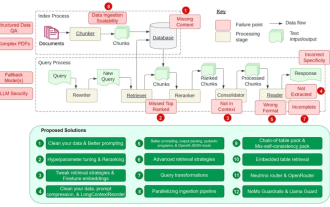

Der leitende NVIDIA-Architekt zählt die 12 Schwachstellen von RAG auf und vermittelt Lösungen

Jul 11, 2024 pm 01:53 PM

Der leitende NVIDIA-Architekt zählt die 12 Schwachstellen von RAG auf und vermittelt Lösungen

Jul 11, 2024 pm 01:53 PM

Retrieval-Augmented Generation (RAG) ist eine Technik, die Retrieval nutzt, um Sprachmodelle zu verbessern. Bevor ein Sprachmodell eine Antwort generiert, ruft es insbesondere relevante Informationen aus einer umfangreichen Dokumentendatenbank ab und verwendet diese Informationen dann zur Steuerung des Generierungsprozesses. Diese Technologie kann die Genauigkeit und Relevanz von Inhalten erheblich verbessern, das Problem der Halluzinationen wirksam lindern, die Geschwindigkeit der Wissensaktualisierung erhöhen und die Nachverfolgbarkeit der Inhaltsgenerierung verbessern. RAG ist zweifellos einer der spannendsten Bereiche der Forschung im Bereich der künstlichen Intelligenz. Weitere Informationen zu RAG finden Sie im Kolumnenartikel auf dieser Website „Was sind die neuen Entwicklungen bei RAG, das sich darauf spezialisiert hat, die Mängel großer Modelle auszugleichen?“ Diese Rezension erklärt es deutlich. Aber RAG ist nicht perfekt und Benutzer stoßen bei der Verwendung oft auf einige „Problempunkte“. Kürzlich die fortschrittliche generative KI-Lösung von NVIDIA