Java

Java

javaLernprogramm

javaLernprogramm

Bewerten Sie den Leistungseffekt des MyBatis First-Level-Cache in einer gleichzeitigen Umgebung

Bewerten Sie den Leistungseffekt des MyBatis First-Level-Cache in einer gleichzeitigen Umgebung

Bewerten Sie den Leistungseffekt des MyBatis First-Level-Cache in einer gleichzeitigen Umgebung

Titel: Analyse der Anwendungswirkung des First-Level-Cache von Mybatis in einer gleichzeitigen Umgebung

Einführung:

Bei Verwendung von Mybatis für den Datenbankzugriff ist der First-Level-Cache standardmäßig aktiviert. Er speichert Abfrageergebnisse zwischen, um die Auswirkungen zu verringern auf die Anzahl der Besuche und die Verbesserung der Systemleistung. In einer gleichzeitigen Umgebung kann es jedoch zu Problemen mit dem First-Level-Cache kommen. In diesem Artikel werden die Anwendungseffekte des Mybatis-First-Level-Cache in einer gleichzeitigen Umgebung analysiert und spezifische Codebeispiele gegeben.

1. Übersicht über den First-Level-Cache

Der First-Level-Cache von mybatis ist ein Sitzungs-Cache. Er ist standardmäßig aktiviert und threadsicher. Die Kernidee des Caches der ersten Ebene besteht darin, die Ergebnisse jeder Abfrage in der Sitzung zwischenzuspeichern. Wenn die Parameter der nächsten Abfrage gleich sind, werden die Ergebnisse direkt aus dem Cache abgerufen, ohne dass die Datenbank erneut abgefragt werden muss kann die Anzahl der Datenbankzugriffe reduzieren.

2. Der Anwendungseffekt des First-Level-Cache

- Reduzieren Sie die Anzahl der Datenbankzugriffe: Durch die Verwendung des First-Level-Cache können Sie die Anzahl der Datenbankzugriffe reduzieren und die Leistung des Systems verbessern. In einer gleichzeitigen Umgebung teilen sich mehrere Threads dieselbe Sitzung und können Daten im Cache gemeinsam nutzen, wodurch wiederholte Datenbankabfragevorgänge vermieden werden.

- Verbessern Sie die Reaktionsgeschwindigkeit des Systems: Da der Cache der ersten Ebene Ergebnisse direkt aus dem Cache abrufen kann, ohne die Datenbank abzufragen, kann er die Reaktionszeit des Systems erheblich verkürzen und das Benutzererlebnis verbessern.

3. Probleme mit dem First-Level-Cache in einer gleichzeitigen Umgebung.

- Dateninkonsistenz: Wenn in einer gleichzeitigen Umgebung mehrere Threads dieselbe Sitzung teilen und einer der Threads die Daten in der Datenbank ändert, ändert der andere die Daten Der Thread erhält alte Daten aus dem Cache, was zu Dateninkonsistenzen führt. Die Lösung für dieses Problem besteht darin, einen Cache der zweiten Ebene zu verwenden oder den Cache manuell zu aktualisieren.

- Übermäßige Speichernutzung: Bei großer Parallelität belegt der Cache der ersten Ebene möglicherweise zu viel Speicher, was zu einer Verringerung der Systemleistung führt. Die Lösung für dieses Problem besteht darin, die Größe des Caches der ersten Ebene entsprechend anzupassen oder einen Cache der zweiten Ebene zu verwenden.

Beispielcode:

Angenommen, es gibt eine UserDao-Schnittstelle und die Datei UserMapper.xml definiert eine getUserById-Methode, um Benutzerinformationen basierend auf der Benutzer-ID abzufragen. Das Codebeispiel lautet wie folgt:

-

UserDao-Schnittstellendefinition

public interface UserDao { User getUserById(int id); }Nach dem Login kopieren UserMapper.xml-Konfigurationsdatei

<mapper namespace="com.example.UserDao"> <select id="getUserById" resultType="com.example.User"> SELECT * FROM user WHERE id = #{id} </select> </mapper>Nach dem Login kopierenCode mit Cache der ersten Ebene

public class Main { public static void main(String[] args) { SqlSessionFactory sqlSessionFactory = MyBatisUtil.getSqlSessionFactory(); // 获取SqlSessionFactory SqlSession sqlSession = sqlSessionFactory.openSession(); // 打开一个会话 UserDao userDao = sqlSession.getMapper(UserDao.class); // 获取UserDao的实例 User user1 = userDao.getUserById(1); // 第一次查询,会将结果缓存到一级缓存中 User user2 = userDao.getUserById(1); // 第二次查询,直接从缓存中获取结果 System.out.println(user1); System.out.println(user2); sqlSession.close(); // 关闭会话 } }Nach dem Login kopieren

Im obigen Code wird die erste Abfrage zwischengespeichert Die Ergebnisse werden in den Cache der ersten Ebene übertragen. Die zweite Abfrage ruft die Ergebnisse direkt aus dem Cache ab, ohne die Datenbank erneut abzufragen. Dadurch kann die Anzahl der Datenbankzugriffe reduziert und die Systemleistung verbessert werden.

Fazit:

Der First-Level-Cache von mybatis kann die Anzahl der Datenbankzugriffe effektiv reduzieren und die Systemleistung in einer gleichzeitigen Umgebung verbessern. Wenn jedoch mehrere Threads dieselbe Sitzung teilen, kann es zu Dateninkonsistenzproblemen kommen. Daher muss in tatsächlichen Anwendungen darüber nachgedacht werden, ob der First-Level-Cache entsprechend den spezifischen Geschäftsanforderungen verwendet werden soll, und entsprechende Strategien zur Lösung potenzieller Probleme übernommen werden. Gleichzeitig kann durch den Einsatz geeigneter Caching-Strategien und technischer Mittel, wie z. B. die Verwendung von Second-Level-Cache oder die manuelle Aktualisierung des Caches, die Systemleistung weiter optimiert werden.

Das obige ist der detaillierte Inhalt vonBewerten Sie den Leistungseffekt des MyBatis First-Level-Cache in einer gleichzeitigen Umgebung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Detaillierte Schritte zum Bereinigen des Speichers in Xiaohongshu

Apr 26, 2024 am 10:43 AM

Detaillierte Schritte zum Bereinigen des Speichers in Xiaohongshu

Apr 26, 2024 am 10:43 AM

1. Öffnen Sie Xiaohongshu, klicken Sie unten rechts auf „Ich“. 2. Klicken Sie auf das Einstellungssymbol und dann auf „Allgemein“. 3. Klicken Sie auf „Cache leeren“.

Was tun, wenn Ihr Huawei-Telefon nicht über genügend Speicher verfügt (Praktische Methoden zur Lösung des Problems des unzureichenden Speichers)

Apr 29, 2024 pm 06:34 PM

Was tun, wenn Ihr Huawei-Telefon nicht über genügend Speicher verfügt (Praktische Methoden zur Lösung des Problems des unzureichenden Speichers)

Apr 29, 2024 pm 06:34 PM

Unzureichender Speicher auf Huawei-Mobiltelefonen ist mit der Zunahme mobiler Anwendungen und Mediendateien zu einem häufigen Problem geworden, mit dem viele Benutzer konfrontiert sind. Um Benutzern zu helfen, den Speicherplatz ihres Mobiltelefons voll auszunutzen, werden in diesem Artikel einige praktische Methoden vorgestellt, um das Problem des unzureichenden Speichers auf Huawei-Mobiltelefonen zu lösen. 1. Cache bereinigen: Verlaufsdatensätze und ungültige Daten, um Speicherplatz freizugeben und von Anwendungen generierte temporäre Dateien zu löschen. Suchen Sie in den Huawei-Telefoneinstellungen nach „Speicher“, klicken Sie auf die Schaltfläche „Cache löschen“ und löschen Sie dann die Cache-Dateien der Anwendung. 2. Deinstallieren Sie selten verwendete Anwendungen: Um Speicherplatz freizugeben, löschen Sie einige selten verwendete Anwendungen. Ziehen Sie es an den oberen Rand des Telefonbildschirms, drücken Sie lange auf das Symbol „Deinstallieren“ der Anwendung, die Sie löschen möchten, und klicken Sie dann auf die Bestätigungsschaltfläche, um die Deinstallation abzuschließen. 3.Mobile Anwendung auf

Wie man Deepseek vor Ort fein abgestimmt

Feb 19, 2025 pm 05:21 PM

Wie man Deepseek vor Ort fein abgestimmt

Feb 19, 2025 pm 05:21 PM

Die lokale Feinabstimmung von Deepseek-Klasse-Modellen steht vor der Herausforderung unzureichender Rechenressourcen und Fachkenntnisse. Um diese Herausforderungen zu bewältigen, können die folgenden Strategien angewendet werden: Modellquantisierung: Umwandlung von Modellparametern in Ganzzahlen mit niedriger Präzision und Reduzierung des Speicherboots. Verwenden Sie kleinere Modelle: Wählen Sie ein vorgezogenes Modell mit kleineren Parametern für eine einfachere lokale Feinabstimmung aus. Datenauswahl und Vorverarbeitung: Wählen Sie hochwertige Daten aus und führen Sie eine geeignete Vorverarbeitung durch, um eine schlechte Datenqualität zu vermeiden, die die Modelleffizienz beeinflusst. Batch -Training: Laden Sie für große Datensätze Daten in Stapel für das Training, um den Speicherüberlauf zu vermeiden. Beschleunigung mit GPU: Verwenden Sie unabhängige Grafikkarten, um den Schulungsprozess zu beschleunigen und die Trainingszeit zu verkürzen.

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Was tun, wenn der Edge-Browser zu viel Speicher beansprucht? Was tun, wenn der Edge-Browser zu viel Speicher beansprucht?

May 09, 2024 am 11:10 AM

Was tun, wenn der Edge-Browser zu viel Speicher beansprucht? Was tun, wenn der Edge-Browser zu viel Speicher beansprucht?

May 09, 2024 am 11:10 AM

1. Rufen Sie zunächst den Edge-Browser auf und klicken Sie auf die drei Punkte in der oberen rechten Ecke. 2. Wählen Sie dann in der Taskleiste [Erweiterungen] aus. 3. Schließen oder deinstallieren Sie als Nächstes die Plug-Ins, die Sie nicht benötigen.

Für nur 250 US-Dollar zeigt Ihnen der technische Leiter von Hugging Face Schritt für Schritt, wie Sie Llama 3 verfeinern

May 06, 2024 pm 03:52 PM

Für nur 250 US-Dollar zeigt Ihnen der technische Leiter von Hugging Face Schritt für Schritt, wie Sie Llama 3 verfeinern

May 06, 2024 pm 03:52 PM

Die bekannten großen Open-Source-Sprachmodelle wie Llama3 von Meta, Mistral- und Mixtral-Modelle von MistralAI und Jamba von AI21 Lab sind zu Konkurrenten von OpenAI geworden. In den meisten Fällen müssen Benutzer diese Open-Source-Modelle anhand ihrer eigenen Daten verfeinern, um das Potenzial des Modells voll auszuschöpfen. Es ist nicht schwer, ein großes Sprachmodell (wie Mistral) im Vergleich zu einem kleinen mithilfe von Q-Learning auf einer einzelnen GPU zu optimieren, aber die effiziente Feinabstimmung eines großen Modells wie Llama370b oder Mixtral blieb bisher eine Herausforderung . Deshalb Philipp Sch, technischer Leiter von HuggingFace

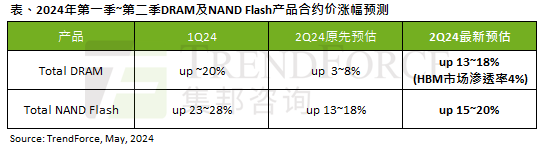

Die Auswirkungen der KI-Welle sind offensichtlich. TrendForce hat seine Prognose für Preiserhöhungen bei DRAM-Speicher und NAND-Flash-Speicher in diesem Quartal nach oben korrigiert.

May 07, 2024 pm 09:58 PM

Die Auswirkungen der KI-Welle sind offensichtlich. TrendForce hat seine Prognose für Preiserhöhungen bei DRAM-Speicher und NAND-Flash-Speicher in diesem Quartal nach oben korrigiert.

May 07, 2024 pm 09:58 PM

Laut einem TrendForce-Umfragebericht hat die KI-Welle erhebliche Auswirkungen auf die Märkte für DRAM-Speicher und NAND-Flash-Speicher. In den Nachrichten dieser Website vom 7. Mai sagte TrendForce heute in seinem neuesten Forschungsbericht, dass die Agentur die Vertragspreiserhöhungen für zwei Arten von Speicherprodukten in diesem Quartal erhöht habe. Konkret schätzte TrendForce ursprünglich, dass der DRAM-Speichervertragspreis im zweiten Quartal 2024 um 3 bis 8 % steigen wird, und schätzt ihn nun auf 13 bis 18 %, bezogen auf NAND-Flash-Speicher, die ursprüngliche Schätzung wird um 13 bis 18 % steigen 18 %, und die neue Schätzung liegt bei 15 %, nur eMMC/UFS weist einen geringeren Anstieg von 10 % auf. ▲Bildquelle TrendForce TrendForce gab an, dass die Agentur ursprünglich damit gerechnet hatte, dies auch weiterhin zu tun

Benötigt Win11 weniger Speicher als Win10?

Apr 18, 2024 am 12:57 AM

Benötigt Win11 weniger Speicher als Win10?

Apr 18, 2024 am 12:57 AM

Ja, insgesamt benötigt Win11 weniger Speicher als Win10. Zu den Optimierungen gehören ein leichterer Systemkernel, eine bessere Speicherverwaltung, neue Optionen für den Ruhezustand und weniger Hintergrundprozesse. Tests zeigen, dass der Speicherbedarf von Win11 in ähnlichen Konfigurationen typischerweise 5–10 % geringer ist als der von Win10. Die Speichernutzung wird aber auch von der Hardwarekonfiguration, den Anwendungen und den Systemeinstellungen beeinflusst.