Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Google AI-Video ist wieder großartig! VideoPrism, ein universeller visueller All-in-One-Encoder, aktualisiert 30 SOTA-Leistungsfunktionen

Google AI-Video ist wieder großartig! VideoPrism, ein universeller visueller All-in-One-Encoder, aktualisiert 30 SOTA-Leistungsfunktionen

Google AI-Video ist wieder großartig! VideoPrism, ein universeller visueller All-in-One-Encoder, aktualisiert 30 SOTA-Leistungsfunktionen

Nachdem das KI-Videomodell Sora populär wurde, traten große Unternehmen wie Meta und Google beiseite, um Forschung zu betreiben und OpenAI nachzuholen.

Kürzlich haben Forscher des Google-Teams einen universellen Video-Encoder vorgeschlagen – VideoPrism.

Es kann verschiedene Videoverständnisaufgaben über ein einziges eingefrorenes Modell bewältigen.

Bilder

Bilder

Papieradresse: https://arxiv.org/pdf/2402.13217.pdf

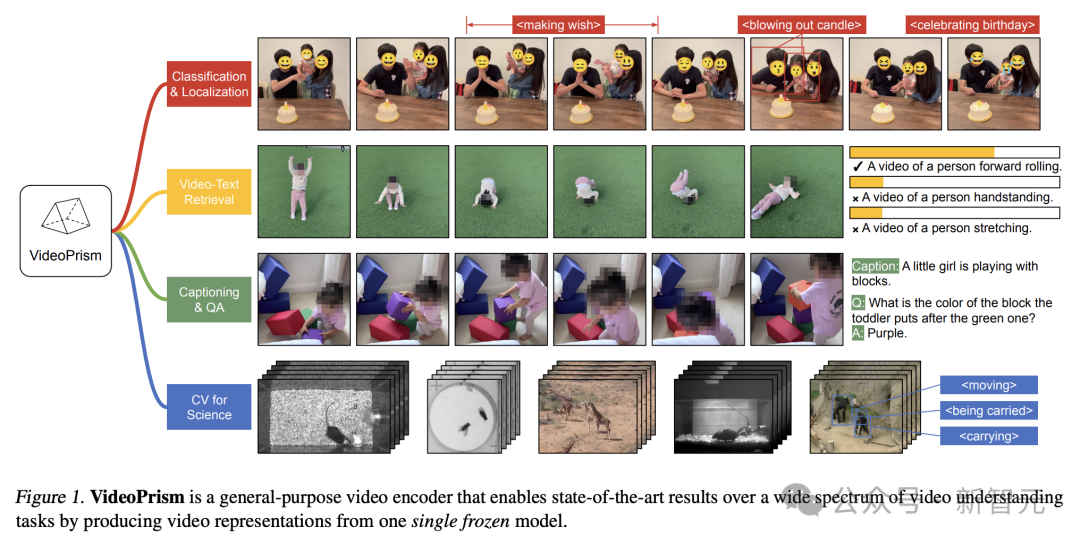

VideoPrism kann beispielsweise die Kerzen blasenden Personen im Video unten klassifizieren und lokalisieren.

Bilder

Bilder

Video-Text-Abruf, basierend auf dem Textinhalt kann der entsprechende Inhalt im Video abgerufen werden.

Bilder

Bilder

Beschreiben Sie als weiteres Beispiel das Video unten – ein kleines Mädchen spielt mit Bauklötzen.

Sie können auch Fragen und Antworten zur Qualitätssicherung durchführen.

- Welche Farbe hat der Block, den sie über den grünen Block gelegt hat?

- Lila.

Bilder

Bilder

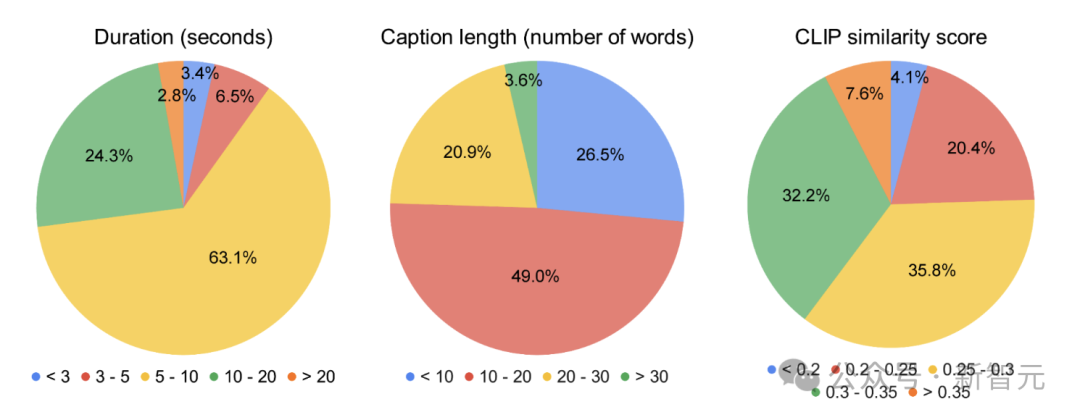

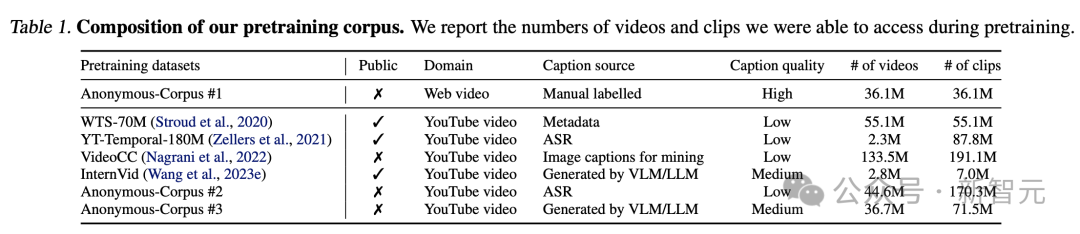

Die Forscher trainierten VideoPrism vorab anhand eines heterogenen Korpus, der 36 Millionen hochwertige Video-Untertitelpaare und 582 Millionen Videoclips mit verrauschtem Paralleltext (z. B. ASR-transkribierter Text) enthielt.

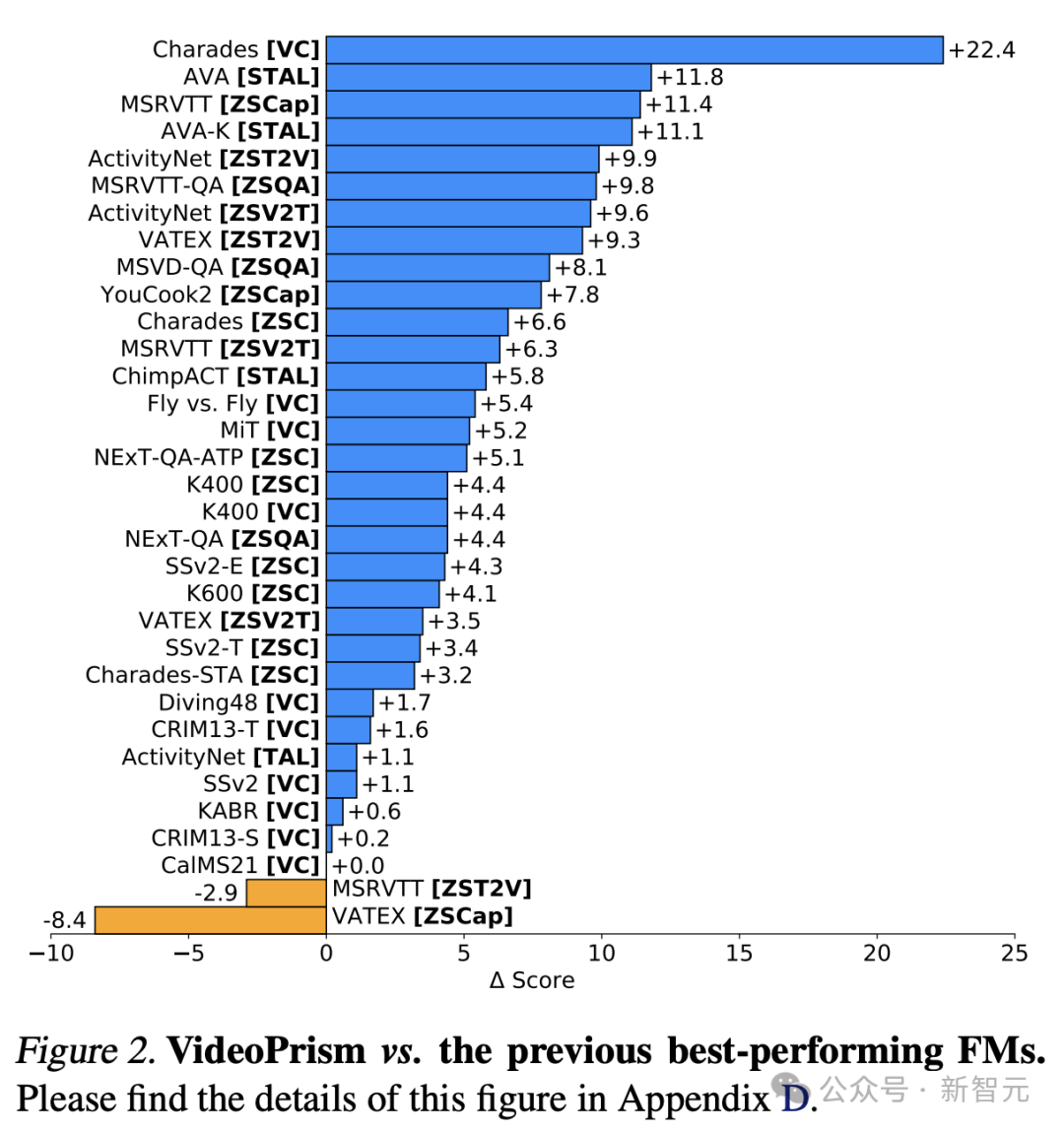

Es ist erwähnenswert, dass VideoPrism in 33 Benchmark-Tests zum Videoverständnis 30 SOTA aktualisiert hat.

Bilder

Bilder

Universal Visual Encoder VideoPrism

Derzeit verfügt das Video Foundation Model (ViFM) über ein enormes Potenzial, neue Funktionen für große Unternehmen freizuschalten.

Obwohl frühere Forschungen beim allgemeinen Videoverständnis große Fortschritte gemacht haben, ist der Aufbau eines echten „grundlegenden Videomodells“ immer noch ein schwer erreichbares Ziel.

Als Reaktion darauf brachte Google VideoPrism auf den Markt, einen universellen visuellen Encoder, der eine Vielzahl von Videoverständnisaufgaben lösen soll, darunter Klassifizierung, Lokalisierung, Abruf, Untertitel und Fragebeantwortung (QA).

VideoPrism wird umfassend anhand von CV-Datensätzen sowie CV-Aufgaben in wissenschaftlichen Bereichen wie Neurowissenschaften und Ökologie evaluiert.

Erzielen Sie Spitzenleistungen bei minimaler Fitness, indem Sie ein einziges eingefrorenes Modell verwenden.

Darüber hinaus sagen Google-Forscher, dass diese eingefrorene Encoder-Einstellung gleichzeitig früheren Untersuchungen folgt und ihre praktische Anwendbarkeit sowie die hohen Kosten für die Berechnung und Feinabstimmung des Videomodells berücksichtigt.

Bilder

Bilder

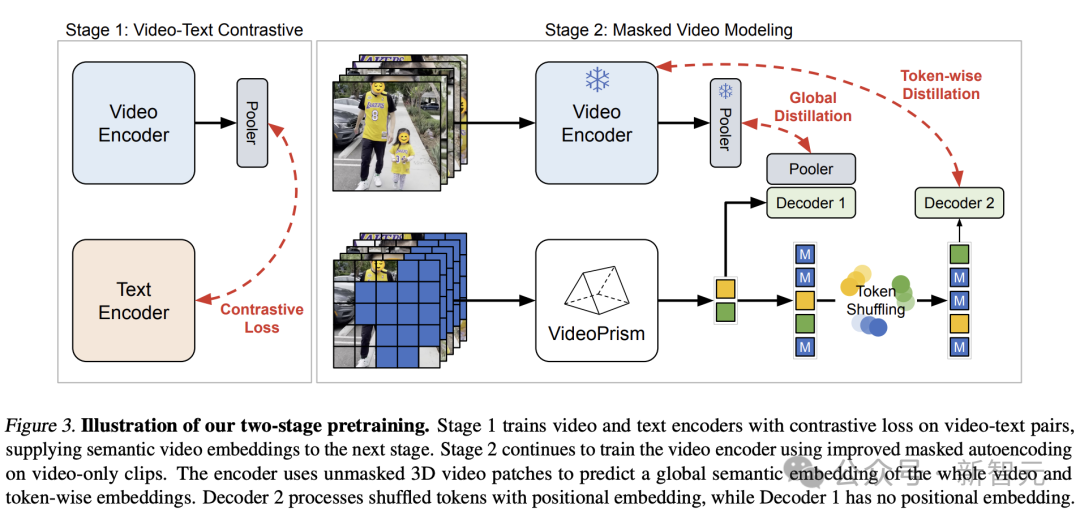

Designstruktur, zweistufige Trainingsmethode

Das Designkonzept hinter VideoPrism ist wie folgt.

Vortrainingsdaten sind die Grundlage des Basismodells (FM). Die idealen Vortrainingsdaten für ViFM sind eine repräsentative Stichprobe aller Videos auf der Welt.

In diesem Beispiel enthalten die meisten Videos keinen parallelen Text, der den Inhalt beschreibt.

Wenn es jedoch auf solchen Text trainiert wird, kann es unschätzbare semantische Hinweise auf den Videoraum liefern.

Daher sollte sich die Pre-Training-Strategie von Google in erster Linie auf den Videomodus konzentrieren und gleichzeitig alle verfügbaren Video-Text-Paare voll ausnutzen.

Auf der Datenseite haben Google-Forscher das erforderliche Vortraining angenähert, indem sie 36 Millionen hochwertige Video-Untertitelpaare und 582 Millionen Videoclips mit verrauschtem Paralleltext (z. B. ASR-Transkriptionen, generierte Untertitel und abgerufener Text) gebündelt haben.

Bilder

Bilder

Bilder

Bilder

In Bezug auf die Modellierung lernen die Autoren zunächst vergleichend semantische Videoeinbettungen aus allen Video-Text-Paaren unterschiedlicher Qualität.

Die semantischen Einbettungen werden dann global und mit umfangreichen reinen Videodaten verfeinert, wodurch die unten beschriebene maskierte Videomodellierung verbessert wird.

Trotz des Erfolgs in natürlicher Sprache bleibt die Modellierung maskierter Daten für CV aufgrund der fehlenden Semantik im rohen visuellen Signal eine Herausforderung.

Bestehende Forschung kombiniert hohe Maskierungsrate und geringes Gewicht, indem sie indirekte Semantik (z. B. die Verwendung von CLIP zur Führung von Modellen oder Tokenisierern oder implizite Semantik zur Bewältigung dieser Herausforderung) entlehnt oder sie implizit verallgemeinert (z. B. die Kennzeichnung visueller Patches) Decoder-Kombination.

Basierend auf den oben genannten Ideen hat das Google-Team einen zweistufigen Ansatz gewählt, der auf Daten vor dem Training basiert.

Bilder

Bilder

In der ersten Phase wird kontrastives Lernen durchgeführt, um den Video-Encoder unter Verwendung aller Video-Text-Paare am Text-Encoder auszurichten.

Basierend auf früheren Untersuchungen minimierte das Google-Team die Ähnlichkeitswerte aller Video-Text-Paare im Stapel und führte eine symmetrische Kreuzentropieverlustminimierung durch.

Und verwenden Sie das Bildmodell von CoCa, um das räumliche Kodierungsmodul zu initialisieren und WebLI in das Vortraining zu integrieren.

Vor der Berechnung des Verlusts werden die Funktionen des Video-Encoders durch Multi-Head Attention Pooling (MAP) aggregiert.

Diese Stufe ermöglicht es dem Video-Encoder, umfangreiche visuelle Semantik durch linguistische Aufsicht zu erlernen, und das resultierende Modell stellt semantische Videoeinbettungen für das Training der zweiten Stufe bereit.

Bilder

Bilder

In der zweiten Stufe wird der Encoder weiter trainiert und es werden zwei Verbesserungen vorgenommen:

- Das Modell muss die globale Einbettung und das Token der ersten Stufe auf Videoebene basierend auf unmaskierten Eingaben vorhersagen Video-Patches einbetten

– Das Ausgabetoken des Encoders wird zufällig gemischt, bevor es an den Decoder übergeben wird, um das Lernen von Verknüpfungen zu vermeiden.

Bemerkenswert ist, dass das Vortraining der Forscher zwei Überwachungssignale nutzt: die Textbeschreibung des Videos und die kontextbezogene Selbstüberwachung, sodass VideoPrism bei erscheinungs- und aktionsorientierten Aufgaben eine gute Leistung erbringen kann.

Tatsächlich zeigen frühere Untersuchungen, dass Videountertitel hauptsächlich Hinweise auf das Aussehen offenbaren, während kontextbezogene Überwachung dabei hilft, Handlungen zu erlernen.

Bilder

Bilder

Experimentelle Ergebnisse

Als nächstes bewerteten die Forscher VideoPrism anhand einer breiten Palette videozentrierter Verständnisaufgaben und demonstrierten seine Fähigkeiten und Allgemeingültigkeit.

Hauptsächlich in die folgenden vier Kategorien unterteilt:

(1) Im Allgemeinen nur Videoverständnis, einschließlich Klassifizierung und räumlich-zeitlicher Positionierung

(2) Zero-Shot-Videotextabruf

(3) Zero-Shot-Videountertitel und Qualitätsprüfung

(4) Lebenslaufaufgaben in der Wissenschaft

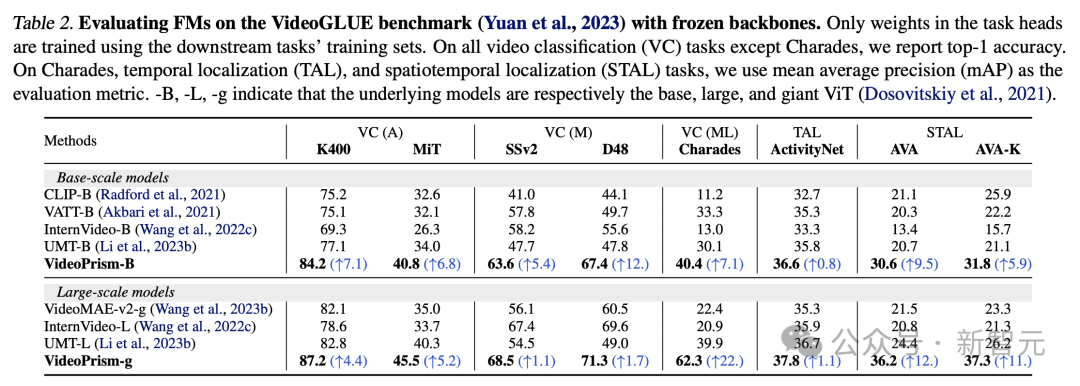

Klassifizierung und raumzeitliche Lokalisierung

Tabelle 2 zeigt die Ergebnisse von Frozen Backbone auf VideoGLUE.

VideoPrism übertrifft die Basislinie bei allen Datensätzen deutlich. Darüber hinaus verbessert die Erhöhung der zugrunde liegenden Modellgröße von VideoPrism von ViT-B auf ViT-g die Leistung erheblich.

Es ist erwähnenswert, dass keine Basismethode bei allen Benchmarks das zweitbeste Ergebnis erzielt, was darauf hindeutet, dass frühere Methoden möglicherweise entwickelt wurden, um auf bestimmte Aspekte des Videoverständnisses abzuzielen.

Und VideoPrism verbessert dieses breite Aufgabenspektrum weiter.

Dieses Ergebnis zeigt, dass VideoPrism verschiedene Videosignale in einen Encoder integriert: Semantik mit mehreren Granularitäten, Erscheinungsbild- und Bewegungshinweise, räumlich-zeitliche Informationen und Robustheit gegenüber verschiedenen Videoquellen (z. B. Online-Videos und geskriptete Darbietungen).

Bild

Bild

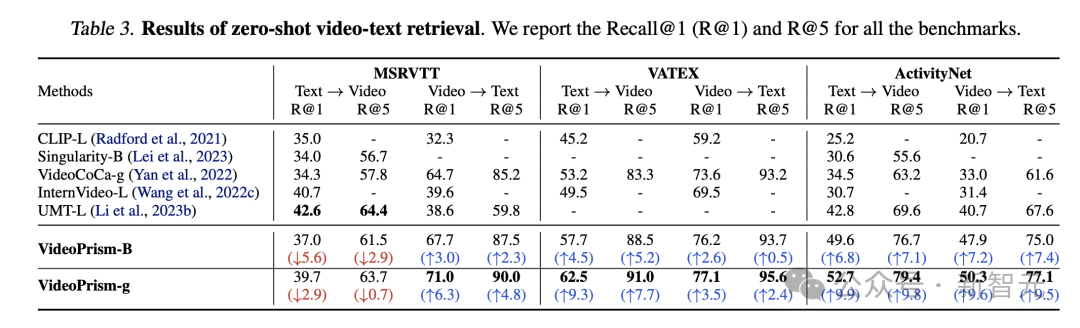

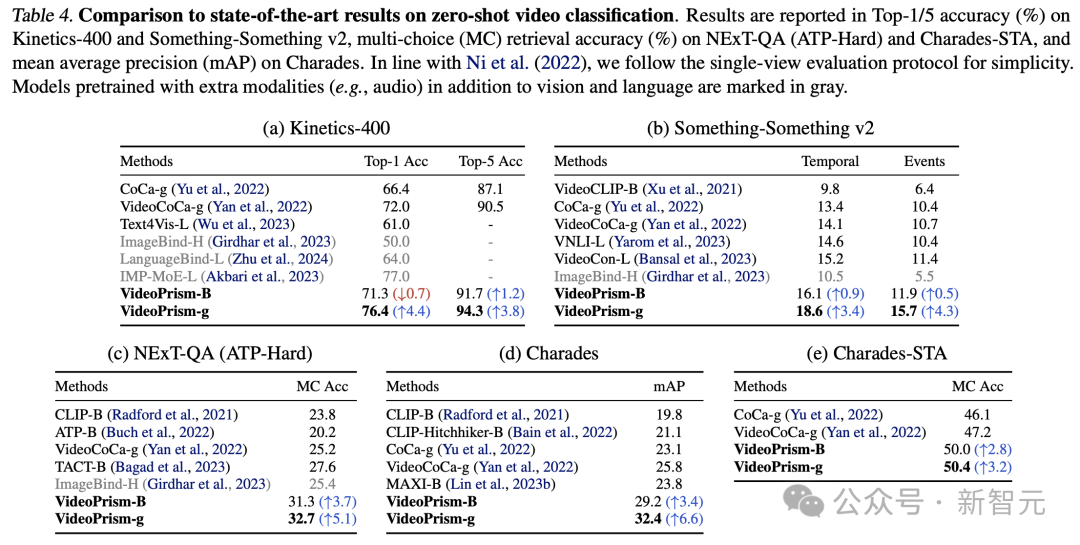

Zero-Shot-Videotextabruf und -klassifizierung

Tabelle 3 und Tabelle 4 fassen die Ergebnisse des Videotextabrufs bzw. der Videoklassifizierung zusammen.

Die Leistung von VideoPrism aktualisiert mehrere Benchmarks und bei anspruchsvollen Datensätzen hat VideoPrism im Vergleich zu früheren Technologien sehr deutliche Verbesserungen erzielt.

Bilder

Bilder

Die meisten Ergebnisse für das Basismodell VideoPrism-B übertreffen tatsächlich bestehende größere Modelle.

Darüber hinaus ist VideoPrism mit den Modellen in Tabelle 4 vergleichbar oder sogar besser als diese, die mit domäneninternen Daten und zusätzlichen Modalitäten (z. B. Audio) vortrainiert wurden. Diese Verbesserungen bei Zero-Shot-Retrieval- und Klassifizierungsaufgaben spiegeln die leistungsstarken Generalisierungsfähigkeiten von VideoPrism wider.

Bilder

Bilder

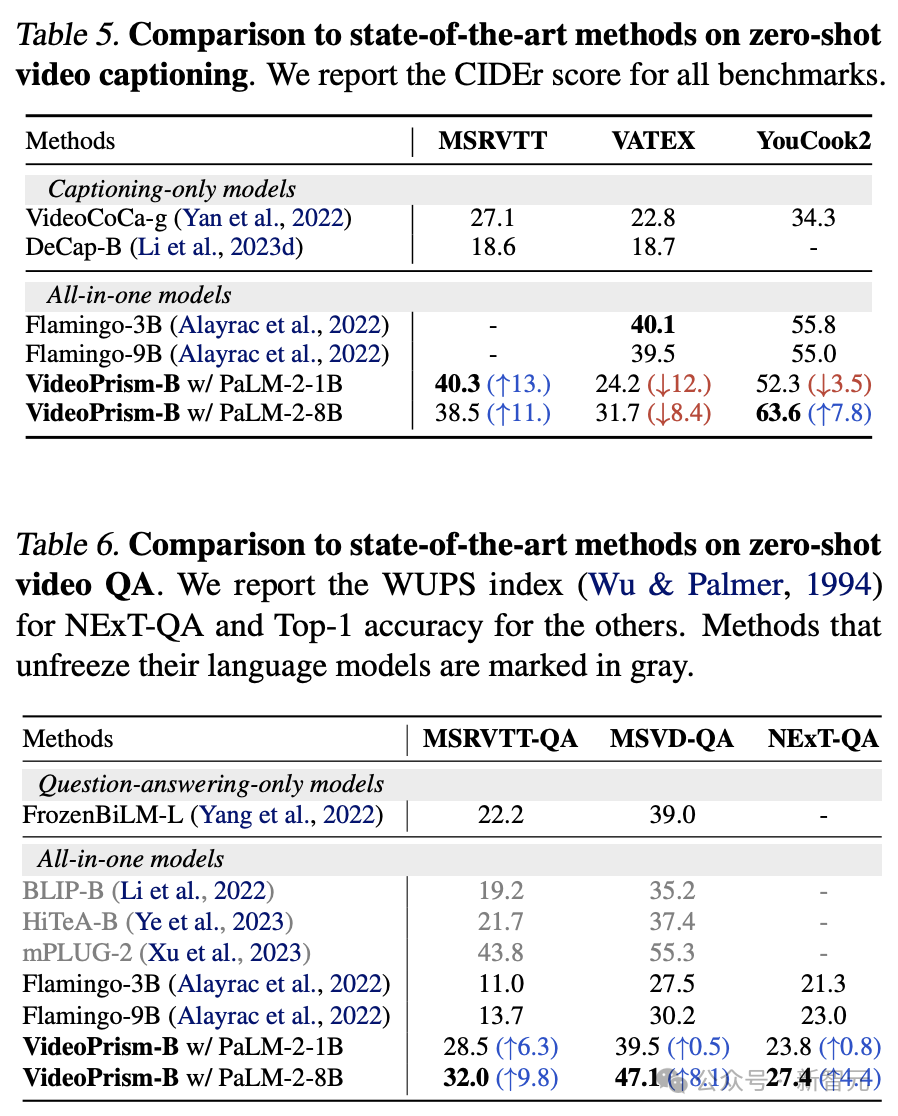

Zero-Sample-Videountertitel und Qualitätsprüfung

Tabelle 5 und Tabelle 6 zeigen jeweils die Ergebnisse von Zero-Sample-Videountertiteln und der Qualitätssicherung.

Trotz der einfachen Modellarchitektur und der geringen Anzahl an Adapterparametern sind die neuesten Modelle immer noch konkurrenzfähig und zählen mit Ausnahme von VATEX zu den Top-Methoden zum Einfrieren visueller und sprachlicher Modelle.

Die Ergebnisse zeigen, dass sich der VideoPrism-Encoder gut für Aufgaben zur Video-zu-Sprache-Generierung eignet.

Bilder

Bilder

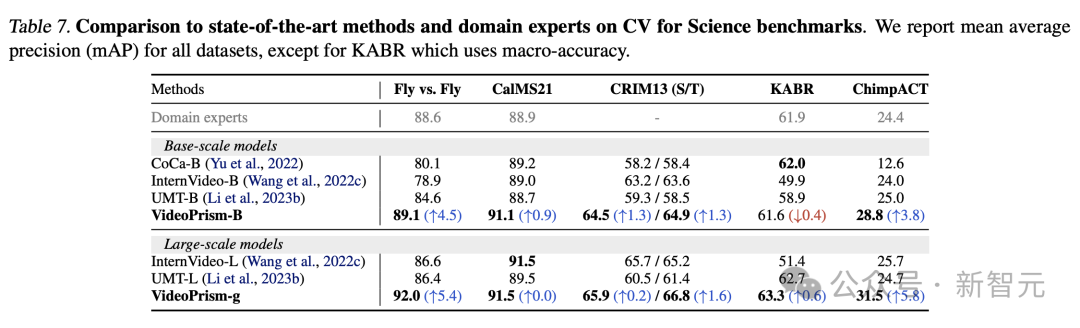

CV-Aufgaben in wissenschaftlichen Bereichen

Universal ViFM verwendet einen gemeinsamen eingefrorenen Encoder für alle Auswertungen, mit einer Leistung, die mit domänenspezifischen Modellen für eine einzelne Aufgabe vergleichbar ist.

Insbesondere VideoPrism schneidet oft am besten ab und übertrifft Domänenexpertenmodelle mit Basismodellen.

Durch die Skalierung auf große Modelle kann die Leistung aller Datensätze weiter verbessert werden. Diese Ergebnisse zeigen, dass ViFM das Potenzial hat, die Videoanalyse in verschiedenen Bereichen erheblich zu beschleunigen.

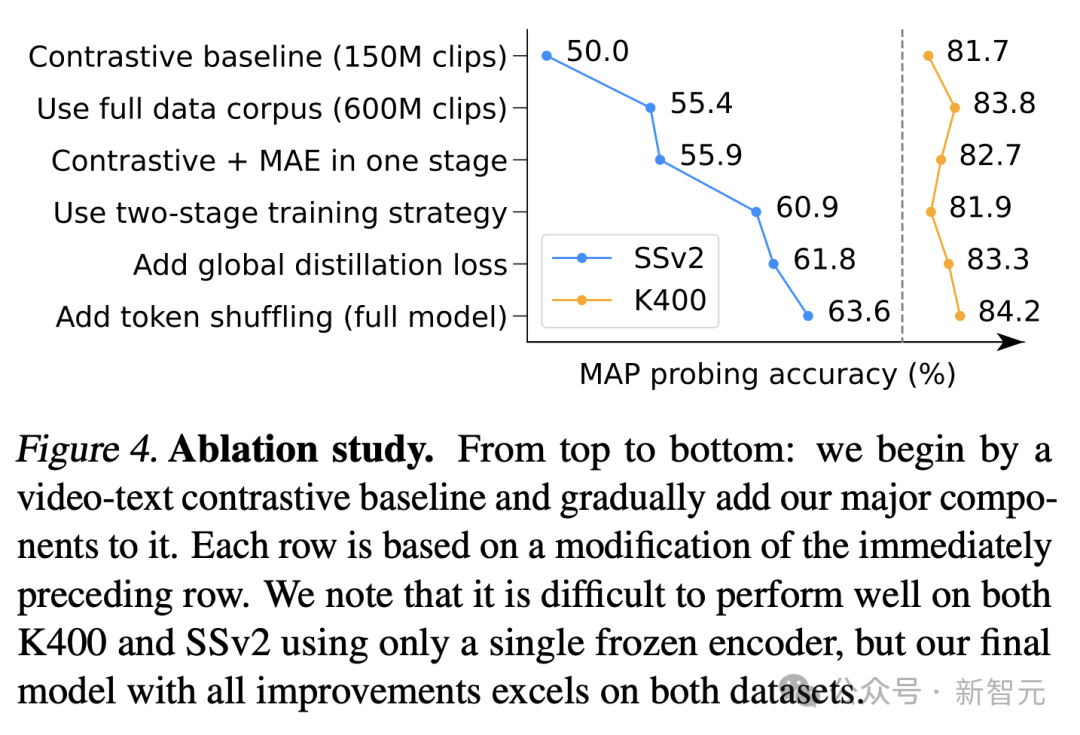

Ablationsstudie

Abbildung 4 zeigt die Ablationsergebnisse. Insbesondere die kontinuierlichen Verbesserungen von VideoPrism gegenüber SSv2 zeigen die Wirksamkeit der Datenverwaltung und Modelldesignbemühungen bei der Förderung des Bewegungsverständnisses in Videos.

Obwohl die Vergleichsbasislinie auf K400 bereits konkurrenzfähige Ergebnisse erzielt hat, verbessern die vorgeschlagene globale Destillation und das Token-Shuffling die Genauigkeit weiter.

Bilder

Bilder

Referenzen:

https://arxiv.org/pdf/2402.13217.pdf

https://blog.research.google/2024/02/videoprism-foundational-visual-encoder .html

Das obige ist der detaillierte Inhalt vonGoogle AI-Video ist wieder großartig! VideoPrism, ein universeller visueller All-in-One-Encoder, aktualisiert 30 SOTA-Leistungsfunktionen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

CentOS8 startet SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 startet SSH

Apr 14, 2025 pm 09:00 PM

Der Befehl zum Neustart des SSH -Dienstes lautet: SystemCTL Neustart SSHD. Detaillierte Schritte: 1. Zugriff auf das Terminal und eine Verbindung zum Server; 2. Geben Sie den Befehl ein: SystemCTL Neustart SSHD; 1. Überprüfen Sie den Dienststatus: SystemCTL -Status SSHD.

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

Eine vollständige Anleitung zum Anzeigen von GitLab -Protokollen unter CentOS -System In diesem Artikel wird in diesem Artikel verschiedene GitLab -Protokolle im CentOS -System angezeigt, einschließlich Hauptprotokolle, Ausnahmebodi und anderen zugehörigen Protokollen. Bitte beachten Sie, dass der Log -Dateipfad je nach GitLab -Version und Installationsmethode variieren kann. Wenn der folgende Pfad nicht vorhanden ist, überprüfen Sie bitte das GitLab -Installationsverzeichnis und die Konfigurationsdateien. 1. Zeigen Sie das Hauptprotokoll an. Verwenden Sie den folgenden Befehl, um die Hauptprotokolldatei der GitLabRails-Anwendung anzuzeigen: Befehl: Sudocat/var/log/gitlab/gitlab-rails/production.log Dieser Befehl zeigt das Produkt an