Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

VPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!

VPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!

VPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!

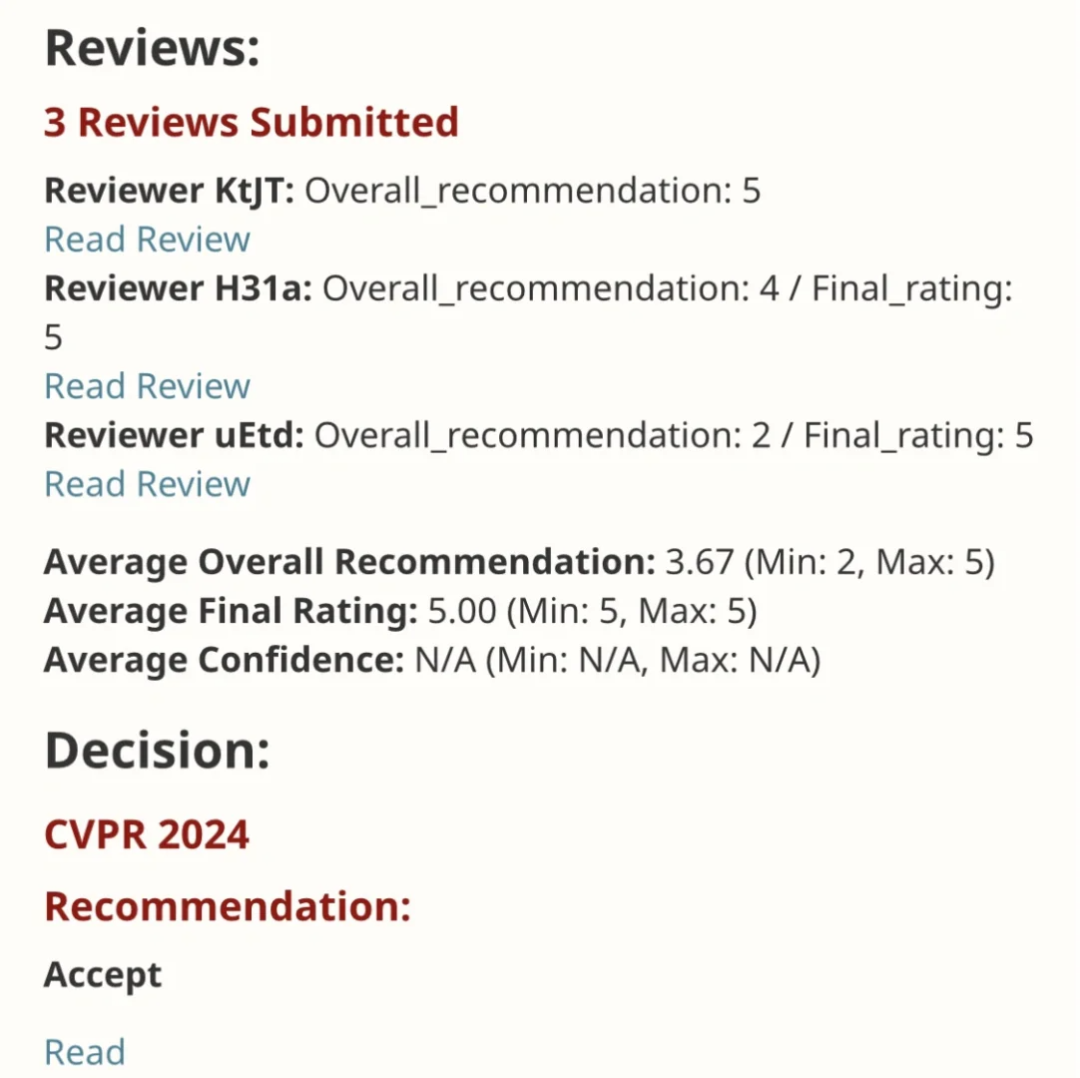

EfficientSAM Diese Arbeit wurde in CVPR 2024 mit einer perfekten Punktzahl von 5/5/5 aufgenommen! Der Autor teilte das Ergebnis in den sozialen Medien mit, wie im Bild unten gezeigt:

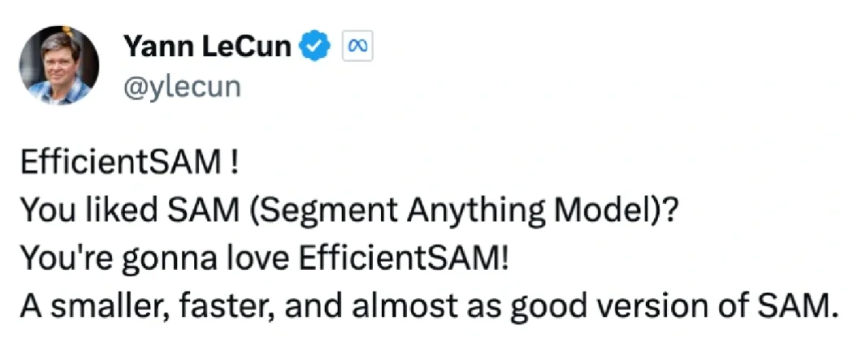

Der LeCun-Turing-Preisträger hat diese Arbeit ebenfalls wärmstens empfohlen!

In jüngsten Untersuchungen haben Metaforscher eine neue verbesserte Methode vorgeschlagen, das Masked Image Pre-Training mit SAM (SAMI). Dieser Ansatz kombiniert MAE-Vortrainingstechniken und SAM-Modelle, um hochwertige vorab trainierte ViT-Encoder zu erhalten. Durch SAMI versuchen Forscher, die Leistung und Effizienz des Modells zu verbessern und bessere Lösungen für Sehaufgaben bereitzustellen. Der Vorschlag dieser Methode bringt neue Ideen und Möglichkeiten mit sich, die Bereiche Computer Vision und Deep Learning weiter zu erforschen und weiterzuentwickeln. Durch die Kombination verschiedener Pre-Training-Techniken und Modellstrukturen können Forscher weiterhin

- Link zum Papier: https://arxiv.org/pdf/2312.00863

- Code : github.com/yformer/EfficientSAM

- Homepage: https://yformer.github.io/efficient-sam/

Dieser Ansatz reduziert die Komplexität von SAM und sorgt gleichzeitig für eine gute Leistung. Konkret nutzt SAMI den SAM-Encoder ViT-H, um Feature-Einbettungen zu generieren und trainiert ein Maskenbildmodell mit einem leichtgewichtigen Encoder, wodurch Features aus SAMs ViT-H anstelle von Bildpatches rekonstruiert werden und das resultierende universelle ViT-Backbone für nachgelagerte Aufgaben wie z B. Bildklassifizierung, Objekterkennung und -segmentierung usw. Anschließend verwenden wir den SAM-Decoder zur Feinabstimmung des vorab trainierten, leichten Encoders, um jede Segmentierungsaufgabe abzuschließen.

Um die Wirksamkeit dieser Methode zu überprüfen, verwendeten die Forscher eine Transfer-Lerneinstellung, die vorab auf maskierten Bildern trainiert wurde. Konkret trainierten sie zunächst das Modell mit Rekonstruktionsverlust im ImageNet-Datensatz mit einer Bildauflösung von 224×224. Anschließend optimieren sie das Modell mithilfe überwachter Daten aus der Zielaufgabe. Diese Transferlernmethode kann dem Modell helfen, schnell zu lernen und die Leistung bei neuen Aufgaben zu verbessern, da das Modell in der Vortrainingsphase gelernt hat, Merkmale aus den Originaldaten zu extrahieren. Diese Transfer-Lernstrategie nutzt effektiv das in großen Datensätzen erlernte Wissen und erleichtert so die Anpassung des Modells an verschiedene Aufgaben. Gleichzeitig kann ViT-Tiny/- durch SAMI-Vortraining auf ImageNet-1K Small trainiert werden /-Base und andere Modelle und verbessern die Generalisierungsleistung. Für das ViT-Small-Modell erreichten die Forscher nach 100-maliger Feinabstimmung auf ImageNet-1K eine Top-1-Genauigkeit von 82,7 %, was besser ist als bei anderen hochmodernen Bild-Pre-Training-Baselines.

Die Forscher haben das vorab trainierte Modell hinsichtlich Zielerkennung, Instanzsegmentierung und semantischer Segmentierung verfeinert. Bei all diesen Aufgaben erzielt unsere Methode bessere Ergebnisse als andere vorab trainierte Basislinien und, was noch wichtiger ist, sie erzielt erhebliche Fortschritte bei kleinen Modellen.

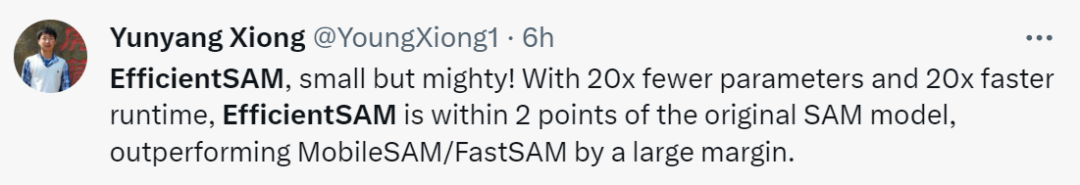

Yunyang Xiong, der Autor des Artikels, sagte: Die in diesem Artikel vorgeschlagenen EfficientSAM-Parameter werden um das 20-fache reduziert, aber die Laufzeit ist 20-mal schneller. Der Unterschied zum ursprünglichen SAM-Modell beträgt nur 2 Prozentpunkte , was viel besser ist als MobileSAM/FastSAM.

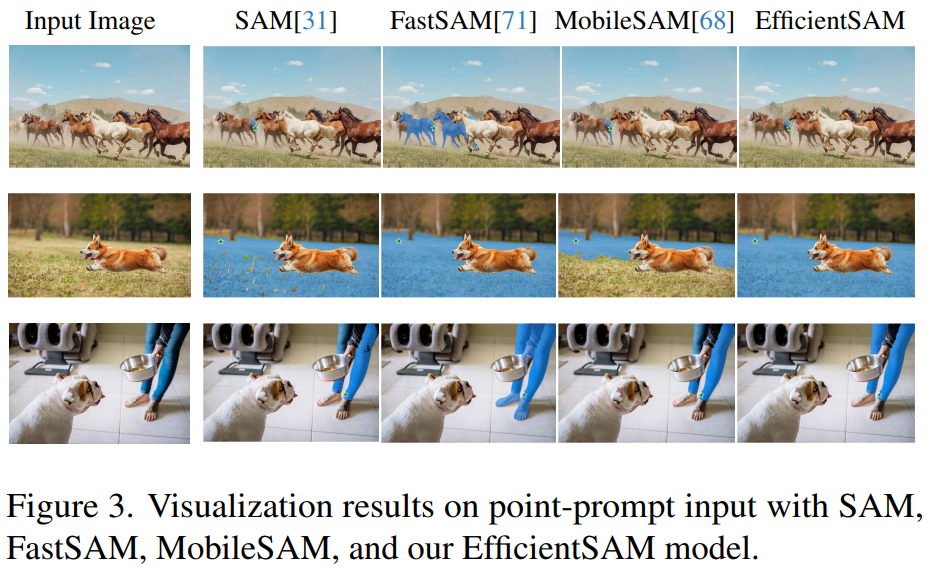

Klicken Sie in der Demo auf das Tier im Bild, und EfficientSAM kann das Objekt schnell segmentieren:

EfficientSAM kann auch die Personen auf dem Bild genau identifizieren:

Testadresse: https://ab348ea7942fe2af48.gradio.live/

Methode

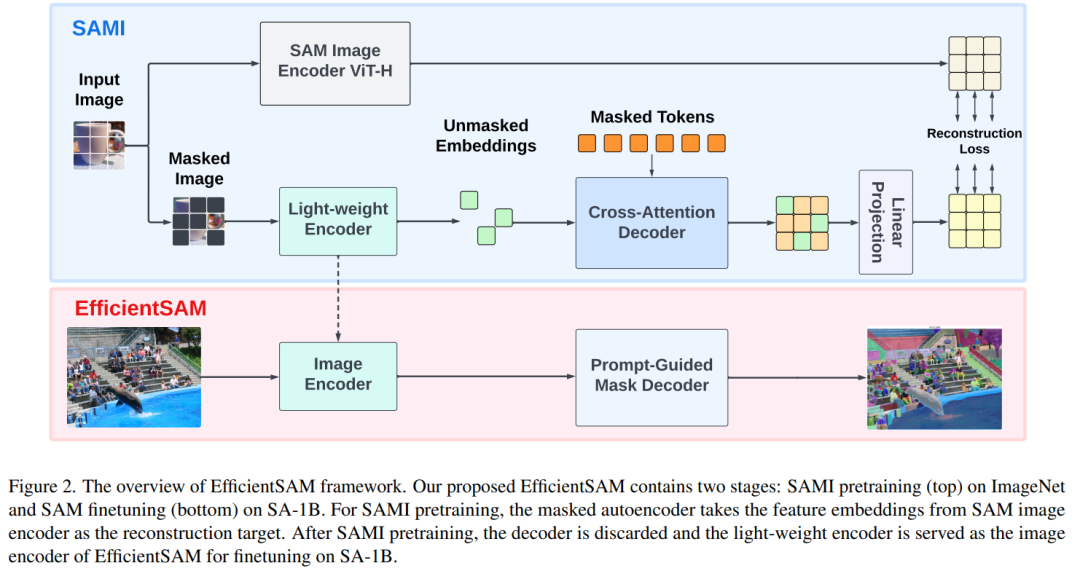

EfficientSAM enthält zwei Phasen: 1) SAMI vor dem Training auf ImageNet (Teil 1); 2) SA-1B-Feinabstimmung das SAM (unten).

Effizientes SAM enthält hauptsächlich die folgenden Komponenten: während des Rekonstruktionsprozesses rekonstruiert werden können, fungieren als Anker. Im Cross-Attention-Decoder kommt die Abfrage von den maskierten Token, und die Schlüssel und Werte werden von den unmaskierten Features und maskierten Features vom Encoder abgeleitet. In diesem Artikel werden die Ausgabemerkmale der maskierten Token des Cross-Attention-Decoders und die Ausgabemerkmale der unmaskierten Token des Encoders für die MAE-Ausgabeeinbettung zusammengeführt. Diese kombinierten Features werden dann in der endgültigen MAE-Ausgabe an den ursprünglichen Positionen der Eingabebild-Tokens neu angeordnet.

Linearer Projektionskopf. Anschließend haben wir die über den Encoder und den Queraufmerksamkeitsdecoder erhaltenen Bildausgaben in einen kleinen Projektkopf eingespeist, um die Merkmale im SAM-Bildencoder auszurichten. Der Einfachheit halber wird in diesem Artikel nur ein linearer Projektionskopf verwendet, um die Nichtübereinstimmung der Merkmalsabmessungen zwischen dem SAM-Bildcodierer und der MAE-Ausgabe zu beheben.

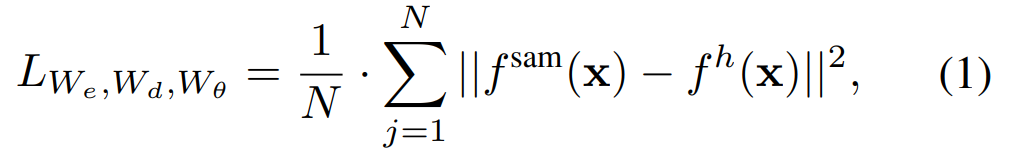

Wiederaufbau von Verlusten. In jeder Trainingsiteration umfasst SAMI die Extraktion von Vorwärtsmerkmalen aus dem SAM-Bildkodierer sowie Vorwärts- und Rückwärtsausbreitungsprozesse des MAE. Die Ausgaben des SAM-Bildkodierers und des MAE-Linearprojektionskopfes werden verglichen, um den Rekonstruktionsverlust zu berechnen.

Nach dem Vortraining kann der Encoder Feature-Darstellungen für verschiedene visuelle Aufgaben extrahieren, und der Decoder wird ebenfalls verworfen. Um insbesondere ein effizientes SAM-Modell für jede Segmentierungsaufgabe zu erstellen, werden in diesem Artikel vorab trainierte SAMI-Leichtgewicht-Encoder (wie ViT-Tiny und ViT-Small) als Bild-Encoder von EfficientSAM und Standard-Maskendecoder von SAM verwendet. , wie in Abbildung 2 (unten) dargestellt. In diesem Artikel wird das EfficientSAM-Modell für den SA-1B-Datensatz verfeinert, um eine Segmentierung jeder Aufgabe zu erreichen.

Experiment

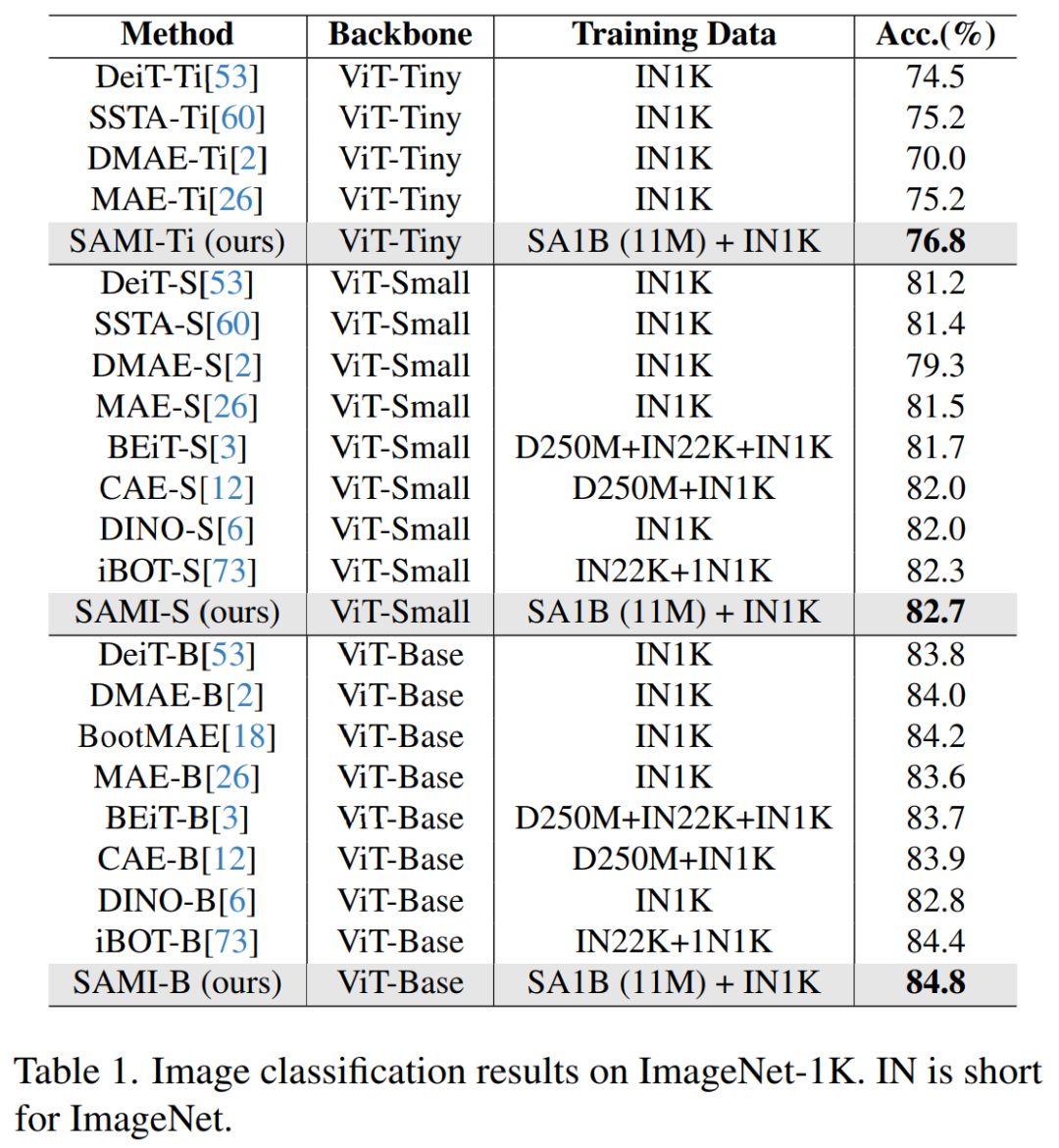

Bildklassifizierung. Um die Wirksamkeit dieser Methode bei Bildklassifizierungsaufgaben zu bewerten, wandten die Forscher SAMI-Ideen auf das ViT-Modell an und verglichen ihre Leistung auf ImageNet-1K.

Wie in Tabelle 1 gezeigt, wird SAMI mit Pre-Training-Methoden wie MAE, iBOT, CAE und BEiT sowie Destillationsmethoden wie DeiT und SSTA verglichen.

Die Top1-Genauigkeit von SAMI-B erreicht 84,8 %, was höher ist als die vorab trainierte Basislinie MAE, DMAE, iBOT, CAE und BEiT. SAMI zeigt auch große Verbesserungen im Vergleich zu Destillationsmethoden wie DeiT und SSTA. Bei leichten Modellen wie ViT-Tiny und ViT-Small zeigen die SAMI-Ergebnisse deutliche Vorteile im Vergleich zu DeiT, SSTA, DMAE und MAE.

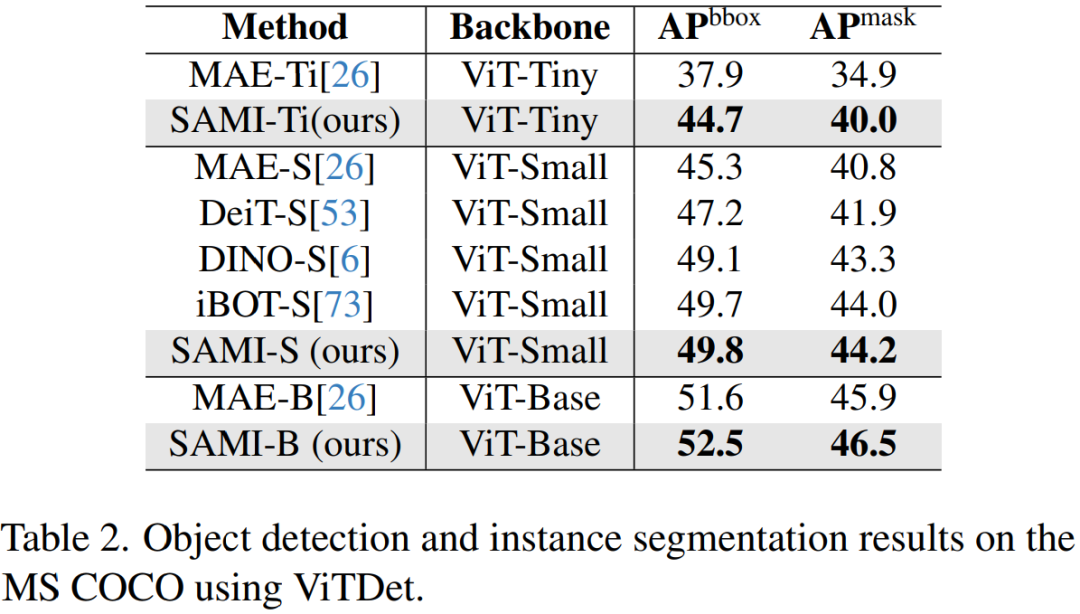

Objekterkennung und Instanzsegmentierung. Dieses Papier erweitert auch das SAMI-vortrainierte ViT-Backbone auf nachgelagerte Objekterkennungs- und Instanzsegmentierungsaufgaben und vergleicht es mit einer Basislinie, die auf dem COCO-Datensatz vorab trainiert wurde. Wie in Tabelle 2 gezeigt, übertrifft SAMI durchweg die Leistung anderer Baselines.

Diese experimentellen Ergebnisse zeigen, dass das von SAMI bereitgestellte vorab trainierte Detektor-Backbone bei Objekterkennungs- und Instanzsegmentierungsaufgaben sehr effektiv ist.

Semantische Segmentierung. In diesem Artikel wird das vorab trainierte Backbone weiter auf semantische Segmentierungsaufgaben erweitert, um seine Wirksamkeit zu bewerten. Die Ergebnisse sind in Tabelle 3 aufgeführt. Mask2former erreicht mit dem vorab trainierten SAMI-Backbone bessere mIoU auf ImageNet-1K als mit dem vorab trainierten MAE-Backbone. Diese experimentellen Ergebnisse bestätigen, dass die in diesem Artikel vorgeschlagene Technologie gut auf verschiedene nachgelagerte Aufgaben übertragen werden kann.

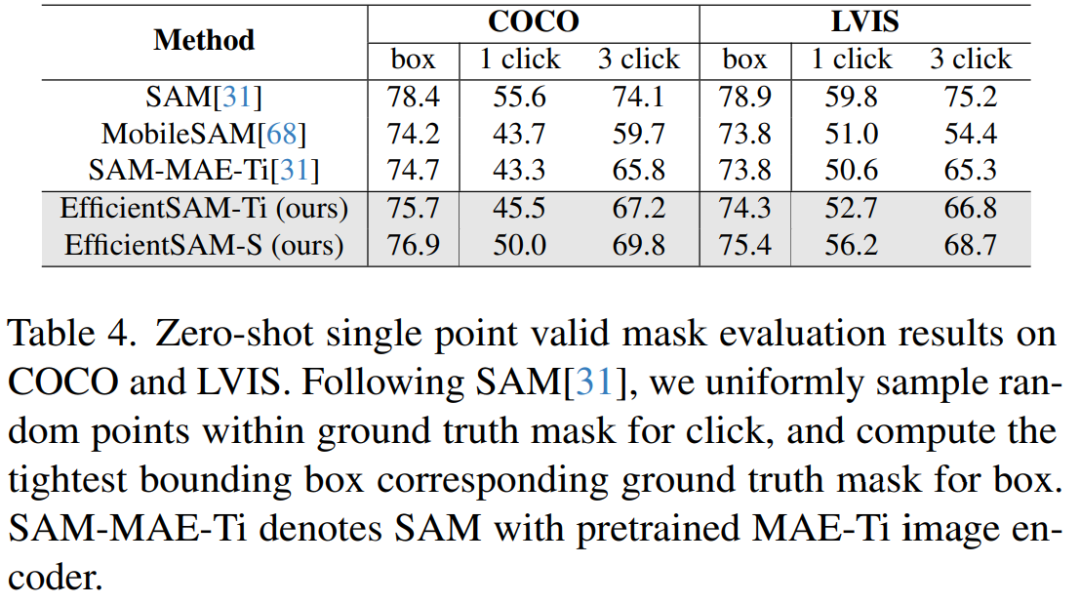

Tabelle 4 vergleicht EfficientSAMs mit SAM, MobileSAM und SAM-MAE-Ti. Auf COCO übertrifft EfficientSAM-Ti MobileSAM. EfficientSAM-Ti verfügt über vorab trainierte SAMI-Gewichte und bietet auch eine bessere Leistung als vorab trainierte MAE-Gewichte.

Darüber hinaus ist EfficientSAM-S nur 1,5 mIoU niedriger als SAM auf der COCO-Box und 3,5 mIoU niedriger als SAM auf der LVIS-Box, mit 20-mal weniger Parametern. In diesem Artikel wurde außerdem festgestellt, dass EfficientSAM im Vergleich zu MobileSAM und SAM-MAE-Ti auch bei mehreren Klicks eine gute Leistung zeigte.

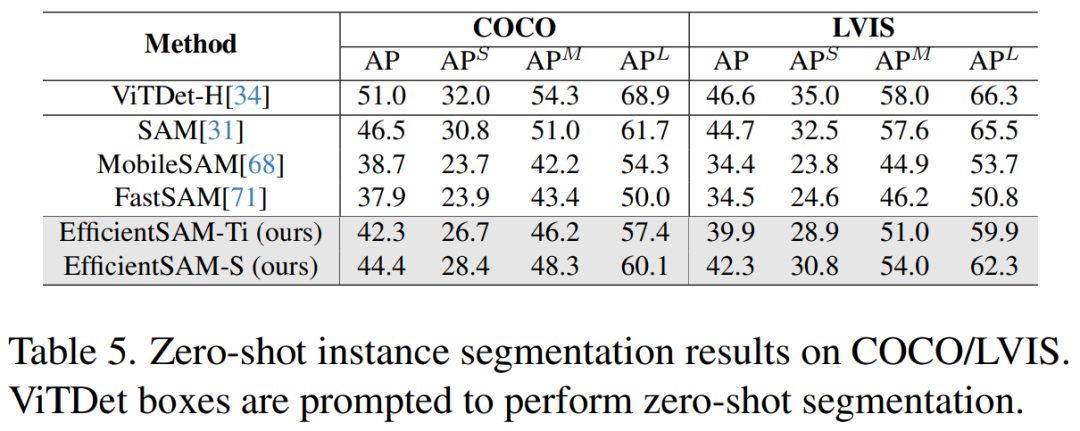

Tabelle 5 zeigt die AP, APS, APM und APL der Zero-Shot-Instanzsegmentierung. Die Forscher verglichen EfficientSAM mit MobileSAM und FastSAM und es zeigt sich, dass EfficientSAM-S im Vergleich zu FastSAM mehr als 6,5 APs auf COCO und 7,8 APs auf LVIS gewann. Im Fall von EffidientSAM-Ti ist es mit 4,1 APs auf COCO und 5,3 APs auf LVIS immer noch deutlich besser als FastSAM, während MobileSAM 3,6 APs auf COCO und 5,5 APs auf LVIS hat.

Darüber hinaus ist EfficientSAM viel leichter als FastSAM, die Parameter vonefficientSAM-Ti betragen 9,8M, während die Parameter von FastSAM 68M betragen.

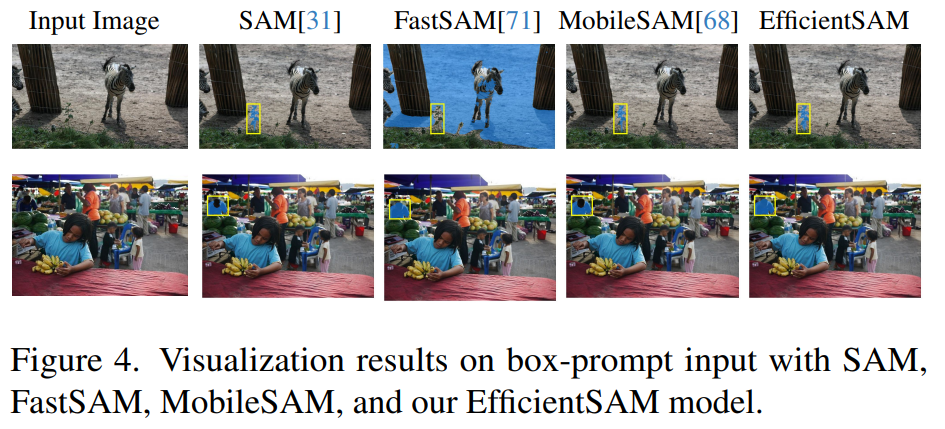

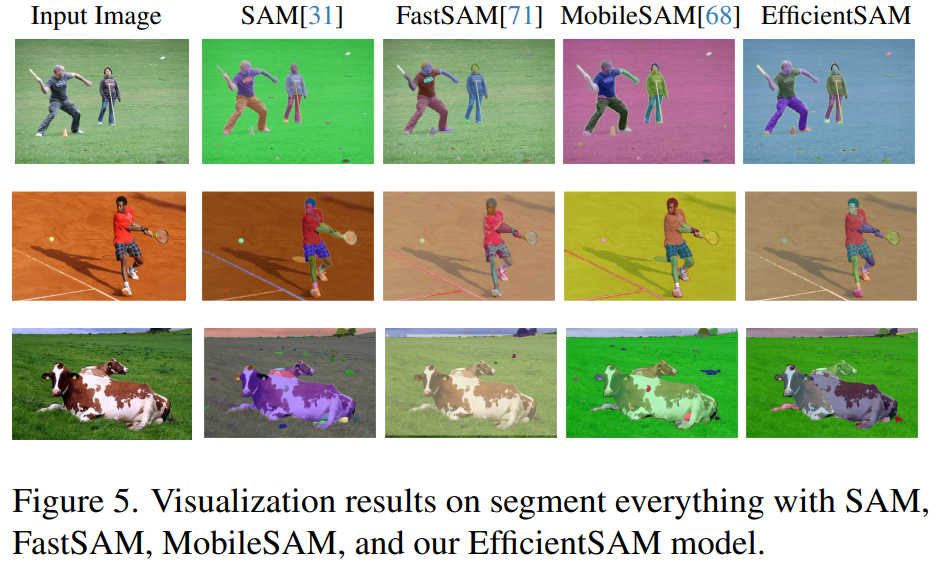

Die Abbildungen 3, 4 und 5 liefern einige qualitative Ergebnisse, damit die Leser ein ergänzendes Verständnis der Instanzsegmentierungsfunktionen von EfficientSAMs erhalten.

Weitere Forschungsdetails finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonVPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1380

1380

52

52

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Aktuelle Deep-Edge-Erkennungsnetzwerke verwenden normalerweise eine Encoder-Decoder-Architektur, die Up- und Down-Sampling-Module enthält, um mehrstufige Merkmale besser zu extrahieren. Diese Struktur schränkt jedoch die Ausgabe genauer und detaillierter Kantenerkennungsergebnisse des Netzwerks ein. Als Antwort auf dieses Problem bietet ein Papier zu AAAI2024 eine neue Lösung. Titel der Abschlussarbeit: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection Autoren: Ye Yunfan (Nationale Universität für Verteidigungstechnologie), Xu Kai (Nationale Universität für Verteidigungstechnologie), Huang Yuxing (Nationale Universität für Verteidigungstechnologie), Yi Renjiao (Nationale Universität für Verteidigungstechnologie), Cai Zhiping (National University of Defense Technology) Link zum Papier: https://ar

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

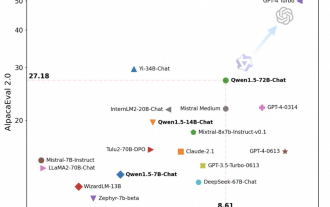

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Pünktlich zum Frühlingsfest ist Version 1.5 des Tongyi Qianwen Large Model (Qwen) online. Heute Morgen erregten die Neuigkeiten über die neue Version die Aufmerksamkeit der KI-Community. Die neue Version des großen Modells umfasst sechs Modellgrößen: 0,5B, 1,8B, 4B, 7B, 14B und 72B. Unter ihnen übertrifft die Leistung der stärksten Version GPT3.5 und Mistral-Medium. Diese Version umfasst das Basismodell und das Chat-Modell und bietet Unterstützung für mehrere Sprachen. Das Tongyi Qianwen-Team von Alibaba gab an, dass die entsprechende Technologie auch auf der offiziellen Website von Tongyi Qianwen und der Tongyi Qianwen App eingeführt wurde. Darüber hinaus bietet die heutige Version von Qwen 1.5 auch die folgenden Highlights: Unterstützt eine Kontextlänge von 32 KB und öffnet den Prüfpunkt des Base+Chat-Modells.

Große Modelle können ebenfalls in Scheiben geschnitten werden, und Microsoft SliceGPT erhöht die Recheneffizienz von LLAMA-2 erheblich

Jan 31, 2024 am 11:39 AM

Große Modelle können ebenfalls in Scheiben geschnitten werden, und Microsoft SliceGPT erhöht die Recheneffizienz von LLAMA-2 erheblich

Jan 31, 2024 am 11:39 AM

Große Sprachmodelle (LLMs) verfügen typischerweise über Milliarden von Parametern und werden auf Billionen von Token trainiert. Die Schulung und Bereitstellung solcher Modelle ist jedoch sehr teuer. Um den Rechenaufwand zu reduzieren, werden häufig verschiedene Modellkomprimierungstechniken eingesetzt. Diese Modellkomprimierungstechniken können im Allgemeinen in vier Kategorien unterteilt werden: Destillation, Tensorzerlegung (einschließlich Faktorisierung mit niedrigem Rang), Bereinigung und Quantisierung. Pruning-Methoden gibt es schon seit einiger Zeit, aber viele erfordern nach dem Pruning eine Feinabstimmung der Wiederherstellung (Recovery Fine-Tuning, RFT), um die Leistung aufrechtzuerhalten, was den gesamten Prozess kostspielig und schwierig zu skalieren macht. Forscher der ETH Zürich und von Microsoft haben eine Lösung für dieses Problem namens SliceGPT vorgeschlagen. Die Kernidee dieser Methode besteht darin, die Einbettung des Netzwerks durch das Löschen von Zeilen und Spalten in der Gewichtsmatrix zu reduzieren.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

LLaVA-1.6, das mit Gemini Pro gleichzieht und die Argumentations- und OCR-Fähigkeiten verbessert, ist zu leistungsstark

Feb 01, 2024 pm 04:51 PM

LLaVA-1.6, das mit Gemini Pro gleichzieht und die Argumentations- und OCR-Fähigkeiten verbessert, ist zu leistungsstark

Feb 01, 2024 pm 04:51 PM

Im April letzten Jahres veröffentlichten Forscher der University of Wisconsin-Madison, Microsoft Research und der Columbia University gemeinsam LLaVA (Large Language and Vision Assistant). Obwohl LLaVA nur mit einem kleinen multimodalen Befehlsdatensatz trainiert wird, zeigt es bei einigen Proben sehr ähnliche Inferenzergebnisse wie GPT-4. Im Oktober brachten sie dann LLaVA-1.5 auf den Markt, das den SOTA in 11 Benchmarks mit einfachen Modifikationen am ursprünglichen LLaVA aktualisierte. Die Ergebnisse dieses Upgrades sind sehr aufregend und bringen neue Durchbrüche auf dem Gebiet der multimodalen KI-Assistenten. Das Forschungsteam kündigte die Einführung der LLaVA-1.6-Version an, die auf Argumentation, OCR und zielt

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.