Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Claude3 hat GPT4 eine Lektion erteilt! Der stärkste Gegner von Open AI ist eine Late-Night-Bombe mit vollständiger Bildanalyse!

Claude3 hat GPT4 eine Lektion erteilt! Der stärkste Gegner von Open AI ist eine Late-Night-Bombe mit vollständiger Bildanalyse!

Claude3 hat GPT4 eine Lektion erteilt! Der stärkste Gegner von Open AI ist eine Late-Night-Bombe mit vollständiger Bildanalyse!

Produziert von 51CTO Technology Stack (WeChat-ID: blog51cto)

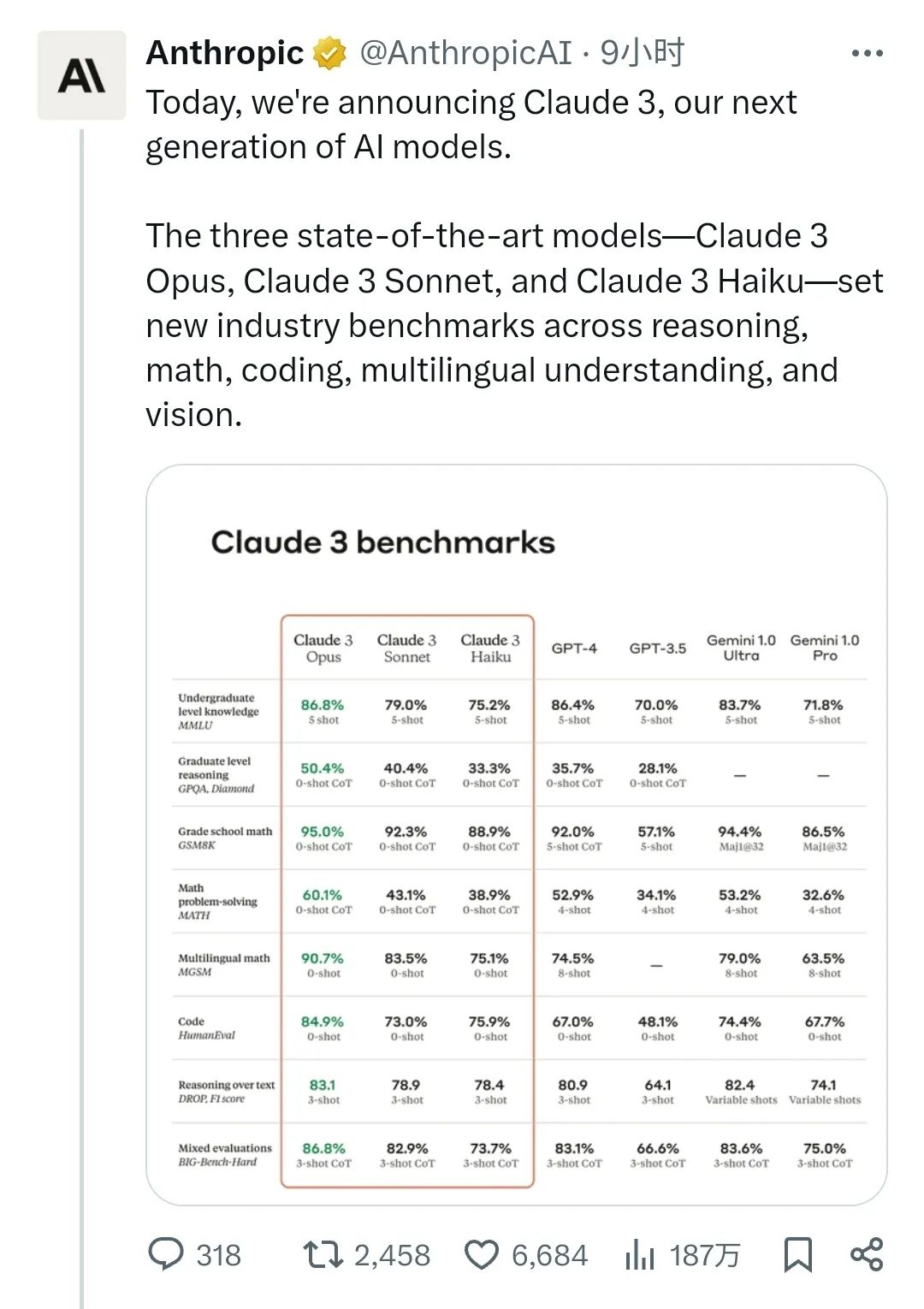

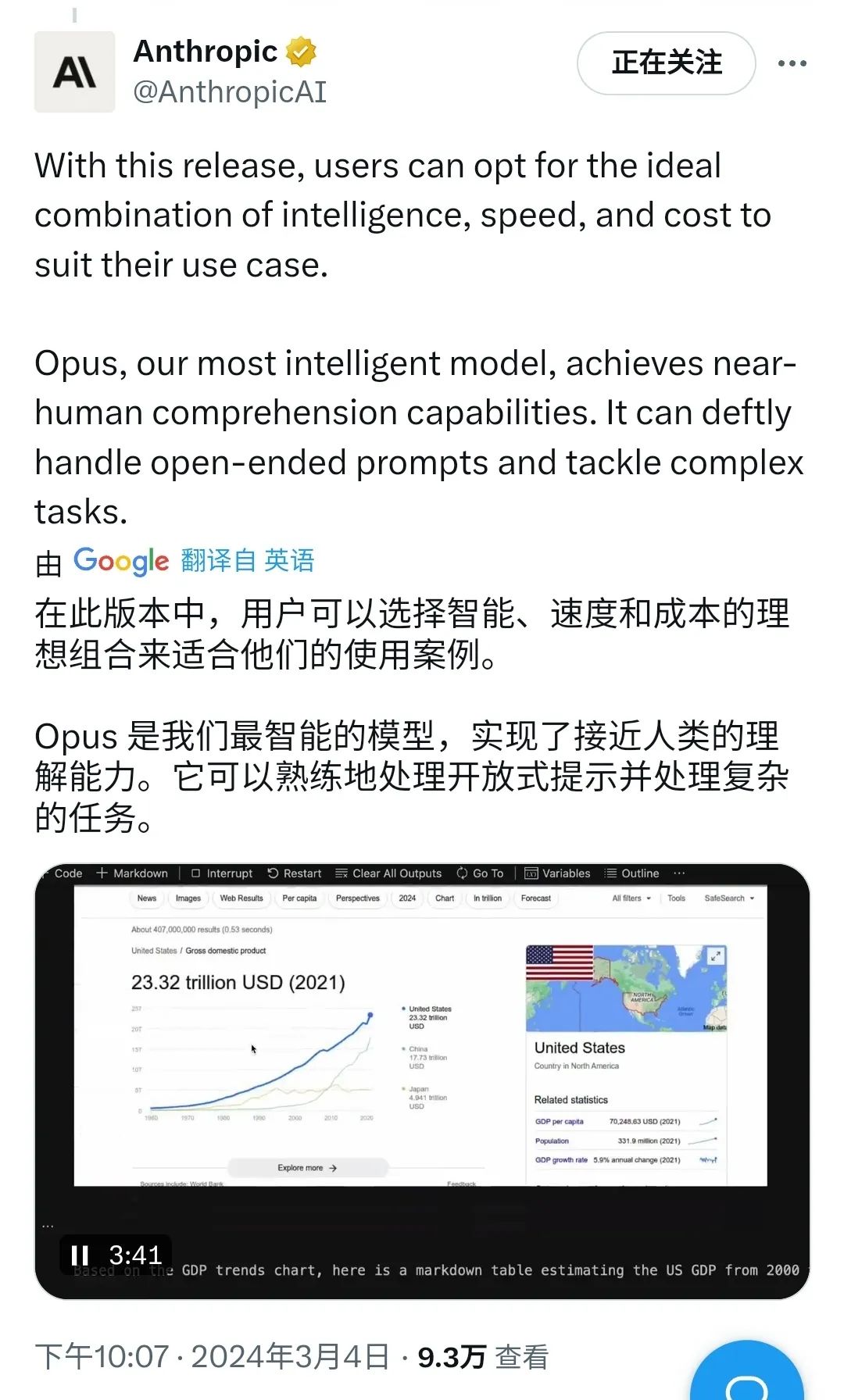

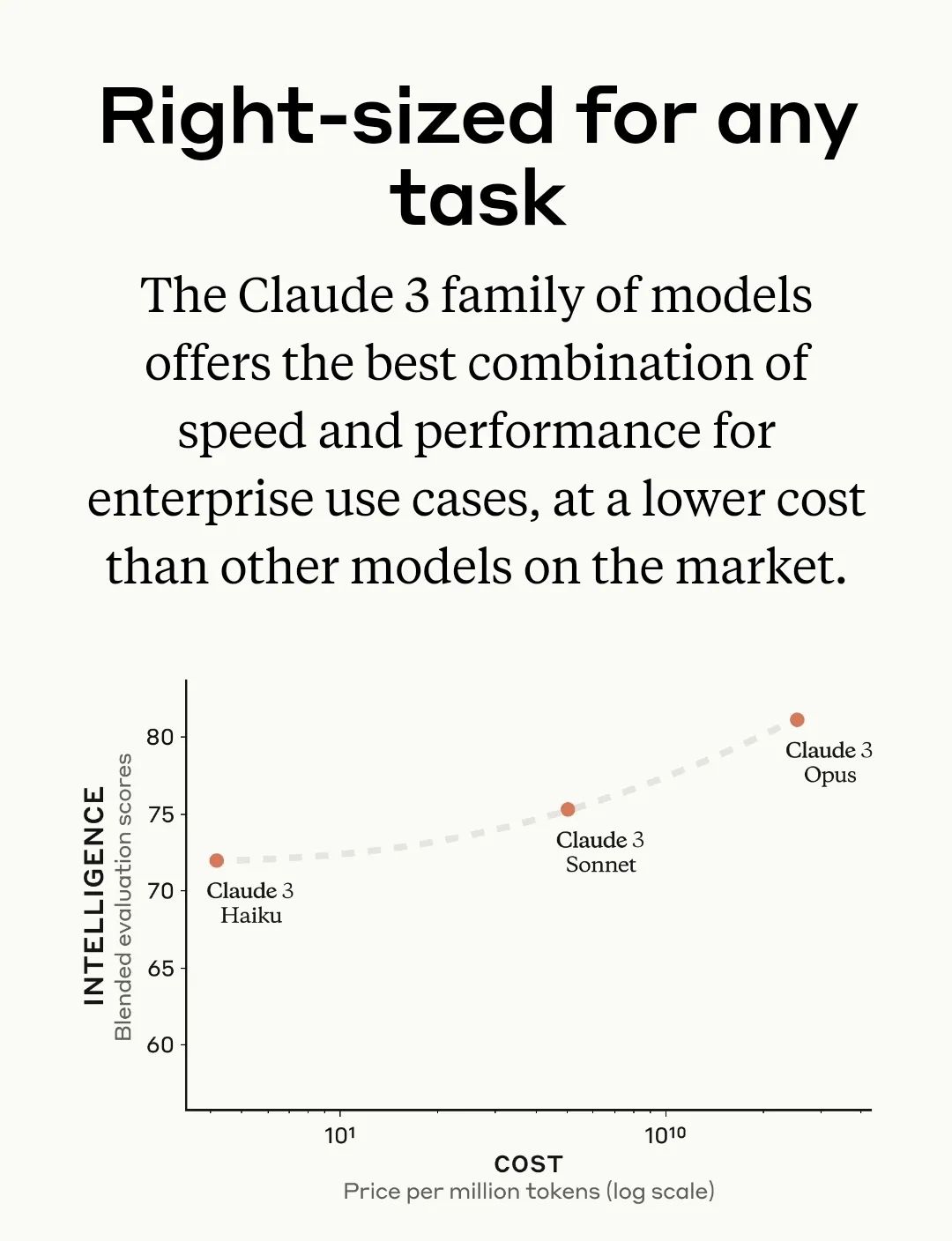

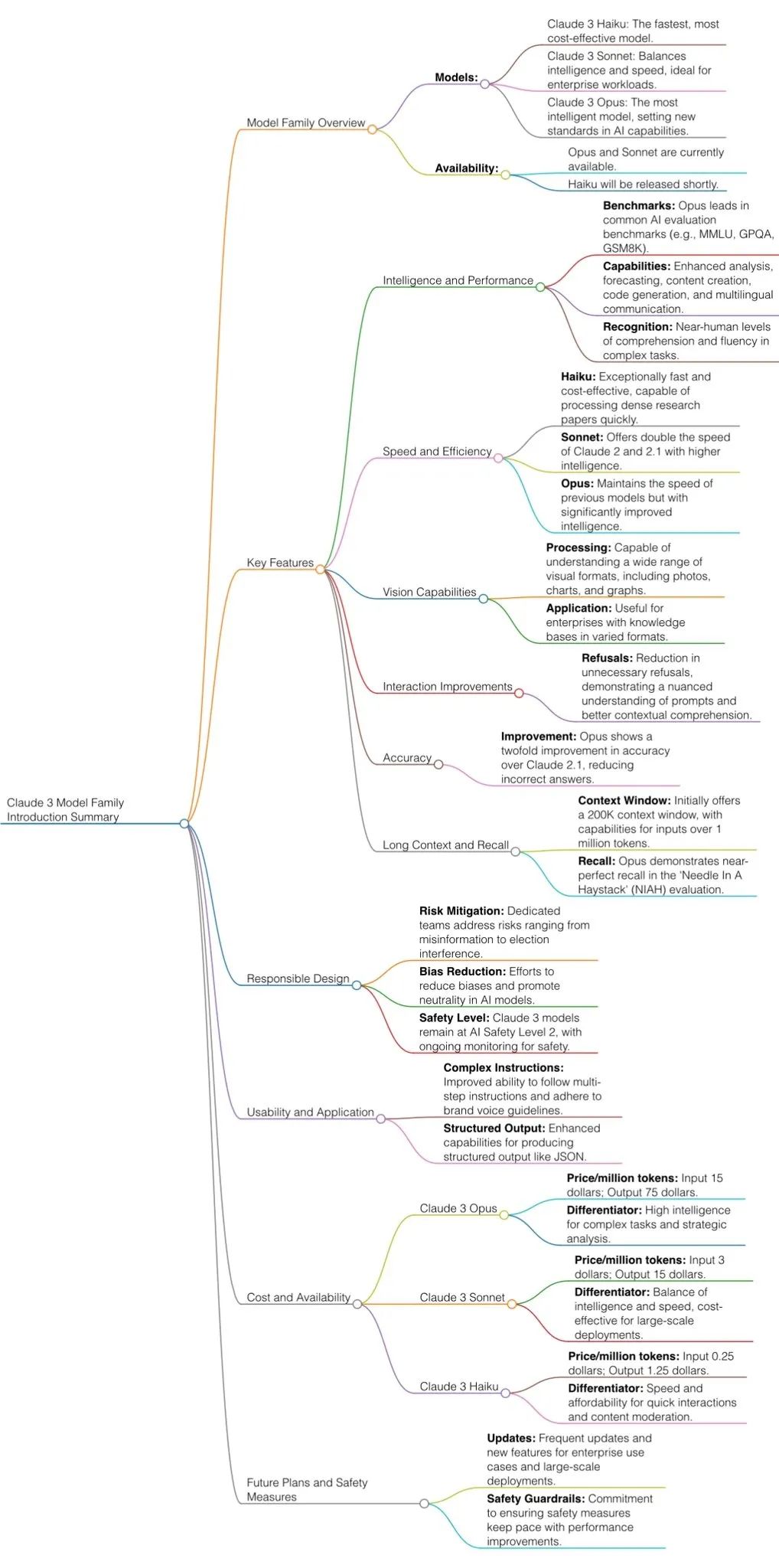

Spät in der Nacht veröffentlichte OpenAIs stärkster Rivale Anthropic drei neue SOTA-Produkte auf einmal, darunter: Claude 3 Haiku, Claude 3 Sonnet und Claude 3 Opus. Die Branche rief aus: Claude 3 bringt eine Reihe neuer Branchenmaßstäbe.

Unter ihnen bedeutet Opus epische Bewegung, Sonnet bedeutet Sonett und Haiku bedeutet Haiku, ein dreizeiliges Kurzgedicht.

Es wird berichtet (Abbildung 9), dass Haiku das schnellste und kostengünstigste Modell auf dem KI-Markt ist. Es kann informative und datenintensive Forschungsarbeiten (~10.000 Token) auf arXiv, die Diagramme und Grafiken enthalten, in weniger als drei Sekunden lesen.

Abbildung 8: Sonnet ist bei den meisten Arbeitslasten doppelt so schnell wie Claude 2 und Claude 2.1 und verfügt über ein höheres Maß an Intelligenz. Es eignet sich hervorragend für Aufgaben, die schnelle Reaktionen erfordern, wie z. B. Wissensabruf oder Vertriebsautomatisierung. Opus ähnelt in der Geschwindigkeit Claude 2 und 2.1, verfügt jedoch über ein höheres Maß an Intelligenz.

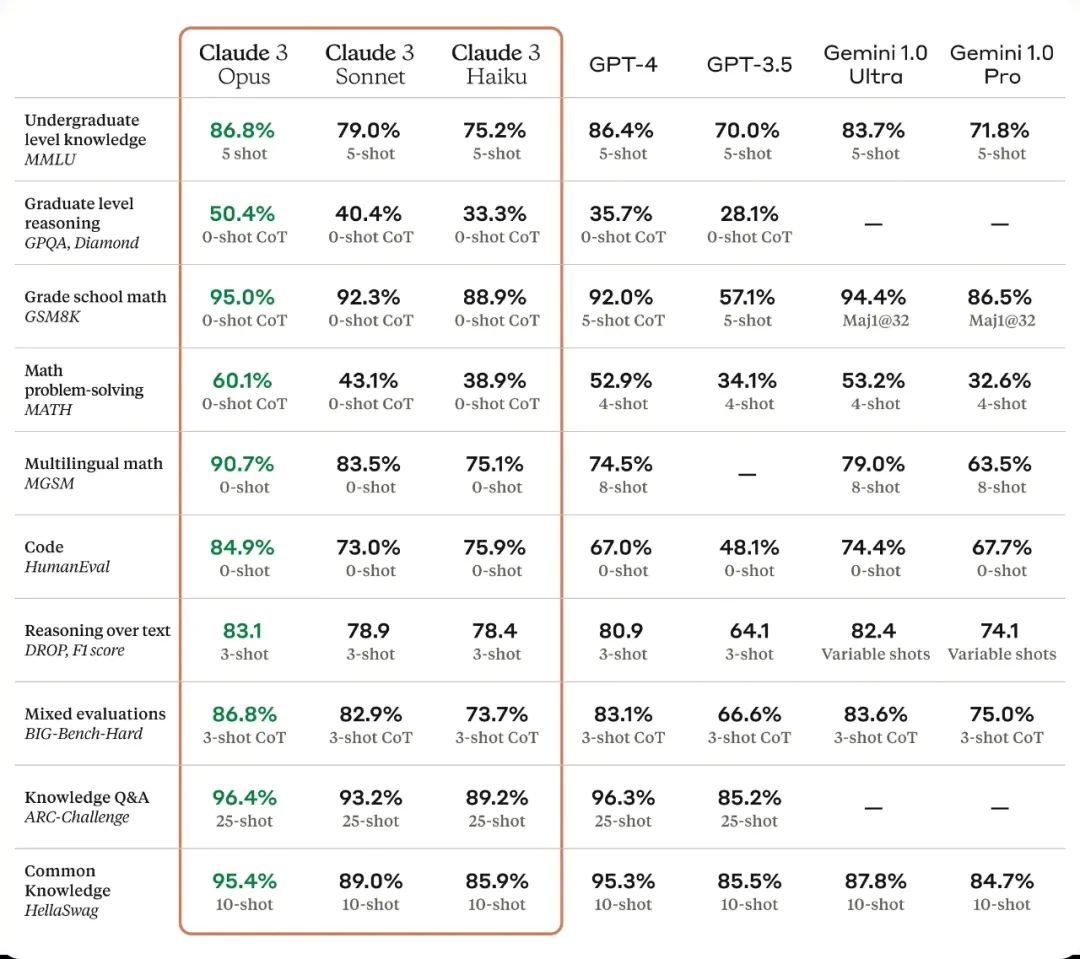

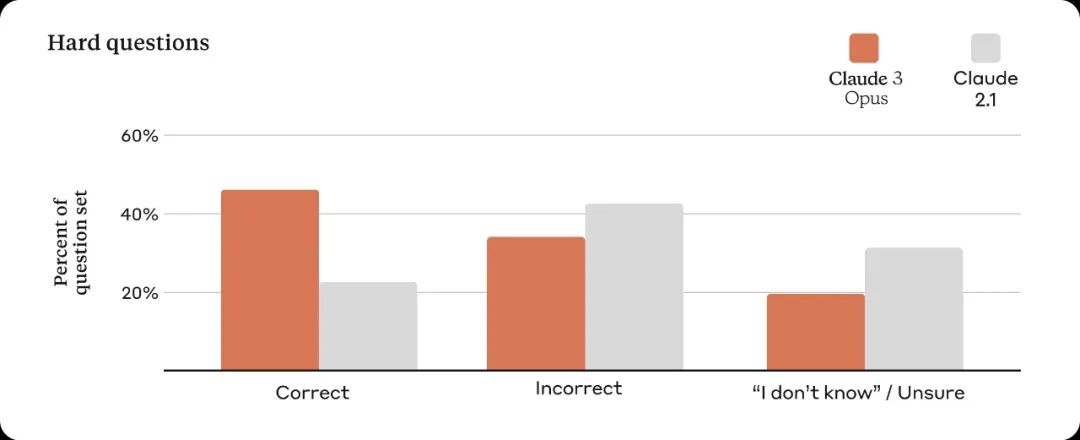

Opus ist derzeit das intelligenteste Modell von Anthropic und übertrifft seine Mitbewerber bei den gängigsten Bewertungsbenchmarks für Systeme der künstlichen Intelligenz, darunter Undergraduate Level Expert Knowledge (MMLU), Graduate Level Expert Reasoning (GPQA), Basic Mathematics (GSM8K) usw. . Es demonstriert ein nahezu menschliches Verständnis und eine fließende Bewältigung komplexer Aufgaben und führt damit die Grenze der allgemeinen Intelligenz an.

Die oben genannten drei Claude-3-Modelle weisen alle größere Fähigkeiten bei der Analyse und Vorhersage, der Erstellung detaillierter Inhalte, der Codegenerierung und der Konversation in nicht-englischen Sprachen wie Spanisch, Japanisch und Französisch auf.

Darüber hinaus verfügt die Claude 3-Serie über nahezu perfekte Speicherkapazitäten und extrem lange Textfenster, die 200.000 Kontextfenster bereitstellen. Und es kann die Eingabe von mehr als 1 Million Token akzeptieren und wird nach und nach entsprechend den Kundenbedürfnissen freigegeben.

Insgesamt hat Claude3 drei schockierende Eigenschaften:

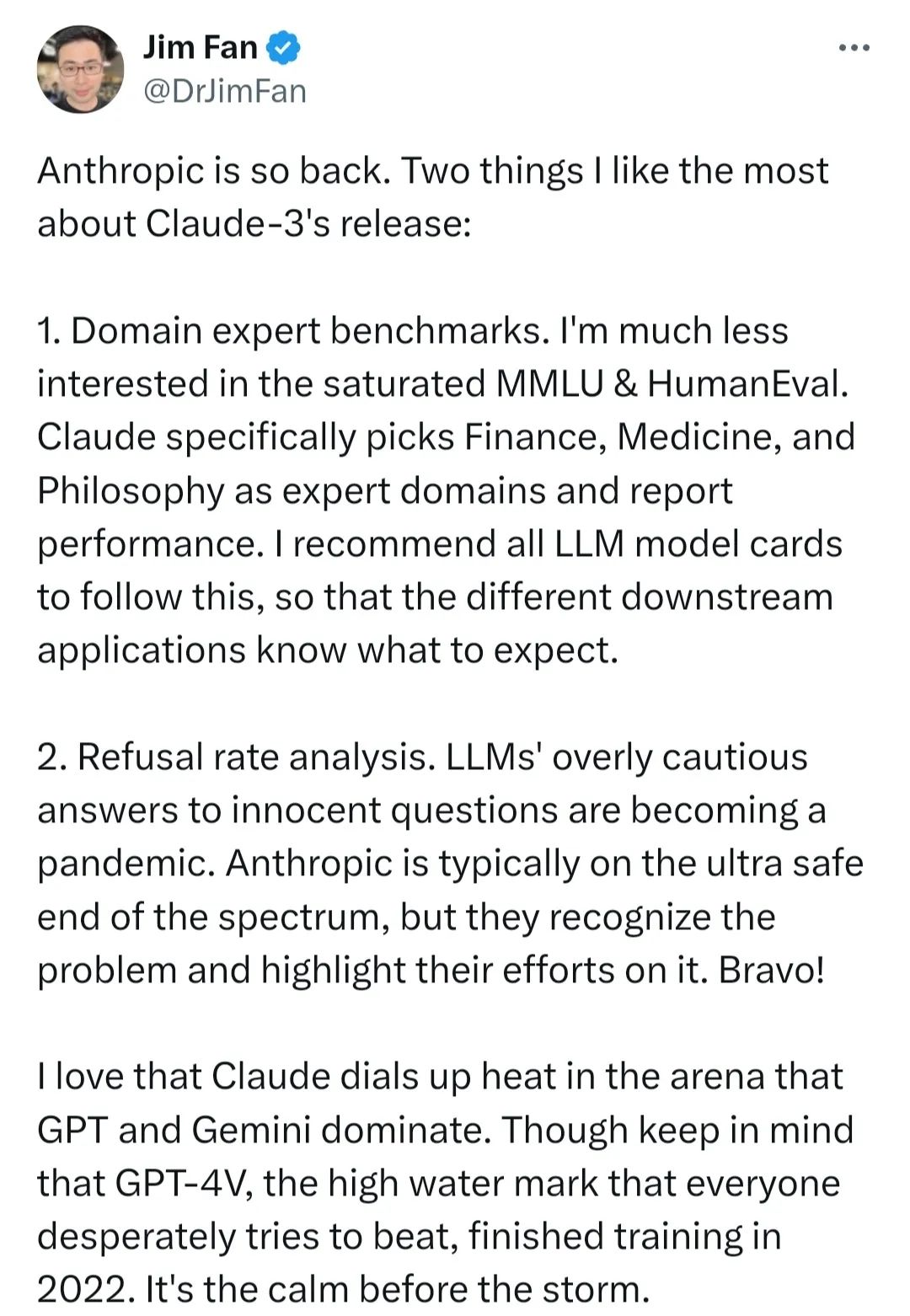

1. Benchmarks von Domain-Experten. Als Testmaßstäbe wurden drei Expertenbereiche aus den Bereichen Finanzen/Medizin/Philosophie ausgewählt. Jim Fan, Forschungsleiter bei NVIDIA, sagte: „Es wird empfohlen, dass sich alle LLMs daran halten, damit verschiedene nachgelagerte Anwendungen wissen, was passieren wird.“

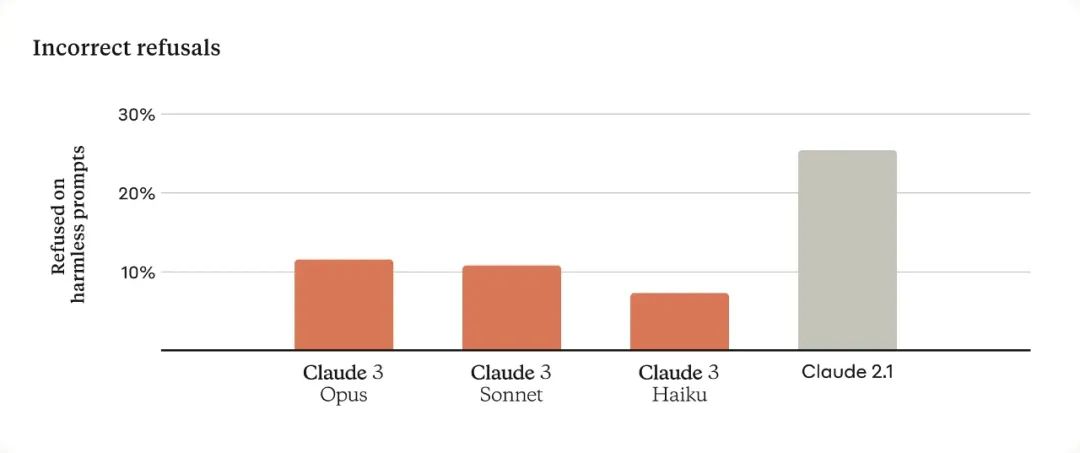

2. Analyse der Ablehnungsrate. LLM ist zu einer Epidemie mit übermäßig vorsichtigen Antworten auf viele „unschuldige Fragen“ geworden. Claude hat sich für sichere KI-Forschung eingesetzt und Anstrengungen in diesem Bereich unternommen.

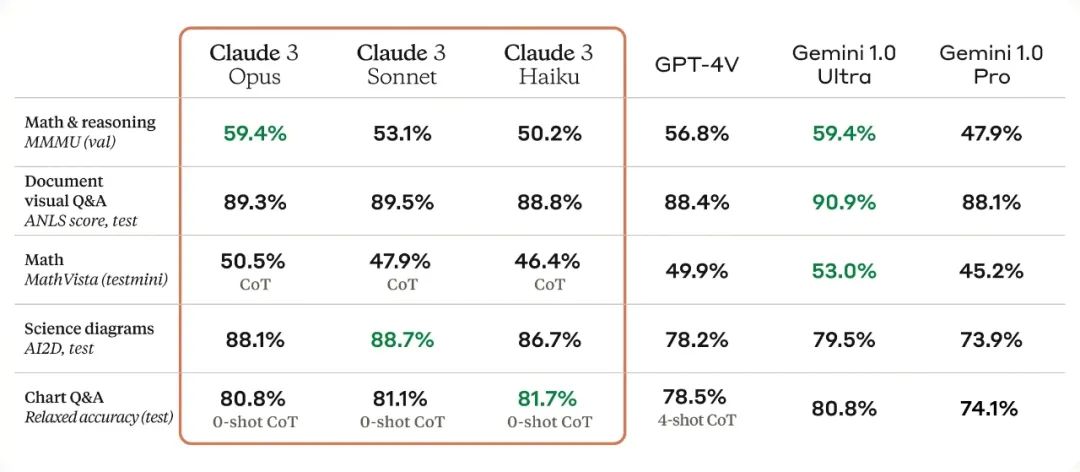

3. Anspruchsvolle visuelle Funktionen, vergleichbar mit anderen führenden Modellen. Funktioniert mit einer Vielzahl visueller Formate, darunter Fotos, Diagramme, Grafiken und technische Diagramme, PDFs, Flussdiagramme oder Präsentationsfolien.

Wie ist die eigentliche Bewertung?

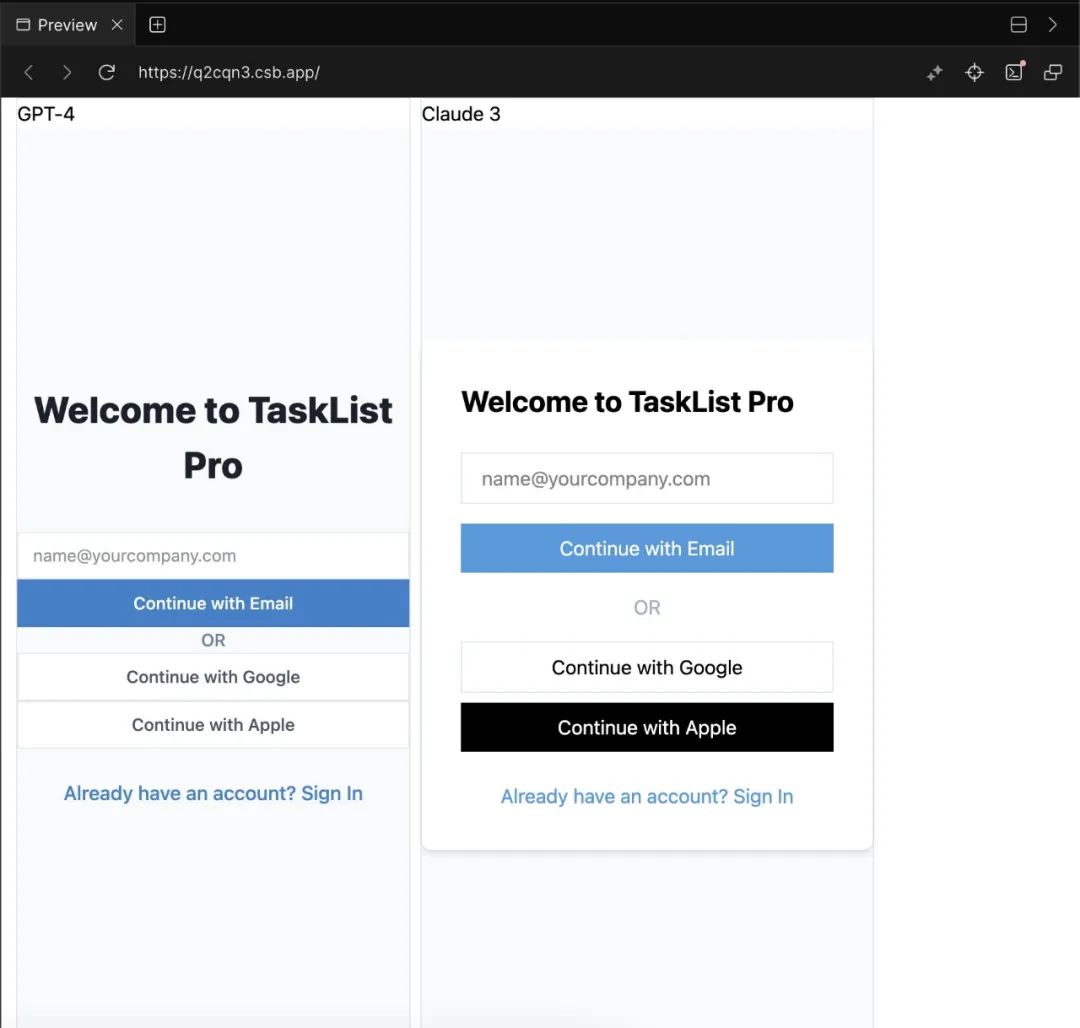

Ein Internetnutzer hat GPT4 und Claude3 gebeten, jeweils einen Login-Schnittstellencode zu schreiben. Die tatsächlichen Testergebnisse (Abbildung 13) zeigen, dass letzterer im App-Schnittstellendesign besser ist.

.

.

Das obige ist der detaillierte Inhalt vonClaude3 hat GPT4 eine Lektion erteilt! Der stärkste Gegner von Open AI ist eine Late-Night-Bombe mit vollständiger Bildanalyse!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1358

1358

52

52

Wählen Sie das Einbettungsmodell, das am besten zu Ihren Daten passt: Ein Vergleichstest von OpenAI und mehrsprachigen Open-Source-Einbettungen

Feb 26, 2024 pm 06:10 PM

Wählen Sie das Einbettungsmodell, das am besten zu Ihren Daten passt: Ein Vergleichstest von OpenAI und mehrsprachigen Open-Source-Einbettungen

Feb 26, 2024 pm 06:10 PM

OpenAI kündigte kürzlich die Einführung seines Einbettungsmodells embeddingv3 der neuesten Generation an, das seiner Meinung nach das leistungsstärkste Einbettungsmodell mit höherer Mehrsprachenleistung ist. Diese Reihe von Modellen ist in zwei Typen unterteilt: das kleinere Text-Embeddings-3-Small und das leistungsfähigere und größere Text-Embeddings-3-Large. Es werden nur wenige Informationen darüber offengelegt, wie diese Modelle entworfen und trainiert werden, und auf die Modelle kann nur über kostenpflichtige APIs zugegriffen werden. Es gab also viele Open-Source-Einbettungsmodelle. Aber wie schneiden diese Open-Source-Modelle im Vergleich zum Closed-Source-Modell von OpenAI ab? In diesem Artikel wird die Leistung dieser neuen Modelle empirisch mit Open-Source-Modellen verglichen. Wir planen, Daten zu erstellen

Ein neues Programmierparadigma, wenn Spring Boot auf OpenAI trifft

Feb 01, 2024 pm 09:18 PM

Ein neues Programmierparadigma, wenn Spring Boot auf OpenAI trifft

Feb 01, 2024 pm 09:18 PM

Im Jahr 2023 ist die KI-Technologie zu einem heißen Thema geworden und hat enorme Auswirkungen auf verschiedene Branchen, insbesondere im Programmierbereich. Die Bedeutung der KI-Technologie wird den Menschen zunehmend bewusst, und die Spring-Community bildet da keine Ausnahme. Mit der kontinuierlichen Weiterentwicklung der GenAI-Technologie (General Artificial Intelligence) ist es entscheidend und dringend geworden, die Erstellung von Anwendungen mit KI-Funktionen zu vereinfachen. Vor diesem Hintergrund entstand „SpringAI“ mit dem Ziel, den Prozess der Entwicklung von KI-Funktionsanwendungen zu vereinfachen, ihn einfach und intuitiv zu gestalten und unnötige Komplexität zu vermeiden. Durch „SpringAI“ können Entwickler einfacher Anwendungen mit KI-Funktionen erstellen, wodurch diese einfacher zu verwenden und zu bedienen sind.

Können Online-Karten noch so sein? MapTracker: Nutzen Sie Tracking, um das neue SOTA von Online-Karten zu realisieren!

Apr 25, 2024 pm 05:01 PM

Können Online-Karten noch so sein? MapTracker: Nutzen Sie Tracking, um das neue SOTA von Online-Karten zu realisieren!

Apr 25, 2024 pm 05:01 PM

Wie oben geschrieben und nach persönlichem Verständnis des Autors ermöglicht dieser Algorithmus eine hochpräzise Online-Kartenerstellung. Unsere Methode MapTracker sammelt Sensorströme in Speicherpuffern für zwei Anzeigen: 1) Rasterlatenten im BEV-Raum (Bird's Eye View) und 2) Vektorlatenten auf Straßenelementen (d. h. Zebrastreifen, Fahrspurlinien und Straßengrenzen). Die Methode stützt sich auf das Abfrageausbreitungsparadigma bei der Objektverfolgung, das die verfolgten Straßenelemente des vorherigen Frames explizit mit dem aktuellen Frame verknüpft und gleichzeitig eine Teilmenge von Speicherlatenzen mit Distanzschritten zum Open-Source-Link zusammenführt: https://map-tracker .github.io/ Zusammenfassend sind die Hauptbeiträge dieses Artikels wie folgt: Ein neuer

Der Rust-basierte Zed-Editor ist Open Source und bietet integrierte Unterstützung für OpenAI und GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Der Rust-basierte Zed-Editor ist Open Source und bietet integrierte Unterstützung für OpenAI und GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Autor丨Zusammengestellt von TimAnderson丨Produziert von Noah|51CTO Technology Stack (WeChat-ID: blog51cto) Das Zed-Editor-Projekt befindet sich noch in der Vorabversionsphase und wurde unter AGPL-, GPL- und Apache-Lizenzen als Open Source bereitgestellt. Der Editor zeichnet sich durch hohe Leistung und mehrere KI-gestützte Optionen aus, ist jedoch derzeit nur auf der Mac-Plattform verfügbar. Nathan Sobo erklärte in einem Beitrag, dass in der Codebasis des Zed-Projekts auf GitHub der Editor-Teil unter der GPL lizenziert ist, die serverseitigen Komponenten unter der AGPL lizenziert sind und der GPUI-Teil (GPU Accelerated User) die Schnittstelle übernimmt Apache2.0-Lizenz. GPUI ist ein vom Zed-Team entwickeltes Produkt

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Wenn die Antwort des KI-Modells überhaupt unverständlich ist, würden Sie es wagen, sie zu verwenden? Da maschinelle Lernsysteme in immer wichtigeren Bereichen eingesetzt werden, wird es immer wichtiger zu zeigen, warum wir ihren Ergebnissen vertrauen können und wann wir ihnen nicht vertrauen sollten. Eine Möglichkeit, Vertrauen in die Ausgabe eines komplexen Systems zu gewinnen, besteht darin, vom System zu verlangen, dass es eine Interpretation seiner Ausgabe erstellt, die für einen Menschen oder ein anderes vertrauenswürdiges System lesbar ist, d. h. so vollständig verständlich, dass mögliche Fehler erkannt werden können gefunden. Um beispielsweise Vertrauen in das Justizsystem aufzubauen, verlangen wir von den Gerichten, dass sie klare und lesbare schriftliche Stellungnahmen abgeben, die ihre Entscheidungen erläutern und stützen. Für große Sprachmodelle können wir auch einen ähnlichen Ansatz verfolgen. Stellen Sie bei diesem Ansatz jedoch sicher, dass das Sprachmodell generiert wird

Warten Sie nicht auf OpenAI, sondern darauf, dass Open-Sora vollständig Open Source ist

Mar 18, 2024 pm 08:40 PM

Warten Sie nicht auf OpenAI, sondern darauf, dass Open-Sora vollständig Open Source ist

Mar 18, 2024 pm 08:40 PM

Vor nicht allzu langer Zeit wurde OpenAISora mit seinen erstaunlichen Videogenerierungseffekten schnell populär und stach aus der Masse der literarischen Videomodelle hervor und rückte in den Mittelpunkt der weltweiten Aufmerksamkeit. Nach der Einführung des Sora-Trainings-Inferenzreproduktionsprozesses mit einer Kostenreduzierung von 46 % vor zwei Wochen hat das Colossal-AI-Team das weltweit erste Sora-ähnliche Architektur-Videogenerierungsmodell „Open-Sora1.0“ vollständig als Open-Source-Lösung bereitgestellt, das das gesamte Spektrum abdeckt Lernen Sie den Trainingsprozess, einschließlich der Datenverarbeitung, aller Trainingsdetails und Modellgewichte, kennen und schließen Sie sich mit globalen KI-Enthusiasten zusammen, um eine neue Ära der Videoerstellung voranzutreiben. Schauen wir uns für einen kleinen Vorgeschmack ein Video einer geschäftigen Stadt an, das mit dem vom Colossal-AI-Team veröffentlichten Modell „Open-Sora1.0“ erstellt wurde. Open-Sora1.0

Die lokale Ausführungsleistung des Embedding-Dienstes übertrifft die von OpenAI Text-Embedding-Ada-002, was sehr praktisch ist!

Apr 15, 2024 am 09:01 AM

Die lokale Ausführungsleistung des Embedding-Dienstes übertrifft die von OpenAI Text-Embedding-Ada-002, was sehr praktisch ist!

Apr 15, 2024 am 09:01 AM

Ollama ist ein superpraktisches Tool, mit dem Sie Open-Source-Modelle wie Llama2, Mistral und Gemma problemlos lokal ausführen können. In diesem Artikel werde ich vorstellen, wie man Ollama zum Vektorisieren von Text verwendet. Wenn Sie Ollama nicht lokal installiert haben, können Sie diesen Artikel lesen. In diesem Artikel verwenden wir das Modell nomic-embed-text[2]. Es handelt sich um einen Text-Encoder, der OpenAI text-embedding-ada-002 und text-embedding-3-small bei kurzen und langen Kontextaufgaben übertrifft. Starten Sie den nomic-embed-text-Dienst, wenn Sie o erfolgreich installiert haben

Microsoft und OpenAI planen, 100 Millionen US-Dollar in humanoide Roboter zu investieren! Internetnutzer rufen Musk an

Feb 01, 2024 am 11:18 AM

Microsoft und OpenAI planen, 100 Millionen US-Dollar in humanoide Roboter zu investieren! Internetnutzer rufen Musk an

Feb 01, 2024 am 11:18 AM

Anfang des Jahres wurde bekannt, dass Microsoft und OpenAI große Geldsummen in ein Startup für humanoide Roboter investieren. Unter anderem plant Microsoft, 95 Millionen US-Dollar zu investieren, und OpenAI wird 5 Millionen US-Dollar investieren. Laut Bloomberg wird das Unternehmen in dieser Runde voraussichtlich insgesamt 500 Millionen US-Dollar einsammeln, und seine Pre-Money-Bewertung könnte 1,9 Milliarden US-Dollar erreichen. Was zieht sie an? Werfen wir zunächst einen Blick auf die Robotik-Erfolge dieses Unternehmens. Dieser Roboter ist ganz in Silber und Schwarz gehalten und ähnelt in seinem Aussehen dem Abbild eines Roboters in einem Hollywood-Science-Fiction-Blockbuster: Jetzt steckt er eine Kaffeekapsel in die Kaffeemaschine: Wenn sie nicht richtig platziert ist, passt sie sich von selbst an menschliche Fernbedienung: Nach einer Weile kann jedoch eine Tasse Kaffee mitgenommen und genossen werden: Haben Sie Familienmitglieder, die es erkannt haben? Ja, dieser Roboter wurde vor einiger Zeit erstellt.