Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Alles in jeder Szene: Realistische Objekteinfügung (zur Unterstützung der Synthese verschiedener Fahrdaten)

Alles in jeder Szene: Realistische Objekteinfügung (zur Unterstützung der Synthese verschiedener Fahrdaten)

Alles in jeder Szene: Realistische Objekteinfügung (zur Unterstützung der Synthese verschiedener Fahrdaten)

Originaltitel: Anything in Any Scene: Photorealistic Video Object Insertion

Papierlink: https://arxiv.org/pdf/2401.17509.pdf

Codelink: https://github.com/AnythingInAnyScene/anything_in_anyscene

Zugehörigkeit des Autors: Vor allem, wenn die Aufnahme von Videos in der realen Welt unpraktisch oder teuer ist. Bestehende Methoden in der Videosimulation sind oft nicht in der Lage, Beleuchtungsumgebungen genau zu modellieren, Objektgeometrien darzustellen oder ein hohes Maß an Fotorealismus zu erreichen. In diesem Artikel wird „Anything in Any Scene“ vorgeschlagen, ein neuartiges und vielseitiges Simulationsframework für reale Videos, das jedes Objekt nahtlos in vorhandene dynamische Videos einfügen und den physischen Realismus betonen kann. Der in diesem Artikel vorgeschlagene Gesamtrahmen enthält drei Schlüsselprozesse: 1) Integration realer Objekte in ein bestimmtes Szenenvideo und deren Platzierung an geeigneten Orten, um geometrischen Realismus sicherzustellen; 2) Schätzung der Verteilung der Himmels- und Umgebungsbeleuchtung sowie Simulation realer Schatten und Verbesserung des Lichtrealismus; 3) Verwenden Sie ein Stilübertragungsnetzwerk, um die endgültige Videoausgabe zu verfeinern und den Fotorealismus zu maximieren. Dieser Artikel beweist experimentell, dass das Anything in Any Scene-Framework Simulationsvideos mit ausgezeichnetem geometrischem Realismus, Beleuchtungsrealismus und Fotorealismus generieren kann. Durch die deutliche Reduzierung der mit der Videodatengenerierung verbundenen Herausforderungen bietet unser Framework eine effiziente und kostengünstige Lösung für den Erhalt hochwertiger Videos. Darüber hinaus gehen seine Anwendungen weit über die Verbesserung von Videodaten hinaus und zeigen vielversprechendes Potenzial in der virtuellen Realität, der Videobearbeitung und verschiedenen anderen videozentrierten Anwendungen.

Hauptbeitrag

Hauptbeitrag

In diesem Artikel wird ein neuartiges und erweiterbares Anything in Any Scene-Videosimulationsframework vorgestellt, mit dem jedes Objekt in jedes dynamische Szenenvideo integriert werden kann.

Dieser Artikel ist einzigartig strukturiert und konzentriert sich auf die Beibehaltung von Geometrie, Beleuchtung und Fotorealismus in Videosimulationen, um eine hohe Qualität und Authentizität der Ausgabeergebnisse sicherzustellen.Nach umfassender Verifizierung zeigen die Ergebnisse, dass das Framework in der Lage ist, äußerst realistische Videosimulationen zu erstellen und damit den Anwendungsbereich und das Entwicklungspotenzial dieses Bereichs deutlich zu erweitern.

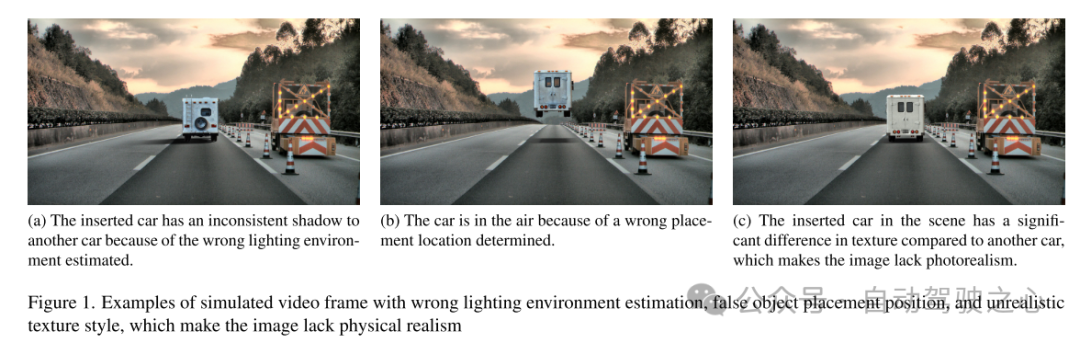

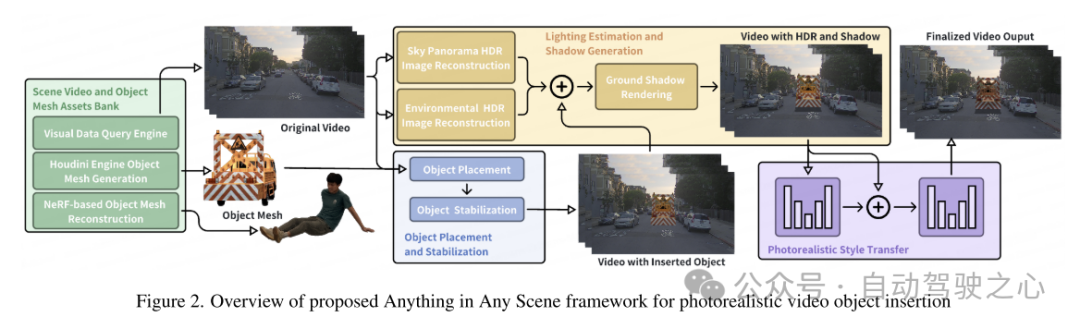

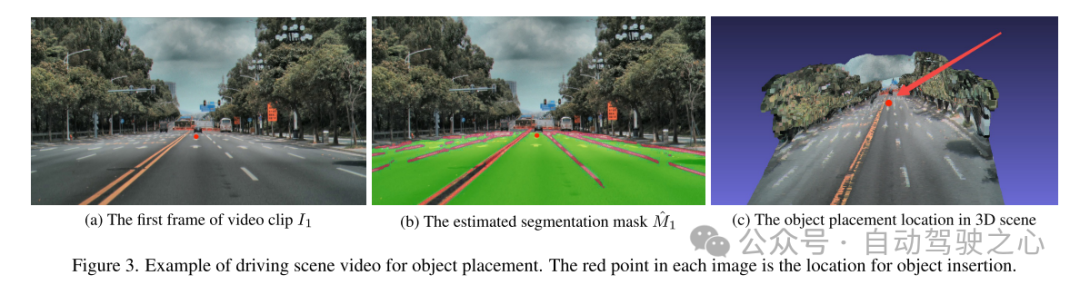

Thesis Design

Bild- und Videosimulationen werden in einer Vielzahl von Anwendungen von der virtuellen Realität bis zur Filmproduktion erfolgreich eingesetzt. Die Fähigkeit, durch fotorealistische Bild- und Videosimulation vielfältige und qualitativ hochwertige visuelle Inhalte zu generieren, hat das Potenzial, diese Bereiche voranzutreiben und neue Möglichkeiten und Anwendungen zu eröffnen. Während die Authentizität von Bildern und Videos, die in der realen Welt aufgenommen wurden, von unschätzbarem Wert ist, wird sie oft durch Long-Tail-Verbreitungen eingeschränkt. Dies führt zu einer Überrepräsentation häufiger Szenarien und einer Unterrepräsentation seltener, aber kritischer Situationen, was eine Herausforderung darstellt, die als Out-of-Distribution-Problem bekannt ist. Herkömmliche Methoden zur Beseitigung dieser Einschränkungen durch Videoaufnahme und -bearbeitung erwiesen sich als unpraktisch oder zu teuer, da es schwierig war, alle möglichen Szenarien abzudecken. Die Bedeutung der Videosimulation, insbesondere durch die Integration vorhandener Videos mit neu eingefügten Objekten, wird für die Bewältigung dieser Herausforderungen von entscheidender Bedeutung. Durch die Generierung umfangreicher, vielfältiger und realistischer visueller Inhalte trägt die Videosimulation dazu bei, Anwendungen in der virtuellen Realität, der Videobearbeitung und der Videodatenerweiterung zu erweitern. Allerdings ist die Erstellung realistischer Simulationsvideos unter Berücksichtigung des physikalischen Realismus immer noch ein herausforderndes offenes Problem. Bestehende Methoden weisen häufig Einschränkungen auf, da sie sich auf bestimmte Umgebungen konzentrieren, insbesondere auf Innenräume [9, 26, 45, 46, 57]. Diese Methoden berücksichtigen möglicherweise nicht ausreichend die Komplexität von Außenszenen, einschließlich unterschiedlicher Lichtverhältnisse und sich schnell bewegender Objekte. Methoden, die auf der Registrierung von 3D-Modellen basieren, beschränken sich auf die Integration begrenzter Objektklassen [12, 32, 40, 42]. Viele Methoden ignorieren wichtige Faktoren wie die Modellierung der Beleuchtungsumgebung, die korrekte Objektplatzierung und das Erreichen von Realismus [12, 36]. Der fehlgeschlagene Fall ist in Abbildung 1 dargestellt. Daher schränken diese Einschränkungen ihre Anwendung in Bereichen stark ein, die hoch skalierbare, geometrisch konsistente und realistische Szenenvideosimulationen erfordern, wie etwa autonomes Fahren und Robotik. In diesem Artikel wird „Anything in Any Scene“ vorgeschlagen, ein umfassendes Framework für das Einfügen fotorealistischer Videoobjekte, das diese Herausforderungen angeht. Das Framework ist so konzipiert, dass es vielseitig und für Innen- und Außenszenen geeignet ist und physikalische Genauigkeit in Bezug auf geometrischen Realismus, Beleuchtungsrealismus und Fotorealismus gewährleistet. Das Ziel dieser Arbeit besteht darin, Videosimulationen zu erstellen, die nicht nur für die visuelle Datenerweiterung beim maschinellen Lernen nützlich sind, sondern auch für verschiedene Videoanwendungen wie virtuelle Realität und Videobearbeitung geeignet sind.Die Übersicht über das Anything in Any Scene-Framework dieses Artikels ist in Abbildung 2 dargestellt. In diesem Artikel wird in Abschnitt 3 unsere neuartige und skalierbare Pipeline zum Aufbau einer vielfältigen Asset-Bibliothek aus Szenenvideos und Objektnetzen beschrieben. In diesem Artikel wird eine visuelle Datenabfrage-Engine vorgestellt, die entwickelt wurde, um relevante Videoclips aus visuellen Abfragen mithilfe beschreibender Schlüsselwörter effizient abzurufen. Als Nächstes werden in diesem Artikel zwei Methoden zum Generieren von 3D-Netzen vorgeschlagen, die sowohl vorhandene 3D-Assets als auch die Bildrekonstruktion mit mehreren Ansichten nutzen. Dies ermöglicht das uneingeschränkte Einfügen jedes gewünschten Objekts, auch wenn es sehr unregelmäßig oder semantisch schwach ist. In Abschnitt 4 beschreibt das Papier Methoden zur Integration von Objekten in dynamische Szenenvideos, wobei der Schwerpunkt auf der Aufrechterhaltung des physischen Realismus liegt. In diesem Artikel wird die in Abschnitt 4.1 beschriebene Methode zur Objektplatzierung und -stabilisierung entworfen, um sicherzustellen, dass das eingefügte Objekt in aufeinanderfolgenden Videobildern stabil verankert ist. Um der Herausforderung gerecht zu werden, realistische Licht- und Schatteneffekte zu erzeugen, schätzt dieses Dokument die Himmels- und Umgebungsbeleuchtung und erzeugt beim Rendern realistische Schatten, wie in Abschnitt 4.2 beschrieben. Die generierten simulierten Videobilder enthalten unweigerlich unrealistische Artefakte, die sich von real aufgenommenen Videos unterscheiden, wie z. B. Unterschiede in der Bildqualität in Bezug auf Rauschpegel, Farbtreue und Schärfe. In diesem Artikel wird das Stilübertragungsnetzwerk verwendet, um den Fotorealismus in Abschnitt 4.3 zu verbessern.

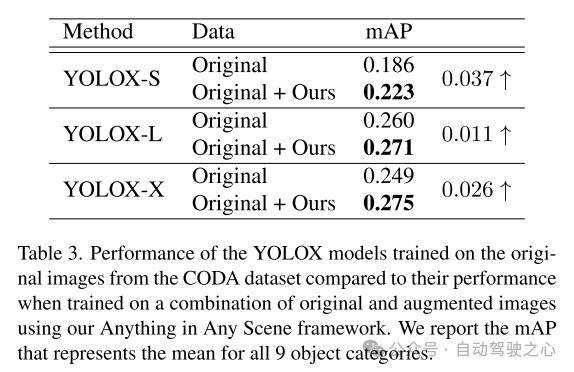

Die aus dem in diesem Artikel vorgeschlagenen Framework generierten Simulationsvideos erreichen ein hohes Maß an Beleuchtungsrealismus, geometrischem Realismus und Fotorealismus und übertreffen andere Videos sowohl in Qualität als auch in Quantität, wie in Abschnitt 5.3 gezeigt. Dieser Artikel demonstriert weiter die Anwendung des Simulationsvideos dieses Artikels beim Training von Wahrnehmungsalgorithmen in Abschnitt 5.4, um seinen praktischen Wert zu überprüfen. Das „Anything in Any Scene“-Framework ermöglicht die Erstellung umfangreicher, kostengünstiger Videodatensätze zur Datenerweiterung mit Zeiteffizienz und realistischer visueller Qualität, wodurch die Belastung durch die Videodatengenerierung verringert und möglicherweise Long-Tail- und Out-of-View-Daten verbessert werden. Herausforderungen im Vertrieb. Mit seinem allgemeinen Framework-Design kann das Anything in Any Scene-Framework problemlos verbesserte Modelle und neue Module, wie beispielsweise verbesserte 3D-Netzrekonstruktionsmethoden, integrieren, um die Leistung der Videosimulation weiter zu verbessern.

Abbildung 1. Beispiele für simulierte Videobilder mit Fehlern bei der Schätzung der Beleuchtungsumgebung, Fehlern bei der Objektplatzierung und unrealistischen Texturstilen. Diese Probleme führen dazu, dass dem Bild der physische Realismus fehlt.

Abbildung 1. Beispiele für simulierte Videobilder mit Fehlern bei der Schätzung der Beleuchtungsumgebung, Fehlern bei der Objektplatzierung und unrealistischen Texturstilen. Diese Probleme führen dazu, dass dem Bild der physische Realismus fehlt.  Abbildung 2. Übersicht über das Anything in Any Scene-Framework für das Einfügen fotorealistischer Videoobjekte.

Abbildung 2. Übersicht über das Anything in Any Scene-Framework für das Einfügen fotorealistischer Videoobjekte.  Abbildung 3. Beispiel eines Fahrszenenvideos für die Objektplatzierung. Die roten Punkte in jedem Bild zeigen an, wo die Objekte eingefügt wurden.

Abbildung 3. Beispiel eines Fahrszenenvideos für die Objektplatzierung. Die roten Punkte in jedem Bild zeigen an, wo die Objekte eingefügt wurden.

Experimentelle Ergebnisse

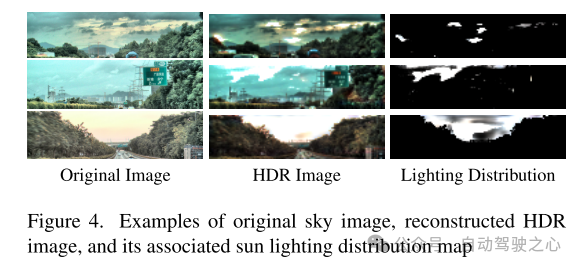

Abbildung 4. Beispiele für Original-Himmelsbilder, rekonstruierte HDR-Bilder und die zugehörigen Karten zur Verteilung der Sonneneinstrahlung

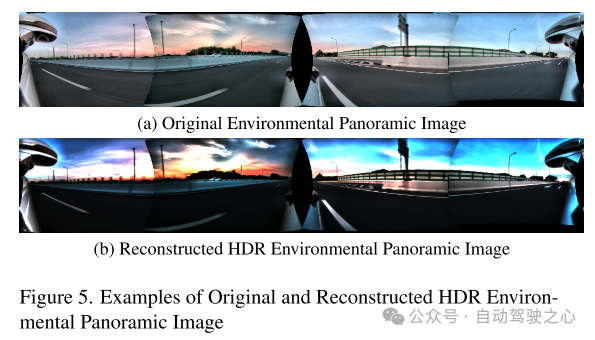

Abbildung 5. Beispiele für Original- und rekonstruierte HDR-Umgebungspanoramabilder

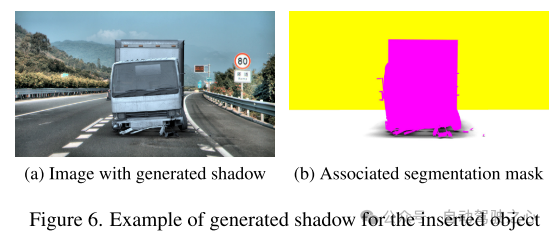

Abbildung 6. Beispiel für die Erzeugung von Schatten für eingefügte Objekte

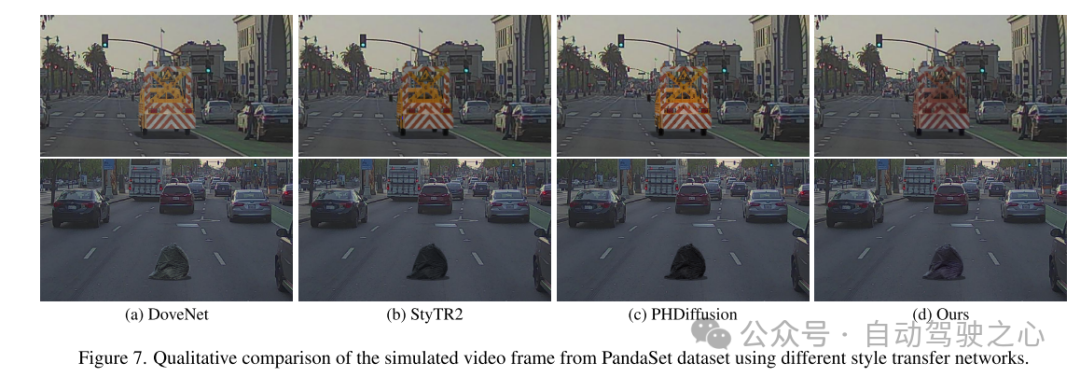

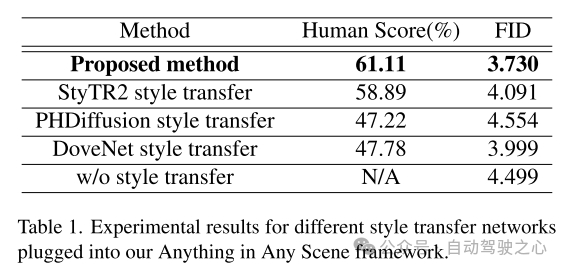

Abbildung 7. Qualitativer Vergleich simulierter Videobilder aus dem PandaSet-Datensatz unter Verwendung verschiedener Übertragungsnetzwerke.

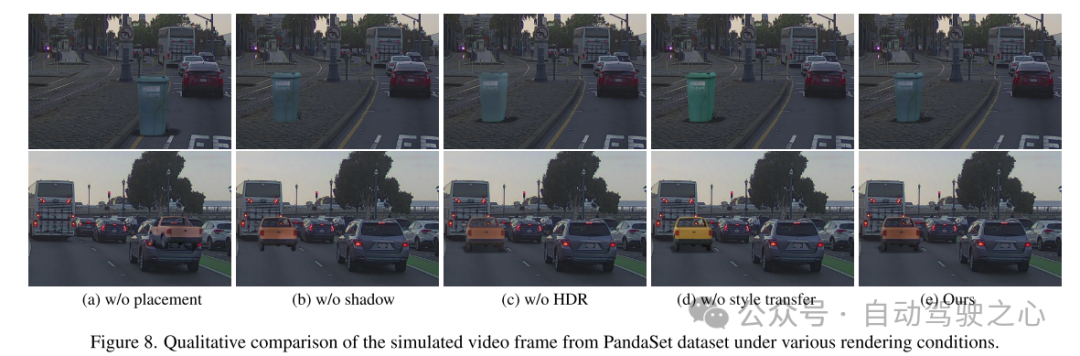

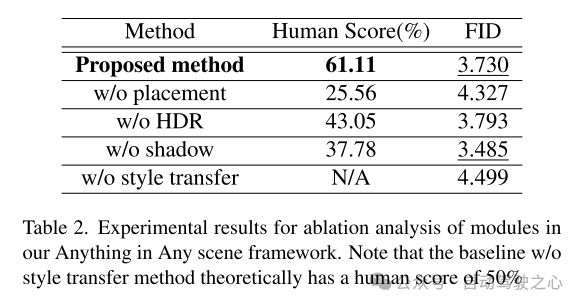

Abbildung 8. Qualitativer Vergleich simulierter Videobilder aus dem PandaSet-Datensatz unter verschiedenen Rendering-Bedingungen.

Zusammenfassung:

Dieses Papier schlägt ein innovatives und erweiterbares Framework vor, „Anything in Any Scene“, das für eine realistische Videosimulation entwickelt wurde. Das in diesem Artikel vorgeschlagene Framework integriert verschiedene Objekte nahtlos in verschiedene dynamische Videos und stellt so sicher, dass geometrischer Realismus, Beleuchtungsrealismus und Fotorealismus erhalten bleiben. Durch ausführliche Demonstrationen demonstriert dieses Papier seine Wirksamkeit bei der Bewältigung der mit der Erfassung und Generierung von Videodaten verbundenen Herausforderungen und bietet kostengünstige und zeitsparende Lösungen für eine Vielzahl von Szenarien. Die Anwendung unseres Frameworks zeigt signifikante Verbesserungen bei nachgelagerten Wahrnehmungsaufgaben, insbesondere bei der Lösung des Long-Tail-Verteilungsproblems bei der Objekterkennung. Die Flexibilität unseres Frameworks ermöglicht die direkte Integration verbesserter Modelle für jedes Modul und unser Framework legt eine solide Grundlage für zukünftige Erkundungen und Innovationen im Bereich der realistischen Videosimulation.

Zitat:

Anything in Any Scene: Photorealistic Video Object Insertion[J].

Das obige ist der detaillierte Inhalt vonAlles in jeder Szene: Realistische Objekteinfügung (zur Unterstützung der Synthese verschiedener Fahrdaten). Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

So nehmen Sie Bildschirmvideos mit einem OPPO-Telefon auf (einfache Bedienung)

May 07, 2024 pm 06:22 PM

So nehmen Sie Bildschirmvideos mit einem OPPO-Telefon auf (einfache Bedienung)

May 07, 2024 pm 06:22 PM

Spielfähigkeiten oder Lehrdemonstrationen: Im täglichen Leben müssen wir häufig Mobiltelefone verwenden, um Bildschirmvideos aufzunehmen, um einige Bedienschritte zu zeigen. Die Funktion zum Aufzeichnen von Bildschirmvideos ist ebenfalls sehr gut und das OPPO-Mobiltelefon ist ein leistungsstarkes Smartphone. Damit Sie die Aufnahmeaufgabe einfach und schnell erledigen können, wird in diesem Artikel detailliert beschrieben, wie Sie OPPO-Mobiltelefone zum Aufzeichnen von Bildschirmvideos verwenden. Vorbereitung – Aufnahmeziele festlegen Bevor Sie beginnen, müssen Sie Ihre Aufnahmeziele klären. Möchten Sie ein Schritt-für-Schritt-Demonstrationsvideo aufnehmen? Oder möchten Sie einen wundervollen Moment eines Spiels festhalten? Oder möchten Sie ein Lehrvideo aufnehmen? Nur durch eine bessere Organisation des Aufnahmeprozesses und klare Ziele. Öffnen Sie die Bildschirmaufzeichnungsfunktion des OPPO-Mobiltelefons und finden Sie sie im Verknüpfungsfeld. Die Bildschirmaufzeichnungsfunktion befindet sich im Verknüpfungsfeld.

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

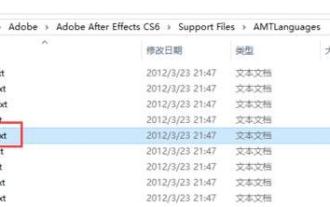

So wechseln Sie die Sprache in Adobe After Effects cs6 (Ae cs6) Detaillierte Schritte zum Wechseln zwischen Chinesisch und Englisch in Ae cs6 – ZOL-Download

May 09, 2024 pm 02:00 PM

So wechseln Sie die Sprache in Adobe After Effects cs6 (Ae cs6) Detaillierte Schritte zum Wechseln zwischen Chinesisch und Englisch in Ae cs6 – ZOL-Download

May 09, 2024 pm 02:00 PM

1. Suchen Sie zuerst den Ordner AMTLangagues. Wir haben einige Dokumentationen im AMTLangagues-Ordner gefunden. Wenn Sie vereinfachtes Chinesisch installieren, gibt es ein Textdokument zh_CN.txt (der Textinhalt ist: zh_CN). Wenn Sie es auf Englisch installiert haben, gibt es ein Textdokument en_US.txt (der Textinhalt ist: en_US). 3. Wenn wir also auf Chinesisch umsteigen möchten, müssen wir ein neues Textdokument von zh_CN.txt (der Textinhalt ist: zh_CN) unter dem Pfad AdobeAfterEffectsCCSupportFilesAMTLanguages erstellen. 4. Im Gegenteil, wenn wir auf Englisch umsteigen wollen,

Wie drehe ich Videos auf TikTok? Wie schalte ich das Mikrofon für Videoaufnahmen ein?

May 09, 2024 pm 02:40 PM

Wie drehe ich Videos auf TikTok? Wie schalte ich das Mikrofon für Videoaufnahmen ein?

May 09, 2024 pm 02:40 PM

Als eine der beliebtesten Kurzvideoplattformen von heute wirken sich Qualität und Wirkung der Videos von Douyin direkt auf das Seherlebnis des Benutzers aus. Wie dreht man also hochwertige Videos auf TikTok? 1. Wie drehe ich Videos auf Douyin? 1. Öffnen Sie die Douyin-App und klicken Sie unten in der Mitte auf die Schaltfläche „+“, um die Videoaufnahmeseite aufzurufen. 2. Douyin bietet eine Vielzahl von Aufnahmemodi, darunter normale Aufnahme, Zeitlupe, Kurzvideo usw. Wählen Sie den passenden Aufnahmemodus entsprechend Ihren Anforderungen. 3. Klicken Sie auf der Aufnahmeseite unten auf dem Bildschirm auf die Schaltfläche „Filter“, um verschiedene Filtereffekte auszuwählen und das Video individueller zu gestalten. 4. Wenn Sie Parameter wie Belichtung und Kontrast anpassen müssen, können Sie zum Einstellen auf die Schaltfläche „Parameter“ in der unteren linken Ecke des Bildschirms klicken. 5. Während der Aufnahme können Sie auf die linke Seite des Bildschirms klicken

Übertrifft DPO umfassend: Das Team von Chen Danqi schlug eine einfache Präferenzoptimierung (SimPO) vor und verfeinerte außerdem das stärkste 8B-Open-Source-Modell

Jun 01, 2024 pm 04:41 PM

Übertrifft DPO umfassend: Das Team von Chen Danqi schlug eine einfache Präferenzoptimierung (SimPO) vor und verfeinerte außerdem das stärkste 8B-Open-Source-Modell

Jun 01, 2024 pm 04:41 PM

Um große Sprachmodelle (LLMs) an menschlichen Werten und Absichten auszurichten, ist es wichtig, menschliches Feedback zu lernen, um sicherzustellen, dass sie nützlich, ehrlich und harmlos sind. Im Hinblick auf die Ausrichtung von LLM ist Reinforcement Learning basierend auf menschlichem Feedback (RLHF) eine wirksame Methode. Obwohl die Ergebnisse der RLHF-Methode ausgezeichnet sind, gibt es einige Herausforderungen bei der Optimierung. Dazu gehört das Training eines Belohnungsmodells und die anschließende Optimierung eines Richtlinienmodells, um diese Belohnung zu maximieren. Kürzlich haben einige Forscher einfachere Offline-Algorithmen untersucht, darunter die direkte Präferenzoptimierung (Direct Preference Optimization, DPO). DPO lernt das Richtlinienmodell direkt auf der Grundlage von Präferenzdaten, indem es die Belohnungsfunktion in RLHF parametrisiert, wodurch die Notwendigkeit eines expliziten Belohnungsmodells entfällt. Diese Methode ist einfach und stabil

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

An der Spitze der Softwaretechnologie kündigte die Gruppe von UIUC Zhang Lingming zusammen mit Forschern der BigCode-Organisation kürzlich das StarCoder2-15B-Instruct-Großcodemodell an. Diese innovative Errungenschaft erzielte einen bedeutenden Durchbruch bei Codegenerierungsaufgaben, übertraf erfolgreich CodeLlama-70B-Instruct und erreichte die Spitze der Codegenerierungsleistungsliste. Die Einzigartigkeit von StarCoder2-15B-Instruct liegt in seiner reinen Selbstausrichtungsstrategie. Der gesamte Trainingsprozess ist offen, transparent und völlig autonom und kontrollierbar. Das Modell generiert über StarCoder2-15B Tausende von Anweisungen als Reaktion auf die Feinabstimmung des StarCoder-15B-Basismodells, ohne auf teure manuelle Annotationen angewiesen zu sein.

LLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version)

May 09, 2024 pm 04:55 PM

LLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version)

May 09, 2024 pm 04:55 PM

Oben geschrieben und persönliches Verständnis des Autors: Dieses Papier widmet sich der Lösung der wichtigsten Herausforderungen aktueller multimodaler großer Sprachmodelle (MLLMs) in autonomen Fahranwendungen, nämlich dem Problem der Erweiterung von MLLMs vom 2D-Verständnis auf den 3D-Raum. Diese Erweiterung ist besonders wichtig, da autonome Fahrzeuge (AVs) genaue Entscheidungen über 3D-Umgebungen treffen müssen. Das räumliche 3D-Verständnis ist für AVs von entscheidender Bedeutung, da es sich direkt auf die Fähigkeit des Fahrzeugs auswirkt, fundierte Entscheidungen zu treffen, zukünftige Zustände vorherzusagen und sicher mit der Umgebung zu interagieren. Aktuelle multimodale große Sprachmodelle (wie LLaVA-1.5) können häufig nur Bildeingaben mit niedrigerer Auflösung verarbeiten (z. B. aufgrund von Auflösungsbeschränkungen des visuellen Encoders und Einschränkungen der LLM-Sequenzlänge). Allerdings erfordern autonome Fahranwendungen