Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Der Eckpfeiler von AI4Science: Geometrisches graphisches neuronales Netzwerk, die umfassendste Rezension ist hier! Die Renmin University of China Hillhouse hat gemeinsam das Tencent AI Lab, die Tsinghua University, Stanford usw. eröffnet.

Der Eckpfeiler von AI4Science: Geometrisches graphisches neuronales Netzwerk, die umfassendste Rezension ist hier! Die Renmin University of China Hillhouse hat gemeinsam das Tencent AI Lab, die Tsinghua University, Stanford usw. eröffnet.

Der Eckpfeiler von AI4Science: Geometrisches graphisches neuronales Netzwerk, die umfassendste Rezension ist hier! Die Renmin University of China Hillhouse hat gemeinsam das Tencent AI Lab, die Tsinghua University, Stanford usw. eröffnet.

Herausgeber |. XS

Nature veröffentlichte im November 2023 zwei wichtige Forschungsergebnisse: die Proteinsynthesetechnologie Chroma und die Kristallmaterialdesignmethode GNoME. In beiden Studien wurden graphische neuronale Netze als Werkzeug zur Verarbeitung wissenschaftlicher Daten eingesetzt.

Tatsächlich waren graphische neuronale Netze, insbesondere geometrische graphische neuronale Netze, schon immer ein wichtiges Werkzeug für die wissenschaftliche Intelligenzforschung (KI für die Wissenschaft). Dies liegt daran, dass physikalische Systeme wie Partikel, Moleküle, Proteine und Kristalle im wissenschaftlichen Bereich in einer speziellen Datenstruktur – geometrischen Graphen – modelliert werden können.

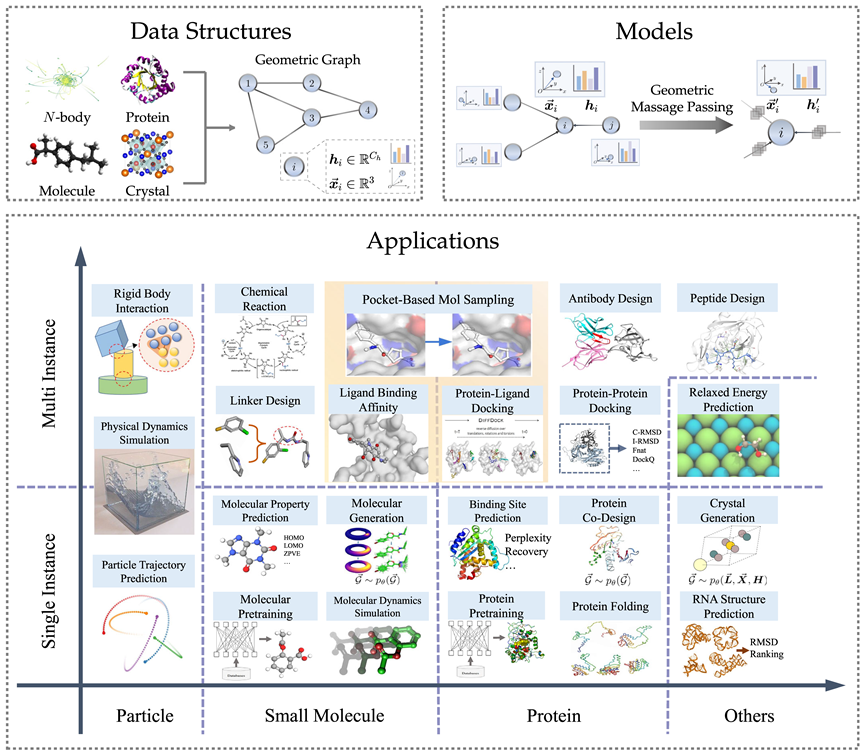

Im Gegensatz zu allgemeinen topologischen Diagrammen fügen geometrische Diagramme zur besseren Beschreibung des physikalischen Systems unverzichtbare räumliche Informationen hinzu und müssen die physikalische Symmetrie von Translation, Rotation und Spiegelung erfüllen. Angesichts der Überlegenheit geometrischer graphischer neuronaler Netze zur Modellierung physikalischer Systeme sind in den letzten Jahren verschiedene Methoden entstanden, und die Zahl der Veröffentlichungen nimmt weiter zu.

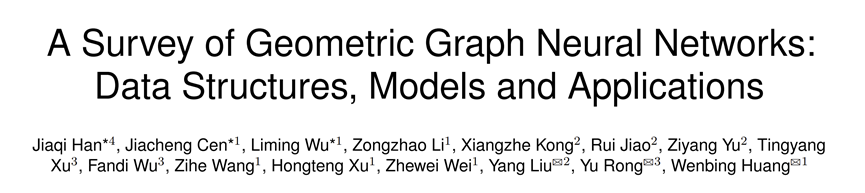

Kürzlich hat sich die Renmin University of China Hillhouse mit dem Tencent AI Lab, der Tsinghua University, Stanford und anderen Institutionen zusammengetan, um ein Übersichtspapier zu veröffentlichen: „A Survey of Geometric Graph Neural Networks: Data Structures, Models and Applications“. Basierend auf einer kurzen Einführung in theoretisches Wissen wie Gruppentheorie und Symmetrie überprüft dieser Aufsatz systematisch die relevante Literatur zu geometrischen graphischen neuronalen Netzwerken von Datenstrukturen und Modellen bis hin zu zahlreichen wissenschaftlichen Anwendungen.

Papier-Link:https://arxiv.org/abs/2403.00485

GitHub-Link:https://github.com/RUC-GLAD/GGNN4Science

In dieser Rezension schreibt der Autor Nachher Durch die Recherche von mehr als 300 Referenzen haben wir drei verschiedene Modelle geometrischer neuronaler Graphen zusammengefasst, verwandte Methoden für insgesamt 23 verschiedene Aufgaben zu verschiedenen wissenschaftlichen Daten wie Partikeln, Molekülen und Proteinen eingeführt und mehr als 50 verwandte Datensätze gesammelt. Abschließend blickt die Rezension auf zukünftige Forschungsrichtungen, einschließlich grundlegender geometrischer Graphenmodelle, Kombination mit großen Sprachmodellen usw.

Im Folgenden finden Sie eine kurze Einführung zu jedem Kapitel.

Datenstruktur des geometrischen Diagramms

Das geometrische Diagramm besteht aus einer Adjazenzmatrix, Knoteneigenschaften und geometrischen Knoteninformationen (z. B. Koordinaten). Im euklidischen Raum weisen geometrische Figuren normalerweise physikalische Symmetrien der Translation, Rotation und Spiegelung auf. Zur Beschreibung dieser Transformationen werden im Allgemeinen Gruppen verwendet, einschließlich euklidischer Gruppen, Translationsgruppen, orthogonaler Gruppen, Permutationsgruppen usw. Intuitiv kann es als eine Kombination aus vier Vorgängen verstanden werden: Verschiebung, Translation, Rotation und Spiegeln in einer bestimmten Reihenfolge.

Für viele Bereiche der KI für die Wissenschaft sind geometrische Diagramme eine leistungsstarke und vielseitige Darstellungsmethode, mit der viele physikalische Systeme dargestellt werden können, darunter kleine Moleküle, Proteine, Kristalle, physikalische Punktwolken usw.

Neuronales Netzwerkmodell mit geometrischem Graphen

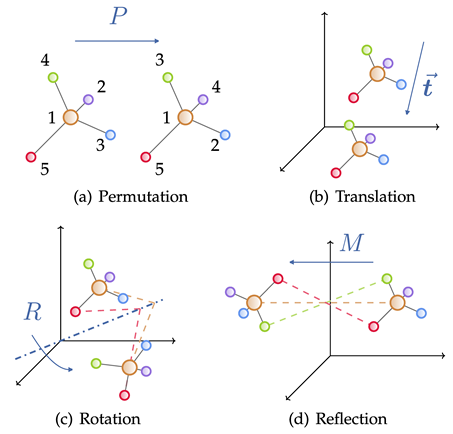

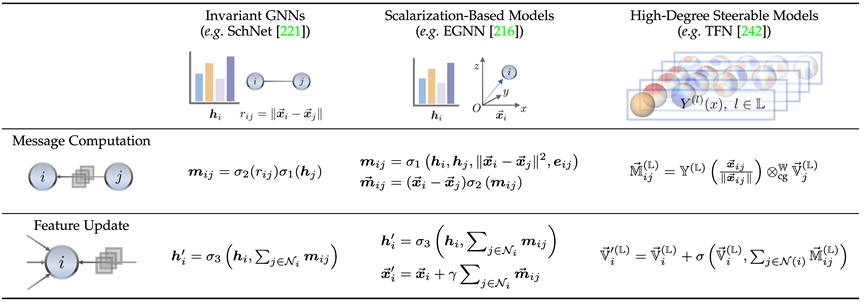

Entsprechend den Symmetrieanforderungen der Lösungsziele bei tatsächlichen Problemen unterteilt dieser Artikel neuronale Netzwerke mit geometrischem Graphen in drei Kategorien: invariantes Modell und äquivariantes Modellmodell sowie den geometrischen Graphtransformator Inspiriert durch die Transformer-Architektur ist das äquivariante Modell in ein auf Skalarisierung basierendes Modell und ein hochgradig steuerbares Modell auf Basis sphärischer Harmonisierung unterteilt. Gemäß den oben genannten Regeln sammelt und kategorisiert der Artikel in den letzten Jahren bekannte geometrische Diagramm-Neuronale-Netzwerk-Modelle.

Hier stellen wir anhand der repräsentativen Arbeit kurz die Beziehung zwischen dem invarianten Modell (SchNet[1]), dem Skalarisierungsmethodenmodell (EGNN[2]) und dem steuerbaren Modell höherer Ordnung (TFN[3]) vor von jedem Zweig und Unterschied. Es lässt sich feststellen, dass alle drei Mechanismen zur Nachrichtenübermittlung verwenden, die beiden letztgenannten, bei denen es sich um äquivariante Modelle handelt, jedoch eine zusätzliche geometrische Nachrichtenübermittlung einführen.

Das invariante Modell verwendet hauptsächlich die Eigenschaften des Knotens selbst (wie Atomtyp, Masse, Ladung usw.) und die invarianten Eigenschaften zwischen Atomen (wie Abstand, Winkel [4], Diederwinkel [5]) usw . um Nachrichten zu berechnen.

Darüber hinaus führt die Skalarisierungsmethode zusätzlich geometrische Informationen durch die Koordinatendifferenz zwischen Knoten ein und kombiniert die invarianten Informationen linear als Gewicht der geometrischen Informationen, um die Einführung von Äquivarianz zu erreichen.

Kontrollierbare Modelle höherer Ordnung verwenden sphärische Harmonische und Wigner-D-Matrizen, um die geometrischen Informationen des Systems darzustellen. Diese Methode steuert die Reihenfolge der irreduziblen Darstellung durch den Clebsch-Gordan-Koeffizienten und realisiert so die geometrische Nachrichtenweitergabe Verfahren.

Die Genauigkeit des neuronalen Netzwerks mit geometrischen Graphen wird durch die durch diese Art von Design gewährleistete Symmetrie erheblich verbessert und glänzt auch bei der Generierungsaufgabe.

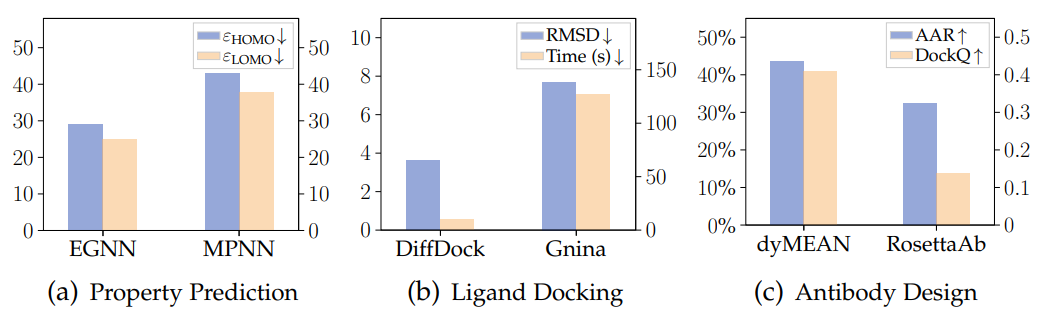

Die folgende Abbildung zeigt die Ergebnisse der drei Aufgaben der Vorhersage molekularer Eigenschaften, des Protein-Ligand-Dockings und des Antikörperdesigns (Generierung) unter Verwendung des geometrischen graphischen neuronalen Netzwerks und des traditionellen Modells für die drei Datensätze QM9, PDBBind und SabDab It Es ist deutlich zu erkennen, dass geometrische graphische neuronale Netze Vorteile bieten.

Wissenschaftliche Anwendungen

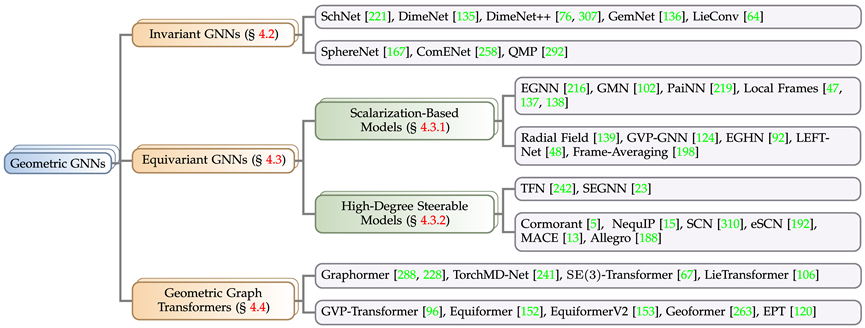

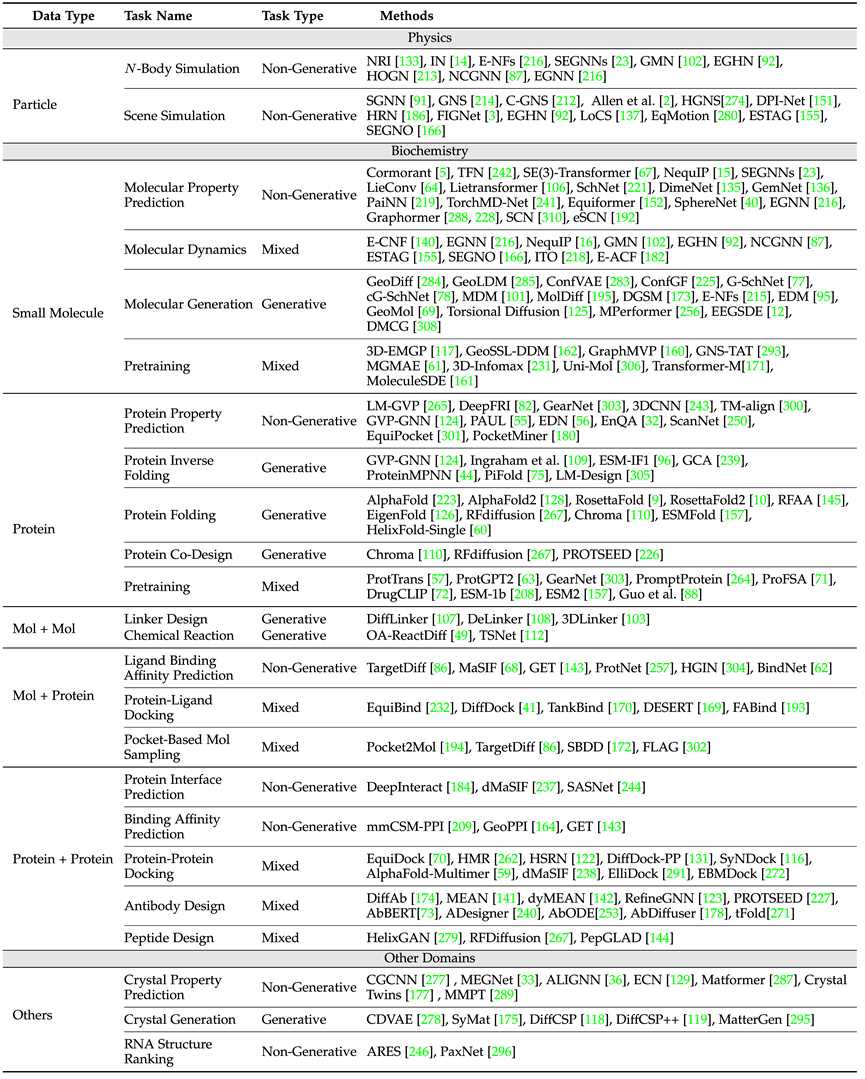

In Bezug auf wissenschaftliche Anwendungen deckt die Übersicht Physik (Teilchen), Biochemie (kleine Moleküle, Proteine) und andere Anwendungsszenarien wie Kristalle, Aufgabendefinitionen und erforderliche Symmetriegarantien ab den Kategorien ab Es werden die in jeder Aufgabe häufig verwendeten Datensätze und die klassischen Modelldesignideen für diese Art von Aufgaben vorgestellt.

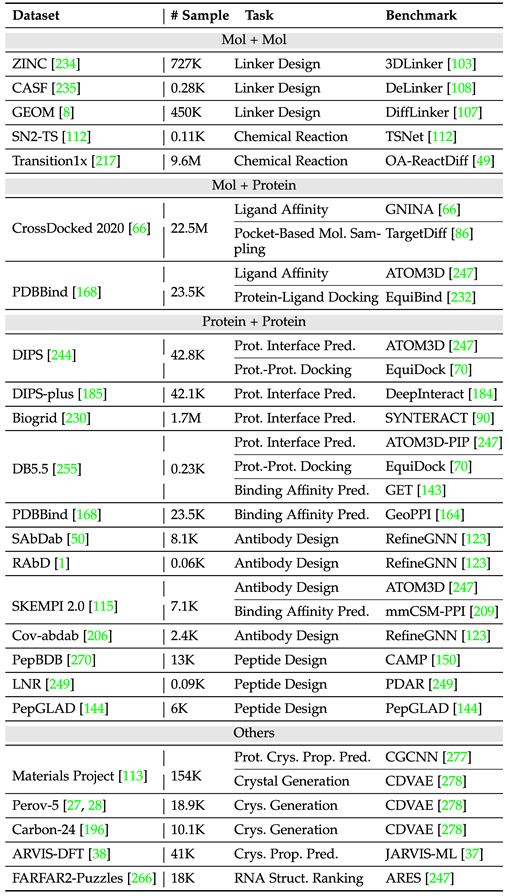

Die obige Tabelle zeigt gängige Aufgaben und klassische Modelle in verschiedenen Bereichen. Darunter unterscheidet der Artikel nach einzelnen Instanzen und mehreren Instanzen (z. B. chemischen Reaktionen, an denen mehrere Moleküle beteiligt sein müssen). kleine Moleküle, kleine Moleküle – Protein, Protein – drei Bereiche des Proteins.

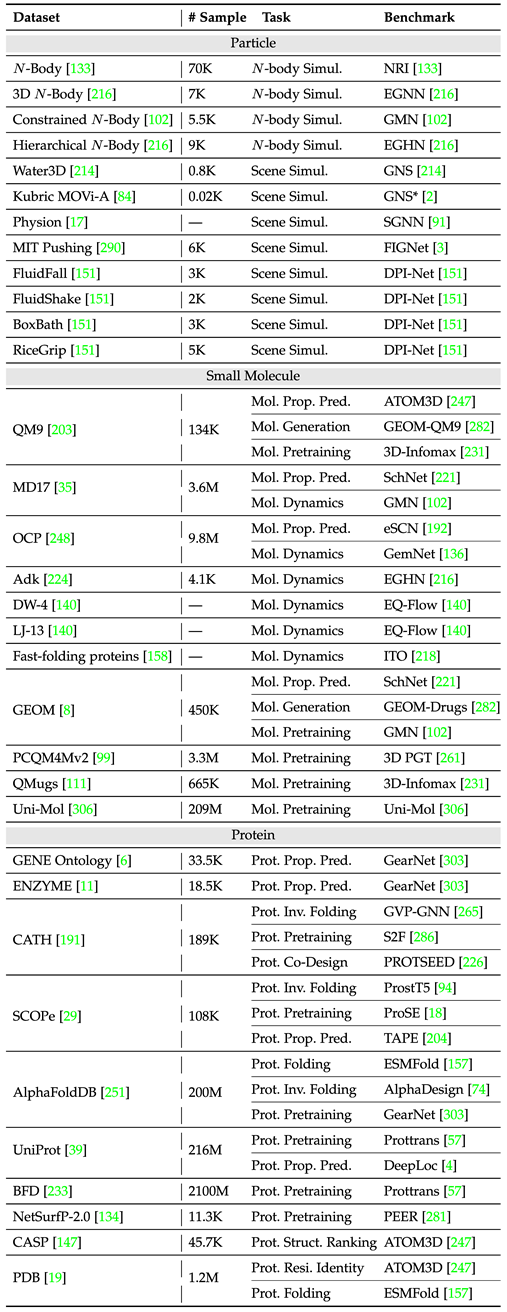

Um das Modelldesign und die Experimententwicklung vor Ort besser zu erleichtern, zählt der Artikel gängige Datensätze und Benchmarks für zwei Arten von Aufgaben basierend auf Einzelinstanzen und mehreren Instanzen und zeichnet die Stichprobengrößen und Aufgabentypen verschiedener Datensätze auf. .

Die folgende Tabelle fasst gängige Einzelinstanz-Aufgabendatensätze zusammen.

Die folgende Tabelle organisiert gängige Multi-Instanz-Aufgabendatensätze.

Zukunftsausblick

Der Artikel gibt einen vorläufigen Ausblick auf mehrere Aspekte und hofft, als Ausgangspunkt zu dienen:

1. Das grundlegende geometrische Graphenmodell

ist in verschiedenen Aufgaben und Bereichen vereinheitlicht Die Überlegenheit des Basismodells spiegelt sich voll und ganz in den erheblichen Fortschritten der Modelle der GPT-Serie wider. Wie ein vernünftiger Entwurf im Aufgabenraum, Datenraum und Modellraum durchgeführt werden kann, um diese Idee in den Entwurf eines neuronalen Netzes mit geometrischem Graphen einzuführen, ist immer noch ein interessantes offenes Problem.

2. Effizienter Zyklus aus Modelltraining und experimenteller Verifizierung in der Praxis

Die Erfassung wissenschaftlicher Daten ist teuer und zeitaufwändig, und Modelle, die nur anhand unabhängiger Datensätze bewertet werden, können das Feedback aus der realen Welt nicht direkt widerspiegeln. Die Bedeutung der Erzielung effizienter iterativer experimenteller Paradigmen in der Modellrealität ähnlich wie bei GNoME (das eine End-to-End-Pipeline einschließlich Graphennetzwerktraining, Berechnungen der Dichtefunktionaltheorie und automatisierten Labors für die Materialentdeckung und -synthese integriert) wird von Tag zu Tag zunehmen Tag.

3. Integration mit großen Sprachmodellen (LLMs)

Große Sprachmodelle (LLMs) verfügen nachweislich über umfangreiches Wissen, das verschiedene Bereiche abdeckt. Obwohl es einige Arbeiten gibt, die LLMs für bestimmte Aufgaben wie die Vorhersage molekularer Eigenschaften und das Arzneimitteldesign nutzen, arbeiten sie nur mit Grundelementen oder molekularen Graphen. Es ist immer noch eine große Herausforderung, sie organisch mit geometrischen graphischen neuronalen Netzen zu kombinieren, damit sie 3D-Strukturinformationen verarbeiten und Vorhersagen oder Generierungen für 3D-Strukturen durchführen können.

4. Lockerung der Äquivarianzbeschränkungen

Es besteht kein Zweifel, dass die Äquivarianz entscheidend ist, um die Dateneffizienz und die Fähigkeit zur Modellverallgemeinerung zu verbessern, aber es ist erwähnenswert, dass zu starke Äquivarianzbeschränkungen das Modell manchmal zu sehr einschränken können Leistung. Daher ist es eine sehr interessante Frage, wie Äquivarianz und Anpassungsfähigkeit des entworfenen Modells in Einklang gebracht werden können. Die Erforschung dieses Bereichs kann nicht nur unser Verständnis des Modellverhaltens bereichern, sondern auch den Weg für die Entwicklung robusterer und allgemeinerer Lösungen mit breiterer Anwendbarkeit ebnen.

Referenzen

[1] Schütt K, Kindermans P J, Sauceda Felix H E, et al. Schnet: A Continuous-Filter Convolutional Neural Network for Modeling Quantum Interactions, 2017, 30 .

[2] Satorras V G, Hoogeboom E, Welling M. E (n) äquivariante graphische neuronale Netze[C]//Internationale Konferenz über maschinelles Lernen. PMLR, 2021: 9323-9332.

[3] Thomas N, Smidt T, Kearnes S, et al. Tensorfeldnetzwerke: Rotations- und translatorisch äquivariante neuronale Netzwerke für 3D-Punktwolken[J]. arXiv preprint arXiv:1802.08219, 2018.

[4] Gasteiger J, Groß J, Günnemann S. Directional Message Passing for Molecular Graphs[C]//International Conference on Learning Representations. 2019.

[5] Gasteiger J, Becker F, Günnemann S. Gemnet: Universal Directional Graph Neural Networks for Molecules[J]. Advances in Neural Information Processing Systems, 2021, 34: 6790-6802.

[6] Merchant A, Batzner S, Schoenholz S S, et al. Skalierung von Deep Learning für die Materialentdeckung[J]. Natur, 2023, 624(7990): 80-85.

Das obige ist der detaillierte Inhalt vonDer Eckpfeiler von AI4Science: Geometrisches graphisches neuronales Netzwerk, die umfassendste Rezension ist hier! Die Renmin University of China Hillhouse hat gemeinsam das Tencent AI Lab, die Tsinghua University, Stanford usw. eröffnet.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

„Defect Spectrum' durchbricht die Grenzen der herkömmlichen Fehlererkennung und erreicht erstmals eine hochpräzise und umfassende semantische Fehlererkennung in der Industrie.

Jul 26, 2024 pm 05:38 PM

„Defect Spectrum' durchbricht die Grenzen der herkömmlichen Fehlererkennung und erreicht erstmals eine hochpräzise und umfassende semantische Fehlererkennung in der Industrie.

Jul 26, 2024 pm 05:38 PM

In der modernen Fertigung ist die genaue Fehlererkennung nicht nur der Schlüssel zur Sicherstellung der Produktqualität, sondern auch der Kern für die Verbesserung der Produktionseffizienz. Allerdings mangelt es vorhandenen Datensätzen zur Fehlererkennung häufig an der Genauigkeit und dem semantischen Reichtum, die für praktische Anwendungen erforderlich sind, was dazu führt, dass Modelle bestimmte Fehlerkategorien oder -orte nicht identifizieren können. Um dieses Problem zu lösen, hat ein Spitzenforschungsteam bestehend aus der Hong Kong University of Science and Technology Guangzhou und Simou Technology innovativ den „DefectSpectrum“-Datensatz entwickelt, der eine detaillierte und semantisch reichhaltige groß angelegte Annotation von Industriedefekten ermöglicht. Wie in Tabelle 1 gezeigt, bietet der Datensatz „DefectSpectrum“ im Vergleich zu anderen Industriedatensätzen die meisten Fehleranmerkungen (5438 Fehlerproben) und die detaillierteste Fehlerklassifizierung (125 Fehlerkategorien).

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Die offene LLM-Community ist eine Ära, in der hundert Blumen blühen und konkurrieren. Sie können Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 und viele andere sehen hervorragende Darsteller. Allerdings weisen offene Modelle im Vergleich zu den proprietären Großmodellen GPT-4-Turbo in vielen Bereichen noch erhebliche Lücken auf. Zusätzlich zu allgemeinen Modellen wurden einige offene Modelle entwickelt, die sich auf Schlüsselbereiche spezialisieren, wie etwa DeepSeek-Coder-V2 für Programmierung und Mathematik und InternVL für visuelle Sprachaufgaben.

Google AI gewann die Silbermedaille der IMO Mathematical Olympiad, das mathematische Argumentationsmodell AlphaProof wurde eingeführt und Reinforcement Learning ist zurück

Jul 26, 2024 pm 02:40 PM

Google AI gewann die Silbermedaille der IMO Mathematical Olympiad, das mathematische Argumentationsmodell AlphaProof wurde eingeführt und Reinforcement Learning ist zurück

Jul 26, 2024 pm 02:40 PM

Für KI ist die Mathematikolympiade kein Problem mehr. Am Donnerstag hat die künstliche Intelligenz von Google DeepMind eine Meisterleistung vollbracht: Sie nutzte KI, um meiner Meinung nach die eigentliche Frage der diesjährigen Internationalen Mathematikolympiade zu lösen, und war nur einen Schritt davon entfernt, die Goldmedaille zu gewinnen. Der IMO-Wettbewerb, der gerade letzte Woche zu Ende ging, hatte sechs Fragen zu Algebra, Kombinatorik, Geometrie und Zahlentheorie. Das von Google vorgeschlagene hybride KI-System beantwortete vier Fragen richtig und erzielte 28 Punkte und erreichte damit die Silbermedaillenstufe. Anfang dieses Monats hatte der UCLA-Professor Terence Tao gerade die KI-Mathematische Olympiade (AIMO Progress Award) mit einem Millionenpreis gefördert. Unerwarteterweise hatte sich das Niveau der KI-Problemlösung vor Juli auf dieses Niveau verbessert. Beantworten Sie die Fragen meiner Meinung nach gleichzeitig. Am schwierigsten ist es meiner Meinung nach, da sie die längste Geschichte, den größten Umfang und die negativsten Fragen haben

Training mit Millionen von Kristalldaten zur Lösung kristallographischer Phasenprobleme, die Deep-Learning-Methode PhAI wird in Science veröffentlicht

Aug 08, 2024 pm 09:22 PM

Training mit Millionen von Kristalldaten zur Lösung kristallographischer Phasenprobleme, die Deep-Learning-Methode PhAI wird in Science veröffentlicht

Aug 08, 2024 pm 09:22 PM

Herausgeber |KX Bis heute sind die durch die Kristallographie ermittelten Strukturdetails und Präzision, von einfachen Metallen bis hin zu großen Membranproteinen, mit keiner anderen Methode zu erreichen. Die größte Herausforderung, das sogenannte Phasenproblem, bleibt jedoch die Gewinnung von Phaseninformationen aus experimentell bestimmten Amplituden. Forscher der Universität Kopenhagen in Dänemark haben eine Deep-Learning-Methode namens PhAI entwickelt, um Kristallphasenprobleme zu lösen. Ein Deep-Learning-Neuronales Netzwerk, das mithilfe von Millionen künstlicher Kristallstrukturen und den entsprechenden synthetischen Beugungsdaten trainiert wird, kann genaue Elektronendichtekarten erstellen. Die Studie zeigt, dass diese Deep-Learning-basierte Ab-initio-Strukturlösungsmethode das Phasenproblem mit einer Auflösung von nur 2 Angström lösen kann, was nur 10 bis 20 % der bei atomarer Auflösung verfügbaren Daten im Vergleich zur herkömmlichen Ab-initio-Berechnung entspricht

Der Standpunkt der Natur: Die Erprobung künstlicher Intelligenz in der Medizin ist im Chaos. Was ist zu tun?

Aug 22, 2024 pm 04:37 PM

Der Standpunkt der Natur: Die Erprobung künstlicher Intelligenz in der Medizin ist im Chaos. Was ist zu tun?

Aug 22, 2024 pm 04:37 PM

Herausgeber | ScienceAI Basierend auf begrenzten klinischen Daten wurden Hunderte medizinischer Algorithmen genehmigt. Wissenschaftler diskutieren darüber, wer die Werkzeuge testen soll und wie dies am besten geschieht. Devin Singh wurde Zeuge, wie ein pädiatrischer Patient in der Notaufnahme einen Herzstillstand erlitt, während er lange auf eine Behandlung wartete, was ihn dazu veranlasste, den Einsatz von KI zu erforschen, um Wartezeiten zu verkürzen. Mithilfe von Triage-Daten aus den Notaufnahmen von SickKids erstellten Singh und Kollegen eine Reihe von KI-Modellen, um mögliche Diagnosen zu stellen und Tests zu empfehlen. Eine Studie zeigte, dass diese Modelle die Zahl der Arztbesuche um 22,3 % verkürzen können und die Verarbeitung der Ergebnisse pro Patient, der einen medizinischen Test benötigt, um fast drei Stunden beschleunigt. Der Erfolg von Algorithmen der künstlichen Intelligenz in der Forschung bestätigt dies jedoch nur

Drei Geheimnisse für die Bereitstellung großer Modelle in der Cloud

Apr 24, 2024 pm 03:00 PM

Drei Geheimnisse für die Bereitstellung großer Modelle in der Cloud

Apr 24, 2024 pm 03:00 PM

Zusammenstellung|Produziert von Ich fange an, serverloses Cloud Computing zu vermissen. Ihre Anwendungen reichen von der Verbesserung der Konversations-KI bis hin zur Bereitstellung komplexer Analyselösungen für verschiedene Branchen und vielen anderen Funktionen. Viele Unternehmen setzen diese Modelle auf Cloud-Plattformen ein, da öffentliche Cloud-Anbieter bereits ein fertiges Ökosystem bereitstellen und dies der Weg des geringsten Widerstands ist. Allerdings ist es nicht billig. Die Cloud bietet darüber hinaus weitere Vorteile wie Skalierbarkeit, Effizienz und erweiterte Rechenfunktionen (GPUs auf Anfrage verfügbar). Es gibt einige wenig bekannte Aspekte der Bereitstellung von LLM auf öffentlichen Cloud-Plattformen

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

PRO |. Warum verdienen große Modelle, die auf MoE basieren, mehr Aufmerksamkeit?

Aug 07, 2024 pm 07:08 PM

PRO |. Warum verdienen große Modelle, die auf MoE basieren, mehr Aufmerksamkeit?

Aug 07, 2024 pm 07:08 PM

Im Jahr 2023 entwickeln sich fast alle Bereiche der KI in beispielloser Geschwindigkeit weiter. Gleichzeitig verschiebt die KI ständig die technologischen Grenzen wichtiger Bereiche wie der verkörperten Intelligenz und des autonomen Fahrens. Wird der Status von Transformer als Mainstream-Architektur großer KI-Modelle durch den multimodalen Trend erschüttert? Warum ist die Erforschung großer Modelle auf Basis der MoE-Architektur (Mixture of Experts) zu einem neuen Trend in der Branche geworden? Können Large Vision Models (LVM) ein neuer Durchbruch im allgemeinen Sehvermögen sein? ...Aus dem PRO-Mitglieder-Newsletter 2023 dieser Website, der in den letzten sechs Monaten veröffentlicht wurde, haben wir 10 spezielle Interpretationen ausgewählt, die eine detaillierte Analyse der technologischen Trends und industriellen Veränderungen in den oben genannten Bereichen bieten, um Ihnen dabei zu helfen, Ihre Ziele in der Zukunft zu erreichen Jahr vorbereitet sein. Diese Interpretation stammt aus Week50 2023