Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

MIT Genesis-Kernfusion bricht Weltrekord! Hochtemperatur-supraleitende Magnete setzen Sternenergie frei. Steht die Geburt einer künstlichen Sonne bevor?

MIT Genesis-Kernfusion bricht Weltrekord! Hochtemperatur-supraleitende Magnete setzen Sternenergie frei. Steht die Geburt einer künstlichen Sonne bevor?

MIT Genesis-Kernfusion bricht Weltrekord! Hochtemperatur-supraleitende Magnete setzen Sternenergie frei. Steht die Geburt einer künstlichen Sonne bevor?

Der Heilige Gral der sauberen Energie wurde erobert?

„Über Nacht reduzierte das MIT-Team die Kosten pro Watt des Fusionsreaktors auf fast 1/40 und machte so die kommerzielle Nutzung der Kernfusionstechnologie möglich“!

Kürzlich haben das MIT Center for Plasma Science and Fusion und das Commonwealth Fusion Systems (CFS) einen umfassenden Bericht veröffentlicht.

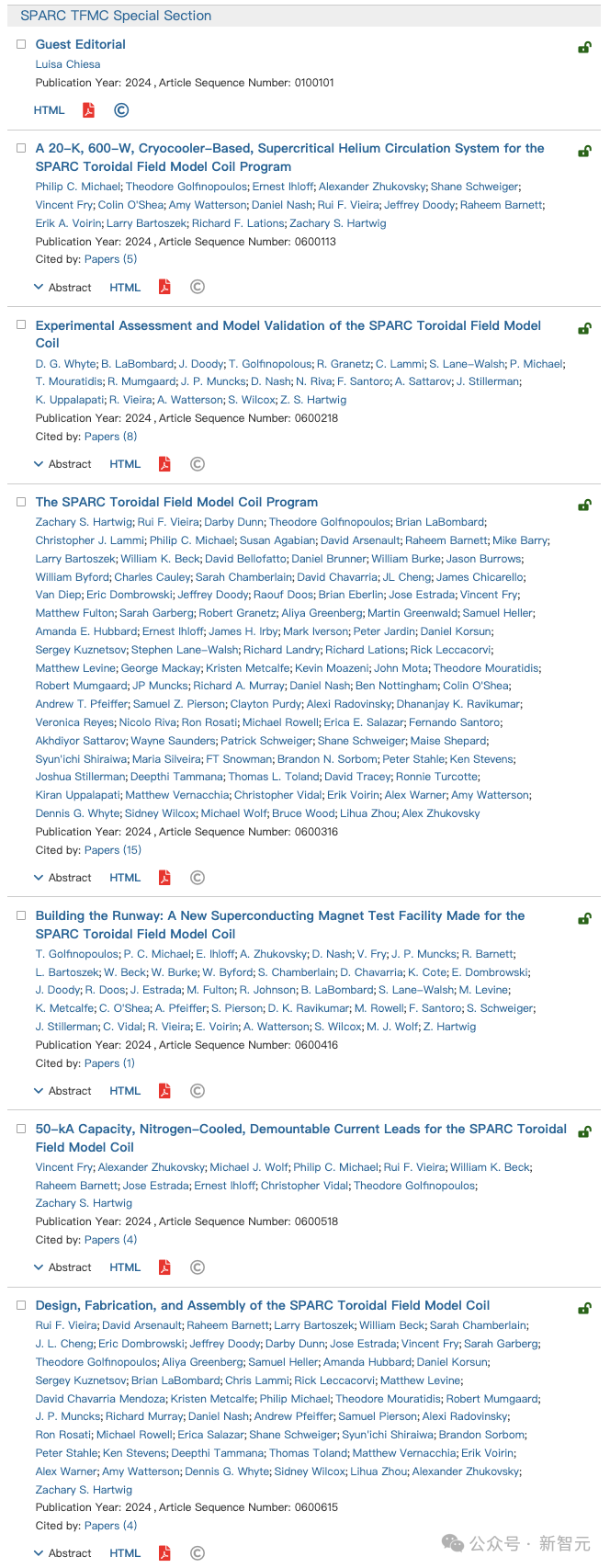

Dieser Bericht zitiert 6 unabhängige Forschungsarbeiten in der März-Sonderausgabe von „IEEE Transactions on Applied Supraconductivity“ und beweist, dass:

MIT im Experiment 2021 „Hochtemperatur-supraleitende Magnete“ verwendet hat und die Nicht- Das isolierte Design ist absolut machbar und zuverlässig.

Es wurde außerdem bestätigt, dass der einzigartige supraleitende Magnet, den das Team im Experiment verwendet hat, als Grundlage für ein Kernfusionskraftwerk ausreicht.

Dies deutet darauf hin, dass die „Kernfusion“ bald zu einer kommerzialisierten Technologie aus einem wissenschaftlichen Forschungsprojekt in einem Labor werden wird.

Papieradresse:

https://ieeexplore.ieee.org/xpl/tocresult.jsp?isnumber=10348035&punumber=77

Und das alles wird 2021 am MIT beginnen. Es fängt an mit dem Kernfusionsexperiment, das einen Weltrekord aufstellte.

„Supraleitender Magnet“ stellt Weltrekord für Magnetfeldstärke auf

Am frühen Morgen des 5. September 2021 erreichten Ingenieure im Labor des MIT Plasma Science and Fusion Center (PSFC) einen wichtigen Meilenstein ——

Ein neuartiger Magnet aus „Hochtemperatur-Supraleitermaterial“ hat einen Weltrekord für großflächige Magnetfeldstärken von 20 Tesla erreicht.

Wissen Sie, 20 Tesla ist genau die Magnetfeldstärke, die zum Bau eines Kernfusionskraftwerks benötigt wird.

Wissenschaftler gehen davon aus, dass dadurch Nettostrom erzeugt und möglicherweise eine Ära nahezu unbegrenzter Stromerzeugung eingeläutet wird.

Das Experiment erwies sich als erfolgreich und erfüllte alle Kriterien für den Entwurf eines neuen Fusionsgeräts namens SPARC, für das Magnete eine Schlüsseltechnologie darstellen.

Die erschöpften Ingenieure öffneten den Champagner, um ihre stolzen Erfolge zu feiern. Dafür haben sie lange und mühsame Anstrengungen unternommen.

Aber die Wissenschaftler hörten bei ihrer Arbeit nicht auf.

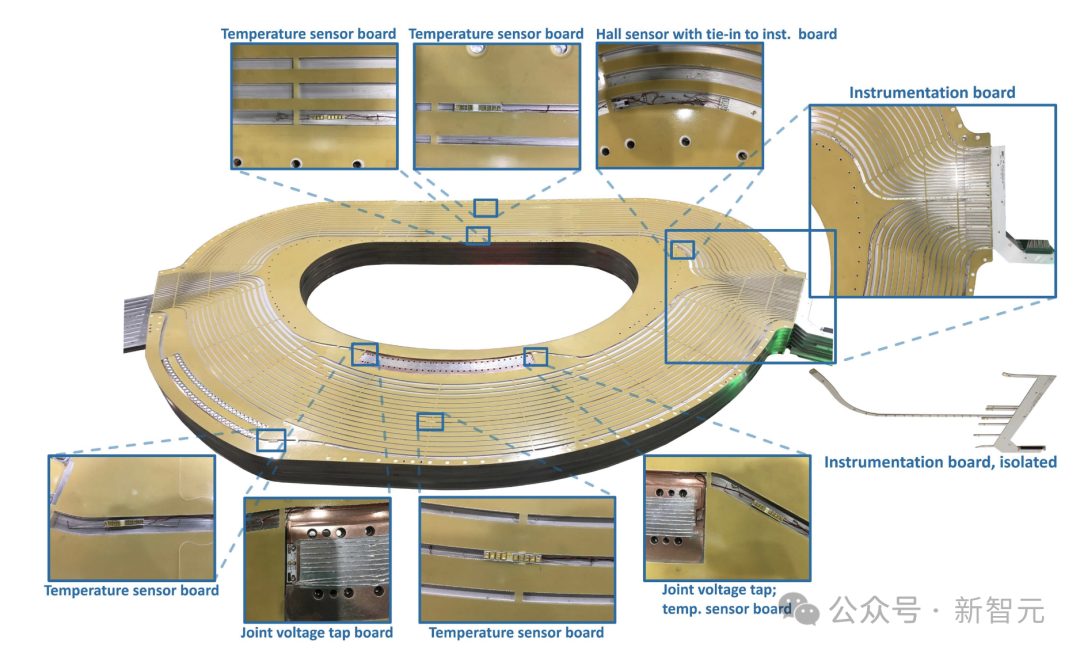

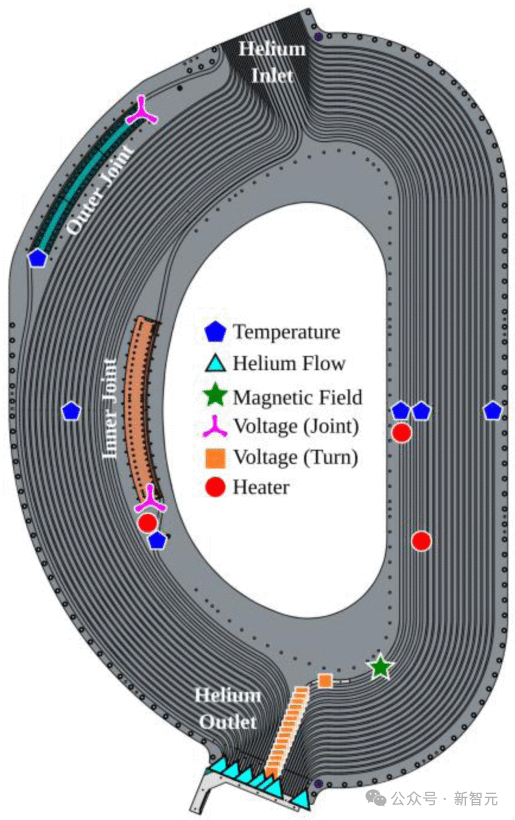

In den nächsten Monaten zerlegte und inspizierte das Team die Komponenten des Magneten und analysierte Daten von Hunderten von Instrumenten, die die Details der Tests aufzeichneten.

Sie führten außerdem zwei weitere Tests mit demselben Magneten durch und testeten ihn schließlich bis zum Äußersten, um die Details möglicher Fehlermodi herauszufinden.

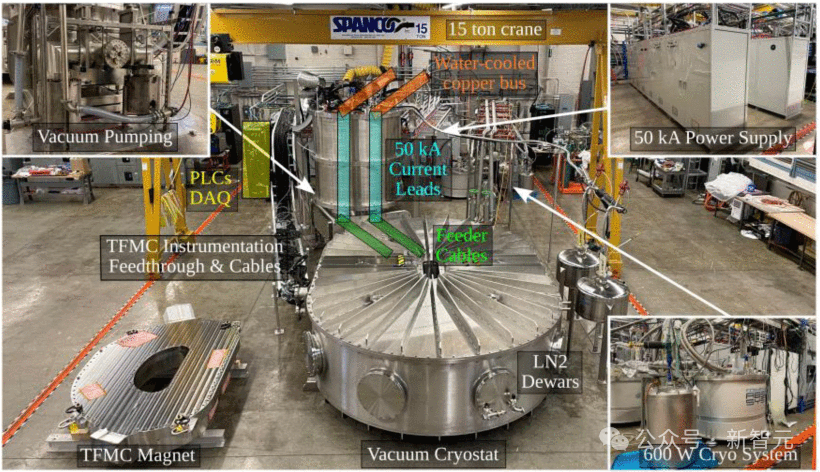

Der Zweck besteht darin, weiter zu überprüfen, ob der supraleitende Magnet in ihrem Experiment in verschiedenen Extremszenarien stabil funktionieren kann. „Ein Team hat Magnete in einen Kryostatenbehälter gelegt.“ Meiner Meinung nach war „die erfolgreiche Erprobung der Magnete das Wichtigste in der Fusionsforschung der letzten 30 Jahre.“

Wie experimentelle Ergebnisse zeigen, sind bestehende supraleitende Magnete stark genug, um möglicherweise Fusionsenergie zu erreichen.

Wie experimentelle Ergebnisse zeigen, sind bestehende supraleitende Magnete stark genug, um möglicherweise Fusionsenergie zu erreichen.

Der einzige Nachteil besteht darin, dass es aufgrund seiner enormen Größe und Kosten niemals praktisch oder wirtschaftlich machbar sein wird.

Nachfolgende Tests der Forscher zeigten, dass ein so starker Magnet auch bei stark reduzierter Größe noch praktisch ist.

„Über Nacht sind die Kosten pro Watt von Fusionsreaktoren an einem Tag um fast das 40-fache gesunken.“

Jetzt hat die Kernfusion eine Chance. „Tokamak“ ist derzeit das am weitesten verbreitete experimentelle Fusionsgerätedesign.

„Meiner Meinung nach hat Tokamak eine Chance, erschwinglich zu werden, denn unter den bekannten Einschränkungen der physikalischen Regeln können wir die Größe und die Kosten des für die Fusion erforderlichen Geräts erheblich reduzieren, was einen qualitativen Sprung darstellt.“

Sechs Artikel detailliert die umfassenden Daten der MIT-Magnettests.

Dann zeigt die Analyse, dass die neue Generation von Kernfusionsgeräten, die vom MIT und CFS entwickelt wurden, sowie ähnliche Entwürfe anderer kommerzieller Fusionsunternehmen wissenschaftlich völlig machbar sind.

Es ist Kernfusion und ein Durchbruch in der Supraleitung.

Kernfusion ist der Prozess, bei dem leichte Atome zu schweren Atomen kombiniert werden, um Energie für die Sonne und die Sterne bereitzustellen.

Doch die Nutzung dieses Prozesses auf der Erde hat sich als schwierige Herausforderung erwiesen.

Seit Jahrzehnten haben die Menschen große Anstrengungen unternommen und sogar Milliarden von Dollar für die experimentelle Geräteforschung ausgegeben.

Das Ziel, das die Menschen verfolgen, aber nie erreichen, ist: ein Fusionskraftwerk zu bauen, das mehr Energie produziert, als es verbraucht.

Im Betrieb kann ein solches Kraftwerk Strom erzeugen, ohne Treibhausgase auszustoßen, und produziert keine großen Mengen radioaktiven Abfalls.

Und der Brennstoff für die Kernfusion, der aus aus Meerwasser gewonnenem Wasserstoff gewonnen wird, ist nahezu unerschöpflich.

Damit die Kernfusion jedoch erfolgreich ist, muss der Brennstoff bei extrem hohen Temperaturen und Drücken komprimiert werden.

Da kein bekanntes Material solchen Temperaturen standhalten kann, müssen extrem starke Magnetfelder verwendet werden, um den Kraftstoff einzuschließen.

Wenn Sie ein so starkes Magnetfeld erzeugen möchten, benötigen Sie einen „supraleitenden Magneten“, aber alle bisherigen Kernfusionsmagnete wurden aus supraleitenden Materialien hergestellt. Dieses Material erfordert etwa 4 Grad über dem absoluten Nullpunkt (also 4 Kelvin). - 270 Grad Celsius).

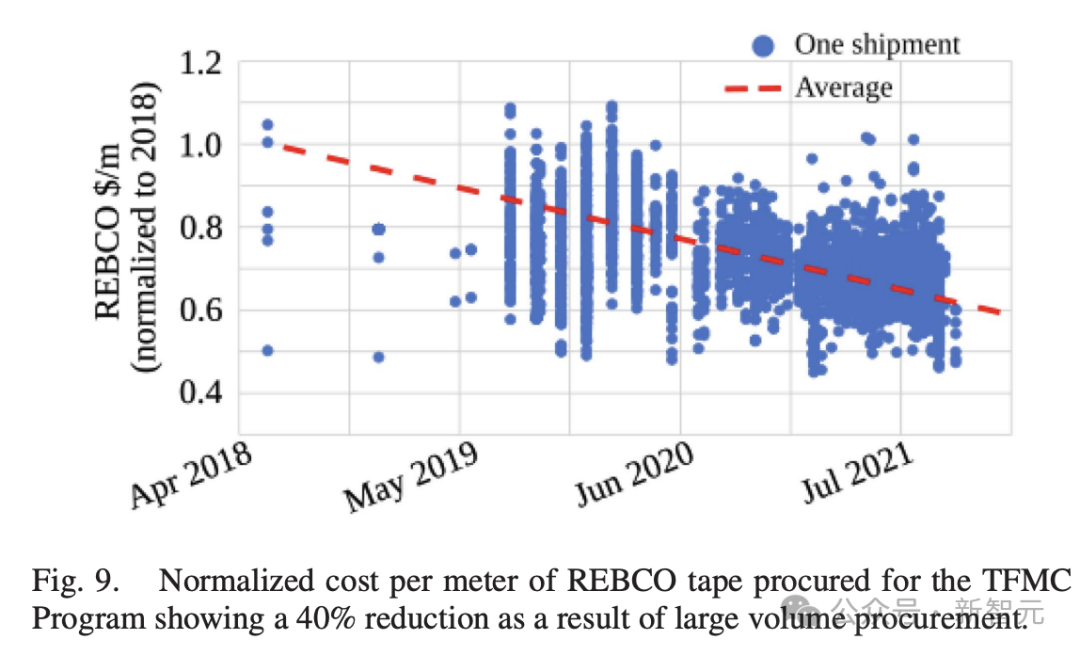

In den letzten Jahren wurde begonnen, ein neues Material namens REBCO (Seltenerd-Bariumkupferoxid) in Kernfusionsmagneten zu verwenden.

Es ermöglicht den Betrieb von Kernfusionsmagneten bei einer Temperatur von 20 Kelvin, die zwar nur 16 Kelvin höher als 4 Kelvin ist, aber erhebliche Vorteile hinsichtlich der Materialeigenschaften und der praktischen Technik bietet.

Neue Hochtemperatur-Supraleitermaterialien sind eine Neugestaltung fast aller Prinzipien, die zur Herstellung supraleitender Magnete verwendet werden.

Wenn dieses neue hochtemperatursupraleitende Material zur Herstellung supraleitender Magnete verwendet wird, wird es nicht nur gegenüber seinen Vorgängern verbessert, sondern erfordert auch Innovation sowie Forschung und Entwicklung von Grund auf.

Ein neuer Artikel in der Zeitschrift „Transactions on Applied Superconductivity“ beschreibt die Details dieses Redesign-Prozesses, und der Patentschutz ist bereits vorhanden.

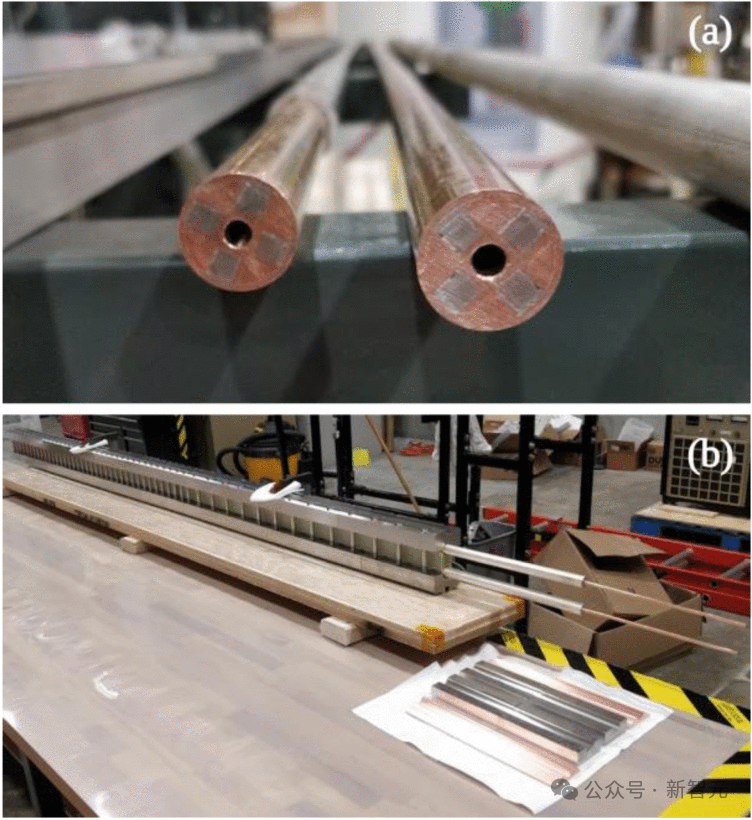

Um REBCO voll auszunutzen, haben Forscher ein industriell skalierbares Hochstromkabel „VIPER REBCO“ auf Basis der TSTC-Architektur neu entworfen.

VIPER REBCO-Kabel hat diese offensichtlichen Vorteile:

– Hat weniger als 5 % stabile Stromdegradation.

– Verfügt über robuste abnehmbare Header im 2–5 nΩ-Bereich

– Zum ersten Mal können zwei verschiedene Kabelabschreckungstests an Leitern voller Größe unter fusionsbedingten Bedingungen durchgeführt werden, die für REBCOs niedrige Ausbreitungsgeschwindigkeiten in der Normalzone geeignet sind.

Schlüsselinnovation: Design ohne Isolationsschicht

Ein weiteres unglaubliches Design dieses supraleitenden Magneten besteht darin, den Isolator um den dünnen und flachen supraleitenden Streifen des Magneten zu entfernen.

In traditionellen Designs sind supraleitende Magnete von isolierenden Materialien umgeben, um sie vor Kurzschlüssen zu schützen.

Und bei diesem neuen supraleitenden Magneten liegt der supraleitende Streifen vollständig frei.

Wissenschaftler verlassen sich auf die stärkere Leitfähigkeit von REBCO, um sicherzustellen, dass der elektrische Strom präzise durch das Material fließt.

Professor Zach Hartwig vom Department of Nuclear Science and Engineering des MIT, der für die Entwicklung der supraleitenden Magnete verantwortlich ist, sagte: „Als wir dieses Projekt im Jahr 2018 begannen, war die Technologie zum Bau großer Hochfeldmagnete unter Verwendung von Temperatursupraleiter befanden sich noch in einem sehr frühen Stadium. „

“ Basierend auf diesem Umfang hat unser Magnetforschungs- und -entwicklungsprojekt die Forschung und Entwicklung von Magneten in Originalgröße in sehr kurzer Zeit abgeschlossen

Das Team stellte schließlich einen fast 10 Tonnen schweren Magneten her. Der Magnet erzeugt ein stabiles und gleichmäßiges Magnetfeld von mehr als 20 Tesla.

„Die Standardmethode zur Herstellung dieser Magnete besteht darin, einen Leiter um eine Wicklung zu wickeln und eine Isolierschicht zwischen die Wicklungen zu legen. Sie benötigen die Isolierschicht, um die hohen Spannungen zu bewältigen, die in unerwarteten Situationen wie Abschaltungen entstehen.“

„Der Vorteil des Entfernens dieser Isolationsschicht besteht darin, dass es sich um ein Niederspannungssystem handelt. Es vereinfacht den Herstellungsprozess und den Zeitplan erheblich.“

Dadurch bleibt auch viel Spielraum für Abkühlung oder mehr Kraftaufbau.

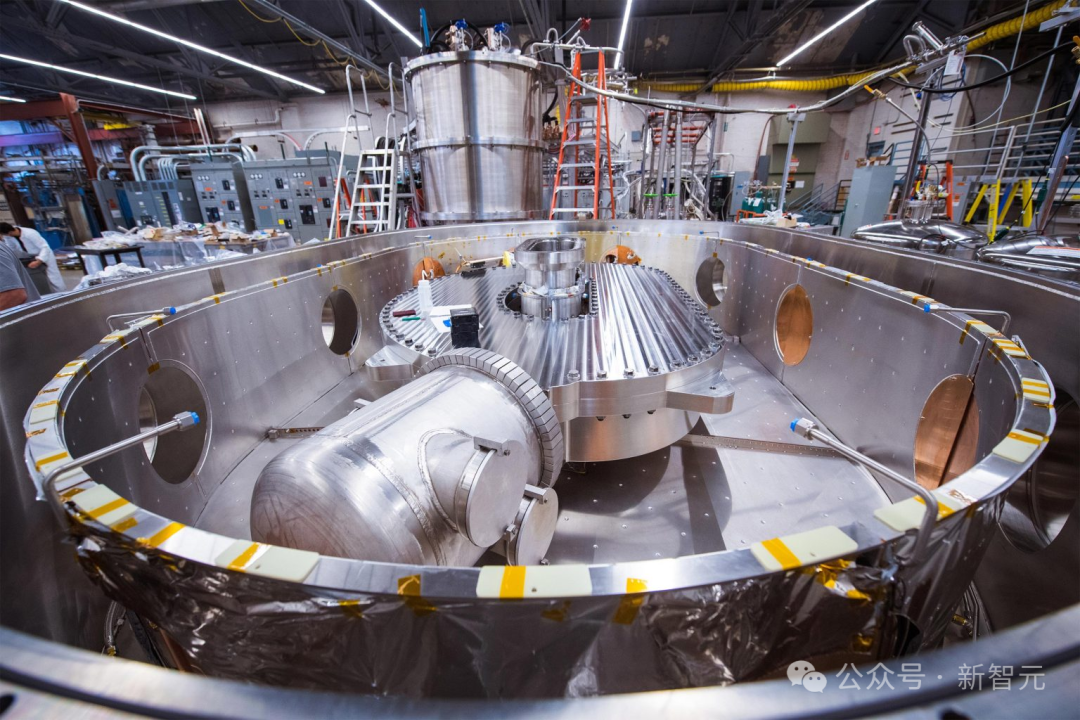

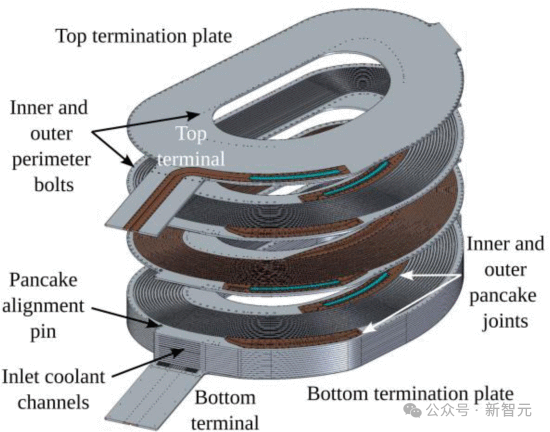

Die etwas kleinere Magnetbaugruppe, die den donutförmigen Hohlraum des SPARC-Kernfusionsgeräts bildet, das von CFS gebaut wird.

Dieser Hohlraum besteht aus 16 Platten, die „Pfannkuchen“ genannt werden. Eine Seite jeder Platte ist mit einem spiralförmigen supraleitenden Streifen umwickelt, und die andere Seite ist ein Helium-Kühlkanal.

„Allerdings ist der nicht isolierende Schichtaufbau in den Augen der meisten Menschen sehr riskant und auch in der Testphase sehr riskant.“ Professor

sagte: „Dies ist der erste Magnet in ausreichender Größe, um die Probleme zu untersuchen, die mit der Entwicklung, Herstellung und Prüfung von Magneten unter Verwendung dieser nichtisolierenden Schicht und nicht verdrillten Technologie verbunden sind.“

„Die ganze Community war sehr überrascht, als das Team verkündete, dass es sich um eine nicht isolierte Spule handelte.“

Der Extremtest ist abgeschlossen, der großflächige kommerzielle Einsatz steht an?

Erste Experimente, die in einer früheren Arbeit beschrieben wurden, haben gezeigt, dass ein solcher Design- und Herstellungsprozess nicht nur machbar, sondern auch sehr stabil ist, obwohl einige Forscher Zweifel geäußert hatten.

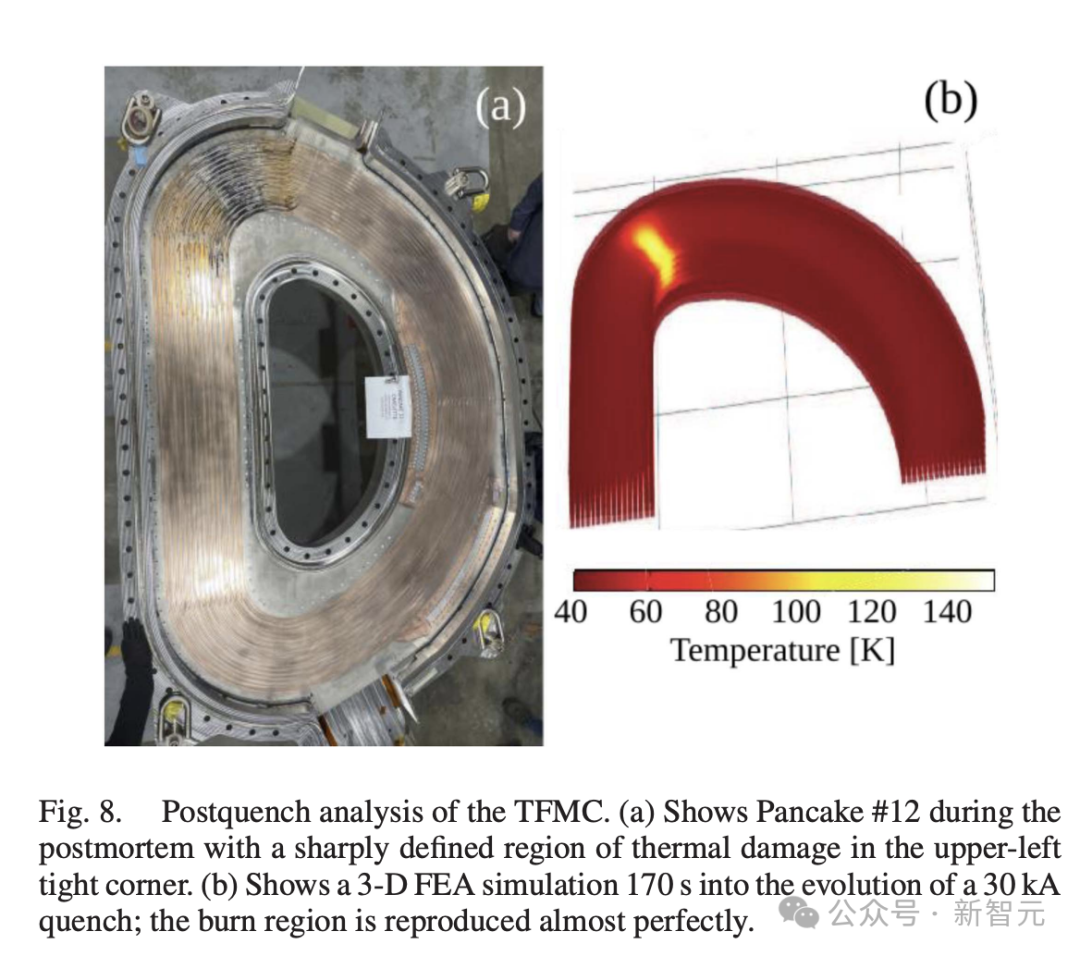

Die nächsten beiden Tests, die ebenfalls Ende 2021 durchgeführt wurden, brachten die Betriebsbedingungen der Geräte an ihre Grenzen, indem sie absichtlich instabile Bedingungen erzeugten, einschließlich der vollständigen Abschaltung der Eingangsleistung, was zu einer katastrophalen Überhitzung führen konnte.

Diese Situation wird als „Quenching“ bezeichnet und gilt als der schlimmste Fall, der beim Betrieb solcher Magnete auftreten kann und das Gerät direkt zerstören kann.

Ein Teil des Testplans, sagte Hartwig, bestehe darin, „tatsächlich rauszugehen und einen Magneten in Originalgröße absichtlich abzuschrecken, damit wir kritische Daten im richtigen Maßstab und unter den richtigen Bedingungen erhalten können, um die Wissenschaft voranzutreiben und zu validieren.“ Design-Code." .

„Dann haben wir die Magnete auseinandergenommen, um zu sehen, was schief gelaufen ist, warum es schief gelaufen ist und wie wir es mit der nächsten Iteration beheben konnten … es war ein großer Erfolg.“

Hartwig sagte, der letzte Test endete damit, dass eine Ecke von 16 „Pfannkuchen“ schmolz, brachte aber viele neue Informationen hervor.

Erstens haben sie mehrere verschiedene Rechenmodelle verwendet, um die Leistung verschiedener Aspekte der Magnete zu entwerfen und vorherzusagen, und in den meisten Fällen stimmen diese Modelle in ihren Gesamtvorhersagen und durch eine Reihe von Tests und tatsächlichen Messungen überein sind gut verifiziert.

Bei der Vorhersage des „Quenching“-Effekts weichen die Vorhersageergebnisse des Modells jedoch ab, sodass experimentelle Daten erforderlich sind, um die Wirksamkeit des Modells zu bewerten.

Das von den Forschern entwickelte Modell sagt nahezu genau voraus, wie sich der Magnet erwärmt, wie stark er sich zu Beginn des Abschreckens verhält und welche Schäden am Magneten daraus entstehen.

Experimente beschreiben die zugrunde liegende Physik genau und ermöglichen Wissenschaftlern zu verstehen, welche Modelle in Zukunft nützlich und welche ungenau sein werden.

Nachdem die Wissenschaftler die Leistung aller Aspekte der Spule getestet hatten, erstellten die Wissenschaftler bewusst auch die schlechteste Simulation der Spule.

Es wurde festgestellt, dass der beschädigte Bereich der Spule nur wenige Prozent des Spulenvolumens ausmachte.

Auf der Grundlage dieses Ergebnisses nahmen sie weitere Änderungen am Design vor, in der Erwartung, dass sie selbst unter extremsten Bedingungen Schäden dieser Größenordnung an den Magneten einer tatsächlichen Kernfusionsanlage verhindern könnten.

Professor Hartwig betonte, dass der Grund, warum das Team ein solch rekordverdächtiges neues Magnetdesign fertigstellen und es mit extrem hoher Geschwindigkeit fertigstellen konnte, hauptsächlich auf den Alcatel C-Mod Toka zurückzuführen sei. Jahrzehntelange Entwicklung fundiertes Wissen, Fachwissen und Ausrüstung vom Mark and Francis Bit Magnet Laboratory und andere am PSFC durchgeführte Arbeiten.

In Zukunft wird das Experiment weiter vorangetrieben, um eine großflächige kommerzielle Nutzung von sauberem Strom zu erreichen.

Das obige ist der detaillierte Inhalt vonMIT Genesis-Kernfusion bricht Weltrekord! Hochtemperatur-supraleitende Magnete setzen Sternenergie frei. Steht die Geburt einer künstlichen Sonne bevor?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Der erste Pilot- und Schlüsselartikel stellt hauptsächlich mehrere häufig verwendete Koordinatensysteme in der autonomen Fahrtechnologie vor und erläutert, wie die Korrelation und Konvertierung zwischen ihnen abgeschlossen und schließlich ein einheitliches Umgebungsmodell erstellt werden kann. Der Schwerpunkt liegt hier auf dem Verständnis der Umrechnung vom Fahrzeug in den starren Kamerakörper (externe Parameter), der Kamera-in-Bild-Konvertierung (interne Parameter) und der Bild-in-Pixel-Einheitenkonvertierung. Die Konvertierung von 3D in 2D führt zu entsprechenden Verzerrungen, Verschiebungen usw. Wichtige Punkte: Das Fahrzeugkoordinatensystem und das Kamerakörperkoordinatensystem müssen neu geschrieben werden: Das Ebenenkoordinatensystem und das Pixelkoordinatensystem. Schwierigkeit: Sowohl die Entzerrung als auch die Verzerrungsaddition müssen auf der Bildebene kompensiert werden. 2. Einführung Insgesamt gibt es vier visuelle Systeme Koordinatensystem: Pixelebenenkoordinatensystem (u, v), Bildkoordinatensystem (x, y), Kamerakoordinatensystem () und Weltkoordinatensystem (). Es gibt eine Beziehung zwischen jedem Koordinatensystem,

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Einige persönliche Gedanken des Autors Im Bereich des autonomen Fahrens sind mit der Entwicklung BEV-basierter Teilaufgaben/End-to-End-Lösungen hochwertige Multi-View-Trainingsdaten und der entsprechende Aufbau von Simulationsszenen immer wichtiger geworden. Als Reaktion auf die Schwachstellen aktueller Aufgaben kann „hohe Qualität“ in drei Aspekte zerlegt werden: Long-Tail-Szenarien in verschiedenen Dimensionen: z. B. Nahbereichsfahrzeuge in Hindernisdaten und präzise Kurswinkel beim Schneiden von Autos sowie Spurliniendaten . Szenen wie Kurven mit unterschiedlichen Krümmungen oder Rampen/Zusammenführungen/Zusammenführungen, die schwer zu erfassen sind. Diese basieren häufig auf der Sammlung großer Datenmengen und komplexen Data-Mining-Strategien, die kostspielig sind. Echter 3D-Wert – hochkonsistentes Bild: Die aktuelle BEV-Datenerfassung wird häufig durch Fehler bei der Sensorinstallation/-kalibrierung, hochpräzisen Karten und dem Rekonstruktionsalgorithmus selbst beeinträchtigt. das hat mich dazu geführt

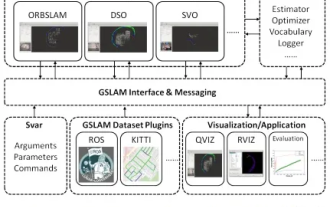

GSLAM |. Eine allgemeine SLAM-Architektur und ein Benchmark

Oct 20, 2023 am 11:37 AM

GSLAM |. Eine allgemeine SLAM-Architektur und ein Benchmark

Oct 20, 2023 am 11:37 AM

Plötzlich wurde ein 19 Jahre altes Papier namens GSLAM: A General SLAM Framework and Benchmark mit offenem Quellcode entdeckt: https://github.com/zdzhaoyong/GSLAM Gehen Sie direkt zum Volltext und spüren Sie die Qualität dieser Arbeit~1 Zusammenfassung der SLAM-Technologie hat in letzter Zeit viele Erfolge erzielt und die Aufmerksamkeit vieler High-Tech-Unternehmen auf sich gezogen. Es bleibt jedoch eine Frage, wie eine Schnittstelle zu bestehenden oder neuen Algorithmen hergestellt werden kann, um ein Benchmarking hinsichtlich Geschwindigkeit, Robustheit und Portabilität effizient durchzuführen. In diesem Artikel wird eine neue SLAM-Plattform namens GSLAM vorgeschlagen, die nicht nur Evaluierungsfunktionen bietet, sondern Forschern auch eine nützliche Möglichkeit bietet, schnell ihre eigenen SLAM-Systeme zu entwickeln.

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

Bitte beachten Sie, dass dieser kantige Mann die Stirn runzelt und über die Identität der „ungebetenen Gäste“ vor ihm nachdenkt. Es stellte sich heraus, dass sie sich in einer gefährlichen Situation befand, und als ihr dies klar wurde, begann sie schnell mit der mentalen Suche nach einer Strategie zur Lösung des Problems. Letztendlich entschloss sie sich, vom Unfallort zu fliehen, dann so schnell wie möglich Hilfe zu suchen und sofort Maßnahmen zu ergreifen. Gleichzeitig dachte die Person auf der Gegenseite das Gleiche wie sie... In „Minecraft“ gab es eine solche Szene, in der alle Charaktere von künstlicher Intelligenz gesteuert wurden. Jeder von ihnen hat eine einzigartige Identität. Das zuvor erwähnte Mädchen ist beispielsweise eine 17-jährige, aber kluge und mutige Kurierin. Sie haben die Fähigkeit, sich zu erinnern und zu denken und in dieser kleinen Stadt in Minecraft wie Menschen zu leben. Was sie antreibt, ist ein brandneues,

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Am 23. September wurde das Papier „DeepModelFusion:ASurvey“ von der National University of Defense Technology, JD.com und dem Beijing Institute of Technology veröffentlicht. Deep Model Fusion/Merging ist eine neue Technologie, die die Parameter oder Vorhersagen mehrerer Deep-Learning-Modelle in einem einzigen Modell kombiniert. Es kombiniert die Fähigkeiten verschiedener Modelle, um die Verzerrungen und Fehler einzelner Modelle zu kompensieren und so eine bessere Leistung zu erzielen. Die tiefe Modellfusion bei groß angelegten Deep-Learning-Modellen (wie LLM und Basismodellen) steht vor einigen Herausforderungen, darunter hohe Rechenkosten, hochdimensionaler Parameterraum, Interferenzen zwischen verschiedenen heterogenen Modellen usw. Dieser Artikel unterteilt bestehende Methoden zur Tiefenmodellfusion in vier Kategorien: (1) „Musterverbindung“, die Lösungen im Gewichtsraum über einen verlustreduzierenden Pfad verbindet, um eine bessere anfängliche Modellfusion zu erzielen