Gerade hat Pika eine neue Funktion veröffentlicht:

Leider wurden wir schon einmal stummgeschaltet.

Ab heute kann jeder nahtlos Soundeffekte für Videos generieren – Soundeffekte!

Es gibt zwei Möglichkeiten, es zu generieren:

Und Pika sagte sehr selbstbewusst: „Wenn du denkst, dass der Soundeffekt großartig klingt, dann deshalb, weil er es ist.“

Der Klang von Autos, Radios, Adlern, Schwertern, Jubelrufen ... man kann sagen, dass der Klang endlos ist und auch in Bezug auf die Wirkung dem Videobild sehr gut entspricht.

Nicht nur das Werbevideo wurde veröffentlicht, auf der offiziellen Website von Pika wurden auch mehrere Demos veröffentlicht.

Zum BeispielEs sind keine Eingabeaufforderungen erforderlich, die KI hat sich gerade das Video zum Braten von Speck angesehen und kann die Soundeffekte ohne das Gefühl einer Verletzung abgleichen.

Eine weitere Eingabeaufforderung:

Super gesättigte Farbe, Feuerwerk über einem Feld bei Sonnenuntergang.

Super gesättigte Farbe, Feuerwerk über einem Feld bei Sonnenuntergang.

Pika kann beim Erstellen des Videos Ton hinzufügen. Anhand des Effekts ist es nicht schwer zu erkennen, dass der Ton in dem Moment hängen bleibt, in dem das Feuerwerk blüht.

Eine solche neue Funktion wurde während des großen Wochenendes veröffentlicht. Während die Internetnutzer Pika „genug Lautstärke und großartig genug“ riefen, dachten einige Leute auch:

Es sammelt alle „unendlichen Juwelen“ für die multimodale KI-Erstellung . ". Schauen wir uns also weiterhin an, wie man Pikas Soundeffekte bedient.

Schauen wir uns also weiterhin an, wie man Pikas Soundeffekte bedient.

„Machen Sie etwas Lärm“ für Videos

Zum Beispiel kann nur eine Aufforderung, ein Video und Soundeffekte

„aus einem Topf kommen“:

Mittelalterlicher Trompeter.Mittelalterlicher Trompeter.

Im Vergleich zum vorherigen Vorgang zum Erstellen von Videos müssen Sie jetzt nur noch die Schaltfläche „Soundeffekte“ unten aktivieren.

Im Vergleich zum vorherigen Vorgang zum Erstellen von Videos müssen Sie jetzt nur noch die Schaltfläche „Soundeffekte“ unten aktivieren.

Die zweite Vorgehensweise besteht darin, das Video nach der Erstellung separat zu überspielen.

Zum Beispiel klicken Sie im Video unten auf

„Bearbeiten“ unten und wählen Sie dann „Soundeffekte“ aus:

Dann können Sie den gewünschten Sound beschreiben, zum Beispiel:

Dann können Sie den gewünschten Sound beschreiben, zum Beispiel:

Der Rennwagen lässt seinen Motor aufheulen.Dann kann Pika in nur wenigen Sekunden Soundeffekte basierend auf der Beschreibung und dem Video erzeugen, und es stehen

6 Sounds zur Auswahl! Es ist erwähnenswert, dass die Soundeffektfunktion derzeit nur Super Collaborator

(Super Collaborator)und Pro-Benutzern zum Testen offen steht. Allerdings sagte Pika auch: „Wir werden diese Funktion bald für alle Benutzer einführen!“

Und jetzt hat eine Gruppe von Internetnutzern damit begonnen, diese Beta-Version zu testen und sagte:

Die Soundeffekte klingen sehr passend zum Video und sorgen für viel Atmosphäre.

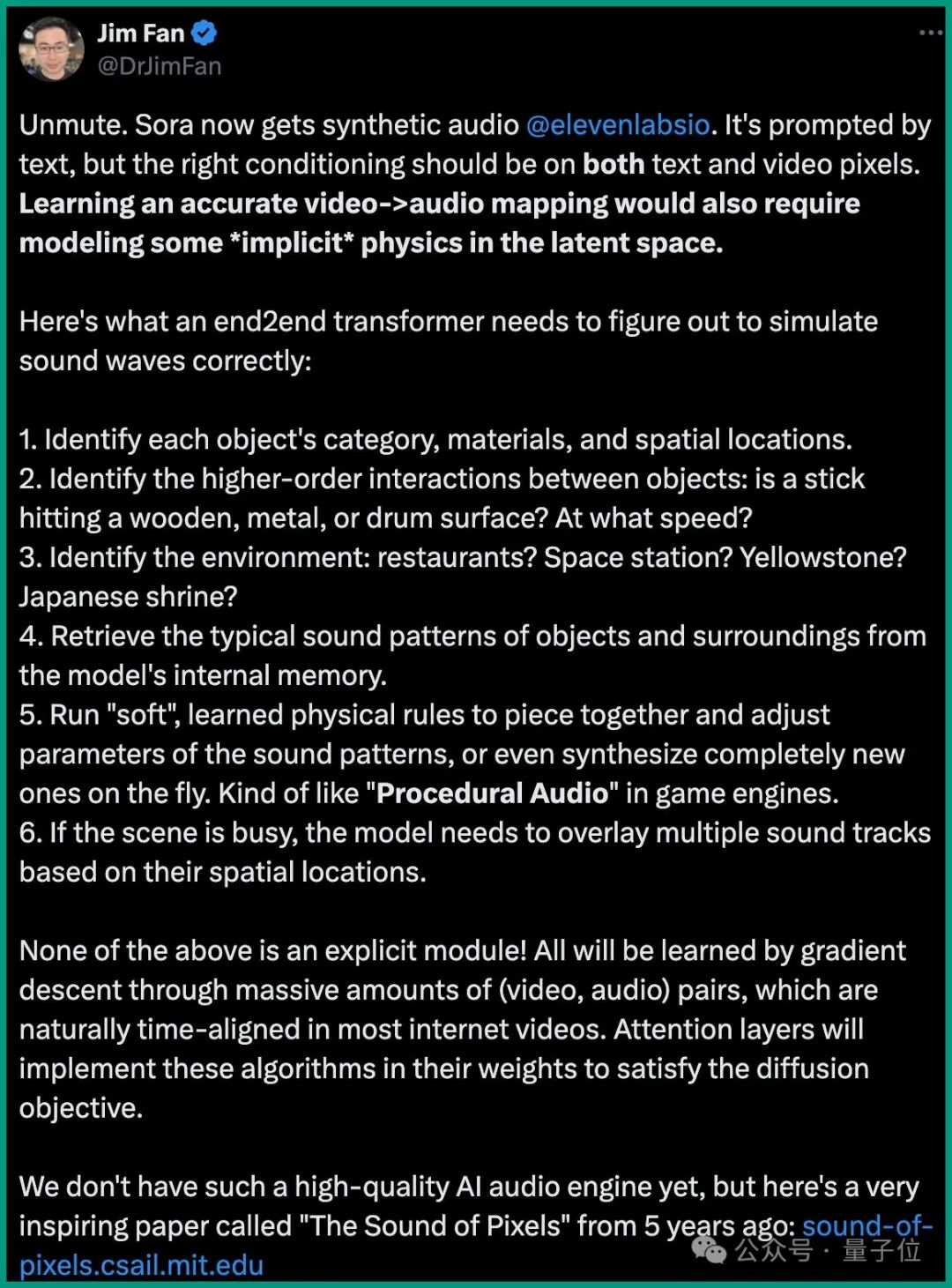

Was das Prinzip hinter Soundeffekten betrifft: Obwohl Pika es dieses Mal nicht öffentlich gemacht hat, hat das Voice-Startup-Unternehmen ElevenLabs nach der Popularität von Sora eine ähnliche Synchronisationsfunktion entwickelt.

Zu diesem Zeitpunkt führte der leitende NVIDIA-Wissenschaftler Jim Fan eine eingehendere Analyse hierzu durch.

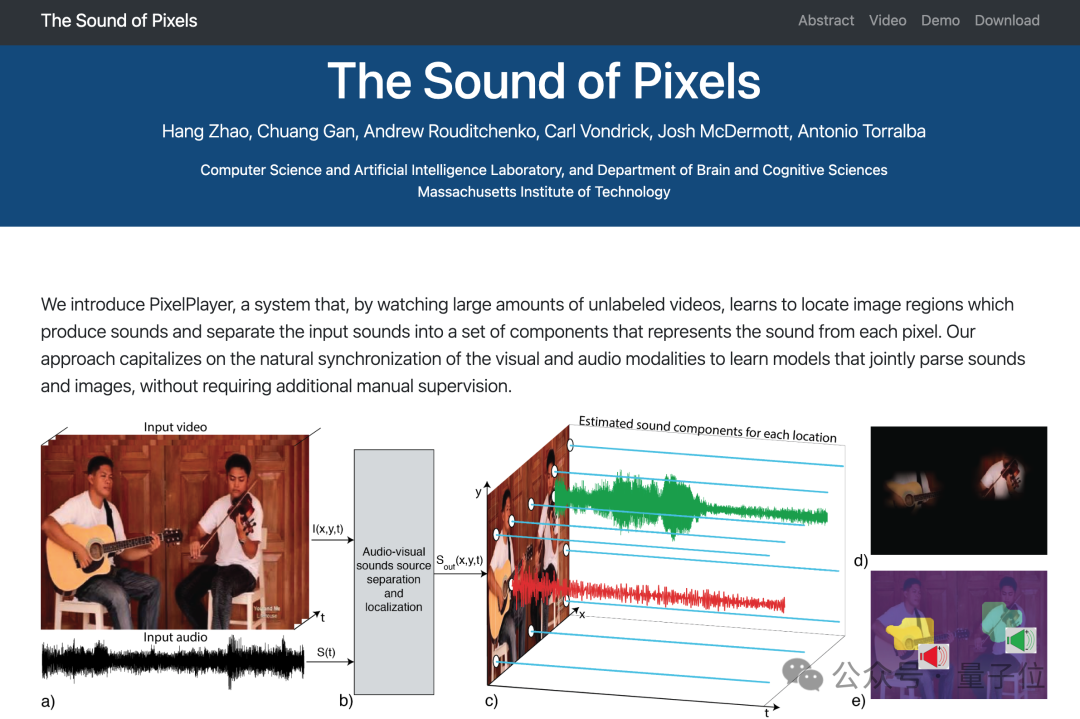

Er glaubt, dass das Erlernen einer genauen Video-zu-Audio-Zuordnung durch KI auch die Modellierung einer „impliziten“ Physik im latenten Raum erfordert.

The Sound of Pixels:

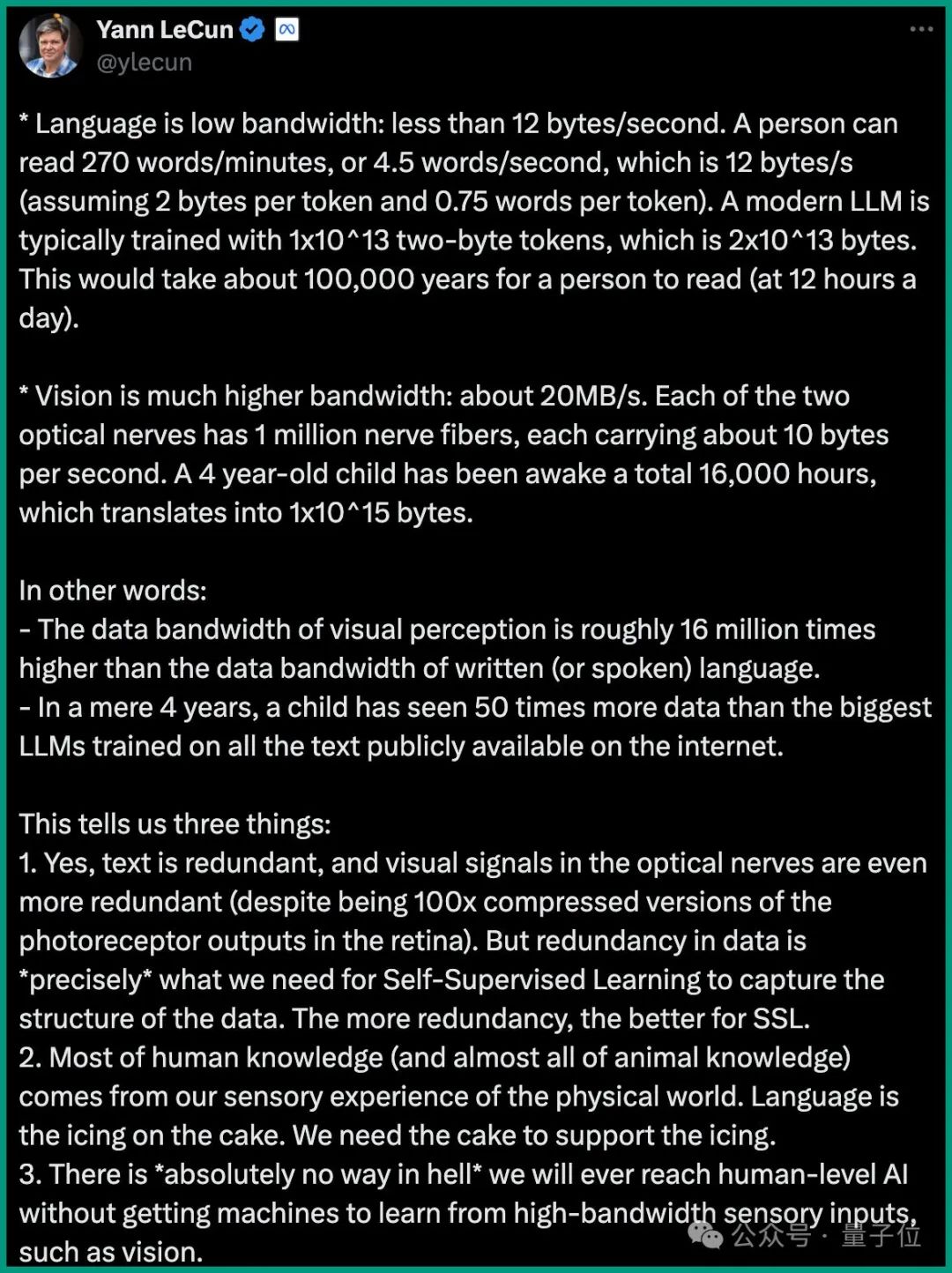

multimodal hat LeCun im letzten Interview auch eine sehr heiße Meinung:

Sprache (Text) hat eine geringe Bandbreite: weniger als 12 Bytes/Sekunde. Moderne LLMs verwenden typischerweise 1x10^13 Doppelbyte-Tokens (d. h. 2x10^13 Bytes) für das Training. Ein Mensch würde etwa 100.000 Jahre (12 Stunden am Tag) brauchen, um zu lesen.

Die visuelle Bandbreite ist viel höher: etwa 20 MB/s. Jeder der beiden Sehnerven verfügt über 1 Million Nervenfasern, von denen jede etwa 10 Bytes pro Sekunde überträgt. Ein 4-jähriges Kind verbringt etwa 16.000 Stunden im Wachzustand, was in Bytes umgerechnet etwa 1x10^15 entspricht.

Die Datenbandbreite der visuellen Wahrnehmung beträgt etwa das 16-Millionen-fache der Datenbandbreite der Textsprache. Die von einem 4-jährigen Kind gesehenen Daten sind 50-mal so groß wie die größten LLM-Daten für alle im Internet veröffentlichten Texttrainings.

Es gibt absolut keine Möglichkeit, künstliche Intelligenz auf menschlicher Ebene zu erreichen, ohne Maschinen aus sensorischen Eingaben mit hoher Bandbreite (z. B. Vision) lernen zu lassen.Stimmen Sie dieser Ansicht zu?

Das obige ist der detaillierte Inhalt vonPikas Verstärkungstrick: Ab heute lassen sich Video- und Soundeffekte „in einem Topf' produzieren!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Der fatale Fehler von Blade-Servern

Der fatale Fehler von Blade-Servern

Was ist besser, zuerst zu lernen, C-Sprache oder C++?

Was ist besser, zuerst zu lernen, C-Sprache oder C++?

So überprüfen Sie tote Links auf Ihrer Website

So überprüfen Sie tote Links auf Ihrer Website

Der Unterschied zwischen Bond0 und Bond1

Der Unterschied zwischen Bond0 und Bond1

CMD-Befehl zum Schließen des Ports

CMD-Befehl zum Schließen des Ports

So verwenden Sie den Java-Switch

So verwenden Sie den Java-Switch