Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie baut das Diffusionsmodell eine neue Generation von Entscheidungsträgern auf? Über die Autoregression hinaus können Sie gleichzeitig lange Sequenzplanungspfade generieren

Wie baut das Diffusionsmodell eine neue Generation von Entscheidungsträgern auf? Über die Autoregression hinaus können Sie gleichzeitig lange Sequenzplanungspfade generieren

Wie baut das Diffusionsmodell eine neue Generation von Entscheidungsträgern auf? Über die Autoregression hinaus können Sie gleichzeitig lange Sequenzplanungspfade generieren

Stellen Sie sich vor, Sie stehen im Raum und bereiten sich darauf vor, zur Tür zu gehen. Planen Sie dann schrittweise den Weg durch Autoregression? Tatsächlich wird Ihr Pfad als Ganzes auf einmal generiert.

Die neuesten Forschungsergebnisse zeigen, dass das Planungsmodul, das das Diffusionsmodell verwendet, gleichzeitig eine Trajektorienplanung mit langer Sequenz generieren kann, was eher der menschlichen Entscheidungsfindung entspricht. Darüber hinaus kann das Diffusionsmodell auch optimiertere Lösungen für bestehende Entscheidungsintelligenzalgorithmen in Bezug auf Richtliniendarstellung und Datensynthese bereitstellen.

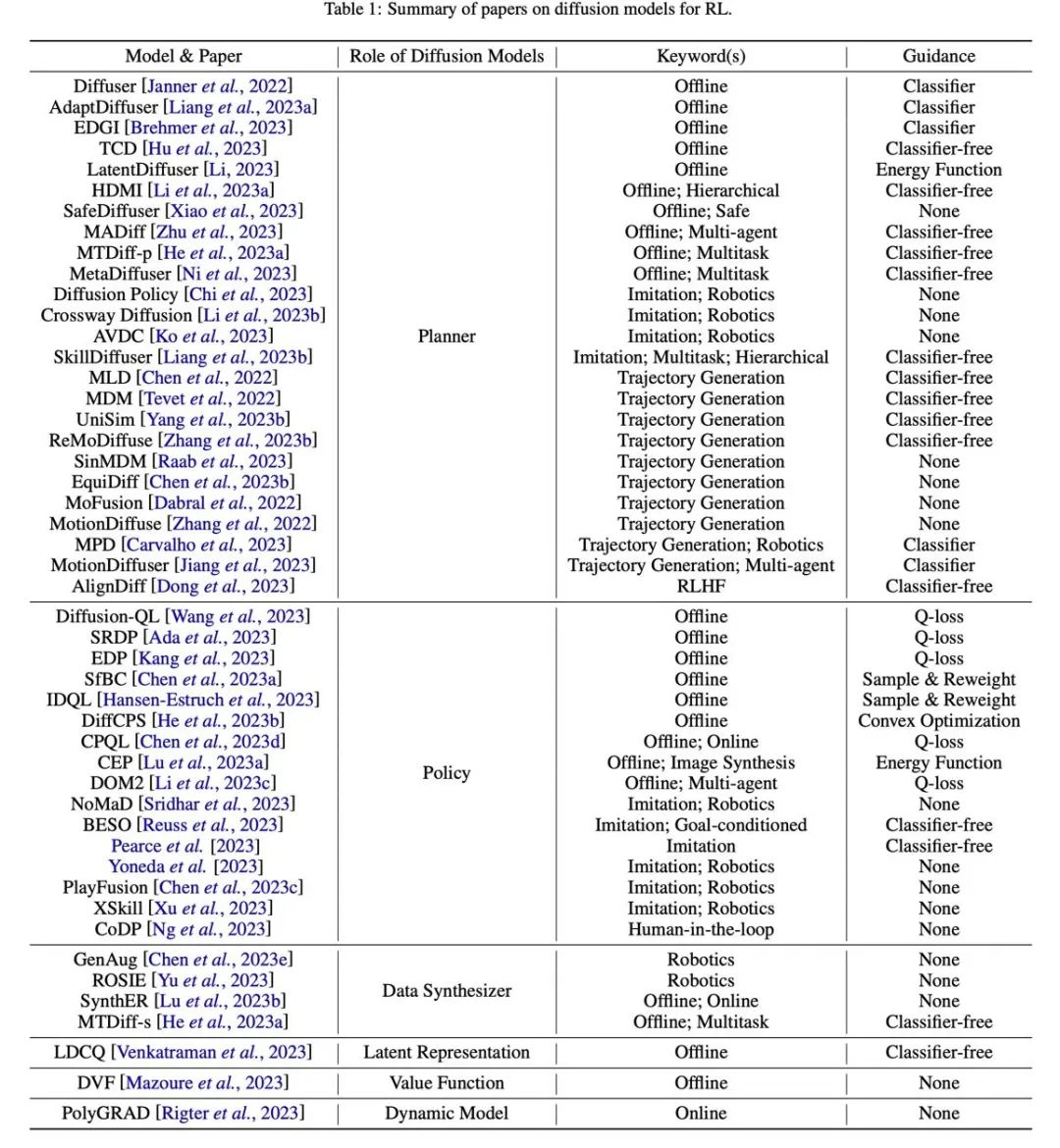

Der von einem Team der Shanghai Jiao Tong University verfasste Übersichtsartikel „Diffusion Models for Reinforcement Learning: A Survey“ fasst die Anwendung von Diffusionsmodellen in Bereichen zusammen, die mit Reinforcement Learning zusammenhängen. In der Überprüfung wird darauf hingewiesen, dass bestehende Algorithmen für das Reinforcement-Learning mit Herausforderungen konfrontiert sind, wie z. B. der Anhäufung von Fehlern bei der Planung über lange Zeiträume, begrenzten Fähigkeiten zum Ausdrücken von Richtlinien und unzureichenden interaktiven Daten. Das Diffusionsmodell hat sich bei der Lösung von Reinforcement-Learning-Problemen als vorteilhaft erwiesen und wurde zur Bewältigung der oben genannten Probleme eingesetzt. Langjährige Herausforderungen bringen neue Ideen. Papierlink: https://arxiv.org/abs/2311.01223

Projektadresse: https://github.com/apexrl/Diff4RLSurvey

Projektadresse: https://github.com/apexrl/Diff4RLSurvey

In dieser Rezension geht es um die Stärkung der Verbreitung Modell Die Rollen beim Lernen werden klassifiziert und erfolgreiche Fälle von Diffusionsmodellen in verschiedenen Szenarien des verstärkenden Lernens zusammengefasst. Abschließend blickt die Überprüfung auf die zukünftige Entwicklungsrichtung der Verwendung von Diffusionsmodellen zur Lösung von Problemen des verstärkenden Lernens.

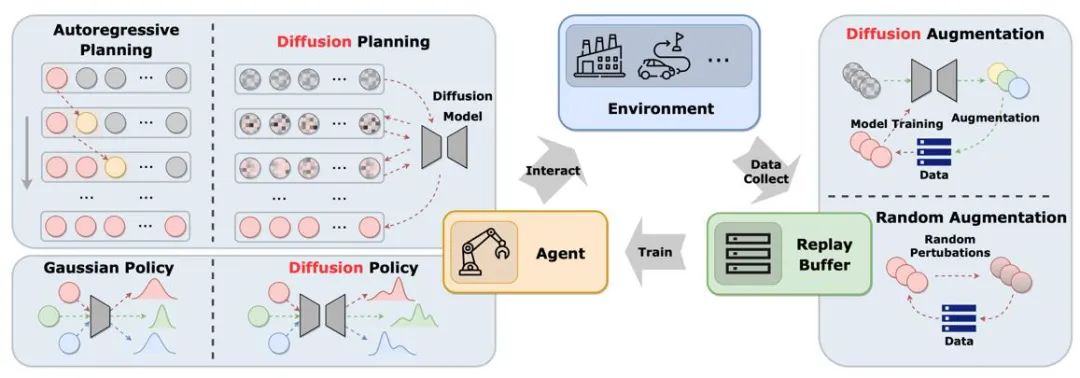

Die Abbildung zeigt die Rolle des Diffusionsmodells im klassischen Replay-Pool-Zyklus zwischen Agent, Umgebung und Erfahrung. Im Vergleich zu herkömmlichen Lösungen führt das Diffusionsmodell neue Elemente in das System ein und bietet umfassendere Informationsinteraktions- und Lernmöglichkeiten. Auf diese Weise kann sich der Agent besser an Umweltveränderungen anpassen und seine Entscheidungsfindung optimieren. Die Rolle des Diffusionsmodells beim verstärkenden Lernen Anwendungsmethoden und Eigenschaften von Diffusionsmodellen werden verglichen.

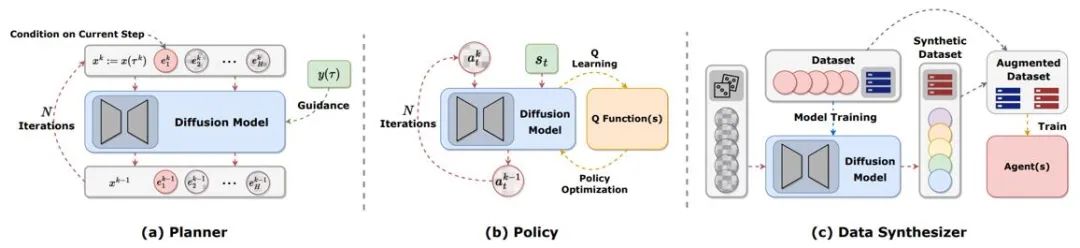

Abbildung 2: Die verschiedenen Rollen, die Diffusionsmodelle beim verstärkenden Lernen spielen.

Trajektorienplanung

Planung beim Reinforcement Learning bezieht sich auf das Treffen von Entscheidungen in der Fantasie mithilfe dynamischer Modelle und die anschließende Auswahl geeigneter Aktionen, um die kumulativen Belohnungen zu maximieren. Der Planungsprozess untersucht häufig Handlungsabfolgen und Zustände, um die langfristige Wirksamkeit von Entscheidungen zu verbessern. In MBRL-Frameworks (Model-Based Reinforcement Learning) werden Planungssequenzen häufig autoregressiv simuliert, was zu akkumulierten Fehlern führt. Diffusionsmodelle können mehrstufige Planungssequenzen gleichzeitig generieren. Die durch vorhandene Artikel unter Verwendung von Diffusionsmodellen generierten Ziele sind sehr vielfältig, einschließlich (s,a,r), (s,a), nur s, nur a usw. Um während der Online-Bewertung Trajektorien mit hoher Belohnung zu generieren, verwenden viele Arbeiten geführte Stichprobenverfahren mit oder ohne Klassifikatoren.

Richtliniendarstellung

Diffusionsplaner ähnelt eher MBRL beim traditionellen verstärkenden Lernen. Im Gegensatz dazu ähnelt die Verwendung des Diffusionsmodells als Richtlinie eher dem modellfreien verstärkenden Lernen. Diffusion-QL kombiniert zunächst die Diffusionsstrategie mit dem Q-Learning-Framework. Da Diffusionsmodelle weitaus besser in der Lage sind, multimodale Verteilungen anzupassen als herkömmliche Modelle, funktionieren Diffusionsstrategien gut in multimodalen Datensätzen, die von mehreren Verhaltensstrategien erfasst wurden. Die Diffusionsstrategie ist die gleiche wie die gewöhnliche Strategie, wobei normalerweise der Zustand als Bedingung für die Generierung von Aktionen verwendet wird und gleichzeitig die Maximierung der Funktion Q (s,a) in Betracht gezogen wird. Methoden wie Diffusion-QL fügen beim Training des Diffusionsmodells einen gewichteten Wertfunktionsterm hinzu, während CEP ein gewichtetes Regressionsziel aus Energieperspektive erstellt und die Wertfunktion als Faktor verwendet, um die vom Diffusionsmodell gelernte Aktionsverteilung anzupassen.

Datensynthese

Das Diffusionsmodell kann als Datensynthesizer verwendet werden, um das Problem spärlicher Daten beim Offline- oder Online-Verstärkungslernen zu lindern. Herkömmliche Methoden zur Datenverbesserung durch Reinforcement Learning können die Originaldaten normalerweise nur geringfügig stören, während die leistungsstarken Verteilungsanpassungsfähigkeiten des Diffusionsmodells es ermöglichen, die Verteilung des gesamten Datensatzes direkt zu lernen und dann neue, qualitativ hochwertige Daten abzutasten.

Andere Arten

Zusätzlich zu den oben genannten Kategorien gibt es auch einige verstreute Arbeiten, die Diffusionsmodelle auf andere Weise nutzen. DVF schätzt beispielsweise eine Wertfunktion mithilfe eines Diffusionsmodells. LDCQ kodiert zunächst die Flugbahn in den latenten Raum und wendet dann das Diffusionsmodell auf den latenten Raum an. PolyGRAD verwendet ein Diffusionsmodell, um die Lernumgebung dynamisch zu übertragen und so die Interaktion von Richtlinien und Modellen zu ermöglichen, um die Effizienz des politischen Lernens zu verbessern.

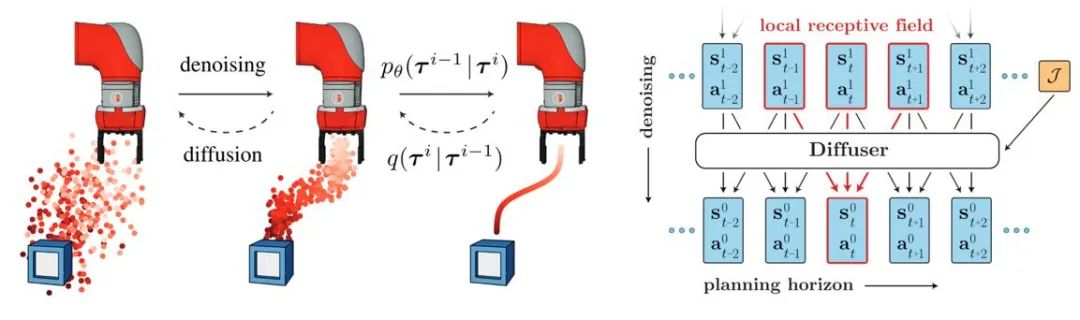

... Fähigkeit. Diffuser schlug zunächst einen Algorithmus zur Trajektoriengenerierung mit hoher Belohnung vor, der auf Klassifiziererführung basierte, und inspirierte viele weitere Arbeiten. Gleichzeitig kann das Diffusionsmodell auch in Multitasking- und Multiagenten-Lernszenarien zur Verstärkung angewendet werden. Abbildung 3: Schematische Darstellung des Prozesses und Modells zur Generierung der Diffusor-Trajektorie Online-Lernen zur Verstärkung. DIPO beschriftet beispielsweise Aktionsdaten neu und verwendet Diffusionsmodelltraining, um die Instabilität wertorientierten Trainings zu vermeiden. CPQL hat bestätigt, dass das einstufige Sampling-Diffusionsmodell als Strategie die Erforschung und Nutzung während der Interaktion ausgleichen kann.Imitationslernen

Imitationslernen rekonstruiert Expertenverhalten, indem es aus Expertendemonstrationsdaten lernt. Die Anwendung des Diffusionsmodells trägt dazu bei, die Fähigkeiten zur politischen Repräsentation zu verbessern und vielfältige Aufgabenkompetenzen zu erlernen. Im Bereich der Robotersteuerung hat die Forschung herausgefunden, dass Diffusionsmodelle geschlossene Aktionssequenzen vorhersagen und gleichzeitig die zeitliche Stabilität aufrechterhalten können. Diffusion Policy verwendet ein Diffusionsmodell der Bildeingabe, um Roboteraktionssequenzen zu generieren. Experimente zeigen, dass das Diffusionsmodell effektive Aktionssequenzen mit geschlossenem Regelkreis erzeugen und gleichzeitig die Konsistenz des Timings gewährleisten kann. Abbildung 4: Schematische Darstellung des Modells der Diffusionspolitik . Durch Diffusionsmodelle generierte Aktionsdaten oder Videodaten werden zum Aufbau von Simulationssimulatoren oder zum Training nachgelagerter Entscheidungsmodelle verwendet. UniPi trainiert ein Diffusionsmodell zur Videoerzeugung als allgemeine Strategie und erreicht eine körperübergreifende Robotersteuerung durch Zugriff auf verschiedene inverse Dynamikmodelle, um zugrunde liegende Steuerbefehle zu erhalten.

Datenverbesserung

Das Diffusionsmodell kann auch direkt an die ursprüngliche Datenverteilung angepasst werden und bietet eine Vielzahl dynamisch erweiterter Daten unter Beibehaltung der Authentizität. Beispielsweise generieren SynthER und MTDiff-s über das Diffusionsmodell vollständige Umgebungsübertragungsinformationen der Trainingsaufgabe und wenden diese auf Richtlinienverbesserungen an. Die Ergebnisse zeigen, dass die Vielfalt und Genauigkeit der generierten Daten besser ist als bei historischen Methoden.

... Hauptsächlich Forschung Diffusionsmodelle werden verwendet, um die Einschränkungen von Agenten und Erfahrungswiedergabepools zu überwinden, und es gibt relativ wenige Studien zur Verwendung von Diffusionsmodellen zur Verbesserung von Simulationsumgebungen. Gen2Sim nutzt das Vincentian-Graph-Diffusionsmodell, um verschiedene manipulierbare Objekte in der Simulationsumgebung zu generieren und so die Generalisierungsfähigkeit der Präzisionsoperationen des Roboters zu verbessern. Diffusionsmodelle haben auch das Potenzial, Zustandsübergangsfunktionen, Belohnungsfunktionen oder gegnerisches Verhalten in Multi-Agenten-Interaktionen in einer Simulationsumgebung zu generieren.

Sicherheitseinschränkungen hinzufügen

Durch die Verwendung von Sicherheitsbeschränkungen als Stichprobenbedingungen des Modells können Agenten, die auf dem Diffusionsmodell basieren, Entscheidungen treffen, die bestimmte Einschränkungen erfüllen. Durch das geführte Sampling des Diffusionsmodells können durch das Erlernen zusätzlicher Klassifikatoren kontinuierlich neue Sicherheitsbeschränkungen hinzugefügt werden, während die Parameter des ursprünglichen Modells unverändert bleiben, wodurch zusätzlicher Trainingsaufwand eingespart wird.

Retrieval-Enhanced-Generierung

Retrieval-Enhanced-Generierungstechnologie kann die Modellfunktionen durch Zugriff auf externe Datensätze verbessern und wird häufig in großen Sprachmodellen verwendet. Die Leistung diffusionsbasierter Entscheidungsmodelle in diesen Zuständen kann auch verbessert werden, indem Trajektorien im Zusammenhang mit dem aktuellen Zustand des Agenten abgerufen und in das Modell eingespeist werden. Wenn der Abrufdatensatz ständig aktualisiert wird, ist es möglich, dass der Agent neue Verhaltensweisen zeigt, ohne dass er neu trainiert werden muss.

Kombinieren Sie mehrere Fähigkeiten.

In Kombination mit oder ohne Klassifikatorführung kann das Diffusionsmodell mehrere einfache Fähigkeiten kombinieren, um komplexe Aufgaben zu erledigen. Frühe Ergebnisse des Offline-Lernens zur Verstärkung deuten auch darauf hin, dass Diffusionsmodelle Wissen zwischen verschiedenen Fähigkeiten teilen können, was es ermöglicht, durch die Kombination verschiedener Fähigkeiten einen Zero-Shot-Transfer oder kontinuierliches Lernen zu erreichen.

Tabelle

Abbildung 7: Zusammenfassung und Klassifizierungstabelle verwandter Arbeiten.

Das obige ist der detaillierte Inhalt vonWie baut das Diffusionsmodell eine neue Generation von Entscheidungsträgern auf? Über die Autoregression hinaus können Sie gleichzeitig lange Sequenzplanungspfade generieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1379

1379

52

52

Einführung in die Verwendung des Joiplay-Simulators

May 04, 2024 pm 06:40 PM

Einführung in die Verwendung des Joiplay-Simulators

May 04, 2024 pm 06:40 PM

Der Jojplay-Simulator ist ein sehr einfach zu bedienender Mobiltelefonsimulator. Er unterstützt Computerspiele und kann auf Mobiltelefonen ausgeführt werden. Einige Spieler wissen nicht, wie man ihn verwendet wie man es benutzt. So verwenden Sie den Joiplay-Simulator 1. Zuerst müssen Sie den Joiplay-Body und das RPGM-Plug-in herunterladen. Am besten installieren Sie sie in der Reihenfolge Body – Plug-in. Das APK-Paket erhalten Sie in der Joiplay-Leiste. Klicken Sie hier, um >>> zu erhalten. 2. Nachdem Android fertig ist, können Sie in der unteren linken Ecke Spiele hinzufügen. 3. Geben Sie den Namen nach und nach ein und drücken Sie bei der ausführbaren Datei auf „Auswählen“, um die Datei „game.exe“ des Spiels auszuwählen. 4. Das Symbol kann leer bleiben oder Sie können Ihr Lieblingsbild auswählen.

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Leitfaden für den Lebensneustart-Simulator

May 07, 2024 pm 05:28 PM

Leitfaden für den Lebensneustart-Simulator

May 07, 2024 pm 05:28 PM

Life Restart Simulator ist ein sehr interessantes Simulationsspiel. Es gibt viele Möglichkeiten, das Spiel zu spielen. Schauen Sie sich das Spiel an Strategien gibt es? Life Restart Simulator-Anleitung Anleitung Funktionen von Life Restart Simulator Dies ist ein sehr kreatives Spiel, in dem Spieler nach ihren eigenen Vorstellungen spielen können. Es gibt jeden Tag viele Aufgaben zu erledigen und Sie können ein neues Leben in dieser virtuellen Welt genießen. Es gibt viele Lieder im Spiel und alle möglichen Leben warten darauf, von Ihnen erlebt zu werden. Spielinhalt des Life Restart Simulators Talent-Zeichnungskarten: Talent: Sie müssen die geheimnisvolle kleine Kiste auswählen, um ein Unsterblicher zu werden. Um ein Absterben auf halbem Weg zu vermeiden, sind verschiedene kleine Kapseln erhältlich. Cthulhu kann wählen

Einführung in die Schriftarteinstellungsmethode des Joiplay-Simulators

May 09, 2024 am 08:31 AM

Einführung in die Schriftarteinstellungsmethode des Joiplay-Simulators

May 09, 2024 am 08:31 AM

Der Jojplay-Simulator kann die Schriftarten des Spiels tatsächlich anpassen und das Problem fehlender Zeichen und umrahmter Zeichen im Text lösen. Ich vermute, dass viele Spieler immer noch nicht wissen, wie man ihn bedient Schriftart des Jojplay-Simulators vorstellen. So legen Sie die Schriftart des Joiplay-Simulators fest: 1. Öffnen Sie zunächst den Joiplay-Simulator, klicken Sie auf die Einstellungen (drei Punkte) in der oberen rechten Ecke und suchen Sie ihn. 2. Klicken Sie in der Spalte „RPGMSettings“ auf die benutzerdefinierte Schriftart „CustomFont“ in der dritten Zeile, um sie auszuwählen. 3. Wählen Sie die Schriftartdatei aus und klicken Sie auf „OK“. Klicken Sie nicht auf das Symbol „Speichern“ in der unteren rechten Ecke, da sonst die Standardeinstellungen wiederhergestellt werden. 4. Empfehlen Sie Founder und Quasi-Yuan Simplified Chinese (bereits in den Ordnern der Spiele Fuxing und Rebirth). joi

Wie lösche ich die Donner- und Blitzsimulatoranwendung? -Wie lösche ich Anwendungen im Thunderbolt Simulator?

May 08, 2024 pm 02:40 PM

Wie lösche ich die Donner- und Blitzsimulatoranwendung? -Wie lösche ich Anwendungen im Thunderbolt Simulator?

May 08, 2024 pm 02:40 PM

Die offizielle Version von Thunderbolt Simulator ist ein sehr professionelles Android-Emulator-Tool. Wie lösche ich also die Donner- und Blitzsimulatoranwendung? Wie lösche ich Anwendungen im Thunderbolt Simulator? Lassen Sie sich vom Herausgeber unten die Antwort geben! Wie lösche ich die Donner- und Blitz-Simulator-Anwendung? 1. Klicken und halten Sie das Symbol der App, die Sie löschen möchten. 2. Warten Sie eine Weile, bis die Option zum Deinstallieren oder Löschen der App angezeigt wird. 3. Ziehen Sie die App auf die Deinstallationsoption. 4. Klicken Sie im daraufhin angezeigten Bestätigungsfenster auf OK, um den Löschvorgang der Anwendung abzuschließen.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Kürzlich wurde die Militärwelt von der Nachricht überwältigt: US-Militärkampfflugzeuge können jetzt mithilfe von KI vollautomatische Luftkämpfe absolvieren. Ja, erst kürzlich wurde der KI-Kampfjet des US-Militärs zum ersten Mal der Öffentlichkeit zugänglich gemacht und sein Geheimnis gelüftet. Der vollständige Name dieses Jägers lautet „Variable Stability Simulator Test Aircraft“ (VISTA). Er wurde vom Minister der US-Luftwaffe persönlich geflogen, um einen Eins-gegen-eins-Luftkampf zu simulieren. Am 2. Mai startete US-Luftwaffenminister Frank Kendall mit einer X-62AVISTA auf der Edwards Air Force Base. Beachten Sie, dass während des einstündigen Fluges alle Flugaktionen autonom von der KI durchgeführt wurden! Kendall sagte: „In den letzten Jahrzehnten haben wir über das unbegrenzte Potenzial des autonomen Luft-Luft-Kampfes nachgedacht, aber es schien immer unerreichbar.“ Nun jedoch,