Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie kann man der KI viel Physikwissen vermitteln? Die Teams des EIT und der Peking-Universität schlugen das Konzept der „Bedeutung von Regeln' vor.

Wie kann man der KI viel Physikwissen vermitteln? Die Teams des EIT und der Peking-Universität schlugen das Konzept der „Bedeutung von Regeln' vor.

Wie kann man der KI viel Physikwissen vermitteln? Die Teams des EIT und der Peking-Universität schlugen das Konzept der „Bedeutung von Regeln' vor.

Herausgeber |. ScienceAI

Deep-Learning-Modelle haben aufgrund ihrer Fähigkeit, latente Beziehungen aus riesigen Datenmengen zu lernen, einen tiefgreifenden Einfluss auf den Bereich der wissenschaftlichen Forschung gehabt. Modelle, die ausschließlich auf Daten basieren, offenbaren jedoch nach und nach ihre Grenzen, einschließlich einer übermäßigen Abhängigkeit von Daten, Einschränkungen bei den Generalisierungsfähigkeiten und Konsistenzproblemen mit der realen physischen Welt. Diese Probleme veranlassen Forscher dazu, besser interpretierbare und erklärbare Modelle zu erforschen, um die Mängel datengesteuerter Modelle auszugleichen. Daher ist die Kombination von Domänenwissen und datengesteuerten Methoden zur Erstellung von Modellen mit besserer Interpretierbarkeit und Generalisierungsfähigkeit zu einer wichtigen Richtung in der aktuellen wissenschaftlichen Forschung geworden. Diese Art von

Zum Beispiel wird das von der amerikanischen Firma OpenAI entwickelte Text-to-Video-Modell Sora für seine hervorragenden Bilderzeugungsfähigkeiten hoch gelobt und gilt als wichtiger Fortschritt auf dem Gebiet der künstlichen Intelligenz. Obwohl Sora in der Lage ist, realistische Bilder und Videos zu erzeugen, hat er immer noch einige Herausforderungen im Umgang mit den Gesetzen der Physik, wie der Schwerkraft und der Fragmentierung von Objekten. Während Sora bei der Simulation realer Szenarien erhebliche Fortschritte gemacht hat, gibt es noch Raum für Verbesserungen beim Verständnis und der genauen Simulation physikalischer Gesetze. Die Entwicklung der KI-Technologie erfordert weiterhin kontinuierliche Anstrengungen zur Verbesserung der Vollständigkeit und Genauigkeit von Modellen, um sie besser an verschiedene Situationen in der realen Welt anzupassen.

Eine mögliche Lösung dieses Problems besteht darin, menschliches Wissen in Deep-Learning-Modelle einzubeziehen. Durch die Kombination von Vorwissen und Daten kann die Generalisierungsfähigkeit des Modells verbessert werden, was zu einem Modell für „informiertes maschinelles Lernen“ führt, das physikalische Gesetze verstehen kann. Dieser Ansatz soll die Leistung und Genauigkeit des Modells verbessern und es so in die Lage versetzen, komplexe Probleme in der realen Welt besser zu bewältigen. Durch die Integration der Erfahrungen und Erkenntnisse menschlicher Experten in maschinelle Lernalgorithmen können wir intelligentere und effizientere Systeme aufbauen und so die Entwicklung und Anwendung der Technologie der künstlichen Intelligenz fördern.

Derzeit mangelt es noch an einer tiefgreifenden Erforschung des genauen Werts von Wissen im Deep Learning. Es besteht ein dringendes Problem darin, zu bestimmen, welches Vorwissen effektiv in das Modell des „Vorlernens“ integriert werden kann. Gleichzeitig kann die blinde Integration mehrerer Regeln zum Scheitern des Modells führen, was ebenfalls Aufmerksamkeit erfordert. Diese Einschränkungen stellen die eingehende Untersuchung der Beziehung zwischen Daten und Wissen vor Herausforderungen.

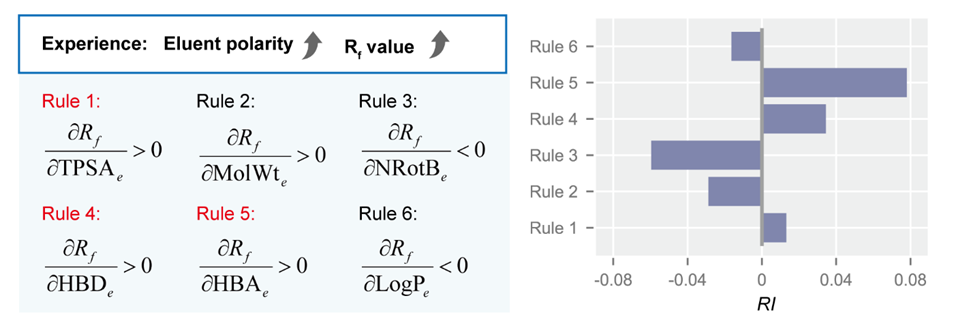

Als Reaktion auf dieses Problem schlug das Forschungsteam des Eastern Institute of Technology (EIT) und der Peking-Universität das Konzept der „Regelwichtigkeit“ vor und entwickelte ein Framework, das den Beitrag jeder Regel zur Vorhersagegenauigkeit des Modells genau berechnen kann. Dieses Framework deckt nicht nur die komplexe Wechselwirkung zwischen Daten und Wissen auf und bietet theoretische Anleitungen für die Einbettung von Wissen, sondern trägt auch dazu bei, den Einfluss von Wissen und Daten während des Trainingsprozesses auszugleichen. Darüber hinaus kann diese Methode auch zur Identifizierung unangemessener A-priori-Regeln eingesetzt werden, was breite Perspektiven für Forschung und Anwendung in interdisziplinären Bereichen bietet.

Diese Forschung mit dem Titel „Prior Knowledge's Impact on Deep Learning“ wurde am 8. März 2024 in der interdisziplinären Zeitschrift „Nexus“ bei Cell Press veröffentlicht. Die Forschung erhielt Aufmerksamkeit von AAAS (American Association for the Advancement of Science) und EurekAlert!

Wenn Sie Kindern Rätsel beibringen, können Sie sie entweder die Antworten durch Ausprobieren herausfinden lassen oder sie mit einigen grundlegenden Regeln und Techniken anleiten. Ebenso kann die Einbeziehung von Regeln und Techniken – etwa den Gesetzen der Physik – in das KI-Training dieses realistischer und effizienter machen. Allerdings war es für Forscher schon immer ein schwieriges Problem, den Wert dieser Regeln in der künstlichen Intelligenz einzuschätzen.

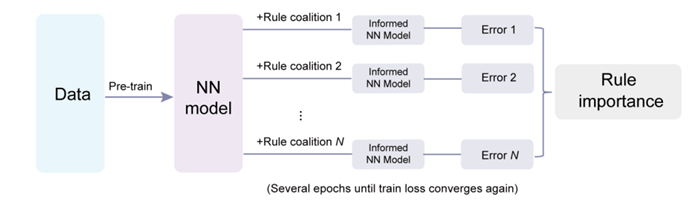

Angesichts der großen Vielfalt an Vorwissen ist die Integration von Vorwissen in Deep-Learning-Modelle eine komplexe Optimierungsaufgabe mit mehreren Zielen. Das Forschungsteam schlägt auf innovative Weise einen Rahmen vor, um die Rolle verschiedener Vorkenntnisse bei der Verbesserung von Deep-Learning-Modellen zu quantifizieren. Sie betrachten diesen Prozess als ein Spiel voller Kooperation und Wettbewerb und definieren die Bedeutung von Regeln, indem sie ihren marginalen Beitrag zu Modellvorhersagen bewerten. Zunächst werden alle möglichen Regelkombinationen (d. h. „Koalitionen“) generiert, für jede Kombination ein Modell erstellt und der mittlere quadratische Fehler berechnet.

Um die Rechenkosten zu senken, haben sie einen effizienten, auf Störungen basierenden Algorithmus eingeführt: Trainieren Sie zunächst ein vollständig datenbasiertes neuronales Netzwerk als Basismodell, fügen Sie dann jede Regelkombination einzeln für zusätzliches Training hinzu und bewerten Sie schließlich die Modellleistung auf den Testdaten. Durch den Vergleich der Leistung des Modells über alle Koalitionen mit und ohne Regel kann der marginale Beitrag dieser Regel und damit ihre Bedeutung berechnet werden.

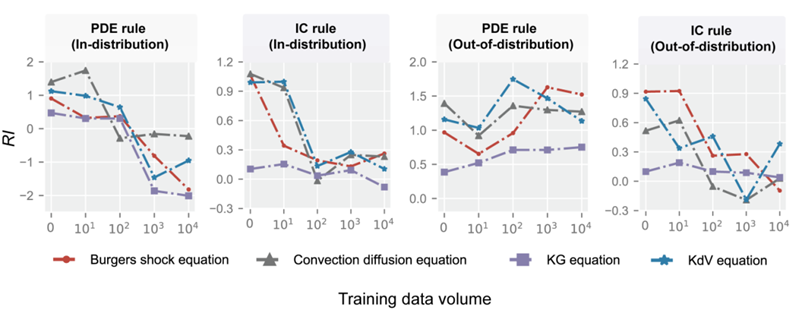

Anhand von Beispielen der Strömungsmechanik untersuchten Forscher die komplexe Beziehung zwischen Daten und Regeln. Sie fanden heraus, dass Daten und vorherige Regeln bei verschiedenen Aufgaben völlig unterschiedliche Rollen spielten. Wenn die Verteilung von Testdaten und Trainingsdaten ähnlich ist (d. h. in der Verteilung), schwächt die Zunahme des Datenvolumens die Wirkung der Regeln.

Wenn jedoch die Verteilungsähnlichkeit zwischen den Testdaten und den Trainingsdaten gering ist (d. h. außerhalb der Verteilung), wird die Bedeutung globaler Regeln hervorgehoben, während der Einfluss lokaler Regeln abgeschwächt wird. Der Unterschied zwischen diesen beiden Arten von Regeln besteht darin, dass globale Regeln (z. B. maßgebende Gleichungen) den gesamten Bereich betreffen, während lokale Regeln (z. B. Randbedingungen) nur auf bestimmte Bereiche wirken.

Das Forschungsteam fand durch numerische Experimente heraus, dass es drei interaktive Effekte zwischen Regeln bei der Wissenseinbettung gibt: Abhängigkeitseffekt und Synergieeffekt und Substitutionseffekt.

Abhängigkeitseffekt bedeutet, dass einige Regeln auf andere Regeln angewiesen sind, um wirksam zu sein. Der Synergieeffekt zeigt, dass die Wirkung mehrerer Regeln die Summe ihrer unabhängigen Effekte übersteigt Daten oder andere Regeln.

Diese drei Effekte treten gleichzeitig auf und werden von der Datenmenge beeinflusst. Durch die Berechnung der Regelwichtigkeit können diese Effekte klar nachgewiesen werden und liefern wichtige Hinweise für die Wissenseinbettung.

Auf der Anwendungsebene versuchte das Forschungsteam, ein Kernproblem im Prozess der Wissenseinbettung zu lösen: Wie lässt sich die Rolle von Daten und Regeln ausbalancieren, um die Einbettungseffizienz zu verbessern und unangemessenes Vorwissen auszusortieren? Während des Trainingsprozesses des Modells schlug das Team eine Strategie zur dynamischen Anpassung der Gewichtung der Regeln vor.

Konkret nimmt mit zunehmenden Trainingsiterationsschritten die Gewichtung der Regeln mit positiver Wichtigkeit allmählich zu, während die Gewichtung der Regeln mit negativer Wichtigkeit abnimmt. Diese Strategie kann die Aufmerksamkeit des Modells entsprechend den Anforderungen des Optimierungsprozesses in Echtzeit an verschiedene Regeln anpassen und so eine effizientere und genauere Wissenseinbettung erreichen.

Darüber hinaus kann die Vermittlung der Gesetze der Physik an KI-Modelle dazu führen, dass diese „für die reale Welt relevanter werden und somit eine größere Rolle in Wissenschaft und Technik spielen“. Daher bietet dieses Framework ein breites Spektrum praktischer Anwendungen in den Bereichen Ingenieurwesen, Physik und Chemie. Die Forscher optimierten nicht nur das maschinelle Lernmodell zur Lösung multivariater Gleichungen, sondern identifizierten auch genau Regeln, die die Leistung des Vorhersagemodells für die Dünnschichtchromatographieanalyse verbessern.

Experimentelle Ergebnisse zeigen, dass durch die Einbeziehung dieser effektiven Regeln die Leistung des Modells deutlich verbessert wird und der mittlere quadratische Fehler im Testdatensatz von 0,052 auf 0,036 reduziert wird (eine Reduzierung um 30,8 %). Das bedeutet, dass das Framework empirische Erkenntnisse in strukturiertes Wissen umwandeln und so die Modellleistung deutlich verbessern kann.

Im Allgemeinen trägt die genaue Einschätzung des Werts von Wissen dazu bei, realistischere KI-Modelle zu erstellen, die Sicherheit und Zuverlässigkeit zu verbessern, und ist von großer Bedeutung für die Entwicklung von Deep Learning.

Als Nächstes plant das Forschungsteam, sein Framework zu einem Plug-in-Tool zu entwickeln, das von Entwicklern künstlicher Intelligenz verwendet werden kann. Ihr ultimatives Ziel ist es, Modelle zu entwickeln, die Wissen und Regeln direkt aus Daten extrahieren und sich dann selbst verbessern können, wodurch ein geschlossenes System von der Wissensentdeckung bis zur Wissenseinbettung entsteht, das das Modell zu einem echten Wissenschaftler der künstlichen Intelligenz macht.

Link zum Papier: https://www.cell.com/nexus/fulltext/S2950-1601(24)00001-9

Das obige ist der detaillierte Inhalt vonWie kann man der KI viel Physikwissen vermitteln? Die Teams des EIT und der Peking-Universität schlugen das Konzept der „Bedeutung von Regeln' vor.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1392

1392

52

52

„Defect Spectrum' durchbricht die Grenzen der herkömmlichen Fehlererkennung und erreicht erstmals eine hochpräzise und umfassende semantische Fehlererkennung in der Industrie.

Jul 26, 2024 pm 05:38 PM

„Defect Spectrum' durchbricht die Grenzen der herkömmlichen Fehlererkennung und erreicht erstmals eine hochpräzise und umfassende semantische Fehlererkennung in der Industrie.

Jul 26, 2024 pm 05:38 PM

In der modernen Fertigung ist die genaue Fehlererkennung nicht nur der Schlüssel zur Sicherstellung der Produktqualität, sondern auch der Kern für die Verbesserung der Produktionseffizienz. Allerdings mangelt es vorhandenen Datensätzen zur Fehlererkennung häufig an der Genauigkeit und dem semantischen Reichtum, die für praktische Anwendungen erforderlich sind, was dazu führt, dass Modelle bestimmte Fehlerkategorien oder -orte nicht identifizieren können. Um dieses Problem zu lösen, hat ein Spitzenforschungsteam bestehend aus der Hong Kong University of Science and Technology Guangzhou und Simou Technology innovativ den „DefectSpectrum“-Datensatz entwickelt, der eine detaillierte und semantisch reichhaltige groß angelegte Annotation von Industriedefekten ermöglicht. Wie in Tabelle 1 gezeigt, bietet der Datensatz „DefectSpectrum“ im Vergleich zu anderen Industriedatensätzen die meisten Fehleranmerkungen (5438 Fehlerproben) und die detaillierteste Fehlerklassifizierung (125 Fehlerkategorien).

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Die offene LLM-Community ist eine Ära, in der hundert Blumen blühen und konkurrieren. Sie können Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 und viele andere sehen hervorragende Darsteller. Allerdings weisen offene Modelle im Vergleich zu den proprietären Großmodellen GPT-4-Turbo in vielen Bereichen noch erhebliche Lücken auf. Zusätzlich zu allgemeinen Modellen wurden einige offene Modelle entwickelt, die sich auf Schlüsselbereiche spezialisieren, wie etwa DeepSeek-Coder-V2 für Programmierung und Mathematik und InternVL für visuelle Sprachaufgaben.

Training mit Millionen von Kristalldaten zur Lösung kristallographischer Phasenprobleme, die Deep-Learning-Methode PhAI wird in Science veröffentlicht

Aug 08, 2024 pm 09:22 PM

Training mit Millionen von Kristalldaten zur Lösung kristallographischer Phasenprobleme, die Deep-Learning-Methode PhAI wird in Science veröffentlicht

Aug 08, 2024 pm 09:22 PM

Herausgeber |KX Bis heute sind die durch die Kristallographie ermittelten Strukturdetails und Präzision, von einfachen Metallen bis hin zu großen Membranproteinen, mit keiner anderen Methode zu erreichen. Die größte Herausforderung, das sogenannte Phasenproblem, bleibt jedoch die Gewinnung von Phaseninformationen aus experimentell bestimmten Amplituden. Forscher der Universität Kopenhagen in Dänemark haben eine Deep-Learning-Methode namens PhAI entwickelt, um Kristallphasenprobleme zu lösen. Ein Deep-Learning-Neuronales Netzwerk, das mithilfe von Millionen künstlicher Kristallstrukturen und den entsprechenden synthetischen Beugungsdaten trainiert wird, kann genaue Elektronendichtekarten erstellen. Die Studie zeigt, dass diese Deep-Learning-basierte Ab-initio-Strukturlösungsmethode das Phasenproblem mit einer Auflösung von nur 2 Angström lösen kann, was nur 10 bis 20 % der bei atomarer Auflösung verfügbaren Daten im Vergleich zur herkömmlichen Ab-initio-Berechnung entspricht

Google AI gewann die Silbermedaille der IMO Mathematical Olympiad, das mathematische Argumentationsmodell AlphaProof wurde eingeführt und Reinforcement Learning ist zurück

Jul 26, 2024 pm 02:40 PM

Google AI gewann die Silbermedaille der IMO Mathematical Olympiad, das mathematische Argumentationsmodell AlphaProof wurde eingeführt und Reinforcement Learning ist zurück

Jul 26, 2024 pm 02:40 PM

Für KI ist die Mathematikolympiade kein Problem mehr. Am Donnerstag hat die künstliche Intelligenz von Google DeepMind eine Meisterleistung vollbracht: Sie nutzte KI, um meiner Meinung nach die eigentliche Frage der diesjährigen Internationalen Mathematikolympiade zu lösen, und war nur einen Schritt davon entfernt, die Goldmedaille zu gewinnen. Der IMO-Wettbewerb, der gerade letzte Woche zu Ende ging, hatte sechs Fragen zu Algebra, Kombinatorik, Geometrie und Zahlentheorie. Das von Google vorgeschlagene hybride KI-System beantwortete vier Fragen richtig und erzielte 28 Punkte und erreichte damit die Silbermedaillenstufe. Anfang dieses Monats hatte der UCLA-Professor Terence Tao gerade die KI-Mathematische Olympiade (AIMO Progress Award) mit einem Millionenpreis gefördert. Unerwarteterweise hatte sich das Niveau der KI-Problemlösung vor Juli auf dieses Niveau verbessert. Beantworten Sie die Fragen meiner Meinung nach gleichzeitig. Am schwierigsten ist es meiner Meinung nach, da sie die längste Geschichte, den größten Umfang und die negativsten Fragen haben

Der Standpunkt der Natur: Die Erprobung künstlicher Intelligenz in der Medizin ist im Chaos. Was ist zu tun?

Aug 22, 2024 pm 04:37 PM

Der Standpunkt der Natur: Die Erprobung künstlicher Intelligenz in der Medizin ist im Chaos. Was ist zu tun?

Aug 22, 2024 pm 04:37 PM

Herausgeber | ScienceAI Basierend auf begrenzten klinischen Daten wurden Hunderte medizinischer Algorithmen genehmigt. Wissenschaftler diskutieren darüber, wer die Werkzeuge testen soll und wie dies am besten geschieht. Devin Singh wurde Zeuge, wie ein pädiatrischer Patient in der Notaufnahme einen Herzstillstand erlitt, während er lange auf eine Behandlung wartete, was ihn dazu veranlasste, den Einsatz von KI zu erforschen, um Wartezeiten zu verkürzen. Mithilfe von Triage-Daten aus den Notaufnahmen von SickKids erstellten Singh und Kollegen eine Reihe von KI-Modellen, um mögliche Diagnosen zu stellen und Tests zu empfehlen. Eine Studie zeigte, dass diese Modelle die Zahl der Arztbesuche um 22,3 % verkürzen können und die Verarbeitung der Ergebnisse pro Patient, der einen medizinischen Test benötigt, um fast drei Stunden beschleunigt. Der Erfolg von Algorithmen der künstlichen Intelligenz in der Forschung bestätigt dies jedoch nur

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

PRO |. Warum verdienen große Modelle, die auf MoE basieren, mehr Aufmerksamkeit?

Aug 07, 2024 pm 07:08 PM

PRO |. Warum verdienen große Modelle, die auf MoE basieren, mehr Aufmerksamkeit?

Aug 07, 2024 pm 07:08 PM

Im Jahr 2023 entwickeln sich fast alle Bereiche der KI in beispielloser Geschwindigkeit weiter. Gleichzeitig verschiebt die KI ständig die technologischen Grenzen wichtiger Bereiche wie der verkörperten Intelligenz und des autonomen Fahrens. Wird der Status von Transformer als Mainstream-Architektur großer KI-Modelle durch den multimodalen Trend erschüttert? Warum ist die Erforschung großer Modelle auf Basis der MoE-Architektur (Mixture of Experts) zu einem neuen Trend in der Branche geworden? Können Large Vision Models (LVM) ein neuer Durchbruch im allgemeinen Sehvermögen sein? ...Aus dem PRO-Mitglieder-Newsletter 2023 dieser Website, der in den letzten sechs Monaten veröffentlicht wurde, haben wir 10 spezielle Interpretationen ausgewählt, die eine detaillierte Analyse der technologischen Trends und industriellen Veränderungen in den oben genannten Bereichen bieten, um Ihnen dabei zu helfen, Ihre Ziele in der Zukunft zu erreichen Jahr vorbereitet sein. Diese Interpretation stammt aus Week50 2023

Die Genauigkeitsrate erreicht 60,8 %. Das auf Transformer basierende Modell zur Vorhersage der chemischen Retrosynthese wurde in der Unterzeitschrift „Nature' veröffentlicht

Aug 06, 2024 pm 07:34 PM

Die Genauigkeitsrate erreicht 60,8 %. Das auf Transformer basierende Modell zur Vorhersage der chemischen Retrosynthese wurde in der Unterzeitschrift „Nature' veröffentlicht

Aug 06, 2024 pm 07:34 PM

Herausgeber | KX-Retrosynthese ist eine entscheidende Aufgabe in der Arzneimittelforschung und organischen Synthese, und KI wird zunehmend eingesetzt, um den Prozess zu beschleunigen. Bestehende KI-Methoden weisen eine unbefriedigende Leistung und eine begrenzte Vielfalt auf. In der Praxis verursachen chemische Reaktionen häufig lokale molekulare Veränderungen mit erheblichen Überschneidungen zwischen Reaktanten und Produkten. Davon inspiriert schlug das Team von Hou Tingjun an der Zhejiang-Universität vor, die einstufige retrosynthetische Vorhersage als eine Aufgabe zur Bearbeitung molekularer Ketten neu zu definieren und dabei die Zielmolekülkette iterativ zu verfeinern, um Vorläuferverbindungen zu erzeugen. Außerdem wird ein bearbeitungsbasiertes retrosynthetisches Modell EditRetro vorgeschlagen, mit dem qualitativ hochwertige und vielfältige Vorhersagen erzielt werden können. Umfangreiche Experimente zeigen, dass das Modell beim Standard-Benchmark-Datensatz USPTO-50 K eine hervorragende Leistung mit einer Top-1-Genauigkeit von 60,8 % erzielt.