curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_386.rpmsudo rpm -ivh k8sgpt_386.rpm

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_amd64.rpmsudo rpm -ivh -i k8sgpt_amd64.rpm

Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die Fehlerbehebung ist zu nervig. Probieren Sie die Superleistung von GPT aus

Die Fehlerbehebung ist zu nervig. Probieren Sie die Superleistung von GPT aus

Die Fehlerbehebung ist zu nervig. Probieren Sie die Superleistung von GPT aus

Bei der Verwendung von Kubernetes treten zwangsläufig Probleme im Cluster auf, die debuggt und repariert werden müssen, um sicherzustellen, dass Pods und Dienste normal ausgeführt werden können. Unabhängig davon, ob Sie Anfänger oder Experte im Umgang mit komplexen Umgebungen sind, ist das Debuggen von Prozessen innerhalb eines Clusters nicht immer einfach und kann zeitaufwändig und mühsam werden. In Kubernetes liegt der Schlüssel zur Problemdiagnose im Verständnis der Beziehungen zwischen Komponenten und ihrer Interaktion untereinander. Protokollierungs- und Überwachungstools sind der Schlüssel zur Problemlösung und können Ihnen dabei helfen, Fehler schnell zu lokalisieren und zu beheben. Darüber hinaus ist ein umfassendes Verständnis der Kubernetes-Ressourcenkonfiguration und des Planungsmechanismus ein wichtiger Bestandteil der Problemlösung. Wenn Sie auf ein Problem stoßen, stellen Sie zunächst sicher, dass Ihr Cluster und Ihre Anwendung richtig konfiguriert sind. Suchen Sie dann die Ursache des Problems, indem Sie Protokolle, Überwachungsindikatoren und Ereignisse anzeigen. Manchmal liegt das Problem möglicherweise an der Netzwerkkonfiguration, an Speicherproblemen oder an Fehlern in der Anwendung selbst, die sorgfältig geprüft werden müssen. In einer Cloud-nativen Umgebung stehen verschiedene Debugging-Lösungen zur Auswahl, mit denen Sie problemlos auf Informationen innerhalb der Anwendung zugreifen können Cluster. Es ist jedoch wichtig zu beachten, dass die meisten Lösungen keine vollständigen Kontextinformationen bereitstellen.

In diesem Blogbeitrag stelle ich Ihnen K8sGPT vor, ein Projekt, das darauf abzielt, die Superkräfte von Kubernetes für jedermann verfügbar zu machen.

K8sGPT-Anwendungsszenarien Übersicht

Übersicht

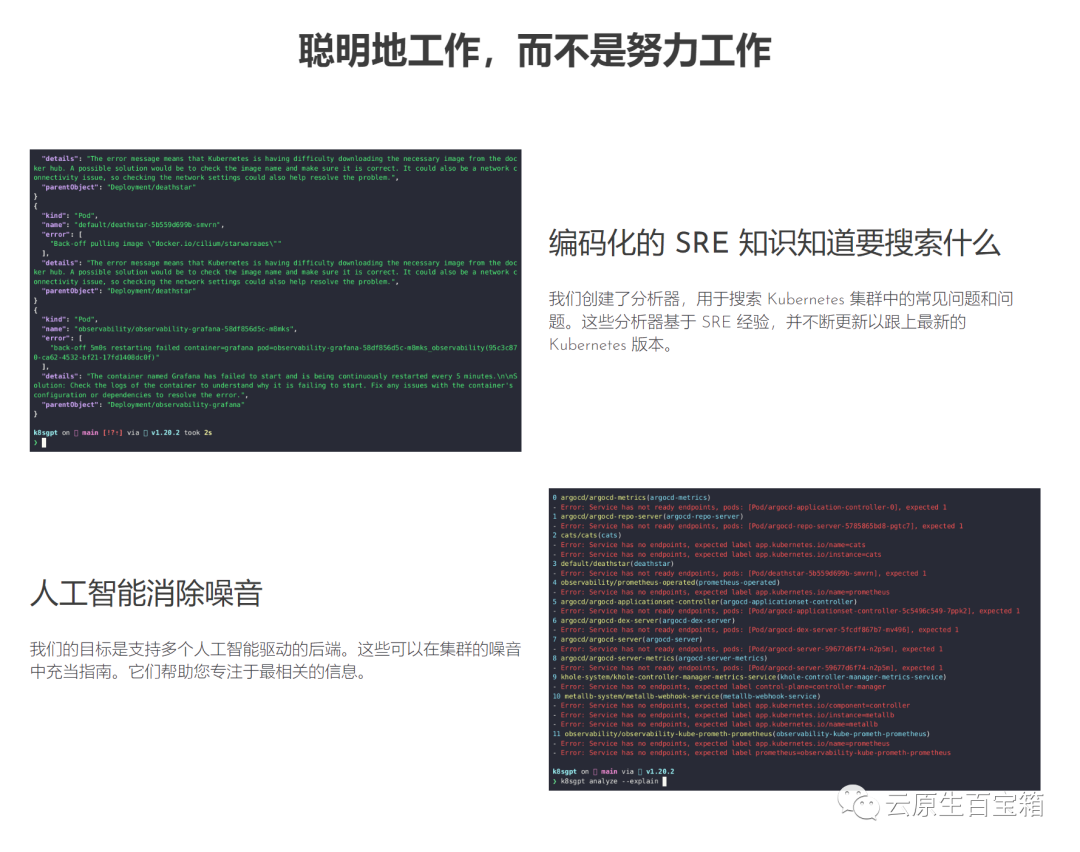

K8sGPT ist ein vollständig Open-Source-Projekt, das im April 2023 von einer Gruppe erfahrener Cloud-Native-Ökosystem-Ingenieure gestartet wurde. Die Kernidee des Projekts besteht darin, mithilfe von Modellen der künstlichen Intelligenz detaillierte und kontextbezogene Erklärungen für Kubernetes-Fehlermeldungen und Cluster-Erkenntnisse bereitzustellen.

Bilder Dieses Projekt wurde von zwei Organisationen übernommen und als CNCF-Sandbox-Projekt beantragt. Die Vision dieses Projekts ist es, aufgabenorientierte Modelle für maschinelles Lernen für Kubernetes zu erstellen.

Dieses Projekt wurde von zwei Organisationen übernommen und als CNCF-Sandbox-Projekt beantragt. Die Vision dieses Projekts ist es, aufgabenorientierte Modelle für maschinelles Lernen für Kubernetes zu erstellen.

Das Projekt unterstützt bereits mehrere Installationsoptionen und verschiedene KI-Backends. In diesem Beitrag zeige ich Ihnen, wie Sie K8sGPT, die CLI-Tools und Operatoren installieren und verwenden und wie K8sGPT andere Integrationen unterstützt.

Installation

Je nach Ihren Vorlieben und Ihrem Betriebssystem stehen mehrere Installationsoptionen zur Verfügung. Verschiedene Optionen finden Sie im Installationsabschnitt der K8sGPT-Dokumentation.

Voraussetzung für die Installation von K8sGPT wie unten beschrieben ist die Installation von Homebrew auf einem Mac oder WSL auf einem Windows-Computer.

Als nächstes können Sie den folgenden Befehl ausführen:

brew tap k8sgpt-ai/k8sgptbrew install k8sgpt

RPM-basierte Installation (RedHat/CentOS/Fedora)

32-Bit:

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_386.rpmsudo rpm -ivh k8sgpt_386.rpm

Nach dem Login kopieren

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_386.rpmsudo rpm -ivh k8sgpt_386.rpm

r reee

32-Bit:

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_amd64.rpmsudo rpm -ivh -i k8sgpt_amd64.rpm

Nach dem Login kopierenE

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_amd64.rpmsudo rpm -ivh -i k8sgpt_amd64.rpm

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_386.debsudo dpkg -i k8sgpt_386.deb

Nach dem Login kopieren

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_386.debsudo dpkg -i k8sgpt_386.deb

curl -LO https://github.com/k8sgpt-ai/k8sgpt/releases/download/v0.3.6/k8sgpt_amd64.debsudo dpkg -i k8sgpt_amd64.deb

Um alle von K8sGPT bereitgestellten Befehle anzuzeigen, verwenden Sie das Flag --help:

k8sgpt versionk8sgpt: 0.3.6 (9c0efe6), built at: unknown

Voraussetzungen

Die Voraussetzungen für das Befolgen des nächsten Abschnitts sind ein OpneAI-Konto und ein laufender Kubernetes-Cluster wie microk8s oder minikube, was ausreichend ist.

Nachdem Sie ein OpneAI-Konto haben, müssen Sie diese Adresse https://platform.openai.com/account/api-keys besuchen, um einen neuen API-Schlüssel zu generieren

Alternativ können Sie den folgenden Befehl ausführen und K8sGPT wird angezeigt Öffnen Sie im Standardbrowser dieselbe Adresse:

k8sgpt --help

k8sgpt generate

k8sgpt auth add openaiEnter openai Key: openai added to the AI backend provider list

k8sgpt auth listDefault:> openaiActive:> openaiUnused:> localai> azureopenai> noopai

apiVersion: apps/v1kind: Deploymentmetadata:name: nginx-deploymentlabels:app: nginxspec:replicas: 3selector:matchLabels:app: nginxtemplate:metadata:labels:app: nginxspec:containers:- name: nginximage: nginx:1.14.2ports:- containerPort: 80securityContext:readOnlyRootFilesystem: true

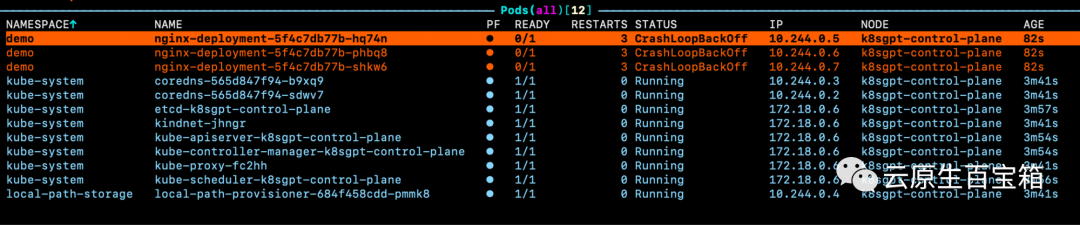

Bilder Wenn wir uns die Ereignisse für einen der Pods ansehen, aber die genaue Ursache des Problems nicht kennen:

Wenn wir uns die Ereignisse für einen der Pods ansehen, aber die genaue Ursache des Problems nicht kennen:

kubectl create ns demonamespace/demo createdkubectl apply -f ./deployment.yaml -n demodeployment.apps/nginx-deployment created

WarningBackOff 3s (x8 over 87s)kubelet Back-off restarting failed container

k8sgpt analyse

AI Provider: openai0 demo/nginx-deployment-5f4c7db77b-hq74n(Deployment/nginx-deployment)- Error: back-off 1m20s restarting failed cnotallow=nginx pod=nginx-deployment-5f4c7db77b-hq74n_demo(7854b793-21b7-4f81-86e5-dbb4113f64f4)1 demo/nginx-deployment-5f4c7db77b-phbq8(Deployment/nginx-deployment)- Error: back-off 1m20s restarting failed cnotallow=nginx pod=nginx-deployment-5f4c7db77b-phbq8_demo(74038531-e362-45a6-a436-cf1a6ea46d8a)2 demo/nginx-deployment-5f4c7db77b-shkw6(Deployment/nginx-deployment)- Error: back-off 1m20s restarting failed cnotallow=nginx pod=nginx-deployment-5f4c7db77b-shkw6_demo(2603f332-3e1c-45da-8080-e34dd6d956ad)

附加功能

根据你的集群大小和 K8sGPT 在集群中识别的问题数量,你还可以按特定命名空间和工作负载类型进行过滤。

此外,如果你或你的组织担心 OpenAI 或其他后端接收有关你的工作负载的敏感信息,你可以使用--anonymize规避应用的敏感信息。

与其他工具的集成

云原生生态系统中大多数工具的价值源于它们与其他工具的集成程度。

在撰写本文时,K8sGPT 提供了与 Gafana 和 Prometheus 等可观察性工具的轻松集成。此外,还可以为 K8sGPT 编写插件。维护者提供的第一个插件是Trivy,一个一体化的云原生安全扫描器。

你可以使用以下命令列出所有可用的集成:

k8sgpt integration listActive:Unused:> trivy

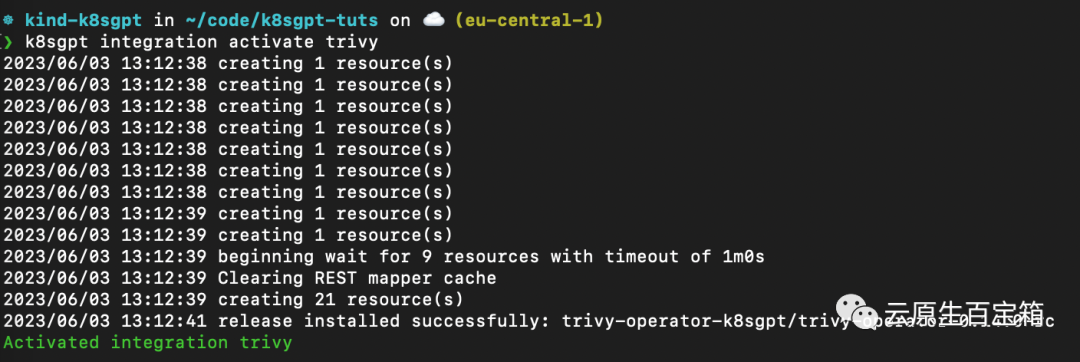

接下来,我们要激活 Trivy 集成:

k8sgpt integration activate trivy

这将在集群内安装 Trivy Operator(如果尚未安装):

图片

图片

激活集成后,我们可以通过 k8sgpt 过滤器,使用 Trivy 创建的漏洞报告作为 K8sGPT 分析的一部分:

❯ k8sgpt filters listActive:> Pod> VulnerabilityReport (integration)Unused:> Deployment> ReplicaSet> Node> Service> Ingress> StatefulSet> CronJob> PersistentVolumeClaim> HorizontalPodAutoScaler> PodDisruptionBudget> NetworkPolicy

过滤器对应于 k8sgpt 代码中的特定分析器。分析器仅查看相关信息,例如最关键的漏洞。

要使用 VulnerabilityReport 过滤器,请使用以下命令:

k8sgpt analyse --filter=VulnerabilityReport

(FIXME)与之前类似,我们也可以要求 K8sGPT 对扫描提供进一步的解释:

k8sgpt analyse --filter=VulnerabilityReport --explain

K8sGPT Operator

虽然 CLI 工具为集群管理员提供了对其基础设施和工作负载执行即席扫描的功能,但 K8sGPT Operator 在集群中全天候 (24/7) 运行。它是 Kubernetes 原生的,这意味着它作为 Kubernetes 自定义资源运行,并生成作为 YAML 清单存储在集群中的报告。

要安装 Operator,请按照以下命令进行操作:

helm repo add k8sgpt https://charts.k8sgpt.ai/helm repo updatehelm install release k8sgpt/k8sgpt-operator -n k8sgpt-operator-system --create-namespace

如果你想将 K8sGPT 与 Prometheus 和 Grafana 集成,你可以通过向上面的安装提供values.yaml 清单来使用略有不同的安装:

serviceMonitor:enabled: trueGrafanaDashboard:enabled: true

然后安装 Operator 或更新现有安装:

helm install release k8sgpt/k8sgpt-operator -n k8sgpt-operator-system --create-namespace --values values.yaml

在本例中,我们告诉 K8sGPT 还安装一个 ServiceMonitor,它将扫描报告中的指标发送到 Prometheus,并为 K8sGPT 创建一个仪表板。如果你使用了此安装,则还需要安装 kube-prometheus-stack Helm Chart 才能访问 Grafana 和 Prometheus。这可以通过以下命令来完成:

helm repo add prometheus-community https://prometheus-community.github.io/helm-chartshelm repo updatehelm install prom prometheus-community/kube-prometheus-stack -n k8sgpt-operator-system --set prometheus.prometheusSpec.serviceMonitorSelectorNilUsesHelmValues=false

此时,你应该在集群内运行 K8sGPT Operator 和 Prometheus Stack Helm Chart(也是 Kubernetes Operator)。

与我们需要向 CLI 提供 OpenAI API 密钥的方式类似,我们需要使用 API 密钥创建 Kubernetes 密钥。为此,请使用与之前相同的密钥,或者在你的 OpenAI 帐户上生成一个新密钥。

要生成 Kubernetes 密钥,请将你的 OpenAI 密钥粘贴到以下命令中:

export OPENAI_TOKEN=<your api key here>kubectl create secret generic k8sgpt-sample-secret --from-literal=openai-api-key=$OPENAI_TOKEN -n k8sgpt-operator-system</your>

然后,我们需要配置 K8sGPT Operator 以了解要使用哪个版本的 K8sGPT 以及哪个 AI 后端:

apiVersion: core.k8sgpt.ai/v1alpha1kind: K8sGPTmetadata:name: k8sgpt-samplespec:model: gpt-3.5-turbobackend: openainoCache: falseversion: v0.3.2enableAI: truesecret:name: k8sgpt-sample-secretkey: openai-api-key

现在,我们需要将此文件应用到我们的 K8sGPT 集群命名空间:

kubectl apply -f k8sgpt-resource.yaml -n k8sgpt-operator-system

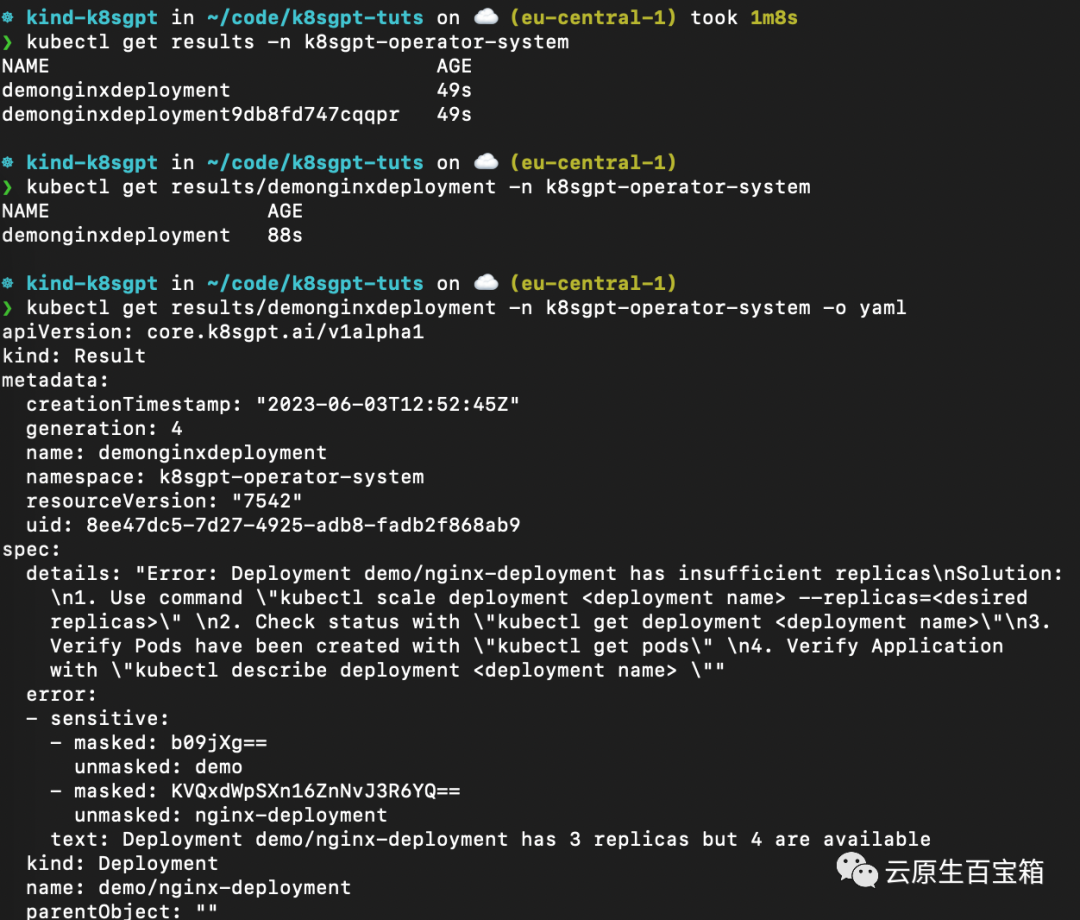

几秒钟内,Operator 将创建新结果:

kubectl get results -n k8sgpt-operator-system

以下是不同命令的屏幕截图,你可以按照这些命令从 K8sGPT Operator 查看结果报告:

从 K8sGPT Operator 查看结果报告

从 K8sGPT Operator 查看结果报告

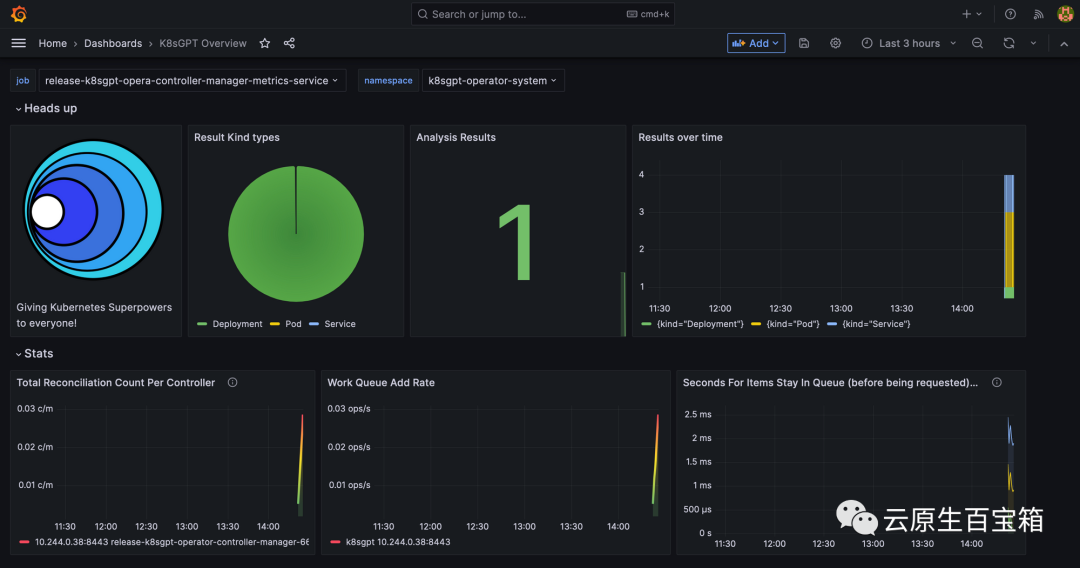

最后,我们将看一下 Grafana 仪表板。端口转发 Grafana 服务以通过 localhost 访问它:

kubectl port-forward service/prom-grafana -n prom 3000:80

打开 localhost:3000,然后导航到 Dashboards>K8sGPT Overview,然后你将看到包含结果的仪表板:

Grafana 中的 K8sGPT 仪表板

Grafana 中的 K8sGPT 仪表板

参考

- 1. https://k8sgpt.ai/

- 2. https://docs.k8sgpt.ai/

- 3. https://github.com/k8sgpt-ai

Das obige ist der detaillierte Inhalt vonDie Fehlerbehebung ist zu nervig. Probieren Sie die Superleistung von GPT aus. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1379

1379

52

52

Die ultimative Waffe für das Kubernetes-Debugging: K8sGPT

Feb 26, 2024 am 11:40 AM

Die ultimative Waffe für das Kubernetes-Debugging: K8sGPT

Feb 26, 2024 am 11:40 AM

Im Zuge der Weiterentwicklung der Technologien für künstliche Intelligenz und maschinelles Lernen haben Unternehmen und Organisationen damit begonnen, aktiv innovative Strategien zu erforschen, um diese Technologien zur Verbesserung der Wettbewerbsfähigkeit zu nutzen. K8sGPT[2] ist eines der leistungsstärksten Tools in diesem Bereich. Es handelt sich um ein auf k8s basierendes GPT-Modell, das die Vorteile der k8s-Orchestrierung mit den hervorragenden Funktionen des GPT-Modells zur Verarbeitung natürlicher Sprache kombiniert. Was ist K8sGPT? Schauen wir uns zunächst ein Beispiel an: Laut der offiziellen Website von K8sGPT ist K8sgpt ein Tool zum Scannen, Diagnostizieren und Klassifizieren von Kubernetes-Clusterproblemen. Es integriert SRE-Erfahrung in seine Analyse-Engine, um die relevantesten Informationen bereitzustellen. Durch den Einsatz künstlicher Intelligenztechnologie bereichert K8sgpt seine Inhalte weiterhin und hilft Benutzern, schneller und genauer zu verstehen.

Soll ich MBR oder GPT als Festplattenformat für Win7 wählen?

Jan 03, 2024 pm 08:09 PM

Soll ich MBR oder GPT als Festplattenformat für Win7 wählen?

Jan 03, 2024 pm 08:09 PM

Wenn wir das Betriebssystem Win7 verwenden, kann es manchmal vorkommen, dass wir das System neu installieren und die Festplatte partitionieren müssen. In Bezug auf die Frage, ob das Win7-Festplattenformat MBR oder GPT erfordert, ist der Herausgeber der Meinung, dass Sie immer noch eine Entscheidung basierend auf den Details Ihres eigenen Systems und Ihrer Hardwarekonfiguration treffen müssen. Aus Kompatibilitätsgründen ist es am besten, das MBR-Format zu wählen. Schauen wir uns für Details an, was der Editor getan hat. Das Win7-Festplattenformat erfordert mbr oder gpt1. Wenn das System mit Win7 installiert ist, wird empfohlen, MBR zu verwenden, das eine gute Kompatibilität aufweist. 2. Wenn es 3T überschreitet oder Win8 installiert, können Sie GPT verwenden. 3. Obwohl GPT tatsächlich weiter fortgeschritten ist als MBR, ist MBR in Bezug auf die Kompatibilität definitiv unschlagbar. GPT- und MBR-Bereiche

Detailliertes Verständnis des Win10-Partitionsformats: GPT- und MBR-Vergleich

Dec 22, 2023 am 11:58 AM

Detailliertes Verständnis des Win10-Partitionsformats: GPT- und MBR-Vergleich

Dec 22, 2023 am 11:58 AM

Bei der Partitionierung ihrer eigenen Systeme wissen viele Benutzer aufgrund der unterschiedlichen Festplatten, die von Benutzern verwendet werden, nicht, ob das Win10-Partitionsformat GPT oder MBR ist. Aus diesem Grund haben wir Ihnen eine detaillierte Einführung zusammengestellt, damit Sie den Unterschied zwischen den beiden kennen zwei. Win10-Partitionsformat gpt oder mbr: Antwort: Wenn Sie eine Festplatte mit mehr als 3 TB verwenden, können Sie gpt verwenden. gpt ist weiter fortgeschritten als mbr, aber in Bezug auf die Kompatibilität ist mbr immer noch besser. Selbstverständlich kann dies auch nach den Vorlieben des Nutzers gewählt werden. Der Unterschied zwischen gpt und mbr: 1. Anzahl der unterstützten Partitionen: 1. MBR unterstützt bis zu 4 primäre Partitionen. 2. GPT ist nicht durch die Anzahl der Partitionen begrenzt. 2. Unterstützte Festplattengröße: 1. MBR unterstützt nur bis zu 2 TB

So ermitteln Sie, ob die Computerfestplatte die GPT- oder MBR-Partitionierungsmethode verwendet

Dec 25, 2023 pm 10:57 PM

So ermitteln Sie, ob die Computerfestplatte die GPT- oder MBR-Partitionierungsmethode verwendet

Dec 25, 2023 pm 10:57 PM

Wie kann man überprüfen, ob eine Computerfestplatte eine GPT-Partition oder eine MBR-Partition ist? Wenn wir eine Computerfestplatte verwenden, müssen wir zwischen GPT und MBR unterscheiden. Lassen Sie uns einen Blick darauf werfen . So überprüfen Sie, ob es sich bei der Computerfestplatte um GPT oder MBR handelt: 1. Klicken Sie mit der rechten Maustaste auf „Computer“ auf dem Desktop und klicken Sie auf „Verwalten“. 2. Suchen Sie „Datenträgerverwaltung“ unter „Verwaltung“. 3. Rufen Sie die Datenträgerverwaltung auf, um den allgemeinen Status anzuzeigen Klicken Sie dann mit der rechten Maustaste auf „Festplatte 0“ und wählen Sie „Eigenschaften“. 4. Wechseln Sie in „Eigenschaften“ zur Registerkarte „Volume“, dann können wir die „Festplattenpartition“ sehen Formular“ und Sie können es als Probleme im Zusammenhang mit der Win10-Festplatte der MBR-Partition sehen. So konvertieren Sie eine MBR-Partition in eine GPT-Partition >

GPT-Lokalisierungsbereitstellungspraxis für das große Sprachmodell Alpaca-lora

Jun 01, 2023 pm 09:04 PM

GPT-Lokalisierungsbereitstellungspraxis für das große Sprachmodell Alpaca-lora

Jun 01, 2023 pm 09:04 PM

Modelleinführung: Das Alpaca-Modell ist ein von der Stanford University entwickeltes LLM-Modell (Large Language Model, große Sprache). Es basiert auf dem LLaMA7B-Modell (7B Open Source von Meta Company) und verfügt über 7 Milliarden Modellparameter (je größer die Modellparameter, desto größer die Modellparameter, desto stärker ist natürlich die Argumentationsfähigkeit des Modells, desto höher sind natürlich die Kosten für das Training des Modells). LoRA, der vollständige englische Name lautet „Low-RankAdaptation of Large Language Models“, wörtlich übersetzt „Low-Rank Adaptation of Large Language Models“. Hierbei handelt es sich um eine von Microsoft-Forschern entwickelte Technologie zur Lösung der Feinabstimmung großer Sprachmodelle. Wenn Sie möchten, dass ein vorab trainiertes großes Sprachmodell eine bestimmte Domäne ausführen kann

Wie viele der drei größten Mängel des LLM kennen Sie?

Nov 26, 2023 am 11:26 AM

Wie viele der drei größten Mängel des LLM kennen Sie?

Nov 26, 2023 am 11:26 AM

Wissenschaft: Weit davon entfernt, ein ewig wohlwollendes und wohltuendes Wesen zu sein, wird die empfindungsfähige allgemeine KI der Zukunft wahrscheinlich ein manipulativer Soziopath sein, der alle Ihre persönlichen Daten auffrisst und dann zusammenbricht, wenn sie am meisten gebraucht wird. Übersetzt aus 3WaysLLMsCanLetYouDown, Autor JoabJackson. OpenAI steht kurz vor der Veröffentlichung von GPT-5, und die Außenwelt setzt große Hoffnungen darauf. Die optimistischsten Prognosen gehen sogar davon aus, dass es allgemeine künstliche Intelligenz erreichen wird. Doch gleichzeitig stehen CEO Sam Altman und sein Team bei der Markteinführung vor einer Reihe schwerwiegender Hindernisse, was er Anfang des Monats einräumte. Es gibt einige kürzlich veröffentlichte Forschungsarbeiten, die Hinweise auf Altmans Herausforderung liefern könnten. Zusammenfassung dieser Arbeiten

Wie hat sich die von Bill Gates gewählte GPT-Technologie entwickelt und wessen Leben hat sie revolutioniert?

May 28, 2023 pm 03:13 PM

Wie hat sich die von Bill Gates gewählte GPT-Technologie entwickelt und wessen Leben hat sie revolutioniert?

May 28, 2023 pm 03:13 PM

Xi Xiaoyao Science and Technology Talks Ursprünglicher Autor |. IQ ist vollständig gesunken, Python Was wird passieren, wenn Maschinen auf ähnliche Weise wie Menschen verstehen und kommunizieren können? Dieses Thema bereitet der akademischen Gemeinschaft große Sorgen, und dank einer Reihe von Durchbrüchen in der Verarbeitung natürlicher Sprache in den letzten Jahren sind wir diesem Ziel möglicherweise näher denn je. An der Spitze dieses Durchbruchs steht der Generative Pre-trained Transformer (GPT) – ein tiefes neuronales Netzwerkmodell, das speziell für Aufgaben der Verarbeitung natürlicher Sprache entwickelt wurde. Seine herausragende Leistung und die Fähigkeit, effektive Gespräche zu führen, haben es zu einem der am weitesten verbreiteten und effektivsten Modelle auf diesem Gebiet gemacht und große Aufmerksamkeit in Forschung und Industrie auf sich gezogen. In einem aktuellen detaillierten

Was ist Krypto-GPT? Warum ist der Crypto GPT von 3EX ein neuer Zugang zum Währungskreis?

Jul 16, 2024 pm 04:51 PM

Was ist Krypto-GPT? Warum ist der Crypto GPT von 3EX ein neuer Zugang zum Währungskreis?

Jul 16, 2024 pm 04:51 PM

Was ist CryptoGPT? Warum soll der CryptoGPT von 3EX ein neuer Zugang zum Währungskreis sein? Laut Nachrichten vom 5. Juli hat die Handelsplattform 3EXAI offiziell CryptoGPT gestartet, ein innovatives Projekt, das auf KI-Technologie und Big Data basiert und darauf abzielt, globale Krypto-Investoren umfassende und intelligente Informationsabfragen und KI-Anlageberatung bereitzustellen. CryptoGPT hat die Top-200-Tokens in CoinMarketCap und Hunderte hochwertige Projektparteiinformationen aufgenommen und plant eine weitere Expansion. Über CryptoGPT können Benutzer kostenlos detaillierte Transaktionsberatungsberichte und KI-Anlageberatung erhalten und so einen vollständigen geschlossenen Kreislauf von Informationsberatungsdiensten bis hin zur intelligenten Strategieerstellung und automatischen Ausführung von Transaktionen realisieren. Derzeit ist der Dienst kostenlos. Erforderlich