Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Um die Privatsphäre der Kunden zu schützen, führen Sie Open-Source-KI-Modelle lokal mit Ruby aus

Um die Privatsphäre der Kunden zu schützen, führen Sie Open-Source-KI-Modelle lokal mit Ruby aus

Um die Privatsphäre der Kunden zu schützen, führen Sie Open-Source-KI-Modelle lokal mit Ruby aus

Übersetzer |. Chen Jun

Rezensent |. Kürzlich haben wir ein maßgeschneidertes Projekt für künstliche Intelligenz (KI) implementiert. Da Partei A über sehr sensible Kundeninformationen verfügt, können wir diese aus Sicherheitsgründen nicht an

OpenAIoder andere proprietäre Modelle weitergeben. Deshalb haben wir ein Open-Source-KI-Modell heruntergeladen und in einer virtuellen AWS-Maschine ausgeführt, sodass wir es vollständig unter unserer Kontrolle haben. Gleichzeitig können Rails-Anwendungen API-Anrufe an die KI in einer sicheren Umgebung tätigen. Wenn Sicherheitsaspekte nicht berücksichtigt werden müssen, würden wir natürlich lieber direkt mit OpenAI zusammenarbeiten.

Im Folgenden erkläre ich Ihnen, wie Sie das Open-Source-KI-Modell lokal herunterladen, laufen lassen und wie Sie das Skript

dagegen ausführen. Warum anpassen?

Die Motivation für dieses Projekt ist einfach: Datensicherheit. Beim Umgang mit sensiblen Kundeninformationen ist es in der Regel am zuverlässigsten, dies innerhalb des Unternehmens zu tun. Daher benötigen wir maßgeschneiderte KI-Modelle, die dazu beitragen, ein höheres Maß an Sicherheitskontrolle und Datenschutz zu gewährleisten.

Open-Source-Modell

In den vergangenen

6Monaten gab es neue Produkte auf dem Markt wie: Mistral, Mixtral und Lamaetc. Eine große Anzahl von Open-Source-KI-Modellen. Obwohl sie nicht so leistungsstark sind wie GPT-4, übertrifft die Leistung vieler von ihnen GPT-3.5 und sie werden mit der Zeit immer leistungsfähiger. Für welches Modell Sie sich entscheiden, hängt natürlich ganz von Ihren Verarbeitungsmöglichkeiten und dem, was Sie erreichen möchten, ab. Da wir das KI-Modell lokal ausführen werden, haben wir den

Mistralausgewählt, der ungefähr 4 GB ist. Bei den meisten Kennzahlen übertrifft es GPT-3.5. Obwohl Mixtral eine bessere Leistung als Mistral bietet, handelt es sich um ein sperriges Modell, das zum Betrieb mindestens 48 GB Speicher benötigt. Parameter

Wenn wir über große Sprachmodelle (

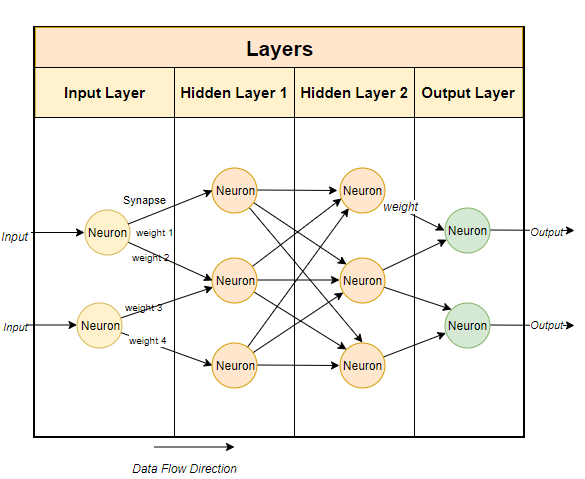

LLM) sprechen, neigen wir dazu, über die Erwähnung ihrer Parametergrößen nachzudenken. Hier ist das Mistral-Modell, das wir lokal ausführen werden, ein 7-Milliarden-Parametermodell (natürlich hat Mixtral 700 Milliarden Parameter und GPT-3.5 Es gibt ungefähr 1750 Milliarden Parameter). Typischerweise verwenden große Sprachmodelle Techniken, die auf neuronalen Netzwerken basieren. Neuronale Netzwerke bestehen aus Neuronen, und jedes Neuron ist mit allen anderen Neuronen in der nächsten Schicht verbunden.

Wie im Bild oben gezeigt, hat jede Verbindung ein Gewicht, das normalerweise als Prozentsatz ausgedrückt wird. Jedes Neuron verfügt außerdem über eine Vorspannung, die die Daten korrigiert, wenn sie einen Knoten durchlaufen.

Der Zweck des neuronalen Netzwerks besteht darin, einen erweiterten Algorithmus, einen Mustervergleichsalgorithmus, zu „lernen“. Indem es an großen Textmengen trainiert wird, lernt es nach und nach die Fähigkeit, Textmuster vorherzusagen und sinnvoll auf die Hinweise zu reagieren, die wir ihm geben. Einfach ausgedrückt sind Parameter die Anzahl der Gewichte und Verzerrungen im Modell. Es gibt uns eine Vorstellung davon, wie viele Neuronen es in einem neuronalen Netzwerk gibt. Beispielsweise gibt es für ein 7 Milliarden Parametermodell ungefähr

100Schichten mit jeweils Tausenden von Neuronen. Führen Sie das Modell lokal aus

Um das Open-Source-Modell lokal auszuführen, müssen Sie zunächst die entsprechende Anwendung herunterladen. Obwohl es viele Optionen auf dem Markt gibt, istOllama diejenige, die sich meiner Meinung nach am einfachsten und am einfachsten auf Intel

Macausführen lässt. Obwohl Ollama derzeit nur auf

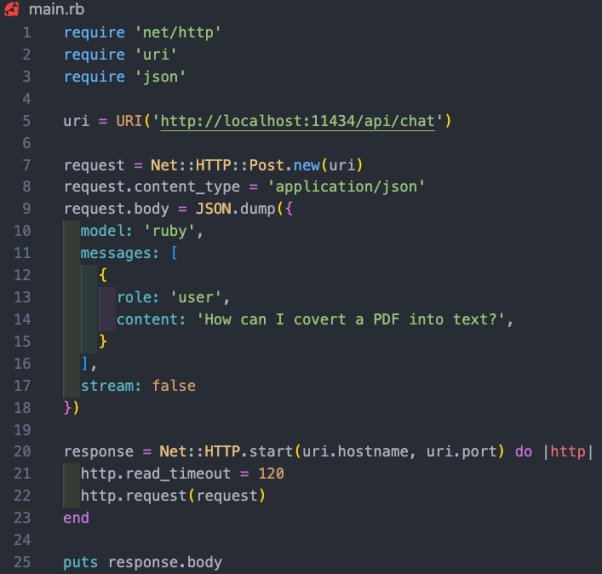

Mac und Linux läuft, wird es in Zukunft auch auf Windows laufen. Natürlich können Sie WSL (Windows-Subsystem für Linux) verwenden, um Linux-Shell unter Windows auszuführen. Ollama ermöglicht Ihnen nicht nur das Herunterladen und Ausführen verschiedener Open-Source-Modelle, sondern öffnet das Modell auch auf einem lokalen Port, sodass Sie API-Aufrufe über RubyCode tätigen können. Dies erleichtert Ruby-Entwicklern das Schreiben von Ruby-Anwendungen, die in lokale Modelle integriert werden können. Da Ollama hauptsächlich befehlszeilenbasiert ist, ist es sehr einfach, Ollama auf Mac und Linux zu installieren . Sie müssen Ollama nur über den Link https://www.php.cn/link/04c7f37f2420f0532d7f0e062ff2d5b5 herunterladen, etwa 5 Minuten für die Installation des Softwarepakets aufwenden und dann das Modell ausführen. Nachdem Sie Ollama eingerichtet und ausgeführt haben, sehen Sie das Ollama-Symbol in der Taskleiste Ihres Browsers. Das bedeutet, dass es im Hintergrund läuft und Ihr Modell ausführen kann. Um das Modell herunterzuladen, können Sie ein Terminal öffnen und den folgenden Befehl ausführen: Da Mistral etwa 4GB groß ist, wird es bei Ihnen eine Weile dauern um den Download abzuschließen. Sobald der Download abgeschlossen ist, wird automatisch die Ollama-Eingabeaufforderung geöffnet, damit Sie mit Mistral interagieren und kommunizieren können. Wenn Sie mistral das nächste Mal durch Ollama laufen, können Sie das entsprechende Modell direkt ausführen. Ähnlich wie wir benutzerdefiniertes GPT in OpenAI erstellen, können Sie über Ollama das Basismodell anpassen. Hier können wir einfach ein benutzerdefiniertes Modell erstellen. Ausführlichere Fälle finden Sie in der Online-Dokumentation von Ollama. Zunächst können Sie ein Modelfile (Modelldatei) erstellen und darin den folgenden Text hinzufügen: Die oben erscheinende Systemmeldung ist die Grundlage für die konkrete Reaktion der KI Modell. Als nächstes können Sie den folgenden Befehl auf dem Terminal ausführen, um ein neues Modell zu erstellen: In unserem Projektfall habe ich das Modell Ruby genannt. Gleichzeitig können Sie den folgenden Befehl verwenden, um Ihre vorhandenen Modelle aufzulisten und anzuzeigen: https://www.php.cn/link/dcd3f83c96576c0fd437286a1ff6f1f0“ darauf zugreifen können. Darüber hinaus bietet die Dokumentation für die Ollama-API auch verschiedene Endpunkte für grundlegende Befehle wie Chat-Konversationen und das Erstellen von Einbettungen. In diesem Projektfall möchten wir den Endpunkt /api/chat verwenden, um Eingabeaufforderungen an das KI-Modell zu senden. Das Bild unten zeigt einige grundlegende RubyCode für die Interaktion mit dem Modell: Die Funktionalität des oben genannten RubyCode-Snippets umfasst: netto /http“, „uri “ drei Bibliotheken führen jeweils HTTP-Anfragen aus, analysieren URI bzw. verarbeiten , Autor: Kane Hooper

Holen Sie sich Ollama

Installieren Ihres ersten Modells

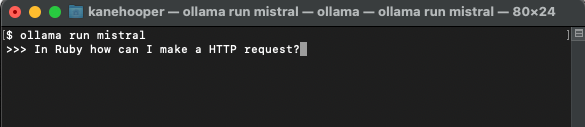

ollama run mistral

Maßgeschneidertes Modell

FROM mistral# Set the temperature set the randomness or creativity of the responsePARAMETER temperature 0.3# Set the system messageSYSTEM ”””You are an excerpt Ruby developer. You will be asked questions about the Ruby Programminglanguage. You will provide an explanation along with code examples.”””

ollama create <model-name> -f './Modelfile</model-name>

ollama create ruby -f './Modelfile'

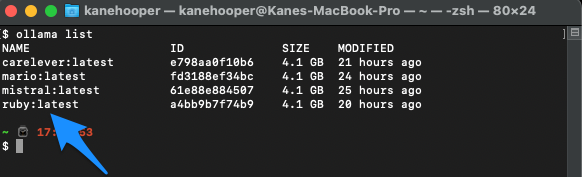

ollama list

Ollama run ruby

11434 öffnen, sodass Sie über „

json

jsonJSON

Mac

How To Run Open-Source AI Models Locally With Ruby

Das obige ist der detaillierte Inhalt vonUm die Privatsphäre der Kunden zu schützen, führen Sie Open-Source-KI-Modelle lokal mit Ruby aus. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

Laut Nachrichten dieser Website vom 1. August hat SK Hynix heute (1. August) einen Blogbeitrag veröffentlicht, in dem es ankündigt, dass es am Global Semiconductor Memory Summit FMS2024 teilnehmen wird, der vom 6. bis 8. August in Santa Clara, Kalifornien, USA, stattfindet viele neue Technologien Generation Produkt. Einführung des Future Memory and Storage Summit (FutureMemoryandStorage), früher Flash Memory Summit (FlashMemorySummit), hauptsächlich für NAND-Anbieter, im Zusammenhang mit der zunehmenden Aufmerksamkeit für die Technologie der künstlichen Intelligenz wurde dieses Jahr in Future Memory and Storage Summit (FutureMemoryandStorage) umbenannt Laden Sie DRAM- und Speicheranbieter und viele weitere Akteure ein. Neues Produkt SK Hynix wurde letztes Jahr auf den Markt gebracht

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

Laut Nachrichten dieser Website vom 5. Juli veröffentlichte GlobalFoundries am 1. Juli dieses Jahres eine Pressemitteilung, in der die Übernahme der Power-Galliumnitrid (GaN)-Technologie und des Portfolios an geistigem Eigentum von Tagore Technology angekündigt wurde, in der Hoffnung, seinen Marktanteil in den Bereichen Automobile und Internet auszubauen Anwendungsbereiche für Rechenzentren mit künstlicher Intelligenz, um höhere Effizienz und bessere Leistung zu erforschen. Da sich Technologien wie generative künstliche Intelligenz (GenerativeAI) in der digitalen Welt weiterentwickeln, ist Galliumnitrid (GaN) zu einer Schlüssellösung für nachhaltiges und effizientes Energiemanagement, insbesondere in Rechenzentren, geworden. Auf dieser Website wurde die offizielle Ankündigung zitiert, dass sich das Ingenieurteam von Tagore Technology im Rahmen dieser Übernahme mit GF zusammenschließen wird, um die Galliumnitrid-Technologie weiterzuentwickeln. G

Iyo One: Teils Kopfhörer, teils Audiocomputer

Aug 08, 2024 am 01:03 AM

Iyo One: Teils Kopfhörer, teils Audiocomputer

Aug 08, 2024 am 01:03 AM

Konzentration ist zu jeder Zeit eine Tugend. Autor |. Herausgeber Tang Yitao |. Jing Yu Das Wiederaufleben der künstlichen Intelligenz hat zu einer neuen Welle von Hardware-Innovationen geführt. Der beliebteste AIPin hat beispiellose negative Bewertungen erhalten. Marques Brownlee (MKBHD) bezeichnete es als das schlechteste Produkt, das er jemals rezensiert habe; David Pierce, Herausgeber von The Verge, sagte, er würde niemandem empfehlen, dieses Gerät zu kaufen. Sein Konkurrent, der RabbitR1, ist nicht viel besser. Der größte Zweifel an diesem KI-Gerät besteht darin, dass es sich offensichtlich nur um eine App handelt, Rabbit jedoch eine 200-Dollar-Hardware gebaut hat. Viele Menschen sehen KI-Hardware-Innovationen als Chance, das Smartphone-Zeitalter zu untergraben und sich ihm zu widmen.

Das Transformer-Autoren-Startup Sakana AI bringt AI Scientist auf den Markt, das erste vollautomatische KI-System für wissenschaftliche Entdeckungen

Aug 13, 2024 pm 04:43 PM

Das Transformer-Autoren-Startup Sakana AI bringt AI Scientist auf den Markt, das erste vollautomatische KI-System für wissenschaftliche Entdeckungen

Aug 13, 2024 pm 04:43 PM

Herausgeber | ScienceAI Vor einem Jahr verließ Llion Jones, der letzte Autor des Transformer-Artikels von Google, das Unternehmen, um ein Unternehmen zu gründen, und gründete zusammen mit dem ehemaligen Google-Forscher David Ha das Unternehmen für künstliche Intelligenz SakanaAI. SakanaAI behauptet, ein neues Basismodell zu schaffen, das auf von der Natur inspirierten Intelligenz basiert! Jetzt hat SakanaAI seinen Antwortbogen eingereicht. SakanaAI kündigt die Einführung von AIScientist an, dem weltweit ersten KI-System für automatisierte wissenschaftliche Forschung und offene Entdeckung! Von der Konzeption, dem Schreiben von Code, der Durchführung von Experimenten und der Zusammenfassung der Ergebnisse bis hin zum Verfassen ganzer Arbeiten und der Durchführung von Peer-Reviews ermöglicht AIScientist KI-gesteuerte wissenschaftliche Forschung und Beschleunigung

Wie konvertiere ich XML -Dateien in PDF auf Ihrem Telefon?

Apr 02, 2025 pm 10:12 PM

Wie konvertiere ich XML -Dateien in PDF auf Ihrem Telefon?

Apr 02, 2025 pm 10:12 PM

Mit einer einzigen Anwendung ist es unmöglich, XML -zu -PDF -Konvertierung direkt auf Ihrem Telefon zu vervollständigen. Es ist erforderlich, Cloud -Dienste zu verwenden, die in zwei Schritten erreicht werden können: 1. XML in PDF in der Cloud, 2. Zugriff auf die konvertierte PDF -Datei auf dem Mobiltelefon konvertieren oder herunterladen.