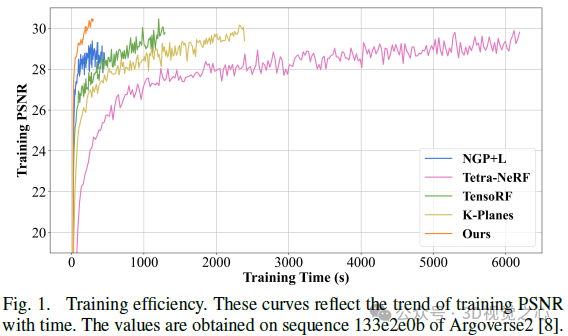

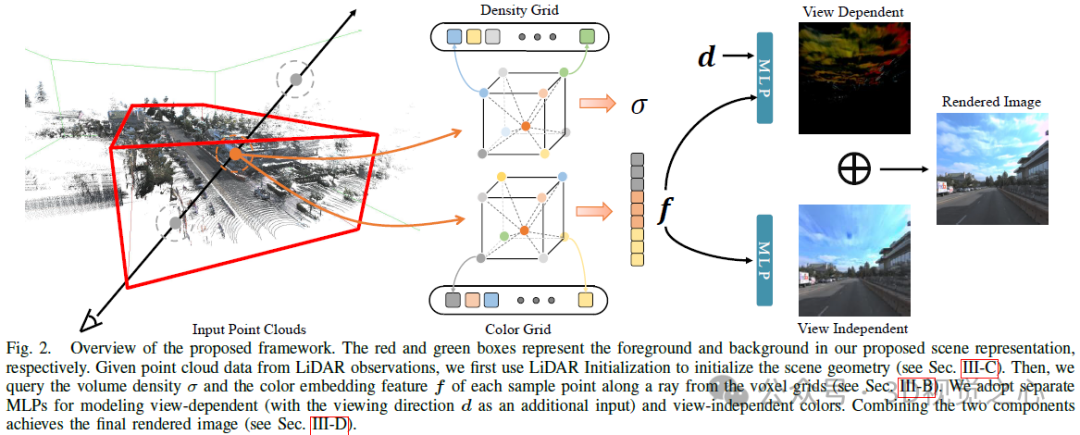

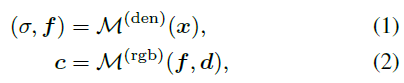

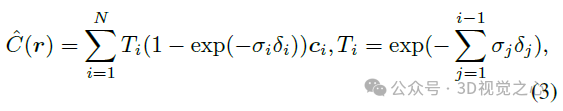

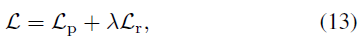

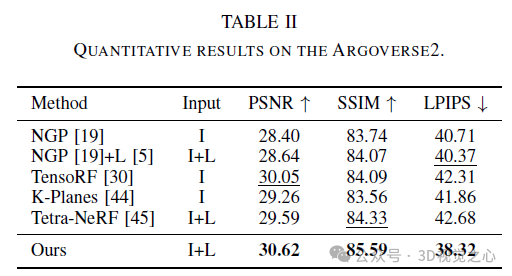

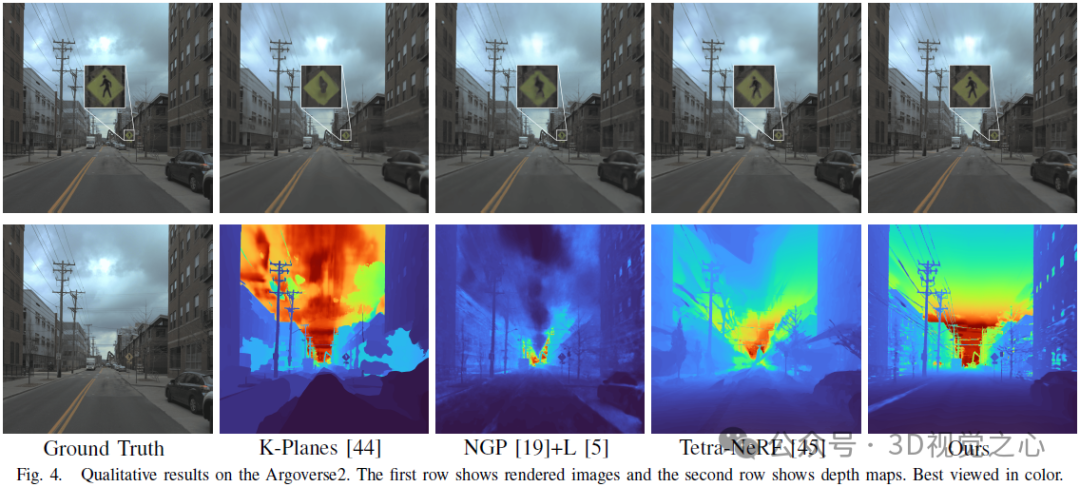

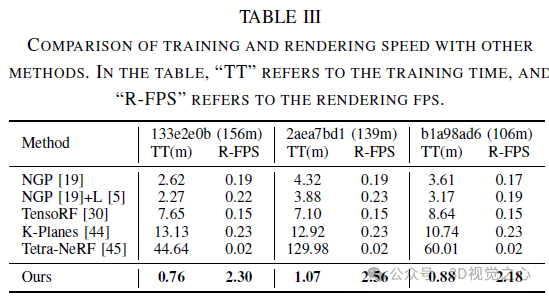

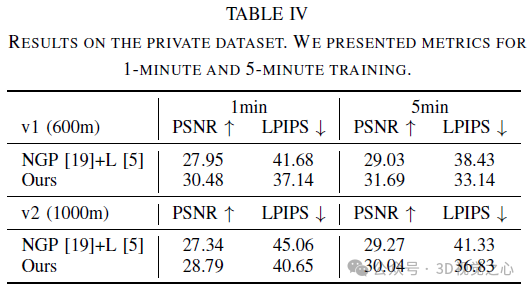

Neueste Forschungen haben die Anwendungsaussichten von NeRF in autonomen Fahrumgebungen hervorgehoben. Allerdings erschwert die Komplexität von Außenumgebungen in Verbindung mit eingeschränkten Blickwinkeln in Fahrszenen die Aufgabe, die Szenengeometrie genau zu rekonstruieren. Diese Herausforderungen führen häufig zu einer verminderten Rekonstruktionsqualität und längeren Trainings- und Rendering-Dauern. Um diesen Herausforderungen zu begegnen, haben wir Lightning NeRF ins Leben gerufen. Es verwendet eine effiziente Hybridszenendarstellung, die die geometrischen Prioritäten von Lidar in autonomen Fahrszenarien effektiv nutzt. Lightning NeRF verbessert die neuartige Ansichtssyntheseleistung von NeRF erheblich und reduziert den Rechenaufwand. Durch die Auswertung realer Datensätze wie KITTI-360, Argoverse2 und unseres privaten Datensatzes zeigen wir, dass unsere Methode nicht nur den aktuellen Stand der Technik in der Qualität der Synthese neuer Ansichten übertrifft, sondern auch die Trainingsgeschwindigkeit Five verbessert Mal schneller und zehnmal schnelleres Rendern. H-Code-Link: https://gision-sjtu/lightning-insf. Detaillierte Erklärung von Lightning Nerf MLP. Es ist in der Lage, den Farbwert c und die Volumendichtevorhersage σ eines 3D-Punktes x in der Szene basierend auf der Blickrichtung d zurückzugeben.

. Eine Voxel-Mesh-Darstellung speichert Szeneneigenschaften (z. B. Dichte, RGB-Farbe oder Features) explizit in ihren Mesh-Scheitelpunkten, um effiziente Feature-Abfragen zu unterstützen. Auf diese Weise können wir für eine gegebene 3D-Position das entsprechende Attribut durch trilineare Interpolation dekodieren:

. Wir erstellen zwei unabhängige Feature-Netze, um die Dichte und Farbeinbettung des Vordergrundbereichs zu modellieren. Insbesondere ordnet die Dichtenetzzuordnung Positionen einem Dichteskalar σ für die volumetrische Darstellung zu. Für die farblich eingebettete Netzzuordnung instanziieren wir mehrere Voxelnetze mit unterschiedlichen Auflösungs-Backups über eine Hash-Tabelle, um feinere Details bei erschwinglichem Speicheraufwand zu erhalten. Die endgültige Farbeinbettung f wird durch Verkettung der Ausgaben mit L Auflösungsstufen erhalten.

Dazu richten wir ein zusätzliches Hintergrundnetzmodell ein, um die Auflösung des Vordergrundteils konstant zu halten. Als Hintergrund verwenden wir die Szenenparametrisierung in [9], die sorgfältig entworfen wurde. Erstens verwenden wir im Gegensatz zur inversen sphärischen Modellierung die inverse kubische Modellierung mit der ℓ∞-Norm, da wir eine Voxelgitterdarstellung verwenden. Zweitens instanziieren wir kein zusätzliches MLP, um die Hintergrundfarbe abzufragen und so Speicherplatz zu sparen. Konkret verzerren wir 3D-Hintergrundpunkte in 4D durch:

Bei Verwendung unserer hybriden Szenendarstellung ist es rechenintensiv, wenn wir direkt von einer effizienten Voxelgitterdarstellung ausgehen. Dieses Modell spart Rechenaufwand und Speicher beim MLP fragt Dichtewerte ab. Angesichts der Großräumigkeit und Komplexität städtischer Szenen kann diese leichtgewichtige Darstellung jedoch aufgrund der begrenzten Auflösung des Dichtegitters während der Optimierung leicht in lokalen Minima stecken bleiben. Glücklicherweise sind beim autonomen Fahren die meisten selbstfahrenden Fahrzeuge (SDVs) mit LiDAR-Sensoren ausgestattet, die grobe geometrische Prioritäten für die Szenenrekonstruktion liefern. Zu diesem Zweck schlagen wir vor, Lidar-Punktwolken zu verwenden, um unser Dichtenetz zu initialisieren und die Hindernisse einer gemeinsamen Optimierung von Szenengeometrie und Radioaktivität zu beseitigen.

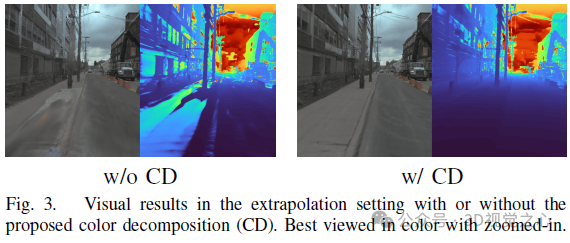

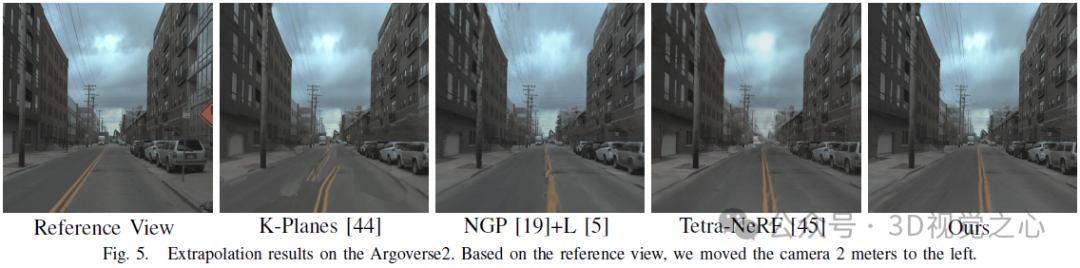

Das ursprüngliche NeRF verwendete ein ansichtsabhängiges MLP, um die Farbe im Strahlungsfeld zu modellieren, eine Vereinfachung der physischen Welt, in der Strahlung aus diffuser (ansichtsunabhängiger) Farbe und spiegelnder (ansichtsbezogener) Farbe besteht Komposition. Da außerdem die endgültige Ausgabefarbe c vollständig mit der Blickrichtung d verknüpft ist, ist es schwierig, hochauflösende Bilder in unsichtbaren Ansichten wiederzugeben. Wie in Abbildung 3 dargestellt, schlägt unsere Methode, die ohne Farbzerlegung (CD) trainiert wurde, bei der Synthese neuer Ansichten in der Extrapolationseinstellung fehl (d. h. beim Verschieben der Blickrichtung um 2 Meter nach links basierend auf der Trainingsansicht), während unsere Methode in Farbe zerlegt wurde case liefert vernünftige Rendering-Ergebnisse.

Die endgültige Farbe am abgetasteten Ort ist die Summe dieser beiden Faktoren:

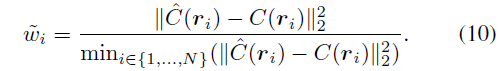

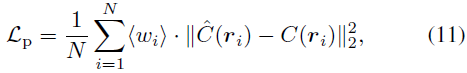

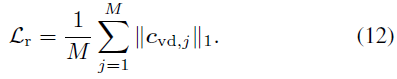

Wir modifizieren den photometrischen Verlust mithilfe neu skalierter Gewichte, um unser Modell zu optimieren. Machen Sie es Konzentrieren Sie sich auf harte Proben, um eine schnelle Konvergenz zu erreichen. Der Gewichtskoeffizient ist definiert als:

Bild

Bild

In diesem Artikel wird Lightning NeRF vorgestellt, ein effizientes Synthese-Framework für Szenenansichten im Freien, das Punktwolken und Bilder integriert. Die vorgeschlagene Methode nutzt Punktwolken, um schnell eine spärliche Darstellung der Szene zu initialisieren und so erhebliche Leistungs- und Geschwindigkeitsverbesserungen zu erzielen. Indem wir den Hintergrund effizienter modellieren, reduzieren wir die Darstellungsbelastung im Vordergrund. Schließlich werden durch Farbzerlegung ansichtsbezogene und ansichtsunabhängige Farben separat modelliert, was die Extrapolationsfähigkeit des Modells verbessert. Umfangreiche Experimente mit verschiedenen Datensätzen zum autonomen Fahren zeigen, dass unsere Methode bisherige State-of-the-Art-Techniken in Bezug auf Leistung und Effizienz übertrifft.

Das obige ist der detaillierte Inhalt vonLightning NeRF wurde für autonomes Fahren entwickelt: 10-mal schneller. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

MySQL-Standard-Transaktionsisolationsstufe

MySQL-Standard-Transaktionsisolationsstufe

Was ist digitale Währung?

Was ist digitale Währung?

Der Unterschied zwischen Pfeilfunktionen und gewöhnlichen Funktionen

Der Unterschied zwischen Pfeilfunktionen und gewöhnlichen Funktionen

Bereinigen Sie den Müll in Win10

Bereinigen Sie den Müll in Win10

besonderer Symbolpunkt

besonderer Symbolpunkt

Auf welche Tasten beziehen sich Pfeile in Computern?

Auf welche Tasten beziehen sich Pfeile in Computern?

So verwenden Sie die Print()-Funktion in Python

So verwenden Sie die Print()-Funktion in Python

In Word gibt es eine zusätzliche leere Seite, die ich nicht löschen kann.

In Word gibt es eine zusätzliche leere Seite, die ich nicht löschen kann.