Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

TensorFlow Deep-Learning-Framework-Modell-Inferenzpipeline für Porträtausschnitt-Inferenz

TensorFlow Deep-Learning-Framework-Modell-Inferenzpipeline für Porträtausschnitt-Inferenz

TensorFlow Deep-Learning-Framework-Modell-Inferenzpipeline für Porträtausschnitt-Inferenz

Übersicht

Um ModelScope-Benutzern die schnelle und bequeme Nutzung verschiedener von der Plattform bereitgestellter Modelle zu ermöglichen, wird eine Reihe voll ausgestatteter Python-Bibliotheken bereitgestellt, die die Implementierung offizieller ModelScope-Modelle sowie deren Verwendung umfassen Modelle für Inferenz, Feinabstimmung von Code im Zusammenhang mit der Datenvorverarbeitung, Nachverarbeitung, Effektbewertung und anderen für andere Aufgaben erforderlichen Funktionen, während gleichzeitig eine einfache und benutzerfreundliche API und umfangreiche Anwendungsbeispiele bereitgestellt werden. Durch den Aufruf der Bibliothek können Benutzer Aufgaben wie Modellinferenz, Training und Bewertung erledigen, indem sie nur wenige Codezeilen schreiben. Außerdem können sie auf dieser Basis schnell eine Sekundärentwicklung durchführen, um ihre eigenen innovativen Ideen zu verwirklichen.

Die derzeit von der Bibliothek bereitgestellten Algorithmusmodelle decken fünf Hauptbereiche der KI ab: Bild, Verarbeitung natürlicher Sprache, Sprache, Multimodalität und Wissenschaft sowie Dutzende von Anwendungsszenarioaufgaben. Informationen zu spezifischen Aufgaben finden Sie im Dokument: Einführung in die Aufgabe.

Deep Learning Framework

Die ModelScope Library unterstützt derzeit Deep-Learning-Frameworks wie Pytorch und Tensorflow. Weitere Frameworks werden in Zukunft kontinuierlich aktualisiert und erweitert, also bleiben Sie dran! Alle offiziellen Modelle können über die ModelScope-Bibliothek zur Modellinferenz verwendet werden, und einige Modelle können die Bibliothek auch zum Training und zur Evaluierung nutzen. Vollständige Nutzungsinformationen finden Sie auf der Modellkarte des entsprechenden Modells.

Modellinferenzpipeline

Modellinferenz

Beim Deep Learning bezieht sich Inferenz auf den Prozess, durch den das Modell Daten vorhersagt. Wenn ModelScope eine Inferenz durchführt, verwendet es die Pipeline, um die erforderlichen Vorgänge nacheinander auszuführen. Eine typische Pipeline umfasst normalerweise drei Schritte: Datenvorverarbeitung, Modellvorwärtsinferenz und Datennachverarbeitung.

Einführung in Pipeline

Die Methode „pipeline()“ ist eine der grundlegendsten Benutzermethoden im ModelScope-Framework und kann zur schnellen Modellinferenz in verschiedenen Bereichen verwendet werden. Mit der Methode „pipeline()“ können Benutzer problemlos Modellinferenzen für bestimmte Aufgaben mit nur einer Codezeile abschließen. Die

pipeline()-Methode ist eine der grundlegendsten Benutzermethoden im ModelScope-Framework und kann zur schnellen Modellinferenz in verschiedenen Bereichen verwendet werden. Mit der Methode „pipeline()“ können Benutzer problemlos Modellinferenzen für bestimmte Aufgaben mit nur einer Codezeile abschließen.

Verwendung von Pipeline

In diesem Artikel wird kurz vorgestellt, wie die Pipeline-Methode zum Laden des Modells für die Inferenz verwendet wird. Durch die Pipeline-Methode können Benutzer das erforderliche Modell einfach aus dem Modelllager abrufen, um daraus Rückschlüsse auf der Grundlage des Aufgabentyps und des Modellnamens zu ziehen. Der Hauptvorteil dieser Methode besteht darin, dass sie einfach zu verwenden ist und Modellinferenzen schnell und effizient durchführen kann. Der Vorteil der Pipeline-Methode besteht darin, dass sie eine direkte Möglichkeit bietet, das Modell zu erhalten und anzuwenden, ohne dass Benutzer die spezifischen Details des Modells verstehen müssen, wodurch die Schwelle für die Verwendung des Modells gesenkt wird. Durch die Pipeline-Methode können sich Benutzer mehr auf die Lösung von Problemen und die Vorbereitung der Umgebung konzentrieren. Wichtige Parameter

Grundlegende Verwendung von Pipeline- Chinesische Wortsegmentierung

- Die Pipeline-Funktion unterstützt die Angabe eines bestimmten Aufgabennamens, das Laden des Aufgabenstandardmodells und das Erstellen des entsprechenden Pipeline-Objekts.

- Python-Code

from modelscope.pipelines import pipelineword_segmentation = pipeline('word-segmentation')input_str = '开源技术小栈作者是Tinywan,你知道不?'print(word_segmentation(input_str))Nach dem Login kopieren- PHP-Code

<?php $operator = PyCore::import("operator");$builtins = PyCore::import("builtins");$pipeline = PyCore::import('modelscope.pipelines')->pipeline;$word_segmentation = $pipeline("word-segmentation");$input_str = "开源技术小栈作者是Tinywan,你知道不?";PyCore::print($word_segmentation($input_str));/usr/local/php-8.2.14/bin/php demo.php 2024-03-25 21:41:42,434 - modelscope - INFO - PyTorch version 2.2.1 Found.2024-03-25 21:41:42,434 - modelscope - INFO - Loading ast index from /home/www/.cache/modelscope/ast_indexer2024-03-25 21:41:42,577 - modelscope - INFO - Loading done! Current index file version is 1.13.0, with md5 f54e9d2dceb89a6c989540d66db83a65 and a total number of 972 components indexed2024-03-25 21:41:44,661 - modelscope - WARNING - Model revision not specified, use revision: v1.0.32024-03-25 21:41:44,879 - modelscope - INFO - initiate model from /home/www/.cache/modelscope/hub/damo/nlp_structbert_word-segmentation_chinese-base2024-03-25 21:41:44,879 - modelscope - INFO - initiate model from location /home/www/.cache/modelscope/hub/damo/nlp_structbert_word-segmentation_chinese-base.2024-03-25 21:41:44,880 - modelscope - INFO - initialize model from /home/www/.cache/modelscope/hub/damo/nlp_structbert_word-segmentation_chinese-baseYou are using a model of type bert to instantiate a model of type structbert. This is not supported for all configurations of models and can yield errors.2024-03-25 21:41:48,633 - modelscope - WARNING - No preprocessor field found in cfg.2024-03-25 21:41:48,633 - modelscope - WARNING - No val key and type key found in preprocessor domain of configuration.json file.2024-03-25 21:41:48,633 - modelscope - WARNING - Cannot find available config to build preprocessor at mode inference, current config: {'model_dir': '/home/www/.cache/modelscope/hub/damo/nlp_structbert_word-segmentation_chinese-base'}. trying to build by task and model information.2024-03-25 21:41:48,639 - modelscope - INFO - cuda is not available, using cpu instead.2024-03-25 21:41:48,640 - modelscope - WARNING - No preprocessor field found in cfg.2024-03-25 21:41:48,640 - modelscope - WARNING - No val key and type key found in preprocessor domain of configuration.json file.2024-03-25 21:41:48,640 - modelscope - WARNING - Cannot find available config to build preprocessor at mode inference, current config: {'model_dir': '/home/www/.cache/modelscope/hub/damo/nlp_structbert_word-segmentation_chinese-base', 'sequence_length': 512}. trying to build by task and model information./home/www/anaconda3/envs/tinywan-modelscope/lib/python3.10/site-packages/transformers/modeling_utils.py:962: FutureWarning: The `device` argument is deprecated and will be removed in v5 of Transformers.warnings.warn({'output': ['开源', '技术', '小', '栈', '作者', '是', 'Tinywan', ',', '你', '知道', '不', '?']}from modelscope.pipelines import pipelineword_segmentation = pipeline('word-segmentation')inputs =['开源技术小栈作者是Tinywan,你知道不?','webman这个框架不错,建议你看看']print(word_segmentation(inputs))<?php $operator = PyCore::import("operator");$builtins = PyCore::import("builtins");$pipeline = PyCore::import('modelscope.pipelines')->pipeline;$word_segmentation = $pipeline("word-segmentation");$inputs = new PyList(["开源技术小栈作者是Tinywan,你知道不?", "webman这个框架不错,建议你看看"]);PyCore::print($word_segmentation($inputs));[{'output': ['开源', '技术', '小', '栈', '作者', '是', 'Tinywan', ',', '你', '知道', '不', '?']},{'output': ['webman', '这个', '框架', '不错', ',', '建议', '你', '看看']}]inputs =['今天天气不错,适合出去游玩','这本书很好,建议你看看']# 指定batch_size参数来支持批量推理print(word_segmentation(inputs, batch_size=2))# 输出[{'output': ['今天', '天气', '不错', ',', '适合', '出去', '游玩']}, {'output': ['这', '本', '书', '很', '好', ',', '建议', '你', '看看']}]from modelscope.msdatasets import MsDatasetfrom modelscope.pipelines import pipelineinputs = ['今天天气不错,适合出去游玩', '这本书很好,建议你看看']dataset = MsDataset.load(inputs, target='sentence')word_segmentation = pipeline('word-segmentation')outputs = word_segmentation(dataset)for o in outputs:print(o)# 输出{'output': ['今天', '天气', '不错', ',', '适合', '出去', '游玩']}{'output': ['这', '本', '书', '很', '好', ',', '建议', '你', '看看']}from modelscope.models import Modelfrom modelscope.pipelines import pipelinemodel = Model.from_pretrained('damo/nlp_structbert_word-segmentation_chinese-base')word_segmentation = pipeline('word-segmentation', model=model)inputs =['开源技术小栈作者是Tinywan,你知道不?','webman这个框架不错,建议你看看']print(word_segmentation(inputs))Hinweis:

<?php $operator = PyCore::import("operator");$builtins = PyCore::import("builtins");$Model = PyCore::import('modelscope.models')->Model;$pipeline = PyCore::import('modelscope.pipelines')->pipeline;$model = $Model->from_pretrained("damo/nlp_structbert_word-segmentation_chinese-base");$word_segmentation = $pipeline("word-segmentation", model: $model);$inputs = new PyList(["开源技术小栈作者是Tinywan,你知道不?", "webman这个框架不错,建议你看看"]);PyCore::print($word_segmentation($inputs));没有安装会提示:PHP Fatal error: Uncaught PyError: No module named 'cv2' in /home/www/build/ai/demo3.php:4

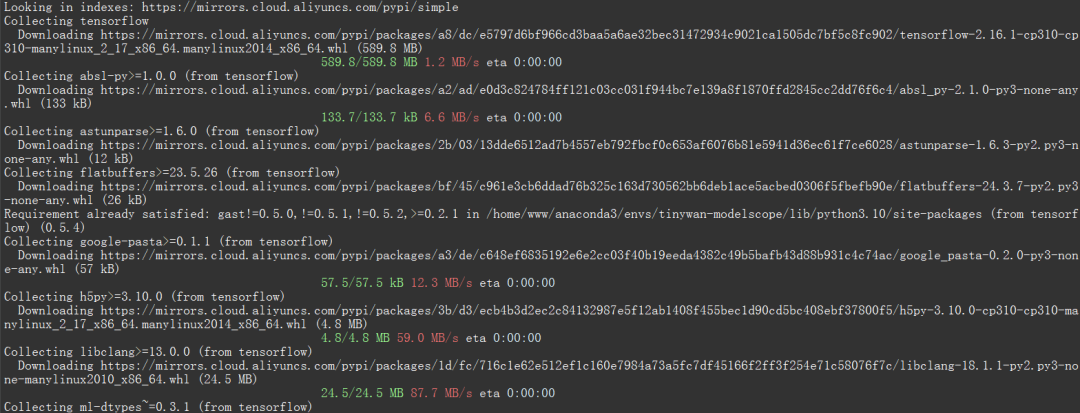

- 确保你已经安装深度学习框架包TensorFlow库

否则提示modelscope.pipelines.cv.image_matting_pipeline requires the TensorFlow library but it was not found in your environment. Checkout the instructions on the installation page: https://www.tensorflow.org/install and follow the ones that match your environment.。

报错信息表明,你正在尝试使用一个名为 modelscope.pipelines.cv.image_matting_pipeline 的模块,该模块依赖于 TensorFlow 库。然而,该模块无法正常工作,因为缺少必要的 TensorFlow 依赖。

可以使用以下命令安装最新版本的 TensorFlow

pip install tensorflow

图片

图片

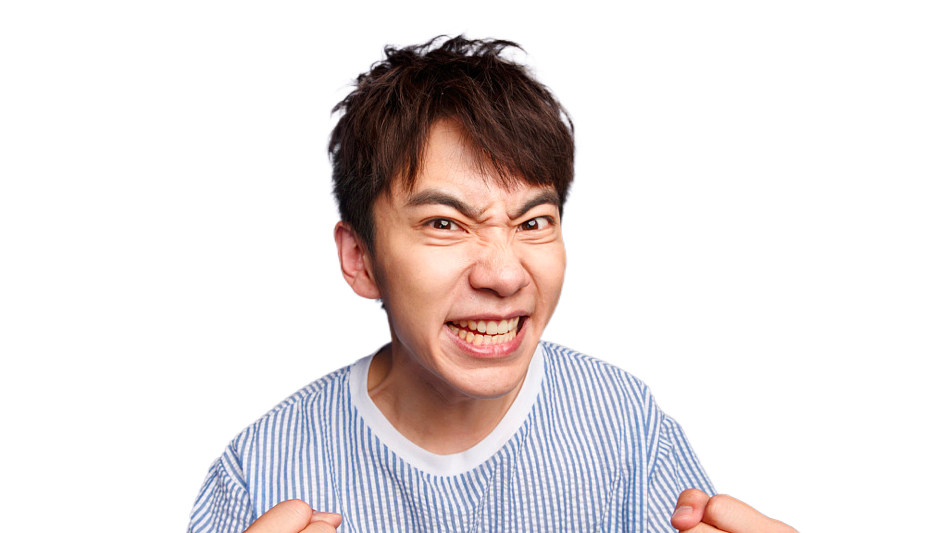

人像抠图('portrait-matting')

输入图片

图片

图片

Python 代码

import cv2from modelscope.pipelines import pipelineportrait_matting = pipeline('portrait-matting')result = portrait_matting('https://modelscope.oss-cn-beijing.aliyuncs.com/test/images/image_matting.png')cv2.imwrite('result.png', result['output_img'])PHP 代码 tinywan-images.php

<?php $operator = PyCore::import("operator");$builtins = PyCore::import("builtins");$cv2 = PyCore::import('cv2');$pipeline = PyCore::import('modelscope.pipelines')->pipeline;$portrait_matting = $pipeline("portrait-matting");$result = $portrait_matting("https://modelscope.oss-cn-beijing.aliyuncs.com/test/images/image_matting.png");$cv2->imwrite("tinywan_result.png", $result->__getitem__("output_img"));加载本地文件图片$result = $portrait_matting("./tinywan.png");

执行结果

/usr/local/php-8.2.14/bin/php tinywan-images.php 2024-03-25 22:17:25,630 - modelscope - INFO - PyTorch version 2.2.1 Found.2024-03-25 22:17:25,631 - modelscope - INFO - TensorFlow version 2.16.1 Found.2024-03-25 22:17:25,631 - modelscope - INFO - Loading ast index from /home/www/.cache/modelscope/ast_indexer2024-03-25 22:17:25,668 - modelscope - INFO - Loading done! Current index file version is 1.13.0, with md5 f54e9d2dceb89a6c989540d66db83a65 and a total number of 972 components indexed2024-03-25 22:17:26,990 - modelscope - WARNING - Model revision not specified, use revision: v1.0.02024-03-25 22:17:27.623085: I tensorflow/core/util/port.cc:113] oneDNN custom operations are on. You may see slightly different numerical results due to floating-point round-off errors from different computation orders. To turn them off, set the environment variable `TF_ENABLE_ONEDNN_OPTS=0`.2024-03-25 22:17:27.678592: I tensorflow/core/platform/cpu_feature_guard.cc:210] This TensorFlow binary is optimized to use available CPU instructions in performance-critical operations.To enable the following instructions: AVX2 AVX512F AVX512_VNNI FMA, in other operations, rebuild TensorFlow with the appropriate compiler flags.2024-03-25 22:17:28.551510: W tensorflow/compiler/tf2tensorrt/utils/py_utils.cc:38] TF-TRT Warning: Could not find TensorRT2024-03-25 22:17:29,206 - modelscope - INFO - initiate model from /home/www/.cache/modelscope/hub/damo/cv_unet_image-matting2024-03-25 22:17:29,206 - modelscope - INFO - initiate model from location /home/www/.cache/modelscope/hub/damo/cv_unet_image-matting.2024-03-25 22:17:29,209 - modelscope - WARNING - No preprocessor field found in cfg.2024-03-25 22:17:29,210 - modelscope - WARNING - No val key and type key found in preprocessor domain of configuration.json file.2024-03-25 22:17:29,210 - modelscope - WARNING - Cannot find available config to build preprocessor at mode inference, current config: {'model_dir': '/home/www/.cache/modelscope/hub/damo/cv_unet_image-matting'}. trying to build by task and model information.2024-03-25 22:17:29,210 - modelscope - WARNING - Find task: portrait-matting, model type: None. Insufficient information to build preprocessor, skip building preprocessorWARNING:tensorflow:From /home/www/anaconda3/envs/tinywan-modelscope/lib/python3.10/site-packages/modelscope/utils/device.py:60: is_gpu_available (from tensorflow.python.framework.test_util) is deprecated and will be removed in a future version.Instructions for updating:Use `tf.config.list_physical_devices('GPU')` instead.2024-03-25 22:17:29,213 - modelscope - INFO - loading model from /home/www/.cache/modelscope/hub/damo/cv_unet_image-matting/tf_graph.pbWARNING:tensorflow:From /home/www/anaconda3/envs/tinywan-modelscope/lib/python3.10/site-packages/modelscope/pipelines/cv/image_matting_pipeline.py:45: FastGFile.__init__ (from tensorflow.python.platform.gfile) is deprecated and will be removed in a future version.Instructions for updating:Use tf.gfile.GFile.2024-03-25 22:17:29,745 - modelscope - INFO - load model done输出图片

图片

图片

Das obige ist der detaillierte Inhalt vonTensorFlow Deep-Learning-Framework-Modell-Inferenzpipeline für Porträtausschnitt-Inferenz. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Lösung häufiger Pandas-Installationsprobleme: Interpretation und Lösungen für Installationsfehler

Feb 19, 2024 am 09:19 AM

Lösung häufiger Pandas-Installationsprobleme: Interpretation und Lösungen für Installationsfehler

Feb 19, 2024 am 09:19 AM

Pandas-Installations-Tutorial: Analyse häufiger Installationsfehler und ihrer Lösungen. Es sind spezifische Codebeispiele erforderlich. Einführung: Pandas ist ein leistungsstarkes Datenanalysetool, das in der Datenbereinigung, Datenverarbeitung und Datenvisualisierung weit verbreitet ist und daher in der Branche hohes Ansehen genießt der Datenwissenschaft. Aufgrund von Umgebungskonfigurations- und Abhängigkeitsproblemen können jedoch bei der Installation von Pandas einige Schwierigkeiten und Fehler auftreten. In diesem Artikel erhalten Sie ein Pandas-Installations-Tutorial und analysieren einige häufige Installationsfehler und deren Lösungen. 1. Pandas installieren

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Die 7 besten Linux-GPU-Überwachungs- und Diagnose-Befehlszeilentools

Feb 11, 2024 pm 08:48 PM

Die 7 besten Linux-GPU-Überwachungs- und Diagnose-Befehlszeilentools

Feb 11, 2024 pm 08:48 PM

Eine Grafikkarte ist eine spezielle Leiterplatte, mit der gesteuert wird, was auf einem Computermonitor angezeigt wird. Sie wird auch als Graphics Processing Unit (GPU) bezeichnet und berechnet 3D-Bilder und Grafiken für Linux-Spiele und andere Zwecke. Werfen wir einen Blick auf die sieben besten Linux-GPU-Überwachungs- und Diagnose-Befehlszeilentools zur Lösung Ihrer Probleme. Die folgenden Tools sind unter Linux für GPU-Überwachungs- und Diagnosezwecke sowie auf anderen Betriebssystemen wie FreeBSD verfügbar. Heutzutage verwenden die meisten Linux- und FreeBSD-Benutzer Nvidia-, Intel- und AMD-GPUs. LinuxGPU-Überwachungs- und Diagnose-Befehlszeilentools Mit den folgenden Tools können wir Linux- oder *BSD-basierte Systeme überwachen, diagnostizieren und prüfen. Grafik abrufen

Effiziente Installation: Tipps und Tricks zur schnellen Installation der Pandas-Bibliothek

Feb 21, 2024 am 09:45 AM

Effiziente Installation: Tipps und Tricks zur schnellen Installation der Pandas-Bibliothek

Feb 21, 2024 am 09:45 AM

Effiziente Installation: Tipps und Tricks für die schnelle Installation der Pandas-Bibliothek, die spezifische Codebeispiele erfordert. Übersicht: Pandas ist ein leistungsstarkes Datenverarbeitungs- und Analysetool, das bei Python-Entwicklern sehr beliebt ist. Allerdings kann die Installation der Pandas-Bibliothek manchmal mit einigen Herausforderungen verbunden sein, insbesondere wenn die Netzwerkbedingungen schlecht sind. In diesem Artikel werden einige Tipps und Tricks vorgestellt, die Ihnen bei der schnellen Installation der Pandas-Bibliothek helfen, und es werden spezifische Codebeispiele bereitgestellt. Mit pip installieren: pip ist der offizielle Paketmanager für Python

Anleitung zur Installation des Flask-Frameworks: Detaillierte Schritte, die Ihnen bei der korrekten Installation von Flask helfen

Feb 18, 2024 pm 10:51 PM

Anleitung zur Installation des Flask-Frameworks: Detaillierte Schritte, die Ihnen bei der korrekten Installation von Flask helfen

Feb 18, 2024 pm 10:51 PM

Tutorial zur Installation des Flask-Frameworks: Bringen Sie Ihnen Schritt für Schritt bei, wie Sie das Flask-Framework korrekt installieren. Einführung: Flask ist ein einfaches und flexibles Python-Webentwicklungs-Framework. Es ist leicht zu erlernen, benutzerfreundlich und voller leistungsstarker Funktionen. Dieser Artikel führt Sie Schritt für Schritt durch die korrekte Installation des Flask-Frameworks und stellt detaillierte Codebeispiele als Referenz bereit. Schritt 1: Python installieren Bevor Sie das Flask-Framework installieren, müssen Sie zunächst sicherstellen, dass Python auf Ihrem Computer installiert ist. Sie können bei P beginnen

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

In der heutigen Welle rasanter technologischer Veränderungen sind künstliche Intelligenz (KI), maschinelles Lernen (ML) und Deep Learning (DL) wie helle Sterne und führen die neue Welle der Informationstechnologie an. Diese drei Wörter tauchen häufig in verschiedenen hochaktuellen Diskussionen und praktischen Anwendungen auf, aber für viele Entdecker, die neu auf diesem Gebiet sind, sind ihre spezifische Bedeutung und ihre internen Zusammenhänge möglicherweise noch immer rätselhaft. Schauen wir uns also zunächst dieses Bild an. Es ist ersichtlich, dass zwischen Deep Learning, maschinellem Lernen und künstlicher Intelligenz ein enger Zusammenhang und eine fortschreitende Beziehung besteht. Deep Learning ist ein spezifischer Bereich des maschinellen Lernens und des maschinellen Lernens

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Fast 20 Jahre sind vergangen, seit das Konzept des Deep Learning im Jahr 2006 vorgeschlagen wurde. Deep Learning hat als Revolution auf dem Gebiet der künstlichen Intelligenz viele einflussreiche Algorithmen hervorgebracht. Was sind Ihrer Meinung nach die zehn besten Algorithmen für Deep Learning? Im Folgenden sind meiner Meinung nach die besten Algorithmen für Deep Learning aufgeführt. Sie alle nehmen hinsichtlich Innovation, Anwendungswert und Einfluss eine wichtige Position ein. 1. Hintergrund des Deep Neural Network (DNN): Deep Neural Network (DNN), auch Multi-Layer-Perceptron genannt, ist der am weitesten verbreitete Deep-Learning-Algorithmus. Als er erstmals erfunden wurde, wurde er aufgrund des Engpasses bei der Rechenleistung in Frage gestellt Jahre, Rechenleistung, Der Durchbruch kam mit der Datenexplosion. DNN ist ein neuronales Netzwerkmodell, das mehrere verborgene Schichten enthält. In diesem Modell übergibt jede Schicht Eingaben an die nächste Schicht und

Eine Anleitung zur Installation und Behebung häufiger Fehler in Scipy-Bibliotheken

Feb 18, 2024 am 10:53 AM

Eine Anleitung zur Installation und Behebung häufiger Fehler in Scipy-Bibliotheken

Feb 18, 2024 am 10:53 AM

Installationsanleitung für die Scipy-Bibliothek und häufige Fehlerlösungen Einführung: Scipy ist eine Open-Source-Bibliothek für wissenschaftliches Rechnen mit Python, die eine Fülle mathematischer, wissenschaftlicher und technischer Rechenfunktionen bietet. Es basiert auf der NumPy-Bibliothek und kann einige komplexe numerische Berechnungsprobleme lösen. In diesem Artikel wird die Scipy-Installationsanleitung vorgestellt, Lösungen für einige häufige Fehler bereitgestellt und spezifische Codebeispiele bereitgestellt, um den Lesern zu helfen, Scipy besser zu verstehen und zu verwenden. 1. Installationsanleitung für die Scipy-Bibliothek zur Installation von Python und Pi