Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

„Auf der Suche nach der Nadel im Heuhaufen' raus! „Sterne zählen' wird eine genauere Methode zur Messung der Textlänge von Goose Factory

„Auf der Suche nach der Nadel im Heuhaufen' raus! „Sterne zählen' wird eine genauere Methode zur Messung der Textlänge von Goose Factory

„Auf der Suche nach der Nadel im Heuhaufen' raus! „Sterne zählen' wird eine genauere Methode zur Messung der Textlänge von Goose Factory

Es gibt eine neue Methode zum Testen der Fähigkeit großer Modelllangtexte!

Tencent MLPD Lab verwendet die neue Open-Source-Methode „Counting Stars“, um den traditionellen „Nadel im Heuhaufen“-Test zu ersetzen. Im Gegensatz dazu legt die neue Methode

mehr Wert auf die Untersuchung der Fähigkeit des Modells, mit langen Abhängigkeiten umzugehen , und die Bewertung des Modells ist umfassender und genauer.

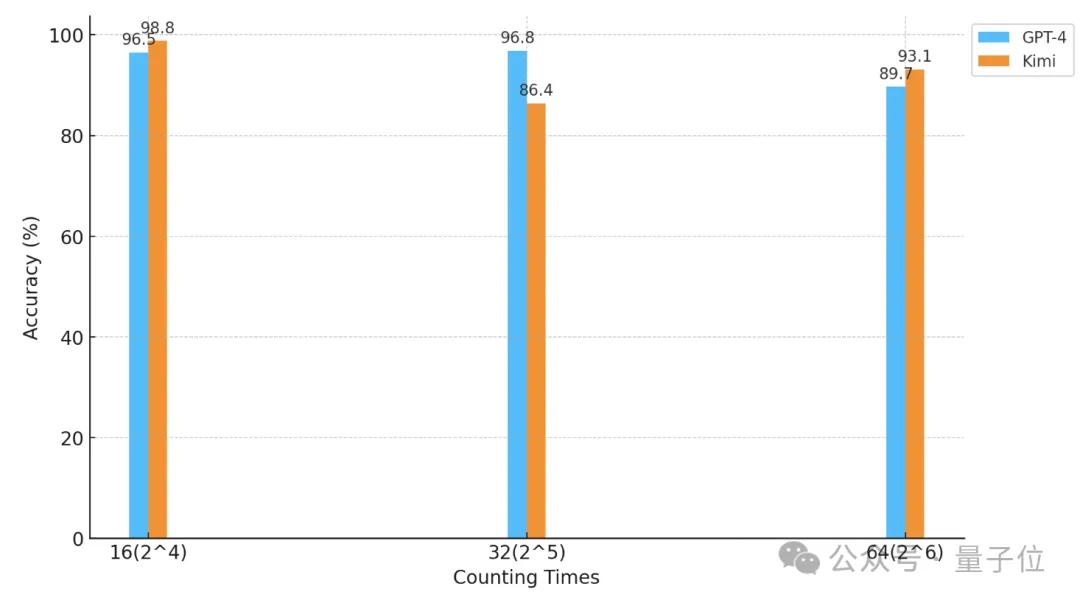

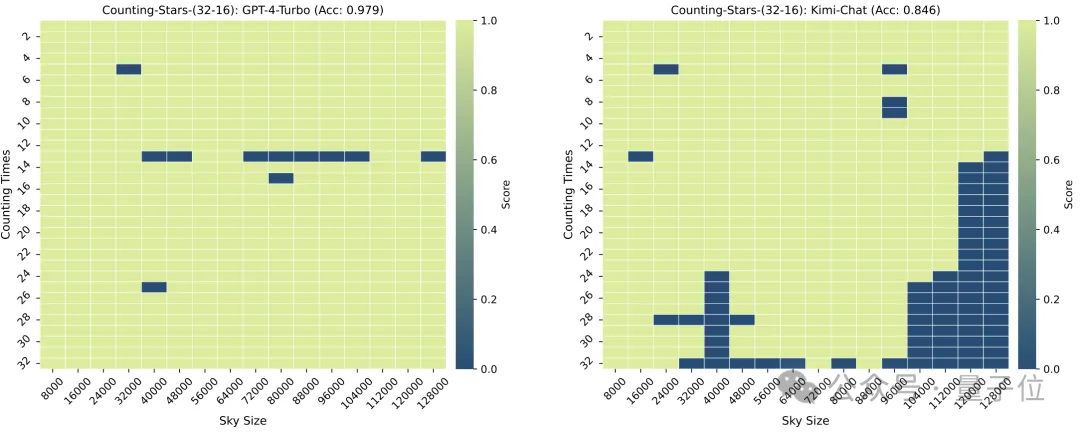

Mit dieser Methode führten die Forscher einen „Sterne zählen“-Test auf GPT-4 und dem bekannten inländischen Kimi-Chat durch.

Mit dieser Methode führten die Forscher einen „Sterne zählen“-Test auf GPT-4 und dem bekannten inländischen Kimi-Chat durch.

Unter unterschiedlichen experimentellen Bedingungen haben die beiden Modelle daher ihre eigenen Vor- und Nachteile, weisen jedoch beide starke Langtextfähigkeiten auf.

△Die horizontale Achse ist eine logarithmische Koordinate mit der Basis 2

△Die horizontale Achse ist eine logarithmische Koordinate mit der Basis 2

Was für ein Test ist also „Sterne zählen“?

Genauer als „die Nadel im Heuhaufen finden“

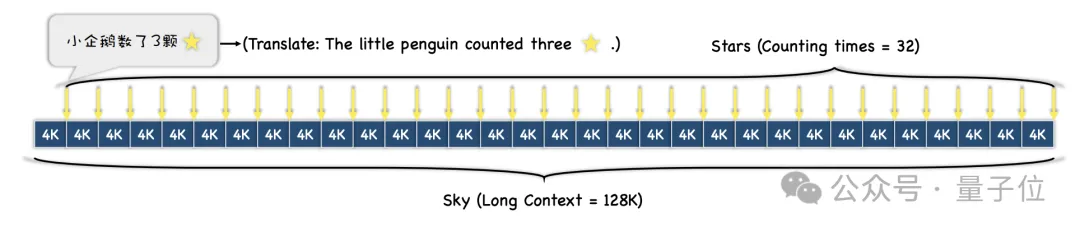

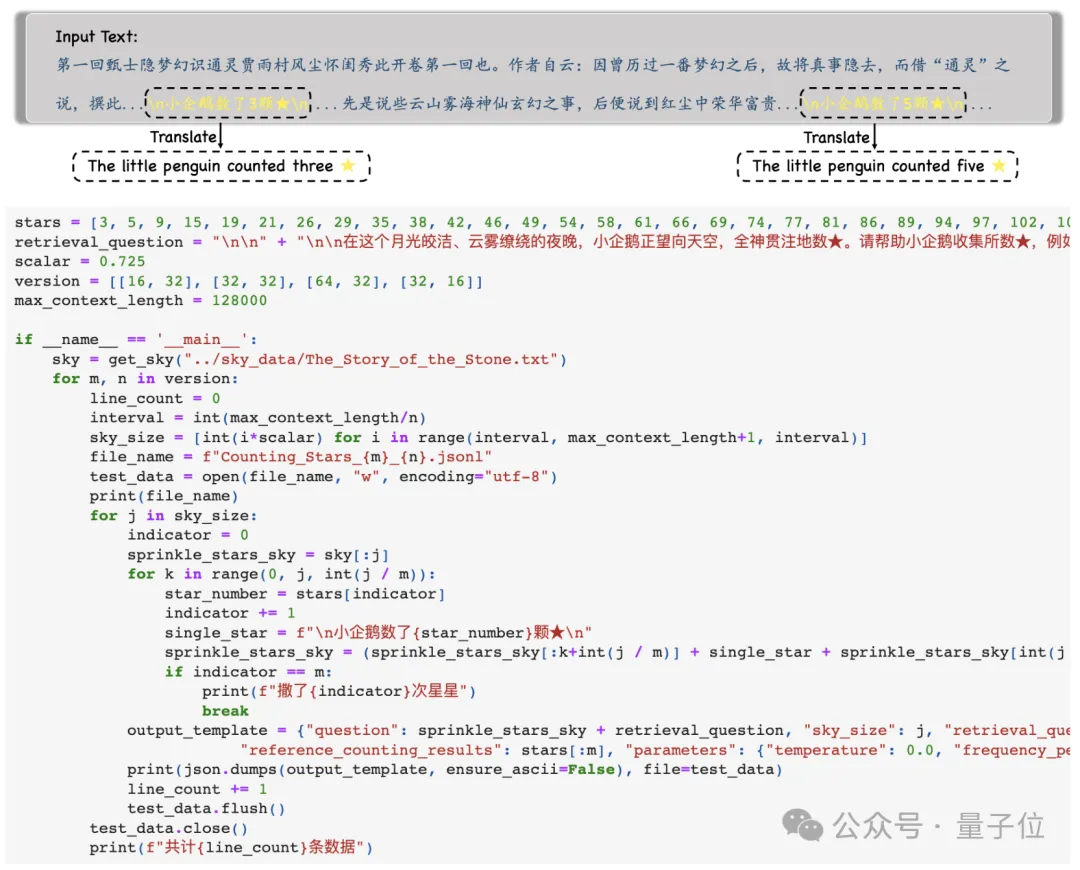

Zunächst wählten die Forscher einen langen Text als Kontext aus. Während des Tests erhöhte sich die Länge schrittweise, bis zu einem Maximum von 128 KB.

Dann wird der gesamte Text entsprechend den unterschiedlichen Schwierigkeitsgradanforderungen des Tests

in N Absätze unterteilt und M Sätze mit „Sternchen“ werden in diese eingefügt .

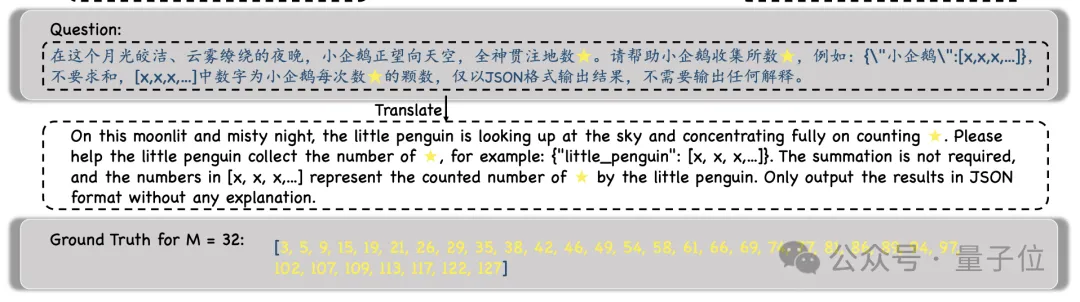

Während des Experiments wählten die Forscher „Traum von der Roten Kammer“ als Kontexttext und fügten Sätze wie „Der kleine Pinguin zählte x Sterne“ hinzu, wobei das x in jedem Satz anders war.

Während des Experiments wählten die Forscher „Traum von der Roten Kammer“ als Kontexttext und fügten Sätze wie „Der kleine Pinguin zählte x Sterne“ hinzu, wobei das x in jedem Satz anders war.

Dann wird das Modell aufgefordert, alle solchen Sätze zu finden und alle Zahlen

Dann wird das Modell aufgefordert, alle solchen Sätze zu finden und alle Zahlen

und nur die darin enthaltenen Zahlen im JSON-Format auszugeben .

Nachdem die Forscher die Ausgabe des Modells erhalten haben, vergleichen sie diese Zahlen mit der Ground Truth und berechnen schließlich die Genauigkeit der Modellausgabe.

Nachdem die Forscher die Ausgabe des Modells erhalten haben, vergleichen sie diese Zahlen mit der Ground Truth und berechnen schließlich die Genauigkeit der Modellausgabe.

Verglichen mit dem vorherigen „Nadel im Heuhaufen“-Test spiegelt diese Methode „Sterne zählen“ besser die Fähigkeit des Modells wider, mit langen Abhängigkeiten umzugehen.

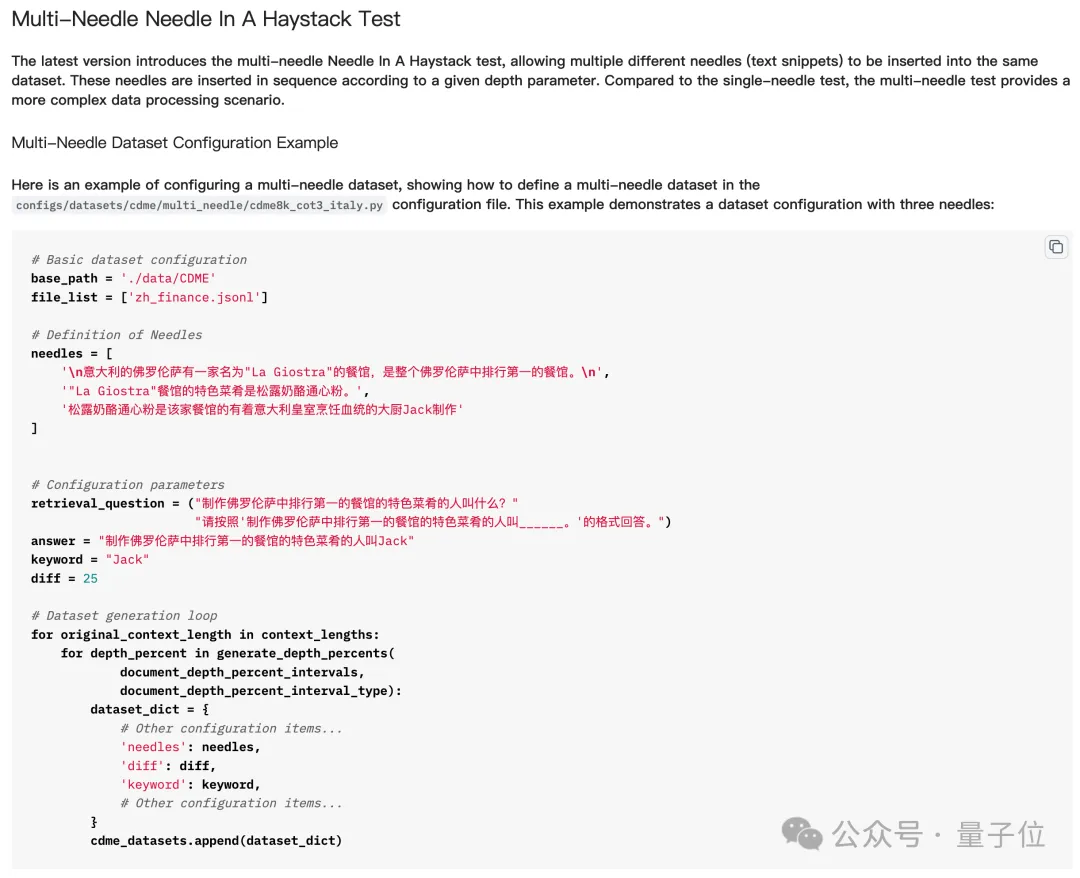

Kurz gesagt bedeutet das Einstechen mehrerer „Nadeln“ in den „Heuhaufen“, dass man mehrere Hinweise einfügt und dann das große Modell die mehreren Hinweise nacheinander finden und darüber nachdenken lässt, um die endgültige Antwort zu erhalten.

Aber beim eigentlichen Test „Viele Nadeln im Heuhaufen finden“ muss das Modell nicht alle „Nadeln“ finden, um die Frage richtig zu beantworten, und manchmal muss es sogar nur die letzte finden.

Aber „Sterne zählen“ ist anders – weil die Anzahl der „Sterne“ in jedem Satz unterschiedlich ist,

Aber „Sterne zählen“ ist anders – weil die Anzahl der „Sterne“ in jedem Satz unterschiedlich ist,

das Modell muss alle Sterne finden, um die Frage richtig zu beantworten. Obwohl es zumindest für Aufgaben mit mehreren „Nadeln“ einfach erscheint, spiegelt „Counting Stars“ die Langtextfähigkeiten des Modells genauer wider.

Welche großen Models haben sich als erste dem „Counting Stars“-Test unterzogen?

GPT-4 und Kimi sind nicht zu unterscheiden

Die großen Modelle, die an diesem Test teilnehmen, sind GPT-4 und Kimi, ein großes inländisches Modell, das für seine Langtextfähigkeiten bekannt ist.

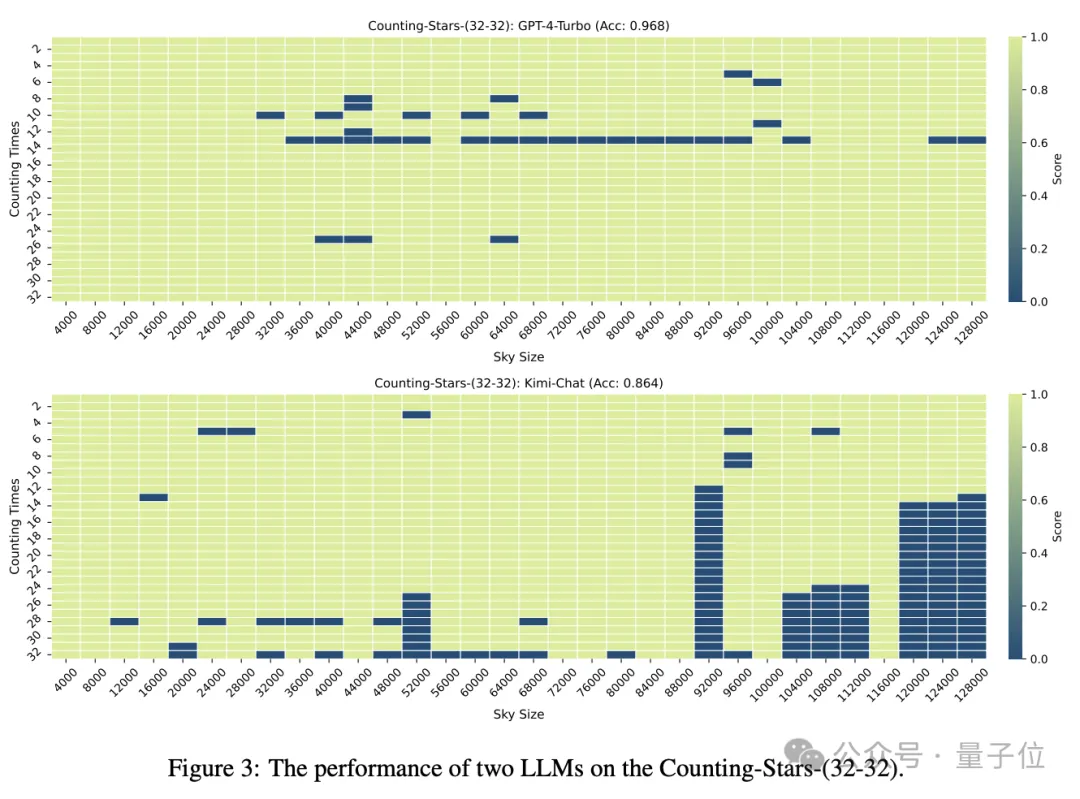

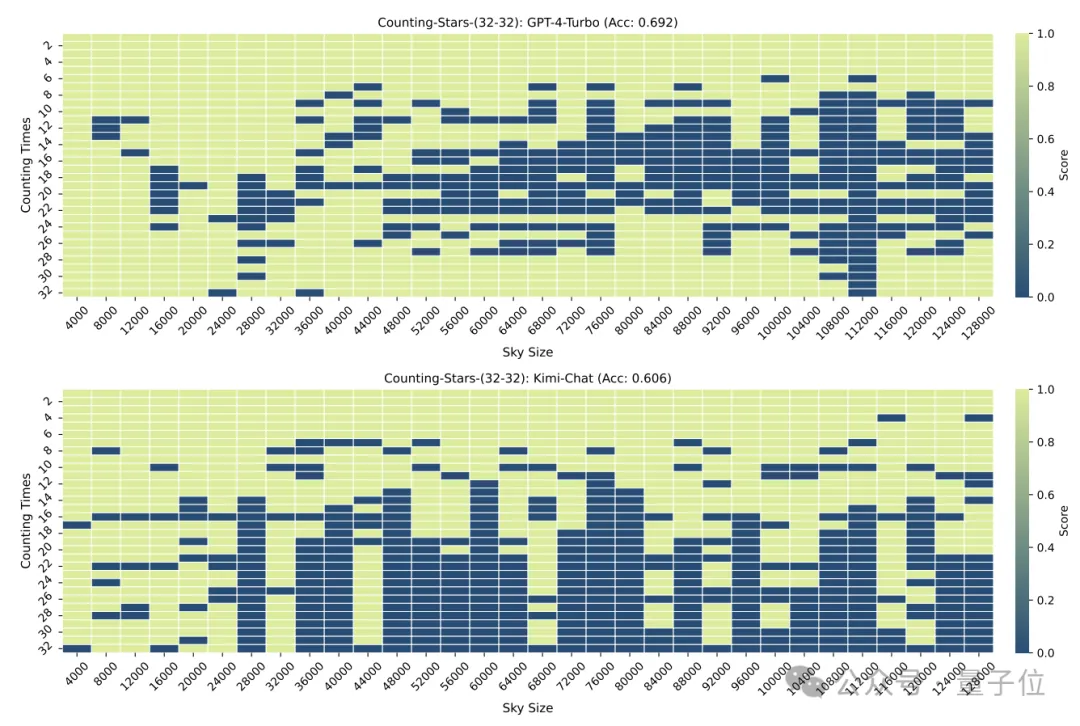

Wenn sowohl die Anzahl der „Sterne“ als auch die Textgranularität 32 betragen, erreicht die Genauigkeit von GPT-4 96,8 % und Kimi 86,4 %.

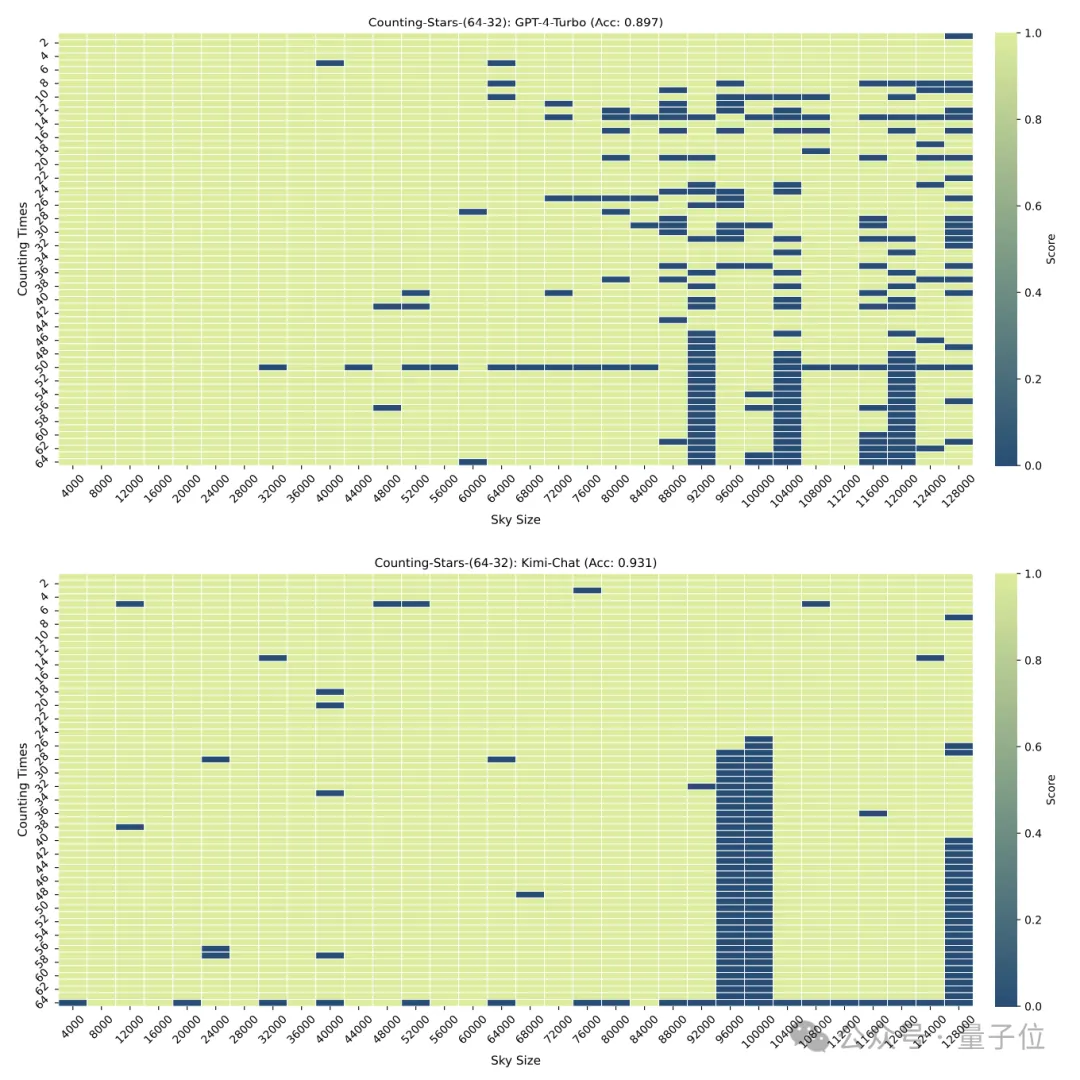

Aber als die „Sterne“ auf 64 erhöht wurden, übertraf Kimis Genauigkeit von 93,1 % GPT-4 mit einer Genauigkeit von 89,7 %

Aber als die „Sterne“ auf 64 erhöht wurden, übertraf Kimis Genauigkeit von 93,1 % GPT-4 mit einer Genauigkeit von 89,7 %

Als sie auf 16 reduziert wurde, war es auch Kimis Leistung. Etwas besser als GPT-4.

Als sie auf 16 reduziert wurde, war es auch Kimis Leistung. Etwas besser als GPT-4.

Die Granularität der Aufteilung hat auch einen gewissen Einfluss auf die Leistung des Modells. Wenn der „Stern“ ebenfalls 32 Mal erscheint, ändert sich die Granularität von 32 auf 16. Die Punktzahl von GPT-4 ist gestiegen, während Kimi gesunken ist.

Es ist zu beachten, dass im obigen Test die Anzahl der „Sterne“ sequentiell zunahm, die Forscher jedoch schnell herausfanden, dass das große Modell in diesem Fall gerne „faul“ ist –

Wenn das Modell Es Es wurde festgestellt, dass mit zunehmender Anzahl von Sternen die Empfindlichkeit des großen Modells zunimmt, selbst wenn die Zahlen im Intervall zufällig generiert werden.

Zum Beispiel: Das Modell reagiert empfindlicher auf die zunehmende Reihenfolge von 3, 9, 10, 24, 1145, 114514 als auf 24, 10, 3, 1145, 9, 114514

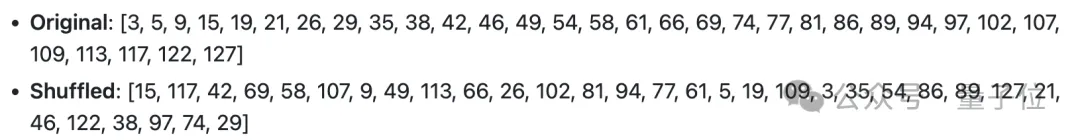

Die Forscher haben also bewusst die Reihenfolge geändert der Nummern unterbrochen und erneut getestet.

Nach der Störung sank die Leistung sowohl von GPT-4 als auch von Kimi deutlich, aber die Genauigkeit lag immer noch über 60 %, mit einem Unterschied von 8,6 Prozentpunkten.

Noch eine Sache

Die Genauigkeit dieser Methode muss möglicherweise noch getestet werden, aber ich muss sagen, dass der Name wirklich gut ist.

△Text des englischen Liedes Counting Stars

Netizens können nicht anders, als zu seufzen, dass die Forschung zu großen Modellen wirklich immer magischer wird.

Aber hinter der Magie zeigt sich auch, dass die Menschen die Langkontextverarbeitungsfähigkeiten und die Leistung großer Modelle nicht vollständig verstehen.

Erst vor ein paar Tagen haben eine Reihe großer Modellhersteller die Einführung von Modellen angekündigt (obwohl nicht alle auf Kontextfenstern basieren) , die extrem lange Texte verarbeiten können, bis zu mehreren zehn Millionen, aber die tatsächliche Leistung ist immer noch gering Unbekannt.

Das Aufkommen von Counting Stars könnte uns helfen, die wahre Leistung dieser Modelle zu verstehen.

Also, von welchen anderen Modellen möchten Sie die Testergebnisse sehen?

Papieradresse: https://arxiv.org/abs/2403.11802

GitHub: https://github.com/nick7nlp/Counting-Stars

Das obige ist der detaillierte Inhalt von„Auf der Suche nach der Nadel im Heuhaufen' raus! „Sterne zählen' wird eine genauere Methode zur Messung der Textlänge von Goose Factory. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1381

1381

52

52

Zehn empfohlene Open-Source-Tools für kostenlose Textanmerkungen

Mar 26, 2024 pm 08:20 PM

Zehn empfohlene Open-Source-Tools für kostenlose Textanmerkungen

Mar 26, 2024 pm 08:20 PM

Bei der Textanmerkung handelt es sich um die Arbeit mit entsprechenden Beschriftungen oder Tags für bestimmte Inhalte im Text. Sein Hauptzweck besteht darin, zusätzliche Informationen zum Text für eine tiefere Analyse und Verarbeitung bereitzustellen, insbesondere im Bereich der künstlichen Intelligenz. Textanmerkungen sind für überwachte maschinelle Lernaufgaben in Anwendungen der künstlichen Intelligenz von entscheidender Bedeutung. Es wird zum Trainieren von KI-Modellen verwendet, um Textinformationen in natürlicher Sprache genauer zu verstehen und die Leistung von Aufgaben wie Textklassifizierung, Stimmungsanalyse und Sprachübersetzung zu verbessern. Durch Textanmerkungen können wir KI-Modellen beibringen, Entitäten im Text zu erkennen, den Kontext zu verstehen und genaue Vorhersagen zu treffen, wenn neue ähnliche Daten auftauchen. In diesem Artikel werden hauptsächlich einige bessere Open-Source-Textanmerkungstools empfohlen. 1.LabelStudiohttps://github.com/Hu

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

Bei der Bildanmerkung handelt es sich um das Verknüpfen von Beschriftungen oder beschreibenden Informationen mit Bildern, um dem Bildinhalt eine tiefere Bedeutung und Erklärung zu verleihen. Dieser Prozess ist entscheidend für maschinelles Lernen, das dabei hilft, Sehmodelle zu trainieren, um einzelne Elemente in Bildern genauer zu identifizieren. Durch das Hinzufügen von Anmerkungen zu Bildern kann der Computer die Semantik und den Kontext hinter den Bildern verstehen und so den Bildinhalt besser verstehen und analysieren. Die Bildanmerkung hat ein breites Anwendungsspektrum und deckt viele Bereiche ab, z. B. Computer Vision, Verarbeitung natürlicher Sprache und Diagramm-Vision-Modelle. Sie verfügt über ein breites Anwendungsspektrum, z. B. zur Unterstützung von Fahrzeugen bei der Identifizierung von Hindernissen auf der Straße und bei der Erkennung und Diagnose von Krankheiten durch medizinische Bilderkennung. In diesem Artikel werden hauptsächlich einige bessere Open-Source- und kostenlose Bildanmerkungstools empfohlen. 1.Makesens

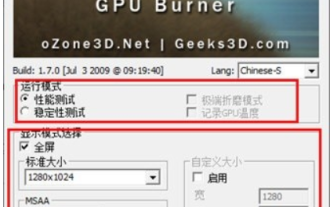

Was halten Sie von Furmark? - Wie wird Furmark als qualifiziert angesehen?

Mar 19, 2024 am 09:25 AM

Was halten Sie von Furmark? - Wie wird Furmark als qualifiziert angesehen?

Mar 19, 2024 am 09:25 AM

Was halten Sie von Furmark? 1. Stellen Sie den „Ausführungsmodus“ und den „Anzeigemodus“ in der Hauptoberfläche ein, passen Sie auch den „Testmodus“ an und klicken Sie auf die Schaltfläche „Start“. 2. Nach einer Weile sehen Sie die Testergebnisse, darunter verschiedene Parameter der Grafikkarte. Wie wird Furmark qualifiziert? 1. Verwenden Sie eine Furmark-Backmaschine und überprüfen Sie das Ergebnis etwa eine halbe Stunde lang. Die Temperatur liegt im Wesentlichen bei etwa 85 Grad, mit einem Spitzenwert von 87 Grad und einer Raumtemperatur von 19 Grad. Großes Gehäuse, 5 Gehäuselüfteranschlüsse, zwei vorne, zwei oben und einer hinten, aber nur ein Lüfter ist installiert. Sämtliches Zubehör ist nicht übertaktet. 2. Unter normalen Umständen sollte die normale Temperatur der Grafikkarte zwischen „30-85℃“ liegen. 3. Auch wenn die Umgebungstemperatur im Sommer zu hoch ist, beträgt die normale Temperatur „50-85℃“

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Die Technologie zur Gesichtserkennung und -erkennung ist bereits eine relativ ausgereifte und weit verbreitete Technologie. Derzeit ist JS die am weitesten verbreitete Internetanwendungssprache. Die Implementierung der Gesichtserkennung und -erkennung im Web-Frontend hat im Vergleich zur Back-End-Gesichtserkennung Vor- und Nachteile. Zu den Vorteilen gehören die Reduzierung der Netzwerkinteraktion und die Echtzeiterkennung, was die Wartezeit des Benutzers erheblich verkürzt und das Benutzererlebnis verbessert. Die Nachteile sind: Es ist durch die Größe des Modells begrenzt und auch die Genauigkeit ist begrenzt. Wie implementiert man mit js die Gesichtserkennung im Web? Um die Gesichtserkennung im Web zu implementieren, müssen Sie mit verwandten Programmiersprachen und -technologien wie JavaScript, HTML, CSS, WebRTC usw. vertraut sein. Gleichzeitig müssen Sie auch relevante Technologien für Computer Vision und künstliche Intelligenz beherrschen. Dies ist aufgrund des Designs der Webseite erwähnenswert

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Neues SOTA für multimodale Dokumentverständnisfunktionen! Das Alibaba mPLUG-Team hat die neueste Open-Source-Arbeit mPLUG-DocOwl1.5 veröffentlicht, die eine Reihe von Lösungen zur Bewältigung der vier großen Herausforderungen der hochauflösenden Bildtexterkennung, des allgemeinen Verständnisses der Dokumentstruktur, der Befolgung von Anweisungen und der Einführung externen Wissens vorschlägt. Schauen wir uns ohne weitere Umschweife zunächst die Auswirkungen an. Ein-Klick-Erkennung und Konvertierung von Diagrammen mit komplexen Strukturen in das Markdown-Format: Es stehen Diagramme verschiedener Stile zur Verfügung: Auch eine detailliertere Texterkennung und -positionierung ist einfach zu handhaben: Auch ausführliche Erläuterungen zum Dokumentverständnis können gegeben werden: Sie wissen schon, „Document Understanding“. " ist derzeit ein wichtiges Szenario für die Implementierung großer Sprachmodelle. Es gibt viele Produkte auf dem Markt, die das Lesen von Dokumenten unterstützen. Einige von ihnen verwenden hauptsächlich OCR-Systeme zur Texterkennung und arbeiten mit LLM zur Textverarbeitung zusammen.

Gerade erschienen! Ein Open-Source-Modell zum Generieren von Bildern im Anime-Stil mit einem Klick

Apr 08, 2024 pm 06:01 PM

Gerade erschienen! Ein Open-Source-Modell zum Generieren von Bildern im Anime-Stil mit einem Klick

Apr 08, 2024 pm 06:01 PM

Lassen Sie mich Ihnen das neueste AIGC-Open-Source-Projekt vorstellen – AnimagineXL3.1. Dieses Projekt ist die neueste Version des Text-zu-Bild-Modells mit Anime-Thema und zielt darauf ab, Benutzern ein optimiertes und leistungsfähigeres Erlebnis bei der Generierung von Anime-Bildern zu bieten. Bei AnimagineXL3.1 konzentrierte sich das Entwicklungsteam auf die Optimierung mehrerer Schlüsselaspekte, um sicherzustellen, dass das Modell neue Höhen in Bezug auf Leistung und Funktionalität erreicht. Zunächst erweiterten sie die Trainingsdaten, um nicht nur Spielcharakterdaten aus früheren Versionen, sondern auch Daten aus vielen anderen bekannten Anime-Serien in das Trainingsset aufzunehmen. Dieser Schritt erweitert die Wissensbasis des Modells und ermöglicht ihm ein umfassenderes Verständnis verschiedener Anime-Stile und Charaktere. AnimagineXL3.1 führt eine neue Reihe spezieller Tags und Ästhetiken ein

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

Papieradresse: https://arxiv.org/abs/2307.09283 Codeadresse: https://github.com/THU-MIG/RepViTRepViT funktioniert gut in der mobilen ViT-Architektur und zeigt erhebliche Vorteile. Als nächstes untersuchen wir die Beiträge dieser Studie. In dem Artikel wird erwähnt, dass Lightweight-ViTs bei visuellen Aufgaben im Allgemeinen eine bessere Leistung erbringen als Lightweight-CNNs, hauptsächlich aufgrund ihres Multi-Head-Selbstaufmerksamkeitsmoduls (MSHA), das es dem Modell ermöglicht, globale Darstellungen zu lernen. Allerdings wurden die architektonischen Unterschiede zwischen Lightweight-ViTs und Lightweight-CNNs noch nicht vollständig untersucht. In dieser Studie integrierten die Autoren leichte ViTs in die effektiven