Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ein voller Durchbruch: Google hat gestern Abend eine große Anzahl großer Modellprodukte aktualisiert

Ein voller Durchbruch: Google hat gestern Abend eine große Anzahl großer Modellprodukte aktualisiert

Ein voller Durchbruch: Google hat gestern Abend eine große Anzahl großer Modellprodukte aktualisiert

An diesem Dienstag hat Google auf Googles Cloud Next 2024 eine Reihe von KI-bezogenen Modellaktualisierungen und -produkten veröffentlicht, darunter Gemini 1.5 Pro, das erstmals eine Funktion zum lokalen Sprachverstehen bietet, und das neue Codegenerierungsmodell CodeGemma Selbst entwickelter Arm-Prozessor Axion und so weiter.

Gemini 1.5 Pro

Gemini 1.5 Pro, Googles leistungsstärkstes generatives KI-Modell, ist jetzt in der öffentlichen Vorschau auf Vertex AI, der unternehmensorientierten KI-Entwicklungsplattform von Google, verfügbar. Dies ist Googles KI-Entwicklungsplattform für Unternehmen. Der Kontext, den es verarbeiten kann, steigt von 128.000 Token auf 1 Million Token. Eine Million Token entspricht etwa 700.000 Wörtern oder etwa 30.000 Codezeilen. Das ist etwa das Vierfache der Datenmenge, die Anthropics Flaggschiffmodell Claude 3 als Eingabe verarbeiten kann, und etwa das Achtfache der maximalen Kontextmenge von OpenAIs GPT-4 Turbo.

Offizieller Originaltext-Link: https://developers.googleblog.com/2024/04/gemini-15-pro-in-public-preview-with-new-features.html

Das Version Zum ersten Mal werden lokale Audio-(Sprach-)Verständnisfunktionen und eine neue Datei-API bereitgestellt, um die Dateiverarbeitung zu vereinfachen. Die Eingabemodi von Gemini 1.5 Pro werden um Audio-(Sprach-)Verstehen in der Gemini API und Google AI Studio erweitert. Darüber hinaus ist Gemini 1.5 Pro jetzt in der Lage, Rückschlüsse auf die Bilder (Frames) und Audiodaten (Sprache) von in Google AI Studio hochgeladenen Videos zu ziehen.

Sie können eine Aufzeichnung einer Vorlesung hochladen, wie zum Beispiel dieser Vorlesung mit über 117.000 Token von Jeff Dean, und Gemini 1.5 Pro kann sie in einen Test mit Antworten umwandeln. (Demo wurde beschleunigt)

Google hat auch Verbesserungen an der Gemini-API vorgenommen, die hauptsächlich die folgenden drei Inhalte umfassen:

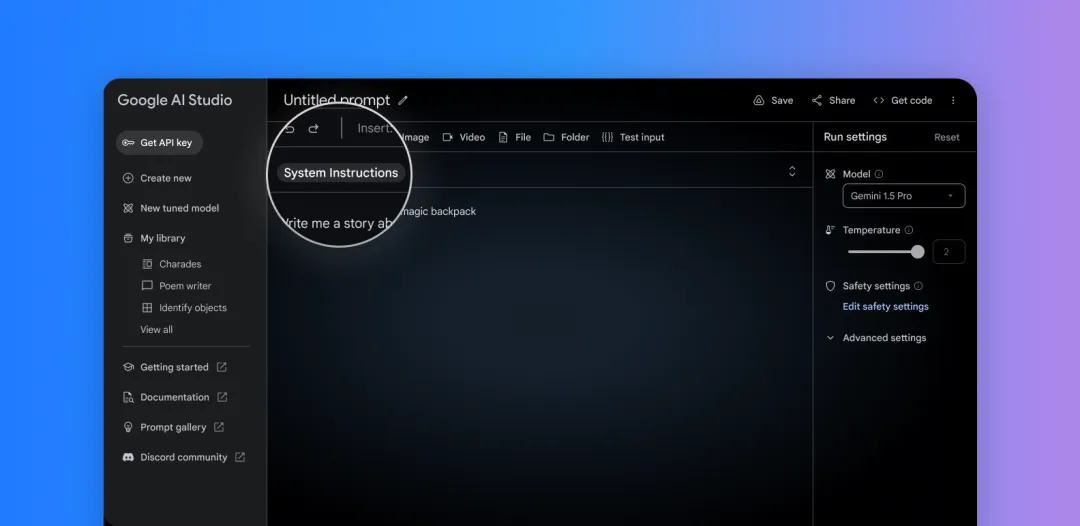

Derzeit können Systembefehle in Google AI Studio und der Gemini-API verwendet werden, um die Reaktion des Modells zu steuern . Definieren Sie Rollen, Formate, Ziele und Regeln, um das Verhalten des Modells für Ihre spezifischen Anwendungsfälle zu steuern.

Einfaches Festlegen von Systembefehlen in Google AI Studio

2. Weisen Sie das Modell an, nur JSON-Objekte auszugeben. Dieses Muster ermöglicht es, strukturierte Daten aus Texten oder Bildern zu extrahieren. cURL ist jetzt verfügbar, die Unterstützung für das Python SDK folgt in Kürze.

3. Verbesserungen an Funktionsaufrufen: Jetzt können Sie Modi auswählen, um die Ausgabe des Modells zu begrenzen und die Zuverlässigkeit zu verbessern. Wählen Sie Text, Funktionsaufrufe oder einfach nur die Funktion selbst aus.

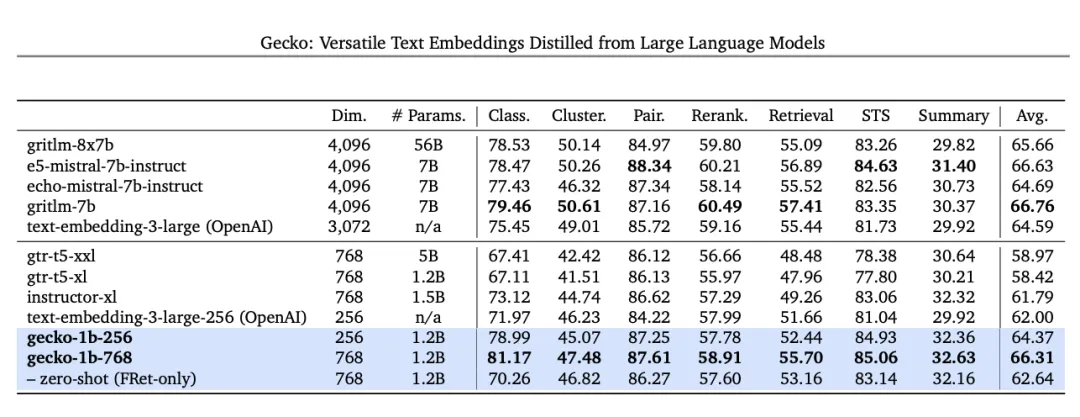

Darüber hinaus wird Google ein Texteinbettungsmodell der nächsten Generation veröffentlichen, das ähnliche Modelle übertrifft. Ab heute können Entwickler über die Gemini-API auf Texteinbettungsmodelle der nächsten Generation zugreifen. Dieses neue Modell, text-embedding-004 (text-embedding-preview-0409 in Vertex AI), erreicht eine stärkere Abrufleistung beim MTEB-Benchmark und übertrifft bestehende Modelle mit vergleichbaren Abmessungen.

Im MTEB-Benchmark übertraf Text-embedding-004 (auch bekannt als Gecko) mit einer Ausgabe von 256 Dims alle größeren Modelle mit einer Ausgabe von 768 Dims.

Es ist jedoch zu beachten, dass Gemini 1.5 Pro nicht verfügbar ist diejenigen ohne Zugriff auf Vertex AI und AI Studio. Derzeit interagieren die meisten Menschen über den Gemini-Chatbot mit Gemini-Sprachmodellen. Gemini Ultra unterstützt den Gemini Advanced-Chatbot. Er ist zwar leistungsstark und kann lange Befehle verstehen, ist aber nicht so schnell wie Gemini 1.5 Pro.

Drei wichtige Open-Source-Tools

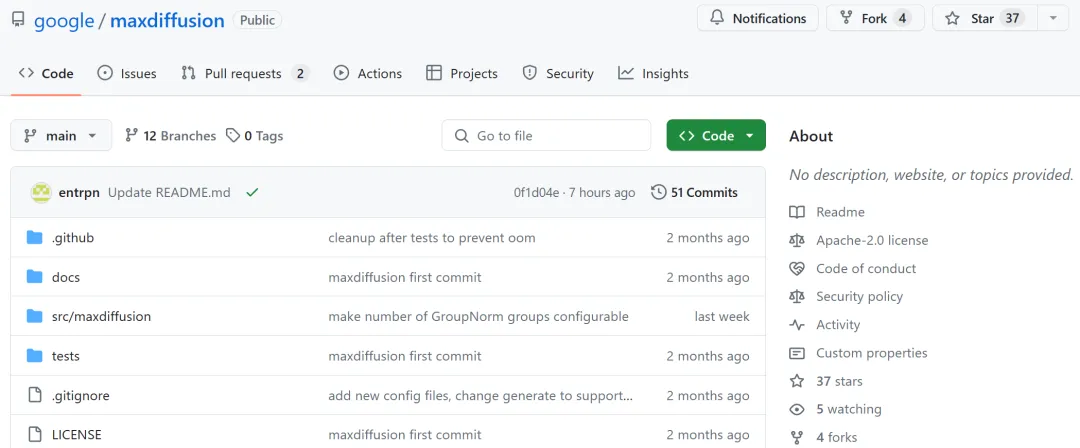

Auf der Google Cloud Next-Konferenz im Jahr 2024 stellte das Unternehmen mehrere Open-Source-Tools vor, hauptsächlich zur Unterstützung generativer KI-Projekte und -Infrastruktur. Eine davon ist Max Diffusion, eine Sammlung von Referenzimplementierungen verschiedener Diffusionsmodelle, die auf XLA-Geräten (Accelerated Linear Algebra) laufen.

GitHub-Adresse: https://github.com/google/maxdiffusion

Die zweite ist Jetstream, eine neue Engine zum Ausführen generativer KI-Modelle. Derzeit unterstützt JetStream nur TPU, wird aber möglicherweise in Zukunft mit GPU kompatibel sein. Google behauptet, dass JetStream bis zu dreimal so viel Preis-Leistungs-Verhältnis bieten kann wie Modelle wie Googles eigenes Gemma 7B und Metas Llama 2.

GitHub-Adresse: https://github.com/google/JetStream

Der dritte ist MaxTest, ein Textgenerierungs-KI-Modell für TPUs und Nvidia-GPUs in der Cloud-Sammlung . MaxText umfasst jetzt Gemma 7B, GPT-3 von OpenAI, Llama 2 und Modelle des KI-Startups Mistral, die laut Google alle individuell angepasst und an die Bedürfnisse der Entwickler angepasst werden können.

GitHub-Adresse: https://github.com/google/maxtext

Der erste selbst entwickelte Arm-Prozessor Axion

Google Cloud hat den Start seines ersten selbst entwickelten Arm-Prozessors angekündigt. entwickelter Arm-Prozessor Arm-Prozessor namens Axion. Es basiert auf Arms Neoverse 2 und ist für Rechenzentren konzipiert. Laut Google sind seine Axion-Instanzen 30 % leistungsfähiger als andere Arm-basierte Instanzen von Wettbewerbern wie AWS und Microsoft und bis zu 50 % leistungsstärker und 60 % energieeffizienter als entsprechende X86-basierte Instanzen.

Google betonte während der Einführungsveranstaltung am Dienstag, dass Google Cloud-Kunden ihre vorhandenen Arm-Workloads ohne Änderungen in Google Cloud übertragen können, da Axion auf einer offenen Grundlage aufbaut.

Allerdings hat Google noch keine detaillierte Einführung dazu veröffentlicht.

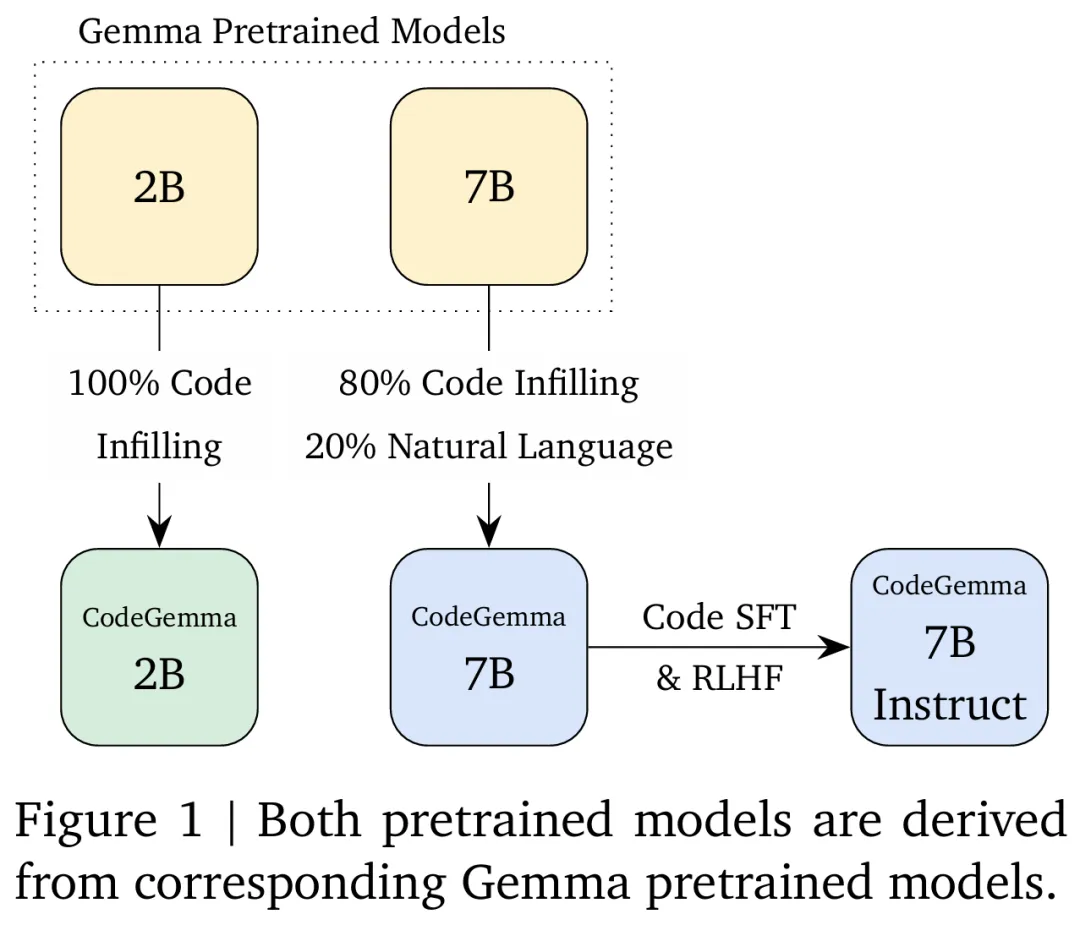

Tool zur Codevervollständigung und -generierung – CodeGemma

CodeGemma basiert auf dem Gemma-Modell und stellt der Community leistungsstarke und leichte Codierungsfunktionen zur Verfügung. Das Modell kann in eine vorab trainierte 7B-Variante unterteilt werden, die speziell Aufgaben zur Codevervollständigung und Codegenerierung übernimmt, eine auf Befehle abgestimmte 7B-Variante für Code-Chat und Befehlsfolge und eine vorab trainierte 2B-Variante, die eine schnelle Codevervollständigung auf der lokalen Ebene ausführt Computervarianten.

CodeGemma bietet die folgenden großen Vorteile:

- Intelligente Codevervollständigung und -generierung: Vervollständigen Sie Zeilen, Funktionen und generieren Sie sogar ganze Codeblöcke, unabhängig davon, ob Sie lokal oder in der Cloud arbeiten;

- Höhere Genauigkeit: CodeGemma verwendet hauptsächlich englischsprachige Daten von 500 Milliarden Token aus Online-Dokumenten, Mathematik und Codes für das Training. Der generierte Code ist nicht nur grammatikalisch korrekter, sondern auch semantisch aussagekräftiger, was dazu beiträgt, Fehler und Debugging-Zeiten zu reduzieren

- Mehrsprachige Funktionen: Unterstützt Python, JavaScript, Java und andere gängige Programmiersprachen;

- Vereinfachter Arbeitsablauf: Integrieren Sie CodeGemma in Ihre Entwicklungsumgebung, um weniger Standardcode zu schreiben und schneller zu arbeiten. Schreiben Sie Code, der wichtig, interessant und interessant ist unterscheidet. Einige Vergleichsergebnisse zwischen

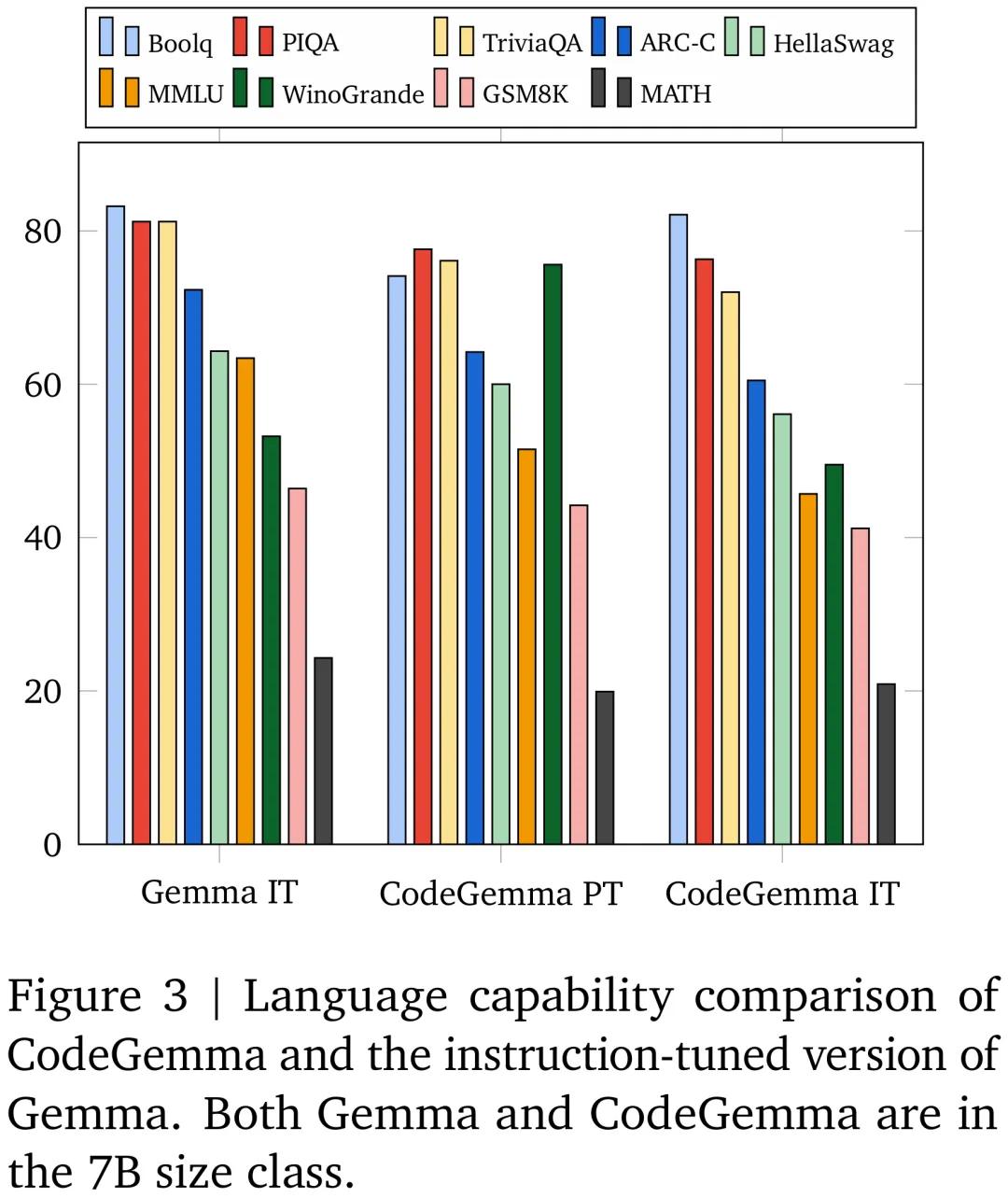

CodeGemma und anderen gängigen Code-Großmodellen sind in der folgenden Abbildung dargestellt:

Vergleichsergebnisse zwischen dem CodeGemma 7B-Modell und dem Gemma 7B-Modell für GSM8K, MATH und andere Datensätze.

Weitere technische Details und experimentelle Ergebnisse finden Sie in dem gleichzeitig von Google veröffentlichten Artikel.

Papieradresse: https://storage.googleapis.com/deepmind-media/gemma/codegemma_report.pdf

Offenes Sprachmodell – RecurrentGemma

Google DeepMind hat auch eine Reihe offener Sprachmodelle veröffentlicht – RecurrentGemma. RecurrentGemma basiert auf der Griffin-Architektur, die eine schnelle Inferenz bei der Generierung langer Sequenzen ermöglicht, indem die globale Aufmerksamkeit durch eine Mischung aus lokaler Aufmerksamkeit und linearen Wiederholungen ersetzt wird.

Technischer Bericht: https://storage.googleapis.com/deepmind-media/gemma/recurrentgemma-report.pdf

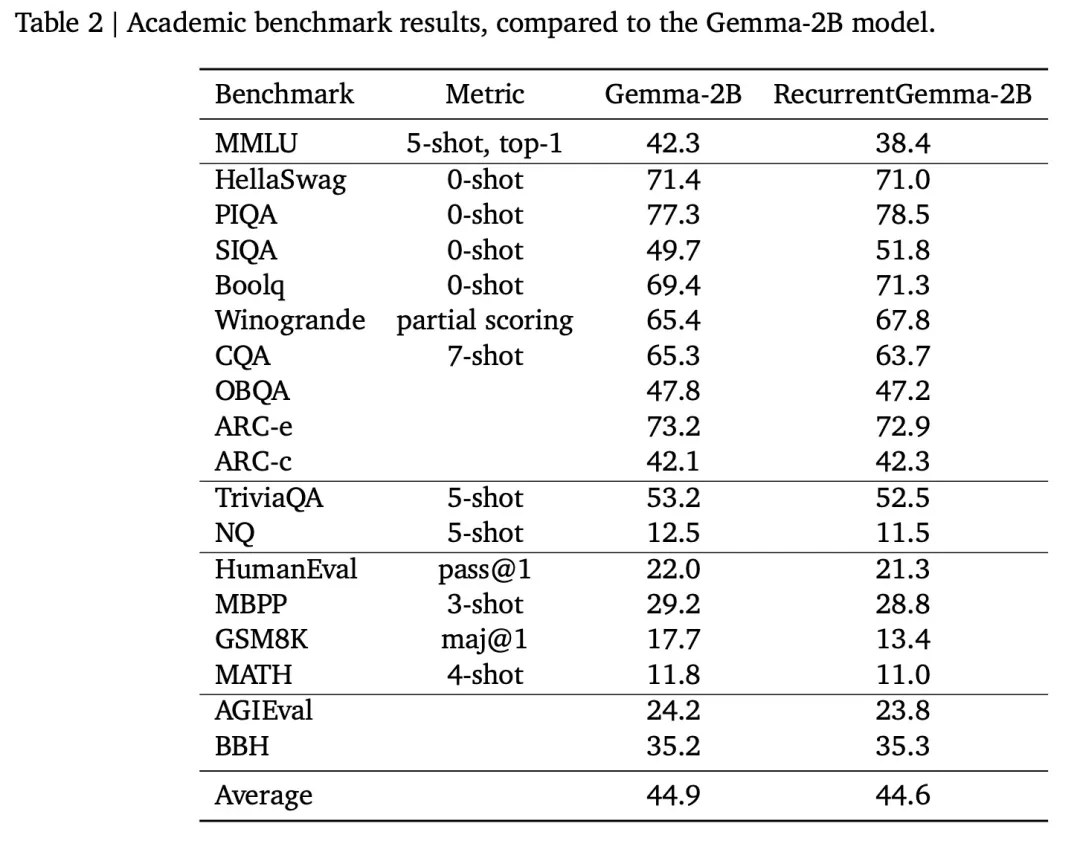

RecurrentGemma-2B erzielt eine überlegene Leistung bei nachgelagerten Aufgaben und kann mit Gemma verglichen werden -2B (Transformatorarchitektur) ist vergleichbar.

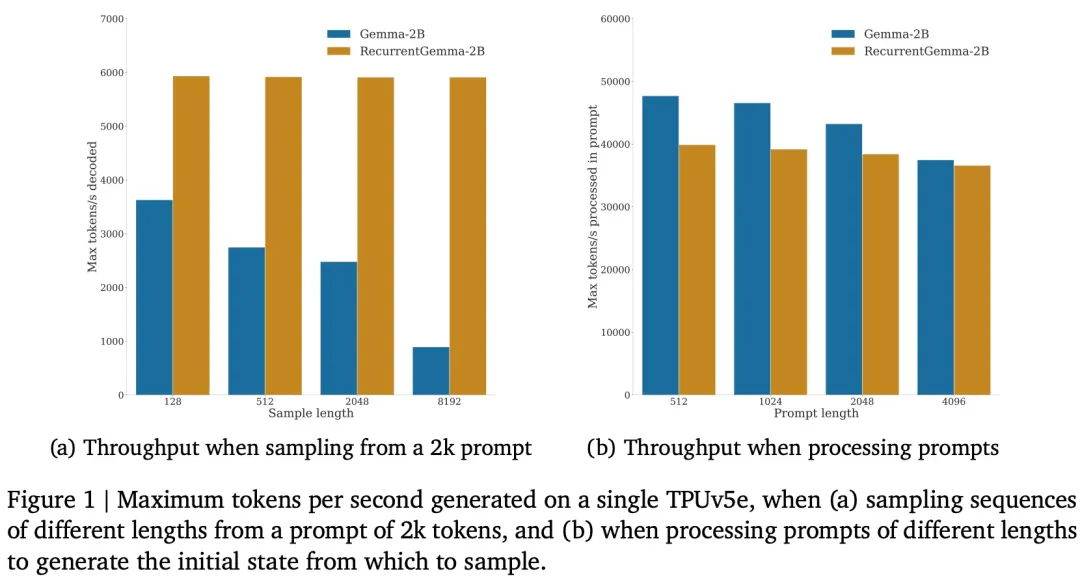

Gleichzeitig erreicht RecurrentGemma-2B einen höheren Durchsatz bei der Inferenz, insbesondere bei langen Sequenzen.

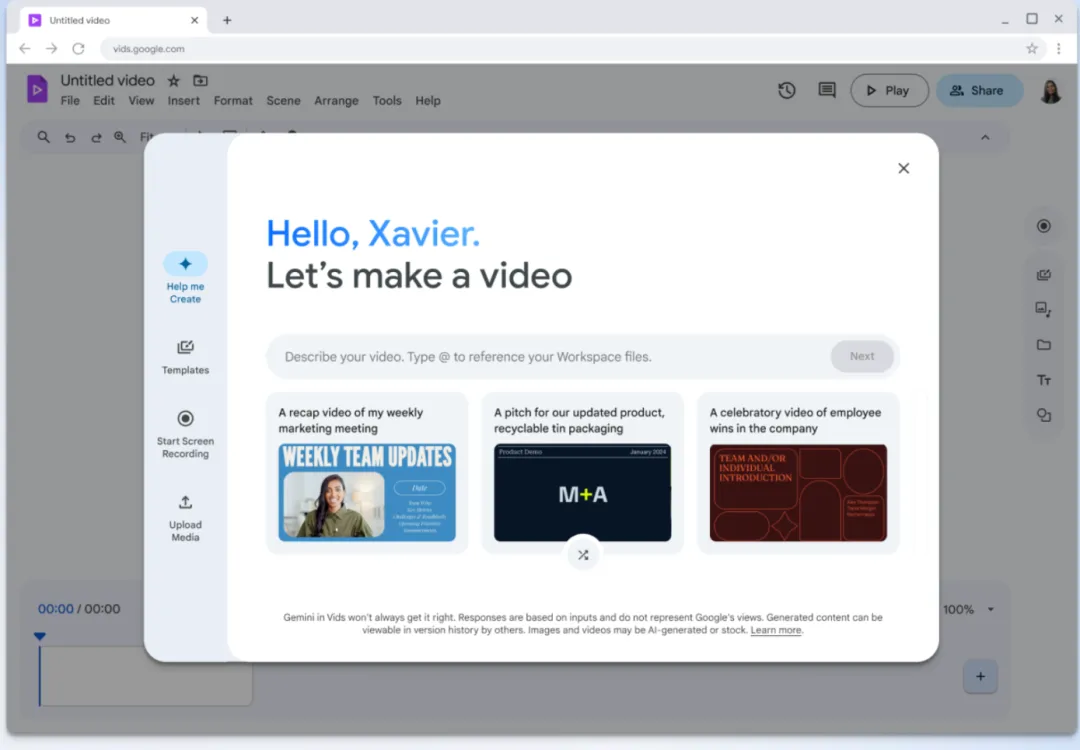

Videobearbeitungstool – Google Vids

Google Vids ist ein KI-Videoerstellungstool und eine neue Funktion, die in Google Workspace hinzugefügt wurde.

Google sagt, dass Nutzer mit Google Vids neben anderen Workspace-Tools wie Docs und Sheets auch Videos erstellen und in Echtzeit mit Kollegen zusammenarbeiten können.

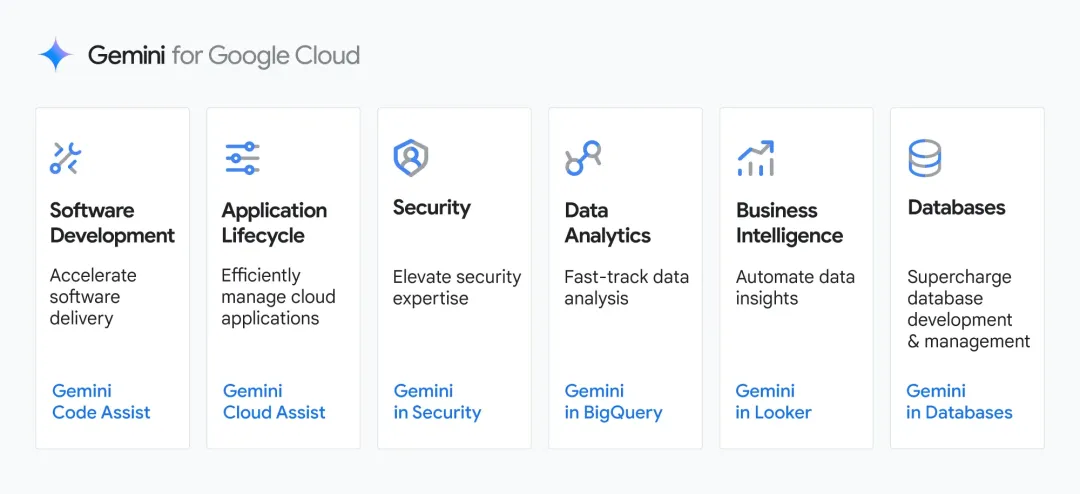

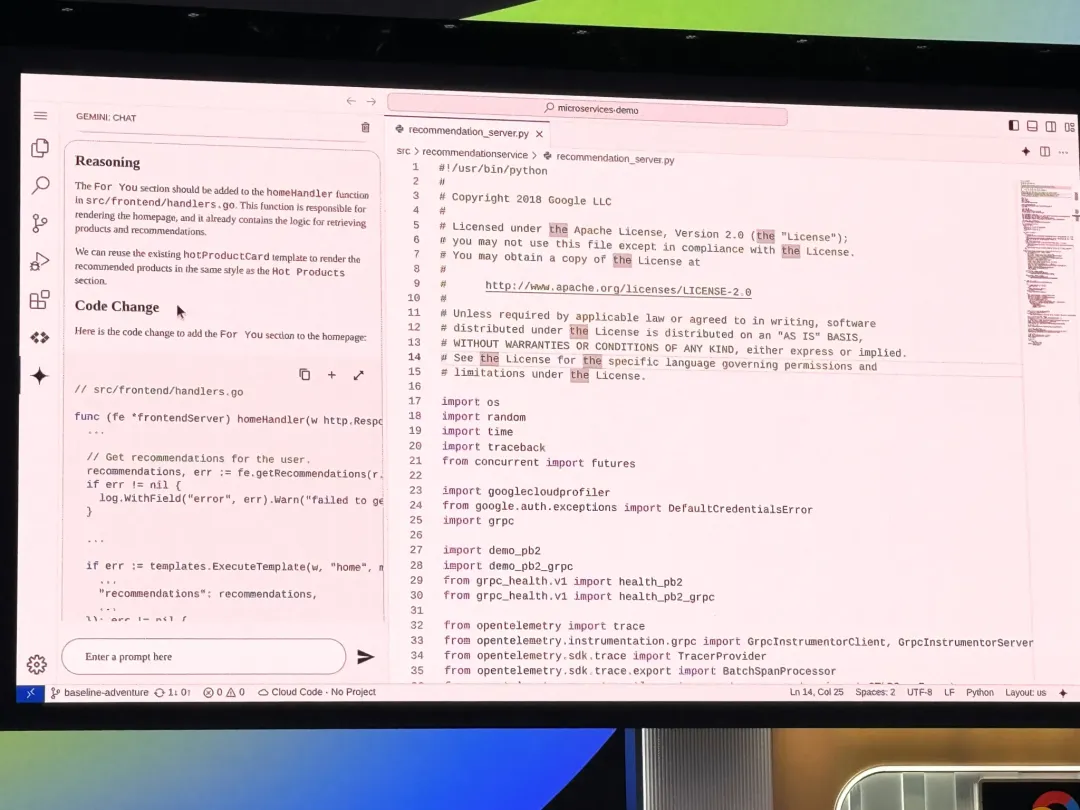

Unternehmensspezifischer Code-Assistent – Gemini Code Assist

Gemini Code Assist ist ein AI-Code-Vervollständigungs- und Unterstützungstool für Unternehmen, das mit GitHub Copilot Enterprise verglichen wird. Code Assist wird als Plug-in für gängige Editoren wie VS Code und JetBrains verfügbar sein.

Bildquelle: https://techcrunch.com/2024/04/09/google-launches-code-assist-its-latest-challenger-to-githubs-copilot/

Code Assist Unterstützt von Gemini 1.5 Pro. Gemini 1.5 Pro verfügt über ein Millionen-Token-Kontextfenster, sodass die Tools von Google mehr Kontext als die Konkurrenz einführen können. Laut Google bedeutet dies, dass Code Assist genauere Codevorschläge liefern kann und die Möglichkeit bietet, große Codeblöcke zu überdenken und zu ändern.

Google sagte: „Code Assist ermöglicht es Kunden, umfangreiche Änderungen an ihrer gesamten Codebasis vorzunehmen und ermöglicht so KI-gestützte Codetransformationen, die bisher unmöglich waren.“ Intelligenz ist in diesem Jahr eine wichtige Entwicklungsrichtung der Branche. Google hat jetzt ein neues Tool angekündigt, das Unternehmen bei der Entwicklung von KI-Agenten unterstützen soll – Vertex AI Agent Builder.

Thomas Kurian, CEO von Google Cloud, sagte: „Vertex AI Agent Builder macht es extrem einfach und schnell, produktionsbereite, KI-gesteuerte generative Konversationsagenten zu erstellen und bereitzustellen, die Menschen in einer Situation führen können Möglichkeit, die Qualität und Genauigkeit der modellgenerierten Ergebnisse zu verbessern.“

Das obige ist der detaillierte Inhalt vonEin voller Durchbruch: Google hat gestern Abend eine große Anzahl großer Modellprodukte aktualisiert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Wie löste ich das Problem der Berechtigungen beim Betrachten der Python -Version in Linux Terminal?

Apr 01, 2025 pm 05:09 PM

Lösung für Erlaubnisprobleme beim Betrachten der Python -Version in Linux Terminal Wenn Sie versuchen, die Python -Version in Linux Terminal anzuzeigen, geben Sie Python ein ...

Python Cross-Platform Desktop-Anwendungsentwicklung: Welche GUI-Bibliothek ist die beste für Sie?

Apr 01, 2025 pm 05:24 PM

Python Cross-Platform Desktop-Anwendungsentwicklung: Welche GUI-Bibliothek ist die beste für Sie?

Apr 01, 2025 pm 05:24 PM

Auswahl der Python-plattformübergreifenden Desktop-Anwendungsentwicklungsbibliothek Viele Python-Entwickler möchten Desktop-Anwendungen entwickeln, die sowohl auf Windows- als auch auf Linux-Systemen ausgeführt werden können ...

Python Hourglass Graph Drawing: Wie vermeiden Sie variable undefinierte Fehler?

Apr 01, 2025 pm 06:27 PM

Python Hourglass Graph Drawing: Wie vermeiden Sie variable undefinierte Fehler?

Apr 01, 2025 pm 06:27 PM

Erste Schritte mit Python: Hourglas -Grafikzeichnung und Eingabeüberprüfung In diesem Artikel wird das Problem der Variablendefinition gelöst, das von einem Python -Anfänger im Hourglass -Grafikzeichnungsprogramm auftritt. Code...

Wie kann ich das Problem lösen, dass die Kamera auf HTML -Seiten, die von Flask und Yolov5 entwickelt wurden, keine Erkennungsboxen anzeigen können?

Apr 01, 2025 pm 06:33 PM

Wie kann ich das Problem lösen, dass die Kamera auf HTML -Seiten, die von Flask und Yolov5 entwickelt wurden, keine Erkennungsboxen anzeigen können?

Apr 01, 2025 pm 06:33 PM

Wie öffne ich die Kamera erfolgreich und zeigt das Erkennungsfeld auf HTML -Webseiten an, die von Flask und Yolov5 entwickelt wurden? Bei der Entwicklung von HTML -Webseiten mithilfe von Flask Framework und Yolov5 öffnen Sie das Foto ...

Wie kann ich große Produktdatensätze in Python effizient zählen und sortieren?

Apr 01, 2025 pm 08:03 PM

Wie kann ich große Produktdatensätze in Python effizient zählen und sortieren?

Apr 01, 2025 pm 08:03 PM

Datenkonvertierung und Statistik: Effiziente Verarbeitung großer Datensätze In diesem Artikel werden ausführlich das Umwandeln einer Datenliste in eine andere enthält ...

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Wie kann ich die gesamte Spalte eines Datenrahmens effizient in einen anderen Datenrahmen mit verschiedenen Strukturen in Python kopieren?

Apr 01, 2025 pm 11:15 PM

Bei der Verwendung von Pythons Pandas -Bibliothek ist das Kopieren von ganzen Spalten zwischen zwei Datenrahmen mit unterschiedlichen Strukturen ein häufiges Problem. Angenommen, wir haben zwei Daten ...

Bieten Google und AWS öffentliche PYPI -Bildquellen an?

Apr 01, 2025 pm 05:15 PM

Bieten Google und AWS öffentliche PYPI -Bildquellen an?

Apr 01, 2025 pm 05:15 PM

Viele Entwickler verlassen sich auf PYPI (PythonpackageIndex) ...

Wie kann die inländische Technologie -Q & A -Community unter den Auswirkungen von ChatGPT durchbrechen?

Apr 01, 2025 pm 05:18 PM

Wie kann die inländische Technologie -Q & A -Community unter den Auswirkungen von ChatGPT durchbrechen?

Apr 01, 2025 pm 05:18 PM

Wie reagieren die Fragen und Antworten der Inlandstechnologie angesichts der Auswirkungen von ChatGPT? Neuerer Stack ...