Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

KI unterstützt die Forschung an Gehirn-Computer-Schnittstellen, die bahnbrechende neuronale Sprachdekodierungstechnologie der New York University, veröffentlicht in der Unterzeitschrift „Nature'.

KI unterstützt die Forschung an Gehirn-Computer-Schnittstellen, die bahnbrechende neuronale Sprachdekodierungstechnologie der New York University, veröffentlicht in der Unterzeitschrift „Nature'.

KI unterstützt die Forschung an Gehirn-Computer-Schnittstellen, die bahnbrechende neuronale Sprachdekodierungstechnologie der New York University, veröffentlicht in der Unterzeitschrift „Nature'.

Autor |. Chen Xupeng

In den letzten Jahren hat die rasante Entwicklung des Deep Learning und der Brain-Computer-Interface-Technologie (BCI) die Möglichkeit eröffnet, Neurosprachprothesen zu entwickeln, die aphasischen Menschen bei der Kommunikation helfen können. Die Sprachdekodierung neuronaler Signale steht jedoch vor Herausforderungen.

Kürzlich haben Forscher von VideoLab und Flinker Lab an der Universität von Jordanien einen neuen Typ eines differenzierbaren Sprachsynthesizers entwickelt, der ein leichtes Faltungs-Neuronales Netzwerk verwenden kann, um Sprache in eine Reihe interpretierbarer Sprachparameter (wie Tonhöhe, Lautstärke, Formant) zu kodieren Frequenz usw.) und diese Parameter werden über ein differenzierbares neuronales Netzwerk in Sprache synthetisiert. Dieser Synthesizer kann auch Sprachparameter (wie Tonhöhe, Lautstärke, Formantenfrequenzen usw.) über ein leichtes Faltungs-Neuronales Netzwerk analysieren und Sprache über einen differenzierbaren Sprachsynthesizer neu synthetisieren.

Die Forscher haben ein System zur Decodierung neuronaler Signale entwickelt, das gut interpretierbar und auf Situationen mit kleinen Datenmengen anwendbar ist, indem neuronale Signale diesen Sprachparametern zugeordnet werden, ohne die Bedeutung des ursprünglichen Inhalts zu ändern.

Die Forschung trug den Titel „

Ein neuronales Sprachdekodierungs-Framework, das Deep Learning und Sprachsynthese nutzt“ und wurde am 8. April 2024 in der Zeitschrift „Nature Machine Intelligence“ veröffentlicht.

Link zum Papier:

Link zum Papier:

Forschungshintergrund

Die meisten Versuche, Decoder für neuronale Sprache zu entwickeln, basieren auf einem A-Special Art der Daten: Daten von Patienten, die sich einer Epilepsieoperation unterzogen, mittels Elektrokortikographie (ECoG)-Aufzeichnungen. Mithilfe von Elektroden, die Patienten mit Epilepsie implantiert werden, um während der Sprachproduktion Daten aus der Großhirnrinde zu sammeln, haben diese Daten eine hohe räumlich-zeitliche Auflösung und haben Forschern dabei geholfen, eine Reihe bemerkenswerter Ergebnisse auf dem Gebiet der Sprachdekodierung zu erzielen und so die Entwicklung von Gehirn-Computer-Schnittstellen voranzutreiben Feld.

Die Sprachdekodierung neuronaler Signale steht vor zwei großen Herausforderungen.

Erstens sind die Daten, die zum Trainieren personalisierter neuronaler Sprachdekodierungsmodelle verwendet werden, zeitlich sehr begrenzt, normalerweise nur etwa zehn Minuten, während Deep-Learning-Modelle oft eine große Menge an Trainingsdaten benötigen, um zu fahren.

Zweitens ist die menschliche Aussprache sehr unterschiedlich. Selbst wenn dieselbe Person wiederholt dasselbe Wort spricht, ändern sich die Sprechgeschwindigkeit, die Intonation und die Tonhöhe, was den vom Modell erstellten Darstellungsraum komplexer macht.

Frühe Versuche, neuronale Signale in Sprache zu dekodieren, stützten sich hauptsächlich auf lineare Modelle. Die Modelle erforderten normalerweise keine großen Trainingsdatensätze und waren gut interpretierbar, aber die Genauigkeit war sehr gering.

Neuere Forschungen, die auf tiefen neuronalen Netzen basieren, insbesondere die Verwendung von Faltungs- und wiederkehrenden neuronalen Netzarchitekturen, werden in zwei Schlüsseldimensionen entwickelt: der latenten Zwischendarstellung simulierter Sprache und der Qualität synthetisierter Sprache. Beispielsweise gibt es Studien, die die Aktivität der Großhirnrinde in Mundbewegungsräume dekodieren und diese dann in Sprache umwandeln. Obwohl die Dekodierungsleistung leistungsstark ist, klingt die rekonstruierte Stimme unnatürlich.

Andererseits rekonstruieren einige Methoden erfolgreich natürlich klingende Sprache mithilfe von Wavenet-Vocoder, Generative Adversarial Network (GAN) usw., ihre Genauigkeit ist jedoch begrenzt. Kürzlich wurden in einer Studie an Patienten mit implantierten Geräten sowohl genaue als auch natürliche Sprachwellenformen erzielt, indem quantisierte HuBERT-Merkmale als Zwischendarstellungsraum und ein vortrainierter Sprachsynthesizer zur Umwandlung dieser Merkmale in Sprache verwendet wurden.

Allerdings können die HuBERT-Funktionen keine sprecherspezifischen akustischen Informationen darstellen und nur feste und einheitliche Sprechertöne erzeugen. Daher sind zusätzliche Modelle erforderlich, um diesen universellen Klang in die Stimme eines bestimmten Patienten umzuwandeln. Darüber hinaus wurde in dieser Studie und den meisten früheren Versuchen eine nicht-kausale Architektur verwendet, was ihre Verwendung in praktischen Anwendungen von Gehirn-Computer-Schnittstellen, die zeitliche kausale Operationen erfordern, möglicherweise einschränkt.

Hauptmodellrahmen

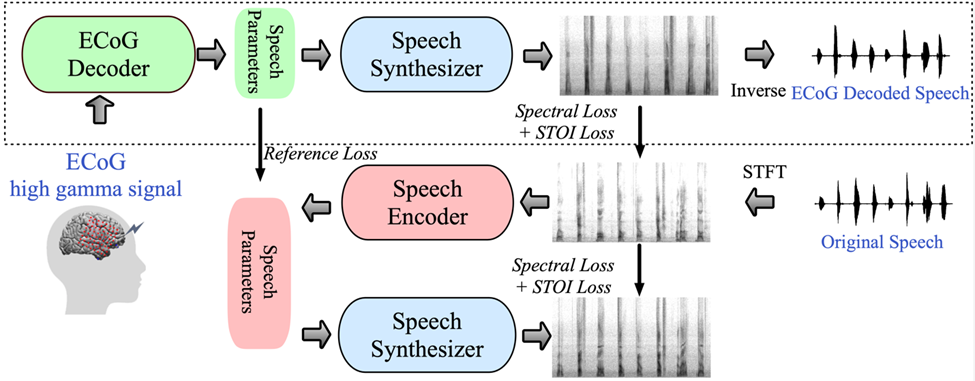

Abbildung 1: Vorgeschlagener Rahmen für die neuronale Sprachdekodierung. (Quelle: Papier)

Abbildung 1: Vorgeschlagener Rahmen für die neuronale Sprachdekodierung. (Quelle: Papier)

Das von der Forschung vorgeschlagene Framework besteht aus zwei Teilen: Der eine ist der ECoG-Decoder, der das ECoG-Signal in akustische Sprachparameter umwandelt, die wir verstehen können (wie Tonhöhe, ob es ausgesprochen wird, Lautstärke und Formantenfrequenz usw.). ); der andere Teil ist ein Sprachsynthesizer, der diese Sprachparameter in ein Spektrogramm umwandelt.

Die Forscher haben einen differenzierbaren Sprachsynthesizer entwickelt, der es dem Sprachsynthesizer ermöglicht, während des Trainings des ECoG-Decoders auch am Training teilzunehmen und gemeinsam zu optimieren, um den Fehler bei der Spektrogrammrekonstruktion zu reduzieren. Dieser niedrigdimensionale latente Raum verfügt über eine starke Interpretierbarkeit, gepaart mit einem leichten vorab trainierten Sprachkodierer zur Generierung von Referenz-Sprachparametern, was Forschern hilft, ein effizientes neuronales Sprachdekodierungs-Framework aufzubauen und das Problem der Datenknappheit zu überwinden.

Dieses Framework kann natürliche Sprache erzeugen, die der eigenen Stimme des Sprechers sehr nahe kommt, und der ECoG-Decoder-Teil kann in verschiedene Deep-Learning-Modellarchitekturen eingebunden werden und unterstützt auch kausale Operationen. Die Forscher sammelten und verarbeiteten ECoG-Daten von 48 neurochirurgischen Patienten und verwendeten dabei mehrere Deep-Learning-Architekturen (einschließlich Faltung, rekurrentes neuronales Netzwerk und Transformer) als ECoG-Decoder.

Das Framework hat bei verschiedenen Modellen eine hohe Genauigkeit bewiesen, wobei die Faltungsarchitektur (ResNet) die beste Leistung erzielte, wobei der Pearson-Korrelationskoeffizient (PCC) zwischen dem ursprünglichen und dem dekodierten Spektrogramm 0,806 erreichte. Das von den Forschern vorgeschlagene Framework kann nur durch kausale Operationen und eine relativ niedrige Abtastrate (niedrige Dichte, 10 mm Abstand) eine hohe Genauigkeit erreichen.

Die Forscher zeigten außerdem, dass eine effektive Sprachdekodierung sowohl von der linken als auch von der rechten Gehirnhälfte aus durchgeführt werden kann, wodurch die Anwendung der neuronalen Sprachdekodierung auf die rechte Gehirnhälfte ausgeweitet wurde.

Forschungsbezogener Code Open Source: https://github.com/flinkerlab/neural_speech_decoding

Die wichtige Innovation dieser Forschung besteht darin, einen differenzierbaren Sprachsynthesizer (Sprachsynthesizer) vorzuschlagen, der die Aufgabe der Sprachneusynthese sehr effizient macht und hochauflösende Aufkleber mit sehr kleiner Sprachanpassung synthetisieren kann Audio.

Das Prinzip des differenzierbaren Sprachsynthesizers basiert auf dem Prinzip des menschlichen generativen Systems und unterteilt die Sprache in zwei Teile: Stimme (zur Modellierung von Vokalen) und Unvoice (zur Modellierung von Konsonanten):

Der Sprachteil kann zunächst mit dem verwendet werden Basis Das Frequenzsignal erzeugt Harmonische, und der Filter, der aus den Formantenspitzen von F1-F6 besteht, wird gefiltert, um die spektralen Eigenschaften des Vokalteils zu erhalten. Der Forscher filtert das weiße Rauschen mit dem entsprechenden Filter, um das entsprechende zu erhalten Spektrum, das mit den erlernten Parametern das Mischungsverhältnis der beiden Teile zu jedem Zeitpunkt steuern kann. Anschließend wird das Lautstärkesignal verstärkt und Hintergrundgeräusche hinzugefügt, um das endgültige Sprachspektrum zu erhalten. Basierend auf diesem Sprachsynthesizer entwirft dieser Artikel ein effizientes Sprachresynthese-Framework und ein neuronales Sprachdecodierungs-Framework.

Forschungsergebnisse

Ergebnisse der Sprachdekodierung mit zeitlicher Kausalität

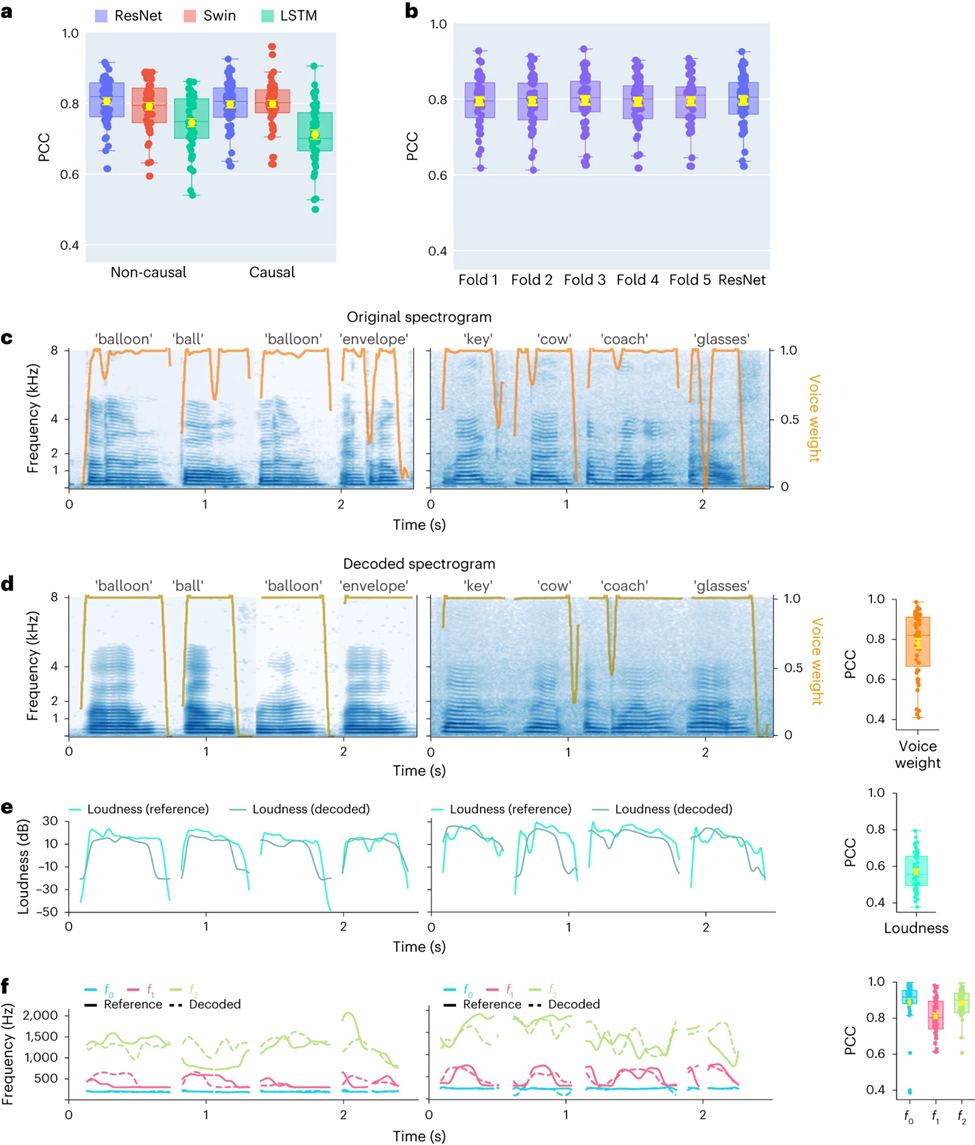

Zunächst verglichen die Forscher direkt die Unterschiede in der Sprachdekodierungsleistung verschiedener Modellarchitekturen (Convolution (ResNet), Recurrent (LSTM) und Transformer (3D Swin). Es ist erwähnenswert, dass diese Modelle keine Leistung erbringen können -kausale oder kausale Operationen auf Zeit

Die Ergebnisse zeigen, dass das ResNet-Modell unter allen Modellen den höchsten Pearson-Korrelationskoeffizienten (PCC) erreicht. Der durchschnittliche PCC für kausal und kausal beträgt 0,806 bzw. 0,797. gefolgt vom Swin-Modell (der durchschnittliche PCC für nicht-kausal und 0,798) (Abbildung 2a)

Ein ähnliches Ergebnis wurde durch die Auswertung des STOI+-Indikators erzielt Dies hat erhebliche Auswirkungen auf Brain-Computer-Interface-Anwendungen (BCI): Kausale Modelle verwenden nur vergangene und aktuelle neuronale Signale, um Sprache zu erzeugen, während akausale Modelle auch zukünftige neuronale Signale verwenden. Bei Verwendung eines nicht-kausalen Modells ist dies in Echtzeitanwendungen nicht möglich Daher konzentrierten sich die Forscher auf den Vergleich der Leistung desselben Modells bei der Durchführung nicht-kausaler und kausaler Operationen.

Die Studie ergab, dass sogar die kausale Version des ResNet-Modells vergleichbar ist. und es gibt keinen signifikanten Unterschied zwischen ihnen. Ebenso ist die Leistung der kausalen und nicht-kausalen Version des Swin-Modells ähnlich, aber die Leistung der kausalen Version des LSTM-Modells ist deutlich geringer als die der nicht-kausalen Version Daher werden sich die Forscher in Zukunft auf die Modelle ResNet und Swin konzentrieren.

Um sicherzustellen, dass sich das in diesem Artikel vorgeschlagene Framework gut auf unbekannte Wörter übertragen lässt, führten die Forscher eine strengere Kreuzvalidierung auf Wortebene durch, was bedeutet, dass verschiedene Versuche durchgeführt werden Das gleiche Wort wird nicht gleichzeitig im Trainingssatz und im Test angezeigt. Wie in Abbildung 2b gezeigt, ist die Leistung bei nicht sichtbaren Wörtern mit der experimentellen Standardmethode im Artikel vergleichbar, was darauf hinweist, dass das Modell gut dekodieren kann Auch wenn es während des Trainings nicht gesehen wurde, was hauptsächlich auf diesen Artikel zurückzuführen ist, führt das gebaute Modell eine Sprachdekodierung auf Phonem- oder ähnlicher Ebene durch.

Darüber hinaus demonstrieren die Forscher die Leistung des ResNet-Kausaldecoders auf Einzelwortebene und zeigen Daten von zwei Teilnehmern (EKoG mit niedriger Abtastrate). Das dekodierte Spektrogramm behält die spektral-zeitliche Struktur der ursprünglichen Sprache genau bei (Abbildung 2c, d).

Die Forscher verglichen auch die vom neuronalen Decoder vorhergesagten Sprachparameter mit den vom Sprachcodierer codierten Parametern (als Referenzwerte). Die Forscher zeigten den durchschnittlichen PCC-Wert (N=48) mehrerer wichtiger Sprachparameter, einschließlich der Klanggewichtung (). Wird zur Unterscheidung von Vokalen und Konsonanten verwendet), Lautstärke, Tonhöhe f0, erster Formant f1 und zweiter Formant f2. Eine genaue Rekonstruktion dieser Sprachparameter, insbesondere Tonhöhe, Klanggewicht und die ersten beiden Formanten, ist entscheidend für eine genaue Sprachdekodierung und -rekonstruktion, die die Stimme des Teilnehmers auf natürliche Weise nachahmt.

Die Forschungsergebnisse zeigen, dass sowohl nicht-kausale als auch kausale Modelle vernünftige Dekodierungsergebnisse erzielen können, was eine positive Orientierung für zukünftige Forschung und Anwendungen bietet.

Studie zur Sprachdekodierung neuronaler Signale der linken und rechten Gehirnhälfte und zur räumlichen Abtastrate

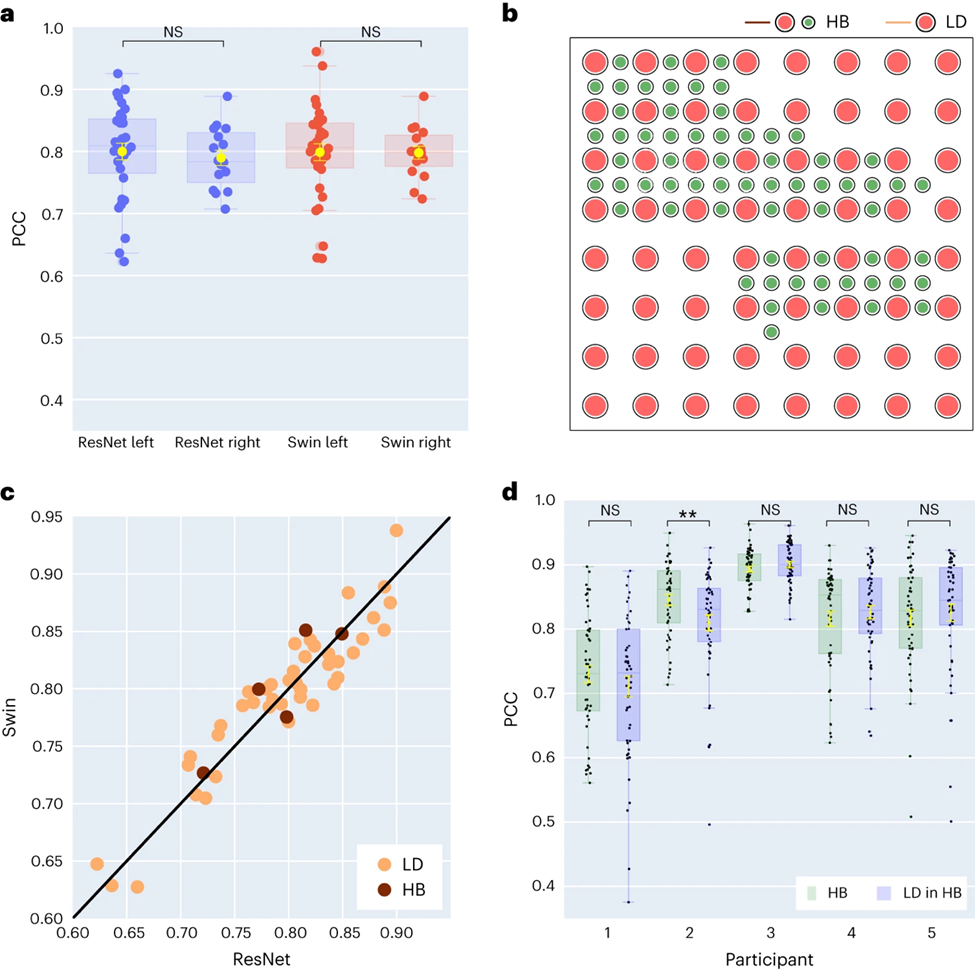

Die Forscher verglichen außerdem die Ergebnisse der Sprachdekodierung der linken und rechten Gehirnhälfte. Die meisten Studien konzentrieren sich auf die linke Gehirnhälfte, die für Sprache und Sprachfunktionen verantwortlich ist. Allerdings ist wenig darüber bekannt, wie Sprachinformationen aus der rechten Gehirnhälfte entschlüsselt werden. Als Reaktion darauf verglichen die Forscher die Dekodierungsleistung der linken und rechten Gehirnhälfte der Teilnehmer, um die Möglichkeit zu überprüfen, die rechte Gehirnhälfte zur Sprachwiederherstellung zu nutzen.

Von den 48 in der Studie erfassten Probanden wurden die ECoG-Signale von 16 Probanden aus der rechten Gehirnhälfte erfasst. Durch den Vergleich der Leistung von ResNet- und Swin-Dekodierern stellten die Forscher fest, dass die rechte Hemisphäre auch Sprache stabil dekodieren kann (der PCC-Wert von ResNet beträgt 0,790, der PCC-Wert von Swin beträgt 0,798), was sich weniger vom Dekodierungseffekt der linken Hemisphäre unterscheidet ( As (siehe Abbildung 3a).

Diese Erkenntnis gilt auch für die Bewertung von STOI+. Dies bedeutet, dass für Patienten mit einer Schädigung der linken Hemisphäre und einem Verlust der Sprachfähigkeit die Verwendung neuronaler Signale der rechten Hemisphäre zur Wiederherstellung der Sprache eine praktikable Lösung sein kann.

Dann untersuchten die Forscher den Einfluss der Elektroden-Abtastdichte auf den Sprachdekodierungseffekt. Frühere Studien verwendeten meist Elektrodengitter mit höherer Dichte (0,4 mm), während die Dichte der in der klinischen Praxis üblicherweise verwendeten Elektrodengitter geringer ist (LD 1 cm).

Fünf Teilnehmer verwendeten Hybrid-Elektrodengitter (HB) (siehe Abbildung 3b), bei denen es sich hauptsächlich um Probenentnahme mit niedriger Dichte handelt, in die jedoch zusätzliche Elektroden integriert sind. Die restlichen 43 Teilnehmer wurden in geringer Dichte beprobt. Die Dekodierungsleistung dieser Hybrid-Samples (HB) ist ähnlich wie bei herkömmlichen Low-Density-Samples (LD), schneidet jedoch bei STOI+ etwas besser ab.

Die Forscher verglichen die Wirkung der ausschließlichen Verwendung von Elektroden mit geringer Dichte mit der Verwendung aller gemischten Elektroden zur Dekodierung und stellten fest, dass der Unterschied zwischen beiden nicht signifikant war (siehe Abbildung 3d), was darauf hindeutet, dass das Modell in der Lage ist, Proben aus der Großhirnrinde zu entnehmen Es werden unterschiedliche räumliche Dichten erlernt, was auch impliziert, dass die in der klinischen Praxis üblicherweise verwendete Abtastdichte für zukünftige Gehirn-Computer-Schnittstellenanwendungen ausreichend sein könnte.

Untersuchung des Beitrags verschiedener Gehirnbereiche der linken und rechten Gehirnhälfte zur Sprachdekodierung

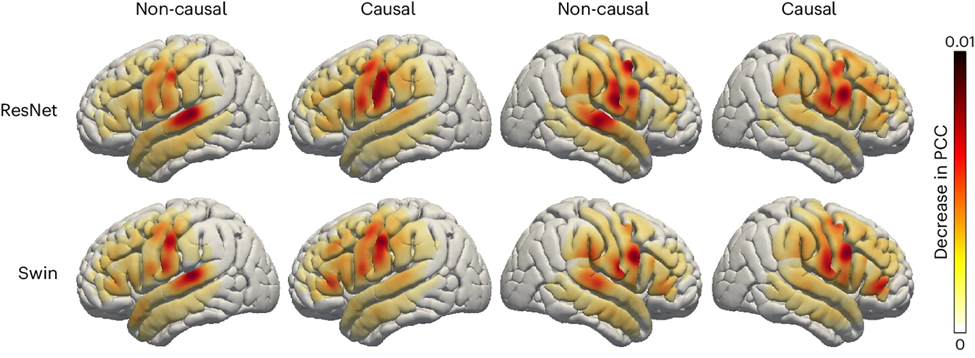

Abschließend untersuchten die Forscher den Beitrag sprachbezogener Bereiche des Gehirns beim Sprachdekodierungsprozess, der eine wichtige Referenz für die zukünftige Implantation von Sprachwiederherstellungsgeräten in die linke und rechte Gehirnhälfte liefert . Die Forscher nutzten die Okklusionsanalyse, um den Beitrag verschiedener Gehirnregionen zur Sprachdekodierung zu bewerten.

Kurz gesagt: Wenn ein bestimmter Bereich für die Decodierung entscheidend ist, verringert das Blockieren des Elektrodensignals in diesem Bereich (d. h. das Setzen des Signals auf Null) die Genauigkeit der rekonstruierten Sprache (PCC-Wert).

Mit dieser Methode haben die Forscher die Verringerung des PCC-Werts gemessen, wenn jeder Bereich verschlossen war. Durch den Vergleich der kausalen und nicht-kausalen Modelle von ResNet- und Swin-Dekodierern wird festgestellt, dass der auditorische Kortex einen größeren Beitrag zum nicht-kausalen Modell leistet. Dies unterstreicht, dass in Echtzeit-Sprachdekodierungsanwendungen kausale Modelle verwendet werden müssen Durch die Echtzeit-Sprachdekodierung können wir Neurofeedback-Signale nicht nutzen.

Darüber hinaus ist der Beitrag des sensomotorischen Kortex, insbesondere des Bauchbereichs, sowohl in der rechten als auch in der linken Hemisphäre ähnlich, was darauf hindeutet, dass es möglich sein könnte, Nervenprothesen in der rechten Hemisphäre zu implantieren.

Schlussfolgerungen und inspirierender Ausblick

Forscher haben einen neuen Typ eines differenzierbaren Sprachsynthesizers entwickelt, der ein leichtes Faltungs-Neuronales Netzwerk verwenden kann, um Sprache in eine Reihe interpretierbarer Sprachparameter (wie Tonhöhe, Lautstärke, Formantenfrequenzen usw.) zu kodieren. ) und synthetisieren Sie die Sprache durch einen differenzierbaren Sprachsynthesizer neu.

Durch die Zuordnung neuronaler Signale zu diesen Sprachparametern haben die Forscher ein neuronales Sprachdekodierungssystem entwickelt, das gut interpretierbar und auf Situationen mit geringem Datenvolumen anwendbar ist und natürlich klingende Sprache erzeugen kann. Diese Methode ist bei allen Teilnehmern (insgesamt 48 Personen) in hohem Maße reproduzierbar, und die Forscher haben erfolgreich die Wirksamkeit der kausalen Dekodierung mithilfe von Faltungs- und Transformer-Architekturen (3D Swin) demonstriert, die beide rekurrenten Architekturen (LSTM) überlegen sind.

Dieses Framework kann hohe und niedrige räumliche Abtastdichten verarbeiten und EEG-Signale aus der linken und rechten Hemisphäre verarbeiten, was ein starkes Potenzial für die Sprachdekodierung zeigt.

Die meisten früheren Studien berücksichtigten nicht die zeitliche Kausalität von Dekodierungsvorgängen in Echtzeit-Gehirn-Computer-Schnittstellenanwendungen. Viele nichtkausale Modelle basieren auf akustischen Rückmeldungssignalen. Die Analyse der Forscher zeigte, dass das nicht-kausale Modell hauptsächlich auf dem Beitrag des oberen Schläfengyrus beruhte, während das kausale Modell diesen im Wesentlichen eliminierte. Forscher glauben, dass die Vielseitigkeit nicht-kausaler Modelle in Echtzeit-BCI-Anwendungen aufgrund der übermäßigen Abhängigkeit von Rückkopplungssignalen begrenzt ist.

Einige Methoden versuchen, Feedback im Training zu vermeiden, beispielsweise die Dekodierung der imaginären Sprache des Probanden. Trotzdem verwenden die meisten Studien immer noch akausale Modelle und können Rückkopplungseffekte während des Trainings und der Schlussfolgerung nicht ausschließen. Darüber hinaus sind in der Literatur häufig verwendete rekurrente neuronale Netze in der Regel bidirektional, was zu nicht-kausalem Verhalten und Vorhersageverzögerungen führt, während unsere Experimente zeigen, dass unidirektional trainierte rekurrente Netze die schlechteste Leistung erbringen.

Obwohl in der Studie keine Echtzeitdekodierung getestet wurde, erreichten die Forscher eine Latenz von weniger als 50 Millisekunden bei der Synthese von Sprache aus neuronalen Signalen, was die Hörverzögerung kaum beeinträchtigte und eine normale Sprachproduktion ermöglichte.

In der Studie wurde untersucht, ob eine höhere Abdeckungsdichte die Decodierungsleistung verbessern kann. Die Forscher fanden heraus, dass sowohl eine Gitterabdeckung mit niedriger als auch hoher Dichte eine hohe Decodierungsleistung erzielte (siehe Abbildung 3c). Darüber hinaus stellten die Forscher fest, dass sich die Decodierungsleistung bei Verwendung aller Elektroden nicht wesentlich von der Leistung bei Verwendung nur von Elektroden mit geringer Dichte unterschied (Abbildung 3d).

Dies beweist, dass der von den Forschern vorgeschlagene ECoG-Decoder Sprachparameter aus neuronalen Signalen für die Sprachrekonstruktion extrahieren kann, solange die peritemporale Abdeckung ausreichend ist, selbst bei Teilnehmern mit geringer Teilnehmerdichte. Ein weiterer bemerkenswerter Befund war die kortikale Struktur der rechten Hemisphäre und der Beitrag des rechten peritemporalen Kortex zur Sprachdekodierung. Obwohl einige frühere Studien einen möglichen Beitrag der rechten Hemisphäre zur Dekodierung von Vokalen und Sätzen gezeigt haben, liefern unsere Ergebnisse Hinweise auf eine robuste phonologische Repräsentation in der rechten Hemisphäre.

Die Forscher erwähnten auch einige Einschränkungen des aktuellen Modells, wie z. B. den Decodierungsprozess, der Sprachtrainingsdaten gepaart mit ECoG-Aufzeichnungen erfordert, was möglicherweise nicht auf Aphasiker anwendbar ist. In Zukunft hoffen die Forscher auch, Modellarchitekturen zu entwickeln, die mit Nicht-Grid-Daten umgehen und multimodale EEG-Daten mehrerer Patienten besser nutzen können.

Der erste Autor dieses Artikels: Xupeng Chen, Ran Wang, korrespondierender Autor: Adeen Flinker.

Finanzielle Unterstützung: National Science Foundation unter Grant No. IIS-1912286, 2309057 (Y.W., A.F.) und National Institute of Health R01NS109367, R01NS115929, R01DC018805 (A.F.).

Weitere Informationen zur Kausalität bei der Dekodierung neuronaler Sprache finden Sie in einem anderen Artikel der Autoren „Distributed Feedforward and Feedback Cortical Processing Supports Human Language Production“: https://www.pnas.org/doi /10.1073 /pnas.2300255120

Quelle: Brain Computer Interface Community

Das obige ist der detaillierte Inhalt vonKI unterstützt die Forschung an Gehirn-Computer-Schnittstellen, die bahnbrechende neuronale Sprachdekodierungstechnologie der New York University, veröffentlicht in der Unterzeitschrift „Nature'.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

So installieren Sie Deepseek

Feb 19, 2025 pm 05:48 PM

So installieren Sie Deepseek

Feb 19, 2025 pm 05:48 PM

Es gibt viele Möglichkeiten, Deepseek zu installieren, einschließlich: kompilieren Sie von Quelle (für erfahrene Entwickler) mit vorberechtigten Paketen (für Windows -Benutzer) mit Docker -Containern (für bequem am besten, um die Kompatibilität nicht zu sorgen), unabhängig von der Methode, die Sie auswählen, bitte lesen Die offiziellen Dokumente vorbereiten sie sorgfältig und bereiten sie voll und ganz vor, um unnötige Schwierigkeiten zu vermeiden.

Zusammenfassung der FAQs für die Verwendung von Deepseek

Feb 19, 2025 pm 03:45 PM

Zusammenfassung der FAQs für die Verwendung von Deepseek

Feb 19, 2025 pm 03:45 PM

Deepseekai Tool User Guide und FAQ Deepseek ist ein leistungsstarkes KI -Intelligent -Tool. FAQ: Der Unterschied zwischen verschiedenen Zugriffsmethoden: Es gibt keinen Unterschied in der Funktion zwischen Webversion, App -Version und API -Aufrufen, und App ist nur ein Wrapper für die Webversion. Die lokale Bereitstellung verwendet ein Destillationsmodell, das der Vollversion von Deepseek-R1 geringfügig unteren ist, das 32-Bit-Modell theoretisch 90% Vollversionsfunktion. Was ist eine Taverne? SillyTervern ist eine Front-End-Oberfläche, die das KI-Modell über API oder Ollama anruft. Was ist Breaking Limit

Was sind die KI-Tools?

Nov 29, 2024 am 11:11 AM

Was sind die KI-Tools?

Nov 29, 2024 am 11:11 AM

Zu den KI-Tools gehören: Doubao, ChatGPT, Gemini, BlenderBot usw.

Was sind die Graustufenverschlüsselungsfonds?

Mar 05, 2025 pm 12:33 PM

Was sind die Graustufenverschlüsselungsfonds?

Mar 05, 2025 pm 12:33 PM

Grayscale -Investitionen: Der Kanal für institutionelle Anleger, um den Kryptowährungsmarkt zu betreten. Das Unternehmen hat mehrere Krypto -Trusts auf den Markt gebracht, was die weit verbreitete Marktaufmerksamkeit auf sich gezogen hat, die Auswirkungen dieser Mittel auf die Tokenpreise jedoch erheblich variieren. In diesem Artikel werden einige der wichtigsten Krypto -Vertrauensfonds von Grayscale ausführlich vorgestellt. Grayscale Major Crypto Trust Funds, die auf einer Blick Grayscale-Investition erhältlich sind (gegründet von DigitalCurrencyGroup im Jahr 2013), verwaltet eine Vielzahl von Crypto Asset Trust Funds und bietet institutionelle Anleger und Einzelpersonen mit hohem Nettel mit konformen Investitionskanälen. Zu den Hauptfonds gehören: Zcash (ZEC), Sol,

Welche Auswirkungen auf die Branche haben die Top -Markthersteller in den Kryptomarkt?

Mar 04, 2025 pm 08:03 PM

Welche Auswirkungen auf die Branche haben die Top -Markthersteller in den Kryptomarkt?

Mar 04, 2025 pm 08:03 PM

Der Einstieg des Makers von Top -Market Maker Castle in den Bitcoin Market Maker ist ein Symbol für die Reife des Bitcoin -Marktes und ein wichtiger Schritt für traditionelle Finanzkräfte, um um zukünftige Vermögenswerte zu konkurrieren. Nach Angaben von Bloomberg versucht Citadel Securities am 25. Februar, ein Liquiditätsanbieter für Kryptowährungen zu werden. Das Unternehmen zielt darauf ab, sich der Liste der Markthersteller an verschiedenen Börsen anzuschließen, einschließlich Börsen, die von CoinbaseGlobal, BinanceHoldings und Crypto.com betrieben werden, sagten mit der Angelegenheit, die mit der Angelegenheit vertraut sind. Nach der Genehmigung von der Börse plante das Unternehmen zunächst, ein Markthersteller -Team außerhalb der USA einzurichten. Dieser Schritt ist nicht nur ein Zeichen

Delphi Digital: Wie kann man die neue KI -Wirtschaft verändern, indem sie die neue Elizaos V2 -Architektur analysiert?

Mar 04, 2025 pm 07:00 PM

Delphi Digital: Wie kann man die neue KI -Wirtschaft verändern, indem sie die neue Elizaos V2 -Architektur analysiert?

Mar 04, 2025 pm 07:00 PM

ElizaOSV2: Erleichterung der KI und Führung der neuen Wirtschaft von Web3. Dieser Artikel wird sich mit den wichtigsten Innovationen von Elizaosv2 befassen und wie er eine KI-gesteuerte zukünftige Wirtschaft prägt. KI -Automatisierung: Es war ursprünglich ein KI -Framework, der sich auf Web3 -Automatisierung konzentrierte. Mit der V1 -Version kann AI mit intelligenten Verträgen und Blockchain -Daten interagieren, während die V2 -Version erhebliche Leistungsverbesserungen erzielt. Anstatt nur einfache Anweisungen auszuführen, kann KI Workflows unabhängig verwalten, Geschäft betreiben und finanzielle Strategien entwickeln. Architektur -Upgrade: Verbessert a

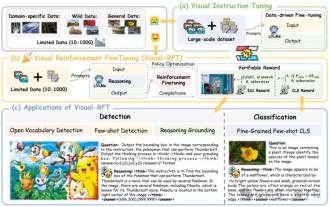

Das Geheimnis hinter O1/Deepseek-R1 kann auch in multimodalen großen Modellen verwendet werden

Mar 12, 2025 pm 01:03 PM

Das Geheimnis hinter O1/Deepseek-R1 kann auch in multimodalen großen Modellen verwendet werden

Mar 12, 2025 pm 01:03 PM

Forscher der Shanghai Jiaotong University, Shanghai Ailab und der chinesischen Universität von Hongkong haben das Open-Source-Projekt zur Visual-RFT (visuelle Verbesserung der Feinabstimmung) gestartet, für das nur eine geringe Datenmenge erforderlich ist, um die Leistung des visuellen Sprachen-Big-Modells (LVLM) signifikant zu verbessern. Visual-RFT kombiniert geschickt die regelbasierte Verstärkungslernansatz von Deepseek-R1 mit dem RFT-Paradigma (Verstärkung der Verstärkung der Verstärkung) und erweitert diesen Ansatz erfolgreich vom Textfeld auf das Gesichtsfeld. Durch die Gestaltung der entsprechenden Regelprämien für Aufgaben wie die visuelle Unterkategorisierung und Objekterkennung überwindet die visuelle RFT die Einschränkungen der Deepseek-R1-Methode, die auf Text, mathematisches Denken und andere Bereiche beschränkt ist und eine neue Möglichkeit für das LVLM-Training bietet. Vis

Bitweise: Unternehmen kaufen Bitcoin einen vernachlässigten großen Trend

Mar 05, 2025 pm 02:42 PM

Bitweise: Unternehmen kaufen Bitcoin einen vernachlässigten großen Trend

Mar 05, 2025 pm 02:42 PM

Wöchentliche Beobachtung: Unternehmen, die Bitcoin horten - ein Brauenwechsel Ich weise oft auf einige übersehene Markttrends in wöchentlichen Memos. Der Schritt von MicroStrategy ist ein starkes Beispiel. Viele Menschen mögen sagen: "Microstrategy und Michaelsaylor sind bereits bekannt, worauf werden Sie achten?" Diese Ansicht ist einseitig. Eingehende Untersuchungen zur Einführung von Bitcoin als Reserve-Vermögenswert in den letzten Monaten zeigen, dass dies kein isolierter Fall ist, sondern ein wichtiger Trend, der sich herausstellt. Ich gehe davon aus, dass in den nächsten 12 bis 18 Monaten Hunderte von Unternehmen dem Beispiel folgen und große Mengen Bitcoin kaufen werden