Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Sechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!

Sechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!

Sechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!

Apr 19, 2024 pm 12:16 PM

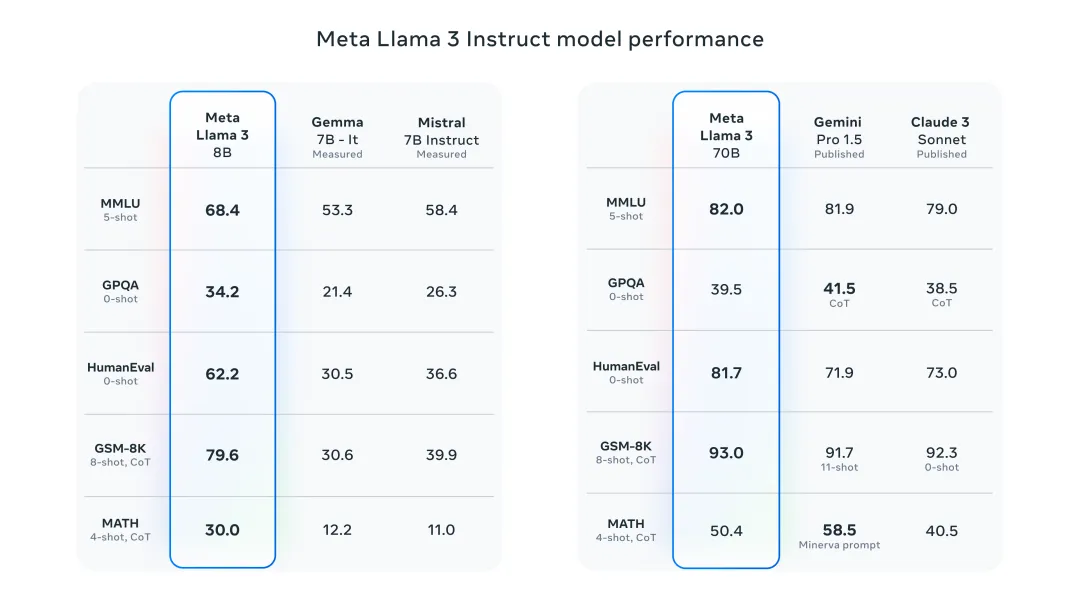

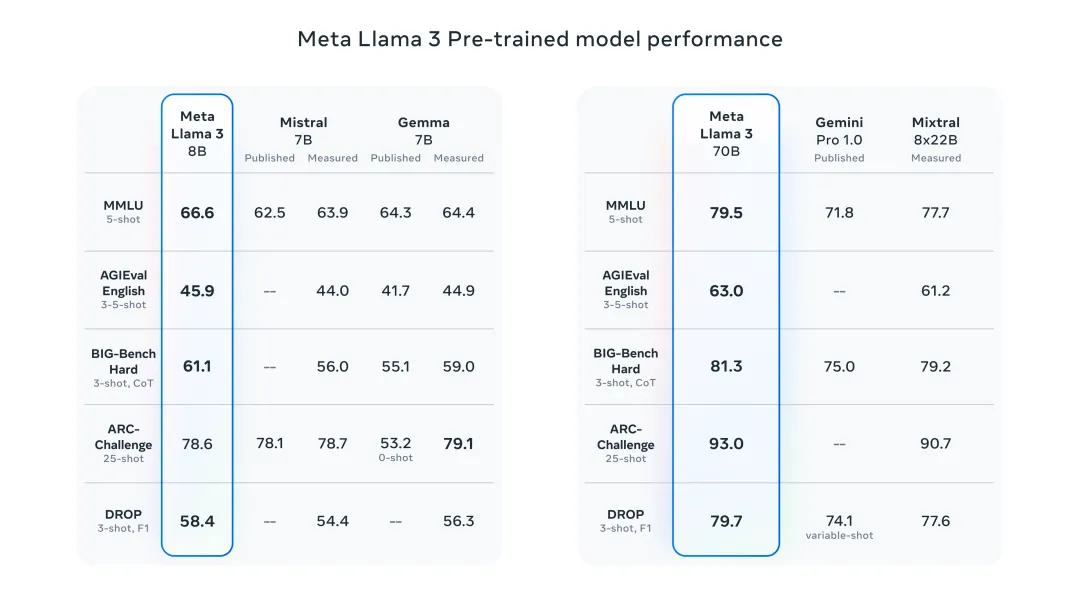

Gestern Abend hat Meta die Llama 3 8B- und 70B-Modelle veröffentlicht, die für Konversations-/Chat-Anwendungsfälle fein abgestimmt und optimiert sind und viele bestehende Open-Source-Chat-Modelle in gängigen Benchmarks übertreffen. Zum Beispiel Gemma 7B und Mistral 7B.

Das Llama+3-Modell verfügt über verbesserte Daten und Skalierbarkeit und erreicht neue Höhen. Es wurde mit mehr als 15T Datentokens auf zwei benutzerdefinierten 24K-GPU-Clustern trainiert, die kürzlich von Meta veröffentlicht wurden. Dieser Trainingsdatensatz ist siebenmal größer als Llama 2 und enthält viermal mehr Code. Dies bringt die Fähigkeiten des Llama-Modells auf das aktuell höchste Niveau und unterstützt Textlängen von mehr als 8 KB, doppelt so viel wie Llama 2.

Im Folgenden stelle ich Ihnen 6 Möglichkeiten vor, wie Sie das neu veröffentlichte Llama 3 schnell erleben können!

Erleben Sie Llama 3 online

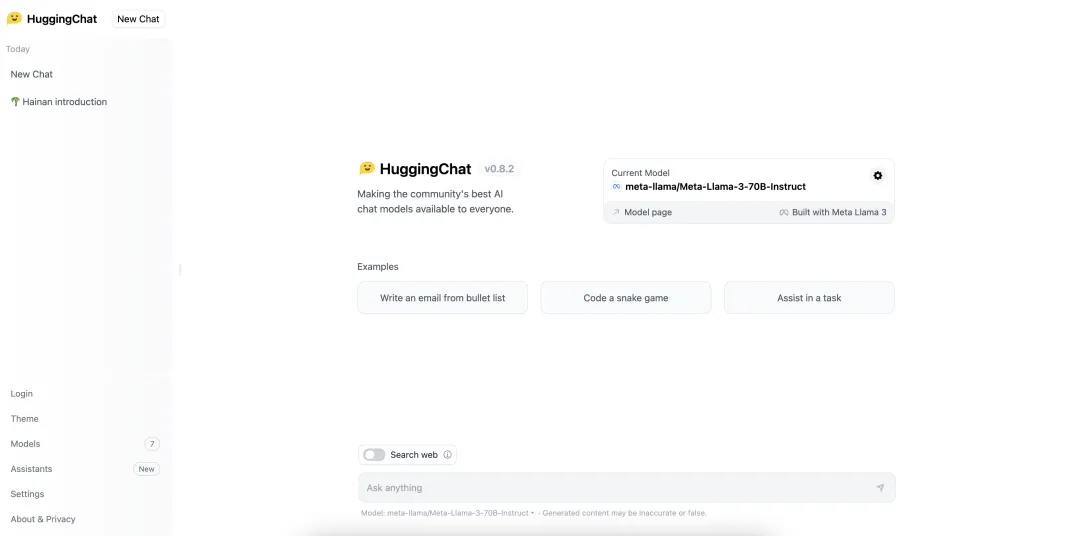

HuggingChat

llama2.ai

https: //www.llama2.ai/

Erleben Sie Llama 3 vor Ort

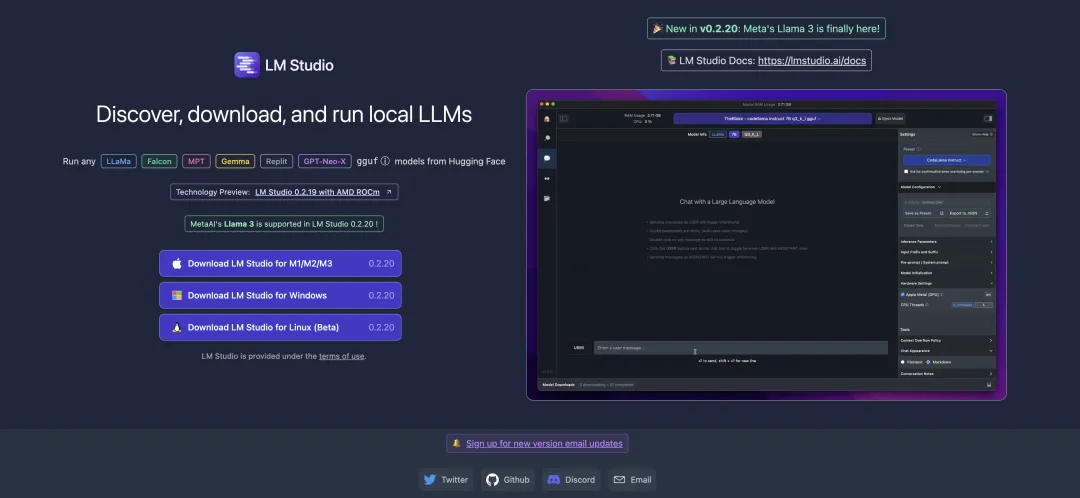

LM Studio

https://lmstudio.ai/

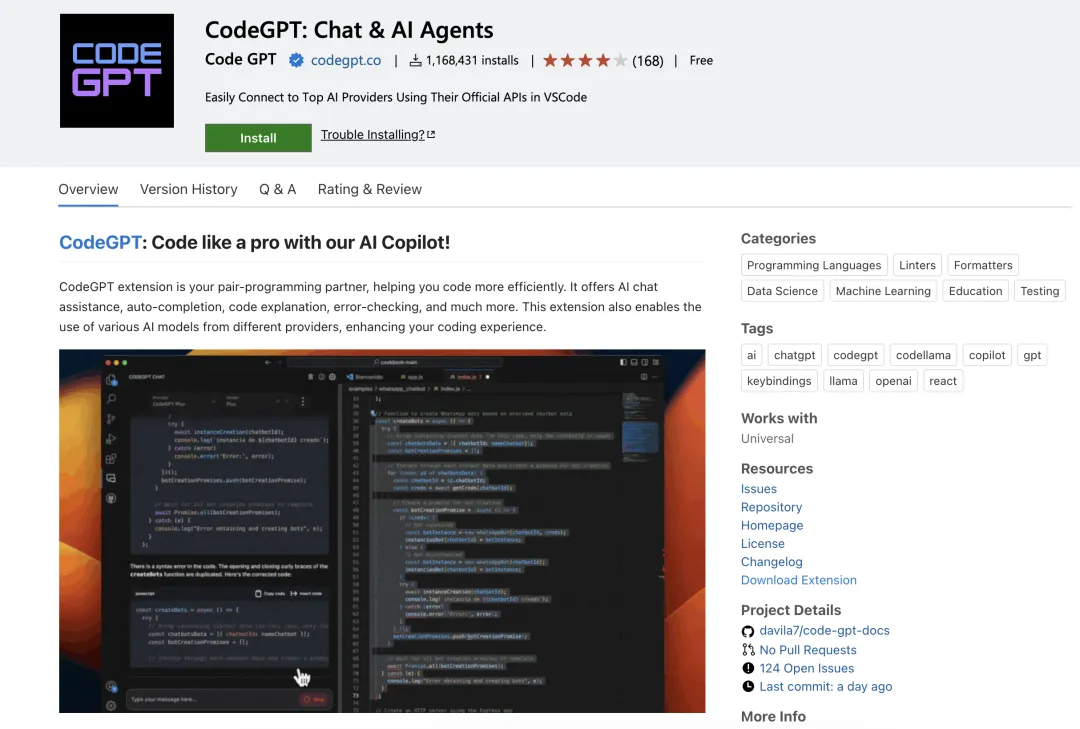

CodeGPT

https ://marketplace.visualstudio.com/items?itemName=DanielSanMedium.dscodegpt&ssr=false

Bevor Sie CodeGPT verwenden, denken Sie daran, Ollama zu verwenden, um das entsprechende Modell abzurufen. Um beispielsweise das Modell „llama3:8b“ zu ziehen: olama pull llama3:8b. Wenn Sie ollama nicht lokal installiert haben, können Sie diesen Artikel „Bereitstellung eines lokalen großen Sprachmodells in nur wenigen Minuten“ lesen.

Ollama

Run Llama 3 8B Modell:

ollama run llama3

Run Llama 3 70B Modell:

ollama run llama3:70b

Open WebUI & Ollama

https://pinokio.computer/item ?uri=https://github.com/cocktailpeanutlabs/open-webui.

Das obige ist der detaillierte Inhalt vonSechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heißer Artikel

Hot-Tools-Tags

Heißer Artikel

Heiße Artikel -Tags

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Zusammenfassung der FAQs für die Verwendung von Deepseek

Feb 19, 2025 pm 03:45 PM

Zusammenfassung der FAQs für die Verwendung von Deepseek

Feb 19, 2025 pm 03:45 PM

Zusammenfassung der FAQs für die Verwendung von Deepseek

Iyo One: Teils Kopfhörer, teils Audiocomputer

Aug 08, 2024 am 01:03 AM

Iyo One: Teils Kopfhörer, teils Audiocomputer

Aug 08, 2024 am 01:03 AM

Iyo One: Teils Kopfhörer, teils Audiocomputer

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Wie registriere ich mich für die LBank Exchange?

Aug 21, 2024 pm 02:20 PM

Wie registriere ich mich für die LBank Exchange?

Aug 21, 2024 pm 02:20 PM

Wie registriere ich mich für die LBank Exchange?

Geplatzte High-End-Träume: Meta hat es offenbar aufgegeben, im Jahr 2027 ein Mixed-Reality-Headset auf den Markt zu bringen

Aug 24, 2024 am 07:30 AM

Geplatzte High-End-Träume: Meta hat es offenbar aufgegeben, im Jahr 2027 ein Mixed-Reality-Headset auf den Markt zu bringen

Aug 24, 2024 am 07:30 AM

Geplatzte High-End-Träume: Meta hat es offenbar aufgegeben, im Jahr 2027 ein Mixed-Reality-Headset auf den Markt zu bringen