Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Lama 3 ist da!

Gerade wurde die offizielle Website von Meta aktualisiert und die Parameterversionen von Lama 3, 8 Milliarden und 70 Milliarden, offiziell angekündigt.

Und der Start ist Open-Source-SOTA:

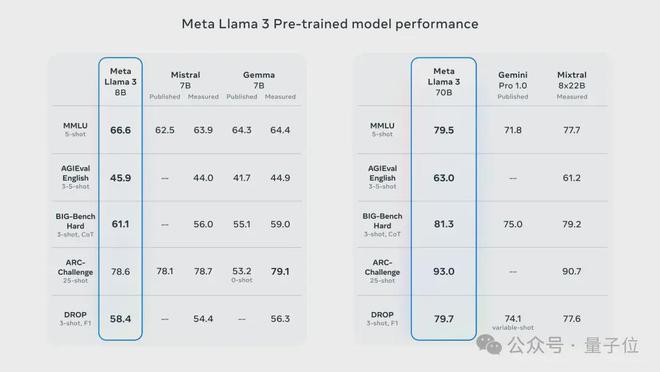

Offizielle Daten von Meta zeigen, dass die Versionen 8B und 70B von Llama 3 alle Konkurrenten in ihren jeweiligen Parameterskalen übertreffen.

8B-Modell übertrifft Gemma 7B und Mistral 7B Instruct bei vielen Benchmarks wie MMLU, GPQA, HumanEval usw.

Das 70B-Modell hat das beliebte Closed-Source-Modell Claude 3 Sonnet übertroffen und ist mit Googles Gemini Pro 1.5 hin und her gegangen.

Sobald der Huggingface-Link herauskam, war die Open-Source-Community wieder aufgeregt.

Die scharfäugigen, blinden Schüler entdeckten auch sofort den Schönheitspunkt:

Meta versteckte sogar eine Version von Llama 3 mit mehr als 400 Milliarden Parametern, die nicht schlechter ist als das supergroße Opus Claude 3!

Der CEO von HyperWriteAI, einem Startup für KI-Schreibassistenten, musste seufzen, als er das sah:

Wir betreten eine neue Welt, eine Welt, in der Modelle auf GPT-4-Ebene Open Source und kostenlos sind zugänglich.

NVIDIA-Wissenschaftler Jim Fan glaubt, dass Llama 3 400B, das sich noch in der Ausbildung befindet, ein Wendepunkt für große Open-Source-Modelle werden und die Art und Weise verändern wird, wie sich viele akademische Forschungs- und Start-up-Unternehmen entwickeln.

Vollständiges SOTA, aber 8k-Fenster

Weitere technische Details gibt Meta im Blogbeitrag.

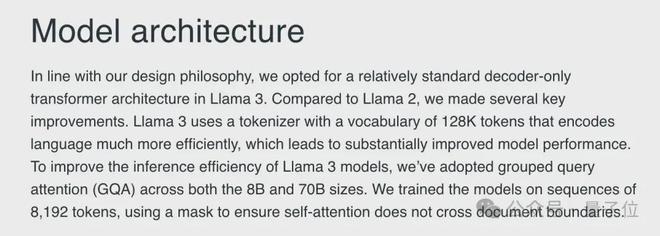

Auf der Architekturebene wählte Llama 3 die klassische Transformer-Architektur nur für Decoder und verwendete einen Wortsegmentierer mit einem 128K-Token-Vokabular.

Ein Blick auf die Trainingsdaten zeigt, dass die Trainingsdatenskala von Llama 3 15T-Token erreicht hat, die alle aus öffentlichen Informationen stammen, von denen 5 % nicht-englische Daten sind und mehr als 30 Sprachen abdecken.

Llama 3 hat 7-mal mehr Trainingsdaten als Llama 2 und enthält 4-mal mehr Code als Llama 2.

Um die Argumentationseffizienz des Llama 3-Modells zu verbessern, übernimmt Meta AI außerdem den Group Query Attention (GQA)-Mechanismus, um das Modell anhand einer Sequenz von 8192 Token zu trainieren, und verwendet eine Maske, um sicherzustellen, dass Selbst- Aufmerksamkeit überschreitet keine Dokumentgrenzen.

Unabhängig davon, ob es sich um die 8B- oder 70B-Version handelt, hat Llama 3 im Vergleich zur Vorgängergeneration Llama 2 ähnlicher Größe einen großen Sprung nach vorne gemacht.

Unter den bisherigen Modellen mit 8B- und 70B-Parameterskala ist Llama 3 das neue SOTA-Modell.

In Bezug auf Sprache (MMLU), Wissen (GPQA), Programmierung (HumanEval), Mathematik (GSM-8K, MATH) und andere Fähigkeiten ist Llama 3 anderen Modellen der gleichen Größenordnung fast vollständig voraus.

Zusätzlich zu diesen regulären Datensätzen hat Meta AI auch die Leistung von Llama 3 in realen Szenarien bewertet und zu diesem Zweck einen Satz hochwertiger Testdatensätze entwickelt.

Dieser Testsatz enthält 1.800 Daten, die 12 wichtige Anwendungsfälle wie Codierung, Argumentation, Schreiben und Zusammenfassung abdecken, und ist für das Entwicklungsteam vertraulich.

Dadurch hat Llama 3 nicht nur Llama 2 deutlich übertroffen, sondern auch bekannte Modelle wie Claude 3 Sonnet, Mistral Medium und GPT-3.5 besiegt.

Bei höherwertigen und schwierigeren Datensätzen wie AGIEval, BIG-Bench und ARC-Challenge ist die Leistung von Llama 3 ebenfalls bemerkenswert.

Die 8B-Version übertraf Mistral und Gemma bei diesen Aufgaben, während die 70B-Version Gemini Pro und Mixtral mit MoE-Architektur besiegte und jeweils SOTAs entsprechender Größe gewann.

Der einzige Nachteil ist jedoch, dass das Kontextfenster von Llama 3 im Vergleich zu den aktuellen großen Modellen mit Dutzenden oder Millionen Fenstern immer noch in der vorherigen Generation steckt (manueller Hundekopf). .

Aber machen Sie sich darüber keine allzu großen Sorgen. Matt Shumer ist optimistisch, dass die Fensterlänge durch die Bemühungen der Open-Source-Community bald erweitert wird.

Llama begrüßt die offizielle Webversion

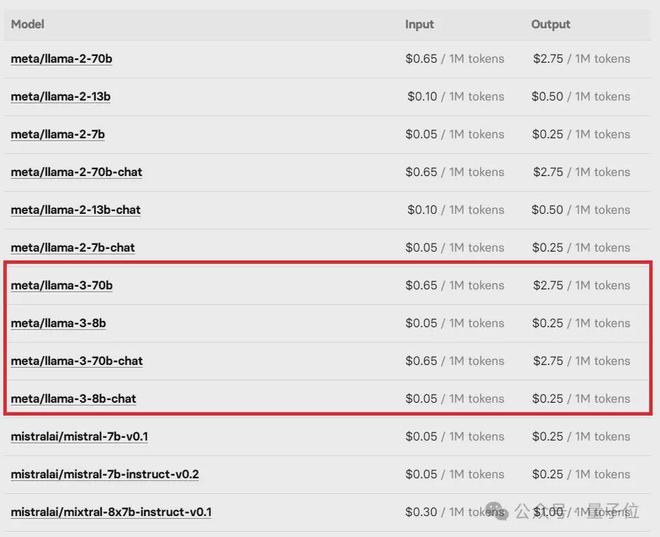

Derzeit stehen die Basis- und Instruct-Versionen der beiden Parameter von Llama 3 auf Hugging Face zum Download bereit.

Darüber hinaus werden auch Cloud-Service-Plattformen wie Microsoft Azure, Google Cloud, Amazon AWS und NVIDIA NIM Llama 3 nacheinander starten.

Gleichzeitig sagte Meta auch, dass Llama 3 von Hardwareplattformen unterstützt wird, die von Intel, NVIDIA, AMD, Qualcomm und anderen Herstellern bereitgestellt werden.

Erwähnenswert ist, dass es dieses Mal zusammen mit dem Basismodell auch eine offizielle Webversion basierend auf Llama 3 namens Meta AI gibt.

Derzeit verfügt die Plattform über zwei Hauptfunktionen: Dialog und Malen. Wenn Sie nur den Dialog nutzen, müssen Sie sich nicht registrieren und können die Malfunktion sofort nutzen Sie müssen sich zunächst bei Ihrem Konto anmelden.

Allerdings unterstützt die Plattform derzeit kein Chinesisch und Funktionen wie das Hochladen von Texten wurden noch nicht gestartet.

In Bezug auf den Code kann die Plattform auch einige einfache Python-Programme ausführen, aber es scheint, dass sie nur Text ausgeben kann und Aufgaben mit Zeichnungen nicht ausgeführt werden können.

Im Allgemeinen ist diese Webversion noch relativ rudimentär, aber Sie können sich genauso gut auf eine Welle nachfolgender Updates freuen.

Noch eine Sache

Ein kleiner Vorfall ist, dass der Azure-Markt von Microsoft bereits wenige Stunden vor Metas offizieller Ankündigung die Nachricht von der Llama 3 8B Instruct-Version gestohlen hatte.

Die Llama 3-Preisliste auf der Open-Source-Online-Plattform für maschinelles Lernen Replicate wurde ebenfalls sofort von Internetnutzern herausgezogen.

Aber bald waren diese „Tattletales“ alle 404’d.

Glücklicherweise ist der Fehler vorbei und die Beamten zögern nicht. Freunde, die sich für große Open-Source-Modelle interessieren, können anfangen zu dogen.

参考链接:

[1]https://ai.meta.com/blog/meta-llama-3/。

[2]https://about.fb.com/news/2024 /04/meta-ai-assistant-built-with-llama-3/。

[3]https://huggingface.co/meta-llama/Meta-Llama-3-70B。

Das obige ist der detaillierte Inhalt vonLama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

MySQL hat eine kostenlose Community -Version und eine kostenpflichtige Enterprise -Version. Die Community -Version kann kostenlos verwendet und geändert werden, die Unterstützung ist jedoch begrenzt und für Anwendungen mit geringen Stabilitätsanforderungen und starken technischen Funktionen geeignet. Die Enterprise Edition bietet umfassende kommerzielle Unterstützung für Anwendungen, die eine stabile, zuverlässige Hochleistungsdatenbank erfordern und bereit sind, Unterstützung zu bezahlen. Zu den Faktoren, die bei der Auswahl einer Version berücksichtigt werden, gehören Kritikalität, Budgetierung und technische Fähigkeiten von Anwendungen. Es gibt keine perfekte Option, nur die am besten geeignete Option, und Sie müssen die spezifische Situation sorgfältig auswählen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Wie richte ich PS -Federn ein?

Apr 06, 2025 pm 07:36 PM

Wie richte ich PS -Federn ein?

Apr 06, 2025 pm 07:36 PM

PS Federn ist ein Bildkantenschwärcheneffekt, der durch den gewichteten Durchschnitt der Pixel im Randbereich erreicht wird. Das Einstellen des Federradius kann den Grad der Unschärfe steuern und je größer der Wert ist, desto unscharfer ist er. Eine flexible Einstellung des Radius kann den Effekt entsprechend den Bildern und Bedürfnissen optimieren. Verwenden Sie beispielsweise einen kleineren Radius, um Details bei der Verarbeitung von Charakterfotos zu erhalten und einen größeren Radius zu verwenden, um ein dunstiges Gefühl bei der Verarbeitung von Kunst zu erzeugen. Es ist jedoch zu beachten, dass zu groß der Radius leicht an Kantendetails verlieren kann, und zu klein ist der Effekt nicht offensichtlich. Der Federneffekt wird von der Bildauflösung beeinflusst und muss anhand des Bildverständnisses und des Griffs von Effekten angepasst werden.

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

MySQL hat sich geweigert, anzufangen? Nicht in Panik, lass es uns ausprobieren! Viele Freunde stellten fest, dass der Service nach der Installation von MySQL nicht begonnen werden konnte, und sie waren so ängstlich! Mach dir keine Sorgen, dieser Artikel wird dich dazu bringen, ruhig damit umzugehen und den Mastermind dahinter herauszufinden! Nachdem Sie es gelesen haben, können Sie dieses Problem nicht nur lösen, sondern auch Ihr Verständnis von MySQL -Diensten und Ihren Ideen zur Fehlerbehebungsproblemen verbessern und zu einem leistungsstärkeren Datenbankadministrator werden! Der MySQL -Dienst startete nicht und es gibt viele Gründe, von einfachen Konfigurationsfehlern bis hin zu komplexen Systemproblemen. Beginnen wir mit den häufigsten Aspekten. Grundkenntnisse: Eine kurze Beschreibung des Service -Startup -Prozesses MySQL Service Startup. Einfach ausgedrückt, lädt das Betriebssystem MySQL-bezogene Dateien und startet dann den MySQL-Daemon. Dies beinhaltet die Konfiguration

Die MySQL -Download -Datei ist beschädigt und kann nicht installiert werden. Reparaturlösung

Apr 08, 2025 am 11:21 AM

Die MySQL -Download -Datei ist beschädigt und kann nicht installiert werden. Reparaturlösung

Apr 08, 2025 am 11:21 AM

Die MySQL -Download -Datei ist beschädigt. Was soll ich tun? Wenn Sie MySQL herunterladen, können Sie die Korruption der Datei begegnen. Es ist heutzutage wirklich nicht einfach! In diesem Artikel wird darüber gesprochen, wie dieses Problem gelöst werden kann, damit jeder Umwege vermeiden kann. Nach dem Lesen können Sie nicht nur das beschädigte MySQL -Installationspaket reparieren, sondern auch ein tieferes Verständnis des Download- und Installationsprozesses haben, um zu vermeiden, dass Sie in Zukunft stecken bleiben. Lassen Sie uns zunächst darüber sprechen, warum das Herunterladen von Dateien beschädigt wird. Dafür gibt es viele Gründe. Netzwerkprobleme sind der Schuldige. Unterbrechung des Download -Prozesses und der Instabilität im Netzwerk kann zu einer Korruption von Dateien führen. Es gibt auch das Problem mit der Download -Quelle selbst. Die Serverdatei selbst ist gebrochen und natürlich auch unterbrochen, wenn Sie sie herunterladen. Darüber hinaus kann das übermäßige "leidenschaftliche" Scannen einer Antiviren -Software auch zu einer Beschädigung von Dateien führen. Diagnoseproblem: Stellen Sie fest, ob die Datei wirklich beschädigt ist

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.