Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

CVPR 2024-Highscore-Papier: Neues generatives Bearbeitungsframework GenN2N, das NeRF-Konvertierungsaufgaben vereinheitlicht

CVPR 2024-Highscore-Papier: Neues generatives Bearbeitungsframework GenN2N, das NeRF-Konvertierungsaufgaben vereinheitlicht

CVPR 2024-Highscore-Papier: Neues generatives Bearbeitungsframework GenN2N, das NeRF-Konvertierungsaufgaben vereinheitlicht

Die AIxiv-Kolumne unserer Website ist eine Kolumne über akademische und technische Inhalte. In den letzten Jahren hat die AIxiv-Kolumne auf unserer Website mehr als 2.000 Inhalte erhalten, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. Die E-Mail-Adresse für die Einreichung lautet liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com.

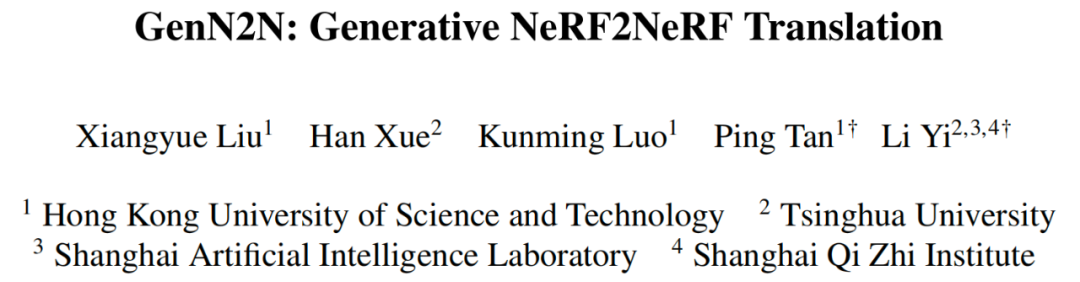

Papieradresse: https://arxiv.org/abs/2404.02788 Papierhomepage: https://xiangyueliu.github.io/GenN2N/ Git Hub-Adresse: https://github.com/Lxiangyue/GenN2N Papiertitel: GenN2N: Generative NeRF2NeRF Translation

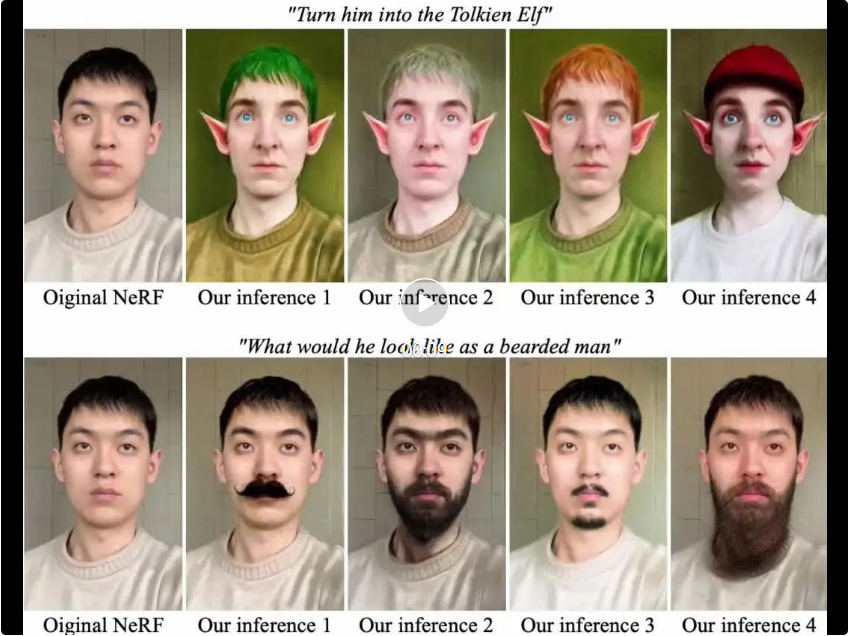

Im Kernteil von GenN2N wird 1) das generative Framework von 3D VAE-GAN eingeführt, wobei VAE verwendet wird, um den gesamten Bearbeitungsraum darzustellen und alle möglichen 3D-NeRF-Bearbeitungsverteilungen zu lernen, die einem Satz eingegebener 2D-Bearbeitungsbilder entsprechen , und verwenden Sie GAN, um eine angemessene Überwachung für die Bearbeitung verschiedener Ansichten von NeRF bereitzustellen, um die Authentizität der Bearbeitungsergebnisse sicherzustellen. 2) Verwenden Sie kontrastives Lernen, um die Bearbeitungsinhalte und -perspektiven zu entkoppeln, um die Konsistenz der Bearbeitungsinhalte zwischen verschiedenen Perspektiven sicherzustellen , Der Benutzer kann durch einfaches zufälliges Abtasten mehrerer Bearbeitungscodes aus dem bedingten Generierungsmodell verschiedene 3D-Bearbeitungsergebnisse generieren, die dem Bearbeitungsziel entsprechen.

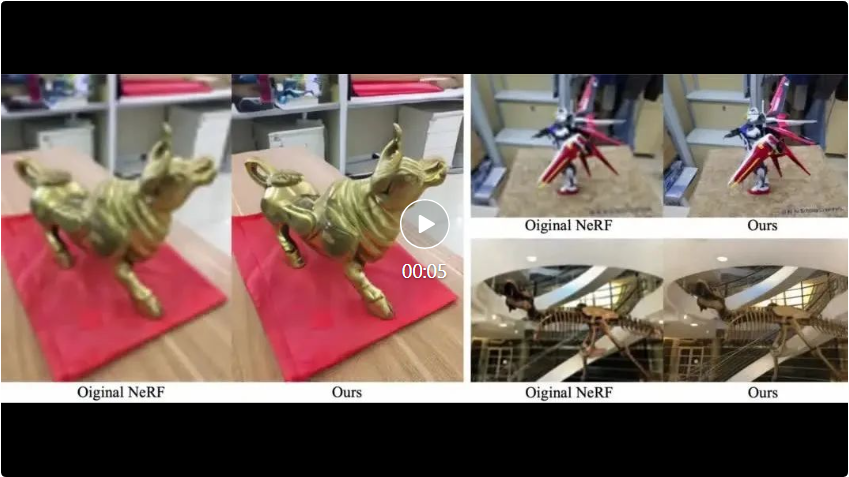

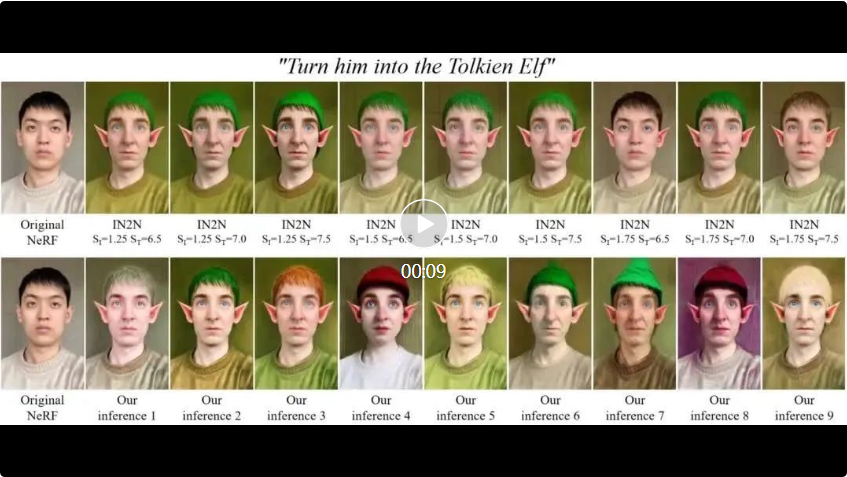

Im Vergleich zu SOTA-Methoden für verschiedene NeRF-Bearbeitungsaufgaben (ICCV2023 Oral usw.) ist GenN2N bestehenden Methoden hinsichtlich Bearbeitungsqualität, Vielfalt, Effizienz usw. überlegen.

Wir führen zunächst eine 2D-Bildbearbeitung durch und aktualisieren diese 2D-Bearbeitungen dann auf 3D-NeRF, um eine generative NeRF-zu-NeRF-Konvertierung zu erreichen.

(negative Probe) oder das bearbeitete Bild

(negative Probe) oder das bearbeitete Bild  (positive Probe) in den Trainingsdaten identifiziert, wählen wir ein bearbeitetes Bild

(positive Probe) in den Trainingsdaten identifiziert, wählen wir ein bearbeitetes Bild  derselben Perspektive aus den Trainingsdaten als Bedingung aus, was das verhindert Der Diskriminator wird nicht durch perspektivische Faktoren bei der Unterscheidung positiver und negativer Proben beeinträchtigt.

derselben Perspektive aus den Trainingsdaten als Bedingung aus, was das verhindert Der Diskriminator wird nicht durch perspektivische Faktoren bei der Unterscheidung positiver und negativer Proben beeinträchtigt.  B.

B.  Vergleichsexperimente

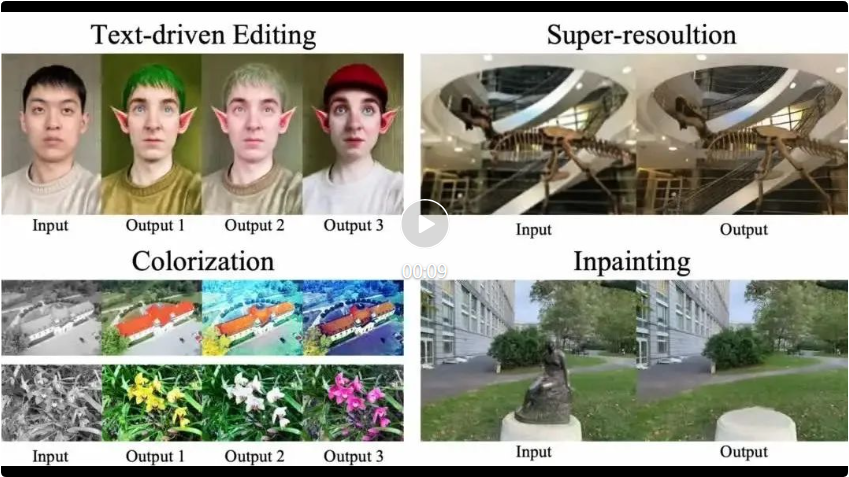

Vergleichsexperimente  Unsere Methode wird qualitativ und quantitativ verglichen mit SOTA-Methoden für verschiedene spezifische NeRF-Aufgaben ( einschließlich textgesteuerter Bearbeitung, Kolorierung, Superauflösung und Inpainting usw.). Die Ergebnisse zeigen, dass GenN2N als allgemeines Framework eine ebenso gute oder bessere Leistung erbringt als aufgabenspezifisches SOTA, während die Bearbeitungsergebnisse eine größere Vielfalt aufweisen (im Folgenden ist ein Vergleich zwischen GenN2N und Instruct-NeRF2NeRF für die textbasierte NeRF-Bearbeitungsaufgabe aufgeführt). ).

Unsere Methode wird qualitativ und quantitativ verglichen mit SOTA-Methoden für verschiedene spezifische NeRF-Aufgaben ( einschließlich textgesteuerter Bearbeitung, Kolorierung, Superauflösung und Inpainting usw.). Die Ergebnisse zeigen, dass GenN2N als allgemeines Framework eine ebenso gute oder bessere Leistung erbringt als aufgabenspezifisches SOTA, während die Bearbeitungsergebnisse eine größere Vielfalt aufweisen (im Folgenden ist ein Vergleich zwischen GenN2N und Instruct-NeRF2NeRF für die textbasierte NeRF-Bearbeitungsaufgabe aufgeführt). ).

Das obige ist der detaillierte Inhalt vonCVPR 2024-Highscore-Papier: Neues generatives Bearbeitungsframework GenN2N, das NeRF-Konvertierungsaufgaben vereinheitlicht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Welche Bibliotheken werden für die Operationen der schwimmenden Punktzahl in Go verwendet?

Apr 02, 2025 pm 02:06 PM

Welche Bibliotheken werden für die Operationen der schwimmenden Punktzahl in Go verwendet?

Apr 02, 2025 pm 02:06 PM

In der Bibliothek, die für den Betrieb der Schwimmpunktnummer in der GO-Sprache verwendet wird, wird die Genauigkeit sichergestellt, wie die Genauigkeit ...

So führen Sie das H5 -Projekt aus

Apr 06, 2025 pm 12:21 PM

So führen Sie das H5 -Projekt aus

Apr 06, 2025 pm 12:21 PM

Ausführen des H5 -Projekts erfordert die folgenden Schritte: Installation der erforderlichen Tools wie Webserver, Node.js, Entwicklungstools usw. Erstellen Sie eine Entwicklungsumgebung, erstellen Sie Projektordner, initialisieren Sie Projekte und schreiben Sie Code. Starten Sie den Entwicklungsserver und führen Sie den Befehl mit der Befehlszeile aus. Vorschau des Projekts in Ihrem Browser und geben Sie die Entwicklungsserver -URL ein. Veröffentlichen Sie Projekte, optimieren Sie Code, stellen Sie Projekte bereit und richten Sie die Webserverkonfiguration ein.

Gitee Pages statische Website -Bereitstellung fehlgeschlagen: Wie können Sie einzelne Dateien 404 Fehler beheben und beheben?

Apr 04, 2025 pm 11:54 PM

Gitee Pages statische Website -Bereitstellung fehlgeschlagen: Wie können Sie einzelne Dateien 404 Fehler beheben und beheben?

Apr 04, 2025 pm 11:54 PM

GitePages statische Website -Bereitstellung fehlgeschlagen: 404 Fehlerbehebung und Auflösung bei der Verwendung von Gitee ...

Welche Bibliotheken in GO werden von großen Unternehmen entwickelt oder von bekannten Open-Source-Projekten bereitgestellt?

Apr 02, 2025 pm 04:12 PM

Welche Bibliotheken in GO werden von großen Unternehmen entwickelt oder von bekannten Open-Source-Projekten bereitgestellt?

Apr 02, 2025 pm 04:12 PM

Welche Bibliotheken in GO werden von großen Unternehmen oder bekannten Open-Source-Projekten entwickelt? Bei der Programmierung in Go begegnen Entwickler häufig auf einige häufige Bedürfnisse, ...

Wie gibt ich die mit dem Modell in Beego Orm zugeordnete Datenbank an?

Apr 02, 2025 pm 03:54 PM

Wie gibt ich die mit dem Modell in Beego Orm zugeordnete Datenbank an?

Apr 02, 2025 pm 03:54 PM

Wie kann man im Beegoorm -Framework die mit dem Modell zugeordnete Datenbank angeben? In vielen BeEGO -Projekten müssen mehrere Datenbanken gleichzeitig betrieben werden. Bei Verwendung von BeEGO ...

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Die H5 -Seite muss aufgrund von Faktoren wie Code -Schwachstellen, Browserkompatibilität, Leistungsoptimierung, Sicherheitsaktualisierungen und Verbesserungen der Benutzererfahrung kontinuierlich aufrechterhalten werden. Zu den effektiven Wartungsmethoden gehören das Erstellen eines vollständigen Testsystems, die Verwendung von Versionstools für Versionskontrolle, die regelmäßige Überwachung der Seitenleistung, das Sammeln von Benutzern und die Formulierung von Wartungsplänen.

Wie löste ich das Problem des Typs des user_id -Typs bei der Verwendung von Redis -Stream, um Nachrichtenwarteschlangen in GO -Sprache zu implementieren?

Apr 02, 2025 pm 04:54 PM

Wie löste ich das Problem des Typs des user_id -Typs bei der Verwendung von Redis -Stream, um Nachrichtenwarteschlangen in GO -Sprache zu implementieren?

Apr 02, 2025 pm 04:54 PM

Das Problem der Verwendung von RETISTREAM zur Implementierung von Nachrichtenwarteschlangen in der GO -Sprache besteht darin, die Go -Sprache und Redis zu verwenden ...

Python Hourglass Graph Drawing: Wie vermeiden Sie variable undefinierte Fehler?

Apr 01, 2025 pm 06:27 PM

Python Hourglass Graph Drawing: Wie vermeiden Sie variable undefinierte Fehler?

Apr 01, 2025 pm 06:27 PM

Erste Schritte mit Python: Hourglas -Grafikzeichnung und Eingabeüberprüfung In diesem Artikel wird das Problem der Variablendefinition gelöst, das von einem Python -Anfänger im Hourglass -Grafikzeichnungsprogramm auftritt. Code...