Wie wählt man ein Java-Big-Data-Verarbeitungsframework aus?

Das Java-Big-Data-Verarbeitungsframework wurde entwickelt, um unterschiedliche Anforderungen zu erfüllen: Hadoop-Ökosystem: skalierbar, fehlertolerant, geeignet für die Verarbeitung massiver Offline-Daten (z. B. die Verarbeitung von Transaktionsdaten durch Einzelhändler). Apache Spark: Schnell, unterstützt Echtzeitverarbeitung und maschinelles Lernen (z. B. personalisierte Inhaltsempfehlungen für Medienunternehmen). Apache Flink: Geringe Latenz, hohe Fehlertoleranz, konzipiert für Echtzeit-Stream-Verarbeitung (z. B. Betrugserkennung in Finanzinstituten). Bei der Auswahl sollten Faktoren wie Datengröße, Verarbeitungsgeschwindigkeit, Echtzeitleistung und Integration maschinellen Lernens berücksichtigt werden.

Leitfaden zur Auswahl des Java Big Data Processing Frameworks

Mit dem Aufkommen des Big Data-Zeitalters ist die Beherrschung eines geeigneten Java Big Data Processing Frameworks für Unternehmen von entscheidender Bedeutung geworden. In diesem Artikel werden gängige Java-Frameworks für die Big-Data-Verarbeitung verglichen und praktische Beispiele vorgestellt, die Ihnen dabei helfen, eine kluge Wahl zu treffen.

1. Hadoop-Ökosystem

Hadoop ist das branchenweit führende Big-Data-Verarbeitungsframework, bestehend aus einem verteilten HDFS-Dateisystem und einer MapReduce-Rechner-Engine. Zu seinen Vorteilen gehören:

- Skalierbarkeit: kann große Datenmengen verarbeiten

- Fehlertoleranz: kann automatisch wiederhergestellt werden, wenn ein Knoten ausfällt

Praktischer Fall:

Ein großer Einzelhändler verwendet Hadoop, um Millionen von Kundentransaktionsdaten zu verarbeiten. Hadoop ermöglicht ihnen die schnelle Analyse großer Datensätze, um wertvolle Erkenntnisse über das Kundenverhalten zu gewinnen.

2. Apache Spark

Spark ist ein In-Memory-Computing-Framework, das auf Hadoop basiert. Es bietet die folgenden Vorteile:

- Geschwindigkeit: 100-mal schneller als MapReduce

- Echtzeitverarbeitung: Unterstützt Streaming-Datenverarbeitung

- Maschinelles Lernen: Bietet integrierte Bibliothek für maschinelles Lernen

Praktischer Fall:

A Medienunternehmen Verwenden Sie Spark, um Benutzerdaten in Echtzeit zu analysieren, um Inhaltsempfehlungen zu personalisieren und das Benutzerengagement zu erhöhen. Die hohe Rechengeschwindigkeit von Spark ermöglicht es ihnen, datenbasierte Entscheidungen im Handumdrehen zu treffen.

3. Apache Flink

Flink ist eine verteilte Stream-Verarbeitungs-Engine. Zu seinen Funktionen gehören:

- Geringe Latenz: kann Millionen von Ereignissen pro Sekunde verarbeiten

- Hohe Fehlertoleranz: garantierte Datenkonsistenz auch bei Knotenausfall

- Unterstützt mehrere Datenquellen: einschließlich Kafka, Flume und benutzerdefinierte Quellen

Praxisfall:

Ein Finanzinstitut nutzt Flink, um ein Echtzeit-Betrugserkennungssystem aufzubauen. Die Verarbeitungsfunktionen von Flink mit geringer Latenz ermöglichen es ihnen, betrügerische Transaktionen schnell zu erkennen und Verluste zu verhindern.

Auswahlkriterien

Berücksichtigen Sie bei der Auswahl eines Big-Data-Verarbeitungsframeworks die folgenden Faktoren:

- Datengröße: die Datenmenge, die Sie verarbeiten müssen

- Verarbeitungsgeschwindigkeit: wie schnell die Verarbeitung erforderlich ist

- Echtzeit : ob es erforderlich ist Echtzeitverarbeitungsfunktionen

- Integration maschinellen Lernens: Benötigen Sie maschinelle Lernfunktionen?

Fazit

Es ist entscheidend, das richtige Java-Big-Data-Verarbeitungsframework für Ihre spezifischen Anforderungen auszuwählen. Das Hadoop-Ökosystem bietet Skalierbarkeit und Fehlertoleranz, Spark bietet Geschwindigkeit und Echtzeitverarbeitung und Flink ist auf Stream-Verarbeitung spezialisiert. Wenn Sie die Vorteile und praktischen Beispiele dieser Frameworks verstehen, können Sie fundierte Entscheidungen treffen, um das Potenzial von Big Data für Ihr Unternehmen auszuschöpfen.

Das obige ist der detaillierte Inhalt vonWie wählt man ein Java-Big-Data-Verarbeitungsframework aus?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1371

1371

52

52

Brechen oder aus Java 8 Stream foreach zurückkehren?

Feb 07, 2025 pm 12:09 PM

Brechen oder aus Java 8 Stream foreach zurückkehren?

Feb 07, 2025 pm 12:09 PM

Java 8 führt die Stream -API ein und bietet eine leistungsstarke und ausdrucksstarke Möglichkeit, Datensammlungen zu verarbeiten. Eine häufige Frage bei der Verwendung von Stream lautet jedoch: Wie kann man von einem Foreach -Betrieb brechen oder zurückkehren? Herkömmliche Schleifen ermöglichen eine frühzeitige Unterbrechung oder Rückkehr, aber die Stream's foreach -Methode unterstützt diese Methode nicht direkt. In diesem Artikel werden die Gründe erläutert und alternative Methoden zur Implementierung vorzeitiger Beendigung in Strahlverarbeitungssystemen erforscht. Weitere Lektüre: Java Stream API -Verbesserungen Stream foreach verstehen Die Foreach -Methode ist ein Terminalbetrieb, der einen Vorgang für jedes Element im Stream ausführt. Seine Designabsicht ist

Gestalten Sie die Zukunft: Java-Programmierung für absolute Anfänger

Oct 13, 2024 pm 01:32 PM

Gestalten Sie die Zukunft: Java-Programmierung für absolute Anfänger

Oct 13, 2024 pm 01:32 PM

Java ist eine beliebte Programmiersprache, die sowohl von Anfängern als auch von erfahrenen Entwicklern erlernt werden kann. Dieses Tutorial beginnt mit grundlegenden Konzepten und geht dann weiter zu fortgeschrittenen Themen. Nach der Installation des Java Development Kit können Sie das Programmieren üben, indem Sie ein einfaches „Hello, World!“-Programm erstellen. Nachdem Sie den Code verstanden haben, verwenden Sie die Eingabeaufforderung, um das Programm zu kompilieren und auszuführen. Auf der Konsole wird „Hello, World!“ ausgegeben. Mit dem Erlernen von Java beginnt Ihre Programmierreise, und wenn Sie Ihre Kenntnisse vertiefen, können Sie komplexere Anwendungen erstellen.

Java -Programm, um das Kapselvolumen zu finden

Feb 07, 2025 am 11:37 AM

Java -Programm, um das Kapselvolumen zu finden

Feb 07, 2025 am 11:37 AM

Kapseln sind dreidimensionale geometrische Figuren, die aus einem Zylinder und einer Hemisphäre an beiden Enden bestehen. Das Volumen der Kapsel kann berechnet werden, indem das Volumen des Zylinders und das Volumen der Hemisphäre an beiden Enden hinzugefügt werden. In diesem Tutorial wird erörtert, wie das Volumen einer bestimmten Kapsel in Java mit verschiedenen Methoden berechnet wird. Kapselvolumenformel Die Formel für das Kapselvolumen lautet wie folgt: Kapselvolumen = zylindrisches Volumenvolumen Zwei Hemisphäre Volumen In, R: Der Radius der Hemisphäre. H: Die Höhe des Zylinders (ohne die Hemisphäre). Beispiel 1 eingeben Radius = 5 Einheiten Höhe = 10 Einheiten Ausgabe Volumen = 1570,8 Kubikeinheiten erklären Berechnen Sie das Volumen mithilfe der Formel: Volumen = π × R2 × H (4

Java leicht gemacht: Ein Leitfaden für Anfänger zur Programmierleistung

Oct 11, 2024 pm 06:30 PM

Java leicht gemacht: Ein Leitfaden für Anfänger zur Programmierleistung

Oct 11, 2024 pm 06:30 PM

Java leicht gemacht: Ein Leitfaden für Anfänger zur leistungsstarken Programmierung Java ist eine leistungsstarke Programmiersprache, die in allen Bereichen von mobilen Anwendungen bis hin zu Systemen auf Unternehmensebene verwendet wird. Für Anfänger ist die Syntax von Java einfach und leicht zu verstehen, was es zu einer idealen Wahl zum Erlernen des Programmierens macht. Grundlegende Syntax Java verwendet ein klassenbasiertes objektorientiertes Programmierparadigma. Klassen sind Vorlagen, die zusammengehörige Daten und Verhaltensweisen organisieren. Hier ist ein einfaches Java-Klassenbeispiel: publicclassPerson{privateStringname;privateintage;

Wie führe ich Ihre erste Spring -Boot -Anwendung in der Spring Tool Suite aus?

Feb 07, 2025 pm 12:11 PM

Wie führe ich Ihre erste Spring -Boot -Anwendung in der Spring Tool Suite aus?

Feb 07, 2025 pm 12:11 PM

Spring Boot vereinfacht die Schaffung robuster, skalierbarer und produktionsbereiteter Java-Anwendungen, wodurch die Java-Entwicklung revolutioniert wird. Der Ansatz "Übereinkommen über Konfiguration", der dem Feder -Ökosystem inhärent ist, minimiert das manuelle Setup, Allo

Wie kann man Node.js oder Python -Dienste in Lampenarchitektur effizient integrieren?

Apr 01, 2025 pm 02:48 PM

Wie kann man Node.js oder Python -Dienste in Lampenarchitektur effizient integrieren?

Apr 01, 2025 pm 02:48 PM

Viele Website -Entwickler stehen vor dem Problem der Integration von Node.js oder Python Services unter der Lampenarchitektur: Die vorhandene Lampe (Linux Apache MySQL PHP) Architekturwebsite benötigt ...

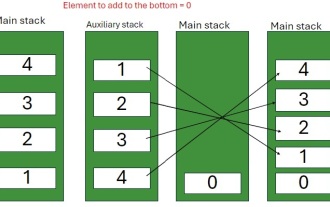

Java -Programm zum Einfügen eines Elements am unteren Rand eines Stapels

Feb 07, 2025 am 11:59 AM

Java -Programm zum Einfügen eines Elements am unteren Rand eines Stapels

Feb 07, 2025 am 11:59 AM

Ein Stapel ist eine Datenstruktur, die dem LIFO -Prinzip (zuletzt, zuerst heraus) folgt. Mit anderen Worten, das letzte Element, das wir einem Stapel hinzufügen, ist das erste, das entfernt wird. Wenn wir einem Stapel Elemente hinzufügen (oder drücken), werden sie oben platziert. vor allem der

Wie leite ich Ihre erste Spring -Boot -Anwendung in Intellij aus?

Feb 07, 2025 am 11:40 AM

Wie leite ich Ihre erste Spring -Boot -Anwendung in Intellij aus?

Feb 07, 2025 am 11:40 AM

Intellij IDEA vereinfacht die Spring -Boot -Entwicklung und macht es zu einem Favoriten bei Java -Entwicklern. Der Ansatz mit Konvention und Konfiguration minimiert den Code von Boilerplate und ermöglicht es Entwicklern, sich auf die Geschäftslogik zu konzentrieren. Dieses Tutorial zeigt zwei Methoden