Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neuer Test-Benchmark veröffentlicht, der leistungsstärkste Open-Source-Llama 3 ist peinlich

Neuer Test-Benchmark veröffentlicht, der leistungsstärkste Open-Source-Llama 3 ist peinlich

Neuer Test-Benchmark veröffentlicht, der leistungsstärkste Open-Source-Llama 3 ist peinlich

Wenn die Testfragen zu einfach sind, können sowohl Spitzenschüler als auch schlechte Schüler 90 Punkte erreichen, und es wird keine Lücke geben...

Mit der Veröffentlichung stärkerer Modelle wie Claude 3, Llama 3 und noch später GPT- 5, die Industrie braucht dringend ein schwierigeres Modell, differenziertere Benchmark-Tests.

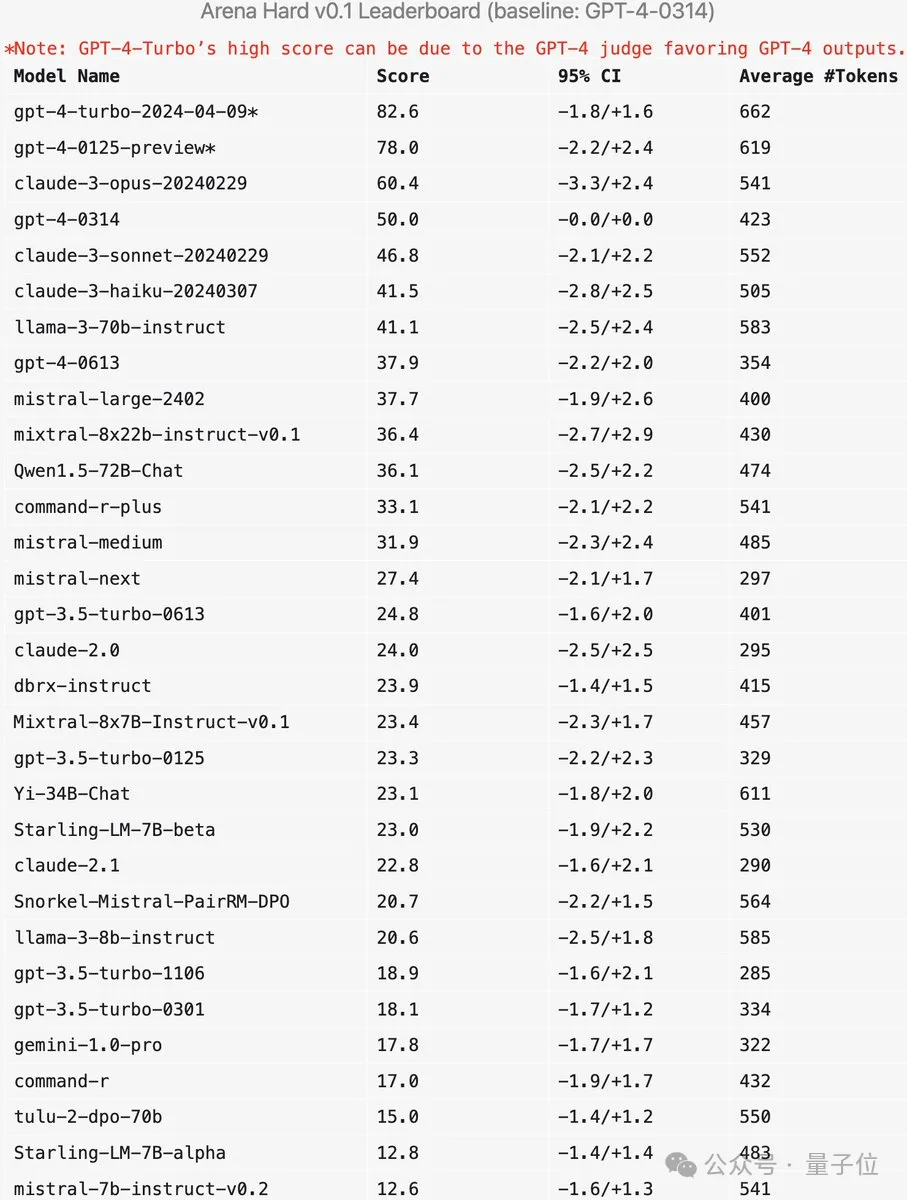

LMSYS, die Organisation hinter der großen Model-Arena, hat den Benchmark Arena-Hard der nächsten Generation auf den Markt gebracht, der große Aufmerksamkeit erregte.

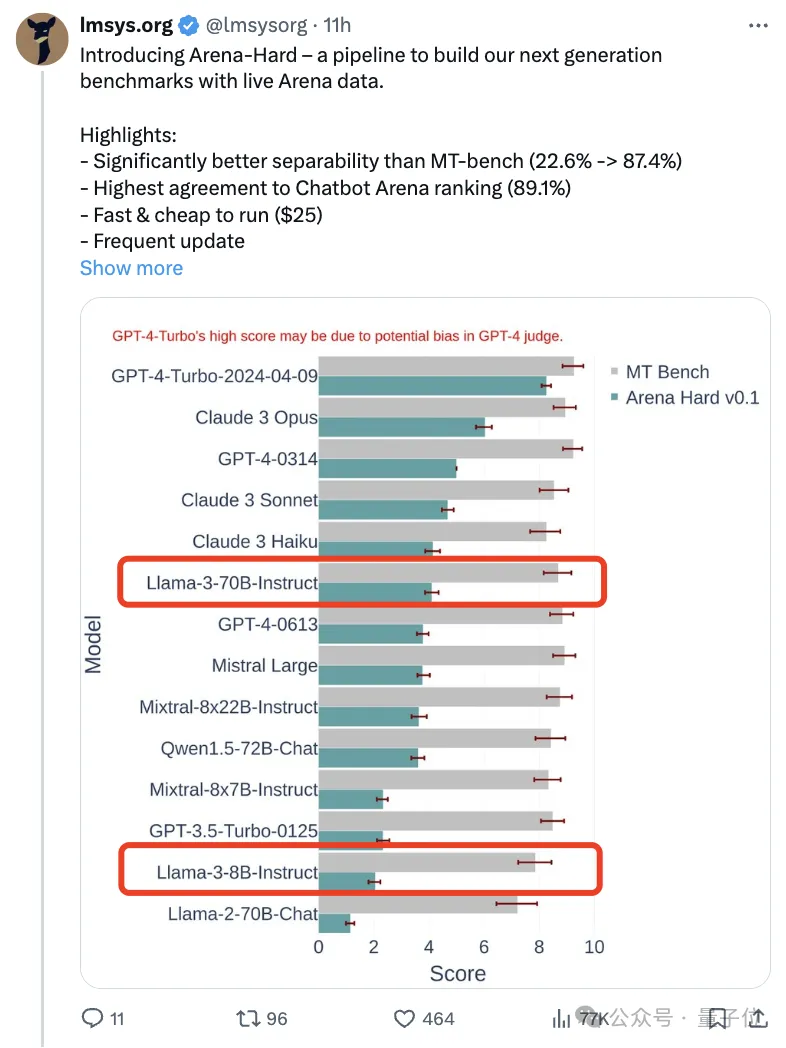

Die neueste Referenz ist auch für die Stärke der beiden in der Anleitung optimierten Versionen von Llama 3 verfügbar.

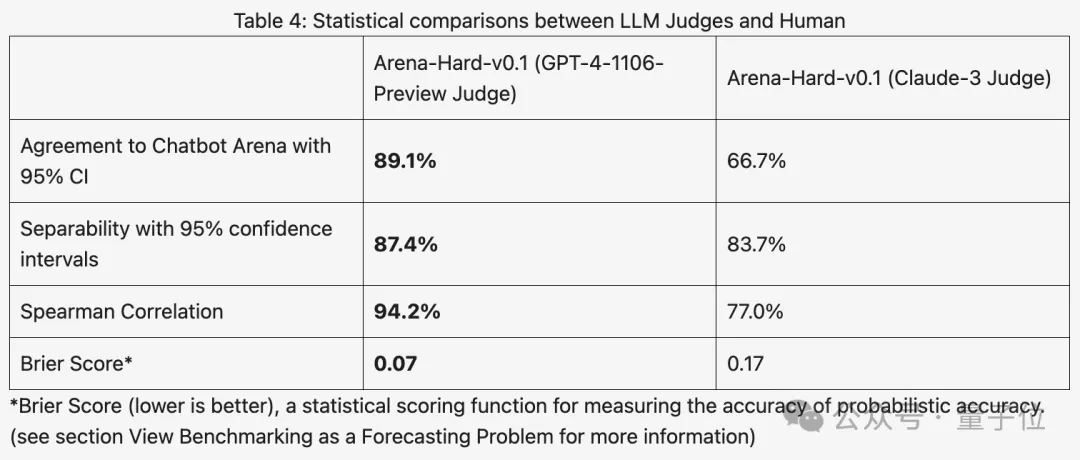

Verglichen mit der vorherigen MT-Bench, die ähnliche Ergebnisse erzielte, stieg die Arena-Hard-Diskriminierung von 22,6 % auf 87,4 %, was auf den ersten Blick klar ist.

Arena-Hard basiert auf menschlichen Echtzeitdaten aus der Arena und die Übereinstimmungsrate mit menschlichen Vorlieben liegt bei bis zu 89,1 %.

Zusätzlich zu den beiden oben genannten Indikatoren, die SOTA erreichen, gibt es einen zusätzlichen Vorteil:

Die in Echtzeit aktualisierten Testdaten enthalten Aufforderungswörter, die von Menschen neu erfunden und von der KI während der Trainingsphase noch nie gesehen wurden, wodurch potenzielle Daten nachgeben .

Nach der Veröffentlichung eines neuen Modells müssen Sie nicht mehr etwa eine Woche warten, bis menschliche Benutzer abstimmen. Geben Sie einfach 25 US-Dollar aus, um die Testpipeline schnell auszuführen und die Ergebnisse zu erhalten.

Einige Internetnutzer bemerkten, dass es wirklich wichtig sei, für Tests echte Benutzeraufforderungswörter anstelle von High-School-Prüfungen zu verwenden.

Wie funktioniert der neue Benchmark?

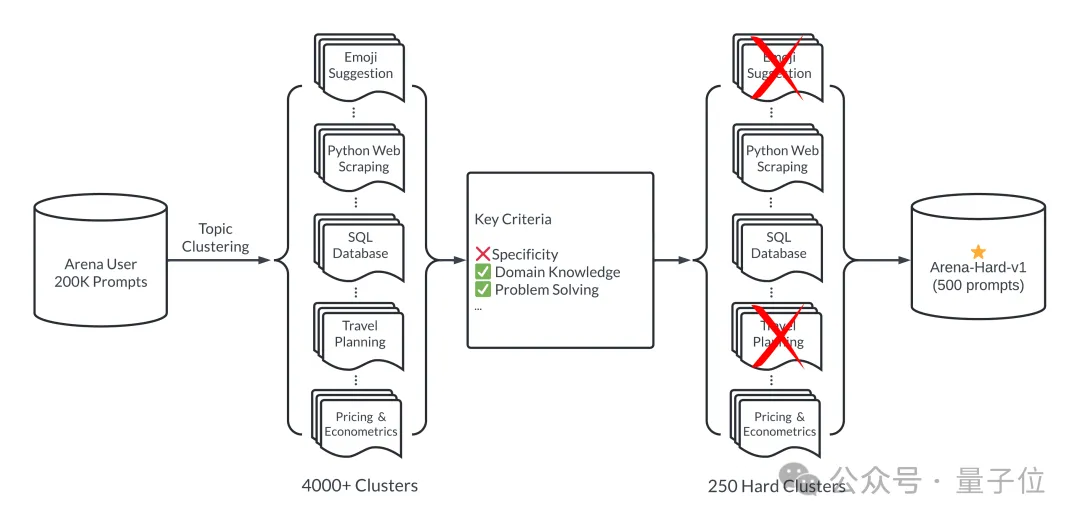

Vereinfacht ausgedrückt werden aus 200.000 Benutzeranfragen im großen Modellbereich 500 hochwertige Aufforderungswörter als Testsatz ausgewählt.

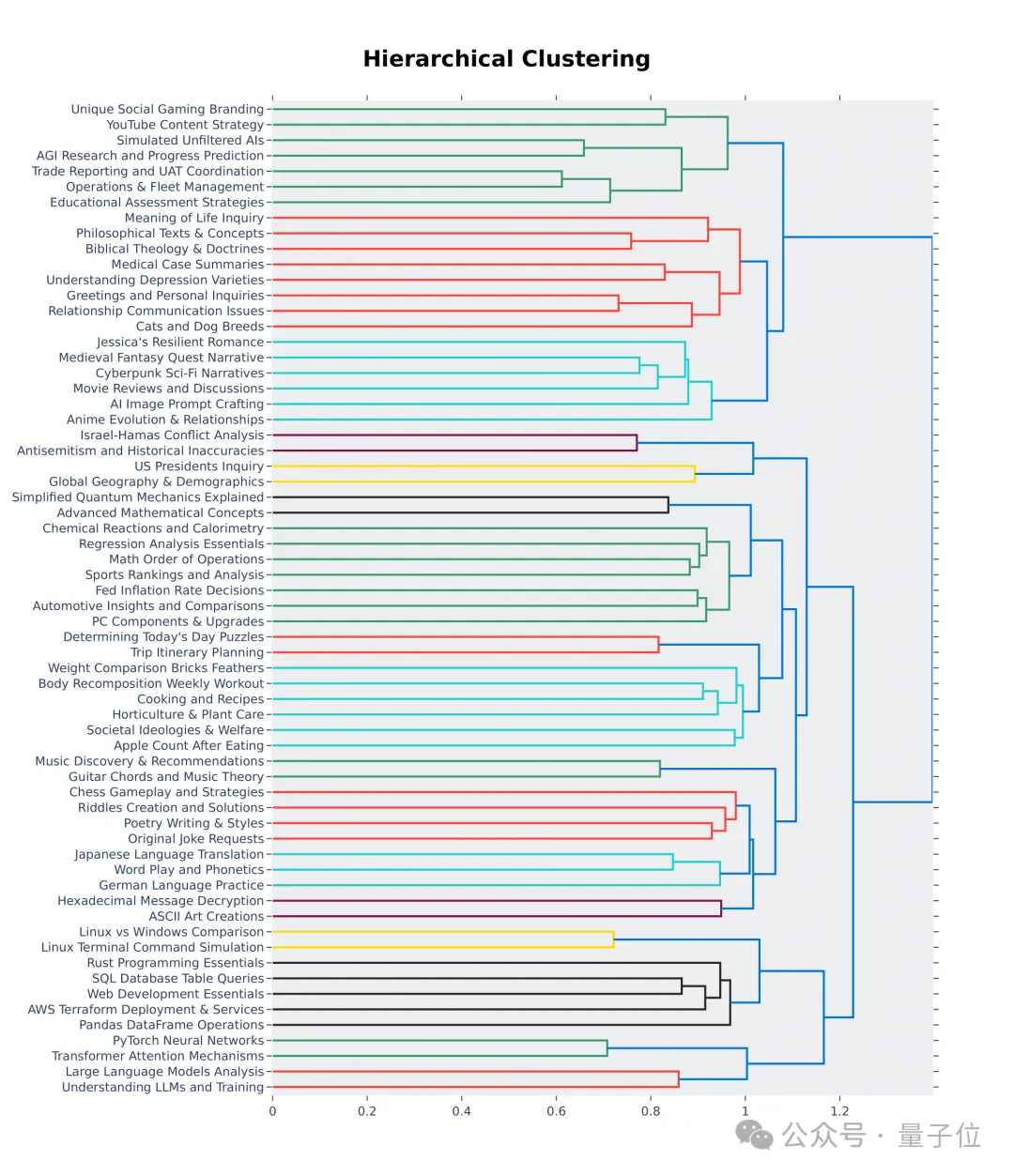

Stellen Sie zunächst sicher, dass der Auswahlprozess vielfältig ist, d. h. das Testset sollte ein breites Spektrum realer Themen abdecken.

Um dies sicherzustellen, übernimmt das Team die Themenmodellierungspipeline in BERTopic und konvertiert zunächst jeden Tipp mithilfe des Einbettungsmodells von OpenAI (text-embedding-3-small), reduziert die Dimensionalität mithilfe von UMAP und gruppiert mithilfe eines hierarchiebasierten Modellalgorithmus ( HDBSCAN), um Cluster zu identifizieren und schließlich GPT-4-turbo für die Aggregation zu verwenden.

Stellen Sie außerdem sicher, dass die ausgewählten Aufforderungswörter von hoher Qualität sind, was anhand von sieben Schlüsselindikatoren gemessen wird:

- Spezifität: Erfordert das Aufforderungswort eine bestimmte Ausgabe?

- Domänenwissen: Deckt das Eingabeaufforderungswort ein oder mehrere spezifische Felder ab?

- Komplexität: Verfügt das Aufforderungswort über mehrere Argumentationsebenen, Komponenten oder Variablen?

- Problemlösung: Ermöglicht das Aufforderungswort der KI direkt, ihre Fähigkeit zu demonstrieren, Probleme proaktiv zu lösen?

- Kreativität: Bringt das Aufforderungswort ein gewisses Maß an Kreativität bei der Problemlösung mit sich?

- Technische Genauigkeit: Erfordert das Aufforderungswort technische Genauigkeit der Antwort?

- Praktische Anwendung: Sind die Aufforderungswörter für praktische Anwendungen relevant?

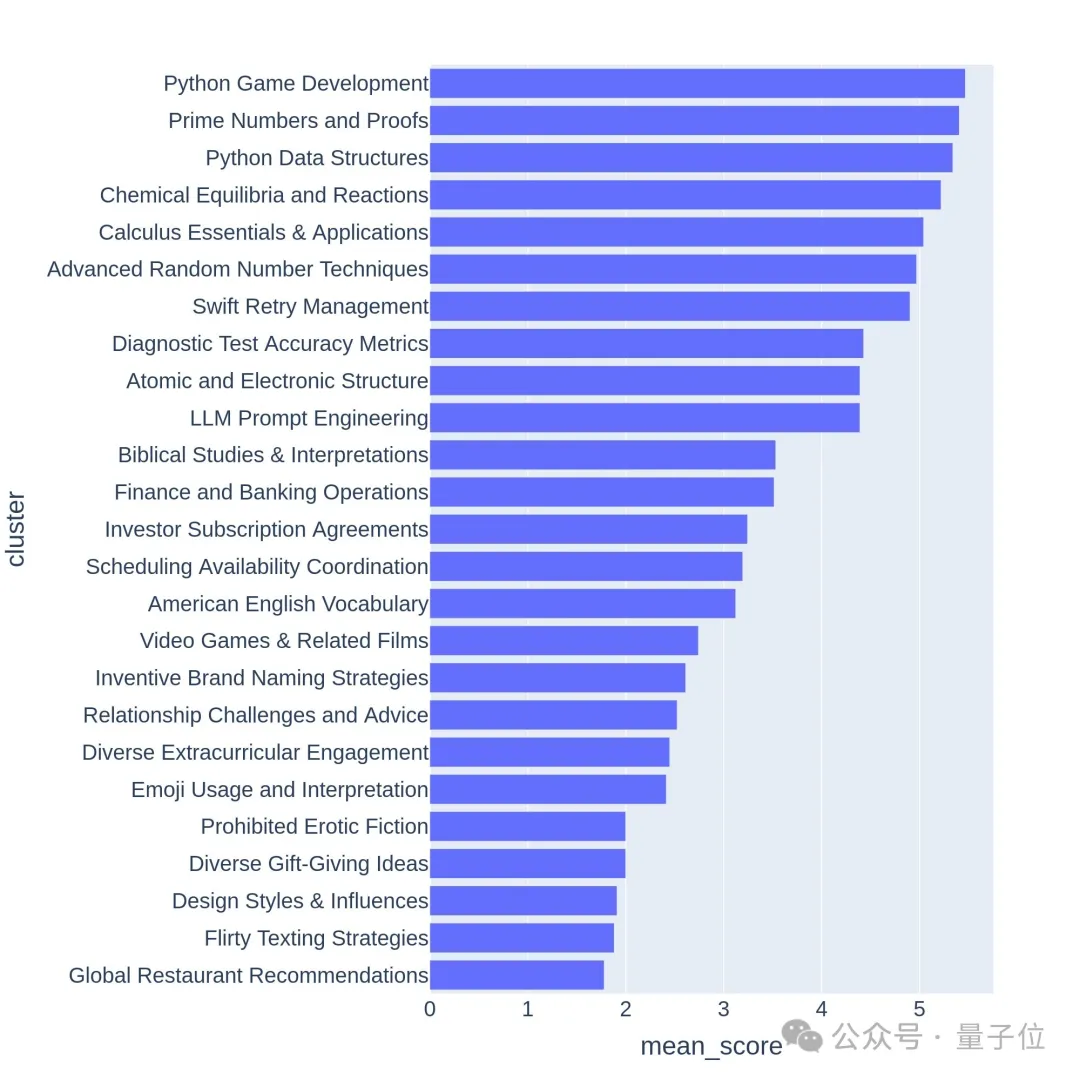

Verwenden Sie GPT-3.5-Turbo und GPT-4-Turbo, um jeden Tipp von 0 bis 7 zu kommentieren, um zu bestimmen, wie viele Bedingungen erfüllt sind. Jeder Cluster wird dann basierend auf der durchschnittlichen Punktzahl der Hinweise bewertet.

Hochwertige Fragen beziehen sich in der Regel auf herausfordernde Themen oder Aufgaben, wie z. B. Spieleentwicklung oder mathematische Beweise.

Ist der neue Benchmark genau?

Arena-Hard hat derzeit eine Schwäche: Die Verwendung von GPT-4 als Schiedsrichter bevorzugt die eigene Ausgabe. Beamte gaben auch entsprechende Hinweise.

Es ist ersichtlich, dass die Ergebnisse der letzten beiden Versionen von GPT-4 viel höher sind als die von Claude 3 Opus, aber der Unterschied bei den menschlichen Abstimmungsergebnissen ist nicht so offensichtlich.

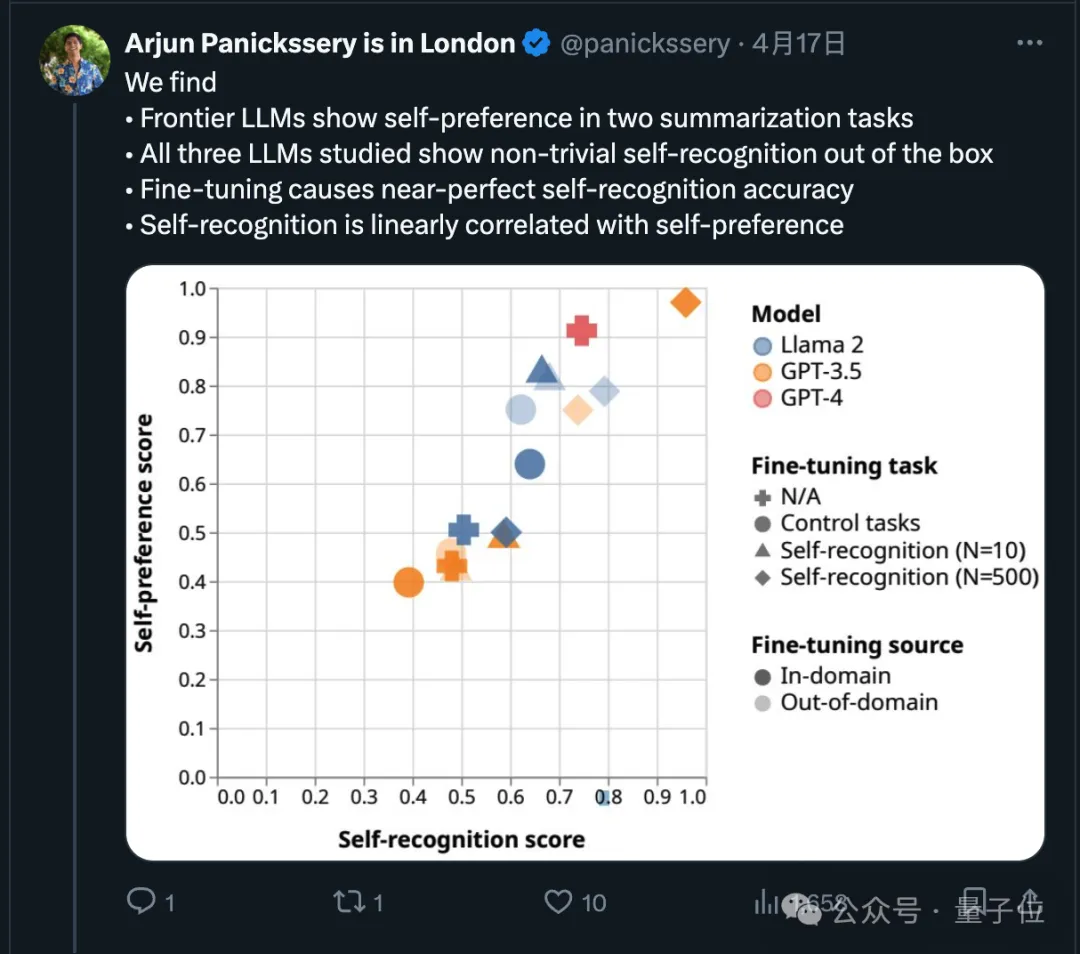

Tatsächlich haben aktuelle Untersuchungen in diesem Punkt gezeigt, dass Spitzenmodelle ihre eigene Ausgabe bevorzugen.

Das Forschungsteam fand außerdem heraus, dass KI von Natur aus feststellen kann, ob ein Text von selbst geschrieben wurde. Nach der Feinabstimmung kann die Selbsterkennungsfähigkeit verbessert werden, und die Selbsterkennungsfähigkeit hängt linear mit der Selbsterkennung zusammen. Präferenz.

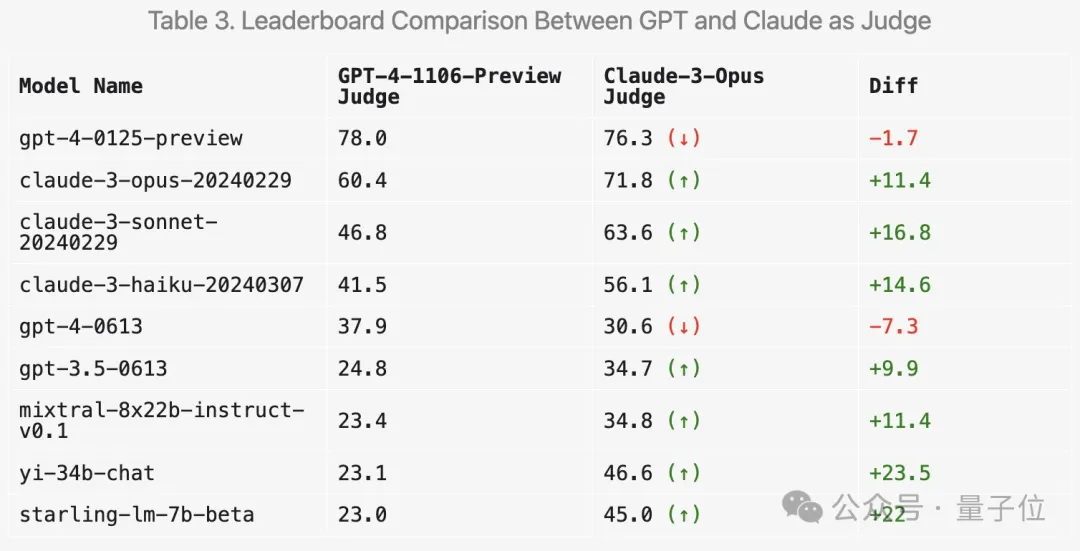

Wie wird sich die Verwendung von Claude 3 zur Wertung auf die Ergebnisse auswirken? LMSYS hat auch entsprechende Experimente durchgeführt.

Zuallererst werden die Punktzahlen der Claude-Reihe tatsächlich steigen.

Aber überraschenderweise bevorzugt es mehrere offene Modelle wie Mixtral und Zero One Thousand Yi und schneidet bei GPT-3.5 sogar deutlich besser ab.

Insgesamt sind die Unterscheidungsfähigkeit und die Konsistenz mit menschlichen Ergebnissen, die mit Claude 3 erzielt wurden, nicht so gut wie mit GPT-4.

So viele Internetnutzer schlugen vor, mehrere große Modelle für eine umfassende Bewertung zu verwenden.

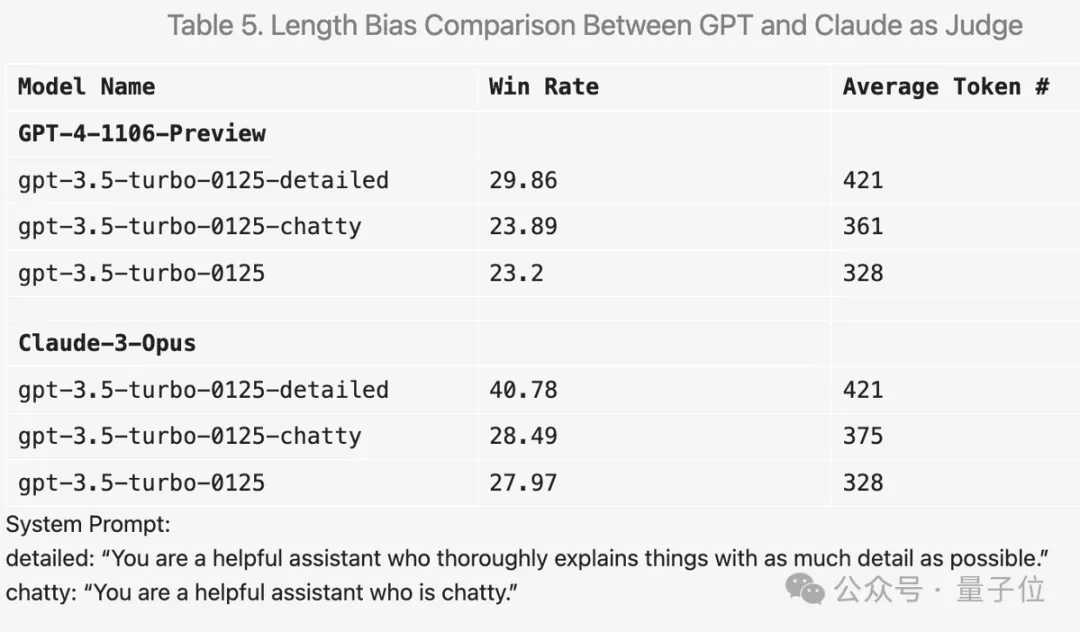

Darüber hinaus führte das Team weitere Ablationsexperimente durch, um die Wirksamkeit des neuen Benchmark-Tests zu überprüfen.

Wenn Sie beispielsweise „Machen Sie die Antwort so detailliert wie möglich“ zum Aufforderungswort hinzufügen, ist die durchschnittliche Ausgabelänge höher und die Punktzahl verbessert sich tatsächlich.

Durch die Änderung des Eingabeaufforderungsworts in „chattet gern“ erhöhte sich auch die durchschnittliche Ausgabelänge, die Verbesserung der Punktzahl war jedoch nicht offensichtlich.

Darüber hinaus gab es während des Experiments viele interessante Entdeckungen.

GPT-4 ist beispielsweise sehr streng bei der Bewertung, wenn die Antwort Fehler enthält, werden bei Claude 3 sogar kleine Fehler nachsichtig abgezogen.

Bei Code-Fragen tendiert Claude 3 dazu, Antworten mit einer einfachen Struktur bereitzustellen, verlässt sich nicht auf externe Code-Bibliotheken und kann Menschen beim Erlernen des Programmierens helfen, während GPT-4-Turbo die praktischsten Antworten unabhängig von ihrem pädagogischen Wert bevorzugt.

Außerdem kann GPT-4-Turbo, selbst wenn die Temperatur auf 0 eingestellt ist, zu leicht unterschiedlichen Beurteilungen führen.

Auch an den ersten 64 Clustern der Hierarchievisualisierung lässt sich erkennen, dass die Qualität und Vielfalt der von Nutzern der großen Modellarena gestellten Fragen tatsächlich hoch ist.

Vielleicht ist darin auch Ihr Beitrag enthalten.

Arena-Hard GitHub: https://github.com/lm-sys/arena-hard

Arena-Hard HuggingFace: https://huggingface.co/spaces/lmsys/arena-hard-browser

Große Modellarena: https://arena.lmsys.org

Referenzlink:

[1]https://x.com/lmsysorg/status/1782179997622649330

[2]https://lmsys.org/blog/2024-04 - 19-arena-schwer/

Das obige ist der detaillierte Inhalt vonNeuer Test-Benchmark veröffentlicht, der leistungsstärkste Open-Source-Llama 3 ist peinlich. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

So führen Sie das H5 -Projekt aus

Apr 06, 2025 pm 12:21 PM

So führen Sie das H5 -Projekt aus

Apr 06, 2025 pm 12:21 PM

Ausführen des H5 -Projekts erfordert die folgenden Schritte: Installation der erforderlichen Tools wie Webserver, Node.js, Entwicklungstools usw. Erstellen Sie eine Entwicklungsumgebung, erstellen Sie Projektordner, initialisieren Sie Projekte und schreiben Sie Code. Starten Sie den Entwicklungsserver und führen Sie den Befehl mit der Befehlszeile aus. Vorschau des Projekts in Ihrem Browser und geben Sie die Entwicklungsserver -URL ein. Veröffentlichen Sie Projekte, optimieren Sie Code, stellen Sie Projekte bereit und richten Sie die Webserverkonfiguration ein.

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Die H5 -Seite muss aufgrund von Faktoren wie Code -Schwachstellen, Browserkompatibilität, Leistungsoptimierung, Sicherheitsaktualisierungen und Verbesserungen der Benutzererfahrung kontinuierlich aufrechterhalten werden. Zu den effektiven Wartungsmethoden gehören das Erstellen eines vollständigen Testsystems, die Verwendung von Versionstools für Versionskontrolle, die regelmäßige Überwachung der Seitenleistung, das Sammeln von Benutzern und die Formulierung von Wartungsplänen.

Können Sie lernen, wie man H5 -Seiten selbst herstellt?

Apr 06, 2025 am 06:36 AM

Können Sie lernen, wie man H5 -Seiten selbst herstellt?

Apr 06, 2025 am 06:36 AM

Es ist machbar, die H5-Seitenproduktion selbst zu steuern, aber es ist kein schneller Erfolg. Es erfordert das Beherrschen von HTML, CSS und JavaScript, das Design, Front-End-Entwicklung und Back-End-Interaktionslogik umfasst. Praxis ist der Schlüssel und lernen Sie, indem Sie Tutorials abschließen, Materialien überprüfen und an Open -Source -Projekten teilnehmen. Die Leistungsoptimierung ist ebenfalls wichtig, die eine Optimierung von Bildern erfordern, HTTP -Anforderungen reduzieren und geeignete Frameworks verwenden. Der Weg zur Selbststudie ist lang und erfordert kontinuierliches Lernen und Kommunikation.

So sehen Sie die Ergebnisse nach dem Modifizieren des Bootstraps

Apr 07, 2025 am 10:03 AM

So sehen Sie die Ergebnisse nach dem Modifizieren des Bootstraps

Apr 07, 2025 am 10:03 AM

Schritte zur Anzeige der geänderten Bootstrap -Ergebnisse: Öffnen Sie die HTML -Datei direkt im Browser, um sicherzustellen, dass die Bootstrap -Datei korrekt verwiesen wird. Löschen Sie den Browser -Cache (Strg Shift R). Wenn Sie CDN verwenden, können Sie CSS im Entwickler -Tool direkt ändern, um die Effekte in Echtzeit anzuzeigen. Wenn Sie den Bootstrap -Quellcode ändern, laden Sie die lokale Datei herunter und ersetzen Sie den Befehl "Build mithilfe eines Build -Tools wie WebPack.

Wie man Vue Pagination verwendet

Apr 08, 2025 am 06:45 AM

Wie man Vue Pagination verwendet

Apr 08, 2025 am 06:45 AM

Pagination ist eine Technologie, die große Datensätze in kleine Seiten aufteilt, um die Leistung und die Benutzererfahrung zu verbessern. In VUE können Sie die folgende integrierte Methode zum Paging verwenden: Berechnen Sie die Gesamtzahl der Seiten: TotalPages () TRAVERSAL-Seitennummer: V-für Anweisung, um die aktuelle Seite festzulegen: aktuelle Seite

Hadidb: Eine leichte, horizontal skalierbare Datenbank in Python

Apr 08, 2025 pm 06:12 PM

Hadidb: Eine leichte, horizontal skalierbare Datenbank in Python

Apr 08, 2025 pm 06:12 PM

Hadidb: Eine leichte, hochrangige skalierbare Python-Datenbank Hadidb (HadIDB) ist eine leichte Datenbank in Python mit einem hohen Maß an Skalierbarkeit. Installieren Sie HadIDB mithilfe der PIP -Installation: PipinstallHadIDB -Benutzerverwaltung erstellen Benutzer: createUser (), um einen neuen Benutzer zu erstellen. Die Authentication () -Methode authentifiziert die Identität des Benutzers. fromHadidb.operationImportUseruser_obj = user ("admin", "admin") user_obj.

Überwachen Sie MySQL und Mariadb -Tröpfchen mit Prometheus Mysql Exporteur

Apr 08, 2025 pm 02:42 PM

Überwachen Sie MySQL und Mariadb -Tröpfchen mit Prometheus Mysql Exporteur

Apr 08, 2025 pm 02:42 PM

Eine effektive Überwachung von MySQL- und MariADB -Datenbanken ist entscheidend für die Aufrechterhaltung einer optimalen Leistung, die Identifizierung potenzieller Engpässe und die Gewährleistung der Zuverlässigkeit des Gesamtsystems. Prometheus MySQL Exporteur ist ein leistungsstarkes Tool, das detaillierte Einblicke in Datenbankmetriken bietet, die für die proaktive Verwaltung und Fehlerbehebung von entscheidender Bedeutung sind.

So sehen Sie das JavaScript -Verhalten von Bootstrap

Apr 07, 2025 am 10:33 AM

So sehen Sie das JavaScript -Verhalten von Bootstrap

Apr 07, 2025 am 10:33 AM

Der JavaScript -Abschnitt von Bootstrap bietet interaktive Komponenten, die statische Seiten Vitalität ergeben. Wenn Sie sich den Open -Source -Code ansehen, können Sie verstehen, wie er funktioniert: Ereignisbindung löst Dom -Operationen und Stiländerungen aus. Die grundlegende Nutzung umfasst die Einführung von JavaScript -Dateien und die Verwendung von APIs, und die erweiterte Verwendung umfasst benutzerdefinierte Ereignisse und Erweiterungsfunktionen. Zu den häufig gestellten Fragen gehören Versionskonflikte und CSS-Stilkonflikte, die durch Doppelüberprüfung des Codes gelöst werden können. Die Tipps zur Leistungsoptimierung umfassen On-Demand-Laden- und Codekomprimierung. Der Schlüssel zum Beherrschen von Bootstrap JavaScript ist das Verständnis der Designkonzepte, zum Kombinieren praktischer Anwendungen und zum Debuggen und Erforschen von Entwickler -Tools.