Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Unter der Leitung von Yan Shuicheng veröffentlichte das Kunlun Wanwei 2050 Global Research Institute gemeinsam mit NUS und NTU Vitron und etablierte damit die ultimative Form allgemeiner visueller multimodaler Großmodelle.

Unter der Leitung von Yan Shuicheng veröffentlichte das Kunlun Wanwei 2050 Global Research Institute gemeinsam mit NUS und NTU Vitron und etablierte damit die ultimative Form allgemeiner visueller multimodaler Großmodelle.

Unter der Leitung von Yan Shuicheng veröffentlichte das Kunlun Wanwei 2050 Global Research Institute gemeinsam mit NUS und NTU Vitron und etablierte damit die ultimative Form allgemeiner visueller multimodaler Großmodelle.

Kürzlich haben das Kunlun Technology 2050 Global Research Institute, die National University of Singapore und das Team der Nanyang Technological University of Singapore unter der Leitung von Professor Yan Shuicheng gemeinsam und Open Source das universelle Visual auf Pixelebene Vitron veröffentlicht multimodales großes Sprachmodell .

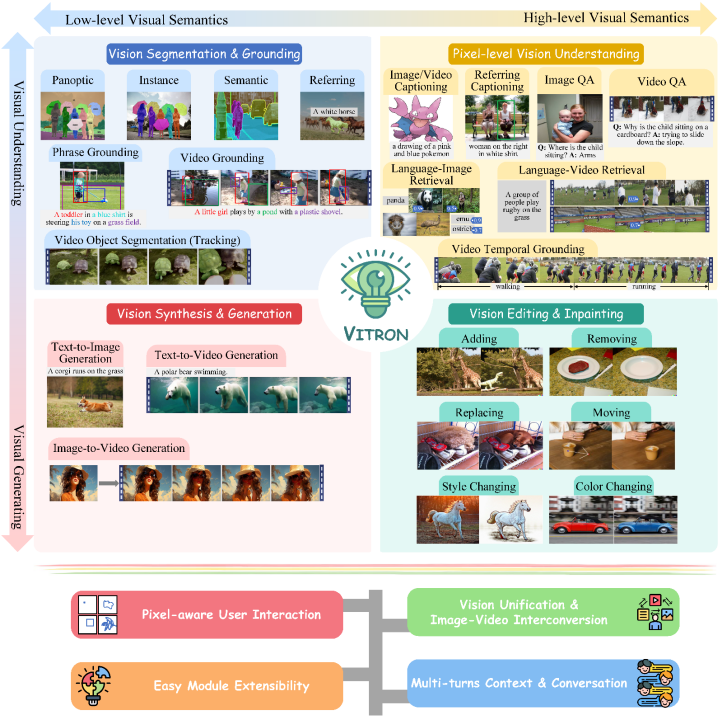

Dies ist ein hochbelastbares, universell einsetzbares, visuelles, multimodales Großmodell, das eine Reihe visueller Aufgaben vom visuellen Verständnis bis zur visuellen Generierung, von niedriger bis hoher Ebene, unterstützt und das Bildproblem löst, das das Große geplagt hat /Das Problem der Videomodellaufteilung bietet ein allgemeines visuelles multimodales Großmodell auf Pixelebene, das das Verständnis, die Generierung, Segmentierung, Bearbeitung und andere Aufgaben von statischen Bildern und dynamischen Videos umfassend vereint Inhalt, der den Grundstein für die nächste Generation allgemeiner visueller Großmodelle legt. Die ultimative Form legt den Grundstein und markiert einen weiteren großen Schritt in Richtung allgemeiner „künstlicher Intelligenz“ (AGI) für große Modelle. Vitron erreicht als einheitliches visuelles multimodales großes Sprachmodell auf Pixelebene umfassende Unterstützung für visuelle Aufgaben von niedrigem bis hohem Niveau

,ist in der Lage, komplexe visuelle Aufgaben zu bewältigen, und Verstehen und generieren Sie Bild- und Videoinhalte und bieten Sie so ein leistungsstarkes visuelles Verständnis und Funktionen zur Aufgabenausführung. Gleichzeitig unterstützt Vitron den kontinuierlichen Betrieb mit Benutzern, ermöglicht eine flexible Mensch-Computer-Interaktion und demonstriert das große Potenzial für ein einheitlicheres visuelles multimodales Universalmodell. Vitron-bezogene Papiere, Codes und Demos

wurden alle veröffentlichtSeine einzigartigen Vorteile und sein Potenzial in Bezug auf Vollständigkeit, technologische Innovation, Mensch-Computer-Interaktion und Anwendungspotenzial fördern nicht nur Es fördert nicht nur die Entwicklung multimodaler Großmodelle, sondern bietet auch eine neue Richtung für die zukünftige visuelle Großmodellforschung. Kunlun Wanwei

2050global Research Institute hat sich dem Aufbau von Outstanding Scientific Research Institution für die zukünftige Welt verpflichtet und mit der wissenschaftlichen Gemeinschaft zusammenarbeitet “, die unbekannte Welt erkunden, eine bessere Zukunft schaffen. Zuvor hat Kunlun Wanwei 2050Global Research Institute das Forschungs- und Entwicklungs-Toolkit für digitale AgentenAgentStudio veröffentlicht und als Open-Source-Lösung bereitgestellt. Das Forschungsinstitut wird auch in Zukunft die technische Intelligenz fördern Durchbrüche, die zum „ökologischen Bauwesen mit künstlicher Intelligenz“ in China beitragen. Die aktuelle Entwicklung visueller großer Sprachmodelle (LLMs) hat erfreuliche Fortschritte gemacht. Die Community glaubt zunehmend, dass der Aufbau allgemeinerer und leistungsfähigerer multimodaler Großmodelle (MLLMs) der einzige Weg zur Erreichung allgemeiner künstlicher Intelligenz (AGI) sein wird. Allerdings gibt es bei der Umstellung auf ein multimodales allgemeines Modell (Generalist) noch einige zentrale Herausforderungen. Beispielsweise erreicht ein großer Teil der Arbeit kein feinkörniges visuelles Verständnis auf Pixelebene oder es fehlt eine einheitliche Unterstützung für Bilder und Videos. Oder die Unterstützung verschiedener Sehaufgaben reicht nicht aus und es handelt sich bei weitem nicht um ein universelles Großmodell. Um diese Lücke zu schließen, haben das Kunlun Worldwide 2050 Global Research Institute, die National University of Singapore und das Team der Nanyang Technological University of Singapore kürzlich gemeinsam das Open-Source-Vitron-Universal-Vitron-Vitron-Visual-Multimodal-Großsprachenmodell auf Pixelebene veröffentlicht . Vitron unterstützt eine Reihe visueller Aufgaben vom visuellen Verständnis bis zur visuellen Generierung, von niedriger bis hoher Ebene, einschließlich umfassendem Verständnis, Generierung, Segmentierung und Bearbeitung statischer Bilder und dynamischer Videoinhalte. Vitron hat die funktionelle Unterstützung für vier wichtige Sehaufgaben umfassend beschrieben. und seine wichtigsten Vorteile. Vitron unterstützt außerdem den kontinuierlichen Betrieb mit Benutzern, um eine flexible Mensch-Computer-Interaktion zu erreichen. Dieses Projekt demonstriert das große Potenzial eines einheitlicheren multimodalen allgemeinen Vision-Modells und legt den Grundstein für die ultimative Form der nächsten Generation großer allgemeiner Vision-Modelle. Vitron-bezogene Dokumente, Codes und Demos sind jetzt alle öffentlich. Titel des Papiers: Vitron: A Unified Pixel-level Vision LLM for Understanding, Generating, Segmenting, EditingProjekthomepage und Demo: https://vitron-llm.github.io/Link zum Papier: https:/ /is.gd/aGu0VVOffener Quellcode: https://github.com/SkyworkAI/Vitron

01 Das ultimative einheitliche multimodale große Sprachmodell

Das ultimative einheitliche multimodale große Sprachmodell

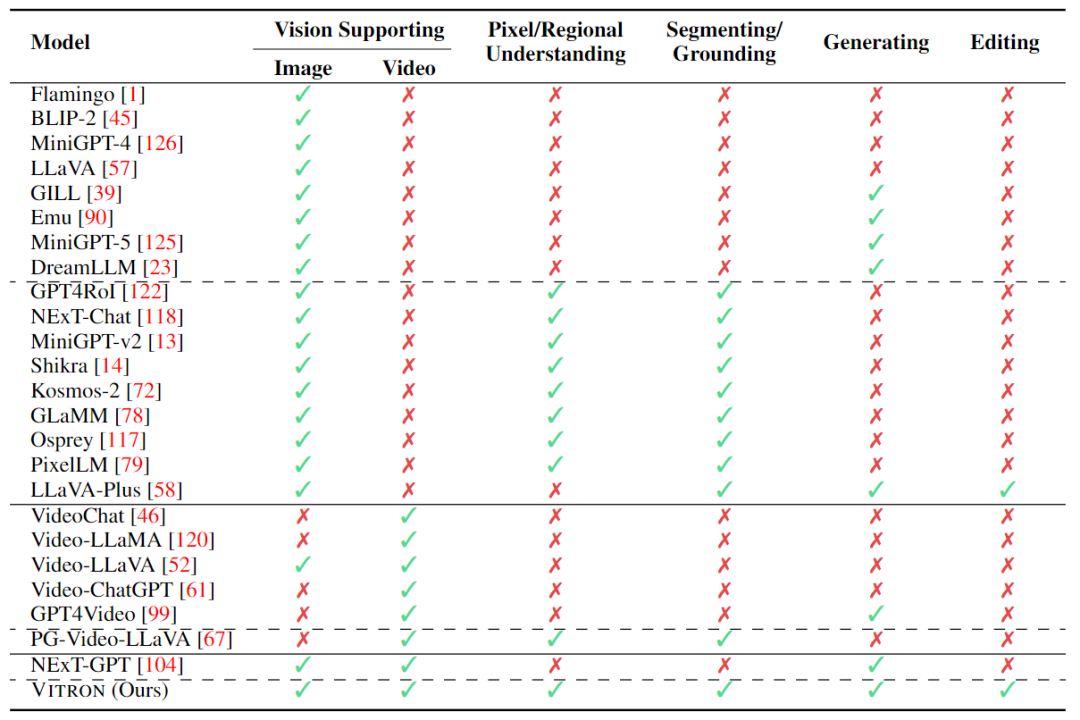

In den letzten Jahren haben große Sprachmodelle (LLMs) eine beispiellose Leistungsfähigkeit bewiesen und sich nach und nach als der technische Weg zur AGI erwiesen. Multimodale große Sprachmodelle (MLLMs) entwickeln sich in vielen Communities schnell und werden durch die Einführung von Modulen, die eine visuelle Wahrnehmung ermöglichen, zu MLLMs erweitert, die leistungsstark und hervorragend im Bildverständnis sind . , wie BLIP-2, LLaVA, MiniGPT-4 usw. Gleichzeitig wurden auch MLLMs mit Schwerpunkt auf Videoverständnis eingeführt, wie z. B. VideoChat, Video-LLaMA, Video-LLaVA usw.

Anschließend versuchten Forscher hauptsächlich, die Fähigkeiten von MLLMs aus zwei Dimensionen weiter auszubauen. Einerseits versuchen Forscher, das Verständnis von MLLMs für das Sehen zu vertiefen, indem sie vom groben Verständnis auf Instanzebene zum feinkörnigen Verständnis von Bildern auf Pixelebene übergehen und so Funktionen zur visuellen Regionspositionierung (Regional Grounding) wie GLaMM und PixelLM erreichen , NExT-Chat und MiniGPT-v2 usw. Andererseits versuchen Forscher, die visuellen Funktionen zu erweitern, die MLLMs unterstützen können. Einige Forschungsarbeiten haben damit begonnen, zu untersuchen, wie MLLMs nicht nur visuelle Eingabesignale verstehen, sondern auch die Generierung visueller Ausgabeinhalte unterstützen. Beispielsweise können MLLMs wie GILL und Emu flexibel Bildinhalte generieren, und GPT4Video und NExT-GPT realisieren die Videogenerierung.

Gegenwärtig ist sich die Community der künstlichen Intelligenz allmählich einig, dass sich der zukünftige Trend visueller MLLMs unweigerlich in Richtung hochgradig einheitlicher und stärkerer Fähigkeiten entwickeln wird. Trotz der zahlreichen von der Community entwickelten MLLMs besteht jedoch immer noch eine deutliche Lücke.

- Zuallererst: Fast alle vorhandenen visuellen LLMs behandeln Bilder und Videos als unterschiedliche Einheiten und unterstützen entweder nur Bilder oder nur Videos. Die Forscher argumentieren, dass das Sehen sowohl statische Bilder als auch dynamische Videos umfassen sollte – beides Kernbestandteile der visuellen Welt und in den meisten Szenarien sogar austauschbar. Daher ist es notwendig, ein einheitliches MLLM-Framework aufzubauen, das sowohl Bild- als auch Videomodalitäten unterstützen kann.

- Zweitens: Die Unterstützung visueller Funktionen durch MLLMs ist derzeit noch unzureichend. Die meisten Modelle sind nur in der Lage, Bilder oder Videos zu verstehen oder allenfalls zu erzeugen. Forscher glauben, dass zukünftige MLLMs ein allgemeines großes Sprachmodell sein sollten, das ein breiteres Spektrum visueller Aufgaben und Operationen abdecken, eine einheitliche Unterstützung für alle visuellen Aufgaben erreichen und „eines für alle“-Fähigkeiten erreichen sollte. Dies ist für praktische Anwendungen von entscheidender Bedeutung, insbesondere bei der visuellen Erstellung, die häufig eine Reihe iterativer und interaktiver Vorgänge umfasst. Beispielsweise beginnen Benutzer normalerweise mit Text und wandeln eine Idee mithilfe von Vincent-Diagrammen in visuelle Inhalte um. Anschließend verfeinern sie die ursprüngliche Idee und fügen weitere Details durch weitere feinkörnige Bildbearbeitung hinzu. Anschließend erstellen sie mehrere Videos Runden iterativer Interaktionen, wie z. B. Videobearbeitung, um die Kreation zu perfektionieren.

Die obige Tabelle fasst lediglich die Fähigkeiten des vorhandenen visuellen MLLM zusammen (nur einige Modelle sind repräsentativ enthalten und die Abdeckung ist unvollständig). Um diese Lücken zu schließen, schlägt das Team Vitron vor, ein allgemeines visuelles MLLM auf Pixelebene.

02. Vitron-Systemarchitektur : drei Schlüsselmodule

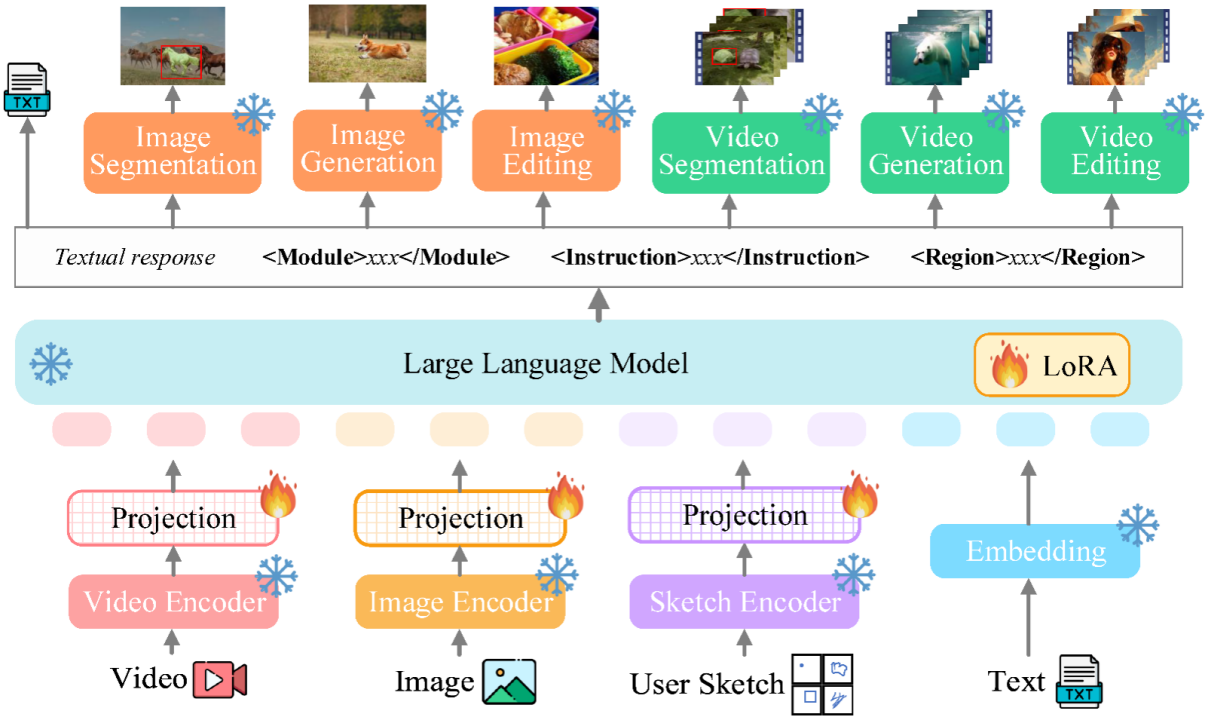

Das Gesamtgerüst von Vitron ist in der folgenden Abbildung dargestellt. Vitron übernimmt eine ähnliche Architektur wie bestehende verwandte MLLMs, einschließlich dreier Schlüsselteile: 1) Front-End-Modul für visuelle und Sprachkodierung, 2) zentrales LLM-Verständnis- und Textgenerierungsmodul und 3) Back-End-Benutzerantwort und Modulaufrufe für die visuelle Steuerung Modul.

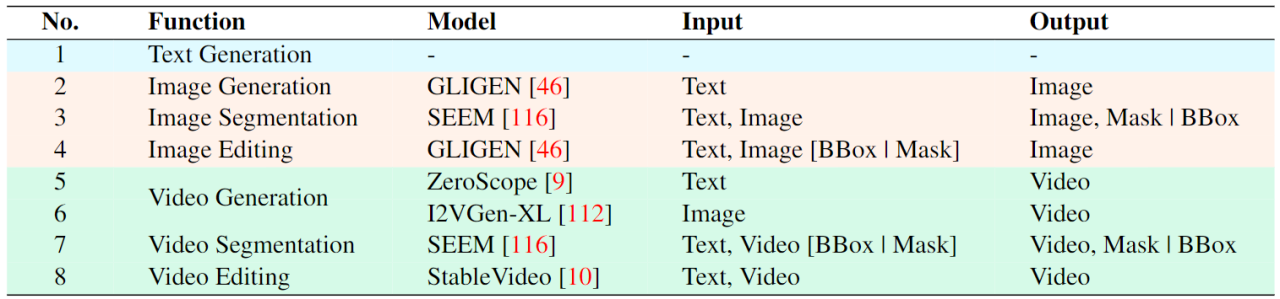

- Frontend-Modul: Visuell-linguistische Codierung. Um modale Bild- und Videosignale wahrzunehmen und feinkörnige visuelle Benutzereingaben zu unterstützen, integriert Vitron Bild-Encoder, Video-Encoder und Region-Box-/Skizzen-Encoder.

- Zentrales Modul: Core LLM. Vitron nutzt Vicuna (7B, 1.5) für das Verständnis, die Argumentation, die Entscheidungsfindung und mehrere Runden der Benutzerinteraktion.

- Backend-Modul: Benutzerantwort und Modulaufruf. Vitron verfolgt eine textzentrierte Anrufstrategie und integriert mehrere handelsübliche leistungsstarke und fortschrittliche (SoTA) Bild- und Videoverarbeitungsmodule zum Dekodieren und Ausführen einer Reihe visueller Terminalaufgaben von Low-Level bis High-Level. Durch die Einführung einer textzentrierten Modulintegrationsaufrufmethode erreicht Vitron nicht nur eine Systemvereinheitlichung, sondern gewährleistet auch Ausrichtungseffizienz und Systemskalierbarkeit.

0... Das Modelltraining umfasst hauptsächlich drei verschiedene Phasen.

- Schritt 1: Lernen der allgemeinen Ausrichtung der visuellen Sprache. Die eingegebenen visuellen Sprachmerkmale werden in einem einheitlichen Merkmalsraum abgebildet, wodurch die eingegebenen multimodalen Signale effektiv verstanden werden können. Hierbei handelt es sich um ein grobkörniges visuell-linguistisches Ausrichtungslernen, das es dem System ermöglicht, eingehende visuelle Signale als Ganzes effektiv zu verarbeiten. Die Forscher nutzten für das Training vorhandene Bild-Untertitel-Paare (CC3M), Video-Untertitel-Paare (Webvid) und Region-Untertitel-Paare (RefCOCO).

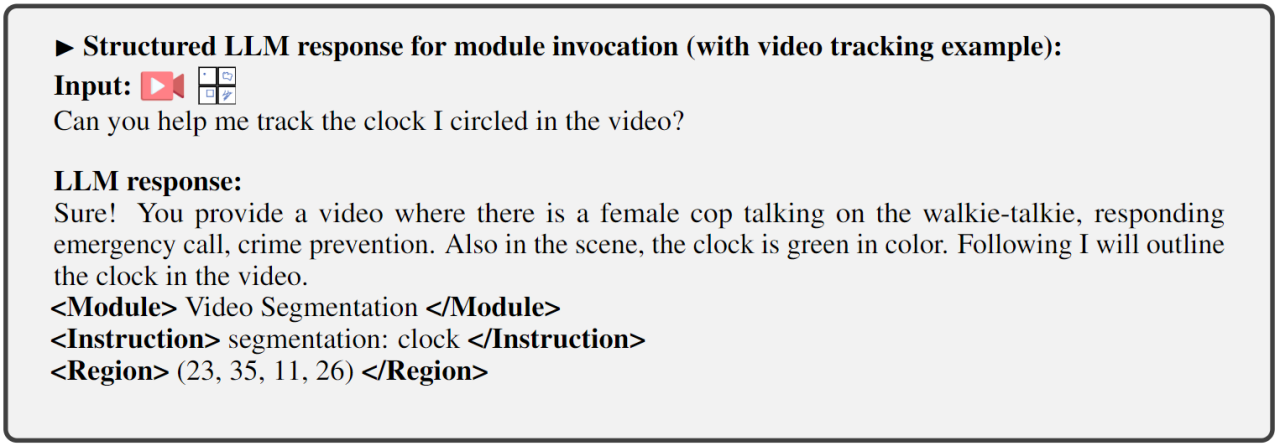

- Schritt 2: Feinkörnige Feinabstimmung der räumlich-zeitlichen visuellen Positionierungsanweisungen. Das System verwendet externe Module, um verschiedene visuelle Aufgaben auf Pixelebene auszuführen. LLM selbst wurde jedoch keinem feinkörnigen visuellen Training unterzogen, was das System daran hindern würde, ein echtes visuelles Verständnis auf Pixelebene zu erreichen. Zu diesem Zweck schlugen die Forscher ein Feinabstimmungstraining für räumlich-zeitliche visuelle Positionierungsanweisungen vor. Die Kernidee besteht darin, LLM in die Lage zu versetzen, die feinkörnige Räumlichkeit des Bildes und die spezifischen zeitlichen Eigenschaften des Videos zu lokalisieren. Schritt 3: Das Ausgabeende wird für den Befehlsaufruf feinabgestimmt. Die oben beschriebene zweite Trainingsstufe verleiht dem LLM und dem Front-End-Encoder die Fähigkeit, das Sehen auf Pixelebene zu verstehen. Dieser letzte Schritt, die Feinabstimmung der Anweisungen für den Befehlsaufruf, zielt darauf ab, das System mit der Fähigkeit auszustatten, Befehle genau auszuführen, sodass LLM geeigneten und korrekten Aufruftext generieren kann. Da unterschiedliche Terminal-Vision-Aufgaben möglicherweise unterschiedliche Aufrufbefehle erfordern, schlugen die Forscher zur Vereinheitlichung vor, die Antwortausgabe von LLM in ein strukturiertes Textformat zu standardisieren, das Folgendes umfasst:

1) Benutzerantwortausgabe, die direkt auf die des Benutzers antwortet Eingabe.

2) Modulname, der die auszuführende Funktion oder Aufgabe angibt.

3) Rufen Sie den Befehl auf, um die Metaanweisung des Aufgabenmoduls auszulösen.

4) Region (optionale Ausgabe), die feinkörnige visuelle Funktionen angibt, die für bestimmte Aufgaben erforderlich sind, beispielsweise bei der Videoverfolgung oder visuellen Bearbeitung, wo Backend-Module diese Informationen benötigen. Für Regionen werden basierend auf dem Verständnis auf Pixelebene von LLM durch Koordinaten beschriebene Begrenzungsrahmen ausgegeben.

04 Auswertungsexperimente

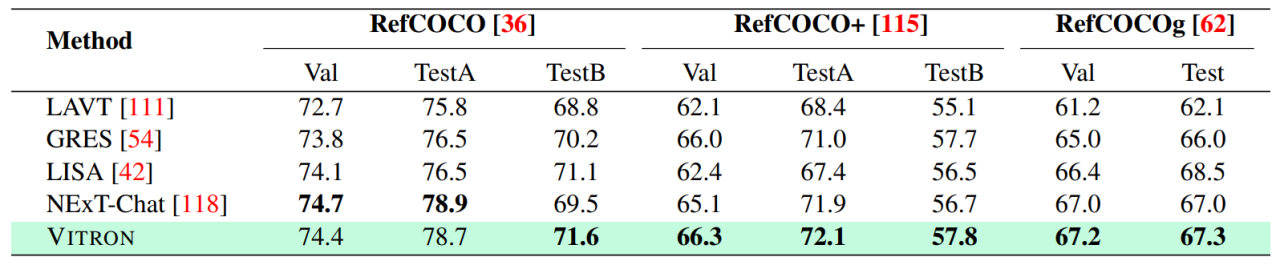

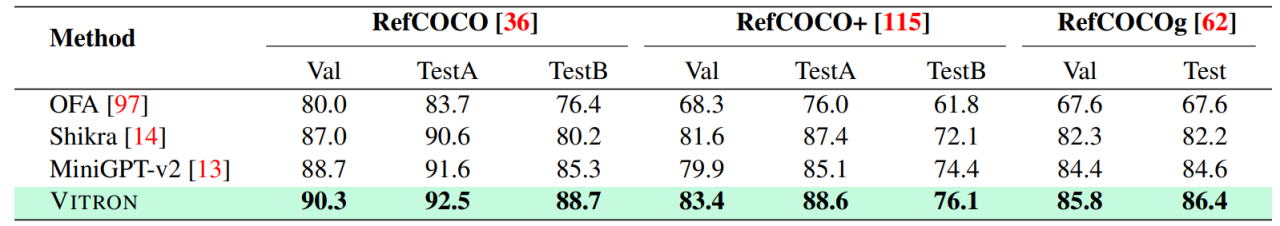

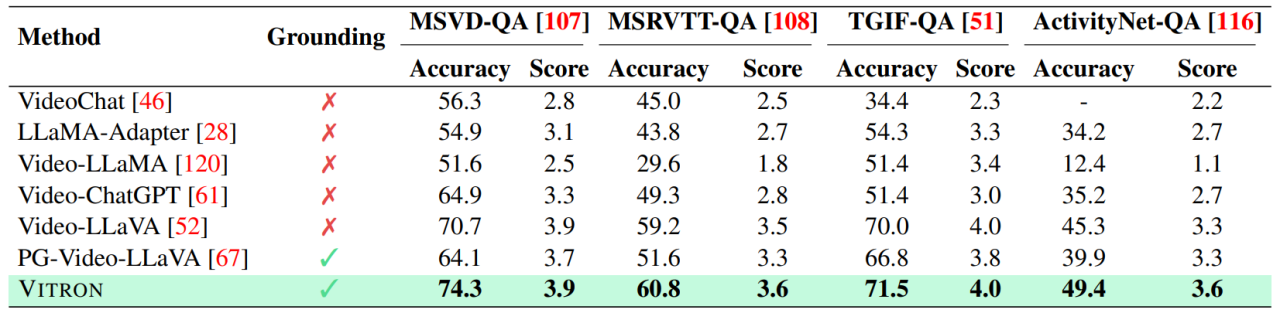

Die Forscher führten umfangreiche experimentelle Auswertungen an 22 gängigen Benchmark-Datensätzen und 12 Bild-/Video-Vision-Aufgaben auf Basis von Vitron durch. Vitron zeigt starke Fähigkeiten in vier großen visuellen Aufgabengruppen (Segmentierung, Verstehen, Generierung und Bearbeitung von Inhalten) und verfügt gleichzeitig über flexible Fähigkeiten zur Mensch-Computer-Interaktion. Das Folgende zeigt repräsentativ einige qualitative Vergleichsergebnisse:

- Vision Segmentation

Ergebnisse der bildbezogenen Bildsegmentierung

- Fine-grained Vision Understanding

Ergebnisse des bildbezogenen Ausdrucksverständnisses .

Ergebnisse zur Video-QA-Bearbeitung

- Detailliertere experimentelle Inhalte und Details Bitte wechseln Sie zum Papier.

- 0

- Future Direction Outlook

- Insgesamt zeigt diese Arbeit das große Potenzial der Entwicklung eines einheitlichen visuellen multimodalen allgemeinen Großmodells und legt den Grundstein für die nächste Generation der visuellen Großmodellforschung . Es nahm eine neue Form an und machte den ersten Schritt in diese Richtung. Obwohl das vom Team vorgeschlagene Vitron-System starke allgemeine Fähigkeiten aufweist, weist es dennoch seine eigenen Einschränkungen auf. Die folgenden Forscher listen einige Richtungen auf, die in Zukunft weiter erforscht werden könnten.

- Systemarchitektur

- Benutzerinteraktivität

Das Vitron-System verwendet immer noch einen halbgelenkten, halbagenten Ansatz, um externe Tools aufzurufen. Obwohl diese aufrufbasierte Methode die Erweiterung und den Austausch potenzieller Module erleichtert, bedeutet dies auch, dass die Back-End-Module dieser Pipeline-Struktur nicht am gemeinsamen Lernen der Front-End- und LLM-Kernmodule teilnehmen. Diese Einschränkung ist nicht förderlich für das Gesamtlernen des Systems, was bedeutet, dass die Leistungsobergrenze verschiedener Sehaufgaben durch die Back-End-Module begrenzt wird. Zukünftige Arbeiten sollten verschiedene Vision-Aufgabenmodule in eine einheitliche Einheit integrieren. Es bleibt eine Herausforderung, ein einheitliches Verständnis und eine einheitliche Ausgabe von Bildern und Videos zu erreichen und gleichzeitig Generierungs- und Bearbeitungsfunktionen durch ein einziges generatives Paradigma zu unterstützen. Derzeit besteht ein vielversprechender Ansatz darin, modularitätsbeständige Tokenisierung zu kombinieren, um die Vereinheitlichung des Systems für verschiedene Ein- und Ausgänge und verschiedene Aufgaben zu verbessern.

Im Gegensatz zu früheren Modellen, die sich auf eine einzelne Sehaufgabe konzentrierten (z. B. Stable Diffusion und SEEM), zielt Vitron darauf ab, eine tiefe Interaktion zwischen LLM und Benutzern zu ermöglichen, ähnlich wie OpenAI in der DALL-E-Industrieserie , Midjourney usw. Das Erreichen einer optimalen Benutzerinteraktivität ist eines der Kernziele dieser Arbeit. Vitron nutzt bestehende sprachbasierte LLMs in Kombination mit entsprechenden Anpassungen der Anweisungen, um ein gewisses Maß an Interaktivität zu erreichen. Beispielsweise kann das System flexibel auf alle erwarteten Nachrichteneingaben des Benutzers reagieren und entsprechende visuelle Betriebsergebnisse erzeugen, ohne dass die Benutzereingaben genau mit den Bedingungen des Back-End-Moduls übereinstimmen müssen. Allerdings lässt diese Arbeit hinsichtlich der Verbesserung der Interaktivität noch viel Raum für Verbesserungen. In Anlehnung an das Closed-Source-Midjourney-System sollte das System den Benutzern unabhängig davon, welche Entscheidung LLM bei jedem Schritt trifft, aktiv Feedback geben, um sicherzustellen, dass seine Aktionen und Entscheidungen mit den Absichten der Benutzer übereinstimmen.

Modale Fähigkeiten

Derzeit integriert Vitron ein 7B Vicuna-Modell, dessen Fähigkeit, Sprache, Bilder und Videos zu verstehen, möglicherweise bestimmte Einschränkungen aufweist. Zukünftige Forschungsrichtungen könnten in der Entwicklung eines umfassenden End-to-End-Systems bestehen, beispielsweise in der Erweiterung des Maßstabs des Modells, um ein gründlicheres und umfassenderes Verständnis der Vision zu erreichen. Darüber hinaus sollten Anstrengungen unternommen werden, um LLM in die Lage zu versetzen, das Verständnis von Bild- und Videomodalitäten vollständig zu vereinheitlichen.

Das obige ist der detaillierte Inhalt vonUnter der Leitung von Yan Shuicheng veröffentlichte das Kunlun Wanwei 2050 Global Research Institute gemeinsam mit NUS und NTU Vitron und etablierte damit die ultimative Form allgemeiner visueller multimodaler Großmodelle.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1375

1375

52

52

Welche Bibliotheken werden für die Operationen der schwimmenden Punktzahl in Go verwendet?

Apr 02, 2025 pm 02:06 PM

Welche Bibliotheken werden für die Operationen der schwimmenden Punktzahl in Go verwendet?

Apr 02, 2025 pm 02:06 PM

In der Bibliothek, die für den Betrieb der Schwimmpunktnummer in der GO-Sprache verwendet wird, wird die Genauigkeit sichergestellt, wie die Genauigkeit ...

Gitee Pages statische Website -Bereitstellung fehlgeschlagen: Wie können Sie einzelne Dateien 404 Fehler beheben und beheben?

Apr 04, 2025 pm 11:54 PM

Gitee Pages statische Website -Bereitstellung fehlgeschlagen: Wie können Sie einzelne Dateien 404 Fehler beheben und beheben?

Apr 04, 2025 pm 11:54 PM

GitePages statische Website -Bereitstellung fehlgeschlagen: 404 Fehlerbehebung und Auflösung bei der Verwendung von Gitee ...

Welche Bibliotheken in GO werden von großen Unternehmen entwickelt oder von bekannten Open-Source-Projekten bereitgestellt?

Apr 02, 2025 pm 04:12 PM

Welche Bibliotheken in GO werden von großen Unternehmen entwickelt oder von bekannten Open-Source-Projekten bereitgestellt?

Apr 02, 2025 pm 04:12 PM

Welche Bibliotheken in GO werden von großen Unternehmen oder bekannten Open-Source-Projekten entwickelt? Bei der Programmierung in Go begegnen Entwickler häufig auf einige häufige Bedürfnisse, ...

So führen Sie das H5 -Projekt aus

Apr 06, 2025 pm 12:21 PM

So führen Sie das H5 -Projekt aus

Apr 06, 2025 pm 12:21 PM

Ausführen des H5 -Projekts erfordert die folgenden Schritte: Installation der erforderlichen Tools wie Webserver, Node.js, Entwicklungstools usw. Erstellen Sie eine Entwicklungsumgebung, erstellen Sie Projektordner, initialisieren Sie Projekte und schreiben Sie Code. Starten Sie den Entwicklungsserver und führen Sie den Befehl mit der Befehlszeile aus. Vorschau des Projekts in Ihrem Browser und geben Sie die Entwicklungsserver -URL ein. Veröffentlichen Sie Projekte, optimieren Sie Code, stellen Sie Projekte bereit und richten Sie die Webserverkonfiguration ein.

Wie erhalten Sie die Daten der Versandregion der Überseeversion? Was stehen einige vorgefertigte Ressourcen zur Verfügung?

Apr 01, 2025 am 08:15 AM

Wie erhalten Sie die Daten der Versandregion der Überseeversion? Was stehen einige vorgefertigte Ressourcen zur Verfügung?

Apr 01, 2025 am 08:15 AM

Frage Beschreibung: Wie erhalten Sie die Daten der Versandregion der Überseeversion? Gibt es bereitgestellte Ressourcen? Werden Sie im grenzüberschreitenden E-Commerce oder im globalisierten Geschäft genau ...

Python Hourglass Graph Drawing: Wie vermeiden Sie variable undefinierte Fehler?

Apr 01, 2025 pm 06:27 PM

Python Hourglass Graph Drawing: Wie vermeiden Sie variable undefinierte Fehler?

Apr 01, 2025 pm 06:27 PM

Erste Schritte mit Python: Hourglas -Grafikzeichnung und Eingabeüberprüfung In diesem Artikel wird das Problem der Variablendefinition gelöst, das von einem Python -Anfänger im Hourglass -Grafikzeichnungsprogramm auftritt. Code...

Wie löste ich das Problem des Typs des user_id -Typs bei der Verwendung von Redis -Stream, um Nachrichtenwarteschlangen in GO -Sprache zu implementieren?

Apr 02, 2025 pm 04:54 PM

Wie löste ich das Problem des Typs des user_id -Typs bei der Verwendung von Redis -Stream, um Nachrichtenwarteschlangen in GO -Sprache zu implementieren?

Apr 02, 2025 pm 04:54 PM

Das Problem der Verwendung von RETISTREAM zur Implementierung von Nachrichtenwarteschlangen in der GO -Sprache besteht darin, die Go -Sprache und Redis zu verwenden ...

Wie gibt ich die mit dem Modell in Beego Orm zugeordnete Datenbank an?

Apr 02, 2025 pm 03:54 PM

Wie gibt ich die mit dem Modell in Beego Orm zugeordnete Datenbank an?

Apr 02, 2025 pm 03:54 PM

Wie kann man im Beegoorm -Framework die mit dem Modell zugeordnete Datenbank angeben? In vielen BeEGO -Projekten müssen mehrere Datenbanken gleichzeitig betrieben werden. Bei Verwendung von BeEGO ...