Hardware-Tutorial

Hardware-Tutorial

Hardware-Neuigkeiten

Hardware-Neuigkeiten

Wie kann die Popularisierung von KI-PCs beschleunigt werden? Nvidia sieht in RTX die ultimative Antwort

Wie kann die Popularisierung von KI-PCs beschleunigt werden? Nvidia sieht in RTX die ultimative Antwort

Wie kann die Popularisierung von KI-PCs beschleunigt werden? Nvidia sieht in RTX die ultimative Antwort

Im letzten Jahrzehnt hat sich die Technologie der künstlichen Intelligenz (KI) von theoretischer Forschung und kleinen Anwendungen zu einer globalen technologischen Revolution entwickelt und die Art und Weise, wie wir leben und arbeiten, völlig verändert. Ob Sprachassistenten auf Smartphones oder komplexe Datenanalysen und automatisierte Produktionslinien – die Auswirkungen von KI sind überall und die damit verbundenen Effizienzsteigerungen und Kostensenkungen treiben eine beispiellose Produktivitätsrevolution voran.

Um die Chance der KI-Produktivität zu nutzen, haben viele Marken schnell ihre eigene KI-Hardware entwickelt: Einige Mobiltelefonmarken nutzen KI-Technologie, um Bewegungsverschmierungen beim Fotografieren zu beseitigen, und andere verwenden KI, um unerwünschte Bewegungsverschmierungen zu entfernen In Bildern sind einige Unternehmen sogar die ersten, die den sogenannten „AI PC“-Standard veröffentlicht haben.

Dagegen wirkt NVIDIA, das sich zurückhält und leise arbeitet, etwas deplatziert. Um diese „Weingasse geht tiefer“-Situation zu ändern, hat NVIDIA in den letzten Jahren auch hart daran gearbeitet, seine Präsenzmöglichkeiten im KI-Bereich zu erhöhen und Wege zu finden, um mehr Benutzer neben der Spielegrafik auch auf die führende Technologie von NVIDIA aufmerksam zu machen Karten – 2024 Am 24. April veranstaltete NVIDIA in Shenzhen ein Offline-Austauschtreffen mit dem Titel „RTX For AI“, bei dem jeder aus erster Hand erfahren konnte, wie NVIDIA „die Hälfte der KI-Branche unterstützt“.

Bildquelle: Lei Technology

Obwohl NVIDIA nicht das erste Unternehmen ist, das das Konzept der KI vorschlägt, könnten aus Produkt- und Technologieperspektive viele historische Knotenpunkte in Computern, einschließlich KI, dahinter stecken weniger von NVIDIA unterstützt: Im Jahr 2008 veröffentlichte NVIDIA die GeForce 8800 GTX-Grafikkarte.

Natürlich ist die Leistung dieser Grafikkarte mittlerweile nicht mehr erwähnenswert, aber für diese Grafikkarte hat NVIDIA das Konzept von „CUDA“ (Unified Computing Architecture) vorgeschlagen. Das Aufkommen von CUDA ermöglicht es der GPU, nicht nur Grafikoperationen zu verarbeiten, sondern auch allgemeine Berechnungen auf Basis von CUDA durchzuführen und zu beschleunigen, was den Computer zu einem echten „universellen Werkzeug“ macht.

Bildquelle: Lei Technology

Neben CUDA hat NVIDIA 2018 auch die Rechenleistung der GPU weiter „verfeinert“ und die Konzepte RT Core und Tensor Core eingeführt, die Raytracing und spezialisiertes ML-Computing ermöglichen möglich gemacht – Tensor Core beschleunigt das Training und die Ausführung von KI-Modellen erheblich, indem es groß angelegte Matrixoperationen effizient durchführt. DLSS, das bei NVIDIA-Benutzern sehr beliebt ist und die FPS in Spielen erheblich verbessern kann, basiert auf Tensor Core. Man kann sagen, dass es sich um den frühesten „echten KI“-Anwendungsfall handelt, mit dem Gamer in Berührung gekommen sind.

Rechenleistung ist die Grundlage aller KI

Vor dem Aufkommen der KI-Ära begann NVIDIA, über Möglichkeiten nachzudenken, Tensor Core zur Implementierung von KI-Funktionen zu nutzen, was den Beginn der KI-Ära beschleunigte ; im Vergleich zu sich selbst vor 6 Jahren: Welche Technologiesprünge hat NVIDIA jetzt im Bereich KI erzielt?

Laut der Einführung von NVIDIA deckt RTX AI derzeit 10 verschiedene KI-Szenarien ab, nämlich: KI-Malerei, KI-Grafikdesign, KI-Videobearbeitung, KI-3D-Erstellung, KI-Videoerlebnis, KI-Konferenz und KI-Dokumentationsassistent, KI-Anwendungsentwicklung, KI-Spiele und KI-Spieleentwicklung.  Bildquelle: Lei Technology

Bildquelle: Lei Technology

Obwohl diese Top-Ten-Szenarien unterschiedlich sind, haben sie alle einen gemeinsamen Bedarf an Computern: Rechenleistung. Und exzellente Rechenleistung ist genau das bekannteste Merkmal der RTX-Hardware.

Bildquelle: Lei Technology

Es besteht kein Zweifel daran, dass die Leistung im Vergleich zur Veröffentlichung der RTX-Grafikkarte und der Einführung von Tensor Core vor 6 Jahren die einfachste Verbesserung für NVIDIA im Bereich KI darstellt. Am Beispiel des häufigsten T2I-Anwendungsfalls sollten Freunde, die versucht haben, Modelle wie StableDiffusion auf ihren eigenen Computern bereitzustellen, wissen, dass die meisten aktuellen Modelle mehr oder weniger Probleme mit der „niedrigen Trefferquote“ haben, was dazu führt, dass Benutzer denselben Satz verwenden müssen von Schlüsselwörtern, um wiederholt Bilder zu generieren, und verwenden Sie eine Methode, die dem Handyspiel „Karten ziehen“ ähnelt, um die gewünschten Bilder zu generieren. Bildquelle: Lei Technology , RTX 4090D Die schnellste StableDiffusion-Bilderzeugung kann mit 120 Bildern pro Sekunde erreicht werden.

Feine Kontrolle ist das Markenzeichen der KI-Produktivität

Ich weiß nicht, ob Sie in den oben genannten Top-Ten-Szenarien ein Detail entdeckt haben. NVIDIA unterscheidet KI-Malerei und KI-Grafikdesign.Dies liegt nicht daran, dass NVIDIA mehr Anwendungsfälle zur Unterstützung der Szene verwenden möchte, sondern daran, dass KI-Malerei und KI-Grafikdesign tatsächlich zwei unterschiedliche Stufen der KI-Technologie markieren:

Die von Wensheng Tu vertretene KI-Malerei hat eine niedrige Trefferquote, Benutzer brauchen kontinuierlich eine große Anzahl von Bildern zu generieren, um „Karten zu ziehen“, bevor sie das gewünschte fertige Produkt erhalten. Und diese „Unkontrollierbarkeit“ bedeutet, dass die Verwendung dieser AIGC-Werke sehr begrenzt ist: entweder zur Unterhaltung, um Inspiration für Designer zu finden oder als Materialien für das Training von KI.

Aber AIGC, das eigentlich für „Produktivität“ verwendet wird, kann diese „Unsicherheit“ nicht tolerieren. Schließlich möchte niemand AIGC verwenden, um Kunden die Wirkung von Modekleidung zu zeigen, und KI erzeugt drei Hände auf der Kleidung; oder dem Design Als der Lehrer dem Kunden den Einrichtungsstil mithilfe von KI erklärte, malte die KI das Dach eines Doppelhauses als Keller.

Mit anderen Worten: Der größte Unterschied zwischen „Entertainment AI“ und „Productivity AI“ besteht darin, ob eine präzise Steuerung von AIGC erreicht werden kann.

Wir wissen, dass „Unterhaltungs-KI“ hauptsächlich zur Verbesserung der Benutzererfahrung und Interaktivität eingesetzt wird. Beispielsweise wird KI in Bereichen wie Videospielen, sozialen Medien und Online-Unterhaltung eingesetzt, um Inhalte zu empfehlen, Musik zu generieren, Gespräche zu simulieren und mehr. Das Hauptziel dieser Art von KI besteht darin, Unterhaltung und Engagement zu verbessern, wobei der Schwerpunkt weniger auf der Genauigkeit und Vorhersehbarkeit der Ergebnisse liegt. Diese Art von KI-generierter Grafik oder Musik muss keine strengen Standards für kommerzielle Anwendungen erfüllen und ihre Kreativität und Neuheit sind wichtiger.

Im Gegensatz dazu wird „Produktivitäts-KI“ in strengeren und anspruchsvolleren kommerziellen und industriellen Umgebungen eingesetzt, beispielsweise in der Fertigung, in der Medizin, in der Finanzanalyse usw. In diesen Bereichen hat KI die Aufgabe, die Effizienz zu steigern, Kosten und Fehlerquoten zu senken und verlässliche Entscheidungsunterstützung zu bieten. Beispielsweise wird KI in der medizinischen Diagnostik eingesetzt, um Bilder zu analysieren und Krankheitsmuster zu identifizieren, was eine äußerst hohe Genauigkeit und Zuverlässigkeit erfordert. Bei diesen Anwendungen hängt die Feinsteuerung nicht nur mit der Wirksamkeit des KI-Systems zusammen, sondern auch mit der direkten Auswirkung seiner Entscheidungsqualität auf das menschliche Leben.

Bildquelle: Lei Technology

Bei der Sharing-Session demonstrierte NVIDIA auch, wie eine „Produktivitäts-KI“ aussehen sollte – Instant AI. Als KI-Anwendung für den Bereich Architekturdesign bietet Zhizhi AI eine Vielzahl vorab trainierter KI-Modelle, die für verschiedene Architekturstile und -szenarien geeignet sind. Gleichzeitig kann Zhizhi AI auf der Grundlage der leistungsstarken Leistung der RTX-Hardware gleichzeitig arbeiten Die KI generiert die importierten Skizzen oder gezeichneten Linien des Designers und erklärt den Kunden nahezu in Echtzeit das Außendesign und den Inneneinrichtungsstil.

Die Probleme, auf die KI stößt, sollten durch KI gelöst werden

Natürlich sind die gerade genannten Anwendungsfälle nur ein kleiner Teil der Anwendungen von NVIDIA RTX im Bereich KI. Von unterhaltungsorientiertem Wenshengtu und DLSS 3.5 über NVIDIA ACE und Sound Cloning, die die Art der Spielinteraktion verändern, bis hin zu KI-Videobearbeitung, die den Kreativmodus verändert, und Chat mit RTX, das den Arbeitsmodus verändert, egal ob es sich um Spiele oder Arbeit handelt, Die KI-Technologie ist bereits in jeden Aspekt unseres Lebens vorgedrungen.

Bildquelle: Lei Technology

Beim Teilen der spezifischen Anwendung von AIGC im Videoerstellungsprozess erwähnte das berühmte Video-Spezialeffektteam „Special Effects Brother Studio“ auch einen sehr interessanten Standpunkt – die Verwendung von KI Lösen Sie aufgetretene KI-Probleme. Ihren Angaben zufolge entschieden sie sich bei der Rekonstruktion der Tiefenschärfe von AIGC-Bildern nicht für die herkömmliche manuelle Markierung von Tiefenkarten, sondern übergaben die Bilder direkt an die KI, ließen die AIGC-Tiefenkarte zeichnen und ausgeben die Ergebnisse in ein anderes KI-Modell übertragen.

Bildquelle: Lei Technology

Diese Art von „Magie mit Magie besiegen“-Lösung ist meiner Meinung nach nicht nur ein Zeichen für die Industrialisierung und Formalisierung von AIGC, sondern auch eine der zukünftigen Entwicklungsrichtungen der KI.

Zuallererst erfordert das Training von KI-Modellen viele Rechenressourcen. Da die Erfassung hochwertiger Daten oft kostspielig und schwierig zu erreichen ist, ist der Einsatz synthetischer Datengenerierungstechniken wie Generative Adversarial Networks (GANs) erforderlich. kann eine große Menge realistischer Trainingsdaten erstellen, was wichtig ist Es ist sehr hilfreich, die Trainingseffizienz und -effektivität von KI-Systemen zu verbessern. Diese Technologie kann nicht nur zur Generierung von Bilddaten verwendet werden, sondern kann auch auf die Generierung von Text, Audio und sogar virtuellen Umgebungen ausgeweitet werden, wodurch Datenquellen erheblich bereichert werden und mehr Möglichkeiten für das KI-Training bereitgestellt werden.

Zweitens ist die Interpretierbarkeit von KI-Modellen auch eine wichtige technische Herausforderung, da viele effiziente Modelle wie tiefe neuronale Netze oft wie Black Boxes wirken und ihre interne Entscheidungslogik nur schwer zu verstehen ist.Durch die Entwicklung interpretierender KI-Technologie kann der Entscheidungsprozess des Modells transparenter gestaltet werden, was das Vertrauen der Benutzer erhöht und es Entwicklern erleichtert, Modellmängel zu finden und zu verbessern.

Bildquelle: Lei Technology

Langfristig gesehen erfordert die Lösung dieser technischen Herausforderungen nicht nur fortschrittlichere Algorithmen und Modelldesigns, sondern auch die Suche nach einem Gleichgewicht zwischen Datenverarbeitung, Modelltraining und praktischen Anwendungen. Dies wird der Schlüssel zur Förderung der zukünftigen Entwicklung der KI-Technologie sein. Wir erwarten, dass KI mehr Komfort bringt und wir erwarten, dass sie uns dabei hilft, alte Probleme auf neue Weise zu lösen.

Und wenn KI die menschliche Produktivität wirklich und vollständig freisetzt, werden Schöpfer und KI mit endloser Fantasie sicherlich noch mehr ungezügelte Ideen wahr werden lassen.

Das obige ist der detaillierte Inhalt vonWie kann die Popularisierung von KI-PCs beschleunigt werden? Nvidia sieht in RTX die ultimative Antwort. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

So nehmen Sie Bildschirmvideos mit einem OPPO-Telefon auf (einfache Bedienung)

May 07, 2024 pm 06:22 PM

So nehmen Sie Bildschirmvideos mit einem OPPO-Telefon auf (einfache Bedienung)

May 07, 2024 pm 06:22 PM

Spielfähigkeiten oder Lehrdemonstrationen: Im täglichen Leben müssen wir häufig Mobiltelefone verwenden, um Bildschirmvideos aufzunehmen, um einige Bedienschritte zu zeigen. Die Funktion zum Aufzeichnen von Bildschirmvideos ist ebenfalls sehr gut und das OPPO-Mobiltelefon ist ein leistungsstarkes Smartphone. Damit Sie die Aufnahmeaufgabe einfach und schnell erledigen können, wird in diesem Artikel detailliert beschrieben, wie Sie OPPO-Mobiltelefone zum Aufzeichnen von Bildschirmvideos verwenden. Vorbereitung – Aufnahmeziele festlegen Bevor Sie beginnen, müssen Sie Ihre Aufnahmeziele klären. Möchten Sie ein Schritt-für-Schritt-Demonstrationsvideo aufnehmen? Oder möchten Sie einen wundervollen Moment eines Spiels festhalten? Oder möchten Sie ein Lehrvideo aufnehmen? Nur durch eine bessere Organisation des Aufnahmeprozesses und klare Ziele. Öffnen Sie die Bildschirmaufzeichnungsfunktion des OPPO-Mobiltelefons und finden Sie sie im Verknüpfungsfeld. Die Bildschirmaufzeichnungsfunktion befindet sich im Verknüpfungsfeld.

Was ist der Unterschied zwischen Quad-Core- und Acht-Core-Computer-CPUs?

May 06, 2024 am 09:46 AM

Was ist der Unterschied zwischen Quad-Core- und Acht-Core-Computer-CPUs?

May 06, 2024 am 09:46 AM

Was ist der Unterschied zwischen Quad-Core- und Acht-Core-Computer-CPUs? Der Unterschied liegt in der Verarbeitungsgeschwindigkeit und Leistung. Eine Quad-Core-CPU verfügt über vier Prozessorkerne, während eine Acht-Core-CPU über acht Kerne verfügt. Dies bedeutet, dass ersterer vier Aufgaben gleichzeitig ausführen kann und letzterer acht Aufgaben gleichzeitig ausführen kann. Daher ist eine Octa-Core-CPU schneller als eine Quad-Core-CPU, wenn sie zur Verarbeitung großer Datenmengen oder zur Ausführung mehrerer Programme verwendet wird. Gleichzeitig eignen sich Achtkern-CPUs auch besser für Multimedia-Arbeiten wie Videobearbeitung oder Spiele, da diese Aufgaben höhere Verarbeitungsgeschwindigkeiten und bessere Grafikverarbeitungsfunktionen erfordern. Allerdings sind auch die Kosten für Achtkern-CPUs höher, daher ist es sehr wichtig, die richtige CPU basierend auf den tatsächlichen Anforderungen und dem Budget auszuwählen. Ist es besser, eine Dual-Core- oder Quad-Core-Computer-CPU zu haben? Ob Dual-Core oder Quad-Core besser ist, hängt von Ihren Nutzungsanforderungen ab.

So ändern Sie die Timing-Einstellungen von TikTok

May 04, 2024 am 01:06 AM

So ändern Sie die Timing-Einstellungen von TikTok

May 04, 2024 am 01:06 AM

Es gibt zwei Möglichkeiten, die Timing-Einstellungen von Douyin zu ändern: Videobearbeitungsseite: Klicken Sie auf der Bearbeitungsseite auf die Option „Geplante Veröffentlichung“, um die Veröffentlichungszeit festzulegen. Videoverwaltungsseite: Drücken Sie lange auf das Video, um „Bearbeiten“ auszuwählen, und klicken Sie auf „Veröffentlichung planen“, um die Veröffentlichungszeit zurückzusetzen.

So richten Sie Douyin ein, um Videos zu planen

May 04, 2024 am 03:33 AM

So richten Sie Douyin ein, um Videos zu planen

May 04, 2024 am 03:33 AM

Die Schritte für die geplante Videoveröffentlichung auf Douyin sind wie folgt: Video hochladen Geplante Videoveröffentlichung bearbeiten (Veröffentlichungszeit festlegen) Veröffentlichung bestätigen (Zeit und Inhalt)

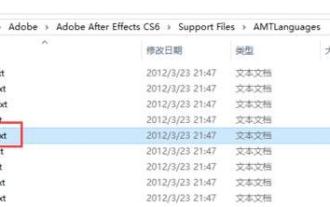

So wechseln Sie die Sprache in Adobe After Effects cs6 (Ae cs6) Detaillierte Schritte zum Wechseln zwischen Chinesisch und Englisch in Ae cs6 – ZOL-Download

May 09, 2024 pm 02:00 PM

So wechseln Sie die Sprache in Adobe After Effects cs6 (Ae cs6) Detaillierte Schritte zum Wechseln zwischen Chinesisch und Englisch in Ae cs6 – ZOL-Download

May 09, 2024 pm 02:00 PM

1. Suchen Sie zuerst den Ordner AMTLangagues. Wir haben einige Dokumentationen im AMTLangagues-Ordner gefunden. Wenn Sie vereinfachtes Chinesisch installieren, gibt es ein Textdokument zh_CN.txt (der Textinhalt ist: zh_CN). Wenn Sie es auf Englisch installiert haben, gibt es ein Textdokument en_US.txt (der Textinhalt ist: en_US). 3. Wenn wir also auf Chinesisch umsteigen möchten, müssen wir ein neues Textdokument von zh_CN.txt (der Textinhalt ist: zh_CN) unter dem Pfad AdobeAfterEffectsCCSupportFilesAMTLanguages erstellen. 4. Im Gegenteil, wenn wir auf Englisch umsteigen wollen,

Welches ist besser, Snapdragon 8gen3 oder Snapdragon 8s der dritten Generation?

May 05, 2024 am 01:24 AM

Welches ist besser, Snapdragon 8gen3 oder Snapdragon 8s der dritten Generation?

May 05, 2024 am 01:24 AM

Snapdragon 8 Gen 3 ist in der Gesamtleistung überlegen, während Snapdragon 8s Gen 3 weitere Vorteile bei Stromverbrauch, Wärmeerzeugung und Konnektivität bietet. Beide unterstützen hochauflösende Kameras, erweiterte Bildverarbeitungsfunktionen und leistungsstarke KI-Engines. Snapdragon 8 Gen 3 ist mit einem X70-Modem ausgestattet, während Snapdragon 8s Gen 3 mit einem X65-Modem ausgestattet ist.

So stellen Sie die Videogröße des TikTok-Bildschirms ein

May 04, 2024 am 03:18 AM

So stellen Sie die Videogröße des TikTok-Bildschirms ein

May 04, 2024 am 03:18 AM

Es gibt zwei Schritte, um die Bildschirmvideogröße auf Douyin einzustellen: 1. Wählen Sie das Videoverhältnis (16:9, 9:16 oder 1:1). 2. Passen Sie die Videogröße an, um sicherzustellen, dass sie zum Bildschirmverhältnis passt. Empfohlene optimale Bildschirmvideogrößen sind 16:9 (Querformat), 9:16 (Hochformat) oder 1:1 (Quadrat). Hinweis: Die Videogröße wirkt sich auf die Klarheit und Glätte aus. Passen Sie die Videogröße mit einer Videobearbeitungssoftware an, um optimale Ergebnisse zu erzielen. Douyin komprimiert das hochgeladene Video und stellt so sicher, dass das Originalvideo eine ausreichend hohe Qualität hat.

So ändern Sie die Videocodenummer auf Douyin

May 04, 2024 am 09:09 AM

So ändern Sie die Videocodenummer auf Douyin

May 04, 2024 am 09:09 AM

So ändern Sie die Codenummer von Douyin-Videos: Schritt 1: Wählen Sie das Video aus; Schritt 3: Wählen Sie „Videobearbeitung“; Schritt 4: Passen Sie die Codenummer an (empfohlene Auflösung: Hoch 720p, Mittel 480p, Niedrig). 360p); Schritt 5: Änderungen speichern.