Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie kann OctopusV3 mit weniger als 1 Milliarde Parametern mit GPT-4V und GPT-4 verglichen werden?

Wie kann OctopusV3 mit weniger als 1 Milliarde Parametern mit GPT-4V und GPT-4 verglichen werden?

Wie kann OctopusV3 mit weniger als 1 Milliarde Parametern mit GPT-4V und GPT-4 verglichen werden?

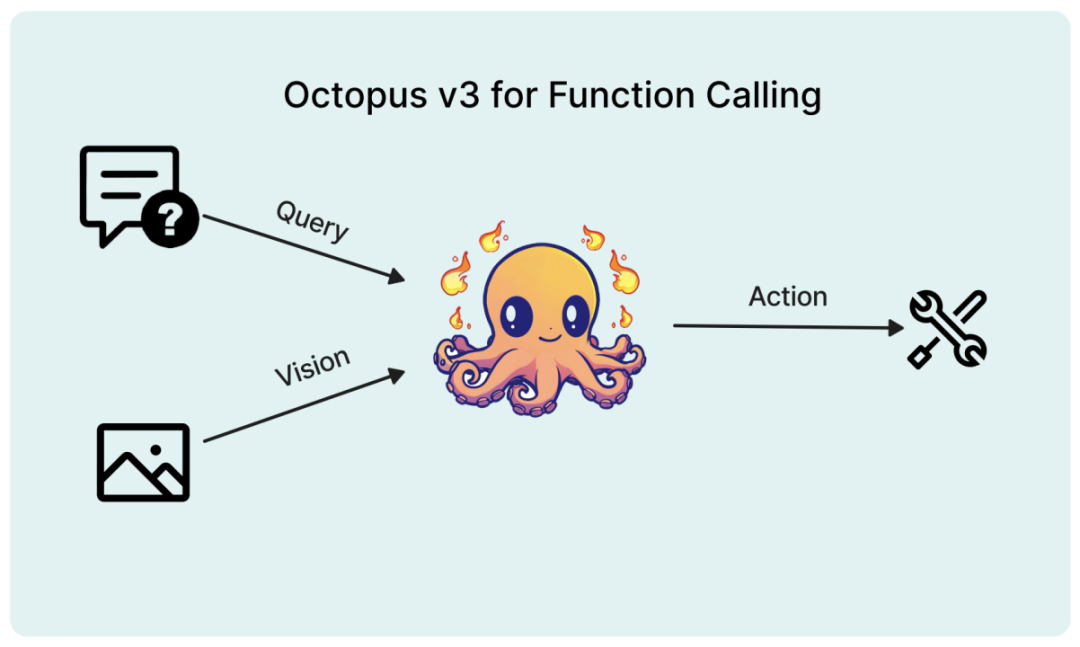

Multimodale KI-Systeme zeichnen sich durch ihre Fähigkeit aus, verschiedene Arten von Daten, einschließlich natürlicher Sprache, Bild, Audio usw., zu verarbeiten und zu lernen, um ihre Verhaltensentscheidungen zu steuern. In jüngster Zeit hat die Forschung zur Integration visueller Daten in große Sprachmodelle (wie GPT-4V) wichtige Fortschritte gemacht, aber die Frage, wie Bildinformationen effektiv in ausführbare Operationen für KI-Systeme umgewandelt werden können, steht immer noch vor Herausforderungen. Um die Transformation von Bildinformationen zu erreichen, besteht eine gängige Methode darin, Bilddaten in entsprechende Textbeschreibungen umzuwandeln, woraufhin das KI-System auf der Grundlage der Beschreibungen arbeitet. Dies kann durch überwachtes Lernen an vorhandenen Bilddatensätzen erfolgen, wodurch das KI-System die Bild-zu-Text-Zuordnungsbeziehung automatisch lernen kann. Darüber hinaus kann mit Methoden des Reinforcement Learning auch gelernt werden, Entscheidungen auf Basis von Bildinformationen durch Interaktion mit der Umgebung zu treffen. Eine andere Methode besteht darin, Bildinformationen direkt mit einem Sprachmodell zu kombinieren, um

In einem kürzlich erschienenen Artikel schlugen Forscher ein multimodales Modell vor, das speziell für KI-Anwendungen entwickelt wurde, und führten das Konzept des „funktionalen Tokens“ ein.

Papiertitel: Octopus v3: Technischer Bericht für On-Device Sub-Billion Multimodal AI Agent

Papierlink: https://arxiv.org/pdf/2404.11459.pdf

Modellgewichte und Inferenz Code: https://www.nexa4ai.com/apply

Dieses Modell kann Edge-Geräte vollständig unterstützen, und Forscher haben seine Parametermenge auf innerhalb von 1 Milliarde optimiert. Ähnlich wie GPT-4 beherrscht dieses Modell sowohl Englisch als auch Chinesisch. Experimente haben gezeigt, dass das Modell auf verschiedenen ressourcenbeschränkten Endgeräten, einschließlich Raspberry Pi, effizient laufen kann.

Forschungshintergrund

Die rasante Entwicklung der Technologie der künstlichen Intelligenz hat die Art und Weise der Mensch-Computer-Interaktion völlig verändert und eine Reihe intelligenter KI-Systeme hervorgebracht, die komplexe Aufgaben ausführen und Entscheidungen auf der Grundlage verschiedener Eingabeformen wie natürlicher Sprache und Vision treffen können. Von diesen Systemen wird erwartet, dass sie alles automatisieren, von einfachen Aufgaben wie Bilderkennung und Sprachübersetzung bis hin zu komplexen Anwendungen wie medizinische Diagnose und autonomes Fahren. Multimodale Sprachmodelle bilden den Kern dieser intelligenten Systeme und ermöglichen es ihnen, durch die Verarbeitung und Integration multimodaler Daten wie Text, Bilder und sogar Audio und Video menschennahe Antworten zu verstehen und zu generieren. Im Vergleich zu traditionellen Sprachmodellen, die sich hauptsächlich auf die Textverarbeitung und -generierung konzentrieren, stellen multimodale Sprachmodelle einen großen Fortschritt dar. Durch die Einbeziehung visueller Informationen sind diese Modelle in der Lage, den Kontext und die Semantik der Eingabedaten besser zu verstehen, was zu einer genaueren und relevanteren Ausgabe führt. Die Fähigkeit, multimodale Daten zu verarbeiten und zu integrieren, ist von entscheidender Bedeutung für die Entwicklung multimodaler KI-Systeme, die gleichzeitig Aufgaben wie Sprache und visuelle Informationen verstehen können, beispielsweise visuelle Beantwortung von Fragen, Bildnavigation, multimodale Stimmungsanalyse usw.

Eine der Herausforderungen bei der Entwicklung multimodaler Sprachmodelle besteht darin, visuelle Informationen effektiv in ein Format zu kodieren, das das Modell verarbeiten kann. Dies geschieht in der Regel mit Hilfe neuronaler Netzwerkarchitekturen wie Visual Transformers (ViT) und Convolutional Neural Networks (CNN). Die Fähigkeit, hierarchische Merkmale aus Bildern zu extrahieren, wird häufig bei Computer-Vision-Aufgaben genutzt. Mithilfe dieser Architekturen als Modelle kann man lernen, komplexere Darstellungen aus Eingabedaten zu extrahieren. Darüber hinaus ist die transformatorbasierte Architektur nicht nur in der Lage, Abhängigkeiten über große Entfernungen zu erfassen, sondern leistet auch gute Dienste beim Verständnis der Beziehungen zwischen Objekten in Bildern. In den letzten Jahren sehr beliebt. Diese Architekturen ermöglichen es Modellen, aussagekräftige Merkmale aus Eingabebildern zu extrahieren und sie in Vektordarstellungen umzuwandeln, die mit Texteingaben kombiniert werden können.

Eine weitere Möglichkeit, visuelle Informationen zu kodieren, ist die Bild-Tokenisierung, bei der das Bild in kleinere diskrete Einheiten oder Token unterteilt wird. Dieser Ansatz ermöglicht es dem Modell, Bilder ähnlich wie Text zu verarbeiten, was eine nahtlosere Integration der beiden Modalitäten ermöglicht. Bild-Token-Informationen können zusammen mit der Texteingabe in das Modell eingespeist werden, sodass es sich auf beide Modalitäten konzentrieren und eine genauere und kontextbezogenere Ausgabe erzeugen kann. Beispielsweise verwendet das von OpenAI entwickelte DALL-E-Modell eine Variante von VQ-VAE (Vector Quantized Variational Autoencoder), um Bilder zu symbolisieren, sodass das Modell neuartige Bilder basierend auf Textbeschreibungen generieren kann. Die Entwicklung kleiner, effizienter Modelle, die auf vom Benutzer bereitgestellte Abfragen und Bilder reagieren können, wird tiefgreifende Auswirkungen auf die zukünftige Entwicklung von KI-Systemen haben. Diese Modelle können auf ressourcenbeschränkten Geräten wie Smartphones und IoT-Geräten eingesetzt werden und erweitern so deren Anwendungsbereich und Szenarios. Durch die Nutzung der Leistungsfähigkeit multimodaler Sprachmodelle können diese kleinen Systeme Benutzeranfragen auf natürlichere und intuitivere Weise verstehen und darauf reagieren und dabei den vom Benutzer bereitgestellten visuellen Kontext berücksichtigen. Dies eröffnet die Möglichkeit für ansprechendere, personalisierte Mensch-Maschine-Interaktionen, wie etwa virtuelle Assistenten, die visuelle Empfehlungen basierend auf Benutzerpräferenzen bereitstellen, oder Smart-Home-Geräte, die Einstellungen basierend auf den Gesichtsausdrücken des Benutzers anpassen.

Darüber hinaus wird erwartet, dass die Entwicklung multimodaler KI-Systeme die Technologie der künstlichen Intelligenz demokratisieren und einem breiteren Spektrum von Benutzern und Branchen zugute kommen wird. Kleinere und effizientere Modelle können auf weniger leistungsstarker Hardware trainiert werden, wodurch die für die Bereitstellung erforderlichen Rechenressourcen und der Energieverbrauch reduziert werden. Dies kann zu einer weit verbreiteten Anwendung von KI-Systemen in verschiedenen Bereichen wie medizinischer Versorgung, Bildung, Unterhaltung, E-Commerce usw. führen und letztendlich die Art und Weise, wie Menschen leben und arbeiten, verändern.

Verwandte Arbeit

Multimodale Modelle haben aufgrund ihrer Fähigkeit, mehrere Datentypen wie Text, Bilder, Audio usw. zu verarbeiten und zu lernen, große Aufmerksamkeit auf sich gezogen. Diese Art von Modell kann die komplexen Wechselwirkungen zwischen verschiedenen Modalitäten erfassen und deren komplementäre Informationen nutzen, um die Leistung verschiedener Aufgaben zu verbessern. Vision-Language Pre-Trained (VLP)-Modelle wie ViLBERT, LXMERT, VisualBERT usw. lernen die Ausrichtung von visuellen und Textmerkmalen durch modalübergreifende Aufmerksamkeit, um reichhaltige multimodale Darstellungen zu generieren. Multimodale Transformatorarchitekturen wie MMT, ViLT usw. verfügen über verbesserte Transformatoren zur effizienten Handhabung mehrerer Modalitäten. Forscher haben auch versucht, andere Modalitäten wie Audio- und Gesichtsausdrücke in Modelle zu integrieren, beispielsweise Modelle zur multimodalen Stimmungsanalyse (MSA), Modelle zur multimodalen Emotionserkennung (MER) usw. Durch die Nutzung der komplementären Informationen verschiedener Modalitäten erreichen multimodale Modelle eine bessere Leistung und Generalisierungsfähigkeit als einmodale Methoden.

Terminalsprachmodelle werden als Modelle mit weniger als 7 Milliarden Parametern definiert, da Forscher herausgefunden haben, dass es selbst mit Quantisierung sehr schwierig ist, ein Modell mit 13 Milliarden Parametern auf Edge-Geräten auszuführen. Zu den jüngsten Fortschritten in diesem Bereich gehören Googles Gemma 2B und 7B, Stable Diffusions Stable Code 3B und Metas Llama 7B. Interessanterweise zeigt die Forschung von Meta, dass kleine Sprachmodelle im Gegensatz zu großen Sprachmodellen bei tiefen und schmalen Architekturen eine bessere Leistung erbringen. Weitere Techniken, die für das Terminalmodell von Vorteil sind, umfassen die in MobileLLM vorgeschlagene Einbettungsfreigabe, gruppierte Abfrageaufmerksamkeit und sofortige Blockgewichtsfreigabe. Diese Ergebnisse unterstreichen die Notwendigkeit, bei der Entwicklung kleiner Sprachmodelle für Endanwendungen andere Optimierungsmethoden und Entwurfsstrategien zu berücksichtigen als bei großen Modellen.

Octopus-Methode

Die Haupttechnologie, die bei der Entwicklung des Octopus v3-Modells verwendet wird. Zwei Schlüsselaspekte der multimodalen Modellentwicklung sind die Integration von Bildinformationen mit Texteingaben und die Optimierung der Fähigkeit des Modells, Aktionen vorherzusagen.

Visuelle Informationskodierung

In der Bildverarbeitung gibt es viele Methoden zur Kodierung visueller Informationen, und häufig wird die Einbettung versteckter Ebenen verwendet. Beispielsweise wird die Einbettung versteckter Schichten des VGG-16-Modells für Stilübertragungsaufgaben verwendet. Das CLIP-Modell von OpenAI demonstriert die Fähigkeit, Text- und Bildeinbettungen auszurichten, indem es seinen Bild-Encoder zum Einbetten von Bildern nutzt. Methoden wie ViT nutzen fortschrittlichere Technologien wie die Bild-Tokenisierung. Die Forscher bewerteten verschiedene Bildcodierungstechniken und stellten fest, dass die CLIP-Modellmethode am effektivsten war. Daher verwendet dieser Artikel ein CLIP-basiertes Modell für die Bildcodierung.

Funktions-Token

Ähnlich wie bei der Tokenisierung, die auf natürliche Sprache und Bilder angewendet wird, können bestimmte Funktionen auch als Funktions-Token gekapselt werden. Die Forscher führten eine Trainingsstrategie für diese Token ein, die sich auf die Technologie natürlicher Sprachmodelle zur Verarbeitung unsichtbarer Wörter stützte. Diese Methode ähnelt word2vec und bereichert die Semantik des Tokens durch seinen Kontext. Beispielsweise können Hochsprachenmodelle zunächst Schwierigkeiten mit komplexen chemischen Begriffen wie PEGylierung und Endosomal Escape haben. Aber durch kausale Sprachmodellierung, insbesondere durch Training an einem Datensatz, der diese Begriffe enthält, kann das Modell diese Begriffe lernen. Ebenso können funktionale Token durch parallele Strategien erlernt werden, wobei das Octopus v2-Modell eine leistungsstarke Plattform für solche Lernprozesse bietet. Untersuchungen zeigen, dass der Definitionsraum funktionaler Token unendlich ist, sodass jede spezifische Funktion als Token dargestellt werden kann.

Mehrstufiges Training

Um ein leistungsstarkes multimodales KI-System zu entwickeln, haben Forscher eine Modellarchitektur übernommen, die kausale Sprachmodelle und Bildkodierer integriert. Der Trainingsprozess dieses Modells ist in mehrere Phasen unterteilt. Zunächst werden das kausale Sprachmodell und der Bildkodierer separat trainiert, um ein Grundmodell zu erstellen. Anschließend werden die beiden Komponenten zusammengeführt und ausgerichtet und trainiert, um Bild- und Textverarbeitungsfähigkeiten zu synchronisieren. Auf dieser Basis wird die Methode von Octopus v2 genutzt, um das Lernen funktionaler Token zu fördern. In der letzten Trainingsphase liefern diese funktionalen Token, die mit der Umgebung interagieren, Feedback zur weiteren Optimierung des Modells. Daher haben die Forscher in der letzten Phase das verstärkende Lernen übernommen und ein anderes großes Sprachmodell als Belohnungsmodell ausgewählt. Diese iterative Trainingsmethode verbessert die Fähigkeit des Modells, multimodale Informationen zu verarbeiten und zu integrieren.

Modellbewertung

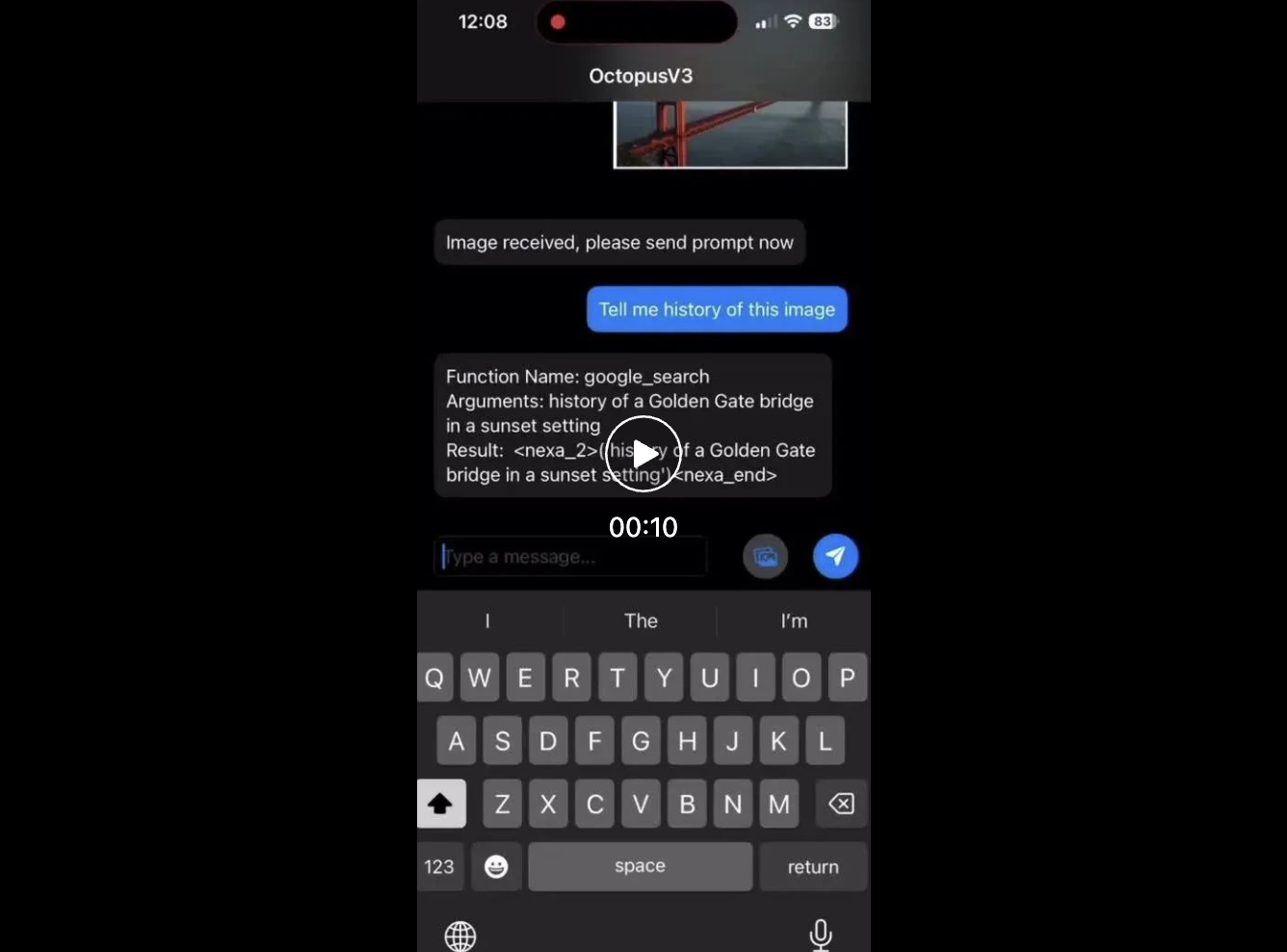

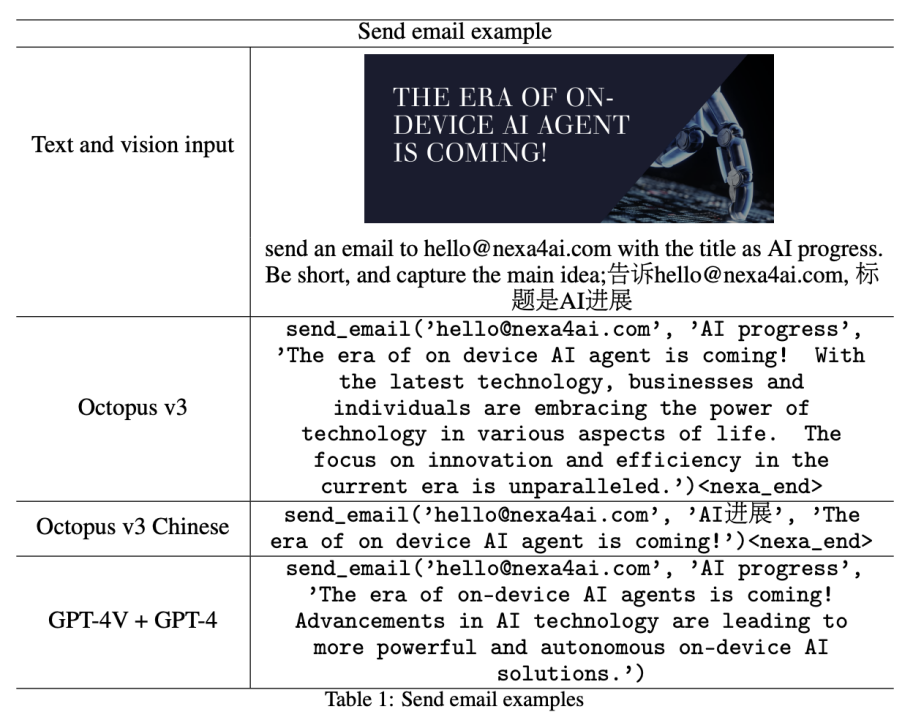

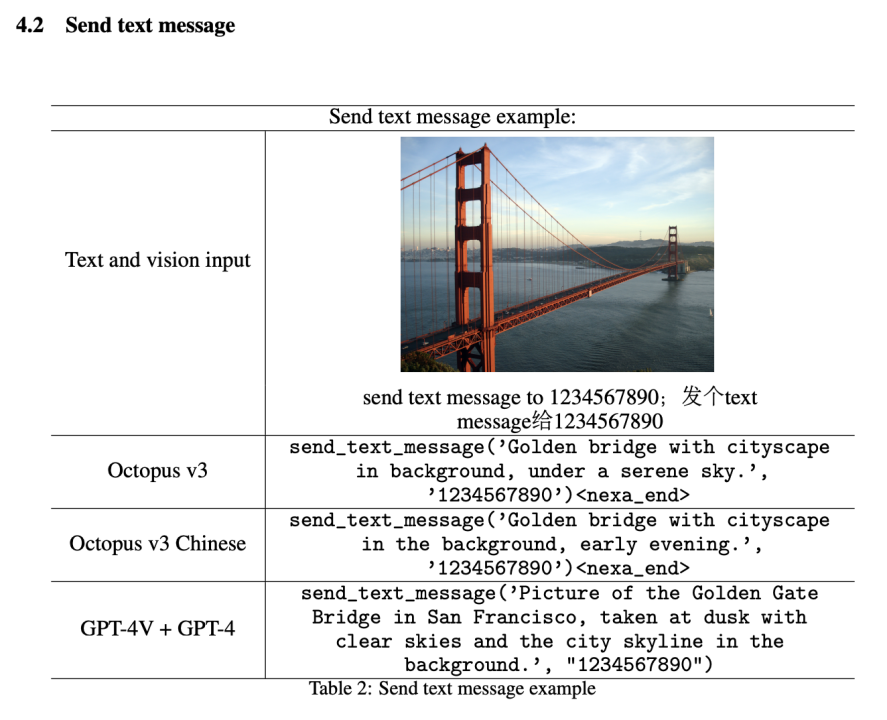

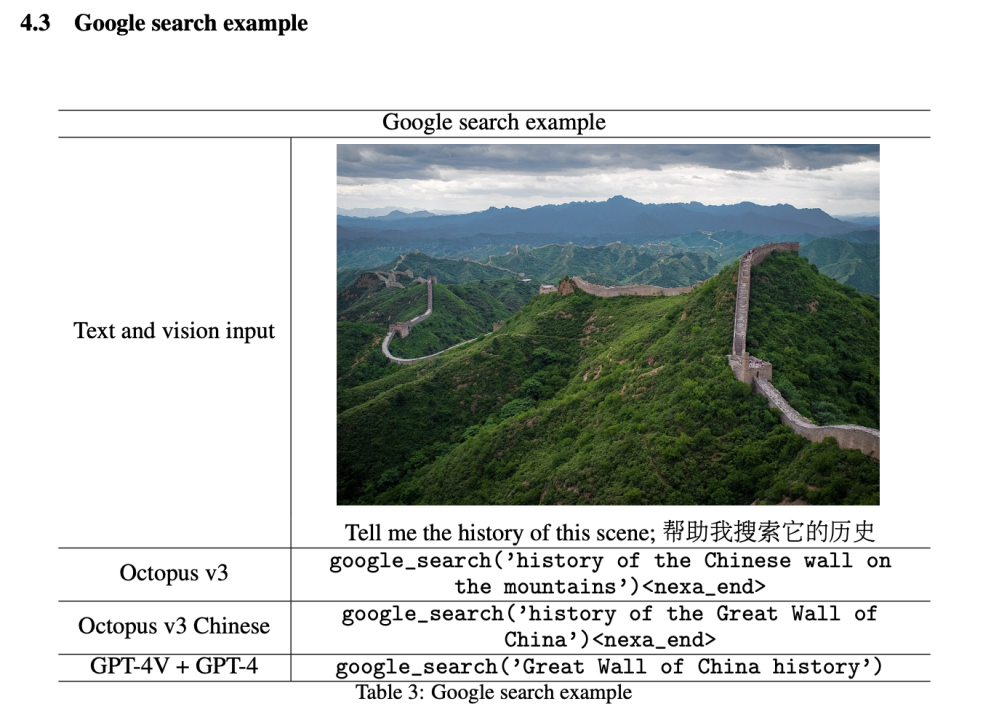

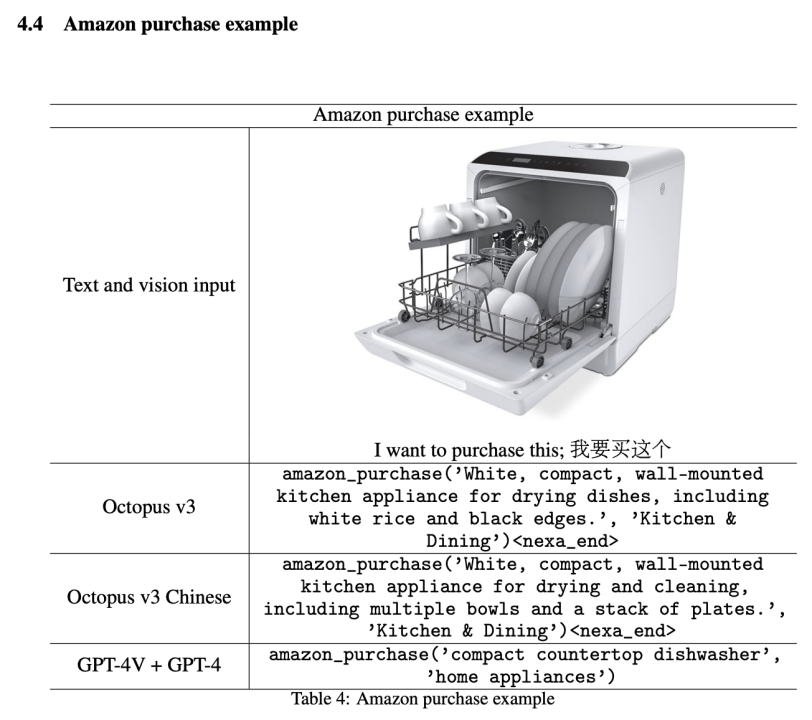

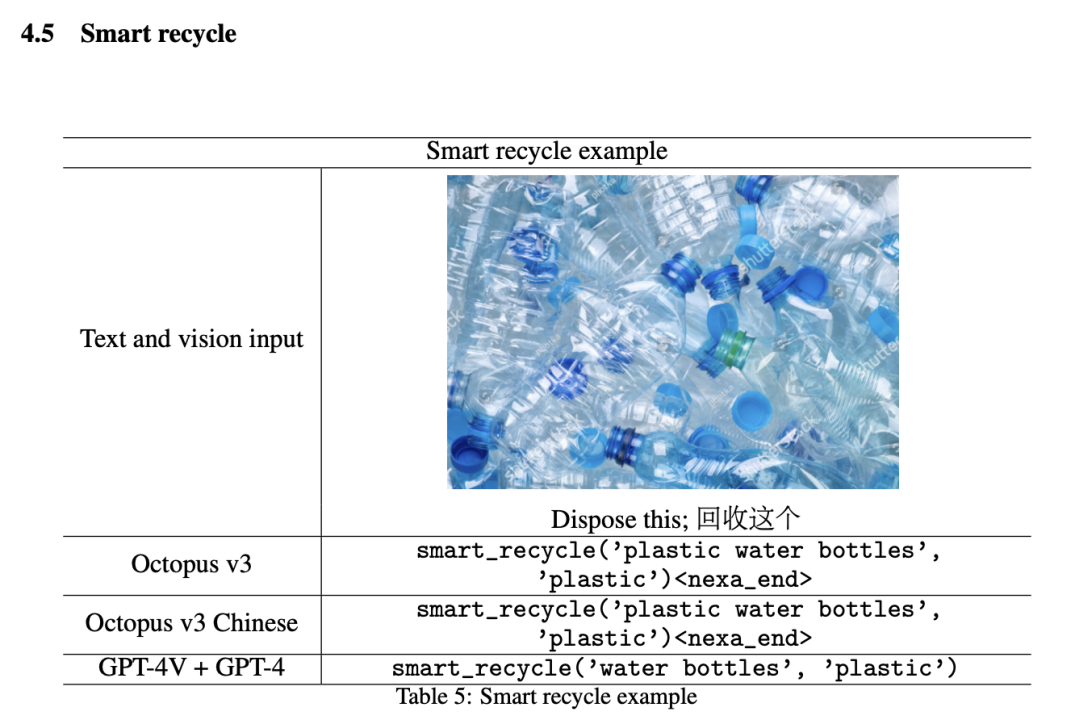

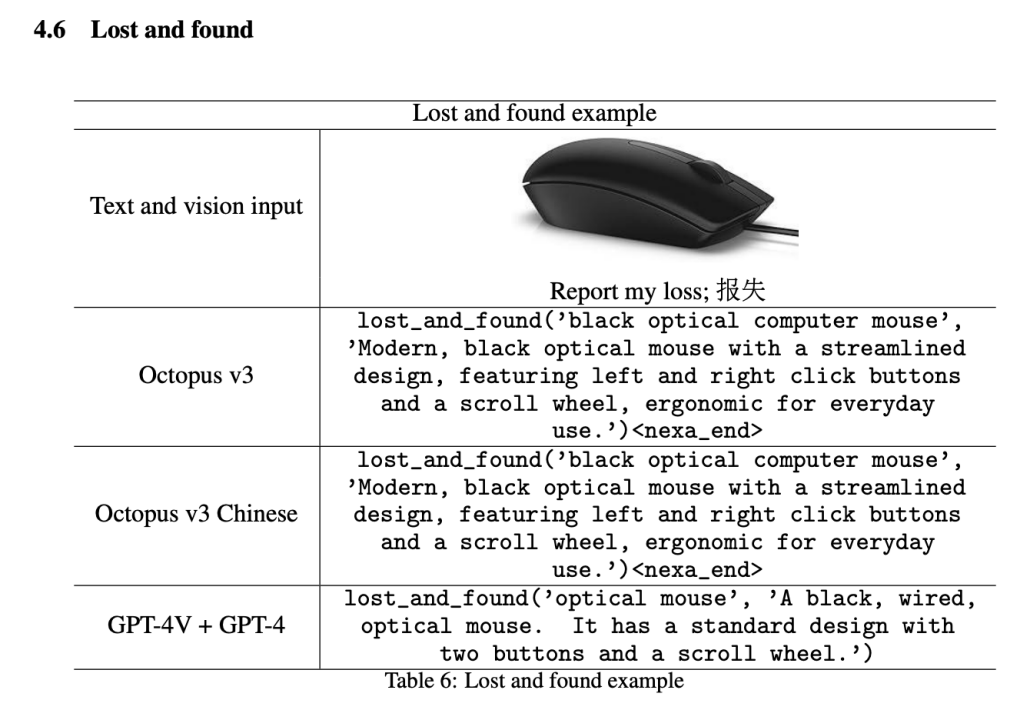

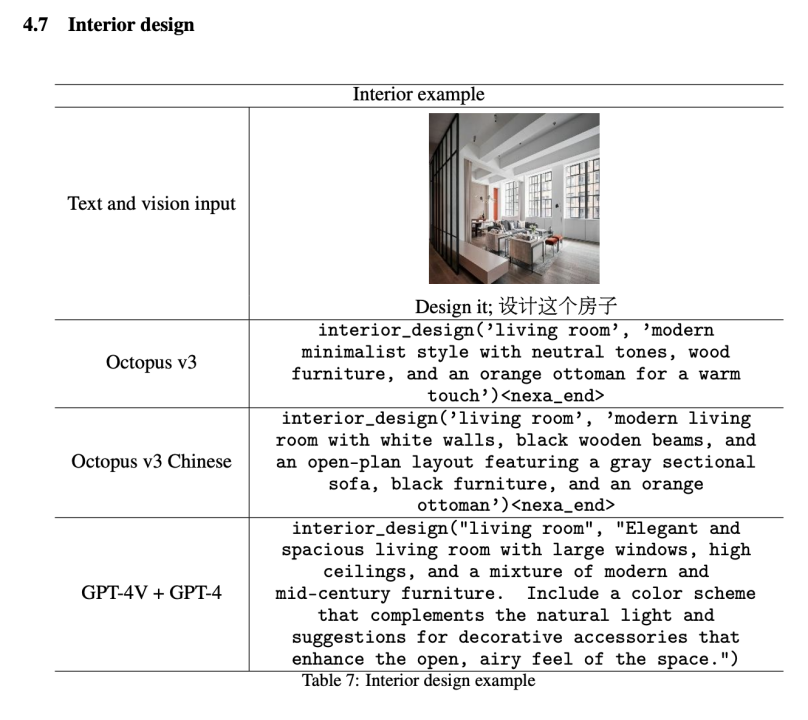

In diesem Abschnitt werden die experimentellen Ergebnisse des Modells vorgestellt und mit den Auswirkungen der Integration von GPT-4V- und GPT-4-Modellen verglichen. Im Vergleichsexperiment verwendeten die Forscher zunächst GPT-4V (gpt-4-turbo) zur Verarbeitung von Bildinformationen. Die extrahierten Daten werden dann in das GPT-4-Framework (gpt-4-turbo-preview) eingespeist, das alle Funktionsbeschreibungen kontextualisiert und Fear-Shot-Learning anwendet, um die Leistung zu verbessern. In der Demonstration wandelten die Forscher 10 häufig verwendete Smartphone-APIs in funktionale Token um und bewerteten deren Leistung, wie in den folgenden Abschnitten beschrieben.

Es ist erwähnenswert, dass dieser Artikel zwar nur 10 funktionale Token zeigt, das Modell jedoch mehr Token trainieren kann, um ein allgemeineres KI-System zu erstellen. Die Forscher fanden heraus, dass für ausgewählte APIs Modelle mit weniger als 1 Milliarde Parametern als multimodale KI vergleichbar mit der Kombination von GPT-4V und GPT-4 funktionierten.

Darüber hinaus ermöglicht die Skalierbarkeit des Modells in diesem Artikel die Einbeziehung einer breiten Palette funktionaler Token, wodurch hochspezialisierte KI-Systeme erstellt werden können, die für bestimmte Bereiche oder Szenarien geeignet sind. Diese Anpassungsfähigkeit macht unseren Ansatz besonders wertvoll in Branchen wie dem Gesundheitswesen, dem Finanzwesen und dem Kundenservice, wo KI-gesteuerte Lösungen die Effizienz und das Benutzererlebnis erheblich verbessern können.

Unter allen unten aufgeführten Funktionsnamen gibt Octopus zur besseren Demonstration nur Funktionstoken aus, z. B.

E-Mail senden

SMS senden

Google-Suche

Amazon Shopping

Smart Recycling

Verloren und Gefunden

Innenarchitektur

„Instacart Shopping“: „DoorDash Delivery“: „Haustierbetreuung“

Funktions-Token ist derzeit autorisiert. Der Forscher ermutigt Entwickler, sich im Rahmen dieses Artikels zu beteiligen und unter der Voraussetzung der Einhaltung der Lizenzvereinbarung frei zu innovieren. In zukünftigen Forschungen wollen die Forscher einen Trainingsrahmen entwickeln, der zusätzliche Datenmodalitäten wie Audio und Video berücksichtigen kann. Darüber hinaus haben Forscher herausgefunden, dass visuelle Eingaben erhebliche Latenzzeiten verursachen können, und optimieren derzeit die Inferenzgeschwindigkeit.

Das obige ist der detaillierte Inhalt vonWie kann OctopusV3 mit weniger als 1 Milliarde Parametern mit GPT-4V und GPT-4 verglichen werden?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1383

1383

52

52

„Defect Spectrum' durchbricht die Grenzen der herkömmlichen Fehlererkennung und erreicht erstmals eine hochpräzise und umfassende semantische Fehlererkennung in der Industrie.

Jul 26, 2024 pm 05:38 PM

„Defect Spectrum' durchbricht die Grenzen der herkömmlichen Fehlererkennung und erreicht erstmals eine hochpräzise und umfassende semantische Fehlererkennung in der Industrie.

Jul 26, 2024 pm 05:38 PM

In der modernen Fertigung ist die genaue Fehlererkennung nicht nur der Schlüssel zur Sicherstellung der Produktqualität, sondern auch der Kern für die Verbesserung der Produktionseffizienz. Allerdings mangelt es vorhandenen Datensätzen zur Fehlererkennung häufig an der Genauigkeit und dem semantischen Reichtum, die für praktische Anwendungen erforderlich sind, was dazu führt, dass Modelle bestimmte Fehlerkategorien oder -orte nicht identifizieren können. Um dieses Problem zu lösen, hat ein Spitzenforschungsteam bestehend aus der Hong Kong University of Science and Technology Guangzhou und Simou Technology innovativ den „DefectSpectrum“-Datensatz entwickelt, der eine detaillierte und semantisch reichhaltige groß angelegte Annotation von Industriedefekten ermöglicht. Wie in Tabelle 1 gezeigt, bietet der Datensatz „DefectSpectrum“ im Vergleich zu anderen Industriedatensätzen die meisten Fehleranmerkungen (5438 Fehlerproben) und die detaillierteste Fehlerklassifizierung (125 Fehlerkategorien).

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Die offene LLM-Community ist eine Ära, in der hundert Blumen blühen und konkurrieren. Sie können Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 und viele andere sehen hervorragende Darsteller. Allerdings weisen offene Modelle im Vergleich zu den proprietären Großmodellen GPT-4-Turbo in vielen Bereichen noch erhebliche Lücken auf. Zusätzlich zu allgemeinen Modellen wurden einige offene Modelle entwickelt, die sich auf Schlüsselbereiche spezialisieren, wie etwa DeepSeek-Coder-V2 für Programmierung und Mathematik und InternVL für visuelle Sprachaufgaben.

Training mit Millionen von Kristalldaten zur Lösung kristallographischer Phasenprobleme, die Deep-Learning-Methode PhAI wird in Science veröffentlicht

Aug 08, 2024 pm 09:22 PM

Training mit Millionen von Kristalldaten zur Lösung kristallographischer Phasenprobleme, die Deep-Learning-Methode PhAI wird in Science veröffentlicht

Aug 08, 2024 pm 09:22 PM

Herausgeber |KX Bis heute sind die durch die Kristallographie ermittelten Strukturdetails und Präzision, von einfachen Metallen bis hin zu großen Membranproteinen, mit keiner anderen Methode zu erreichen. Die größte Herausforderung, das sogenannte Phasenproblem, bleibt jedoch die Gewinnung von Phaseninformationen aus experimentell bestimmten Amplituden. Forscher der Universität Kopenhagen in Dänemark haben eine Deep-Learning-Methode namens PhAI entwickelt, um Kristallphasenprobleme zu lösen. Ein Deep-Learning-Neuronales Netzwerk, das mithilfe von Millionen künstlicher Kristallstrukturen und den entsprechenden synthetischen Beugungsdaten trainiert wird, kann genaue Elektronendichtekarten erstellen. Die Studie zeigt, dass diese Deep-Learning-basierte Ab-initio-Strukturlösungsmethode das Phasenproblem mit einer Auflösung von nur 2 Angström lösen kann, was nur 10 bis 20 % der bei atomarer Auflösung verfügbaren Daten im Vergleich zur herkömmlichen Ab-initio-Berechnung entspricht

Google AI gewann die Silbermedaille der IMO Mathematical Olympiad, das mathematische Argumentationsmodell AlphaProof wurde eingeführt und Reinforcement Learning ist zurück

Jul 26, 2024 pm 02:40 PM

Google AI gewann die Silbermedaille der IMO Mathematical Olympiad, das mathematische Argumentationsmodell AlphaProof wurde eingeführt und Reinforcement Learning ist zurück

Jul 26, 2024 pm 02:40 PM

Für KI ist die Mathematikolympiade kein Problem mehr. Am Donnerstag hat die künstliche Intelligenz von Google DeepMind eine Meisterleistung vollbracht: Sie nutzte KI, um meiner Meinung nach die eigentliche Frage der diesjährigen Internationalen Mathematikolympiade zu lösen, und war nur einen Schritt davon entfernt, die Goldmedaille zu gewinnen. Der IMO-Wettbewerb, der gerade letzte Woche zu Ende ging, hatte sechs Fragen zu Algebra, Kombinatorik, Geometrie und Zahlentheorie. Das von Google vorgeschlagene hybride KI-System beantwortete vier Fragen richtig und erzielte 28 Punkte und erreichte damit die Silbermedaillenstufe. Anfang dieses Monats hatte der UCLA-Professor Terence Tao gerade die KI-Mathematische Olympiade (AIMO Progress Award) mit einem Millionenpreis gefördert. Unerwarteterweise hatte sich das Niveau der KI-Problemlösung vor Juli auf dieses Niveau verbessert. Beantworten Sie die Fragen meiner Meinung nach gleichzeitig. Am schwierigsten ist es meiner Meinung nach, da sie die längste Geschichte, den größten Umfang und die negativsten Fragen haben

Der Standpunkt der Natur: Die Erprobung künstlicher Intelligenz in der Medizin ist im Chaos. Was ist zu tun?

Aug 22, 2024 pm 04:37 PM

Der Standpunkt der Natur: Die Erprobung künstlicher Intelligenz in der Medizin ist im Chaos. Was ist zu tun?

Aug 22, 2024 pm 04:37 PM

Herausgeber | ScienceAI Basierend auf begrenzten klinischen Daten wurden Hunderte medizinischer Algorithmen genehmigt. Wissenschaftler diskutieren darüber, wer die Werkzeuge testen soll und wie dies am besten geschieht. Devin Singh wurde Zeuge, wie ein pädiatrischer Patient in der Notaufnahme einen Herzstillstand erlitt, während er lange auf eine Behandlung wartete, was ihn dazu veranlasste, den Einsatz von KI zu erforschen, um Wartezeiten zu verkürzen. Mithilfe von Triage-Daten aus den Notaufnahmen von SickKids erstellten Singh und Kollegen eine Reihe von KI-Modellen, um mögliche Diagnosen zu stellen und Tests zu empfehlen. Eine Studie zeigte, dass diese Modelle die Zahl der Arztbesuche um 22,3 % verkürzen können und die Verarbeitung der Ergebnisse pro Patient, der einen medizinischen Test benötigt, um fast drei Stunden beschleunigt. Der Erfolg von Algorithmen der künstlichen Intelligenz in der Forschung bestätigt dies jedoch nur

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

PRO |. Warum verdienen große Modelle, die auf MoE basieren, mehr Aufmerksamkeit?

Aug 07, 2024 pm 07:08 PM

PRO |. Warum verdienen große Modelle, die auf MoE basieren, mehr Aufmerksamkeit?

Aug 07, 2024 pm 07:08 PM

Im Jahr 2023 entwickeln sich fast alle Bereiche der KI in beispielloser Geschwindigkeit weiter. Gleichzeitig verschiebt die KI ständig die technologischen Grenzen wichtiger Bereiche wie der verkörperten Intelligenz und des autonomen Fahrens. Wird der Status von Transformer als Mainstream-Architektur großer KI-Modelle durch den multimodalen Trend erschüttert? Warum ist die Erforschung großer Modelle auf Basis der MoE-Architektur (Mixture of Experts) zu einem neuen Trend in der Branche geworden? Können Large Vision Models (LVM) ein neuer Durchbruch im allgemeinen Sehvermögen sein? ...Aus dem PRO-Mitglieder-Newsletter 2023 dieser Website, der in den letzten sechs Monaten veröffentlicht wurde, haben wir 10 spezielle Interpretationen ausgewählt, die eine detaillierte Analyse der technologischen Trends und industriellen Veränderungen in den oben genannten Bereichen bieten, um Ihnen dabei zu helfen, Ihre Ziele in der Zukunft zu erreichen Jahr vorbereitet sein. Diese Interpretation stammt aus Week50 2023

Identifizieren Sie automatisch die besten Moleküle und reduzieren Sie die Synthesekosten. Das MIT entwickelt ein Algorithmus-Framework für die Entscheidungsfindung im molekularen Design

Jun 22, 2024 am 06:43 AM

Identifizieren Sie automatisch die besten Moleküle und reduzieren Sie die Synthesekosten. Das MIT entwickelt ein Algorithmus-Framework für die Entscheidungsfindung im molekularen Design

Jun 22, 2024 am 06:43 AM

Herausgeber |. Der Einsatz von Ziluo AI bei der Rationalisierung der Arzneimittelforschung nimmt explosionsartig zu. Durchsuchen Sie Milliarden von Kandidatenmolekülen nach solchen, die möglicherweise über Eigenschaften verfügen, die für die Entwicklung neuer Medikamente erforderlich sind. Es sind so viele Variablen zu berücksichtigen, von Materialpreisen bis hin zum Fehlerrisiko, dass es keine leichte Aufgabe ist, die Kosten für die Synthese der besten Kandidatenmoleküle abzuwägen, selbst wenn Wissenschaftler KI einsetzen. Hier entwickelten MIT-Forscher SPARROW, ein quantitatives Entscheidungsalgorithmus-Framework, um automatisch die besten molekularen Kandidaten zu identifizieren und so die Synthesekosten zu minimieren und gleichzeitig die Wahrscheinlichkeit zu maximieren, dass die Kandidaten die gewünschten Eigenschaften aufweisen. Der Algorithmus bestimmte auch die Materialien und experimentellen Schritte, die zur Synthese dieser Moleküle erforderlich sind. SPARROW berücksichtigt die Kosten für die gleichzeitige Synthese einer Charge von Molekülen, da häufig mehrere Kandidatenmoleküle verfügbar sind