Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wird es im Jahr 2024 in China erhebliche Durchbrüche und Fortschritte beim durchgängigen autonomen Fahren geben?

Wird es im Jahr 2024 in China erhebliche Durchbrüche und Fortschritte beim durchgängigen autonomen Fahren geben?

Wird es im Jahr 2024 in China erhebliche Durchbrüche und Fortschritte beim durchgängigen autonomen Fahren geben?

Nicht jeder kann verstehen, dass der Tesla V12 in Nordamerika weithin beworben wurde und aufgrund seiner hervorragenden Leistung immer mehr Anerkennung bei den Benutzern erlangt hat. Auch das durchgängig autonome Fahren ist zu der technischen Richtung geworden, die allen am meisten am Herzen liegt die Branche des autonomen Fahrens. Kürzlich hatte ich die Gelegenheit, mich mit erstklassigen Ingenieuren, Produktmanagern, Investoren und Medienleuten aus vielen Branchen auszutauschen. Ich habe festgestellt, dass jeder sehr an einem durchgängigen autonomen Fahren interessiert ist, aber in einigen Fällen sogar Grundverständnis des durchgängigen autonomen Fahrens. Es gibt immer noch solche Missverständnisse. Als jemand, der das Glück hatte, die Stadtfunktion mit und ohne Bilder einer inländischen First-Tier-Marke sowie die beiden Versionen von FSD V11 und V12 zu erleben, möchte ich hier auf der Grundlage meiner Erfahrungen über einige aktuelle Entwicklungen sprechen Beruflicher Hintergrund und Verfolgung des Fortschritts von Tesla FSD im Laufe der Jahre. In dieser Phase sprachen alle über häufige Missverständnisse über durchgängiges autonomes Fahren und gaben meine eigene Interpretation dieser Probleme.

Zweifel 1: Können eine durchgängige Wahrnehmung und eine durchgängige Entscheidungsfindung und Planung als durchgängiges autonomes Fahren gezählt werden?

Alle Schritte von der Sensoreingabe über die Planung bis hin zur Steuersignalausgabe sind durchgängig ableitbar, sodass das gesamte System durch Gradientenabstiegstraining und Gradienten-Backpropagation während des Modelltrainings als großes Modell trainiert werden kann werden in allen Aspekten des Modells von der Eingabe bis zur Ausgabe aktualisiert und optimiert, sodass das Fahrverhalten des gesamten Systems für die vom Benutzer direkt wahrgenommene Fahrentscheidungstrajektorie optimiert werden kann. Kürzlich haben einige Freunde behauptet, dass es sich bei der Förderung des durchgängigen autonomen Fahrens um eine End-to-End-Erkennung oder End-to-End-Entscheidungsfindung handelt. Tatsächlich denke ich, dass beides nicht als End-to-End-Entscheidungsfindung gezählt werden kann. Das Ende des autonomen Fahrens kann jedoch nur als durchgängiges autonomes Fahren angesehen werden. Es wird als reine datengesteuerte Wahrnehmung und reine datengesteuerte Entscheidungsplanung bezeichnet.

Einige treffen Entscheidungen möglicherweise auf der Grundlage eines bestimmten Modells in Kombination mit einer Hybridstrategie aus herkömmlichen Methoden zur Optimierung der Sicherheitsprüfsummen-Trajektorie, auch bekannt als End-to-End-Planung. Darüber hinaus glauben einige Leute, dass Tesla V12 kein rein genaues Modellausgangssteuersignal ist, sondern eine Hybridstrategie, die einige Regelmethoden kombiniert. Laut dem berühmten Green auf http://X.com hat er vor einiger Zeit einen Tweet gepostet, in dem er sagte, dass der Code der Regeln immer noch im V12-Technologie-Stack zu finden sei. Mein Verständnis davon ist, dass der von Green entdeckte Code wahrscheinlich der V11-Versionscode ist, der vom V12-Hochgeschwindigkeitstechnologie-Stack beibehalten wird, da wir wissen, dass V12 derzeit tatsächlich nur den ursprünglichen City-Technologie-Stack durch End-to-End ersetzt. und die Hochgeschwindigkeitslösung verwendet weiterhin die V11-Lösung. Das Auffinden einiger Fragmente regulären Codes im entschlüsselten Code bedeutet also nicht, dass V12 falsch „End-to-End“ ist, aber es ist wahrscheinlich, dass der gefundene Code Hochgeschwindigkeitscode ist Code. Tatsächlich können wir am AI+Day im Jahr 2022 erkennen, dass es sich bei V11 und den Vorgängerversionen bereits um Hybridlösungen handelt. Wenn es sich bei V12 also nicht direkt um ein vollständiges Modell handelt, wird sich die Lösung nicht wesentlich von den Vorgängerversionen unterscheiden. Auf diese Weise gibt es keine vernünftige Erklärung für den Leistungssprung des V12. Informationen zu Teslas früheren Plänen finden Sie in meiner Interpretation von EatElephant am AI+Day: Tesla AI Day 2022 – Interpretation der Weltwörter: Er rief die selbstfahrende Frühlingsfest-Gala, ein dezentrales Forschungs- und Entwicklungsteam, auf und ist bestrebt, sich in ein zu verwandeln KI-Technologieunternehmen.

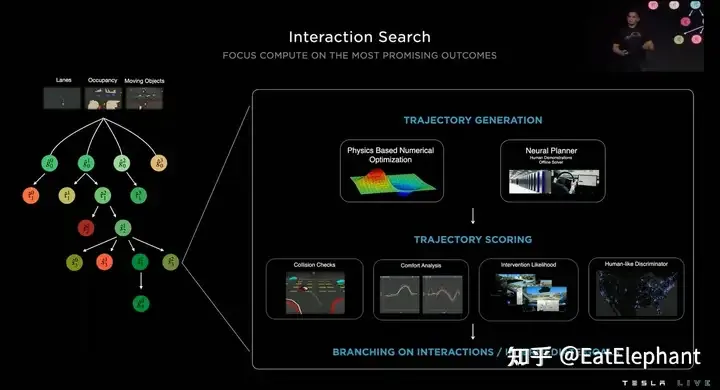

Nach dem KI-Tag 2022 zu urteilen, ist V11 bereits eine Planungslösung, die mit NN Planner gemischt ist

Im Allgemeinen ist es einmal die Regel, ob es sich um Wahrnehmungsnachbearbeitungscode, Regelkandidaten-Trajektorienbewertung oder sogar Sicherheitstaschenstrategien handelt Wenn Code eingeführt wird und es einen If-Else-Zweig gibt, wird die stabile Übertragung des gesamten Systems abgeschnitten, wodurch auch der größte Vorteil des End-to-End-Systems verloren geht, um durch Training eine globale Optimierung zu erreichen.

Zweifel 2: Ist End-to-End eine Neuerfindung der bisherigen Technologie?

Ein weiteres häufiges Missverständnis ist, dass End-to-End darin besteht, die zuvor angesammelte Technologie zu stürzen und umfassende neue Technologieinnovationen durchzuführen, und viele Leute denken, dass Tesla gerade erst den Benutzerschub des End-to-End-Systems für autonomes Fahren erreicht hat Andere Hersteller können es überhaupt nicht implementieren. Es besteht keine Notwendigkeit, den ursprünglichen modularen Technologiestapel für Wahrnehmung, Vorhersage und Planung zu durchlaufen. Stattdessen können wir lernen von den Vorteilen der Nachzügler, um Tesla schnell einzuholen oder sogar zu übertreffen. Es stimmt, dass die Verwendung eines großen Modells zur Vervollständigung der Zuordnung von Sensoreingaben bis hin zu Planungssteuersignalen der gründlichste End-to-End-Ansatz ist. Auch Unternehmen haben seit langem ähnliche Methoden ausprobiert, beispielsweise Nvidias DAVE-2 und Wayve haben ähnliche Methoden verwendet. Diese umfassende End-to-End-Technologie ähnelt in der Tat eher einer Black Box und ist schwierig zu debuggen und iterativ zu optimieren. Da es sich bei Sensoreingangssignalen wie Bildern und Punktwolken gleichzeitig um sehr hochdimensionale Eingaberäume handelt, werden Steuersignale ausgegeben B. Lenkradwinkel und Drosselklappensteuerung. Das bewegliche Pedal ist ein relativ kleindimensionaler Ausgaberaum, der für tatsächliche Fahrzeugtests völlig unbrauchbar ist.

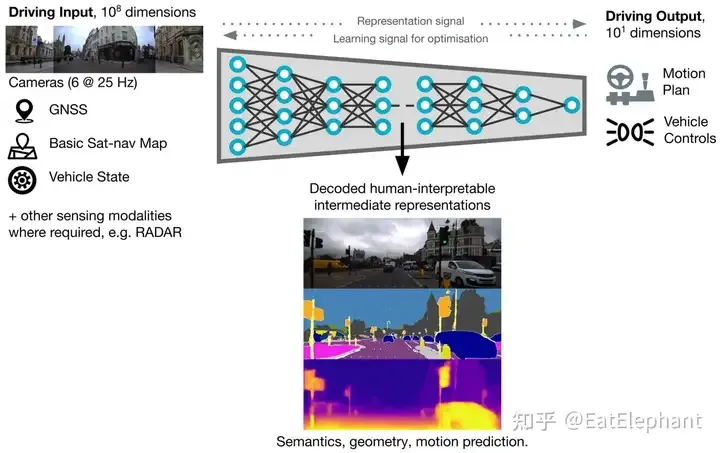

Das umfassende End-to-End-System verwendet auch einige allgemeine Hilfsaufgaben wie semantische Segmentierung und Tiefenschätzung, um die Modellkonvergenz und das Debugging zu unterstützen

Der FSD V12, den wir gesehen haben, behält also tatsächlich fast alle vorherigen Visualisierungsinhalte bei, was zeigt, dass FSD V12 durchgängig auf der ursprünglichen Grundlage für starke Wahrnehmung trainiert wurde und die FSD-Iteration ab Oktober 2020 nicht aufgegeben wurde. Im Gegenteil , es ist eine solide technische Grundlage für V12 geworden. Andrej Karparthy hat bereits zuvor ähnliche Fragen beantwortet. Obwohl er nicht an der Entwicklung von V12 beteiligt war, glaubt er, dass die gesamte bisherige Technologieakkumulation nicht aufgegeben wurde, sondern lediglich von der Front in den Hintergrund verlagert wurde. Daher wird die End-to-End-Navigation schrittweise auf der Grundlage der ursprünglichen Technologie realisiert, indem Teile des Regelcodes Schritt für Schritt entfernt werden.

V12 behält fast alle Wahrnehmungen von FSD bei und löscht nur begrenzte visuelle Inhalte wie Kegelfässer.

Zweifel 3: Kann das End-to-End in wissenschaftlichen Arbeiten auf tatsächliche Produkte übertragen werden?

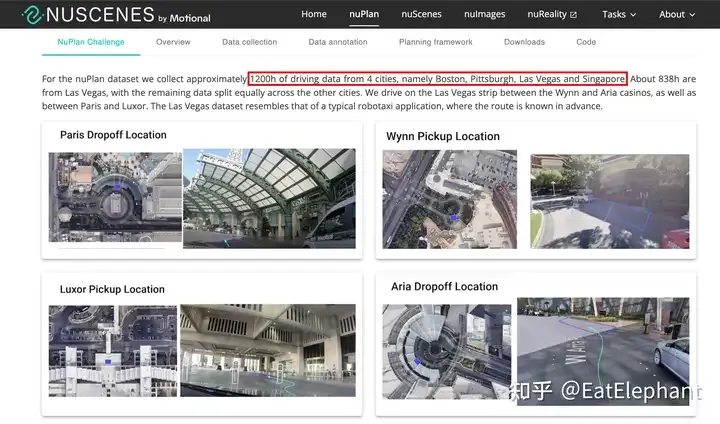

Die Auszeichnung von UniAD als CVPR Best Paper 2023 spiegelt zweifellos die hohen Erwartungen der akademischen Gemeinschaft an durchgängige autonome Fahrsysteme wider. Seit Tesla im Jahr 2021 die Innovation seiner visuellen BEV-Wahrnehmungstechnologie eingeführt hat, hat die inländische akademische Gemeinschaft viel Begeisterung in die autonome Fahr-BEV-Wahrnehmung investiert und eine Reihe von Studien ins Leben gerufen, die die Leistungsoptimierung und den Implementierungseinsatz von BEV-Methoden fördern. Kann End-to-End einem ähnlichen Weg folgen, der von der Wissenschaft vorangetrieben und von der Industrie verfolgt wird, um die schnelle iterative Implementierung der End-to-End-Technologie in Produkten zu fördern? Ich denke, es ist relativ schwierig. Erstens handelt es sich bei der BEV-Erkennung immer noch um eine relativ modulare Technologie, eher auf Algorithmusebene, und die Leistung auf Einstiegsebene erfordert kein so großes Datenvolumen. Die Einführung des hochwertigen akademischen Open-Source-Datensatzes Nuscenes bietet einen praktischen Vorläufer Bei vielen BEV-Forschungen ist die auf Nuscenes iterierte BEV-Sensorlösung zwar nicht in der Lage, die Leistungsanforderungen auf Produktebene zu erfüllen, sie ist jedoch als Proof of Concept und Modellauswahl von großem Referenzwert. Allerdings mangelt es der Wissenschaft an umfassend verfügbaren End-to-End-Daten. Der größte Nuplan-Datensatz enthält derzeit 1.200 Stunden reale Fahrzeugerfassungsdaten in 4 Städten. Bei einer Finanzberichtssitzung im Jahr 2023 sagte Musk jedoch, dass „1 Million Videofälle trainiert wurden.“ es kann kaum noch funktionieren.“ ; 2 Millionen, es ist etwas besser; 3 Millionen, Sie werden das Gefühl haben, Wow; wenn es 10 Millionen erreicht, wird seine Leistung unglaublich.“ Die Autopilot-Rückgabedaten von Tesla werden im Allgemeinen als 1-Minuten-Segment betrachtet, sodass der Einstiegsfall mit 1 Million Videos etwa 16.000 Stunden beträgt, was mindestens eine Größenordnung mehr ist als der größte akademische Datensatz. Dies sollte hier beachtet werden Da Nuplan kontinuierlich Daten sammelt, gibt es in den Daten schwerwiegende Mängel in der Verteilung und Vielfalt. Bei den meisten Daten handelt es sich um einfache Szenen, was bedeutet, dass die Verwendung akademischer Datensätze wie Nuplan nicht einmal eine Version erhalten kann, die kaum in den Zug gelangen kann.

Der Nuplan-Datensatz ist bereits ein sehr umfangreicher akademischer Datensatz, aber die Erkundung als End-to-End-Lösung reicht möglicherweise nicht aus

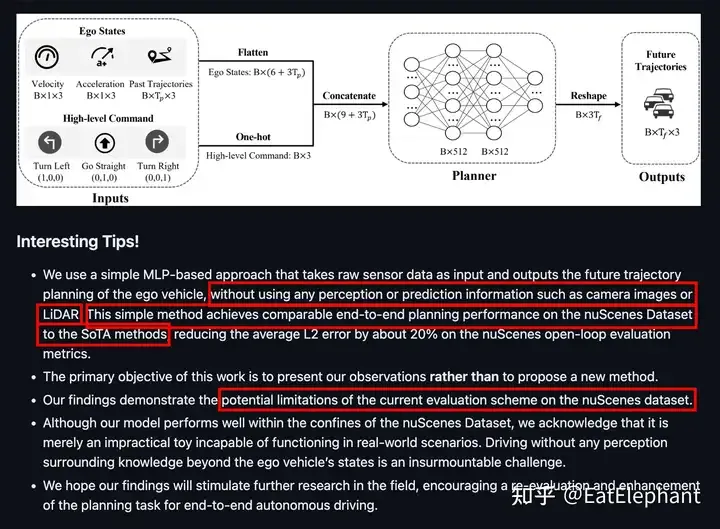

Wir sehen also die überwiegende Mehrheit der End-to-End-Autonomie Fahren einschließlich UniAD Keine der Lösungen kann auf einem realen Fahrzeug ausgeführt werden, und wir können nur auf die Open-Loop-Bewertung als nächstbeste Option zurückgreifen. Die Zuverlässigkeit von Open-Loop-Bewertungsindikatoren ist sehr gering, da die Open-Loop-Bewertung das Problem der Modellverwirrung und Ursache-Wirkung nicht identifizieren kann. Selbst wenn das Modell nur lernt, die historische Pfadextrapolation zu verwenden, kann es eine sehr gute Open-Loop-Bewertung erzielen Indikatoren, aber ein solches Modell ist völlig nicht verfügbar. Im Jahr 2023 veröffentlichte Baidu einmal ein Papier mit dem Titel AD-MLP (https://arxiv.org/pdf/2305.10430), um die Mängel von Open-Loop-Planungsbewertungsindikatoren zu diskutieren Das Papier verwendet nur historische Informationen, ohne irgendwelche Erkenntnisse einzuführen, und hat sehr gute Open-Loop-Bewertungsindikatoren erhalten, sogar in der Nähe einiger aktueller SOTA-Arbeiten. Es ist jedoch offensichtlich, dass niemand ein Auto mit geschlossenen Augen fahren kann!

AD MLP erzielt gute Open-Loop-Indikatoren, indem es sich nicht auf sensorische Eingaben verlässt. Dies zeigt, dass die Verwendung von Open-Loop-Indikatoren als Referenz von geringer praktischer Bedeutung ist Open-Loop-Nachahmungslernen? Zumindest derzeit verlässt sich die akademische Gemeinschaft bei der durchgängigen Forschung und Entwicklung im Allgemeinen auf das Closed-Loop-Simulationssystem CARLA, doch auch die von CARLA auf Basis von Game-Engines gewonnenen Modelle lassen sich nur schwer auf die reale Welt übertragen.

Zweifel 4: Ist durchgängiges autonomes Fahren nur eine Algorithmus-Innovation?

Letztendlich ist End-to-End nicht nur ein neuer Algorithmus. Die Modelle verschiedener Module des modularen autonomen Fahrsystems können mithilfe der Daten ihrer jeweiligen Aufgaben iterativ separat trainiert werden. Allerdings wird jede Funktion des End-to-End-Systems gleichzeitig trainiert, was die Trainingsdaten erfordert Äußerst konsistent und alle Teilaufgabenbezeichnungen müssen korrekt sein. Sobald eine Aufgabenbezeichnung fehlschlägt, wird es schwierig, diese Daten in der End-to-End-Trainingsaufgabe zu verwenden Rate und Leistung der automatischen Etikettierungspipeline. Zweitens erfordert das End-to-End-System, dass alle Module ein hohes Leistungsniveau erreichen, um bessere Ergebnisse bei End-to-End-Entscheidungs- und Planungsausgabeaufgaben zu erzielen. Daher wird allgemein angenommen, dass die Datenschwelle von Das End-to-End-System ist viel höher als die Daten jedes einzelnen Moduls, und der Datenschwellenwert ist nicht nur die Anforderung an die absolute Menge, sondern auch an die Verteilung und Vielfalt der Daten Sie haben die vollständige Kontrolle über das Fahrzeug und müssen sich auf mehrere Lieferanten mit Kunden unterschiedlicher Modelle einstellen. Bei der Entwicklung eines End-to-End-Systems kann es zu größeren Schwierigkeiten kommen. Was die Rechenleistung angeht, erklärte Musk Anfang März dieses Jahres auf X.com, dass der größte limitierende Faktor von FSD die Rechenleistung sei. Kürzlich sagte Boss Ma, dass sich ihr Rechenleistungsproblem fast gleichzeitig verbessert habe Auf der Finanzberichtssitzung zum ersten Quartal 2024 gab Tesla bekannt, dass das Unternehmen nun über 35.000 H100-Rechenressourcen verfügt und dass diese Zahl bis Ende 2024 85.000 erreichen wird. Es besteht kein Zweifel, dass Tesla über sehr leistungsstarke Möglichkeiten zur Optimierung der Rechenleistung verfügt, was bedeutet, dass, um das aktuelle Niveau von FSD V12 zu erreichen, mit hoher Wahrscheinlichkeit 35.000 H100 und Milliarden von Dollar an Infrastrukturinvestitionen erforderlich sind nicht so effizient wie Tesla, dann kann dieser Schwellenwert noch weiter angehoben werden.

Anfang März sagte Musk, dass der wichtigste limitierende Faktor bei der Iteration von FSD die Rechenleistung sei

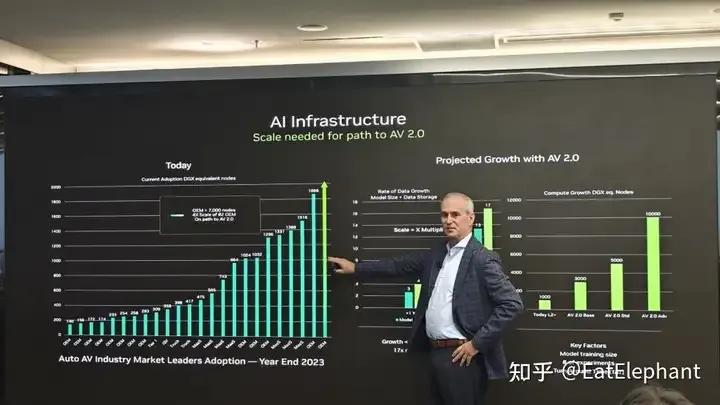

Auch auf http:/ / Tesla ist im Histogramm völlig überwältigend. (Der grüne Pfeil ganz rechts im linken Bild, der Text in der Mitte erklärt, dass die Anzahl der NV-Grafikkarten im Besitz des OEM Nr. 1 > 7.000 DGX-Knoten beträgt. Dieser OEM ist Offensichtlich wird Tesla mit 8 Karten berechnet, 23 Bis Ende des Jahres wird Tesla wahrscheinlich mehr als 56.000 A100-Grafikkarten haben, was mehr als viermal mehr ist als der zweitplatzierte OEM In Kombination mit der restriktiven US-Politik beim Export chinesischer Grafikkarten wird es noch schwieriger, diese Rechenleistung einzuholen.

Norm Marks hat intern einen Screenshot geteilt, Quelle: Wie man Probleme so früh wie möglich erkennt, datengesteuert löst und schnell iteriert, wenn Regelcodes nicht verwendet werden können, ist derzeit für die meisten Autonomen eine unbekannte Herausforderung Führung von F&E-Teams.

Das letzte Ende ist immer noch eine organisatorische Änderung für das aktuelle Forschungs- und Entwicklungsteam für autonomes Fahren, da die Organisationsstruktur der meisten autonomen Fahrteams seit L4 autonomes Fahren modular ist und nicht nur in Wahrnehmungsgruppe, Vorhersagegruppe usw. unterteilt ist. Die Positionierungsgruppe, die Planungskontrollgruppe und sogar die Wahrnehmungsgruppe sind in visuelle Wahrnehmung, Laserwahrnehmung usw. unterteilt. Die durchgängige technische Architektur beseitigt direkt die Schnittstellenbarrieren zwischen verschiedenen Modulen, sodass das durchgängige Forschungs- und Entwicklungsteam alle Humanressourcen integrieren muss, um sich an das neue Technologieparadigma anzupassen. Dies stellt eine große Herausforderung für die unflexible Teamorganisation dar Kultur.

Das obige ist der detaillierte Inhalt vonWird es im Jahr 2024 in China erhebliche Durchbrüche und Fortschritte beim durchgängigen autonomen Fahren geben?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und persönliches Verständnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gaußkurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die hauptsächlich ein implizites koordinatenbasiertes Modell verwendet, um räumliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-Fähigkeiten, sondern führt auch ein beispielloses Maß an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der nächsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen Überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Persönliches Verständnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies ermöglicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fußgängern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit große Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschließlich ihrer Standorte, genau wahrnehmen und beschreiben kann.

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Der erste Pilot- und Schlüsselartikel stellt hauptsächlich mehrere häufig verwendete Koordinatensysteme in der autonomen Fahrtechnologie vor und erläutert, wie die Korrelation und Konvertierung zwischen ihnen abgeschlossen und schließlich ein einheitliches Umgebungsmodell erstellt werden kann. Der Schwerpunkt liegt hier auf dem Verständnis der Umrechnung vom Fahrzeug in den starren Kamerakörper (externe Parameter), der Kamera-in-Bild-Konvertierung (interne Parameter) und der Bild-in-Pixel-Einheitenkonvertierung. Die Konvertierung von 3D in 2D führt zu entsprechenden Verzerrungen, Verschiebungen usw. Wichtige Punkte: Das Fahrzeugkoordinatensystem und das Kamerakörperkoordinatensystem müssen neu geschrieben werden: Das Ebenenkoordinatensystem und das Pixelkoordinatensystem. Schwierigkeit: Sowohl die Entzerrung als auch die Verzerrungsaddition müssen auf der Bildebene kompensiert werden. 2. Einführung Insgesamt gibt es vier visuelle Systeme Koordinatensystem: Pixelebenenkoordinatensystem (u, v), Bildkoordinatensystem (x, y), Kamerakoordinatensystem () und Weltkoordinatensystem (). Es gibt eine Beziehung zwischen jedem Koordinatensystem,

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schlägt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herkömmlichen Agent-Cent

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt