Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

LLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version)

LLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version)

LLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version)

Vorab geschrieben und das persönliche Verständnis des Autors

Dieses Papier widmet sich der Lösung der wichtigsten Herausforderungen aktueller multimodaler großer Sprachmodelle (MLLMs) in autonomen Fahranwendungen, d. h. der Erweiterung von MLLMs vom 2D-Verständnis auf den 3D-Raum Frage. Diese Erweiterung ist besonders wichtig, da autonome Fahrzeuge (AVs) genaue Entscheidungen über 3D-Umgebungen treffen müssen. Das räumliche 3D-Verständnis ist für AVs von entscheidender Bedeutung, da es sich direkt auf die Fähigkeit des Fahrzeugs auswirkt, fundierte Entscheidungen zu treffen, zukünftige Zustände vorherzusagen und sicher mit der Umgebung zu interagieren.

Aktuelle multimodale große Sprachmodelle (wie LLaVA-1.5) können aufgrund von Auflösungsbeschränkungen des visuellen Encoders und LLM-Sequenzlängenbeschränkungen normalerweise nur Bildeingaben mit niedrigerer Auflösung verarbeiten (z. B.). Allerdings erfordern autonome Fahranwendungen einen hochauflösenden Multi-View-Videoeingang, um sicherzustellen, dass Fahrzeuge die Umgebung wahrnehmen und über große Entfernungen sichere Entscheidungen treffen können. Darüber hinaus haben viele bestehende 2D-Modellarchitekturen Schwierigkeiten, diese Eingaben effizient zu verarbeiten, da sie umfangreiche Rechen- und Speicherressourcen erfordern. Um diese Probleme anzugehen, arbeiten Forscher an der Entwicklung neuer Modellarchitekturen und Speicherressourcen.

In diesem Zusammenhang schlägt dieses Papier eine neue 3D-MLLM-Architektur vor, die auf dem Design im Q-Former-Stil basiert. Die Architektur verwendet einen Cross-Attention-Decoder, um hochauflösende visuelle Informationen in spärliche Abfragen zu komprimieren und so die Skalierung auf hochauflösende Eingaben zu erleichtern. Diese Architektur weist Ähnlichkeiten mit Familien von Ansichtsmodellen wie DETR3D, PETR(v2), StreamPETR und Far3D auf, da sie alle spärliche 3D-Abfragemechanismen nutzen. Durch das Anhängen einer 3D-Positionskodierung an diese Abfragen und die Interaktion mit Multi-View-Eingaben erreicht unsere Architektur ein räumliches 3D-Verständnis und nutzt dadurch vorab trainiertes Wissen in 2D-Bildern besser.

Zusätzlich zur Innovation der Modellarchitektur schlägt dieser Artikel auch anspruchsvollere Benchmark-OmniDrive-nuScenes vor. Der Benchmark deckt eine Reihe komplexer Aufgaben ab, die ein 3D-Raumverständnis und weitreichendes Denken erfordern, und führt einen Benchmark für kontrafaktisches Denken ein, um Ergebnisse durch Simulation von Lösungen und Trajektorien zu bewerten. Dieser Benchmark kompensiert effektiv das Problem der Bevorzugung eines einzelnen Expertenverlaufs in aktuellen offenen Bewertungen und vermeidet so eine Überanpassung an Expertenverläufe.

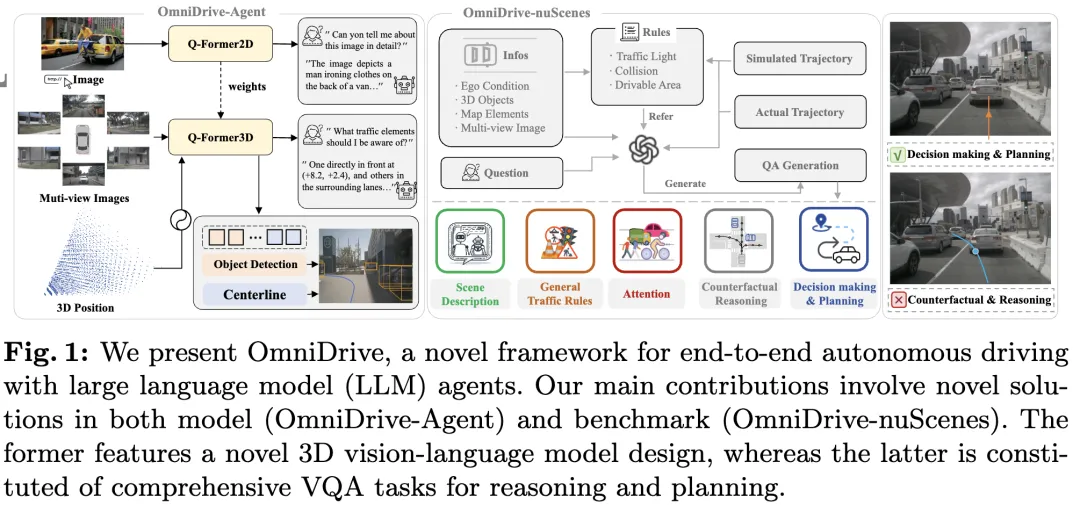

In diesem Artikel wird OmniDrive vorgestellt, ein umfassendes End-to-End-Framework für autonomes Fahren, das ein effektives 3D-Argumentations- und Planungsmodell auf Basis des LLM-Agenten bereitstellt und einen anspruchsvolleren Benchmark bildet, der weitere Entwicklungen im Bereich des autonomen Fahrens vorantreibt. Die spezifischen Beiträge sind wie folgt:

- Vorgeschlagene 3D-Q-Former-Architektur geeignet für verschiedene fahrbezogene Aufgaben, einschließlich Zielerkennung, Fahrspurerkennung, visuelle 3D-Positionierung, Entscheidungsfindung und Planung.

- Wir stellen den OmniDrive-nuScenes-Benchmark vor, den ersten QA-Benchmark, der zur Lösung planungsbezogener Herausforderungen entwickelt wurde und genaue 3D-Rauminformationen abdeckt.

- Erzielen Sie die beste Leistung bei Planungsaufgaben.

Detaillierte Erläuterung von OmniDrive

Gesamtstruktur

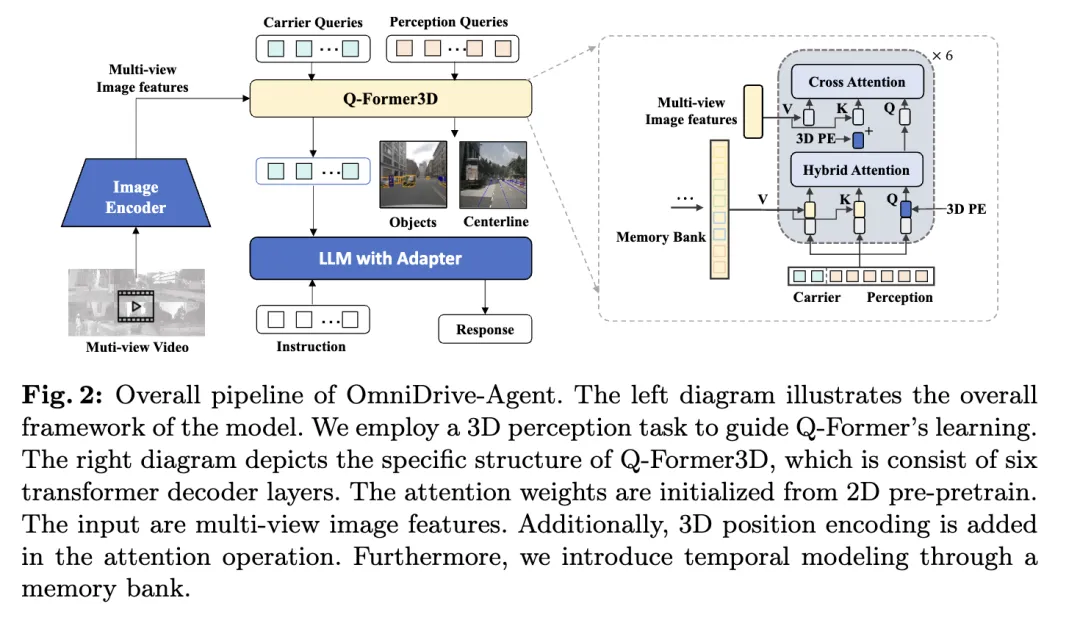

Der in diesem Artikel vorgeschlagene OmniDrive-Agent kombiniert die Vorteile von Q-Former und abfragebasierten 3D-Wahrnehmungsmodellen, um 3D-Rauminformationen effizient in mehreren zu erhalten -Bildfunktionen anzeigen, 3D-Wahrnehmungs- und Planungsaufgaben beim autonomen Fahren lösen. Die Gesamtarchitektur ist in der Abbildung dargestellt.

- Visueller Encoder: Zunächst wird ein gemeinsamer visueller Encoder verwendet, um Bildfunktionen für mehrere Ansichten zu extrahieren.

- Positionskodierung: Die extrahierten Bildmerkmale werden zusammen mit der Positionskodierung in Q-Former3D eingegeben.

- Q-Former3D-Modul: Unter diesen steht für den Spleißvorgang. Der Kürze halber wird in der Formel auf die Positionskodierung verzichtet. Nach diesem Schritt wird die Abfragesammlung zur interagierten . Darunter steht für die 3D-Positionskodierung und ist eine Funktion zur Mehrfachansicht von Bildern.

- Multi-View-Bild-Feature-Sammlung: Als nächstes sammeln diese Abfragen Informationen aus Multi-View-Bildern:

- Abfrageinitialisierung und Selbstaufmerksamkeit: In Q-Former3D werden die Erkennungsabfrage und die Vektorabfrage initialisiert, und Selbstaufmerksamkeitsoperationen werden durchgeführt, um Informationen zwischen ihnen auszutauschen:

- Ausgabeverarbeitung:

- Vorhersage von Wahrnehmungsaufgaben: Vorhersage der Kategorie und Koordinaten von Vordergrundelementen mithilfe von Wahrnehmungsabfragen.

- Trägerabfrageausrichtung und Textgenerierung: Die Trägerabfrage wird über ein einschichtiges MLP an die Dimensionen des LLM-Tokens (z. B. die 4096-Dimension in LLaMA) ausgerichtet und weiter zur Textgenerierung verwendet.

- Die Rolle der Trägerabfrage

Durch dieses Architekturdesign kann OmniDrive-Agent effizient umfangreiche räumliche 3D-Informationen aus Bildern mit mehreren Ansichten abrufen und diese mit LLM zur Textgenerierung kombinieren, um eine 3D-Raumwahrnehmung zu ermöglichen und Autonomes Fahren bietet neue Lösungen.

Multitasking und zeitliche Modellierung

Die Methode des Autors profitiert vom Multitasking-Lernen und der zeitlichen Modellierung. Beim Lernen mit mehreren Aufgaben kann der Autor spezifische Q-Former3D-Module für jede Wahrnehmungsaufgabe integrieren und eine einheitliche Initialisierungsstrategie übernehmen (siehe cref{Training Strategy}). In verschiedenen Aufgaben können Carrier-Anfragen Informationen über verschiedene Verkehrselemente sammeln. Die Implementierung des Autors umfasst Aufgaben wie die Mittellinienkonstruktion und die 3D-Objekterkennung. Während der Trainings- und Inferenzphasen verwenden diese Module dieselbe 3D-Positionskodierung. Unsere Methode bereichert Aufgaben wie die Mittellinienkonstruktion und die 3D-Objekterkennung. Während der Trainings- und Inferenzphasen verwenden diese Module dieselbe 3D-Positionskodierung. Unsere Methode bereichert Aufgaben wie die Mittellinienkonstruktion und die 3D-Objekterkennung. Während der Trainings- und Inferenzphasen verwenden diese Module dieselbe 3D-Positionskodierung.

In Bezug auf die zeitliche Modellierung speichern die Autoren Wahrnehmungsabfragen mit Top-K-Klassifizierungswerten in der Speicherbank und verbreiten sie Frame für Frame. Die propagierte Abfrage interagiert durch Queraufmerksamkeit mit der Wahrnehmungsabfrage und der Trägerabfrage des aktuellen Frames und erweitert dadurch die Verarbeitungsfähigkeiten des Modells für Videoeingaben.

Trainingsstrategie

Die Trainingsstrategie von OmniDrive-Agent ist in zwei Phasen unterteilt: 2D-Vortraining und 3D-Feinabstimmung. In der Anfangsphase haben die Autoren zunächst multimodale große Modelle (MLLMs) für 2D-Bildaufgaben vorab trainiert, um Q-Former- und Vektorabfragen zu initialisieren. Nach dem Entfernen der Erkennungsabfrage kann das OmniDrive-Modell als standardmäßiges visuelles Sprachmodell betrachtet werden, das in der Lage ist, Text basierend auf Bildern zu generieren. Daher nutzte der Autor die Trainingsstrategie und Daten von LLaVA v1.5, um OmniDrive vorab auf 558K-Bild- und Textpaaren zu trainieren. Während des Vortrainings bleiben alle Parameter außer Q-Former eingefroren. Anschließend wurden die MLLMs mithilfe des Befehlsoptimierungsdatensatzes von LLaVA v1.5 feinabgestimmt. Während der Feinabstimmung bleibt der Bildencoder eingefroren und andere Parameter können trainiert werden.

In der 3D-Feinabstimmungsphase besteht das Ziel darin, die 3D-Positionierungsfähigkeiten des Modells zu verbessern und gleichzeitig seine semantischen 2D-Verständnisfähigkeiten so weit wie möglich beizubehalten. Zu diesem Zweck fügte der Autor dem ursprünglichen Q-Former 3D-Positionskodierungs- und Timing-Module hinzu. In dieser Phase verwendet der Autor die LoRA-Technologie, um den visuellen Encoder und das große Sprachmodell mit einer kleinen Lernrate zu optimieren und Q-Former3D mit einer relativ großen Lernrate zu trainieren. In diesen beiden Phasen berücksichtigt die Verlustberechnung von OmniDrive-Agent nur den Textgenerierungsverlust, ohne die kontrastiven Lern- und Matching-Verluste in BLIP-2 zu berücksichtigen.

OmniDrive-nuScenes

Um das Fahren multimodaler großer Modellagenten zu bewerten, schlagen die Autoren OmniDrive-nuScenes vor, einen neuartigen Benchmark, der auf dem nuScenes-Datensatz basiert und hochwertige visuelle Fragenbeantwortung (QA) enthält. Ja, abdeckend Wahrnehmungs-, Argumentations- und Planungsaufgaben im 3D-Bereich.

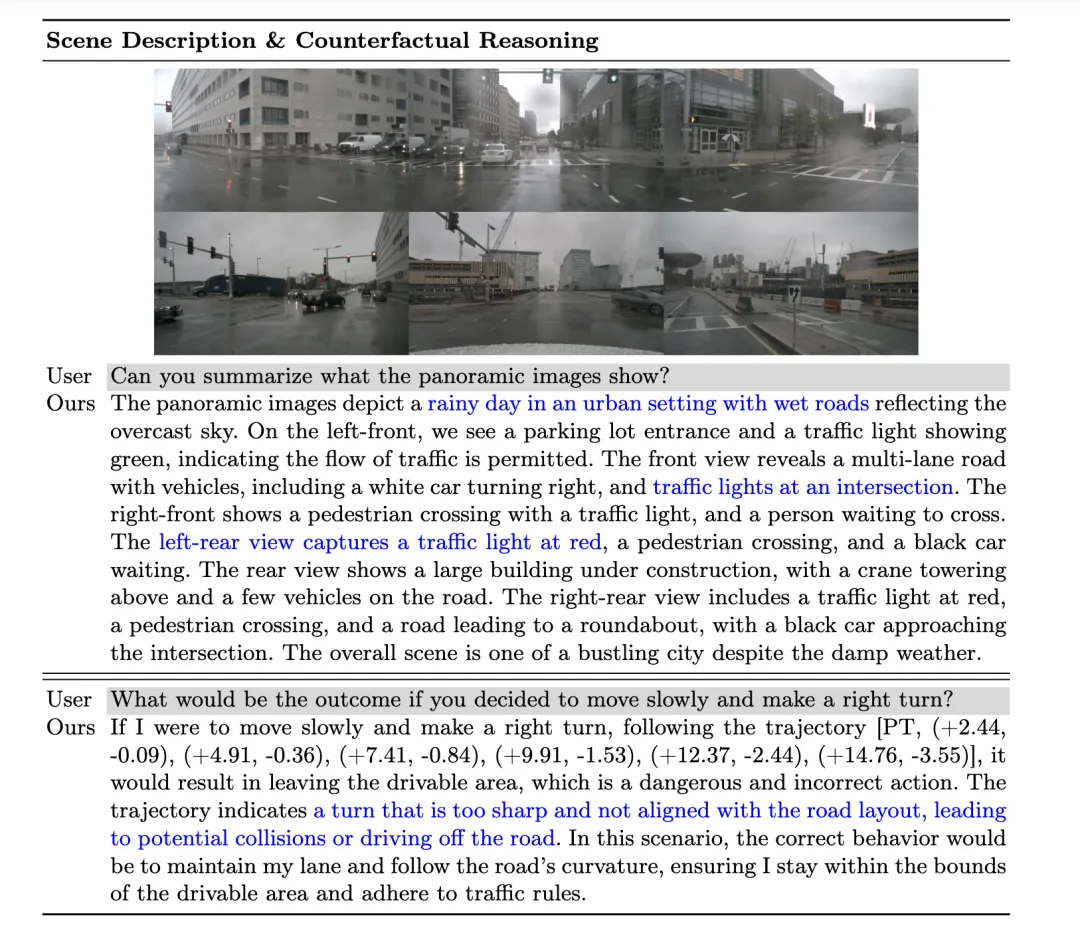

Das Highlight von OmniDrive-nuScenes ist der vollautomatische QA-Generierungsprozess, der GPT-4 zur Generierung von Fragen und Antworten verwendet. Ähnlich wie LLaVA stellt unsere Pipeline 3D-fähige Anmerkungen als Kontextinformationen für GPT-4 bereit. Auf dieser Grundlage nutzt der Autor außerdem Verkehrsregeln und Planungssimulationen als zusätzliche Eingaben, um GPT-4 dabei zu helfen, die 3D-Umgebung besser zu verstehen. Der Benchmark des Autors testet nicht nur die Wahrnehmungs- und Argumentationsfähigkeiten des Modells, sondern fordert auch das tatsächliche räumliche Verständnis und die Planungsfähigkeiten des Modells im 3D-Raum durch langfristige Probleme mit Aufmerksamkeit, kontrafaktischem Denken und Planung im offenen Regelkreis heraus, da diese Probleme eine Fahrplanung erfordern In den nächsten Sekunden wird simuliert, um zur richtigen Antwort zu gelangen.

Zusätzlich zum Generierungsprozess für Offline-Fragen und -Antworten schlägt der Autor auch einen Prozess zur Online-Generierung verschiedener Positionierungsfragen vor. Dieser Prozess kann als implizite Datenverbesserungsmethode angesehen werden, um das räumliche 3D-Verständnis und die Argumentationsfähigkeiten des Modells zu verbessern.

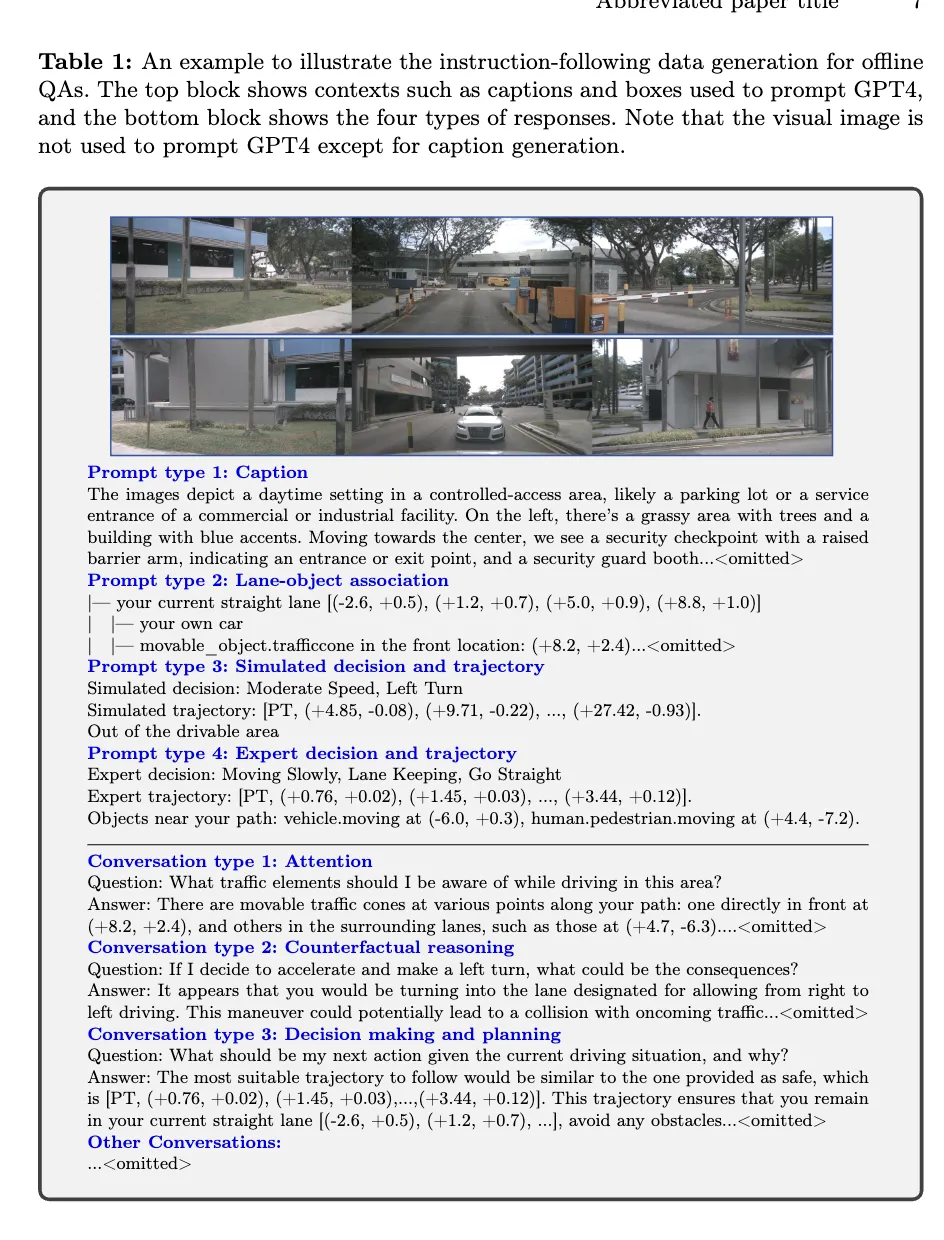

Offline-Fragen-Antworten

Im Offline-QA-Generierungsprozess verwendet der Autor Kontextinformationen, um QA-Paare auf nuScenes zu generieren. Zunächst generiert der Autor mit GPT-4 eine Szenenbeschreibung, fügt die dreiperspektivische Vorderansicht und die dreiperspektivische Rückansicht in zwei unabhängige Bilder zusammen und gibt sie in GPT-4 ein. Durch schnelle Eingabe kann GPT-4 Informationen wie Wetter, Zeit, Szenentyp usw. beschreiben und die Richtung jedes Betrachtungswinkels identifizieren. Gleichzeitig wird die Beschreibung nach Betrachtungswinkel vermieden, sondern der Inhalt relativ zum Position des eigenen Fahrzeugs.

Damit GPT-4V die relative räumliche Beziehung zwischen Verkehrselementen besser verstehen kann, stellt der Autor die Beziehung zwischen Objekten und Fahrspurlinien in einer Dateibaumstruktur dar und basiert auf dem 3D-Begrenzungsrahmen des Objekts. Seine Informationen werden in eine Beschreibung in natürlicher Sprache umgewandelt.

Dann generierte der Autor Trajektorien, indem er verschiedene Fahrabsichten simulierte, einschließlich Spurhalten, Spurwechsel nach links und Spur nach rechts, und verwendete einen Tiefensuchalgorithmus, um die Spurmittellinien zu verbinden, um alle möglichen Fahrpfade zu generieren. Darüber hinaus hat der Autor die Trajektorien des eigenen Fahrzeugs im nuScenes-Datensatz geclustert, repräsentative Fahrwege ausgewählt und sie als Teil der simulierten Trajektorie verwendet.

Durch die Kombination verschiedener Kontextinformationen im Offline-QA-Generierungsprozess sind die Autoren schließlich in der Lage, mehrere Arten von QA-Paaren zu generieren, einschließlich Szenenbeschreibung, Aufmerksamkeitsobjekterkennung, kontrafaktisches Denken und Entscheidungsplanung. GPT-4 kann Bedrohungsobjekte anhand von Simulationen und Expertentrajektorien identifizieren und sinnvolle Fahrempfehlungen geben, indem es Überlegungen zur Sicherheit des Fahrwegs anstellt.

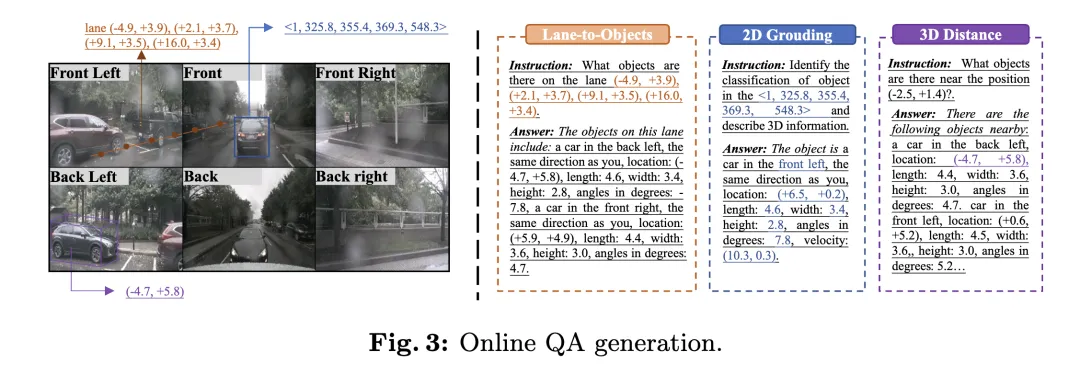

Online-Fragen-Beantwortung

Um die 3D-Wahrnehmungsanmerkungen im autonomen Fahrdatensatz voll auszunutzen, hat der Autor während des Trainingsprozesses online eine große Anzahl von Positionierungsaufgaben generiert. Diese Aufgaben sollen das räumliche 3D-Verständnis und die Argumentationsfähigkeiten des Modells verbessern, einschließlich:

- 2D-zu-3D-Lokalisierung: Bei einem 2D-Begrenzungsrahmen auf einer bestimmten Kamera muss das Modell die 3D-Attribute des entsprechenden Objekts bereitstellen. einschließlich Kategorie, Standort, Größe, Ausrichtung und Geschwindigkeit.

- 3D-Entfernung: Identifizieren Sie Verkehrselemente in der Nähe des Zielorts anhand zufällig generierter 3D-Koordinaten und geben Sie deren 3D-Attribute an.

- Spur zu Objekten: Listen Sie basierend auf einer zufällig ausgewählten Spurmittellinie alle Objekte auf dieser Spur und ihre 3D-Eigenschaften auf.

Metriken

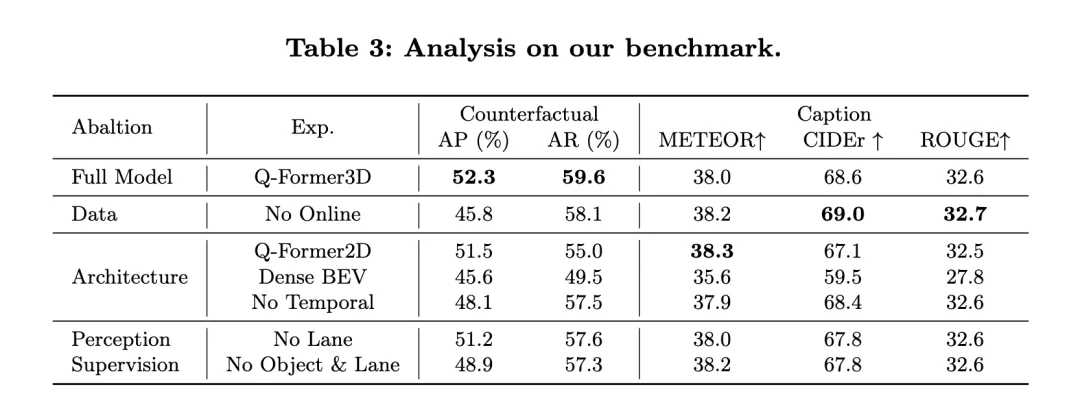

Der OmniDrive-nuScenes-Datensatz umfasst Szenenbeschreibungen, Open-Loop-Planung und kontrafaktische Argumentationsaufgaben. Jede Aufgabe konzentriert sich auf unterschiedliche Aspekte, was eine Bewertung anhand einer einzigen Metrik erschwert. Daher haben die Autoren unterschiedliche Bewertungskriterien für unterschiedliche Aufgaben entwickelt.

Für Aufgaben im Zusammenhang mit der Szenenbeschreibung (z. B. Szenenbeschreibung und Auswahl von Aufmerksamkeitsobjekten) verwendet der Autor häufig verwendete Sprachbewertungsindikatoren, einschließlich METEOR, ROUGE und CIDEr, um die Satzähnlichkeit zu bewerten. In der Open-Loop-Planungsaufgabe verwenden die Autoren die Kollisionsrate und die Geschwindigkeit des Überquerens von Straßengrenzen, um die Leistung des Modells zu bewerten. Für die Aufgabe des kontrafaktischen Denkens verwenden die Autoren GPT-3.5, um Schlüsselwörter in Vorhersagen zu extrahieren und diese Schlüsselwörter mit der Grundwahrheit zu vergleichen, um Präzision und Erinnerung für verschiedene Unfallkategorien zu berechnen.

Experimentelle Ergebnisse

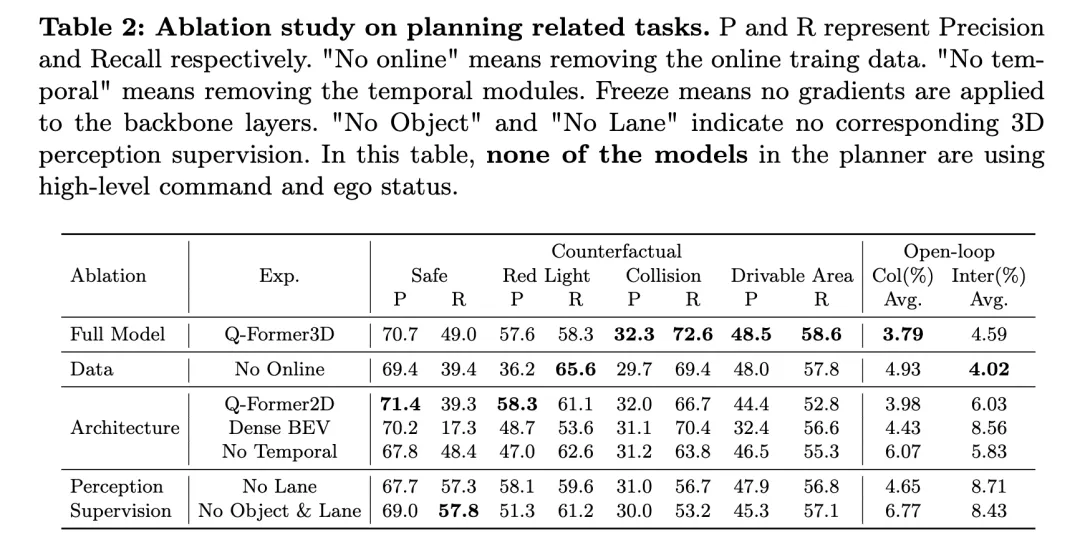

Die obige Tabelle zeigt die Ergebnisse der Ablationsforschung zu planungsbezogenen Aufgaben, einschließlich der Leistungsbewertung von kontrafaktischem Denken und Open-Loop-Planung.

Das vollständige Modell, Q-Former3D, schneidet sowohl bei kontrafaktischen Überlegungen als auch bei Planungsaufgaben mit offenem Regelkreis gut ab. Bei der Aufgabe zum kontrafaktischen Denken zeigte das Modell eine hohe Präzision und Erinnerungsraten sowohl in den Kategorien „Verstoß gegen die rote Ampel“ als auch „Verstoß gegen zugängliche Bereiche“, die jeweils bei 57,6 %/58,3 % und 48,5 %/58,6 % lagen. Gleichzeitig erreichte das Modell die höchste Rückrufquote (72,6 %) in der Kategorie „Kollision“. Bei der Open-Loop-Planungsaufgabe schnitt Q-Former3D sowohl bei der durchschnittlichen Kollisionsrate als auch bei der Kreuzungsrate von Straßengrenzen gut ab und erreichte 3,79 % bzw. 4,59 %.

Nach dem Entfernen der Online-Trainingsdaten (No Online) stieg die Rückrufrate der Kategorie „Rotlichtverstoß“ in der Aufgabe zum kontrafaktischen Denken (65,6 %), die Gesamtleistung nahm jedoch leicht ab. Die Präzisionsrate und die Erinnerungsrate von Kollisionen und Verstößen gegen befahrbare Bereiche sind etwas niedriger als die des Gesamtmodells, während die durchschnittliche Kollisionsrate der Open-Loop-Planungsaufgabe auf 4,93 % stieg und die durchschnittliche Rate des Überquerens von Straßengrenzen auf 4,02 % sank. Dies spiegelt die Bedeutung von Online-Trainingsdaten für die Verbesserung der Gesamtplanungsleistung des Modells wider.

Im Architekturablationsexperiment erreichte die Q-Former2D-Version die höchste Präzision (58,3 %) und den höchsten Rückruf (61,1 %) in der Kategorie „Rotlichtverletzung“, aber die Leistung in anderen Kategorien war nicht so gut wie die Vollversion Modell, insbesondere „Rückrufe für die Kategorien „Kollision“ und „Verstöße gegen zugängliche Bereiche“ gingen deutlich zurück. Bei der Planungsaufgabe mit offenem Regelkreis sind die durchschnittliche Kollisionsrate und die Kreuzungsrate der Straßengrenzen höher als im Gesamtmodell, nämlich 3,98 % bzw. 6,03 %.

Das Modell mit der Dense-BEV-Architektur schneidet bei allen Kategorien kontrafaktischer Argumentationsaufgaben besser ab, aber die Gesamtrückrufrate ist niedrig. Die durchschnittliche Kollisionsrate und die Kreuzungsrate von Straßengrenzen in der Planungsaufgabe mit offenem Regelkreis erreichten 4,43 % bzw. 8,56 %.

Wenn das Zeitmodul entfernt wird (kein Temporal), sinkt die Leistung des Modells bei der Aufgabe des kontrafaktischen Denkens erheblich, insbesondere steigt die durchschnittliche Kollisionsrate auf 6,07 % und die Straßengrenzüberschreitungsrate erreicht 5,83 %.

In Bezug auf die Wahrnehmungsüberwachung sank die Erinnerungsrate des Modells in der Kategorie „Kollision“ nach dem Entfernen der Spurlinienüberwachung („No Lane“) deutlich, während die Leistung anderer Kategorien kontrafaktischer Denkaufgaben und Planungsaufgaben mit offenem Regelkreis sank relativ Stabil. Nachdem die 3D-Wahrnehmungsüberwachung von Objekten und Fahrspurlinien vollständig entfernt wurde (No Object & Lane), verringerten sich die Präzision und die Erinnerungsrate jeder Kategorie der kontrafaktischen Denkaufgabe, insbesondere sank die Erinnerungsrate der Kategorie „Kollision“ auf 53,2 %. Die durchschnittliche Kollisionsrate und die Kreuzungsrate von Straßengrenzen stiegen bei der Planungsaufgabe mit offenem Regelkreis auf 6,77 % bzw. 8,43 % und lagen damit deutlich über dem Gesamtmodell.

Wie aus den obigen experimentellen Ergebnissen ersichtlich ist, schneidet das vollständige Modell bei kontrafaktischen Argumentations- und Open-Loop-Planungsaufgaben gut ab. Online-Trainingsdaten, Zeitmodule und die 3D-Wahrnehmungsüberwachung von Fahrspurlinien und Objekten spielen eine wichtige Rolle bei der Verbesserung der Modellleistung. Das vollständige Modell kann multimodale Informationen effektiv für eine effiziente Planung und Entscheidungsfindung nutzen, und die Ergebnisse des Ablationsexperiments bestätigen die Schlüsselrolle dieser Komponenten bei autonomen Fahraufgaben weiter.

Pada masa yang sama, mari kita lihat prestasi NuScenes-QA: ia menunjukkan prestasi OmniDrive dalam tugas perancangan gelung terbuka dan membandingkannya dengan kaedah sedia ada yang lain. Keputusan menunjukkan bahawa OmniDrive++ (versi penuh) mencapai prestasi terbaik dalam semua penunjuk, terutamanya dalam ralat purata perancangan gelung terbuka, kadar perlanggaran dan kadar persimpangan sempadan jalan, yang lebih baik daripada kaedah lain.

Prestasi OmniDrive++: Model OmniDrive++ mempunyai ralat purata L2 sebanyak 0.14, 0.29 dan 0.55 meter dalam masa ramalan masing-masing 1 saat, 2 saat dan 3 saat, dan ralat purata akhir hanya 0.33 meter Selain itu, kadar perlanggaran purata dan purata kadar persimpangan sempadan jalan bagi model ini juga masing-masing mencapai 0.30% dan 3.00%, yang jauh lebih rendah daripada kaedah lain. Terutamanya dari segi kadar perlanggaran, OmniDrive++ mencapai kadar perlanggaran sifar dalam tempoh masa ramalan 1 saat dan 2 saat, menunjukkan sepenuhnya perancangan cemerlang dan keupayaan mengelak halangannya.

Perbandingan dengan kaedah lain: Berbanding model penanda aras lanjutan lain, seperti UniAD, BEV-Planner++ dan Ego-MLP, OmniDrive++ mengatasi semua metrik utama. Apabila UniAD menggunakan arahan peringkat tinggi dan maklumat status kenderaan sendiri, ralat purata L2nya ialah 0.46 meter, manakala OmniDrive++ mempunyai ralat yang lebih rendah iaitu 0.33 meter di bawah tetapan yang sama. Pada masa yang sama, kadar perlanggaran dan kadar persimpangan sempadan jalan OmniDrive++ juga jauh lebih rendah daripada UniAD, terutamanya kadar perlanggaran dikurangkan hampir separuh.

Berbanding dengan BEV-Planner++, ralat L2 OmniDrive++ dikurangkan dengan ketara dalam semua tempoh masa ramalan, terutamanya dalam tempoh masa ramalan 3 saat, ralat dikurangkan daripada 0.57 meter kepada 0.55 meter. Pada masa yang sama, OmniDrive++ juga lebih baik daripada BEV-Planner++ dari segi kadar perlanggaran dan kadar lintasan sempadan jalan menurun daripada 0.34% kepada 0.30%, dan kadar lintasan sempadan jalan menurun daripada 3.16% kepada 3.00%.

Percubaan Ablasi: Untuk menilai lebih lanjut kesan modul utama dalam seni bina OmniDrive terhadap prestasi, penulis juga membandingkan prestasi versi berbeza model OmniDrive. OmniDrive (yang tidak menggunakan arahan peringkat tinggi dan maklumat status kenderaan sendiri) adalah jauh lebih rendah daripada model lengkap dari segi ralat ramalan, kadar perlanggaran dan kadar lintasan sempadan jalan, terutamanya ralat L2 dalam tempoh ramalan 3 saat mencapai 2.84 meter, dengan purata Kadar perlanggaran adalah setinggi 3.79%.

Apabila hanya menggunakan model OmniDrive (tanpa arahan peringkat tinggi dan maklumat status kenderaan sendiri), ralat ramalan, kadar perlanggaran dan kadar persimpangan sempadan jalan telah bertambah baik, tetapi masih terdapat jurang berbanding model lengkap. Ini menunjukkan bahawa penyepaduan arahan peringkat tinggi dan maklumat status kenderaan sendiri mempunyai kesan yang ketara ke atas peningkatan prestasi perancangan keseluruhan model.

Secara keseluruhan, hasil percubaan jelas menunjukkan prestasi cemerlang OmniDrive++ dalam tugas perancangan gelung terbuka. Dengan menyepadukan maklumat berbilang mod, arahan peringkat tinggi dan maklumat status kenderaan sendiri, OmniDrive++ mencapai ramalan laluan yang lebih tepat dan kadar perlanggaran yang lebih rendah dan kadar persimpangan sempadan jalan dalam tugas perancangan yang kompleks, menyediakan maklumat untuk perancangan pemanduan autonomi dan membuat keputusan yang kukuh sokongan.

Perbincangan

Ejen OmniDrive dan dataset OmniDrive-nuScenes yang dicadangkan oleh pengarang memperkenalkan paradigma baharu dalam bidang model besar berbilang mod, yang mampu menyelesaikan masalah pemanduan dalam persekitaran 3D model tersebut Penilaian menyediakan penanda aras yang komprehensif. Walau bagaimanapun, setiap kaedah dan set data baru mempunyai kelebihan dan kekurangannya.

Ejen OmniDrive mencadangkan strategi latihan dua peringkat: pra-latihan 2D dan penalaan halus 3D. Dalam peringkat pra-latihan 2D, penjajaran yang lebih baik antara ciri imej dan model bahasa besar dicapai dengan pra-latihan Q-Former dan pertanyaan pembawa menggunakan set data berpasangan teks imej LLaVA v1.5. Dalam peringkat penalaan halus 3D, pengekodan maklumat kedudukan 3D dan modul masa diperkenalkan untuk meningkatkan keupayaan kedudukan 3D model. Dengan memanfaatkan LoRA untuk memperhalusi pengekod visual dan model bahasa, OmniDrive mengekalkan pemahaman semantik 2D sambil meningkatkan penguasaannya terhadap penyetempatan 3D. Strategi latihan berperingkat ini melepaskan sepenuhnya potensi model besar berbilang modal, memberikan persepsi, penaakulan dan keupayaan perancangan yang lebih kukuh dalam senario pemanduan 3D. Sebaliknya, OmniDrive-nuScenes berfungsi sebagai penanda aras baharu yang direka khusus untuk menilai keupayaan memandu model besar. Proses penjanaan QA automatik sepenuhnya menjana pasangan soalan-jawapan berkualiti tinggi melalui GPT-4, meliputi tugas yang berbeza daripada persepsi kepada perancangan. Di samping itu, tugas penentududukan yang dijana dalam talian juga menyediakan peningkatan data tersirat untuk model, membantunya lebih memahami persekitaran 3D. Kelebihan set data ini ialah ia bukan sahaja menguji persepsi dan keupayaan penaakulan model, tetapi juga menilai kefahaman spatial model dan keupayaan perancangan melalui masalah jangka panjang. Penanda aras komprehensif ini memberikan sokongan kukuh untuk pembangunan model besar pelbagai modal masa hadapan.

Walau bagaimanapun, ejen OmniDrive dan set data OmniDrive-nuScenes juga mempunyai beberapa kelemahan. Pertama, memandangkan ejen OmniDrive perlu memperhalusi keseluruhan model semasa peringkat penalaan halus 3D, keperluan sumber latihan adalah tinggi, yang meningkatkan masa latihan dan kos perkakasan dengan ketara. Di samping itu, penjanaan data OmniDrive-nuScenes bergantung sepenuhnya pada GPT-4 Walaupun ia memastikan kualiti dan kepelbagaian soalan, ia juga menyebabkan soalan yang dihasilkan lebih cenderung kepada model dengan keupayaan bahasa semula jadi yang kuat, yang mungkin menjadikan model itu. lebih bergantung kepada ujian penanda aras Berdasarkan ciri bahasa dan bukannya keupayaan pemanduan sebenar. Walaupun OmniDrive-nuScenes menyediakan penanda aras QA yang komprehensif, liputan senario pemanduannya masih terhad. Peraturan lalu lintas dan simulasi perancangan yang terlibat dalam set data hanya berdasarkan set data nuScenes, yang menyukarkan masalah yang dijana untuk mewakili sepenuhnya pelbagai senario pemanduan di dunia nyata. Selain itu, disebabkan sifat proses penjanaan data yang sangat automatik, soalan yang dijana pasti dipengaruhi oleh berat sebelah data dan reka bentuk segera.

Kesimpulan

Ejen OmniDrive dan dataset OmniDrive-nuScenes yang dicadangkan oleh pengarang membawa perspektif baharu dan penanda aras penilaian kepada penyelidikan model besar berbilang mod dalam adegan pemanduan 3D. Strategi latihan dua peringkat ejen OmniDrive berjaya menggabungkan pra-latihan 2D dan penalaan halus 3D, menghasilkan model yang cemerlang dalam persepsi, penaakulan dan perancangan. Sebagai penanda aras QA baharu, OmniDrive-nuScenes menyediakan penunjuk komprehensif untuk menilai model pemanduan besar. Walau bagaimanapun, penyelidikan lanjut masih diperlukan untuk mengoptimumkan keperluan sumber latihan model, menambah baik proses penjanaan set data, dan memastikan soalan yang dijana dengan lebih tepat mewakili persekitaran pemanduan kehidupan sebenar. Secara keseluruhannya, kaedah dan set data pengarang adalah sangat penting dalam memajukan penyelidikan model besar berbilang mod dalam bidang pemanduan, meletakkan asas yang kukuh untuk kerja masa depan.

Das obige ist der detaillierte Inhalt vonLLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version). Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt