Insgesamt10000 bezogener Inhalt gefunden

Wie kann ich C-Code (DLL) aus C# aufrufen?

Artikeleinführung:Aufrufen von C-Code aus C#In einem typischen Szenario kann die Verbindung mit externen Bibliotheken und Code, der in verschiedenen Programmiersprachen geschrieben ist, eine Herausforderung darstellen.

2025-01-14

Kommentar 0

945

Entwicklung einer einfachen RESTful-API mit Gin, Ginvalidator und Validatorgo

Artikeleinführung:Dieses Tutorial führt Sie durch die Erstellung einer grundlegenden RESTful-API mit Go, dem Gin-Framework und den Open-Source-Bibliotheken Ginvalidator und Validatorgo. Diese Bibliotheken vereinfachen die Eingabevalidierung und machen Ihre API robuster. Wir erstellen eine API zur Verwaltung des Produktinventars. Die API unterstützt Sie

2025-01-14

Kommentar 0

735

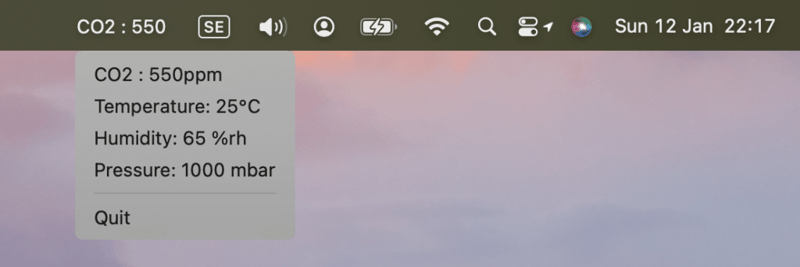

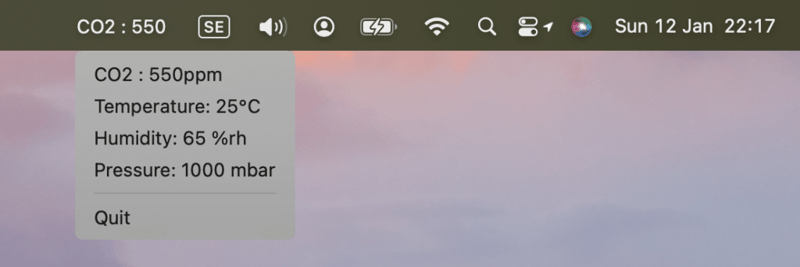

Erstellen einer BLE-Echtzeit-MacOS-Menüleisten-App

Artikeleinführung:Dieses Tutorial demonstriert den Aufbau einer Echtzeit-MacOS-Menüanwendung mithilfe eines BleuIOUSBBLE-Dongles zur Anzeige von Umgebungsdaten. BleuIO vereinfacht die BLE-Entwicklung (Bluetooth Low Energy) und eignet sich daher ideal für die Erstellung innovativer Projekte. MacOS-Menüleisten-Apps bieten eine diskrete Möglichkeit zur Überwachung

2025-01-14

Kommentar 0

740

Erstellen statischer HTML-Seiten mit serverseitigem JSX-Rendering

Artikeleinführung:Einführung

Haben Sie schon einmal eine Website besucht, deren Laden ewig gedauert hat? Frustrierend, nicht wahr? Schnelle Ladezeiten und ein reibungsloses Benutzererlebnis sind nicht nur „nice-to-have“ – sie sind unerlässlich, um Besucher in der Nähe zu halten und in den Suchmaschinen weit oben zu ranken

2025-01-14

Kommentar 0

839

Kompilierungszeit-Assertions in Go (Golang)

Artikeleinführung:Der Assertionsmechanismus zur Kompilierungszeit der Go-Sprache wird verwendet, um bestimmte Bedingungen oder Einschränkungen in der Kompilierungsphase und nicht zur Laufzeit durchzusetzen. Wenn die Bedingungen nicht erfüllt sind, schlägt der Kompilierungsprozess fehl und meldet einen Fehler. Dies hilft, Fehler so früh wie möglich zu erkennen und sicherzustellen, dass das Programm vor der Ausführung bestimmte Invarianten oder Annahmen erfüllt. Assertionen zur Kompilierungszeit werden häufig verwendet, um sicherzustellen, dass Datenstrukturen die erwartete Größe haben. Stellen Sie sicher, dass der Wert einer Konstante oder eines Ausdrucks wie erwartet ist. Erzwingen Sie Typeinschränkungen oder andere Prüfungen zur Kompilierungszeit. Zusicherungen zur Kompilierungszeit in Go Die Go-Sprache selbst unterstützt Zusicherungen zur Kompilierungszeit nicht direkt wie einige andere Sprachen. Mit einigen cleveren Techniken können wir jedoch eine ähnliche Funktionalität erreichen. Hier sind einige gängige Methoden: Stellen Sie sicher, dass ein konstanter boolescher Ausdruck zur Kompilierungszeit wahr (oder falsch) ist: Wir können die folgenden Funktionen nutzen: Die Go-Sprachspezifikation ist klar

2025-01-14

Kommentar 0

779

FastHTML und Heroku

Artikeleinführung:FastHTML: Ein schneller Pfad zur Web-App-Entwicklung mit Python. Die Entwicklung neuer Anwendungen erfordert häufig die Beherrschung zahlreicher Tools und Frameworks. Für Python-Entwickler kann der Einstieg in HTML, CSS und JavaScript eine erhebliche Hürde darstellen. Umgekehrt können Webentwickler auf Python-Backend-Tools stoßen

2025-01-14

Kommentar 0

582