Insgesamt10000 bezogener Inhalt gefunden

Java EJB und Big-Data-Analyse, um den Wert von Unternehmensdaten freizusetzen

Artikeleinführung:EJB und Big-Data-Analyse JavaEnterpriseJavaBeans (EJB) ist ein Framework, das häufig zur Entwicklung verteilter Unternehmensanwendungen verwendet wird. Es bietet zentrale Unternehmensfunktionen wie Transaktionsverarbeitung, Parallelität und Sicherheit. Mit dem Aufkommen des Big-Data-Zeitalters wurde EJB erweitert, um die wachsende Datenmenge zu verarbeiten und zu analysieren. Durch die Integration von Big-Data-Technologien können EJB-Anwendungen: Riesige Datenmengen verarbeiten und speichern. Komplexe Datenanalyseaufgaben ausführen. Zugriff auf Echtzeitdaten bereitstellen. Datengesteuerte Entscheidungsfindung unterstützen. EJB- und Big-Data-Integrationsbeispiel. Der folgende Code zeigt, wie EJB verwendet wird Integration mit Apachespark. Big-Data-Analyse: @StatelesspublicclassSparkDa

2024-02-21

Kommentar 0

751

So verwenden Sie die Datenanalysefunktionen von MySQL für eine erweiterte Datenanalyse

Artikeleinführung:So nutzen Sie die Datenanalysefunktionen von MySQL für erweiterte Datenanalysen. Im Bereich der Datenanalyse verfügt MySQL als leistungsstarke und benutzerfreundliche relationale Datenbank über eine Fülle von Datenanalysefunktionen, die uns bei der Durchführung verschiedener erweiterter Datenanalysen helfen können. In diesem Artikel wird erläutert, wie Sie mit den Datenanalysefunktionen von MySQL eine erweiterte Datenanalyse durchführen und Codebeispiele anhängen. 1. Übersicht Datenanalysefunktionen sind eine Reihe leistungsstarker integrierter Funktionen, die von MySQL bereitgestellt werden und Aggregation, Sortierung, Rangfolge, Fensterberechnung und andere Vorgänge an Daten durchführen können. Diese Funktionen können

2023-08-02

Kommentar 0

1511

Integration von PHP-Funktionen und Big-Data-Analyse

Artikeleinführung:Nutzen Sie PHP-Funktionen und Erweiterungen, um Big Data effizient zu verarbeiten und zu analysieren. Integrieren Sie gängige PHP-Funktionen: Führen Sie Datenkonvertierung, Aggregation, Gruppierung und andere Aufgaben durch. Verwenden Sie Erweiterungsbibliotheken: Verbessern Sie die Big-Data-Verarbeitungsfunktionen von PHP, z. B. die MongoDBPHP-Bibliothek und die ElasticsearchPHP-Bibliothek. Praktischer Fall: Durch Herstellen einer Verbindung zur Datenbank, Abrufen von Daten, Verwenden integrierter Funktionen zur Berechnung der Anzahl der Besuche und Analysieren von Website-Verkehrsdaten.

2024-05-01

Kommentar 0

1197

Wie kann die Geschwindigkeit der Datenanalyse in der C++-Big-Data-Entwicklung verbessert werden?

Artikeleinführung:Wie kann die Datenanalysegeschwindigkeit bei der C++-Big-Data-Entwicklung verbessert werden? Einführung: Mit dem Aufkommen des Big-Data-Zeitalters ist die Datenanalyse zu einem unverzichtbaren Bestandteil der Unternehmensentscheidung und Geschäftsentwicklung geworden. Bei der Big-Data-Verarbeitung wird C++ als effiziente und leistungsstarke Computersprache häufig im Entwicklungsprozess der Datenanalyse eingesetzt. Beim Umgang mit großen Datenmengen ist jedoch die Frage, wie die Geschwindigkeit der Datenanalyse in der C++-Big-Data-Entwicklung verbessert werden kann, zu einem wichtigen Thema geworden. Dieser Artikel beginnt mit der Verwendung effizienterer Datenstrukturen und Algorithmen, der gleichzeitigen Multithread-Verarbeitung und GP

2023-08-27

Kommentar 0

803

Datenanalyse- und Analysefunktionsfähigkeiten für PHP- und Oracle-Datenbanken

Artikeleinführung:Einführung in die Datenanalyse und Analysefunktionsfähigkeiten von PHP und Oracle-Datenbanken. Im Entwicklungsprozess moderner Computeranwendungen ist die Datenanalyse ein sehr wichtiges Bindeglied. Insbesondere bei großen Datenbankanwendungen müssen Datenanalyse- und Analysefunktionen verwendet werden, um wertvolle Informationen aus großen Datenmengen zu gewinnen. In diesem Artikel wird die Verwendung der PHP-Programmiersprache und der Oracle-Datenbank zur Durchführung von Datenanalysetechniken vorgestellt und einige relevante Beispielcodes bereitgestellt. 1. Verbindung zwischen PHP und Oracle-Datenbank vor dem Start

2023-07-11

Kommentar 0

857

Datenanalyse beherrschen: Der ultimative Leitfaden zur Datenanalyse.

Artikeleinführung:Datenanalyse beherrschen: Der ultimative Leitfaden zur Datenanalyse

In der heutigen datengesteuerten Welt ist die Beherrschung der Datenanalyse zu einer wesentlichen Fähigkeit für Unternehmen und Einzelpersonen geworden. Datenanalysen ermöglichen es Unternehmen, das volle Potenzial auszuschöpfen

2024-10-16

Kommentar 0

691

So implementieren Sie eine Echtzeit-Big-Data-Analyse von Daten in MongoDB

Artikeleinführung:So implementieren Sie die Echtzeit-Big-Data-Analysefunktion von Daten in MongoDB. Einführung: Mit dem Aufkommen des Informationszeitalters ist die Big-Data-Analyse nach und nach zu einem wichtigen Instrument für die Entscheidungsfindung im Unternehmens- und Organisationsmanagement geworden. Als beliebte nicht-relationale Datenbank bietet MongoDB die Vorteile einer hohen Leistung, einer hohen Skalierbarkeit und eines flexiblen Datenmodells, was es zur besten Wahl für die Analyse großer Datenmengen macht. In diesem Artikel wird erläutert, wie eine Echtzeit-Big-Data-Analyse von Daten in MongoDB implementiert wird, und es werden spezifische Codebeispiele bereitgestellt. 1. Konfigurieren Sie MongoDB für die Unterstützung großer Zahlen

2023-09-19

Kommentar 0

1456

Verwendung der Go-Sprache für die Verarbeitung und Analyse großer Datenmengen

Artikeleinführung:Verwendung der Go-Sprache für die Verarbeitung und Analyse großer Datenmengen Mit der rasanten Entwicklung der Internettechnologie ist Big Data in allen Lebensbereichen zu einem unvermeidlichen Thema geworden. Angesichts der riesigen Datenmengen ist die effiziente Verarbeitung und Analyse dieser Daten eine sehr wichtige Frage. Als leistungsstarke gleichzeitige Programmiersprache kann die Go-Sprache eine hohe Leistung und hohe Zuverlässigkeit bieten, was sie zu einer guten Wahl für die Verarbeitung und Analyse großer Datenmengen macht. In diesem Artikel wird erläutert, wie die Go-Sprache für die Verarbeitung und Analyse großer Datenmengen verwendet wird, einschließlich Datenlesen, Datenbereinigung, Datenverarbeitung und Datenanalyse

2023-08-08

Kommentar 0

1071

Polars: Ermöglichen der groß angelegten Datenanalyse in Python

Artikeleinführung:In der heutigen datengesteuerten Welt ist die effiziente Analyse großer Datensätze von entscheidender Bedeutung. Python, eine vielseitige Programmiersprache, bietet verschiedene Bibliotheken zur Datenmanipulation und -analyse. Ein leistungsstarkes Tool ist Polars, eine Open-Source-Bibliothek für hohe Anforderungen

2024-07-18

Kommentar 0

1080

Entdecken Sie die Zauberformel der Python-Datenanalyse und helfen Sie Ihnen, ein Datenmaster zu werden

Artikeleinführung:Python hat sich mit seinen leistungsstarken und benutzerfreundlichen Bibliotheken und Tools zu einer dominierenden Kraft im Bereich der Datenanalyse entwickelt. Die Beherrschung der Kerntechniken der Python-Datenanalyse kann das wahre Potenzial von Daten freisetzen und Sie zum Datenmeister machen. 1. Datenvorbereitung und Datenladen: Verwenden Sie die Pandas-Bibliothek, um Daten aus verschiedenen Quellen (z. B. CSV, JSON, SQL) zu laden. Datenbereinigung: Behandeln Sie fehlende Werte, Ausreißer und doppelte Daten, um die Datenintegrität und -genauigkeit sicherzustellen. Feature-Engineering: Erstellen Sie neue Features, Variablentransformationen und Klassifizierungen, um die Modellleistung zu verbessern. 2. Visualisierung der Datenexplorationsanalyse: Verwenden Sie Bibliotheken wie Matplotlib und Seaborn, um Diagramme und Grafiken zu erstellen und Muster, Trends und Ausreißer in den Daten zu entdecken. Statistische Analyse: Beschreibung der Berechnungen

2024-03-17

Kommentar 0

1118

Python-Datenanalyse: Der Weg zum datengesteuerten Erfolg

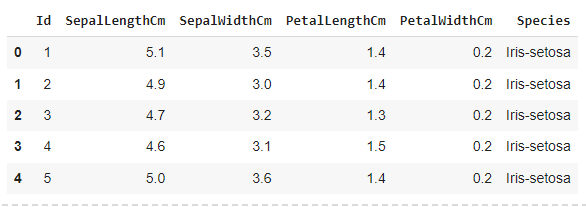

Artikeleinführung:Die Python-Datenanalyse umfasst das Sammeln, Bereinigen, Untersuchen, Modellieren und Visualisieren von Daten aus verschiedenen Datenquellen mithilfe der Programmiersprache Python. Es bietet leistungsstarke Tools und Bibliotheken wie NumPy, Pandas, Scikit-learn und Matplotlib, um Forschern und Analysten die effiziente Verarbeitung und Analyse großer Datenmengen zu ermöglichen. Datenexploration und -bereinigung Die Pandas-Bibliothek erleichtert die Datenexploration. Sie können damit DataFrame-Objekte erstellen, bei denen es sich um tabellenähnliche Objekte handelt, die das Sortieren, Filtern und Gruppieren von Daten erleichtern. NumPy bietet leistungsstarke mathematische und statistische Funktionen zur Datenbereinigung und -transformation. importpandasaspdimpor

2024-02-20

Kommentar 0

668

Was sind die Kerntechnologien des Big-Data-Analysesystems?

Artikeleinführung:Zu den Kerntechnologien des Big-Data-Analysesystems gehören Datenerfassung, Vorverarbeitung, verteilte Speicherung, verteiltes Rechnen, Data Mining und Visualisierung. Detaillierte Einführung: 1. Datenerfassungstechnologie: Big-Data-Analysesysteme müssen verschiedene Arten von Daten aus verschiedenen Datenquellen in Echtzeit oder zeitnah sammeln und zur anschließenden Verarbeitung an Speichersysteme oder Daten-Middleware-Systeme senden Technologie: Die Qualität der Daten hat einen direkten Einfluss auf den Wert der Daten. Daten von geringer Qualität führen zu minderwertigen Analyse- und Mining-Ergebnissen. Daher müssen Vorverarbeitungsvorgänge wie Bereinigung, Deduplizierung, Zusammenführung und Konvertierung von Daten durchgeführt werden.

2023-12-20

Kommentar 0

1552

Gängige Techniken für die Big-Data-Analyse mit der Go-Sprache

Artikeleinführung:Gängige Techniken für die Big-Data-Analyse mithilfe der Go-Sprache Mit dem Aufkommen des Big-Data-Zeitalters ist die Datenanalyse zu einem unverzichtbaren Bestandteil verschiedener Bereiche geworden. Als leistungsstarke Programmiersprache ist Go aufgrund seiner Einfachheit und Effizienz die ideale Wahl für die Analyse großer Datenmengen. In diesem Artikel werden einige häufig verwendete Techniken zur Big-Data-Analyse mithilfe der Go-Sprache vorgestellt und spezifische Codebeispiele bereitgestellt. 1. Gleichzeitige Programmierung Bei der Durchführung einer Big-Data-Analyse ist die Datenmenge oft sehr groß und die herkömmliche serielle Verarbeitungsmethode ist ineffizient. Gleichzeitige Programmierung ist die Stärke der Go-Sprache

2023-12-23

Kommentar 0

952

Tipps und Praktiken für die Analyse umfangreicher Daten mit PHP Elasticsearch

Artikeleinführung:Tipps und Praktiken für die Analyse umfangreicher Daten mit phpElasticsearch Einführung Im Zeitalter von Big Data ist die Datenanalyse zu einem wichtigen Instrument für die Entscheidungsfindung von Unternehmen geworden. Um große Datenmengen schnell und effizient zu analysieren, ist Elasticsearch mittlerweile eine gängige Wahl. In diesem Artikel wird die Verwendung von phpElasticsearch für die Analyse umfangreicher Daten vorgestellt, einschließlich Techniken und Praktiken zum Indizieren von Daten, Abfragen von Daten und Analysieren von Daten, und es werden spezifische Codebeispiele bereitgestellt. Vorbereitung vor dem Start,

2023-09-13

Kommentar 0

966

So verwenden Sie PHP für die grundlegende Big-Data-Analyse

Artikeleinführung:In den letzten Jahren hat die Datenmenge mit der kontinuierlichen Entwicklung und Popularisierung des Internets und der Beliebtheit mobiler Geräte einen explosionsartigen Wachstumstrend gezeigt, und die Datenanalyse ist zu einer der notwendigen Fähigkeiten für Unternehmen und Einzelpersonen geworden. Neben vielen Datenanalysetools kann PHP als Open-Source-Programmiersprache auch für die grundlegende Big-Data-Analyse verwendet werden. In diesem Artikel wird erläutert, wie Sie mit PHP eine grundlegende Big-Data-Analyse durchführen. 1. Grundkenntnisse in PHP Bevor Sie lernen, PHP für die Big-Data-Analyse zu verwenden, müssen Sie einige Grundkenntnisse in PHP verstehen. PHP ist eine Open-Source-Skriptsprache

2023-06-22

Kommentar 0

1545

Java-Datenstrukturen und -Algorithmen: Ein praktischer Leitfaden zur Big-Data-Analyse

Artikeleinführung:Big-Data-Analyseanwendungen von Datenstrukturen und Algorithmen in Java. Stammdatenstrukturen (Arrays, verknüpfte Listen, Stapel, Warteschlangen, Hash-Tabellen) und Algorithmen (Sortierung, Suche, Hashing, Graphtheorie und Union-Lookup). wichtig. Diese Datenstrukturen und Algorithmen bieten Mechanismen für die effiziente Speicherung, Verwaltung und Verarbeitung riesiger Datenmengen. Praktische Beispiele veranschaulichen die Anwendung dieser Konzepte, beispielsweise die Verwendung von Hash-Tabellen zum schnellen Auffinden von Worthäufigkeiten und die Verwendung von Diagrammalgorithmen zum Auffinden relevanter Knoten in sozialen Netzwerken.

2024-05-08

Kommentar 0

878

Erkundung der Big-Data-Analyse und Mining-Technologie mit Elasticsearch in PHP

Artikeleinführung:Erforschung der von Elasticsearch in PHP implementierten Big-Data-Analyse- und Mining-Technologie Zusammenfassung: Mit dem Aufkommen des Big-Data-Zeitalters ist die effiziente Analyse und Gewinnung großer Datenmengen zu einer wichtigen Aufgabe geworden. In diesem Artikel wird erläutert, wie Sie die PHP-Sprache in Kombination mit der Elasticsearch-Suchmaschine verwenden, um Big-Data-Analyse und -Mining zu erreichen. Und verwenden Sie spezifische Codebeispiele, um die Implementierungsmethoden und technischen Punkte zu demonstrieren. Schlüsselwörter: PHP, Elasticsearch, Big-Data-Analyse, Data-Mining-Einführung

2023-10-03

Kommentar 0

711

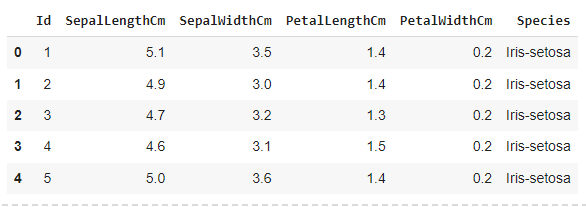

Ihre Daten verstehen: Die Grundlagen der explorativen Datenanalyse

Artikeleinführung:Die explorative Datenanalyse ist ein beliebter Ansatz zur Analyse von Datensätzen und zur visuellen Darstellung Ihrer Ergebnisse. Es trägt dazu bei, maximale Einblicke in den Datensatz und die Struktur zu erhalten. Dies identifiziert die explorative Datenanalyse als eine Technik zum Verständnis der Variablen

2024-08-10

Kommentar 0

578

Python-Datenanalyse: ein leistungsstarkes Tool für die Datenwissenschaft

Artikeleinführung:Die Datenanalyse ist zu einem wichtigen Bestandteil unternehmerischer Entscheidungsfindung und strategischer Planung geworden. Python, eine leistungsstarke und vielseitige Programmiersprache, ist zum Werkzeug der Wahl für Datenanalysten und Datenwissenschaftler geworden. Dieser Artikel befasst sich mit der Leistungsfähigkeit von Python bei der Datenanalyse, von der Datenerfassung und -bereinigung bis hin zur Modellierung und Visualisierung. Datenabruf und -bereinigung Python bietet eine umfangreiche Bibliothek zum Abrufen von Daten aus einer Vielzahl von Quellen, einschließlich Dateien, Datenbanken und APIs. Datenrahmen können mit der Pandas-Bibliothek einfach gelesen und verarbeitet werden, während die Numpy-Bibliothek effiziente Array-Verarbeitungsfunktionen bietet. Bei der Datenbereinigung geht es darum, fehlende Werte, Ausreißer und Duplikate zu identifizieren und zu behandeln. dropna, fillna und dupli in Python

2024-02-19

Kommentar 0

799

Welche Datenanalyse-Websites werden empfohlen?

Artikeleinführung:Empfohlen: 1. Wirtschaftsforum des Volkskongresses – Bereich Ökonometrie und Statistik; 4. Forum für Datenanalyse; . Datenanalyse; 8. Data Mining Research Institute; 9. S-PLUS, R Statistikforum.

2024-03-13

Kommentar 0

1009