Insgesamt10000 bezogener Inhalt gefunden

Training von Machine-Learning-Modellen mit C++: von der Datenvorverarbeitung bis zur Modellvalidierung

Artikeleinführung:Das Training eines ML-Modells in C++ umfasst die folgenden Schritte: Datenvorverarbeitung: Laden, Transformieren und Konstruieren der Daten. Modelltraining: Wählen Sie einen Algorithmus und trainieren Sie das Modell. Modellvalidierung: Partitionieren Sie den Datensatz, bewerten Sie die Leistung und optimieren Sie das Modell. Wenn Sie diese Schritte befolgen, können Sie Modelle für maschinelles Lernen in C++ erfolgreich erstellen, trainieren und validieren.

2024-06-01

Kommentar 0

656

Trainieren Sie das YOLOv7-Modell und entwickeln Sie eine KI-Branderkennung

Artikeleinführung:1. Bereiten Sie den Datensatz vor. Der Datensatz verwendet Open-Source-Bilder mit insgesamt 6.000 Brandbildern, die mit Rauch und Feuer markiert sind. Das Fire and Smoke-Projekt verwendet YOLO für das Training. Ich habe die Daten in das YOLO-Format konvertiert und in einen Trainingssatz und einen Verifizierungssatz unterteilt. 2. Informationen zum Schulungsprozess finden Sie in der Dokumentation der offiziellen Website von YOLOv7. Ändern Sie die Datei data/coco.yaml und konfigurieren Sie den Pfad und die Kategorie der Trainingsdaten. Laden Sie das vorab trainierte Modell yolov7.pt herunter und beginnen Sie mit dem Training. 3. Suchen Sie nach Abschluss des Brandüberwachungstrainings die generierte Modelldatei-best.pt im Ausführungsverzeichnis unter dem Verzeichnis yolov7. ich trainiere

2023-05-11

Kommentar 0

994

Detaillierte Erläuterung des Deep-Learning-Pre-Training-Modells in Python

Artikeleinführung:Mit der Entwicklung von künstlicher Intelligenz und Deep Learning sind Pre-Training-Modelle zu einer beliebten Technologie in der Verarbeitung natürlicher Sprache (NLP), Computer Vision (CV), Spracherkennung und anderen Bereichen geworden. Als eine der derzeit beliebtesten Programmiersprachen spielt Python natürlich eine wichtige Rolle bei der Anwendung vorab trainierter Modelle. Dieser Artikel konzentriert sich auf das Deep-Learning-Pre-Training-Modell in Python, einschließlich seiner Definition, Typen, Anwendungen und der Verwendung des Pre-Training-Modells. Was ist ein vorab trainiertes Modell? Die Hauptschwierigkeit von Deep-Learning-Modellen besteht darin, eine große Anzahl qualitativ hochwertiger Modelle zu analysieren

2023-06-11

Kommentar 0

2010

CMU schließt sich mit Adobe zusammen: GAN-Modelle läuten die Ära des Vortrainings ein und erfordern nur 1 % der Trainingsbeispiele

Artikeleinführung:Nach Eintritt in die Ära vor dem Training hat sich die Leistung visueller Erkennungsmodelle schnell entwickelt, aber Bilderzeugungsmodelle wie Generative Adversarial Networks (GAN) scheinen ins Hintertreffen zu geraten. Normalerweise wird das GAN-Training von Grund auf unbeaufsichtigt durchgeführt, was zeitaufwändig und arbeitsintensiv ist. Ist das nicht ein Nachteil, wenn das durch Big Data erlernte „Wissen“ genutzt wird? Darüber hinaus muss die Bilderzeugung selbst in der Lage sein, komplexe statistische Daten in realen visuellen Phänomenen zu erfassen und zu simulieren. Andernfalls entsprechen die erzeugten Bilder nicht den Gesetzen der physischen Welt und können auf den ersten Blick direkt als „Fälschung“ identifiziert werden . Das vorab trainierte Modell stellt Wissen bereit und das GAN-Modell bietet Generierungsfunktionen. Die Kombination der beiden kann eine schöne Sache sein! Die Frage ist, welche vorab trainierten Modelle und wie man sie kombiniert, die Generierungsfähigkeit des GAN-Modells verbessern kann

2023-05-11

Kommentar 0

1466

Wie beschleunigt das Java-Framework das Training von Modellen für künstliche Intelligenz?

Artikeleinführung:Das Java-Framework kann das Training künstlicher Intelligenzmodelle beschleunigen, indem es TensorFlowServing verwendet, um vorab trainierte Modelle für schnelle Inferenzen bereitzustellen; Verwendung von H2OAIDriverlessAI, um den Trainingsprozess zu automatisieren, und Verwendung von SparkMLlib, um verteiltes Training und große Datenmengen zu implementieren auf der Apache Spark-Architektur Set-Verarbeitung.

2024-06-04

Kommentar 0

904

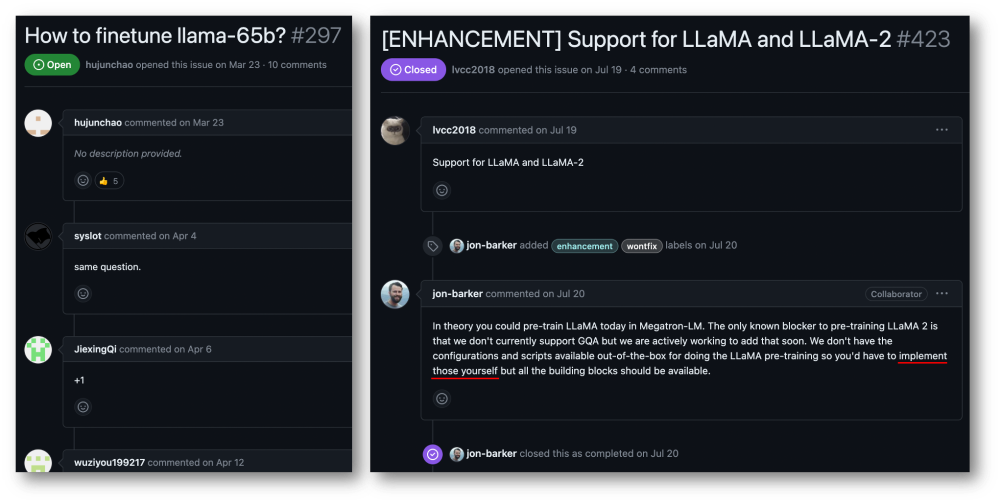

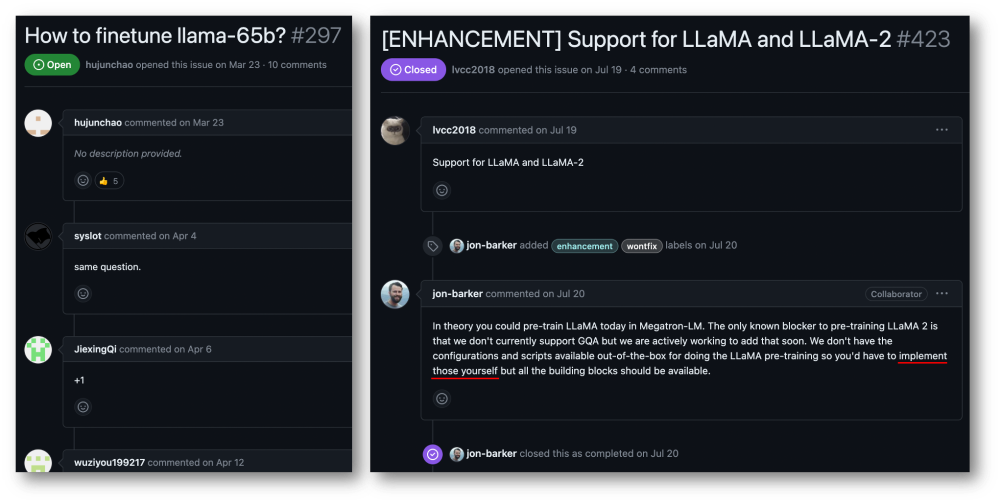

32 Karten, 176 % Trainingsbeschleunigung, Open-Source-Trainingsframework für große Modelle Megatron-LLaMA ist da

Artikeleinführung:Die Taotian Group und Aicheng Technology haben am 12. September offiziell das Open-Source-Schulungsframework für große Modelle – Megatron-LLaMA – veröffentlicht. Ziel dieses Frameworks ist es, Technologieentwicklern die Möglichkeit zu geben, die Trainingsleistung großer Sprachmodelle einfacher zu verbessern, die Trainingskosten zu senken und die Kompatibilität mit der LLaMA-Community aufrechtzuerhalten. Die Testergebnisse zeigen, dass Megatron-LLaMA beim 32-Karten-Training eine Beschleunigung von 176 % im Vergleich zur direkt auf HuggingFace erhaltenen Codeversion erreichen kann. Beim groß angelegten Training dehnt sich Megatron-LLaMA nahezu linear aus und zeigt eine hohe Instabilität im Netzwerk Maß an Toleranz. Derzeit wurde Megatron-LLaMA in der Open-Source-Community unter der Open-Source-Adresse https: gestartet.

2023-09-14

Kommentar 0

633

Die Auswirkungen der Datenknappheit auf das Modelltraining

Artikeleinführung:Die Auswirkungen der Datenknappheit auf das Modelltraining erfordern spezifische Codebeispiele. In den Bereichen maschinelles Lernen und künstliche Intelligenz sind Daten eines der Kernelemente für das Training von Modellen. Ein Problem, mit dem wir in der Realität jedoch häufig konfrontiert sind, ist die Datenknappheit. Unter Datenknappheit versteht man die unzureichende Menge an Trainingsdaten oder das Fehlen annotierter Daten. In diesem Fall hat dies einen gewissen Einfluss auf das Modelltraining. Das Problem der Datenknappheit spiegelt sich hauptsächlich in den folgenden Aspekten wider: Überanpassung: Wenn die Menge an Trainingsdaten nicht ausreicht, ist das Modell anfällig für Überanpassung. Überanpassung bezieht sich auf eine übermäßige Anpassung des Modells an die Trainingsdaten.

2023-10-08

Kommentar 0

1407

Die Open-Source-Erweiterungsbibliothek für verteiltes Training AToch von Ant erreicht eine effektive Auslastungsrate von 60 % der Rechenleistung für das Training großer Modelle

Artikeleinführung:Die Ant Group kündigte kürzlich die Einführung einer großen Erweiterungsbibliothek für verteilte Trainingsbeschleunigung mit dem Namen ATorch an, einem Open-Source-Tool. Das Ziel von ATorch besteht darin, die Intelligenz des Deep Learning durch automatische Optimierung der Ressourcendynamik und Verbesserung der verteilten Trainingsstabilität zu verbessern. Es versteht sich, dass ATorch beim Training großer Modelle die Rechenleistungsauslastung des Kilokalorien-Trainings von Hunderten Milliarden Modellen auf 60 % steigern kann, was dem Einbau eines leistungsstarken Motors in einen Sportwagen entspricht. Dies wird ein wichtiges Werkzeug für Deep-Learning-Forscher und -Entwickler sein, das ihnen hilft, große Modelle effizienter zu trainieren und zu optimieren. Abbildung: ATorch setzt sich dafür ein, das Training großer Modelle effizienter und reproduzierbarer zu machen. Mit der Explosion generativer großer Modelle ist der Umfang der Datensätze und Parameter für das Modelltraining exponentiell.

2024-01-14

Kommentar 0

1426

So implementieren Sie verteilte Algorithmen und Modelltraining in PHP-Microservices

Artikeleinführung:So implementieren Sie verteilte Algorithmen und Modelltraining in PHP-Microservices. Einführung: Mit der rasanten Entwicklung von Cloud Computing und Big-Data-Technologie steigt die Nachfrage nach Datenverarbeitung und Modelltraining. Verteilte Algorithmen und Modelltraining sind der Schlüssel zum Erreichen von Effizienz, Geschwindigkeit und Skalierbarkeit. In diesem Artikel wird die Implementierung verteilter Algorithmen und Modelltrainings in PHP-Microservices vorgestellt und einige spezifische Codebeispiele bereitgestellt. 1. Was ist verteiltes Algorithmus- und Modelltraining? Verteiltes Algorithmus- und Modelltraining ist eine Technologie, die mehrere Maschinen oder Serverressourcen verwendet, um Datenverarbeitung und Modelltraining gleichzeitig durchzuführen.

2023-09-25

Kommentar 0

1454

Verwendung von JavaScript-Funktionen zur Implementierung des Modelltrainings für maschinelles Lernen

Artikeleinführung:Verwenden von JavaScript-Funktionen zur Implementierung des Modelltrainings für maschinelles Lernen Mit der rasanten Entwicklung des maschinellen Lernens haben viele Entwickler begonnen, darauf zu achten, wie JavaScript zur Implementierung des Modelltrainings für maschinelles Lernen im Frontend verwendet werden kann. In diesem Artikel wird erläutert, wie JavaScript-Funktionen zum Implementieren eines Modelltrainings für maschinelles Lernen verwendet werden, und es werden spezifische Codebeispiele bereitgestellt. Bevor wir beginnen, müssen wir einige wichtige Konzepte verstehen. Datensatz: Das Modelltraining für maschinelles Lernen erfordert einen Satz gekennzeichneter Datensätze als Eingabe. Der Datensatz besteht aus

2023-11-03

Kommentar 0

1190

Übertragen Sie Lernanwendungen und gängige Technologien in das Training großer Sprachmodelle

Artikeleinführung:Große Sprachmodelle beziehen sich auf Modelle zur Verarbeitung natürlicher Sprache mit mehr als 100 Millionen Parametern. Aufgrund ihrer schieren Größe und Komplexität erfordert das Training eines solchen Modells erhebliche Rechenressourcen und Daten. Daher ist Transferlernen zu einer wichtigen Methode zum Training großer Sprachmodelle geworden. Durch die Nutzung vorhandener Modelle und Daten kann der Trainingsprozess beschleunigt und die Leistung verbessert werden. Transferlernen kann die Parameter und das Wissen von Modellen, die für andere Aufgaben trainiert wurden, auf die Zielaufgabe übertragen und so den Datenbedarf und die Trainingszeit reduzieren. Dieser Ansatz wird sowohl in der Forschung als auch in der Industrie häufig eingesetzt und legt den Grundstein für die Entwicklung leistungsfähigerer Sprachmodelle. Transferlernen ist eine Methode, die ein bereits trainiertes Modell verwendet, um seine Parameter oder einige Komponenten bei der Lösung anderer Aufgaben anzupassen. Im Bereich der Verarbeitung natürlicher Sprache kann Transferlernen erfolgen

2024-01-22

Kommentar 0

934

Die Bedeutung der Batch-Größe und ihre Auswirkung auf das Training (im Zusammenhang mit Modellen des maschinellen Lernens)

Artikeleinführung:BatchSize bezieht sich auf die Datenmenge, die das maschinelle Lernmodell jedes Mal während des Trainingsprozesses verwendet. Es teilt große Datenmengen in kleine Datenmengen für das Modelltraining und die Parameteraktualisierung auf. Diese Stapelverarbeitungsmethode trägt dazu bei, die Trainingseffizienz und Speichernutzung zu verbessern. Trainingsdaten werden für das Training normalerweise in Stapel unterteilt, und jeder Stapel enthält mehrere Proben. Die Chargengröße (Batchsize) bezieht sich auf die Anzahl der Proben, die in jeder Charge enthalten sind. Beim Training eines Modells hat die Batchgröße einen wichtigen Einfluss auf den Trainingsprozess. 1. Trainingsgeschwindigkeit Die Batchgröße (Batchgröße) hat einen Einfluss auf die Trainingsgeschwindigkeit des Modells. Eine größere Batchgröße kann Trainingsdaten schneller verarbeiten, da in jeder Epoche eine größere Batchgröße mehr Daten gleichzeitig verarbeiten kann.

2024-01-23

Kommentar 0

2241

So trainieren Sie Modelle mit Python mit Bildern anhand von Bildern

Artikeleinführung:Überblick über die Verwendung von Python zum Trainieren von Modellen für Bilder: Im Bereich Computer Vision ist die Verwendung von Deep-Learning-Modellen zur Klassifizierung von Bildern, zur Zielerkennung und für andere Aufgaben zu einer gängigen Methode geworden. Als weit verbreitete Programmiersprache bietet Python eine Fülle von Bibliotheken und Tools, die das Trainieren von Modellen anhand von Bildern relativ einfach machen. In diesem Artikel wird die Verwendung von Python und den zugehörigen Bibliotheken zum Trainieren von Modellen auf Bildern vorgestellt und entsprechende Codebeispiele bereitgestellt. Umgebungsvorbereitung: Bevor Sie beginnen, müssen Sie sicherstellen, dass Sie die Installation durchgeführt haben

2023-08-26

Kommentar 0

1663

ChatGPT Python-Modell-Schulungsleitfaden: Schritte zum Anpassen eines Chatbots

Artikeleinführung:ChatGPTPython-Modellschulungsleitfaden: Übersicht über die Schritte zum Anpassen von Chat-Robotern: In den letzten Jahren haben Chat-Roboter mit der zunehmenden Entwicklung der NLP-Technologie (Natural Language Processing) immer mehr Aufmerksamkeit auf sich gezogen. ChatGPT von OpenAI ist ein leistungsstarkes vorab trainiertes Sprachmodell, das zum Erstellen von Multi-Domain-Chatbots verwendet werden kann. In diesem Artikel werden die Schritte zur Verwendung von Python zum Trainieren des ChatGPT-Modells vorgestellt, einschließlich Datenvorbereitung, Modelltraining und Generierung von Dialogbeispielen. Schritt 1: Datenaufbereitung, -erfassung und -bereinigung

2023-10-24

Kommentar 0

1329

Ist es schwieriger, ein großes Modell zu trainieren, als den Himmel zu erreichen? Die vorab trainierte, benutzerfreundliche und hocheffiziente Modellbibliothek „Li Bai' ist da!

Artikeleinführung:Die LiBai-Modellbibliothek deckt die Vorteile aller gängigen Transformer-Bibliotheken wie Hugging Face, Megatron-LM, DeepSpeed und FairSeq ab und macht das Training großer Modelle für normale Menschen zugänglich. Es gibt so viele große Modelle. Sagen Sie mir, wie ich sie beschleunigen kann. Seit der Geburt von BERT im Jahr 2018 sind weiterhin Modelle mit Hunderten Millionen Parametern wie GPT-3 und ViT entstanden. Es ist keine Überraschung, dass die Anzahl der Parameter in KI-Modellen explodiert ist und Alchemisten keine Zeit mehr haben, sich darum zu kümmern sogar ein Taubheitsgefühl. Gleichzeitig stellen große Modelle große Anforderungen an die Rechen- und Speicherressourcen. Die Schulungskosten steigen stark an, beispielsweise durch die Verwendung eines sehr fortschrittlichen NVIDIA A

2023-04-09

Kommentar 0

1378

Das Prinzip und die Anwendung der Ablehnungsstichprobe beim Training großer Modelle

Artikeleinführung:Ablehnungsstichprobe ist eine gängige Technik beim Training großer Sprachmodelle. Es werden Stichproben basierend auf der Wahrscheinlichkeitsdichtefunktion der Zielverteilung durchgeführt, um Stichproben zu generieren, die zur Zielverteilung passen. Der Zweck der Ablehnungsstichprobe besteht darin, die Vielfalt der Trainingsdaten zu erhöhen und dadurch die Generalisierungsfähigkeit des Modells zu verbessern. Diese Methode ist beim Sprachmodelltraining besonders wichtig, da sie dem Modell dabei helfen kann, reichhaltigere und genauere Sprachausdrücke zu lernen. Durch den Verzicht auf Sampling kann das Modell Text aus verschiedenen Perspektiven und Stilen generieren, was ihn anpassungsfähiger und kreativer macht. Auf diese Weise kann das Modell bei der Verarbeitung verschiedener Texttypen das nächste Wort oder die nächste Phrase genauer vorhersagen und so die Generierungsqualität insgesamt verbessern. Die Anwendung der Ablehnungsstichprobe kann auch das Training erleichtern

2024-01-22

Kommentar 0

1287