Insgesamt10000 bezogener Inhalt gefunden

Python implementiert die automatische Seitenaktualisierung und die Funktionsanalyse geplanter Aufgaben für Headless-Browser-Sammlungsanwendungen

Artikeleinführung:Python implementiert die automatische Seitenaktualisierung und geplante Aufgabenfunktionsanalyse für Headless-Browser-Erfassungsanwendungen. Mit der schnellen Entwicklung des Netzwerks und der Popularisierung von Anwendungen ist die Erfassung von Webseitendaten immer wichtiger geworden. Der Headless-Browser ist eines der effektivsten Tools zum Sammeln von Webseitendaten. In diesem Artikel wird erläutert, wie Sie mit Python die automatische Seitenaktualisierung und geplante Aufgabenfunktionen eines Headless-Browsers implementieren. Der Headless-Browser übernimmt einen Browser-Betriebsmodus ohne grafische Oberfläche, der das menschliche Bedienverhalten auf automatisierte Weise simulieren kann, wodurch der Benutzer auf Webseiten zugreifen, auf Schaltflächen klicken und Informationen eingeben kann.

2023-08-08

Kommentar 0

1407

Wie verwende ich PHP-Funktionen für Web-Crawling und Datenerfassung?

Artikeleinführung:Wie verwende ich PHP-Funktionen für Web-Crawling und Datenerfassung? Mit der rasanten Entwicklung des Internets enthalten immer mehr Websites und Webseiten alle Arten von Daten, die wir benötigen. Webcrawler und Datenerfassung sind für uns zu einem gängigen Mittel geworden, um an diese Daten zu gelangen. In diesem Artikel werde ich die Verwendung von PHP-Funktionen für das Web-Crawling und die Datenerfassung vorstellen und relevante Codebeispiele geben. Grundprinzipien von Webcrawlern Webcrawler sind der Prozess des Erhaltens der erforderlichen Daten durch Simulieren von Netzwerkanforderungen, Anfordern und Analysieren von Webseiteninhalten. PHP bietet viele Funktionen

2023-07-25

Kommentar 0

1259

Analyse der Seitendaten-Caching- und inkrementellen Aktualisierungsfunktionen der Python-Implementierung für Headless-Browser-Sammlungsanwendungen

Artikeleinführung:Analyse der Seitendaten-Caching- und inkrementellen Aktualisierungsfunktionen für in Python implementierte Headless-Browser-Erfassungsanwendungen. Einführung: Angesichts der anhaltenden Beliebtheit von Netzwerkanwendungen erfordern viele Datenerfassungsaufgaben das Crawlen und Parsen von Webseiten. Der Headless-Browser kann die Webseite vollständig bedienen, indem er das Verhalten des Browsers simuliert, wodurch die Erfassung von Seitendaten einfach und effizient wird. In diesem Artikel wird die spezifische Implementierungsmethode der Verwendung von Python zum Implementieren der Seitendaten-Caching- und inkrementellen Aktualisierungsfunktionen einer Headless-Browser-Sammlungsanwendung vorgestellt und detaillierte Codebeispiele angehängt. 1. Grundprinzipien: kopflos

2023-08-08

Kommentar 0

811

Modularer Aufbau in PHP

Artikeleinführung:In den letzten Jahren, mit der rasanten Entwicklung der Internet-Technologie, wurde PHP als effiziente, leistungsstarke und flexible Web-Programmiersprache von immer mehr Entwicklern übernommen. Da es sich jedoch um eine serverseitige Sprache handelt, stellt die Wartung und Verwaltung des PHP-Codes bei großen Projekten eine große Herausforderung dar. Um dieses Problem zu lösen, begannen PHP-Entwickler, die Idee des modularen Designs zu übernehmen, um komplexe Anwendungen zu erstellen. In diesem Artikel wird das modulare Design in PHP ausführlich vorgestellt, einschließlich der Vorteile des modularen Designs, der Methoden zur Implementierung des modularen Designs und des modularen Designs

2023-05-28

Kommentar 0

1302

Welche Arten von Crawler-Modulen gibt es in PHP?

Artikeleinführung:Zu den PHP-Crawler-Modultypen gehören cURL, Simple HTML DOM, Goutte, PhantomJS, Selenium usw. Detaillierte Einführung: 1. cURL, das das Browserverhalten simulieren kann, um Webseiteninhalte einfach abzurufen; 2. Einfaches HTML-DOM, das HTML-Elemente über CSS-Selektoren oder XPath-Ausdrücke finden und extrahieren und die erforderlichen Daten einfach aus Webseiten extrahieren kann; 3. Goutte kann HTTP-Anfragen senden, Cookies verarbeiten, Formulare verarbeiten usw.

2023-09-01

Kommentar 0

1711

So öffnen Sie den Texteditor in Python

Artikeleinführung:In Python können Sie einen Texteditor öffnen, indem Sie das Subprocess-Modul verwenden, um jede ausführbare Datei, einschließlich eines Texteditors, zu öffnen. Verwenden Sie das Betriebssystemmodul, um Methoden für die Interaktion mit dem Betriebssystem bereitzustellen. Die spezifischen Funktionen variieren je nach Plattform. Verwenden Sie das Webbrowser-Modul, um Webseiten und Textdateien zu öffnen.

2024-05-05

Kommentar 0

719

【捷哥浅谈PHP】第十五弹-运用cURL获取网页内容

Artikeleinführung:

【捷哥浅谈PHP】第十五弹---使用cURL获取网页内容这几天在帮一些同学处理问题的时候,突然发现这些同学是使用file_get_contents()函数来采集页面内容的,貌似都没有curl的概念亦或是对这种工具特别不敏感,本文我来给大家详细介绍下cURL的简单的使用方法,下文我将会给大家详细介绍cURL的高级应用,好,废话不多说,我们先来

2016-06-13

Kommentar 0

871

smartcomb:用php实现的web模块拼合器

Artikeleinführung:smartcomb:用php实现的web模块拼合器。smartcomb是一个用php实现的web模块拼合器,相对于其他的代码拼合工具,如下特性: 可以拼合任意类型的文件,不限于js文件。 集中并声明依

2016-06-13

Kommentar 0

827

Anmerkungen zur PHP-Studie: Webcrawler und Datenerfassung

Artikeleinführung:Anmerkungen zur PHP-Studie: Webcrawler und Datenerfassung Einführung: Ein Webcrawler ist ein Tool, das automatisch Daten aus dem Internet crawlt. Es kann menschliches Verhalten simulieren, Webseiten durchsuchen und die erforderlichen Daten sammeln. Als beliebte serverseitige Skriptsprache spielt PHP auch im Bereich Webcrawler und Datenerfassung eine wichtige Rolle. In diesem Artikel wird erklärt, wie man einen Webcrawler mit PHP schreibt, und praktische Codebeispiele bereitgestellt. 1. Grundprinzipien von Webcrawlern Die Grundprinzipien von Webcrawlern bestehen darin, HTTP-Anfragen zu senden, die H-Antwort des Servers zu empfangen und zu analysieren.

2023-10-08

Kommentar 0

1286

Methoden zur Datenerfassung: Detaillierte Erläuterung von PHP und regulären Ausdrücken

Artikeleinführung:Methoden zum Sammeln von Daten: Detaillierte Erläuterung von PHP und regulären Ausdrücken Einführung: Im Zeitalter der modernen Technologie sind Datenerfassung und -verarbeitung zu einer sehr wichtigen Aufgabe geworden. Manchmal müssen wir die Daten, die uns wichtig sind, aus Webseiten, Textdateien oder anderen Datenquellen extrahieren. Um den Lesern zu helfen, die Datenerfassungsmethode besser zu verstehen und zu beherrschen, wird in diesem Artikel die Datenerfassungsmethode mit PHP und regulären Ausdrücken ausführlich vorgestellt und entsprechende Codebeispiele bereitgestellt. 1. Was ist ein regulärer Ausdruck? Reguläre Ausdrücke sind eine Textart, die zur Beschreibung von Mustern verwendet wird

2023-08-07

Kommentar 0

976

Ausführliche Interpretation: So optimieren Sie die Effizienz von PHP und regulären Ausdrücken bei der Verarbeitung gesammelter Daten

Artikeleinführung:Ausführliche Interpretation: So optimieren Sie die Effizienz von PHP und regulären Ausdrücken bei der Verarbeitung gesammelter Daten. Übersicht: Im Prozess von Webcrawlern und der Datenerfassung sind reguläre Ausdrücke ein häufig verwendetes Werkzeug zum Extrahieren der erforderlichen Daten aus Webinhalten. Bei groß angelegten Datenerfassungsvorgängen können jedoch Effizienzprobleme auftreten. In diesem Artikel erfahren Sie, wie Sie die Effizienz der Datenerfassung durch die Optimierung der Verwendung von PHP und regulären Ausdrücken verbessern können. 1. Datenbereinigung vor der Verwendung regulärer Ausdrücke. Vor dem Abgleich regulärer Ausdrücke können Sie eine Verarbeitung der Originaldaten durchführen, um die nachfolgende Leistung zu verbessern.

2023-08-06

Kommentar 0

1078

Wie verarbeitet man gesammelte Daten mit PHP und regulären Ausdrücken?

Artikeleinführung:Wie verarbeitet man gesammelte Daten mit PHP und regulären Ausdrücken? In der modernen Netzwerkumgebung sind Datenerfassung und -verarbeitung sehr wichtige Aufgaben. Ob es darum geht, Webseiteninformationen zu crawlen, Protokolldateien zu analysieren oder Textinhalte zu extrahieren, dafür sind Tools und Technologien erforderlich. Als beliebte serverseitige Skriptsprache wird PHP häufig in den Bereichen Webentwicklung und Datenverarbeitung eingesetzt. In diesem Artikel wird erläutert, wie die gesammelten Daten mithilfe von PHP und regulären Ausdrücken verarbeitet werden, um den Lesern bei der Lösung praktischer Probleme zu helfen. Zunächst müssen wir die Grundkonzepte und die Syntax regulärer Ausdrücke verstehen

2023-08-10

Kommentar 0

1582

Wie vereinfacht das PHP-Framework die Wartung und Verwaltung von E-Commerce-Websites?

Artikeleinführung:Das PHP-Framework vereinfacht die Wartung und Verwaltung von E-Commerce-Websites, indem es eine MVC-Architektur einsetzt, um Geschäftslogik, Benutzeroberfläche und Benutzerinteraktion für eine unabhängige Verwaltung zu trennen und so die Codeduplizierung zu reduzieren und die Website-Integration zu vereinfachen Content-Management-System (CMS), das es technisch nicht versiertem Personal ermöglicht, Website-Inhalte einfach zu verwalten; bietet Hilfstools und Befehle zur Automatisierung von Aufgaben und zur Vereinfachung von Bereitstellung, Updates und Wartung, beispielsweise durch EloquentORM, ArtisanCLI-Tools und die Scout-Suchmaschine Integration und Cashier Payment Gateway-Integration und andere Funktionen steigern die Effizienz der Website-Verwaltung weiter.

2024-06-06

Kommentar 0

442

Welchen Code kann eine PHP-Datei enthalten?

Artikeleinführung:PHP-Dateien können Code enthalten: 1. PHP-Code, der zum Ausführen verschiedener serverseitiger Aufgaben verwendet wird; 2. HTML-Code, der zum Definieren der Struktur und des Layouts der Webseite verwendet wird; 3. CSS-Code, der zum Definieren des Stils des Webs verwendet wird; 4. JavaScript-Code, der zum Implementieren verschiedener dynamischer Interaktionsfunktionen in Webseiten verwendet wird. 6. Die Datei enthält Code, der den Code modularisieren kann , wodurch schnell eine funktionsreiche Anwendung erstellt werden kann.

2023-08-01

Kommentar 0

1037

Bringen Sie Ihnen Schritt für Schritt bei, wie Sie mit PHP und phpSpider ein leistungsstarkes Crawler-System aufbauen!

Artikeleinführung:Bringen Sie Ihnen Schritt für Schritt bei, wie Sie mit PHP und phpSpider ein leistungsstarkes Crawler-System aufbauen! Einleitung: Mit der rasanten Entwicklung des Internets ist das Zeitalter der Informationsexplosion angebrochen. Um spezifische Informationen effizienter zu erhalten, entstanden Crawler-Systeme. In diesem Artikel erfahren Sie, wie Sie mit PHP und phpSpider ein leistungsstarkes Crawler-System erstellen, das Sie bei der automatisierten Erfassung von Informationen unterstützt. 1. Verstehen Sie das Crawler-System. Das Crawler-System, auch Webcrawler, Spider usw. genannt, ist ein Programm, das automatisch Webseiteninformationen sammelt. Durch Simulation des Browserverhaltens, Crawling

2023-07-22

Kommentar 0

1233

Wählen Sie ein flexibles PHP-Framework, das komponentenbasierte Entwicklung unterstützt

Artikeleinführung:Symfony und Laravel sind flexible PHP-Frameworks, die komponentenbasierte Entwicklung unterstützen: Symfony: bietet eine breite Palette an Komponenten, die nach Bedarf integriert werden können und eine hohe Anpassungsfähigkeit unterstützen. Laravel: Verwendet eine komponentenbasierte Architektur und stellt vorgefertigte Module bereit, die für allgemeine Entwicklungsaufgaben verwendet werden können. Die Komponenten können je nach Bedarf angepasst werden.

2024-06-02

Kommentar 0

1137

Verwendung von PHP und XML zur Implementierung der Webcrawler-Datenanalyse

Artikeleinführung:Implementierung der Datenanalyse von Webcrawlern mithilfe von PHP und XML Einführung: Mit der rasanten Entwicklung des Internets gibt es riesige Datenressourcen im Netzwerk, die für Analyse und Forschung in vielen Bereichen von großer Bedeutung sind. Als gängiges Datenerfassungstool können Webcrawler uns dabei helfen, die erforderlichen Daten automatisch von Webseiten zu crawlen. In diesem Artikel wird erläutert, wie Sie mithilfe von PHP und XML einen Webcrawler implementieren und die erfassten Daten analysieren. 1. Implementierung des PHP-Webcrawlers 1. Schrittanalyse der Hauptpakete der PHP-Webcrawler-Implementierung

2023-08-07

Kommentar 0

782

Welche Methoden gibt es, Crawler zu verhindern?

Artikeleinführung:Zu den Anti-Crawler-Methoden gehören Robots.txt-Text, User-Agent-Filterung, IP-Einschränkungen, Bestätigungscodes, dynamische Seitengenerierung, Häufigkeitsgrenzen, dynamische URL-Parameter und Anti-Crawler-Technologie. Detaillierte Einführung: 1. Robots.txt-Datei, die verwendet wird, um Suchmaschinen-Crawlern mitzuteilen, auf welche Seiten zugegriffen werden kann und auf welche Seiten der Zugriff verboten ist; 2. IP-Einschränkungen, die verwendet werden, um dem Server mitzuteilen, welcher Browser oder Crawler verwendet wird; , können Sie verhindern, dass einige böswillige Crawler umfangreiche Daten auf der Website usw. sammeln.

2023-10-12

Kommentar 0

1598

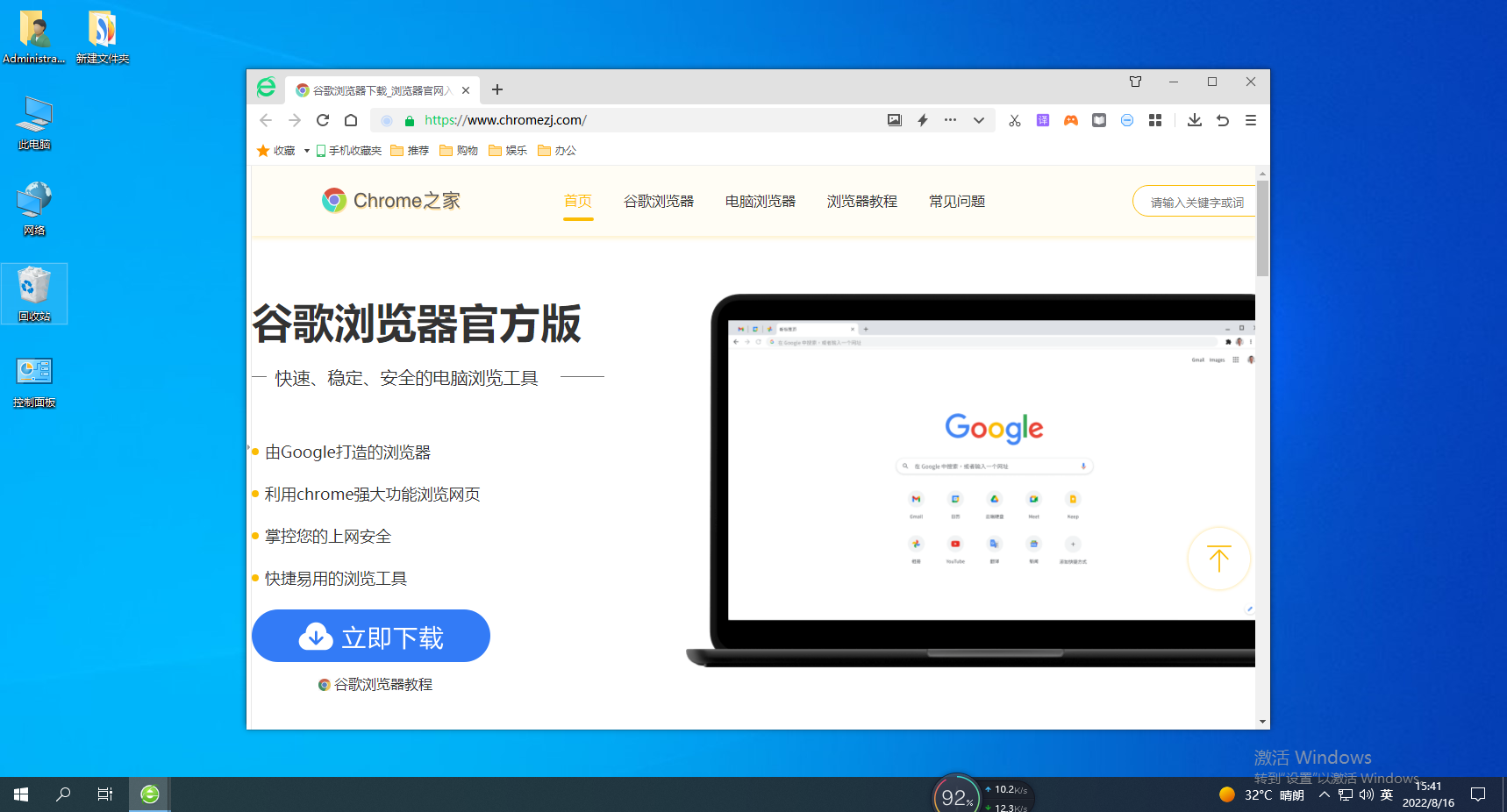

So aktivieren Sie die Geschwindigkeitsmoduseinstellungen im 360-Browser

Artikeleinführung:Wie stellt man den Geschwindigkeitsmodus des 360-Browsers ein? 360 verfügt über zwei Modi, die eingestellt werden können. Wie stellt man also den Geschwindigkeitsmodus ein? Der 360-Browser verfügt derzeit über einen Geschwindigkeitsmodus und einen Kompatibilitätsmodus. Der Geschwindigkeitsmodus verwendet den neuen Chromium86-Kernel, der Webseiten schneller öffnet. Wie sollten sie den Geschwindigkeitsmodus aktivieren? Im Einzelnen: Wie funktioniert das? Der Herausgeber unten hat die Schritte zum Einrichten des Geschwindigkeitsmodus im 360-Browser zusammengestellt. Wenn Sie nicht wissen, wie, folgen Sie mir und lesen Sie weiter! So stellen Sie den Geschwindigkeitsmodus des 360-Browsers ein: 1. Öffnen Sie den 360-Browser, rufen Sie die Benutzeroberfläche auf und öffnen Sie eine beliebige Webseite. 2. Klicken Sie auf den Blitz auf der rechten Seite des Suchfelds und wählen Sie den Geschwindigkeitsmodus aus. 3. Der Browser ist Jetzt im Geschwindigkeitsmodus

2024-01-30

Kommentar 0

1979