Insgesamt10000 bezogener Inhalt gefunden

ChatGPT Python-Modell-Schulungsleitfaden: Schritte zum Anpassen eines Chatbots

Artikeleinführung:ChatGPTPython-Modellschulungsleitfaden: Übersicht über die Schritte zum Anpassen von Chat-Robotern: In den letzten Jahren haben Chat-Roboter mit der zunehmenden Entwicklung der NLP-Technologie (Natural Language Processing) immer mehr Aufmerksamkeit auf sich gezogen. ChatGPT von OpenAI ist ein leistungsstarkes vorab trainiertes Sprachmodell, das zum Erstellen von Multi-Domain-Chatbots verwendet werden kann. In diesem Artikel werden die Schritte zur Verwendung von Python zum Trainieren des ChatGPT-Modells vorgestellt, einschließlich Datenvorbereitung, Modelltraining und Generierung von Dialogbeispielen. Schritt 1: Datenaufbereitung, -erfassung und -bereinigung

2023-10-24

Kommentar 0

1325

ChatGPT Python-Modell-Trainingsleitfaden: Integrieren Sie neue Fähigkeiten in Ihren Chatbot

Artikeleinführung:ChatGPTPython-Modellschulungsleitfaden: Das Einbringen neuer Fähigkeiten in Chatbots erfordert spezifische Codebeispiele. Einführung: In den letzten Jahren hat die rasante Entwicklung der Technologie der künstlichen Intelligenz dazu geführt, dass Chatbots in verschiedenen Bereichen weit verbreitet sind. Bestehende Chatbot-Modelle bieten jedoch häufig nur grundlegende Konversationsfunktionen und können nicht über intelligentere Fähigkeiten wie Fragebeantwortungs- und Empfehlungssysteme verfügen. Um dem Chatbot mehr Fähigkeiten zu verleihen, können wir das ChatGPT-Modell verwenden und das Modell über Python trainieren.

2023-10-24

Kommentar 0

1006

Training von Machine-Learning-Modellen mit C++: von der Datenvorverarbeitung bis zur Modellvalidierung

Artikeleinführung:Das Training eines ML-Modells in C++ umfasst die folgenden Schritte: Datenvorverarbeitung: Laden, Transformieren und Konstruieren der Daten. Modelltraining: Wählen Sie einen Algorithmus und trainieren Sie das Modell. Modellvalidierung: Partitionieren Sie den Datensatz, bewerten Sie die Leistung und optimieren Sie das Modell. Wenn Sie diese Schritte befolgen, können Sie Modelle für maschinelles Lernen in C++ erfolgreich erstellen, trainieren und validieren.

2024-06-01

Kommentar 0

652

So trainieren Sie Modelle mit Python mit Bildern anhand von Bildern

Artikeleinführung:Überblick über die Verwendung von Python zum Trainieren von Modellen für Bilder: Im Bereich Computer Vision ist die Verwendung von Deep-Learning-Modellen zur Klassifizierung von Bildern, zur Zielerkennung und für andere Aufgaben zu einer gängigen Methode geworden. Als weit verbreitete Programmiersprache bietet Python eine Fülle von Bibliotheken und Tools, die das Trainieren von Modellen anhand von Bildern relativ einfach machen. In diesem Artikel wird die Verwendung von Python und den zugehörigen Bibliotheken zum Trainieren von Modellen auf Bildern vorgestellt und entsprechende Codebeispiele bereitgestellt. Umgebungsvorbereitung: Bevor Sie beginnen, müssen Sie sicherstellen, dass Sie die Installation durchgeführt haben

2023-08-26

Kommentar 0

1648

Die Bedeutung der Batch-Größe und ihre Auswirkung auf das Training (im Zusammenhang mit Modellen des maschinellen Lernens)

Artikeleinführung:BatchSize bezieht sich auf die Datenmenge, die das maschinelle Lernmodell jedes Mal während des Trainingsprozesses verwendet. Es teilt große Datenmengen in kleine Datenmengen für das Modelltraining und die Parameteraktualisierung auf. Diese Stapelverarbeitungsmethode trägt dazu bei, die Trainingseffizienz und Speichernutzung zu verbessern. Trainingsdaten werden für das Training normalerweise in Stapel unterteilt, und jeder Stapel enthält mehrere Proben. Die Chargengröße (Batchsize) bezieht sich auf die Anzahl der Proben, die in jeder Charge enthalten sind. Beim Training eines Modells hat die Batchgröße einen wichtigen Einfluss auf den Trainingsprozess. 1. Trainingsgeschwindigkeit Die Batchgröße (Batchgröße) hat einen Einfluss auf die Trainingsgeschwindigkeit des Modells. Eine größere Batchgröße kann Trainingsdaten schneller verarbeiten, da in jeder Epoche eine größere Batchgröße mehr Daten gleichzeitig verarbeiten kann.

2024-01-23

Kommentar 0

2236

Die Open-Source-Erweiterungsbibliothek für verteiltes Training AToch von Ant erreicht eine effektive Auslastungsrate von 60 % der Rechenleistung für das Training großer Modelle

Artikeleinführung:Die Ant Group kündigte kürzlich die Einführung einer großen Erweiterungsbibliothek für verteilte Trainingsbeschleunigung mit dem Namen ATorch an, einem Open-Source-Tool. Das Ziel von ATorch besteht darin, die Intelligenz des Deep Learning durch automatische Optimierung der Ressourcendynamik und Verbesserung der verteilten Trainingsstabilität zu verbessern. Es versteht sich, dass ATorch beim Training großer Modelle die Rechenleistungsauslastung des Kilokalorien-Trainings von Hunderten Milliarden Modellen auf 60 % steigern kann, was dem Einbau eines leistungsstarken Motors in einen Sportwagen entspricht. Dies wird ein wichtiges Werkzeug für Deep-Learning-Forscher und -Entwickler sein, das ihnen hilft, große Modelle effizienter zu trainieren und zu optimieren. Abbildung: ATorch setzt sich dafür ein, das Training großer Modelle effizienter und reproduzierbarer zu machen. Mit der Explosion generativer großer Modelle ist der Umfang der Datensätze und Parameter für das Modelltraining exponentiell.

2024-01-14

Kommentar 0

1421

So implementieren Sie verteilte Algorithmen und Modelltraining in PHP-Microservices

Artikeleinführung:So implementieren Sie verteilte Algorithmen und Modelltraining in PHP-Microservices. Einführung: Mit der rasanten Entwicklung von Cloud Computing und Big-Data-Technologie steigt die Nachfrage nach Datenverarbeitung und Modelltraining. Verteilte Algorithmen und Modelltraining sind der Schlüssel zum Erreichen von Effizienz, Geschwindigkeit und Skalierbarkeit. In diesem Artikel wird die Implementierung verteilter Algorithmen und Modelltrainings in PHP-Microservices vorgestellt und einige spezifische Codebeispiele bereitgestellt. 1. Was ist verteiltes Algorithmus- und Modelltraining? Verteiltes Algorithmus- und Modelltraining ist eine Technologie, die mehrere Maschinen oder Serverressourcen verwendet, um Datenverarbeitung und Modelltraining gleichzeitig durchzuführen.

2023-09-25

Kommentar 0

1453

Detaillierte Erläuterung des Deep-Learning-Pre-Training-Modells in Python

Artikeleinführung:Mit der Entwicklung von künstlicher Intelligenz und Deep Learning sind Pre-Training-Modelle zu einer beliebten Technologie in der Verarbeitung natürlicher Sprache (NLP), Computer Vision (CV), Spracherkennung und anderen Bereichen geworden. Als eine der derzeit beliebtesten Programmiersprachen spielt Python natürlich eine wichtige Rolle bei der Anwendung vorab trainierter Modelle. Dieser Artikel konzentriert sich auf das Deep-Learning-Pre-Training-Modell in Python, einschließlich seiner Definition, Typen, Anwendungen und der Verwendung des Pre-Training-Modells. Was ist ein vorab trainiertes Modell? Die Hauptschwierigkeit von Deep-Learning-Modellen besteht darin, eine große Anzahl qualitativ hochwertiger Modelle zu analysieren

2023-06-11

Kommentar 0

2007

Was ist das PHP-Trainingsmodell?

Artikeleinführung:Das PHP-Schulungsmodell ist: 1. Verfeinerter Unterricht Das allgemeine Modell besteht aus Unterricht am Vormittag und Selbstübungen am Nachmittag mit der Unterstützung erfahrener Dozenten. 2. Diese PHP-Schulungen umfassen tatsächliche Projekte mit Unternehmen, an denen Auszubildende teilnehmen können Genießen Sie in ihnen die Beschäftigungsressourcen, Projektressourcen und gewonnenen Erkenntnisse.

2020-02-21

Kommentar 0

2406

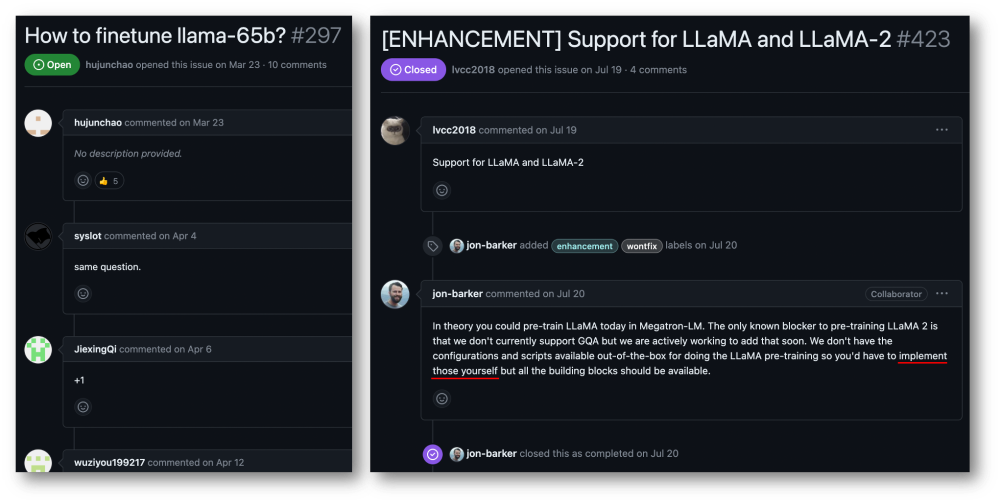

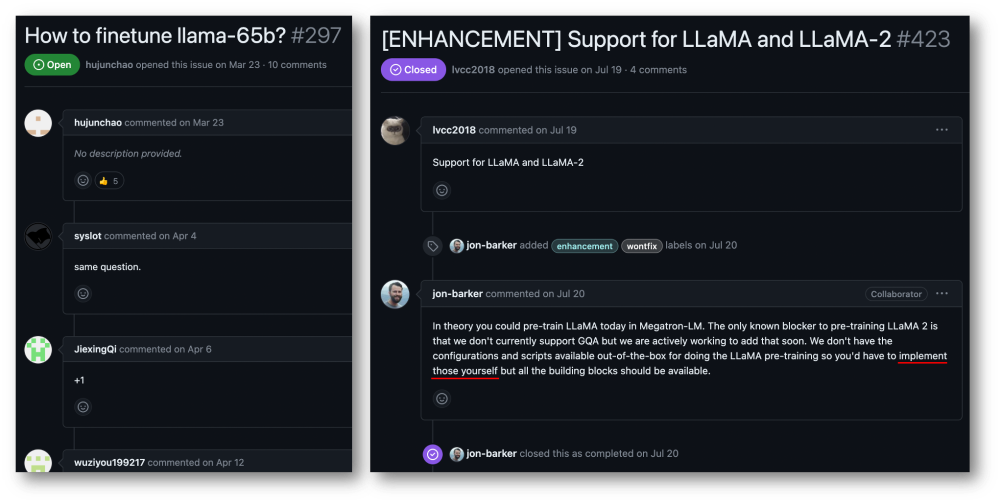

32 Karten, 176 % Trainingsbeschleunigung, Open-Source-Trainingsframework für große Modelle Megatron-LLaMA ist da

Artikeleinführung:Die Taotian Group und Aicheng Technology haben am 12. September offiziell das Open-Source-Schulungsframework für große Modelle – Megatron-LLaMA – veröffentlicht. Ziel dieses Frameworks ist es, Technologieentwicklern die Möglichkeit zu geben, die Trainingsleistung großer Sprachmodelle einfacher zu verbessern, die Trainingskosten zu senken und die Kompatibilität mit der LLaMA-Community aufrechtzuerhalten. Die Testergebnisse zeigen, dass Megatron-LLaMA beim 32-Karten-Training eine Beschleunigung von 176 % im Vergleich zur direkt auf HuggingFace erhaltenen Codeversion erreichen kann. Beim groß angelegten Training dehnt sich Megatron-LLaMA nahezu linear aus und zeigt eine hohe Instabilität im Netzwerk Maß an Toleranz. Derzeit wurde Megatron-LLaMA in der Open-Source-Community unter der Open-Source-Adresse https: gestartet.

2023-09-14

Kommentar 0

633

Wie beschleunigt das Java-Framework das Training von Modellen für künstliche Intelligenz?

Artikeleinführung:Das Java-Framework kann das Training künstlicher Intelligenzmodelle beschleunigen, indem es TensorFlowServing verwendet, um vorab trainierte Modelle für schnelle Inferenzen bereitzustellen; Verwendung von H2OAIDriverlessAI, um den Trainingsprozess zu automatisieren, und Verwendung von SparkMLlib, um verteiltes Training und große Datenmengen zu implementieren auf der Apache Spark-Architektur Set-Verarbeitung.

2024-06-04

Kommentar 0

903

Verwendung von JavaScript-Funktionen zur Implementierung des Modelltrainings für maschinelles Lernen

Artikeleinführung:Verwenden von JavaScript-Funktionen zur Implementierung des Modelltrainings für maschinelles Lernen Mit der rasanten Entwicklung des maschinellen Lernens haben viele Entwickler begonnen, darauf zu achten, wie JavaScript zur Implementierung des Modelltrainings für maschinelles Lernen im Frontend verwendet werden kann. In diesem Artikel wird erläutert, wie JavaScript-Funktionen zum Implementieren eines Modelltrainings für maschinelles Lernen verwendet werden, und es werden spezifische Codebeispiele bereitgestellt. Bevor wir beginnen, müssen wir einige wichtige Konzepte verstehen. Datensatz: Das Modelltraining für maschinelles Lernen erfordert einen Satz gekennzeichneter Datensätze als Eingabe. Der Datensatz besteht aus

2023-11-03

Kommentar 0

1189

Übertragen Sie Lernanwendungen und gängige Technologien in das Training großer Sprachmodelle

Artikeleinführung:Große Sprachmodelle beziehen sich auf Modelle zur Verarbeitung natürlicher Sprache mit mehr als 100 Millionen Parametern. Aufgrund ihrer schieren Größe und Komplexität erfordert das Training eines solchen Modells erhebliche Rechenressourcen und Daten. Daher ist Transferlernen zu einer wichtigen Methode zum Training großer Sprachmodelle geworden. Durch die Nutzung vorhandener Modelle und Daten kann der Trainingsprozess beschleunigt und die Leistung verbessert werden. Transferlernen kann die Parameter und das Wissen von Modellen, die für andere Aufgaben trainiert wurden, auf die Zielaufgabe übertragen und so den Datenbedarf und die Trainingszeit reduzieren. Dieser Ansatz wird sowohl in der Forschung als auch in der Industrie häufig eingesetzt und legt den Grundstein für die Entwicklung leistungsfähigerer Sprachmodelle. Transferlernen ist eine Methode, die ein bereits trainiertes Modell verwendet, um seine Parameter oder einige Komponenten bei der Lösung anderer Aufgaben anzupassen. Im Bereich der Verarbeitung natürlicher Sprache kann Transferlernen erfolgen

2024-01-22

Kommentar 0

932

Für 1.890 US-Dollar können Sie ein anständiges Diffusionsmodell mit 1,2 Milliarden Parametern von Grund auf trainieren.

Artikeleinführung:Mit nur 1.890 US-Dollar und 37 Millionen Bildern können Sie ein anständiges Verbreitungsmodell trainieren. Derzeit eignen sich visionäre generative Modelle gut für die Erstellung realistischer visueller Inhalte, allerdings sind die Kosten und der Aufwand, diese Modelle von Grund auf zu trainieren, nach wie vor hoch. StableDiffusion2.1 benötigte beispielsweise 200.000 A100GPU-Stunden. Selbst wenn Forscher die fortschrittlichste Methode verwenden, dauert das Training auf einer 8×H100-GPU immer noch mehr als einen Monat. Darüber hinaus stellt das Training großer Modelle auch Herausforderungen für Datensätze dar. Diese Daten liegen grundsätzlich in Einheiten von Hunderten von Millionen vor, was auch Herausforderungen für das Training von Modellen mit sich bringt. Hohe Schulungskosten und Anforderungen an den Datensatz stellen unüberwindbare Hindernisse für die Entwicklung groß angelegter Diffusionsmodelle dar. Jetzt von Sony AI und mehr

2024-07-29

Kommentar 0

534

Welches ist die Wahl zwischen PHP- und Python-Training?

Artikeleinführung:Im Vergleich zu PHP-Training und Python-Training ist das größte Merkmal von Python, dass es leicht zu verstehen, einfach zu verwenden und leistungsstark ist. Es ist auch die ideale Wahl, um in die Programmierwelt einzusteigen In vielen Bereichen kann die Python-Sprache eingesetzt werden. Der Entwicklungsraum ist ebenfalls sehr groß und das Gehalt ist ebenfalls sehr hoch.

2020-02-27

Kommentar 0

2968

Trainieren Sie das YOLOv7-Modell und entwickeln Sie eine KI-Branderkennung

Artikeleinführung:1. Bereiten Sie den Datensatz vor. Der Datensatz verwendet Open-Source-Bilder mit insgesamt 6.000 Brandbildern, die mit Rauch und Feuer markiert sind. Das Fire and Smoke-Projekt verwendet YOLO für das Training. Ich habe die Daten in das YOLO-Format konvertiert und in einen Trainingssatz und einen Verifizierungssatz unterteilt. 2. Informationen zum Schulungsprozess finden Sie in der Dokumentation der offiziellen Website von YOLOv7. Ändern Sie die Datei data/coco.yaml und konfigurieren Sie den Pfad und die Kategorie der Trainingsdaten. Laden Sie das vorab trainierte Modell yolov7.pt herunter und beginnen Sie mit dem Training. 3. Suchen Sie nach Abschluss des Brandüberwachungstrainings die generierte Modelldatei-best.pt im Ausführungsverzeichnis unter dem Verzeichnis yolov7. ich trainiere

2023-05-11

Kommentar 0

992

Mininglamp Technology veröffentlicht die kostenlose Open-Source-Datei TensorBoard.cpp, um das Vortraining großer Modelle zu erleichtern

Artikeleinführung:Kürzlich hat die Mininglamp Technology Group die C++-Schnittstelle von TensorBoard implementiert, einem Visualisierungstool für maschinelles Lernen, das den Werkzeugsatz großer Modellprojekte auf Basis von C++ weiter bereichert und die Überwachung des Pre-Training-Prozesses großer Modelle komfortabler und effizienter macht Beschleunigung der Vorschulung großer Modelle im Marketingbereich. Das Tool ist Open Source auf Github. TensorBoard ist ein von Google entwickeltes Visualisierungstool für maschinelles Lernen und wird häufig zur Überwachung verschiedener Indikatoren des maschinellen Lernprozesses verwendet. Zhao Liang, leitender technischer Direktor von Mininglamp Technology, sagte: „Im Prozess des Trainings großer Modelle ist die Datenüberwachung eine wichtige Dimension, und TensorBoard visualisiert verschiedene Parameter und Ergebnisse im Modell, wie z. B. die Aufzeichnung von Verluständerungen und Verifizierungssätzen während des Großen.“ Modelltrainingsprozess.

2023-08-14

Kommentar 0

816

Wissenskomprimierung: Modelldestillation und Modellbereinigung

Artikeleinführung:Modelldestillation und -bereinigung sind Technologien zur Modellkomprimierung neuronaler Netzwerke, die Parameter und Rechenkomplexität effektiv reduzieren und die Betriebseffizienz und Leistung verbessern. Die Modelldestillation verbessert die Leistung, indem sie ein kleineres Modell auf einem größeren Modell trainiert und so Wissen überträgt. Durch das Bereinigen wird die Modellgröße reduziert, indem redundante Verbindungen und Parameter entfernt werden. Diese beiden Techniken sind für die Modellkomprimierung und -optimierung sehr nützlich. Modelldestillation Die Modelldestillation ist eine Technik, die die Vorhersagekraft eines großen Modells durch Training eines kleineren Modells reproduziert. Das große Modell wird „Lehrermodell“ und das kleine Modell „Schülermodell“ genannt. Lehrermodelle verfügen in der Regel über mehr Parameter und Komplexität und passen daher besser zu den Trainings- und Testdaten. Bei der Modelldestillation wird das Schülermodell darauf trainiert, das vorhergesagte Verhalten des Lehrermodells zu imitieren, um mit einem kleineren Modell eine bessere Leistung zu erzielen.

2024-01-23

Kommentar 0

766

Methoden zum adaptiven Training von ML-Modellen

Artikeleinführung:Die adaptive Methode bezieht sich auf die Verwendung dynamischer Anpassungstechnologie in Modellen für maschinelles Lernen, um eine Selbstanpassung und Verbesserung des Modells zu erreichen. Mit diesen Methoden können sich Modelle auf der Grundlage von Echtzeitdaten und Umgebungsveränderungen anpassen und so die Leistung verbessern und sich an neue Situationen anpassen. Zu den gängigen adaptiven Methoden gehören Parameteranpassung, Lernratenanpassung, Funktionsauswahl und Modellintegration. Diese Methoden können dazu beitragen, dass sich das Modell an verschiedene Aufgaben und Umgebungen anpasst, wodurch die Genauigkeit und Robustheit des Modells verbessert wird. Inkrementelles Lernen ist eine Methode, die kontinuierlich neue Trainingsbeispiele einführt, um Modellparameter zu aktualisieren. Im Vergleich zur Neuschulung des gesamten Modells vermeidet inkrementelles Lernen die Verschwendung von Rechenressourcen und Zeit. Durch das kontinuierliche Hinzufügen neuer Stichproben kann sich das Modell schrittweise an neue Daten anpassen und die Leistung verbessern, während die Wirksamkeit der ursprünglichen Parameter erhalten bleibt. diese Methode

2024-01-23

Kommentar 0

1142