Insgesamt10000 bezogener Inhalt gefunden

So trainieren Sie Modelle mit Python mit Bildern anhand von Bildern

Artikeleinführung:Überblick über die Verwendung von Python zum Trainieren von Modellen für Bilder: Im Bereich Computer Vision ist die Verwendung von Deep-Learning-Modellen zur Klassifizierung von Bildern, zur Zielerkennung und für andere Aufgaben zu einer gängigen Methode geworden. Als weit verbreitete Programmiersprache bietet Python eine Fülle von Bibliotheken und Tools, die das Trainieren von Modellen anhand von Bildern relativ einfach machen. In diesem Artikel wird die Verwendung von Python und den zugehörigen Bibliotheken zum Trainieren von Modellen auf Bildern vorgestellt und entsprechende Codebeispiele bereitgestellt. Umgebungsvorbereitung: Bevor Sie beginnen, müssen Sie sicherstellen, dass Sie die Installation durchgeführt haben

2023-08-26

Kommentar 0

1647

Trainingszeitproblem des Deep-Learning-Modells

Artikeleinführung:Einführung in die Trainingszeitproblematik von Deep-Learning-Modellen: Mit der Entwicklung von Deep Learning haben Deep-Learning-Modelle in verschiedenen Bereichen bemerkenswerte Ergebnisse erzielt. Allerdings ist die Trainingszeit von Deep-Learning-Modellen ein häufiges Problem. Bei großen Datensätzen und komplexen Netzwerkstrukturen erhöht sich die Trainingszeit von Deep-Learning-Modellen deutlich. In diesem Artikel wird das Problem der Trainingszeit von Deep-Learning-Modellen erörtert und spezifische Codebeispiele gegeben. Paralleles Computing beschleunigt die Trainingszeit Der Trainingsprozess von Deep-Learning-Modellen erfordert normalerweise eine große Menge an Rechenressourcen und Zeit. Um das Training zu beschleunigen

2023-10-09

Kommentar 0

1736

ChatGPT Python-Modell-Schulungsleitfaden: Schritte zum Anpassen eines Chatbots

Artikeleinführung:ChatGPTPython-Modellschulungsleitfaden: Übersicht über die Schritte zum Anpassen von Chat-Robotern: In den letzten Jahren haben Chat-Roboter mit der zunehmenden Entwicklung der NLP-Technologie (Natural Language Processing) immer mehr Aufmerksamkeit auf sich gezogen. ChatGPT von OpenAI ist ein leistungsstarkes vorab trainiertes Sprachmodell, das zum Erstellen von Multi-Domain-Chatbots verwendet werden kann. In diesem Artikel werden die Schritte zur Verwendung von Python zum Trainieren des ChatGPT-Modells vorgestellt, einschließlich Datenvorbereitung, Modelltraining und Generierung von Dialogbeispielen. Schritt 1: Datenaufbereitung, -erfassung und -bereinigung

2023-10-24

Kommentar 0

1324

Training von Machine-Learning-Modellen mit C++: von der Datenvorverarbeitung bis zur Modellvalidierung

Artikeleinführung:Das Training eines ML-Modells in C++ umfasst die folgenden Schritte: Datenvorverarbeitung: Laden, Transformieren und Konstruieren der Daten. Modelltraining: Wählen Sie einen Algorithmus und trainieren Sie das Modell. Modellvalidierung: Partitionieren Sie den Datensatz, bewerten Sie die Leistung und optimieren Sie das Modell. Wenn Sie diese Schritte befolgen, können Sie Modelle für maschinelles Lernen in C++ erfolgreich erstellen, trainieren und validieren.

2024-06-01

Kommentar 0

652

Wie beschleunigt das Java-Framework das Training von Modellen für künstliche Intelligenz?

Artikeleinführung:Das Java-Framework kann das Training künstlicher Intelligenzmodelle beschleunigen, indem es TensorFlowServing verwendet, um vorab trainierte Modelle für schnelle Inferenzen bereitzustellen; Verwendung von H2OAIDriverlessAI, um den Trainingsprozess zu automatisieren, und Verwendung von SparkMLlib, um verteiltes Training und große Datenmengen zu implementieren auf der Apache Spark-Architektur Set-Verarbeitung.

2024-06-04

Kommentar 0

903

Die Auswirkungen der Datenknappheit auf das Modelltraining

Artikeleinführung:Die Auswirkungen der Datenknappheit auf das Modelltraining erfordern spezifische Codebeispiele. In den Bereichen maschinelles Lernen und künstliche Intelligenz sind Daten eines der Kernelemente für das Training von Modellen. Ein Problem, mit dem wir in der Realität jedoch häufig konfrontiert sind, ist die Datenknappheit. Unter Datenknappheit versteht man die unzureichende Menge an Trainingsdaten oder das Fehlen annotierter Daten. In diesem Fall hat dies einen gewissen Einfluss auf das Modelltraining. Das Problem der Datenknappheit spiegelt sich hauptsächlich in den folgenden Aspekten wider: Überanpassung: Wenn die Menge an Trainingsdaten nicht ausreicht, ist das Modell anfällig für Überanpassung. Überanpassung bezieht sich auf eine übermäßige Anpassung des Modells an die Trainingsdaten.

2023-10-08

Kommentar 0

1403

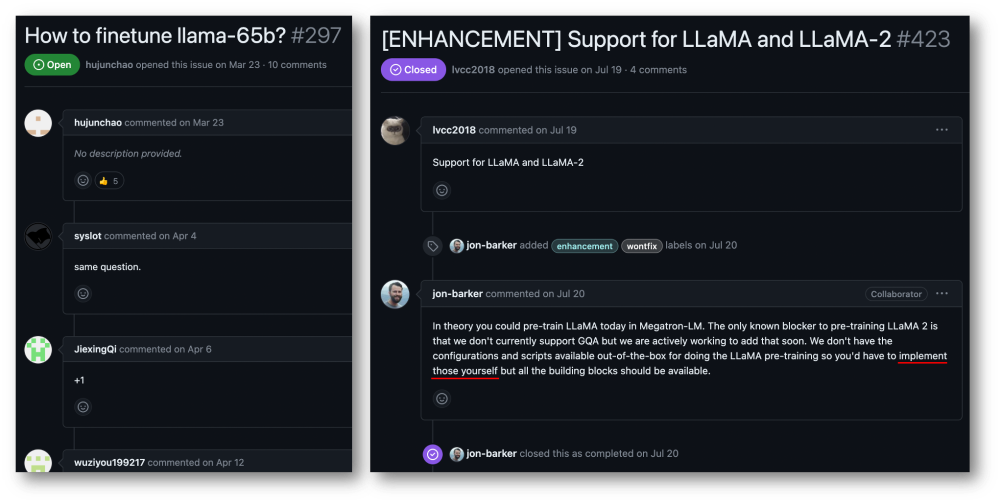

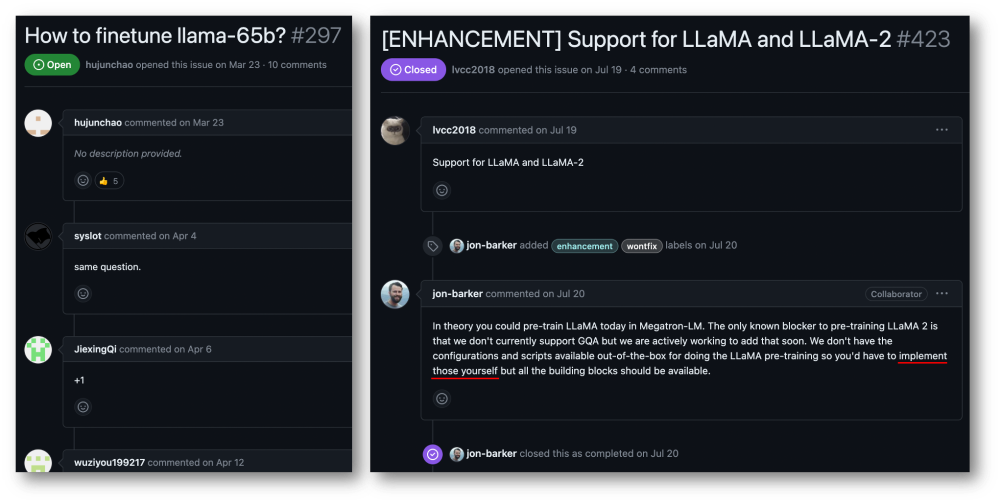

32 Karten, 176 % Trainingsbeschleunigung, Open-Source-Trainingsframework für große Modelle Megatron-LLaMA ist da

Artikeleinführung:Die Taotian Group und Aicheng Technology haben am 12. September offiziell das Open-Source-Schulungsframework für große Modelle – Megatron-LLaMA – veröffentlicht. Ziel dieses Frameworks ist es, Technologieentwicklern die Möglichkeit zu geben, die Trainingsleistung großer Sprachmodelle einfacher zu verbessern, die Trainingskosten zu senken und die Kompatibilität mit der LLaMA-Community aufrechtzuerhalten. Die Testergebnisse zeigen, dass Megatron-LLaMA beim 32-Karten-Training eine Beschleunigung von 176 % im Vergleich zur direkt auf HuggingFace erhaltenen Codeversion erreichen kann. Beim groß angelegten Training dehnt sich Megatron-LLaMA nahezu linear aus und zeigt eine hohe Instabilität im Netzwerk Maß an Toleranz. Derzeit wurde Megatron-LLaMA in der Open-Source-Community unter der Open-Source-Adresse https: gestartet.

2023-09-14

Kommentar 0

633

Das Llama3-Training stürzt alle 3 Stunden ab? Big Bean Bag-Modell und HKU-Team verbessern das knusprige Wanka-Training

Artikeleinführung:Da die Iterationsgeschwindigkeit großer Modelle immer schneller wird, wird der Umfang der Trainingscluster immer größer und hochfrequente Software- und Hardwarefehler sind zu einem Problem geworden, das die weitere Verbesserung der Trainingseffizienz behindert Die Speicherung und Wiederherstellung des Zustands während des Trainingsprozesses ist zum Schlüssel zur Überwindung von Trainingsfehlern, zur Sicherstellung des Trainingsfortschritts und zur Verbesserung der Trainingseffizienz geworden. Kürzlich haben das ByteDance Beanbao-Modellteam und die Universität Hongkong gemeinsam ByteCheckpoint vorgeschlagen. Hierbei handelt es sich um ein in PyTorch natives Checkpointing-System für große Modelle, das mit mehreren Trainingsframeworks kompatibel ist und das effiziente Lesen und Schreiben von Checkpoints sowie die automatische Neusegmentierung unterstützt. Im Vergleich zu vorhandenen Methoden weist es erhebliche Leistungsverbesserungen und Benutzerfreundlichkeitsvorteile auf. In diesem Artikel wird das Training großer Modelle vorgestellt

2024-08-08

Kommentar 0

611

So implementieren Sie verteilte Algorithmen und Modelltraining in PHP-Microservices

Artikeleinführung:So implementieren Sie verteilte Algorithmen und Modelltraining in PHP-Microservices. Einführung: Mit der rasanten Entwicklung von Cloud Computing und Big-Data-Technologie steigt die Nachfrage nach Datenverarbeitung und Modelltraining. Verteilte Algorithmen und Modelltraining sind der Schlüssel zum Erreichen von Effizienz, Geschwindigkeit und Skalierbarkeit. In diesem Artikel wird die Implementierung verteilter Algorithmen und Modelltrainings in PHP-Microservices vorgestellt und einige spezifische Codebeispiele bereitgestellt. 1. Was ist verteiltes Algorithmus- und Modelltraining? Verteiltes Algorithmus- und Modelltraining ist eine Technologie, die mehrere Maschinen oder Serverressourcen verwendet, um Datenverarbeitung und Modelltraining gleichzeitig durchzuführen.

2023-09-25

Kommentar 0

1453

Die Open-Source-Erweiterungsbibliothek für verteiltes Training AToch von Ant erreicht eine effektive Auslastungsrate von 60 % der Rechenleistung für das Training großer Modelle

Artikeleinführung:Die Ant Group kündigte kürzlich die Einführung einer großen Erweiterungsbibliothek für verteilte Trainingsbeschleunigung mit dem Namen ATorch an, einem Open-Source-Tool. Das Ziel von ATorch besteht darin, die Intelligenz des Deep Learning durch automatische Optimierung der Ressourcendynamik und Verbesserung der verteilten Trainingsstabilität zu verbessern. Es versteht sich, dass ATorch beim Training großer Modelle die Rechenleistungsauslastung des Kilokalorien-Trainings von Hunderten Milliarden Modellen auf 60 % steigern kann, was dem Einbau eines leistungsstarken Motors in einen Sportwagen entspricht. Dies wird ein wichtiges Werkzeug für Deep-Learning-Forscher und -Entwickler sein, das ihnen hilft, große Modelle effizienter zu trainieren und zu optimieren. Abbildung: ATorch setzt sich dafür ein, das Training großer Modelle effizienter und reproduzierbarer zu machen. Mit der Explosion generativer großer Modelle ist der Umfang der Datensätze und Parameter für das Modelltraining exponentiell.

2024-01-14

Kommentar 0

1421

Verwendung von JavaScript-Funktionen zur Implementierung des Modelltrainings für maschinelles Lernen

Artikeleinführung:Verwenden von JavaScript-Funktionen zur Implementierung des Modelltrainings für maschinelles Lernen Mit der rasanten Entwicklung des maschinellen Lernens haben viele Entwickler begonnen, darauf zu achten, wie JavaScript zur Implementierung des Modelltrainings für maschinelles Lernen im Frontend verwendet werden kann. In diesem Artikel wird erläutert, wie JavaScript-Funktionen zum Implementieren eines Modelltrainings für maschinelles Lernen verwendet werden, und es werden spezifische Codebeispiele bereitgestellt. Bevor wir beginnen, müssen wir einige wichtige Konzepte verstehen. Datensatz: Das Modelltraining für maschinelles Lernen erfordert einen Satz gekennzeichneter Datensätze als Eingabe. Der Datensatz besteht aus

2023-11-03

Kommentar 0

1189

Übertragen Sie Lernanwendungen und gängige Technologien in das Training großer Sprachmodelle

Artikeleinführung:Große Sprachmodelle beziehen sich auf Modelle zur Verarbeitung natürlicher Sprache mit mehr als 100 Millionen Parametern. Aufgrund ihrer schieren Größe und Komplexität erfordert das Training eines solchen Modells erhebliche Rechenressourcen und Daten. Daher ist Transferlernen zu einer wichtigen Methode zum Training großer Sprachmodelle geworden. Durch die Nutzung vorhandener Modelle und Daten kann der Trainingsprozess beschleunigt und die Leistung verbessert werden. Transferlernen kann die Parameter und das Wissen von Modellen, die für andere Aufgaben trainiert wurden, auf die Zielaufgabe übertragen und so den Datenbedarf und die Trainingszeit reduzieren. Dieser Ansatz wird sowohl in der Forschung als auch in der Industrie häufig eingesetzt und legt den Grundstein für die Entwicklung leistungsfähigerer Sprachmodelle. Transferlernen ist eine Methode, die ein bereits trainiertes Modell verwendet, um seine Parameter oder einige Komponenten bei der Lösung anderer Aufgaben anzupassen. Im Bereich der Verarbeitung natürlicher Sprache kann Transferlernen erfolgen

2024-01-22

Kommentar 0

932

Die Bedeutung der Batch-Größe und ihre Auswirkung auf das Training (im Zusammenhang mit Modellen des maschinellen Lernens)

Artikeleinführung:BatchSize bezieht sich auf die Datenmenge, die das maschinelle Lernmodell jedes Mal während des Trainingsprozesses verwendet. Es teilt große Datenmengen in kleine Datenmengen für das Modelltraining und die Parameteraktualisierung auf. Diese Stapelverarbeitungsmethode trägt dazu bei, die Trainingseffizienz und Speichernutzung zu verbessern. Trainingsdaten werden für das Training normalerweise in Stapel unterteilt, und jeder Stapel enthält mehrere Proben. Die Chargengröße (Batchsize) bezieht sich auf die Anzahl der Proben, die in jeder Charge enthalten sind. Beim Training eines Modells hat die Batchgröße einen wichtigen Einfluss auf den Trainingsprozess. 1. Trainingsgeschwindigkeit Die Batchgröße (Batchgröße) hat einen Einfluss auf die Trainingsgeschwindigkeit des Modells. Eine größere Batchgröße kann Trainingsdaten schneller verarbeiten, da in jeder Epoche eine größere Batchgröße mehr Daten gleichzeitig verarbeiten kann.

2024-01-23

Kommentar 0

2235

Die Bedeutung der Datenvorverarbeitung beim Modelltraining

Artikeleinführung:Die Bedeutung der Datenvorverarbeitung beim Modelltraining und spezifische Codebeispiele Einführung: Beim Training von Modellen für maschinelles Lernen und Deep Learning ist die Datenvorverarbeitung ein sehr wichtiges und wesentliches Bindeglied. Der Zweck der Datenvorverarbeitung besteht darin, Rohdaten durch eine Reihe von Verarbeitungsschritten in eine für das Modelltraining geeignete Form umzuwandeln, um die Leistung und Genauigkeit des Modells zu verbessern. Ziel dieses Artikels ist es, die Bedeutung der Datenvorverarbeitung beim Modelltraining zu diskutieren und einige häufig verwendete Codebeispiele für die Datenvorverarbeitung zu geben. 1. Die Bedeutung der Datenvorverarbeitung. Datenbereinigung. Datenbereinigung ist die

2023-10-08

Kommentar 0

1284

Für 1.890 US-Dollar können Sie ein anständiges Diffusionsmodell mit 1,2 Milliarden Parametern von Grund auf trainieren.

Artikeleinführung:Mit nur 1.890 US-Dollar und 37 Millionen Bildern können Sie ein anständiges Verbreitungsmodell trainieren. Derzeit eignen sich visionäre generative Modelle gut für die Erstellung realistischer visueller Inhalte, allerdings sind die Kosten und der Aufwand, diese Modelle von Grund auf zu trainieren, nach wie vor hoch. StableDiffusion2.1 benötigte beispielsweise 200.000 A100GPU-Stunden. Selbst wenn Forscher die fortschrittlichste Methode verwenden, dauert das Training auf einer 8×H100-GPU immer noch mehr als einen Monat. Darüber hinaus stellt das Training großer Modelle auch Herausforderungen für Datensätze dar. Diese Daten liegen grundsätzlich in Einheiten von Hunderten von Millionen vor, was auch Herausforderungen für das Training von Modellen mit sich bringt. Hohe Schulungskosten und Anforderungen an den Datensatz stellen unüberwindbare Hindernisse für die Entwicklung groß angelegter Diffusionsmodelle dar. Jetzt von Sony AI und mehr

2024-07-29

Kommentar 0

534

Apple verwendet autoregressive Sprachmodelle, um Bildmodelle vorab zu trainieren

Artikeleinführung:1. Hintergrund Nach dem Aufkommen großer Modelle wie GPT hat die autoregressive Modellierungsmethode Transformer + des Sprachmodells, bei der es sich um die Vortrainingsaufgabe zur Vorhersage von nexttoken handelt, große Erfolge erzielt. Kann diese autoregressive Modellierungsmethode also bessere Ergebnisse in visuellen Modellen erzielen? Der heute vorgestellte Artikel ist ein kürzlich von Apple veröffentlichter Artikel über das Training eines visuellen Modells basierend auf Transformer + autoregressivem Vortraining. Lassen Sie mich Ihnen diese Arbeit vorstellen. Titel des Bildpapiers: ScalablePre-trainingofLargeAutoregressiveImageModels Download-Adresse: https://ar

2024-01-29

Kommentar 0

1014