Kurs Dazwischenliegend 11388

Kurseinführung:„Selbststudium IT-Netzwerk-Linux-Lastausgleich-Video-Tutorial“ implementiert hauptsächlich den Linux-Lastausgleich durch Ausführen von Skriptvorgängen im Web, LVS und Linux unter Nagin.

Kurs Fortschrittlich 17699

Kurseinführung:„Shang Xuetang MySQL Video Tutorial“ führt Sie in den Prozess von der Installation bis zur Verwendung der MySQL-Datenbank ein und stellt die spezifischen Vorgänge jedes Links im Detail vor.

Kurs Fortschrittlich 11397

Kurseinführung:„Brothers Band Front-End-Beispiel-Display-Video-Tutorial“ stellt jedem Beispiele für HTML5- und CSS3-Technologien vor, damit jeder die Verwendung von HTML5 und CSS3 besser beherrschen kann.

2017-06-23 09:14:51 0 1 1366

2023-09-05 11:18:47 0 1 889

Experimentieren Sie mit der Sortierung nach Abfragelimit

2023-09-05 14:46:42 0 1 774

2023-09-05 15:18:28 0 1 652

PHP-Volltextsuchfunktion mit den Operatoren AND, OR und NOT

2023-09-05 15:06:32 0 1 621

Kurseinführung:Das kausale Faltungs-Neuronale Netzwerk ist ein spezielles Faltungs-Neuronales Netzwerk, das für Kausalitätsprobleme in Zeitreihendaten entwickelt wurde. Im Vergleich zu herkömmlichen Faltungs-Neuronalen Netzen bieten kausale Faltungs-Neuronale Netze einzigartige Vorteile bei der Beibehaltung der kausalen Beziehung von Zeitreihen und werden häufig bei der Vorhersage und Analyse von Zeitreihendaten verwendet. Die Kernidee des kausalen Faltungs-Neuronalen Netzwerks besteht darin, Kausalität in die Faltungsoperation einzuführen. Herkömmliche Faltungs-Neuronale Netze können gleichzeitig Daten vor und nach dem aktuellen Zeitpunkt wahrnehmen, bei der Vorhersage von Zeitreihen kann dies jedoch zu Informationsverlustproblemen führen. Da die Vorhersageergebnisse zum aktuellen Zeitpunkt durch die Daten zu zukünftigen Zeitpunkten beeinflusst werden. Das kausale Faltungs-Neuronale Netzwerk löst dieses Problem. Es kann nur den aktuellen Zeitpunkt und frühere Daten wahrnehmen, aber keine zukünftigen Daten.

2024-01-24 Kommentar 0 917

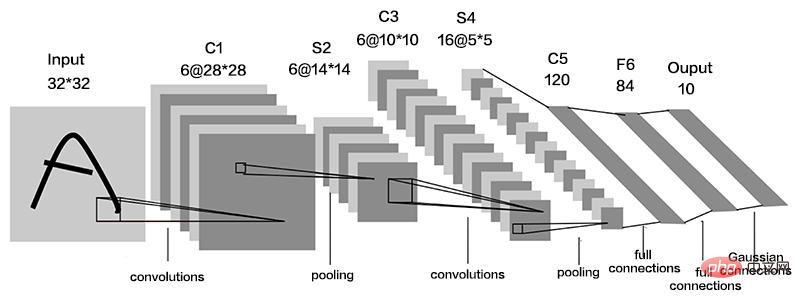

Kurseinführung:Dieser Artikel ist ein Nachdruck aus dem öffentlichen WeChat-Konto „Leben im Informationszeitalter“. Der Autor lebt im Informationszeitalter. Um diesen Artikel erneut zu drucken, wenden Sie sich bitte an das öffentliche Konto „Living in the Information Age“. Die Faltungsschicht des neuronalen Netzwerks (Convolutional Neural Network, CNN) ist ein spezielles Deep-Feed-Forward-Netzwerk, das im Allgemeinen eine Dateneingabeschicht, eine Faltungsschicht, eine Aktivierungsschicht, eine Downsampling-Schicht und eine vollständig verbundene Schicht umfasst. Die Faltungsschicht ist eine wichtige Einheit im Faltungs-Neuronalen Netzwerk. Sie besteht aus einer Reihe von Faltungskernen, die die Daten filtern. Ihr Kern ist ein linearer Überlagerungsprozess der gewichteten Summe der lokalen Fläche des Bildes des Faltungskerns. Das Bild I wird als Eingabe verwendet und der zweidimensionale Faltungskern K wird für die Faltung verwendet. Der Faltungsprozess kann wie folgt ausgedrückt werden: wobei I(i,j) der Wert des Bildes an der Position (i,j) ist ), S

2023-04-29 Kommentar 0 1755

Kurseinführung:Übersetzer |. Rezensiert von Zhu Xianzhong |. 1. Was ist ein Faltungs-Neuronales Netzwerk (CNN)? Zusammenfassend lässt sich sagen, dass Faltungs-Neuronale Netze eine spezielle Art neuronaler Netze sind, die in der Lage sind, einzigartige Bildmerkmale aus Bilddaten zu extrahieren. Beispielsweise werden Faltungs-Neuronale Netze häufig bei der Gesichtserkennung und -erkennung eingesetzt, da sie bei der Identifizierung komplexer Merkmale in Bilddaten sehr hilfreich sind. 2. Wie funktioniert ein Faltungs-Neuronales Netzwerk? Wie andere Arten neuronaler Netze verwenden CNNs numerische Daten. Daher müssen die in diese Netzwerke eingespeisten Bilder zunächst in digitale Darstellungen umgewandelt werden. Da Bilder aus Pixeln bestehen, werden sie vor der Weitergabe an CNN in digitale Form umgewandelt. Wie wir im nächsten Abschnitt besprechen werden, wird nicht die gesamte numerische Darstellungsschicht an das Netzwerk übergeben. für

2023-05-06 Kommentar 0 1657

Kurseinführung:Faltungs-Neuronale Netze eignen sich gut für Aufgaben zur Bildrauschunterdrückung. Es nutzt die erlernten Filter, um das Rauschen zu filtern und so das Originalbild wiederherzustellen. In diesem Artikel wird die Methode zur Bildentrauschung basierend auf einem Faltungs-Neuronalen Netzwerk ausführlich vorgestellt. 1. Überblick über das Convolutional Neural Network Das Convolutional Neural Network ist ein Deep-Learning-Algorithmus, der eine Kombination aus mehreren Faltungsschichten, Pooling-Schichten und vollständig verbundenen Schichten verwendet, um Bildmerkmale zu lernen und zu klassifizieren. In der Faltungsschicht werden die lokalen Merkmale des Bildes durch Faltungsoperationen extrahiert und so die räumliche Korrelation im Bild erfasst. Die Pooling-Schicht reduziert den Rechenaufwand durch Reduzierung der Feature-Dimension und behält die Hauptfeatures bei. Die vollständig verbundene Schicht ist für die Zuordnung erlernter Merkmale und Beschriftungen zur Implementierung der Bildklassifizierung oder anderer Aufgaben verantwortlich. Das Design dieser Netzwerkstruktur macht das Faltungs-Neuronale Netzwerk für die Bildverarbeitung und -erkennung nützlich.

2024-01-23 Kommentar 0 1321

Kurseinführung:Das Convolutional Neural Network (CNN) ist ein Deep-Learning-Modell, das häufig bei Computer-Vision-Aufgaben eingesetzt wird. Im Vergleich zu vollständig verbundenen neuronalen Netzen verfügt CNN über weniger Parameter und leistungsfähigere Funktionen zur Merkmalsextraktion und eignet sich gut für Aufgaben wie Bildklassifizierung, Zielerkennung und Bildsegmentierung. Im Folgenden stellen wir vor, wie man ein grundlegendes CNN-Modell erstellt. Convolutional Neural Network (CNN) ist ein Deep-Learning-Modell mit mehreren Faltungsschichten, Pooling-Schichten, Aktivierungsfunktionen und vollständig verbundenen Schichten. Die Faltungsschicht ist die Kernkomponente von CNN und wird zum Extrahieren von Merkmalen des Eingabebildes verwendet. Der Pooling-Layer kann die Größe der Feature-Map reduzieren und die Hauptmerkmale des Bildes beibehalten. Die Aktivierungsfunktion führt eine nichtlineare Transformation ein und vergrößert das Modell

2024-01-24 Kommentar 0 530