Map/Reduce开发环境

最近,在Mac上折腾了下,想搭建一个hadoop的测试环境,用于写一些Map/Reduce的sample,下面就先将搭建环境的过程记录下来。 1. hadoop 单机搭建 1.1 确认java环境已经安装 在terminal里再次键入java -version,出现如下信息: 1.2 安装SSH 首先,输入 ssh-ke

最近,在Mac上折腾了下,想搭建一个hadoop的测试环境,用于写一些Map/Reduce的sample,下面就先将搭建环境的过程记录下来。

1. hadoop 单机搭建

1.1 确认java环境已经安装

在terminal里再次键入”java -version”,出现如下信息:

1.2 安装SSH

首先,输入 ssh-keygen -t dsa -P ” -f ~/.ssh/id_dsa

ssh-keygen表示生成秘钥;-t表示秘钥类型;-P用于提供密语;-f指定生成的秘钥文件。这个命令在”~/.ssh/“文件夹下创建两个文件id_dsa和id_dsa.pub,是ssh的一对儿私钥和公钥。接下来,将公钥追加到授权的key中去,输入:cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

ssh免登陆设置完成。然后输入 ssh localhost 查看下即可

1.3 下载hadoop压缩包

1.4 hadoop-env.sh脚本文件,设置如下环境变量:

export JAVA_HOME=/usr/alibaba/java

export HADOOP_INSTALL=/Users/metaboy/project/hadoop/hadoop-1.0.4/

export PATH=$PATH:$HADOOP_INSTALL/bin

export HADOOP_OPTS=”-Djava.security.krb5.realm=OX.AC.UK -Djava.security.krb5.kdc=kdc0.ox.ac.uk:kdc1.ox.ac.uk”

1.5 core-site.xml文件,配置hdfs的地址和端口号:

fs.default.name

hdfs://localhost:9000

hadoop.tmp.dir

/Users/metaboy/project/hadoop/hadoop-1.0.4/tmp

A base for other temporary directories.

1.6 mapred-site.xml文件,设置map-reduce中jobtracker的地址和端口号:

mapred.job.tracker

localhost:9001

mapred.local.dir

/Users/metaboy/project/hadoop/hadoop-1.0.4/tmp/mapred/local

mapred.system.dir

/Users/metaboy/project/hadoop/hadoop-1.0.4/tmp/mapred/system

1.7 最后是hdfs-site.xml文件,设置hdfs的默认备份方式:

默认值是3,在伪分布式系统中,需要修改为1。

dfs.replication

1

dfs.permissions

false

dfs.data.dir

/Users/metaboy/project/hadoop/hadoop-1.0.4/tmp/hdfs/data

dfs.name.dir

/Users/metaboy/project/hadoop/hadoop-1.0.4/tmp/hdfs/name

1.8 格式化namenode

在terminal里输入如下命令:

bin/Hadoop NameNode -format

1.9 启动

在terminal里输入如下命令:

bin/start-all.sh

1.10 测试是否正常

如果一切正常的话,会在http://localhost:50030和http://localhost:50070分别看到map-reduce和hdfs的相关信息。

2. hadoop eclipse 插件编译

2.1 导入hadoop的eclipse-plugin的工程

用hadoop提供的文件自行编译,导入hadoop的eclipse-plugin文件夹.打开eclipse,在File菜单中选择Import.

2.2 导入后,在项目中新建lib目录,并复制jar文件

在项目中新建lib目录,并将hadoop安装根目录的hadoop-core-1.0.4.jar文件,lib目录中的commons-cli-1.2.jar、commons-configuration-1.6.jar、commons-httpclient-3.0.1.jar、commons-lang-2.4.jar、jackson-core-asl-1.8.8.jar、jackson-mapper-asl-1.8.8.jar文件复制到新建的目录中。复制完成后,将新建目录中的hadoop-core-1.0.4.jar文件名改为hadoop-core.jar 。

2.3 修改hadoop-1.0.4/src/contrib目录的build-contrib.xml文件

找到

并在该行下面添加以下两行内容。

eclipse.home是指eclipse的安装目录,需要替换为你自己的安装路径。

version的值要替换为hadoop的版本号。

2.4 修改MapReduceTools项目下的build.xml文件

打开build.xml文件,在文件中搜索name=”jar” ,找到的代码段并加上

–>

–>

jarfile=”${build.dir}/hadoop-${name}-${version}.jar”

manifest=”${root}/META-INF/MANIFEST.MF”]]>

2.5 在build.xml文件中查找

2.6 在文件中搜索

2.7 修改 Bundle-ClassPath

使用编辑器打开META-INF文件夹中的MANIFEST.MF文件,在文件中搜索Bundle-ClassPath,可以看到该行内容如下:

Bundle-ClassPath: classes/,

lib/hadoop-core.jar,lib/commons-cli-1.2.jar,lib/commons-httpclient-3.0.1.jar,lib/jackson-core-asl-1.8.8.jar,lib/jackson-mapper-asl-1.8.8.jar,lib/commons-configuration-1.6.jar,lib/commons-lang-2.4.jar

2.8 用ant开始编译

保存build.xml文件后,在build.xml文件上点击右键,并选择Run As -> Ant Build

2.9 安装插件

编译后的plugin文件会保存在hadoop-1.0.4/build/contrib/eclipse-plugin文件夹中,文件名为hadoop-eclipse-plugin-1.0.4.jar 。

将该文件复制到eclipse安装目录的plugins文件夹下,并重启eclipse。

2.10 测试

在eclipse的window菜单中选择Show View -> Other,在Show View窗口中选择MapReduce Tools下的Map/Reduce Locations,点击OK

问题记录:

1. An internal error occurred during: “Connecting to DFS localhost”.

详细信息如下:

java.lang.NoClassDefFoundError: org/codehaus/jackson/map/JsonMappingException

找到刚才添加的lib目录下的几个jar文件,分别解压,然后通过betterzip将这些字节码分别添加到classes下面

问题2:Call to localhost/127.0.0.1:9000 failed on connection exception: java.net.ConnectException

使用jps发现NameNode进程没有正确运行。解决的办法就是先停止服务,然后重新格式化namenode。

bin/hadoop namenode -format

重新启动后,运行该插件无问题

问题3:Unable to load realm info from SCDynamicStore

这个问题是hadoop官方的一个bug,详细bug介绍可以参考这个链接:https://issues.apache.org/jira/browse/HADOOP-7489

一般在是当start-all.sh 的时候,会抛出这样的异常:

Unable to load realm info from SCDynamicStore

网络上有一种解决方法,解决单机部署还行,对于伪分布式部署还是不行:

就是在hadoop-env.sh文件中加上这一行:

export HADOOP_OPTS=”-Djava.security.krb5.realm=OX.AC.UK -Djava.security.krb5.kdc=kdc0.ox.ac.uk:kdc1.ox.ac.uk”

(意思是设置启动hadoop时设定相关的JVM参数)

~~~EOF~~~

原文地址:Map/Reduce开发环境, 感谢原作者分享。

Hot AI Tools

Undresser.AI Undress

AI-powered app for creating realistic nude photos

AI Clothes Remover

Online AI tool for removing clothes from photos.

Undress AI Tool

Undress images for free

Clothoff.io

AI clothes remover

AI Hentai Generator

Generate AI Hentai for free.

Hot Article

Hot Tools

Notepad++7.3.1

Easy-to-use and free code editor

SublimeText3 Chinese version

Chinese version, very easy to use

Zend Studio 13.0.1

Powerful PHP integrated development environment

Dreamweaver CS6

Visual web development tools

SublimeText3 Mac version

God-level code editing software (SublimeText3)

Hot Topics

Four recommended AI-assisted programming tools

Apr 22, 2024 pm 05:34 PM

Four recommended AI-assisted programming tools

Apr 22, 2024 pm 05:34 PM

This AI-assisted programming tool has unearthed a large number of useful AI-assisted programming tools in this stage of rapid AI development. AI-assisted programming tools can improve development efficiency, improve code quality, and reduce bug rates. They are important assistants in the modern software development process. Today Dayao will share with you 4 AI-assisted programming tools (and all support C# language). I hope it will be helpful to everyone. https://github.com/YSGStudyHards/DotNetGuide1.GitHubCopilotGitHubCopilot is an AI coding assistant that helps you write code faster and with less effort, so you can focus more on problem solving and collaboration. Git

How to set up WeChat Mac to automatically convert voice messages into text - How to set up voice to text conversion

Mar 19, 2024 am 08:28 AM

How to set up WeChat Mac to automatically convert voice messages into text - How to set up voice to text conversion

Mar 19, 2024 am 08:28 AM

Recently, some friends have consulted the editor about how to set up WeChat Mac to automatically convert voice messages into text. The following is a method for setting up WeChat Mac to automatically convert voice messages into text. Friends in need can come and learn more. Step 1: First, open the Mac version of WeChat. As shown in the picture: Step 2: Next, click "Settings". As shown in the picture: Step 3: Then, click "General". As shown in the picture: Step 4: Then check the option "Automatically convert voice messages in chat to text". As shown in the picture: Step 5: Finally, close the window. As shown in the picture:

Learn how to develop mobile applications using Go language

Mar 28, 2024 pm 10:00 PM

Learn how to develop mobile applications using Go language

Mar 28, 2024 pm 10:00 PM

Go language development mobile application tutorial As the mobile application market continues to boom, more and more developers are beginning to explore how to use Go language to develop mobile applications. As a simple and efficient programming language, Go language has also shown strong potential in mobile application development. This article will introduce in detail how to use Go language to develop mobile applications, and attach specific code examples to help readers get started quickly and start developing their own mobile applications. 1. Preparation Before starting, we need to prepare the development environment and tools. head

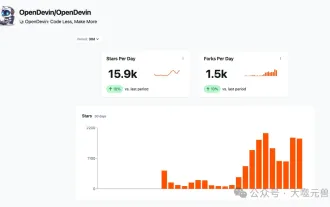

Which AI programmer is the best? Explore the potential of Devin, Tongyi Lingma and SWE-agent

Apr 07, 2024 am 09:10 AM

Which AI programmer is the best? Explore the potential of Devin, Tongyi Lingma and SWE-agent

Apr 07, 2024 am 09:10 AM

On March 3, 2022, less than a month after the birth of the world's first AI programmer Devin, the NLP team of Princeton University developed an open source AI programmer SWE-agent. It leverages the GPT-4 model to automatically resolve issues in GitHub repositories. SWE-agent's performance on the SWE-bench test set is similar to Devin, taking an average of 93 seconds and solving 12.29% of the problems. By interacting with a dedicated terminal, SWE-agent can open and search file contents, use automatic syntax checking, edit specific lines, and write and execute tests. (Note: The above content is a slight adjustment of the original content, but the key information in the original text is retained and does not exceed the specified word limit.) SWE-A

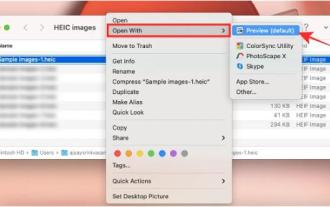

3 Ways to Convert HEIC Photos to JPG on Mac

Mar 15, 2024 pm 08:43 PM

3 Ways to Convert HEIC Photos to JPG on Mac

Mar 15, 2024 pm 08:43 PM

By default, iPhone takes photos from the camera in HEIC format. HEIC stands for High Efficiency Image Container and can hold more pixel data than PNG or JPG files, taking up significantly less space on iPhone storage compared to other formats. These files work best on iPhones but are not widely accepted on the internet because they often result in blurry/grainy pictures when you share them with non-Apple devices. To ensure that HEIC images are compatible on other devices, you may need to convert them to JPG format. This article will introduce how to convert HEIC images to JPG on Mac. How to Convert HEIC Photos to JPG on Mac [3 Methods] Method

How to post to Moments on WeChat Mac - How to post to Moments on WeChat Mac

Mar 18, 2024 pm 05:43 PM

How to post to Moments on WeChat Mac - How to post to Moments on WeChat Mac

Mar 18, 2024 pm 05:43 PM

Friends, do you know how to post Moments on WeChat Mac? Today I will explain how to post Moments on WeChat Mac. If you are interested, come and take a look with me. I hope it can help everyone. Step 1: After opening WeChat, click the Moments button on the left. Step 2: Next, click the camera button on the upper right side. Step 3: Enter the text content you want to send. Step 4: Next, click on who can watch. Step 5: In the pop-up box, select the viewable conditions and click OK. Step 6: Finally, click the Publish button.

How to format a drive using GUID on Mac

Apr 12, 2024 am 09:13 AM

How to format a drive using GUID on Mac

Apr 12, 2024 am 09:13 AM

Formatting the drive of your Mac system is crucial for proper functioning. It helps prevent various system problems and makes your Mac more stable overall. While naturally Mac supports various partitioning schemes, GUID offers more modern and versatile features compared to other options. Also essential for newer Macs and supports larger drives, giving you the best compatibility and stability. This guide will take an in-depth look at how to format a drive using a GUID on macOS. That said, let's get started. Why GUID is important for macOS installation A GUID (full form of Globally Unique Identifier) is a partitioning scheme that helps install and run the macOS operating system. It is better than traditional MBR (main lead

Apple iPhone 16 is no longer pre-installed with Apple Intelligence

Jul 30, 2024 pm 01:18 PM

Apple iPhone 16 is no longer pre-installed with Apple Intelligence

Jul 30, 2024 pm 01:18 PM

According to industry insider Mark Gurman, Apple’s Apple Intelligence will be postponed to October. In other words, it will be pushed first on iOS18.1. Apple iPhone 16 is expected to be released in September, so Apple Intelligence will not be pre-installed. 1. Apple Intelligence Apple Intelligence is a personal intelligence system that uses a powerful generative model to provide new functions for iPhone, iPad and Mac to assist users in communicating, working and expressing. 2. Natural language understanding The large model embedded in Apple Intelligence has a deep understanding of the meaning of language.