php读取大文件的一点疑问

我要分析一个6G的log文件,比对每行文件是否符合我的要求,程序如下

$file_path = 'd:\work\workplace\test\file\system.log';$file = fopen($file_path, 'r');$key = md5(0);$i = 1;while (!feof($file)) { $buff = fgets($file); if ($buff == $key . "\r\n") { echo "find 0 at Line {$i}\r\n"; } $i ++;}fclose($file);我想问下这样性能怎么样吗,不会出现内存泄露或其他问题吧,还有进一步优化的方法吗?

回复讨论(解决方案)

你需要先将这个文件分割成若干个小文件

然后循环读取每个小文件即可!

linux 下 $ split -b

分割···

linux 下 $ split -b

分割···

为什么要分割啊,用fgets不是每次只去一行,并没有把文件都读取进内存啊

我建议你用fgets时最好制定读取的字符数,不要一行一行的读,6G的文件说不定某一行会很长!

现在可以肯定每一行不会很长,应为日志是按规定格式存取的

哦,那你看着办吧!呵呵,我只是建议!

哦,那你看着办吧!呵呵,我只是建议!

我的确也看到有的人像你那样做,但是如果不是一下子读入内存,应该不比那样吧,切割文件和删除临时文件还有消耗,这是我个人感觉,有不对的情指出

6G的文本文件……

你咋能整这么大的文件?

日志应该按天或者按周、按月来记,超过一定大小就新建一个文件

应该分成多个文件

6G的文本文件……

你咋能整这么大的文件?

日志应该按天或者按周、按月来记,超过一定大小就新建一个文件

应该分成多个文件

我们公司的行为日志,一天6G

可以,没有问题。就是很费时间

仅就代码而言,可以缩减一点

$file_path = 'd:\work\workplace\test\file\system.log';

$file = fopen($file_path, 'r');

$key = md5(0);

$i = 1;

while ($buff = fgets($file)) {

if ($buff == $key . "\r\n")

{

echo "find 0 at Line {$i}\r\n";

}

$i ++;

}

fclose($file);

如果一次读取的多一点(比如1M)可能要快一点。不过算法要复杂些

做这种东西,不是php的长项

要不搞WEB的话,还是换其它程序搞吧。

引用 9 楼 baiyuxiong 的回复:

6G的文本文件……

你咋能整这么大的文件?

日志应该按天或者按周、按月来记,超过一定大小就新建一个文件

应该分成多个文件

我们公司的行为日志,一天6G

如果用shell怎么写啊,求达人,没有也很感谢大家

后来呢?怎么解决了嘛??

我用的fgets读的文件,也不算大吧,150M的一个csv文件,18秒钟,用fgets按行读的话(已知不会出现很长的行),需不需要再用fseek来设定文件指针?可以提高效率吗?

Hot AI Tools

Undresser.AI Undress

AI-powered app for creating realistic nude photos

AI Clothes Remover

Online AI tool for removing clothes from photos.

Undress AI Tool

Undress images for free

Clothoff.io

AI clothes remover

AI Hentai Generator

Generate AI Hentai for free.

Hot Article

Hot Tools

Notepad++7.3.1

Easy-to-use and free code editor

SublimeText3 Chinese version

Chinese version, very easy to use

Zend Studio 13.0.1

Powerful PHP integrated development environment

Dreamweaver CS6

Visual web development tools

SublimeText3 Mac version

God-level code editing software (SublimeText3)

Hot Topics

Working with Flash Session Data in Laravel

Mar 12, 2025 pm 05:08 PM

Working with Flash Session Data in Laravel

Mar 12, 2025 pm 05:08 PM

Laravel simplifies handling temporary session data using its intuitive flash methods. This is perfect for displaying brief messages, alerts, or notifications within your application. Data persists only for the subsequent request by default: $request-

cURL in PHP: How to Use the PHP cURL Extension in REST APIs

Mar 14, 2025 am 11:42 AM

cURL in PHP: How to Use the PHP cURL Extension in REST APIs

Mar 14, 2025 am 11:42 AM

The PHP Client URL (cURL) extension is a powerful tool for developers, enabling seamless interaction with remote servers and REST APIs. By leveraging libcurl, a well-respected multi-protocol file transfer library, PHP cURL facilitates efficient execution of various network protocols, including HTTP, HTTPS, and FTP. This extension offers granular control over HTTP requests, supports multiple concurrent operations, and provides built-in security features.

Simplified HTTP Response Mocking in Laravel Tests

Mar 12, 2025 pm 05:09 PM

Simplified HTTP Response Mocking in Laravel Tests

Mar 12, 2025 pm 05:09 PM

Laravel provides concise HTTP response simulation syntax, simplifying HTTP interaction testing. This approach significantly reduces code redundancy while making your test simulation more intuitive. The basic implementation provides a variety of response type shortcuts: use Illuminate\Support\Facades\Http; Http::fake([ 'google.com' => 'Hello World', 'github.com' => ['foo' => 'bar'], 'forge.laravel.com' =>

12 Best PHP Chat Scripts on CodeCanyon

Mar 13, 2025 pm 12:08 PM

12 Best PHP Chat Scripts on CodeCanyon

Mar 13, 2025 pm 12:08 PM

Do you want to provide real-time, instant solutions to your customers' most pressing problems? Live chat lets you have real-time conversations with customers and resolve their problems instantly. It allows you to provide faster service to your custom

Explain the concept of late static binding in PHP.

Mar 21, 2025 pm 01:33 PM

Explain the concept of late static binding in PHP.

Mar 21, 2025 pm 01:33 PM

Article discusses late static binding (LSB) in PHP, introduced in PHP 5.3, allowing runtime resolution of static method calls for more flexible inheritance.Main issue: LSB vs. traditional polymorphism; LSB's practical applications and potential perfo

PHP Logging: Best Practices for PHP Log Analysis

Mar 10, 2025 pm 02:32 PM

PHP Logging: Best Practices for PHP Log Analysis

Mar 10, 2025 pm 02:32 PM

PHP logging is essential for monitoring and debugging web applications, as well as capturing critical events, errors, and runtime behavior. It provides valuable insights into system performance, helps identify issues, and supports faster troubleshoot

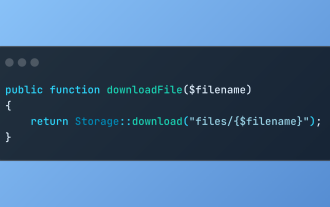

Discover File Downloads in Laravel with Storage::download

Mar 06, 2025 am 02:22 AM

Discover File Downloads in Laravel with Storage::download

Mar 06, 2025 am 02:22 AM

The Storage::download method of the Laravel framework provides a concise API for safely handling file downloads while managing abstractions of file storage. Here is an example of using Storage::download() in the example controller:

How to Register and Use Laravel Service Providers

Mar 07, 2025 am 01:18 AM

How to Register and Use Laravel Service Providers

Mar 07, 2025 am 01:18 AM

Laravel's service container and service providers are fundamental to its architecture. This article explores service containers, details service provider creation, registration, and demonstrates practical usage with examples. We'll begin with an ove