大数据图数据库之离线挖掘计算模型

/* .*/ author:张俊林 节选自《大数据日知录:架构与算法》十四章,书籍目录在此 对于离线挖掘类图计算而言,目前已经涌现出众多各方面表现优秀而各具特点的实际系统,典型的比如Pregel、Giraph、Hama、PowerGraph、GraphLab、GraphChi等。通过对这些系统的

/* .*/

author: 张俊林

节选自《大数据日知录:架构与算法》十四章,书籍目录在此

对于离线挖掘类图计算而言,目前已经涌现出众多各方面表现优秀而各具特点的实际系统,典型的比如Pregel、Giraph、Hama、PowerGraph、GraphLab、GraphChi等。通过对这些系统的分析,我们可以归纳出离线挖掘类图计算中一些常见的计算模型。

本节将常见的计算模型分为两类,一类是图编程模型,另一类是图计算范型。编程模型更多地面向图计算系统的应用开发者,而计算范型则是图计算系统开发者需要关心的问题。在本节中,关于编程模型,主要介绍以节点为中心的编程模型及其改进版本的GAS编程模型;关于计算范型,则重点介绍同步执行模型和异步执行模型。这几类模型已经被广泛采用在目前的大规模图挖掘系统中。

14.4.1 以节点为中心的编程模型

以节点为中心的编程模型(Vertex-Centered ProgrammingModel)首先由Pregel系统提出,之后的绝大多数离线挖掘类大规模图计算系统都采用这个模型作为编程模型。

对图G=(V,E)来说,以节点为中心的编程模型将图节点vertex?V看作计算的中心,应用开发者可以自定义一个与具体应用密切相关的节点更新函数Function(vertex),这个函数可以获取并改变图节点vertex及与其有关联的边的权值,甚至可以通过增加和删除边来更改图结构。对于所有图中的节点都执行节点更新函数Function(vertex)来对图的状态(包括节点信息和边信息)进行转换,如此反复迭代进行,直到达到一定的停止标准为止。

典型的图节点更新函数Function(vertex)基本遵循如下逻辑。

即首先从vertex的入边和出边收集信息,对这些信息经过针对节点权值的函数f()变换后,将计算得到的值更新vertex的权值,之后以节点的新权值和边原先的权值作为输入,通过针对边的函数g()进行变换,变换后的值用来依次更新边的权值。通过vertex的节点更新函数,来达到更新部分图状态的目的。

以节点为中心的编程模型有很强的表达能力。研究表明,很多类型的问题都可以通过这个编程模型来进行表达,比如很多图挖掘、数据挖掘、机器学习甚至是线性代数的问题都可以以这种编程模型来获得解决。这也是为何以图节点为中心的编程模型大行其道的根本原因。

14.4.2 GAS编程模型

GAS模型可以看作是对以节点为中心的图计算编程模型的一种细粒度改造,通过将计算过程进一步细分来增加计算并发性。GAS模型明确地将以节点为中心的图计算模型的节点更新函数Function(Vertex)划分为三个连续的处理阶段:信息收集阶段(Gather)、应用阶段(Apply)和分发阶段(Scatter)。通过这种明确的计算阶段划分,可以使原先的一个完整计算流程细分,这样在计算过程中可以将各个子处理阶段并发执行来进一步增加系统的并发处理性能。

这里假设当前要进行计算的节点是u,并以此为基础来说明GAS模型。

在信息收集阶段,将u节点的所有邻接节点和相连的边上的信息通过一个通用累加函数收集起来:

通过以上三个阶段的操作,可以定义以图节点为中心的高度抽象的GAS计算模型。在GAS模型中,节点的入边和出边在信息收集和分发阶段如何使用取决于具体的应用,比如,在PageRank计算中,信息收集阶段只考虑入边信息,分发阶段只考虑出边信息,但是在类似于Facebook的社交关系图中,如果边表达的语义是朋友关系,那么在信息收集和分发阶段则是所有边的信息都会纳入计算范围。

14.4.3 同步执行模型

同步执行模型是相对于异步执行模型而言的。我们知道,图计算往往需要经过多轮迭代过程,在以节点为中心的图编程模型下,在每轮迭代过程中对图节点会调用用户自定义函数Function(vertex),这个函数会更改vertex节点及其对应边的状态,如果节点的这种状态变化在本轮迭代过程中就可以被其他节点看到并使用,也就是说变化立即可见,那么这种模式被称为异步执行模型;如果所有的状态变化只有等到下一轮迭代才可见并允许使用,那么这种模式被称为同步执行模型。采用同步执行模型的系统在迭代过程中或者连续两轮迭代过程之间往往存在一个同步点,同步点的目的在于保证每个节点都已经接受到本轮迭代更新后的状态信息,以保证可以进入下一轮的迭代过程。

在实际的系统中,两种典型的同步执行模型包括BSP模型和MapReduce模型。关于BSP模型的介绍及其与MapReduce模型的关系,可以参考本书“机器学习:范型与架构”一章,这里不再赘述。下面介绍图计算中的MapReduce计算模型,总体而言,由于很多图挖掘算法带有迭代运行的特点,MapReduce计算模型并不是十分适合解决此类问题的较佳答案,但是由于Hadoop的广泛流行,实际工作中还有一些图计算是采用MapReduce机制来进行的。14.4.4 异步执行模型

异步执行模型相对于同步执行模型而言,因为不需要进行数据同步,而且更新的数据能够在本轮迭代即可被使用,所以算法收敛速度快,系统吞吐量和执行效率都要明显高于同步模型。但是异步模型也有相应的缺点:其很难推断程序的正确性。因为其数据更新立即生效,所以节点的不同执行顺序很可能会导致不同的运行结果,尤其是对图节点并发更新计算的时候,还可能产生争用状况(Race Condition)和数据不一致的问题,所以其在系统实现的时候必须考虑如何避免这些问题,系统实现机制较同步模型复杂。

下面以GraphLab为例讲解异步执行模型的数据一致性问题,GraphLab比较适合应用于机器学习领域的非自然图计算情形,比如马尔科夫随机场(MRF)、随机梯度下降算法(SGD)等机器学习算法。

在讲解异步模型的数据一致性问题前,先来了解一下GraphLab论文提出的图节点的作用域(Scope)概念。对于图G中的某个节点v来说,其作用域Sv包括:节点v本身、与节点v关联的所有边,以及节点v的所有邻接图节点。之所以定义图节点的作用域,是因为在以节点为中心的编程模型中,作用域体现了节点更新函数f(v)能够涉及的图对象范围及与其绑定的数据。

在并发的异步执行模型下,可以定义三类不同强度的数据一致性条件(见图14-12),根据其一致性限制条件的强度,由强到弱分别为:完全一致性(Full Consistency)、边一致性(Edge Consistency)和节点一致性(Vertex Consistency)。

完全一致性的含义是:在节点v的节点更新函数f(v)执行期间,保证不会有其他更新函数去读写或者更改节点v的作用域Sv内图对象的数据。因此,满足完全一致性条件的情形下,并行计算只允许出现在无公共邻接点的图节点之间,因为如果两个图节点有公共邻接图节点,那么两者的作用域必有交集,若两者并发执行,可能会发生争用状况,而这违反了完全一致性的定义。

比完全一致性稍弱些的是边一致性条件,其含义为:在节点v的节点更新函数f(v)执行期间,保证不会有其他更新函数去读写或者更改节点v,以及与其邻接的所有边的数据。即与完全一致性条件相比,放松了条件,允许读写与节点v邻接的其他图节点的数据。在满足边一致性条件下,并行计算允许出现在无公共边的图节点之间,因为只要两个节点u和v不存在共享边,则一定会满足边一致性条件。

更弱一些的是节点一致性,其含义为:在节点v的节点更新函数f(v)执行期间,保证不会有其他更新函数去读写或者更改节点v的数据。很明显,最弱的节点一致性能够允许最大程度的并发,之所以说其限制条件较弱,是因为除非应用逻辑可以保证节点更新函数f(v)只读写节点本身的数据,否则很易发生争用状况,使得程序运行结果不一致。

选择不同的一致性模型对于并行程序执行的结果正确性有很大影响,所谓并行执行的结果正确性,可以用其和顺序执行相比是否一致来进行判断。因此,可以定义“序列一致性”如下:

如果对所有可能的并发执行顺序总是存在与序列执行完全一致的执行结果,在此种情形下,我们可以将这个并发程序称为是满足序列一致性的。

是否满足序列一致性可以帮助我们验证将一个顺序执行的程序改造为并行执行程序后的正确性。在并行的异步图计算环境下,以下三种情形是可以满足序列一致性的。

情形一:满足完全一致性条件。

情形二:满足边一致性条件,并且节点更新函数f(v)不会修改邻接节点的数据。

情形三:满足节点一致性条件,并且节点更新函数f(v)只会读写节点本身的数据。

上面三种情形可供应用者在设计算法时参考,以在并发性和结果正确性之间做好权衡:一致性条件越弱,则并发能力越强,但是争用状况发生概率越高,即结果可能越难保障正确性。如果应用能够明确节点更新函数的数据涉及范围,就可以根据上述几种情形来进行选择,更好地做到在保证结果正确性的前提下提高并发性能。

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Afin d'aligner les grands modèles de langage (LLM) sur les valeurs et les intentions humaines, il est essentiel d'apprendre les commentaires humains pour garantir qu'ils sont utiles, honnêtes et inoffensifs. En termes d'alignement du LLM, une méthode efficace est l'apprentissage par renforcement basé sur le retour humain (RLHF). Bien que les résultats de la méthode RLHF soient excellents, certains défis d’optimisation sont impliqués. Cela implique de former un modèle de récompense, puis d'optimiser un modèle politique pour maximiser cette récompense. Récemment, certains chercheurs ont exploré des algorithmes hors ligne plus simples, dont l’optimisation directe des préférences (DPO). DPO apprend le modèle politique directement sur la base des données de préférence en paramétrant la fonction de récompense dans RLHF, éliminant ainsi le besoin d'un modèle de récompense explicite. Cette méthode est simple et stable

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

1. Introduction Au cours des dernières années, les YOLO sont devenus le paradigme dominant dans le domaine de la détection d'objets en temps réel en raison de leur équilibre efficace entre le coût de calcul et les performances de détection. Les chercheurs ont exploré la conception architecturale de YOLO, les objectifs d'optimisation, les stratégies d'expansion des données, etc., et ont réalisé des progrès significatifs. Dans le même temps, le recours à la suppression non maximale (NMS) pour le post-traitement entrave le déploiement de bout en bout de YOLO et affecte négativement la latence d'inférence. Dans les YOLO, la conception de divers composants manque d’une inspection complète et approfondie, ce qui entraîne une redondance informatique importante et limite les capacités du modèle. Il offre une efficacité sous-optimale et un potentiel d’amélioration des performances relativement important. Dans ce travail, l'objectif est d'améliorer encore les limites d'efficacité des performances de YOLO à la fois en post-traitement et en architecture de modèle. à cette fin

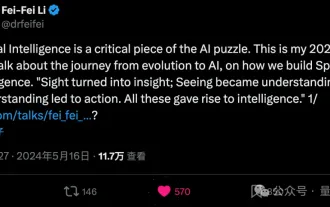

Li Feifei révèle l'orientation entrepreneuriale de « l'intelligence spatiale » : la visualisation se transforme en aperçu, la vue devient compréhension et la compréhension mène à l'action

Jun 01, 2024 pm 02:55 PM

Li Feifei révèle l'orientation entrepreneuriale de « l'intelligence spatiale » : la visualisation se transforme en aperçu, la vue devient compréhension et la compréhension mène à l'action

Jun 01, 2024 pm 02:55 PM

Stanford Li Feifei a dévoilé pour la première fois le nouveau concept « d'intelligence spatiale » après avoir lancé sa propre entreprise. Ce n'est pas seulement son orientation entrepreneuriale, mais aussi « l'étoile du Nord » qui la guide, elle la considère comme « la pièce clé du puzzle pour résoudre le problème de l'intelligence artificielle ». La visualisation mène à la perspicacité ; la vue mène à la compréhension ; la compréhension mène à l’action. Basé sur la conférence TED de 15 minutes de Li Feifei, il est entièrement révélé, depuis l'origine de l'évolution de la vie il y a des centaines de millions d'années, jusqu'à la façon dont les humains ne sont pas satisfaits de ce que la nature leur a donné et développent l'intelligence artificielle, jusqu'à la façon de construire l'intelligence spatiale dans la prochaine étape. Il y a neuf ans, Li Feifei a présenté au monde le nouveau ImageNet sur la même scène - l'un des points de départ de cette explosion d'apprentissage profond. Elle a elle-même encouragé les internautes : si vous regardez les deux vidéos, vous pourrez comprendre la vision par ordinateur des 10 dernières années.

L'Université Tsinghua a pris le relais et YOLOv10 est sorti : les performances ont été grandement améliorées et il figurait sur la hot list de GitHub

Jun 06, 2024 pm 12:20 PM

L'Université Tsinghua a pris le relais et YOLOv10 est sorti : les performances ont été grandement améliorées et il figurait sur la hot list de GitHub

Jun 06, 2024 pm 12:20 PM

La série de référence YOLO de systèmes de détection de cibles a une fois de plus reçu une mise à niveau majeure. Depuis la sortie de YOLOv9 en février de cette année, le relais de la série YOLO (YouOnlyLookOnce) a été passé entre les mains de chercheurs de l'Université Tsinghua. Le week-end dernier, la nouvelle du lancement de YOLOv10 a attiré l'attention de la communauté IA. Il est considéré comme un cadre révolutionnaire dans le domaine de la vision par ordinateur et est connu pour ses capacités de détection d'objets de bout en bout en temps réel, poursuivant l'héritage de la série YOLO en fournissant une solution puissante alliant efficacité et précision. Adresse de l'article : https://arxiv.org/pdf/2405.14458 Adresse du projet : https://github.com/THU-MIG/yo

Les startups d'IA ont collectivement transféré leurs emplois vers OpenAI, et l'équipe de sécurité s'est regroupée après le départ d'Ilya !

Jun 08, 2024 pm 01:00 PM

Les startups d'IA ont collectivement transféré leurs emplois vers OpenAI, et l'équipe de sécurité s'est regroupée après le départ d'Ilya !

Jun 08, 2024 pm 01:00 PM

" sept péchés capitaux" » Dissiper les rumeurs : selon des informations divulguées et des documents obtenus par Vox, la haute direction d'OpenAI, y compris Altman, était bien au courant de ces dispositions de récupération de capitaux propres et les a approuvées. De plus, OpenAI est confronté à un problème grave et urgent : la sécurité de l’IA. Les récents départs de cinq employés liés à la sécurité, dont deux de ses employés les plus en vue, et la dissolution de l'équipe « Super Alignment » ont une nouvelle fois mis les enjeux de sécurité d'OpenAI sur le devant de la scène. Le magazine Fortune a rapporté qu'OpenA

Le modèle 70B génère 1 000 jetons en quelques secondes, la réécriture du code dépasse GPT-4o, de l'équipe Cursor, un artefact de code investi par OpenAI

Jun 13, 2024 pm 03:47 PM

Le modèle 70B génère 1 000 jetons en quelques secondes, la réécriture du code dépasse GPT-4o, de l'équipe Cursor, un artefact de code investi par OpenAI

Jun 13, 2024 pm 03:47 PM

Modèle 70B, 1000 tokens peuvent être générés en quelques secondes, ce qui se traduit par près de 4000 caractères ! Les chercheurs ont affiné Llama3 et introduit un algorithme d'accélération. Par rapport à la version native, la vitesse est 13 fois plus rapide ! Non seulement il est rapide, mais ses performances sur les tâches de réécriture de code dépassent même GPT-4o. Cette réalisation vient d'anysphere, l'équipe derrière le populaire artefact de programmation d'IA Cursor, et OpenAI a également participé à l'investissement. Il faut savoir que sur Groq, un framework d'accélération d'inférence rapide bien connu, la vitesse d'inférence de 70BLlama3 n'est que de plus de 300 jetons par seconde. Avec la vitesse de Cursor, on peut dire qu'il permet une édition complète et quasi instantanée des fichiers de code. Certaines personnes l'appellent un bon gars, si tu mets Curs