Périphériques technologiques

Périphériques technologiques

IA

IA

L'IA multimodale est l'avenir de la médecine. Google lance trois nouveaux modèles et Med-Gemini accueille une mise à niveau majeure.

L'IA multimodale est l'avenir de la médecine. Google lance trois nouveaux modèles et Med-Gemini accueille une mise à niveau majeure.

L'IA multimodale est l'avenir de la médecine. Google lance trois nouveaux modèles et Med-Gemini accueille une mise à niveau majeure.

Edit | Feuilles de chou

De nombreuses tâches cliniques nécessitent la compréhension de données professionnelles, comme les images médicales, la génomique, etc. Ce type d'informations sur les connaissances professionnelles n'existe généralement pas dans la formation de grands modèles multimodaux généraux...

Dans la description de l'article précédent, Med-Gemini a dépassé la mise en œuvre du modèle de la série GPT-4 sur diverses tâches d'imagerie médicale. SOTA!

Ici, Google DeepMind a rédigé un deuxième article sur Med-Gemini.

Sur la base du modèle multimodal de Gemini, l'équipe a développé plusieurs modèles pour la série Med-Gemini. Ces modèles héritent des fonctionnalités de base de Gemini et sont optimisés pour un usage médical avec un réglage fin des données de radiologie 2D et 3D, d'histopathologie, d'ophtalmologie, de dermatologie et de génomique.

L'étude, intitulée « Advancing Multimodal Medical Capabilities of Gemini », a été publiée sur la plateforme de prépublication arXiv le 6 mai 2024.

Les sources de données médicales comprennent des données médicales provenant de différentes sources telles que les biobanques, les dossiers de santé électroniques, l'imagerie médicale, les appareils portables, les biocapteurs et le séquençage du génome. Ces données stimulent le développement de solutions d’IA multimodales pour mieux saisir la complexité de la santé et des maladies des populations.

L'IA en médecine s'est principalement concentrée sur des tâches étroites avec des types d'entrée et de sortie uniques, mais les progrès récents de l'IA générative sont prometteurs pour résoudre les défis multimodaux et multitâches dans les contextes médicaux.

L'IA générative multimodale, représentée par des modèles puissants tels que Gemini, a un grand potentiel pour révolutionner les soins de santé. Bien que la médecine soit une source de données permettant une itération rapide de ces nouveaux modèles, les modèles généraux fonctionnent souvent mal lorsqu’ils sont appliqués au domaine médical en raison de leurs données hautement spécialisées.

Basé sur les fonctions de base de Gemini, DeepMind a lancé trois nouveaux modèles de la série Med-Gemini, Med-Gemini-2D, Med-Gemini-3D et Med-Gemini-Polygenic.

Plus de 7 millions d'échantillons de données provenant de 3,7 millions d'images et de cas médicaux ont été utilisés pour entraîner le modèle. Divers ensembles de données de réponses visuelles aux questions et de sous-titres d’images sont utilisés, y compris certains ensembles de données privés provenant d’hôpitaux.

Pour traiter les données 3D (CT), l'encodeur vidéo Gemini est utilisé, où la dimension temporelle est traitée comme la dimension de profondeur. Pour traiter les données génomiques, les scores de risque pour divers traits ont été codés sous forme de pixels RVB dans l'image.

Med-Gemini-2D

Med-Gemini-2D établit une nouvelle norme en matière de génération de rapports de radiographie thoracique (CXR) basés sur l'IA, basés sur une évaluation d'experts, dépassant deux données indépendantes précédentes. Le meilleur résultats de l'ensemble, avec des avantages absolus de 1 % et 12 %, dont les rapports de cas normaux d'AI étaient de 57 % et 96 % et les rapports de cas anormaux de 43 % et 65 %. Par rapport au rapport original du radiologue, la qualité est " comparable" " ou même " meilleur ".

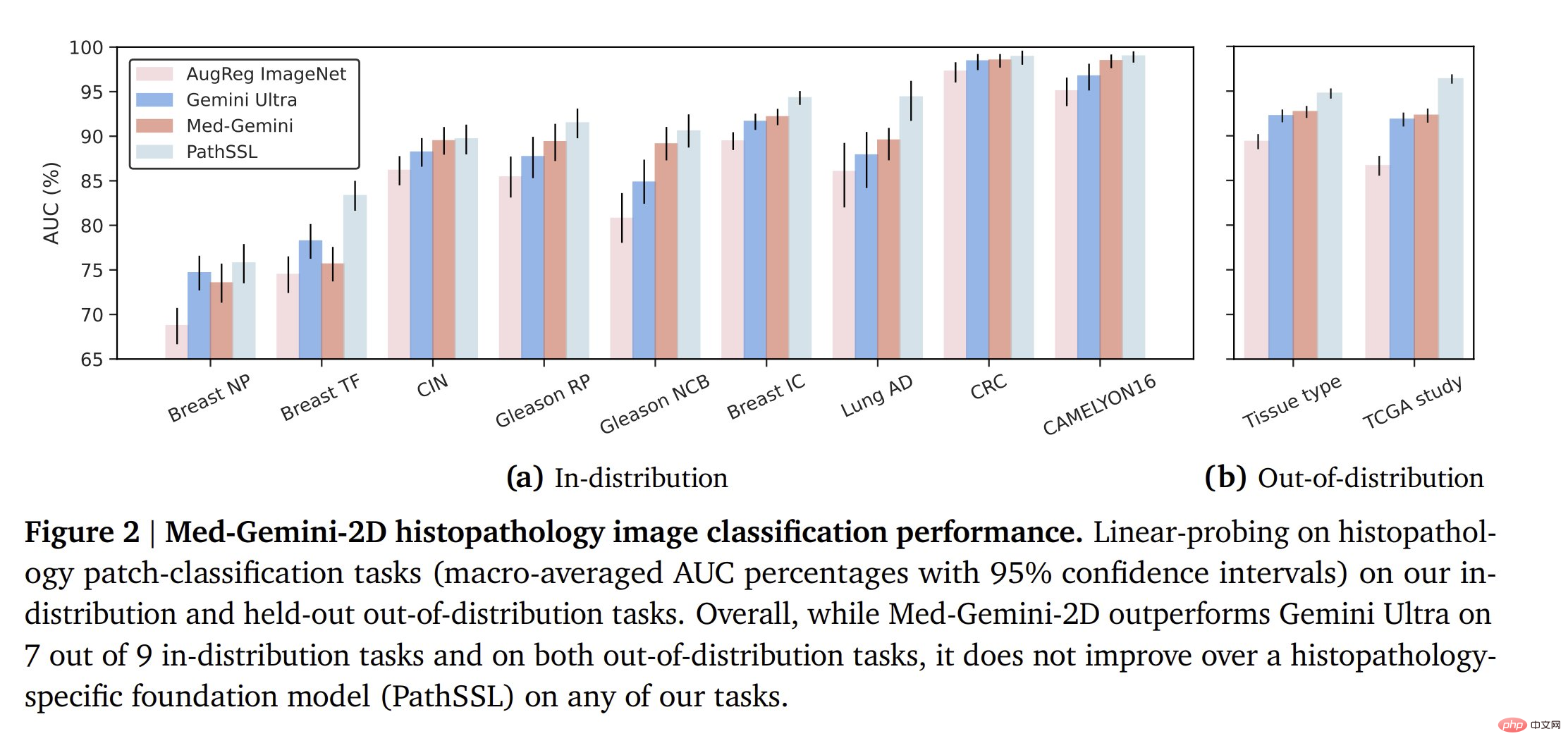

Graphique : performances de Med-Gemini-2D dans la tâche de classification des radiographies pulmonaires. (Source : article)

Med-Gemini-2D surpasse le modèle général Gemini 1.0 Ultra plus grand dans la tâche de classification distribuée des radiographies thoraciques (vu sur des exemples du même ensemble de données pendant la formation). Pour les tâches en dehors de la distribution, les performances varient.

Sur les tâches de classification histopathologique, Med-Gemini a largement surpassé Gemini Ultra, mais n'a pas réussi à surpasser le modèle de base spécifique à la pathologie.

Une tendance similaire est observée pour la classification des lésions cutanées (modèle spécifique au domaine > Med-Gemini > Gemini Ultra), bien que Med-Gemini soit très proche du modèle spécifique au domaine.

Pour la classification en ophtalmologie, une situation similaire se retrouve. Notez que les modèles spécifiques à un domaine sont formés sur environ 200 fois plus de données, donc Med-Gemini fonctionne plutôt bien en comparaison.

L'équipe a également évalué le modèle Med-Gemini-2D en réponse à des questions visuelles médicales (VQA). Ici, leur modèle est très puissant sur de nombreuses tâches VQA, battant souvent les modèles SOTA. Med-Gemini-2D a obtenu de bons résultats en matière de classification CXR et de radiologie VQA, dépassant SOTA ou référence sur 17 tâches sur 20.

Au-delà d'une simple interprétation étroite des images médicales, les auteurs évaluent également les performances de Med-Gemini-2D sur la génération de rapports de radiologie thoracique et observent ses résultats sur la base de l'évaluation d'experts en radiologie SOTA !

Med-Gemini-3D

Med-Gemini-3D n'est pas seulement destiné aux images 2D, mais également à la génération automatisée de rapports CT de bout en bout. Selon l'évaluation des experts, 53 % de ces rapports d'IA ont été jugés cliniquement acceptables, et bien que des recherches supplémentaires soient nécessaires pour garantir la qualité des rapports des radiologues experts, il s'agit du premier modèle génératif capable d'accomplir cette tâche.

Med-Gemini-Polygenic

Enfin, la prédiction des résultats de santé de Med-Gemini-Polygenic a été évaluée sur la base de scores de risque polygénique pour divers traits. Le modèle surpasse généralement les références existantes.

Illustration : Prédictions des résultats en matière de santé à l'aide de Med-Gemini-Polygenic par rapport à deux lignes de base de résultats mal distribués et hors distribution. (Source : Paper)

Voici quelques exemples de conversations multimodales prises en charge par Med-Gemini !

Dans la classification d'images en histopathologie, ophtalmologie et dermatologie, Med-Gemini-2D a dépassé la ligne de base dans 18 tâches sur 20 et s'est approché des performances du modèle spécifique à une tâche.

Conclusion

Dans l'ensemble, ces travaux ont fait des progrès utiles sur un modèle général d'intelligence artificielle médicale multimodale, mais il reste évidemment encore beaucoup à faire. De nombreux modèles spécifiques à un domaine surpassent Med-Gemini, mais Med-Gemini est capable de bien fonctionner avec moins de données et des méthodes plus générales. Il est intéressant de noter que Med-Gemini semble mieux performer dans les tâches qui reposent davantage sur la compréhension du langage, telles que la génération de rapports VQA ou de radiologie.

Les chercheurs envisagent un avenir dans lequel toutes ces fonctions individuelles seront intégrées dans des systèmes complets pour effectuer une gamme de tâches cliniques multidisciplinaires complexes. L’IA travaille aux côtés des humains pour maximiser l’efficacité clinique et améliorer les résultats pour les patients.

Lien papier : https://arxiv.org/abs/2405.03162

Contenu associé : https://twitter.com/iScienceLuvr/status/1789216212704018469

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1664

1664

14

14

1421

1421

52

52

1315

1315

25

25

1266

1266

29

29

1239

1239

24

24

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Cet article recommande les dix principales plates-formes de trading de crypto-monnaie qui méritent d'être prêtées, notamment Binance, Okx, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Ces plateformes ont leurs propres avantages en termes de quantité de devises de transaction, de type de transaction, de sécurité, de conformité et de fonctionnalités spéciales. Le choix d'une plate-forme appropriée nécessite une considération complète en fonction de votre propre expérience de trading, de votre tolérance au risque et de vos préférences d'investissement. J'espère que cet article vous aide à trouver le meilleur costume pour vous-même

Tutoriel sur la façon de vous inscrire, d'utiliser et d'annuler le compte Okex

Mar 31, 2025 pm 04:21 PM

Tutoriel sur la façon de vous inscrire, d'utiliser et d'annuler le compte Okex

Mar 31, 2025 pm 04:21 PM

Cet article présente en détail les procédures d'enregistrement, d'utilisation et d'annulation du compte OUYI OKEX. Pour vous inscrire, vous devez télécharger l'application, entrez votre numéro de téléphone mobile ou votre adresse e-mail pour vous inscrire et terminer l'authentification réelle. L'utilisation couvre les étapes de fonctionnement telles que les paramètres de connexion, de recharge et de retrait, de transaction et de sécurité. Pour annuler un compte, vous devez contacter le service client OKE OKEX, fournir les informations nécessaires et attendre le traitement, et enfin obtenir la confirmation d'annulation du compte. Grâce à cet article, les utilisateurs peuvent facilement maîtriser la gestion complète du cycle de vie du compte OUYI OKEX et effectuer des transactions d'actifs numériques en toute sécurité et pratiquement.

Tutoriel détaillé sur la façon de s'inscrire à Binance (2025 Guide du débutant)

Mar 18, 2025 pm 01:57 PM

Tutoriel détaillé sur la façon de s'inscrire à Binance (2025 Guide du débutant)

Mar 18, 2025 pm 01:57 PM

Cet article fournit un guide complet sur les paramètres d'enregistrement et de sécurité des binances, couvrant les préparations de pré-inscription (y compris l'équipement, le courrier électronique, le numéro de téléphone mobile et la préparation des documents d'identité), et introduit deux méthodes d'enregistrement sur le site officiel et l'application, ainsi que différents niveaux de vérification d'identité (KYC). De plus, l'article se concentre également sur les étapes de sécurité clés telles que la configuration d'un mot de passe de fonds, l'activation de la vérification à deux facteurs (2FA, y compris Google Authenticator et SMS Verification) et la mise en place de codes anti-phishing, aidant les utilisateurs à s'inscrire et à utiliser la plate-forme de binance de binance pour les transactions de crypto-monnaie en toute sécurité et pratique. Assurez-vous de comprendre les lois et réglementations pertinentes et les risques de marché avant de négocier et d'investir avec prudence.

Comment optimiser la segmentation des mots jieba pour améliorer l'effet d'extraction des mots clés des commentaires pittoresques?

Apr 01, 2025 pm 06:24 PM

Comment optimiser la segmentation des mots jieba pour améliorer l'effet d'extraction des mots clés des commentaires pittoresques?

Apr 01, 2025 pm 06:24 PM

Comment optimiser la segmentation des mots jieba pour améliorer l'extraction de mots clés des commentaires pittoresques? Lorsque vous utilisez la segmentation des mots jieba pour traiter les données de commentaires pittoresques, si les résultats de la segmentation des mots sont ignorés ...

Tutoriel sur l'utilisation de l'application mobile gate.io

Mar 26, 2025 pm 05:15 PM

Tutoriel sur l'utilisation de l'application mobile gate.io

Mar 26, 2025 pm 05:15 PM

Tutoriel sur l'utilisation de l'application mobile Gate.io: 1. Pour les utilisateurs d'Android, visitez le site officiel de Gate.io et téléchargez le package d'installation Android, vous devrez peut-être autoriser l'installation d'applications à partir de sources inconnues dans les paramètres de votre téléphone mobile; 2. Pour les utilisateurs iOS, recherchez "Gate.io" dans l'App Store à télécharger.

Top 10 recommandé pour les applications d'achat de devises virtuelles sûres et fiables

Mar 18, 2025 pm 12:12 PM

Top 10 recommandé pour les applications d'achat de devises virtuelles sûres et fiables

Mar 18, 2025 pm 12:12 PM

Top 10 des plates-formes mondiales de négociation de devises virtuelles recommandées en 2025, vous aidant à jouer le marché des devises numériques! Cet article analysera profondément les avantages de base et les caractéristiques spéciales de dix plates-formes top, notamment Binance, OKX, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Que vous recherchiez des liquidités élevées et des types de trading riches ou que vous vous concentriez sur la sécurité, la conformité et les fonctions innovantes, vous pouvez trouver une plate-forme qui vous convient. Nous fournirons une comparaison complète des types de transactions, de la sécurité, des fonctions spéciales, etc. pour vous aider à choisir la plate-forme de trading de devises virtuelles la plus appropriée et saisir les opportunités d'investissement en monnaie numérique en 2025

Les dernières mises à jour sur le classement de la plus ancienne monnaie virtuelle

Apr 22, 2025 am 07:18 AM

Les dernières mises à jour sur le classement de la plus ancienne monnaie virtuelle

Apr 22, 2025 am 07:18 AM

Le classement du «plus ancien» des Currences virtuels est le suivant: 1. Bitcoin (BTC), publié le 3 janvier 2009, est la première monnaie numérique décentralisée. 2. Litecoin (LTC), sorti le 7 octobre 2011, est connu sous le nom de "version légère de Bitcoin". 3. Ripple (XRP), publié en 2011, est conçu pour les paiements transfrontaliers. 4. Dogecoin (DOGE), publié le 6 décembre 2013, est une "pièce de mèmes" basée sur le code Litecoin. 5. Ethereum (ETH), publié le 30 juillet 2015, est la première plate-forme à prendre en charge les contrats intelligents. 6. Tether (USDT), publié en 2014, est le premier stablecoin à être ancré au dollar américain 1: 1. 7. Ada,

Plateforme de trading OKEX Portail de connexion du site officiel

Mar 18, 2025 pm 12:42 PM

Plateforme de trading OKEX Portail de connexion du site officiel

Mar 18, 2025 pm 12:42 PM

Cet article présente en détail les étapes complètes de la connexion dans la version Web OKEX d'Ouyi en détail, y compris les travaux de préparation (pour garantir la connexion stable et la mise à jour du navigateur), l'accès au site officiel (pour prêter attention à la précision du site Web de l'URL et à l'évitement de la piste de la maison, de l'entrée sur le chignon, de l'entrée en haut de la parole de téléphone, de l'entrée en haut de l'or et de la parole de la parole de la maison, de la parole de la parole de l'or et de la par courriel de la parole / du paradis de la parole de téléphone, de la référence de la référence), de la saisie du code de téléphone / du paroles de pwor-pwinging, de la référence du site Web), de la saisie du code de téléphone / Putword-Motching du site Web). ), terminer la vérification de la sécurité (vérification glissante, vérification de Google ou vérification SMS), et enfin vous pouvez effectuer un trading d'actifs numériques après avoir réussi à vous connecter. Un processus de connexion sûr et pratique pour assurer la sécurité des actifs des utilisateurs.