Périphériques technologiques

Périphériques technologiques

IA

IA

Kimi + Coze (coze) est un super combo, je veux construire un GPT-4o

Kimi + Coze (coze) est un super combo, je veux construire un GPT-4o

Kimi + Coze (coze) est un super combo, je veux construire un GPT-4o

Bonjour à tous, je m'appelle Laodu.

Parmi les grands modèles domestiques, les performances de Kimi sont très bonnes. Heureusement, la plateforme coze prend en charge le grand modèle Kimi.

Button est une plate-forme pour créer l'intelligence des agents. Aujourd'hui, nous allons essayer d'utiliser Kimi + Button pour créer un agent avec effet GPT-4o.

Tout d'abord, cliquez sur "Créer un bot" sur la page d'accueil du bouton. Le bot est en fait un agent.

Photos

Photos

Ici, le modèle de la série moonshot choisi est le Kimi grand modèle

Photos

Photos

Le point fort restant est le "plug-in", fourni par Coze Très riche des plug-ins, qui peuvent être combinés avec de grands modèles pour compléter de nombreuses fonctions complexes.

Donnez quelques exemples, comme la capacité visuelle. Ajoutez des plug-ins pour permettre aux grands modèles de générer et de comprendre des images.

Images

Images

Entrez à nouveau les images de chat générées et constatez que vous avez déjà la possibilité d'afficher les images

Images

Images

Plug-in de recherche et plug-in de lecture de documents, tous deux pour les grands modèles, les capacités de recherche sur Internet et la possibilité de lire des documents locaux

images

images

Bien sûr, la capacité vocale ne peut être ignorée. Avec le plug-in vocal, les grands modèles peuvent à la fois comprendre la voix et parler.

Images

Images

Il existe de nombreux autres plug-ins utiles, tels que l'exécution de code, la génération de PPT, la génération de PDF, de cartes mentales, etc.

Kouzi (Kouzi) propose un ensemble de plug-ins très riche, il en existe des centaines. Le plus important est que ces plug-ins ne nécessitent ni clé ni autorisation. Ils peuvent être utilisés directement et gratuitement après les avoir ajoutés.

Pictures

Pictures

Avec une plateforme comme Button, il est en effet pratique de créer des agents intelligents.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1664

1664

14

14

1422

1422

52

52

1316

1316

25

25

1268

1268

29

29

1241

1241

24

24

L'application de grands modèles Tencent Yuanbao est en ligne ! Hunyuan est mis à niveau pour créer un assistant IA complet pouvant être transporté n'importe où

Jun 09, 2024 pm 10:38 PM

L'application de grands modèles Tencent Yuanbao est en ligne ! Hunyuan est mis à niveau pour créer un assistant IA complet pouvant être transporté n'importe où

Jun 09, 2024 pm 10:38 PM

Le 30 mai, Tencent a annoncé une mise à niveau complète de son modèle Hunyuan. L'application « Tencent Yuanbao » basée sur le modèle Hunyuan a été officiellement lancée et peut être téléchargée sur les magasins d'applications Apple et Android. Par rapport à la version de l'applet Hunyuan lors de la phase de test précédente, Tencent Yuanbao fournit des fonctionnalités de base telles que la recherche IA, le résumé IA et l'écriture IA pour les scénarios d'efficacité du travail ; pour les scénarios de la vie quotidienne, le gameplay de Yuanbao est également plus riche et fournit de multiples fonctionnalités d'application IA. , et de nouvelles méthodes de jeu telles que la création d'agents personnels sont ajoutées. « Tencent ne s'efforcera pas d'être le premier à créer un grand modèle. » Liu Yuhong, vice-président de Tencent Cloud et responsable du grand modèle Tencent Hunyuan, a déclaré : « Au cours de l'année écoulée, nous avons continué à promouvoir les capacités de Tencent. Grand modèle Tencent Hunyuan. Dans la technologie polonaise riche et massive dans des scénarios commerciaux tout en obtenant un aperçu des besoins réels des utilisateurs.

Lancement du grand modèle Bytedance Beanbao, le service d'IA complet Volcano Engine aide les entreprises à se transformer intelligemment

Jun 05, 2024 pm 07:59 PM

Lancement du grand modèle Bytedance Beanbao, le service d'IA complet Volcano Engine aide les entreprises à se transformer intelligemment

Jun 05, 2024 pm 07:59 PM

Tan Dai, président de Volcano Engine, a déclaré que les entreprises qui souhaitent bien mettre en œuvre de grands modèles sont confrontées à trois défis clés : l'effet de modèle, le coût d'inférence et la difficulté de mise en œuvre : elles doivent disposer d'un bon support de base de grands modèles pour résoudre des problèmes complexes, et elles doivent également avoir une inférence à faible coût. Les services permettent d'utiliser largement de grands modèles, et davantage d'outils, de plates-formes et d'applications sont nécessaires pour aider les entreprises à mettre en œuvre des scénarios. ——Tan Dai, président de Huoshan Engine 01. Le grand modèle de pouf fait ses débuts et est largement utilisé. Le polissage de l'effet de modèle est le défi le plus critique pour la mise en œuvre de l'IA. Tan Dai a souligné que ce n'est que grâce à une utilisation intensive qu'un bon modèle peut être poli. Actuellement, le modèle Doubao traite 120 milliards de jetons de texte et génère 30 millions d'images chaque jour. Afin d'aider les entreprises à mettre en œuvre des scénarios de modèles à grande échelle, le modèle à grande échelle beanbao développé indépendamment par ByteDance sera lancé à travers le volcan.

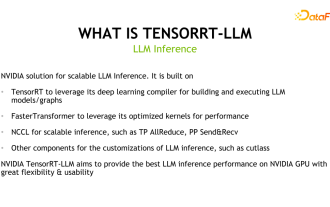

Découverte du framework d'inférence de grands modèles NVIDIA : TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

Découverte du framework d'inférence de grands modèles NVIDIA : TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

1. Positionnement du produit TensorRT-LLM TensorRT-LLM est une solution d'inférence évolutive développée par NVIDIA pour les grands modèles de langage (LLM). Il crée, compile et exécute des graphiques de calcul basés sur le cadre de compilation d'apprentissage en profondeur TensorRT et s'appuie sur l'implémentation efficace des noyaux dans FastTransformer. De plus, il utilise NCCL pour la communication entre les appareils. Les développeurs peuvent personnaliser les opérateurs pour répondre à des besoins spécifiques en fonction du développement technologique et des différences de demande, comme le développement de GEMM personnalisés basés sur le coutelas. TensorRT-LLM est la solution d'inférence officielle de NVIDIA, engagée à fournir des performances élevées et à améliorer continuellement sa praticité. TensorRT-LL

Pratique avancée du graphe de connaissances industrielles

Jun 13, 2024 am 11:59 AM

Pratique avancée du graphe de connaissances industrielles

Jun 13, 2024 am 11:59 AM

1. Introduction au contexte Tout d’abord, présentons l’historique du développement de la technologie Yunwen. Yunwen Technology Company... 2023 est la période où les grands modèles prédominent. De nombreuses entreprises pensent que l'importance des graphiques a été considérablement réduite après les grands modèles et que les systèmes d'information prédéfinis étudiés précédemment ne sont plus importants. Cependant, avec la promotion du RAG et la prévalence de la gouvernance des données, nous avons constaté qu'une gouvernance des données plus efficace et des données de haute qualité sont des conditions préalables importantes pour améliorer l'efficacité des grands modèles privatisés. Par conséquent, de plus en plus d'entreprises commencent à y prêter attention. au contenu lié à la construction des connaissances. Cela favorise également la construction et le traitement des connaissances à un niveau supérieur, où de nombreuses techniques et méthodes peuvent être explorées. On voit que l'émergence d'une nouvelle technologie ne détruit pas toutes les anciennes technologies, mais peut également intégrer des technologies nouvelles et anciennes.

Référence GPT-4 ! Le grand modèle Jiutian de China Mobile a passé le double enregistrement

Apr 04, 2024 am 09:31 AM

Référence GPT-4 ! Le grand modèle Jiutian de China Mobile a passé le double enregistrement

Apr 04, 2024 am 09:31 AM

Selon des informations du 4 avril, l'Administration du cyberespace de Chine a récemment publié une liste de grands modèles enregistrés, et le « Grand modèle d'interaction du langage naturel Jiutian » de China Mobile y a été inclus, indiquant que le grand modèle Jiutian AI de China Mobile peut officiellement fournir des informations artificielles génératives. services de renseignement vers le monde extérieur. China Mobile a déclaré qu'il s'agit du premier modèle à grande échelle développé par une entreprise centrale à avoir réussi à la fois le double enregistrement national « Enregistrement du service d'intelligence artificielle générative » et le double enregistrement « Enregistrement de l'algorithme de service de synthèse profonde domestique ». Selon les rapports, le grand modèle d'interaction en langage naturel de Jiutian présente les caractéristiques de capacités, de sécurité et de crédibilité améliorées de l'industrie, et prend en charge la localisation complète. Il a formé plusieurs versions de paramètres telles que 9 milliards, 13,9 milliards, 57 milliards et 100 milliards. et peut être déployé de manière flexible dans le Cloud, la périphérie et la fin sont des situations différentes

GPT Store ne peut même pas ouvrir ses portes. Comment cette plateforme nationale ose-t-elle emprunter cette voie ? ?

Apr 19, 2024 pm 09:30 PM

GPT Store ne peut même pas ouvrir ses portes. Comment cette plateforme nationale ose-t-elle emprunter cette voie ? ?

Apr 19, 2024 pm 09:30 PM

Attention, cet homme a connecté plus de 1 000 grands modèles, vous permettant de vous brancher et de switcher en toute transparence. Récemment, un flux de travail d'IA visuelle a été lancé : vous offrant une interface intuitive de type glisser-déposer, vous pouvez glisser, tirer et faire glisser pour organiser votre propre flux de travail sur un canevas infini. Comme le dit le proverbe, la guerre coûte cher, et Qubit a appris que dans les 48 heures suivant la mise en ligne de cet AIWorkflow, les utilisateurs avaient déjà configuré des flux de travail personnels avec plus de 100 nœuds. Sans plus tarder, je veux parler aujourd'hui de Dify, une société LLMOps, et de son PDG Zhang Luyu. Zhang Luyu est également le fondateur de Dify. Avant de rejoindre l'entreprise, il avait 11 ans d'expérience dans l'industrie Internet. Je suis engagé dans la conception de produits, je comprends la gestion de projet et j'ai des connaissances uniques sur le SaaS. Plus tard, il

Nouveau benchmark de test publié, le Llama 3 open source le plus puissant est gêné

Apr 23, 2024 pm 12:13 PM

Nouveau benchmark de test publié, le Llama 3 open source le plus puissant est gêné

Apr 23, 2024 pm 12:13 PM

Si les questions du test sont trop simples, les meilleurs étudiants et les mauvais étudiants peuvent obtenir 90 points, et l'écart ne peut pas être creusé... Avec la sortie plus tard de modèles plus puissants tels que Claude3, Llama3 et même GPT-5, l'industrie est en besoin urgent d'un modèle de référence plus difficile et différencié. LMSYS, l'organisation à l'origine du grand modèle Arena, a lancé la référence de nouvelle génération, Arena-Hard, qui a attiré une large attention. Il existe également la dernière référence pour la force des deux versions affinées des instructions Llama3. Par rapport à MTBench, qui avait des scores similaires auparavant, la discrimination Arena-Hard est passée de 22,6 % à 87,4 %, ce qui est plus fort et plus faible en un coup d'œil. Arena-Hard est construit à partir de données humaines en temps réel provenant de l'arène et a un taux de cohérence de 89,1 % avec les préférences humaines.

Grâce à la technologie Shengteng AI, le modèle de transport Qinling·Qinchuan aide Xi'an à construire un centre d'innovation en matière de transport intelligent

Oct 15, 2023 am 08:17 AM

Grâce à la technologie Shengteng AI, le modèle de transport Qinling·Qinchuan aide Xi'an à construire un centre d'innovation en matière de transport intelligent

Oct 15, 2023 am 08:17 AM

« Une complexité élevée, une fragmentation élevée et des domaines interdomaines » ont toujours été les principaux problèmes sur la voie de la mise à niveau numérique et intelligente du secteur des transports. Récemment, le « modèle de trafic Qinling·Qinchuan » avec une échelle de paramètres de 100 milliards, construit conjointement par China Science Vision, le gouvernement du district de Xi'an Yanta et le centre informatique d'intelligence artificielle du futur de Xi'an, est orienté vers le domaine des transports intelligents. et fournit des services à Xi'an et ses environs. La région créera un pivot pour l'innovation en matière de transport intelligent. Le « modèle de trafic Qinling·Qinchuan » combine les données écologiques massives du trafic local de Xi'an dans des scénarios ouverts, l'algorithme avancé original développé indépendamment par China Science Vision et la puissante puissance de calcul de l'IA Shengteng du futur centre informatique d'intelligence artificielle de Xi'an pour fournir la surveillance du réseau routier, les scénarios de transport intelligents tels que la commande d'urgence, la gestion de la maintenance et les déplacements publics entraînent des changements numériques et intelligents. La gestion du trafic présente des caractéristiques différentes selon les villes, et le trafic sur différentes routes