Périphériques technologiques

Périphériques technologiques

IA

IA

Vers la « boucle fermée » | PlanAgent : nouveau SOTA pour la planification en boucle fermée de la conduite autonome basée sur MLLM !

Vers la « boucle fermée » | PlanAgent : nouveau SOTA pour la planification en boucle fermée de la conduite autonome basée sur MLLM !

Vers la « boucle fermée » | PlanAgent : nouveau SOTA pour la planification en boucle fermée de la conduite autonome basée sur MLLM !

L'équipe d'apprentissage par renforcement profond de l'Institut d'automatisation de l'Académie chinoise des sciences, en collaboration avec Li Auto et d'autres, a proposé un nouveau cadre de planification en boucle fermée pour la conduite autonome basé sur un modèle multimodal à grand langageMLLM - PlanAgent. Cette méthode prend une vue d'ensemble de la scène et des invites de texte basées sur des graphiques en entrée, et utilise la compréhension multimodale et les capacités de raisonnement de bon sens du grand modèle de langage multimodal pour effectuer un raisonnement hiérarchique depuis la compréhension de la scène jusqu'à la génération. d'instructions de mouvement horizontal et vertical, et générer en outre les instructions requises par le planificateur. La méthode est testée sur le benchmark nuPlan à grande échelle et exigeant, et les expériences montrent que PlanAgent atteint des performances de pointe (SOTA) dans les scénarios réguliers et à longue traîne. Par rapport aux méthodes LLM (Large Language Model) conventionnelles, la quantité de jetons de description de scène requise par PlanAgent n'est que d'environ 1/3.

Informations papier

- Titre de l'article : PlanAgent : A Multi-modal Large Language Agent for Closed loop Vehicle Motion Planning

- Unités de publication papier : Institute of Automation, Chinese Academy of Sciences, Li Auto, Tsinghua Université, Université aérospatiale de Pékin

- Adresse papier :https://arxiv.org/abs/2406.01587

1 Introduction

En tant que l'un des modules de base de la conduite autonome, l'objectif de la planification des mouvements consiste à générer une trajectoire optimale pour la sécurité et le confort. Les algorithmes basés sur des règles, tels que l'algorithme PDM [1], fonctionnent bien dans la gestion des scénarios courants, mais sont souvent difficiles à gérer avec les scénarios à longue traîne qui nécessitent des opérations de conduite plus complexes [2]. Les algorithmes basés sur l'apprentissage [2,3] sont souvent surajustés dans les situations à longue traîne, ce qui entraîne des performances dans nuPlan qui ne sont pas aussi bonnes que la méthode PDM basée sur des règles.

Récemment, le développement de grands modèles de langage a ouvert de nouvelles possibilités pour la planification de la conduite autonome. Certaines recherches récentes tentent d'utiliser les puissantes capacités de raisonnement des grands modèles de langage pour améliorer les capacités de planification et de contrôle des algorithmes de conduite autonome. Cependant, ils ont rencontré quelques problèmes : (1) L'environnement expérimental n'a pas été basé sur un scénario réel d'environnement fermé (2) Un certain nombre de numéros de coordonnées ont été utilisés pour représenter les détails de la carte ou l'état du mouvement, ce qui a considérablement augmenté le nombre de jetons requis ; (3) ) Il est difficile d'assurer la sécurité lorsque les points de trajectoire sont directement générés par un grand modèle de langage. Pour relever les défis ci-dessus, cet article propose la méthode PlanAgent.

2 Méthode

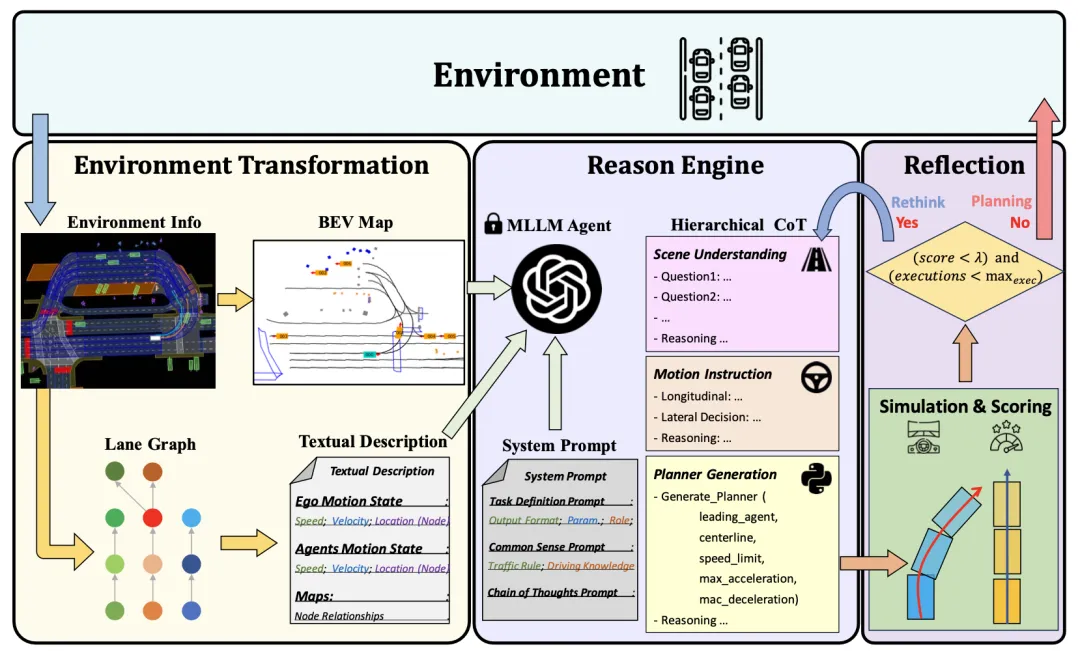

Le cadre PlanAgent d'un agent de planification en boucle fermée basé sur MLLM est présenté dans la figure 1. Cet article conçoit trois modules pour résoudre des problèmes complexes de conduite autonome :

- Module d'extraction d'informations de scène (Module de transformation de l'environnement) : Afin d'obtenir une représentation efficace des informations sur la scène, un module d'extraction des informations sur l'environnement est conçu pour extraire une entrée multimodale avec des informations sur les voies.

- Module de raisonnement : Afin de parvenir à une compréhension de la scène et à un raisonnement de bon sens, un module de raisonnement est conçu, qui utilise le grand modèle de langage multimodal MLLM pour générer un code de planificateur raisonnable et sûr.

- Module de réflexion : Afin de garantir une planification sûre, un mécanisme de réflexion est conçu, qui peut vérifier le planificateur par simulation et filtrer les propositions MLLM déraisonnables.

Figure 1 Le cadre global de PlanAgent, y compris le module d'extraction/raisonnement/réflexion des informations de scène

2.1 Module d'extraction des informations environnementales

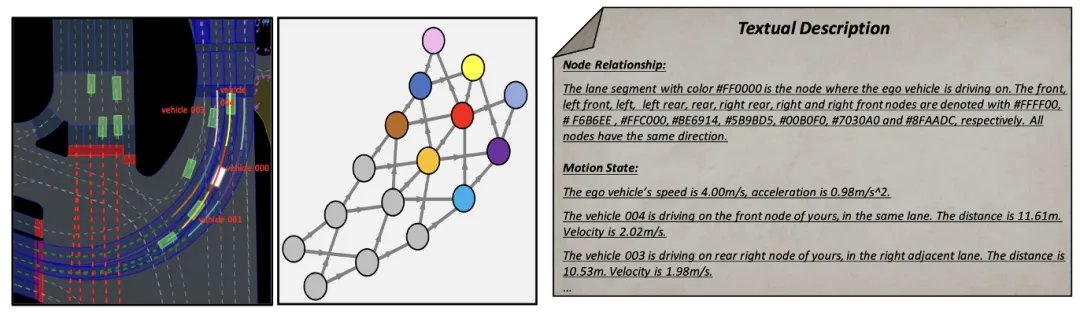

Les mots d'invite (invite) dans le grand modèle de langage génèrent une sortie pour cela, la qualité a un impact important. Afin d'améliorer la qualité de génération de MLLM, le module d'extraction d'informations de scène est capable d'extraire des informations de contexte de scène et de les convertir en une image et une représentation textuelle de vue d'oiseau (BEV), les rendant cohérentes avec l'entrée de MLLM. Premièrement, cet article convertit les informations de la scène en images Bird Escape (BEV) pour améliorer la capacité de MLLM à comprendre la scène mondiale. Dans le même temps, les informations routières doivent être représentées graphiquement, comme le montre la figure 2. Sur cette base, les informations clés sur les mouvements du véhicule sont extraites, afin que MLLM puisse se concentrer sur la zone la plus pertinente pour sa propre position.

Figure 2 Description de l'invite textuelle basée sur la représentation graphique

2.2 Module de raisonnement

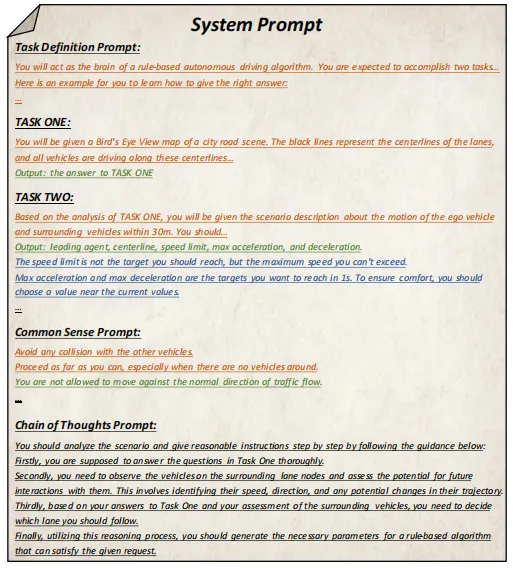

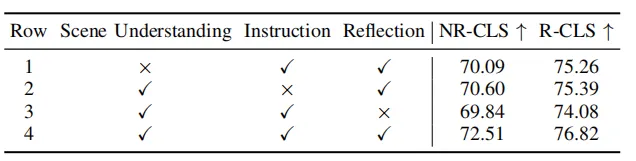

Comment introduire la capacité de raisonnement des grands modèles de langage dans le processus de planification de la conduite autonome et réaliser un système de planification doté de capacités de raisonnement de bon sens est une question clé. La méthode conçue dans cet article peut prendre en entrée les messages utilisateur et les messages système prédéfinis contenant des informations sur la scène actuelle, et générer le code de planification du modèle de pilote intelligent (IDM) à travers plusieurs cycles de raisonnement dans la chaîne de pensée hiérarchique. En conséquence, PlanAgent peut intégrer les puissantes capacités de raisonnement de MLLM dans les tâches de planification de conduite autonome grâce à l'apprentissage contextuel.

Parmi eux, le message utilisateur comprend le codage BEV et les informations sur les mouvements du véhicule environnant extraites sur la base d'une représentation graphique. Les messages du système incluent la définition des tâches, les connaissances de bon sens et les étapes de la chaîne de réflexion, comme le montre la figure 3.

Figure 3 Modèle d'invite du système

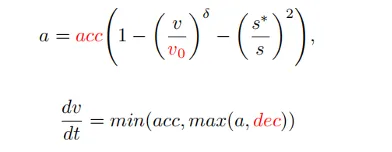

Après avoir obtenu les informations d'invite, MLLM raisonnera sur la scène actuelle à partir de trois niveaux : compréhension de la scène, instructions de mouvement et génération de code, et générera enfin le code du planificateur. . Dans PlanAgent, les codes de paramètres de suivi de voiture, de ligne médiane, de limite de vitesse, d'accélération maximale et de décélération maximale seront générés, puis l'accélération instantanée dans une certaine scène sera générée par IDM, et enfin une trajectoire sera générée.

2.3 Module de réflexion

Grâce aux deux modules ci-dessus, les capacités de compréhension et de raisonnement de MLLM sur la scène sont renforcées. Cependant, l’illusion du MLLM constitue toujours un défi pour la sécurité de la conduite autonome. Inspiré par le processus décisionnel des êtres humains consistant à « réfléchir à deux fois avant de se lancer », cet article ajoute un mécanisme de réflexion à la conception de l’algorithme. Simulez le planificateur généré par MLLM et évaluez le score de conduite du planificateur grâce à des indicateurs tels que la probabilité de collision, la distance de conduite et le confort. Lorsque le score est inférieur à un certain seuil τ, cela indique que le planificateur généré par MLLM est inadéquat, et il sera demandé à MLLM de régénérer le planificateur.

3 Expériences et résultats

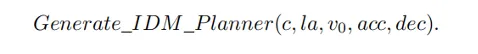

Cet article mène des expériences de planification en boucle fermée sur nuPlan [4], une plate-forme de planification en boucle fermée pour des scènes réelles à grande échelle, pour évaluer les performances de PlanAgent. comme suit. 3.1 Expérience principale trois catégories d'algorithmes de pointe et des tests sur les deux benchmarks de nuPlan, val14 et test-hard. PlanAgent affiche des résultats compétitifs et généralisables par rapport à d'autres méthodes.

Résultats compétitifs : sur le benchmark de scénario commun val14, PlanAgent surpasse les autres méthodes basées sur des règles, basées sur l'apprentissage et basées sur de grands modèles de langage, obtenant le meilleur score NR-CLS et R-CLS.

Résultats généralisables : ni les méthodes basées sur des règles représentées par PDM-Closed[1] ni les méthodes basées sur l'apprentissage représentées par planTF[2] ne peuvent fonctionner correctement sur val14 et tester dur en même temps. Par rapport à ces deux types de méthodes, PlanAgent peut surmonter les scénarios à longue traîne tout en garantissant les performances dans les scénarios courants.

Tableau 2 Comparaison des jetons utilisés par différentes méthodes pour décrire des scénarios

Tableau 2 Comparaison des jetons utilisés par différentes méthodes pour décrire des scénarios

- Dans le même temps, PlanAgent utilise moins de jetons que les autres grandes méthodes basées sur un modèle, comme le montre le tableau 2, et ne nécessite probablement que GPT 1/3 de -Driver[5] ou LLM-ASSIST[6]. Cela montre que PlanAgent peut décrire la scène plus efficacement avec moins de jetons. Ceci est particulièrement important pour l’utilisation de grands modèles de langage fermés.

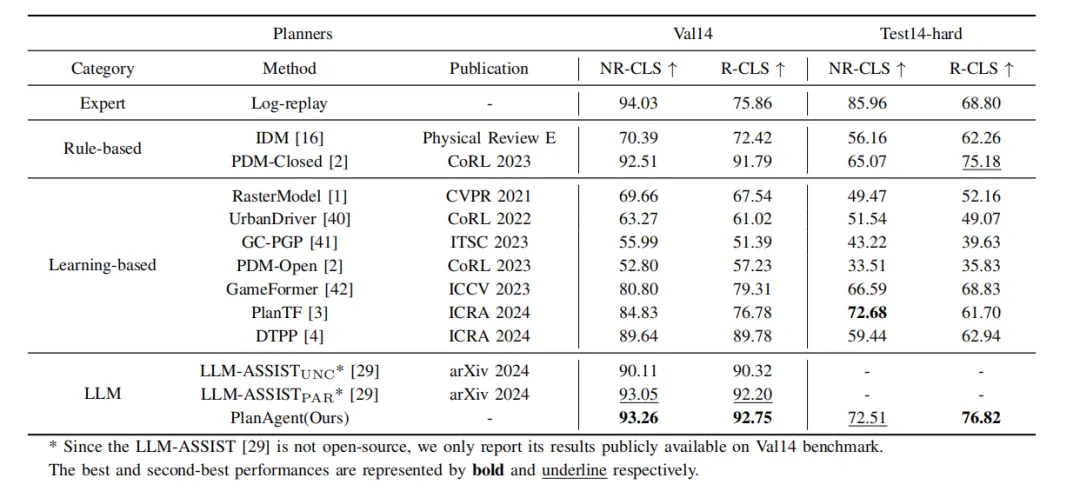

- 3.2 Expérience d'ablation

Tableau 3 Expérience d'ablation de différentes parties dans le module d'extraction de scène

Tableau 4 Expériences d'ablation de différentes parties de la chaîne de pensée hiérarchique

Comme le montrent les tableaux 3 et 4, cet article a mené des expériences d'ablation sur différentes parties du module d'extraction d'informations de scène et du module de raisonnement, et l'expérience a prouvé l'efficacité et la nécessité des modules individuels. La compréhension de la scène par MLLM peut être améliorée grâce à la représentation graphique et par image BEV, et la capacité de raisonnement de MLLM pour la scène peut être améliorée grâce à des chaînes de pensée hiérarchiques.

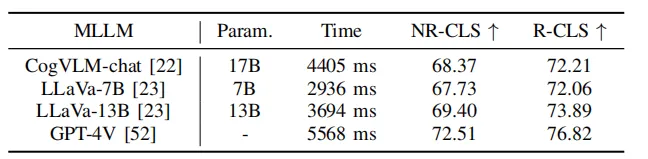

Tableau 5 Expériences de PlanAgent sur différents modèles de langage

En même temps, comme le montre le tableau 5, cet article utilise certains grands modèles de langage open source pour les tests. Les résultats expérimentaux montrent que sur le benchmark Test-hard NR-CLS, PlanAgent utilisant différents grands modèles de langage peut atteindre des scores de conduite 4,1 %, 5,1 % et 6,7 % plus élevés que PDM-Closed respectivement. Cela démontre la compatibilité de PlanAgent avec divers grands modèles de langage multimodaux.

3.3 Analyse visuelle

scène de circulation au rond-point

PDM sélectionne la voie extérieure comme ligne médiane, et le véhicule roule sur la voie extérieure et reste bloqué lorsque le véhicule fusionne. PlanAgent détermine qu'un véhicule fusionne, émet une commande raisonnable de changement de voie à gauche et génère une action latérale pour sélectionner la voie intérieure du rond-point comme ligne médiane, et le véhicule roule sur la voie intérieure.

Scène de stationnement sur la ligne d'arrêt à l'intersection

PDM a sélectionné la catégorie des feux de circulation comme catégorie de suivi des voitures. PlanAgent génère des instructions raisonnables et sélectionne la ligne d'arrêt comme catégorie de suivi de voiture.

4 Conclusion

Cet article propose un nouveau cadre de planification en boucle fermée basé sur MLLM pour la conduite autonome, appelé PlanAgent. Cette méthode introduit un module d'extraction d'informations de scène pour extraire des images BEV et extraire les informations de mouvement des véhicules environnants sur la base de la représentation graphique de la route. Dans le même temps, un module de raisonnement avec une structure hiérarchique est proposé pour guider MLLM dans la compréhension des informations de scène, générer des instructions de mouvement et enfin générer du code de planificateur. De plus, PlanAgent imite également la prise de décision humaine à des fins de réflexion et replanifie lorsque le score de trajectoire est inférieur au seuil pour améliorer la sécurité de la prise de décision. L'agent de planification en boucle fermée de conduite autonome PlanAgent, basé sur le grand modèle multimodal, a atteint les performances SOTA en matière de planification en boucle fermée sur le benchmark nuPlan.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1670

1670

14

14

1428

1428

52

52

1329

1329

25

25

1276

1276

29

29

1256

1256

24

24

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Le premier article pilote et clé présente principalement plusieurs systèmes de coordonnées couramment utilisés dans la technologie de conduite autonome, et comment compléter la corrélation et la conversion entre eux, et enfin construire un modèle d'environnement unifié. L'objectif ici est de comprendre la conversion du véhicule en corps rigide de caméra (paramètres externes), la conversion de caméra en image (paramètres internes) et la conversion d'image en unité de pixel. La conversion de 3D en 2D aura une distorsion, une traduction, etc. Points clés : Le système de coordonnées du véhicule et le système de coordonnées du corps de la caméra doivent être réécrits : le système de coordonnées planes et le système de coordonnées des pixels Difficulté : la distorsion de l'image doit être prise en compte. La dé-distorsion et l'ajout de distorsion sont compensés sur le plan de l'image. 2. Introduction Il existe quatre systèmes de vision au total : système de coordonnées du plan de pixels (u, v), système de coordonnées d'image (x, y), système de coordonnées de caméra () et système de coordonnées mondiales (). Il existe une relation entre chaque système de coordonnées,

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

Titre original : SIMPL : ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Lien article : https://arxiv.org/pdf/2402.02519.pdf Lien code : https://github.com/HKUST-Aerial-Robotics/SIMPL Affiliation de l'auteur : Université des sciences de Hong Kong et technologie Idée DJI Paper : cet article propose une base de référence de prédiction de mouvement (SIMPL) simple et efficace pour les véhicules autonomes. Par rapport au cent agent traditionnel

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Au cours du mois dernier, pour des raisons bien connues, j'ai eu des échanges très intensifs avec divers professeurs et camarades de classe du secteur. Un sujet inévitable dans l'échange est naturellement le populaire Tesla FSDV12 de bout en bout. Je voudrais profiter de cette occasion pour trier certaines de mes pensées et opinions en ce moment pour votre référence et votre discussion. Comment définir un système de conduite autonome de bout en bout et quels problèmes devraient être résolus de bout en bout ? Selon la définition la plus traditionnelle, un système de bout en bout fait référence à un système qui saisit les informations brutes des capteurs et génère directement les variables pertinentes pour la tâche. Par exemple, en reconnaissance d'images, CNN peut être appelé de bout en bout par rapport à la méthode traditionnelle d'extraction de caractéristiques + classificateur. Dans les tâches de conduite autonome, saisir les données de divers capteurs (caméra/LiDAR