Périphériques technologiques

Périphériques technologiques

IA

IA

Open source! V2Xverse : remise et publication de la première plateforme de simulation et du premier modèle de bout en bout pour V2X

Open source! V2Xverse : remise et publication de la première plateforme de simulation et du premier modèle de bout en bout pour V2X

Open source! V2Xverse : remise et publication de la première plateforme de simulation et du premier modèle de bout en bout pour V2X

Données de conduite synchronisées de la collaboration véhicule-route

Conduite autonome assistée du véhicule vers tout Le V2X-AD (conduite autonome assistée du véhicule vers tout) a un grand potentiel pour fournir des stratégies de conduite plus sûres. Les chercheurs ont mené de nombreuses recherches sur les aspects de communication et de communication du V2X-AD, mais l'effet de ces infrastructures et ressources de communication sur l'amélioration des performances de conduite n'a pas été entièrement exploré. Cela met en évidence la nécessité d’étudier la conduite autonome collaborative, c’est-à-dire comment concevoir des stratégies efficaces de partage d’informations pour la planification de la conduite afin d’améliorer les performances de conduite de chaque véhicule. Cela nécessite deux conditions de base clés : l'une est une plate-forme capable de fournir un environnement de données pour V2X-AD et un système de conduite de bout en bout avec des fonctions complètes liées à la conduite et des mécanismes de partage d'informations. En ce qui concerne la plate-forme qui fournit l'environnement de données, cela peut être réalisé en utilisant le réseau de communication entre les véhicules et le support de l'infrastructure. De cette manière, les véhicules peuvent partager en temps réel les informations environnementales nécessaires à la conduite, améliorant ainsi les performances de conduite. D’un autre côté, les systèmes de conduite de bout en bout doivent disposer de fonctions de conduite complètes et être capables de partager des informations. Cela signifie que le système de conduite doit être capable d'obtenir des informations relatives à la conduite provenant d'autres véhicules et infrastructures et de combiner ces informations avec sa propre planification de conduite pour offrir des performances de conduite plus efficaces. Tout en respectant ces deux conditions fondamentales, la sécurité et la protection de la vie privée doivent également être prises en compte. Par conséquent, lors de la conception de la stratégie de planification de conduite du V2X-AD, nous devons nous concentrer sur l’efficacité de la stratégie de partage d’informations et ainsi améliorer les performances de conduite de chaque véhicule. Pour résumer, la conduite autonome assistée collaborative véhicule-route V2X-AD a un énorme potentiel

" Pour cette raison, des chercheurs de l'Université Jiao Tong de Shanghai et du Laboratoire d'intelligence artificielle de Shanghai ont publié un nouvel article de recherche "Vers une conduite autonome collaborative : plate-forme de simulation" et End-to-End System" a proposé CoDriving : un système de conduite collaborative de bout en bout qui utilise une stratégie de partage d'informations pour conduire la planification afin d'obtenir une communication et une collaboration efficaces. Dans le même temps, les chercheurs de cet article ont construit une plate-forme de simulation. V2Xverse, cette plateforme fournit un environnement complet de formation et de test pour la conduite collaborative, y compris la génération d'ensembles de données de conduite collaborative véhicule-route, le déploiement de systèmes de conduite collaborative full-stack, ainsi que l'évaluation des performances de conduite en boucle fermée et l'évaluation des tâches de conduite de manière personnalisable. scénarios. "

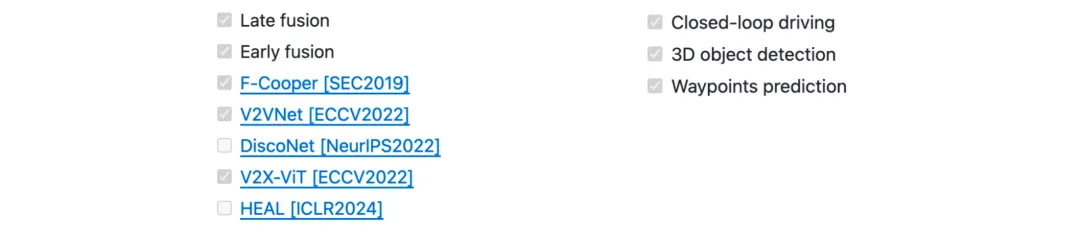

Dans le même temps, la plate-forme de simulation V2Xverse intègre les codes de test de formation et de déploiement de plusieurs méthodes de détection collaborative existantes et utilise une variété de tâches de test pour tester des capacités de conduite complètes : détection de cibles 3D, planification de chemin et fermeture. conduite autonome en boucle. V2Xverse dépasse les limites des méthodes de détection collaborative existantes qui peuvent uniquement « voir » mais pas « contrôler ». Il prend en charge l'intégration des méthodes de détection collaborative existantes dans un système de conduite complet et teste les performances de conduite dans un environnement de simulation. Les chercheurs de cet article pensent que cela apportera de meilleures extensions fonctionnelles et un test de référence plus adapté aux scénarios de conduite réels pour la recherche sur la collaboration véhicule-route basée sur la vision dans la conduite autonome.

- Lien papier : https://arxiv.org/pdf/2404.09496

- Lien code : https://github.com/CollaborativePerception/V2Xverse

Contexte et signification de la recherche

Recherche sur ce sujet article Focus sur la conduite autonome collaborative basée sur la communication V2X (Vehicle-to-everything). Par rapport à la conduite autonome d'un seul véhicule, la conduite autonome collaborative améliore la perception du véhicule et les performances de conduite grâce à l'échange d'informations entre le véhicule et l'environnement (tels que les unités en bordure de route, les piétons équipés d'appareils intelligents, etc.), ce qui profitera aux personnes malvoyantes. . Conduite sûre dans des scénarios complexes (Figure 1).

Figure 1. Scénario dangereux de « sonde fantôme », le vélo ne peut pas détecter l'objet obstrué

Figure 1. Scénario dangereux de « sonde fantôme », le vélo ne peut pas détecter l'objet obstrué

Actuellement, la plupart des travaux collaboratifs véhicule-route basés sur V2X se concentrent sur l'optimisation des capacités de perception au niveau du module. Cependant, la manière d’utiliser les capacités de détection coopérative pour améliorer les performances de conduite finales dans les systèmes intégrés reste encore sous-explorée.

Afin de résoudre ce problème, cet article vise à étendre la capacité de détection collaborative à un système de conduite collaborative couvrant des capacités de conduite complètes, comprenant des modules clés tels que la perception, la prédiction, la planification et le contrôle. Parvenir à une conduite autonome collaborative nécessite deux fondations clés : une plate-forme pouvant fournir un environnement de données pour V2X-AD et la seconde est un système de conduite de bout en bout qui intègre des fonctions complètes liées à la conduite et des mécanismes de partage d'informations. Du point de vue de la plate-forme, ce travail construit V2Xverse, une plate-forme complète de simulation de conduite autonome collaborative qui fournit un processus complet depuis la génération d'ensembles de données de conduite collaborative véhicule-route jusqu'au déploiement de systèmes de conduite collaboratifs complets et à l'évaluation des performances de conduite en boucle fermée. . Du point de vue du système de conduite, cet article présente CoDriving, un nouveau système de conduite collaborative de bout en bout qui conçoit et intègre un module de collaboration basé sur la communication V2X dans un cadre de conduite autonome complet pour améliorer les performances de conduite collaborative en partageant des informations sensorielles. . L'idée centrale de CoDriving est une nouvelle stratégie de partage d'informations pour la planification de la conduite, qui utilise des informations sur les caractéristiques visuelles spatialement clairsemées mais importantes pour la conduite comme contenu de communication afin d'optimiser l'efficacité de la communication tout en améliorant les performances de conduite.

V2Xverse : Plateforme de simulation de conduite collaborative véhicule-route

La principale caractéristique de V2Xverse proposée dans cet article est qu'elle peut réaliser une génération de référence hors ligne de sous-tâches liées à la conduite et une évaluation en ligne en boucle fermée des performances de conduite dans différents scénarios, prenant pleinement en charge le développement de systèmes de conduite autonome collaboratifs. Afin de créer une scène V2X-AD, V2Xverse met en place plusieurs voitures intelligentes équipées de capacités de conduite complètes dans la scène et place des unités en bordure de route des deux côtés de la route grâce à certaines stratégies pour fournir une vision supplémentaire aux voitures intelligentes. Afin de soutenir le développement de méthodes de conduite autonome collaboratives, V2Xverse fournit d'abord des modules de communication (véhicule-véhicule) et (véhicule-unité routière), et fournit des signaux de conduite complets et des annotations d'experts pour la formation du système, et fournit également une évaluation de conduite en boucle fermée. Une variété de scénarios dangereux. Le cadre de la plateforme de simulation est illustré à la figure 2.

Figure 2. Cadre de la plateforme de simulation V2Xverse

Figure 2. Cadre de la plateforme de simulation V2Xverse

Par rapport à la plateforme de simulation de conduite autonome existante basée sur Carla, V2Xverse présente trois avantages. Tout d'abord, V2Xverse prend en charge la simulation de conduite multi-véhicules, tandis que le carla-leaderboard grand public et ses plates-formes dérivées ne prennent en charge que la simulation de conduite mono-véhicule. Deuxièmement, V2Xverse prend en charge la simulation complète des fonctions de conduite, tandis que la plateforme de simulation de perception collaborative existante ne prend en charge que les fonctions liées au module de perception. Troisièmement, V2Xverse prend en charge des scénarios V2X-AD complets, notamment divers dispositifs de capteurs, l'intégration de modèles et une personnalisation flexible des scénarios, voir le tableau 1.

Tableau 1. Comparaison entre V2Xverse et la plateforme de simulation de conduite autonome existante basée sur Carla

Tableau 1. Comparaison entre V2Xverse et la plateforme de simulation de conduite autonome existante basée sur Carla

CoDriving : Un modèle de conduite autonome de bout en bout pour une collaboration efficace

CoDriving comprend deux composants (voir Figure 3) : 1 ) Le réseau de conduite autonome de vélo de bout en bout convertit les entrées des capteurs en signaux de commande de conduite ; 2) Collaboration axée sur la conduite, les collaborateurs parviennent à une communication efficace en partageant les fonctionnalités de détection clés pour la conduite et améliorent les fonctionnalités de détection du BEV du vélo grâce à l'agrégation de fonctionnalités, la perception améliorée. Les fonctionnalités aideront le système à produire des résultats de reconnaissance de perception et des résultats de prévision de planification plus précis.

Figure 3. Le cadre global de CoDriving

Figure 3. Le cadre global de CoDriving

Réseau de conduite autonome de bout en bout

Le réseau de conduite autonome de bout en bout pour véhicule unique apprend les prédictions de points de chemin de sortie en fonction des entrées de différentes modalités, et convertit le chemin à travers un module de commande, les points sont convertis en signaux de commande de conduite. Pour y parvenir, CoDriving intègre les composants modulaires nécessaires à la conduite dans un système de bout en bout, comprenant des détecteurs d'objets 3D, des prédicteurs de waypoints et des contrôleurs. CoDriving utilise la représentation Bird's Eye View (BEV) car elle fournit un système de coordonnées global unifié, évite les transformations de coordonnées complexes et prend mieux en charge la collaboration basée sur les informations spatiales.

Stratégie de collaboration orientée conduite

La collaboration V2X résout l'inévitable problème de la visibilité limitée des vélos grâce au partage d'informations. Dans ce travail, cet article propose une nouvelle stratégie de collaboration orientée conduite pour optimiser simultanément les performances de conduite et l'efficacité de la communication. Le système comprend i) une communication de perception basée sur l'intention de conduite, où CoDriving échange des caractéristiques de perception BEV spatialement clairsemées mais critiques pour la conduite via un module de demande de conduite et ii) une amélioration des fonctionnalités BEV, où CoDriving utilise les informations de caractéristiques reçues pour améliorer les performances de chacun ; véhicule collaboratif. Les fonctionnalités BEV améliorées aideront le système à produire des résultats de reconnaissance de perception et des résultats de prévision de planification plus précis.

Résultats expérimentaux

À l'aide de la plateforme de simulation V2Xverse, cet article a testé les performances de CoDriving sur trois tâches : conduite en boucle fermée, détection de cibles 3D et prédiction de waypoints. Dans le test de conduite clé en boucle fermée, par rapport à la précédente méthode SOTA de conduite autonome de bout en bout pour un seul véhicule, le score de conduite de CoDriving s'est considérablement amélioré de 62,49 % et le taux de collisions avec des piétons a chuté de 53,50 %. Dans les tâches de détection de cibles et de prédiction de points de cheminement, CoDriving fonctionne mieux que les autres méthodes collaboratives, comme le montre le tableau 2.

Tableau 2. CoDriving est meilleur que la méthode de conduite unique de SOTA dans la tâche de conduite en boucle fermée, et meilleur que les autres méthodes de détection collaborative dans les sous-tâches de détection et de planification modulaires

Tableau 2. CoDriving est meilleur que la méthode de conduite unique de SOTA dans la tâche de conduite en boucle fermée, et meilleur que les autres méthodes de détection collaborative dans les sous-tâches de détection et de planification modulaires

Cet article étudie également la collaboration de CoDriving sous différentes bandes passantes de communication Les performances ont été vérifiées. Dans les trois tâches de conduite en boucle fermée, de détection de cibles 3D et de prédiction de points de cheminement, CoDriving surpasse les autres méthodes de collaboration sous différentes contraintes de bande passante de communication, comme le montre la figure 4.

Figure 4. Performances de collaboration de CoDriving sous différentes bandes passantes de communication

Figure 4. Performances de collaboration de CoDriving sous différentes bandes passantes de communication

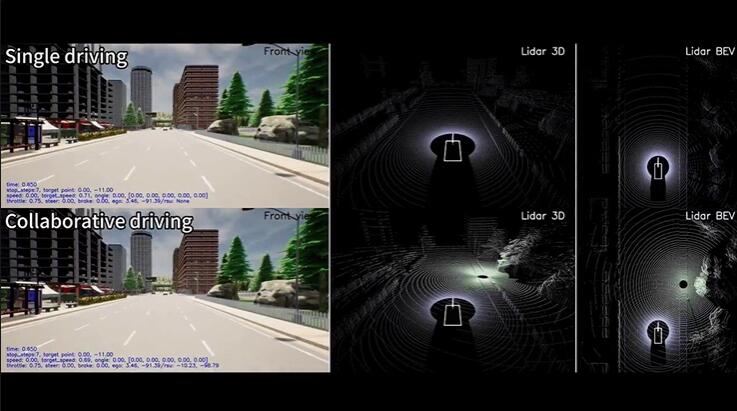

La figure 5 montre un cas de conduite de CoDriving dans l'environnement de simulation V2Xverse. Dans la scène de la figure 5, un piéton dans l'angle mort s'est soudainement précipité hors de la route. On peut voir que le vélo autonome avait un champ de vision limité et n'a pas pu éviter le piéton à l'avance, provoquant un grave accident de voiture. . CoDriving utilise les caractéristiques de vision partagées des unités routières pour détecter les piétons à l'avance et les éviter en toute sécurité.

Par rapport aux vélos autonomes avec une vision limitée, CoDriving utilise les informations fournies par les unités en bordure de route pour détecter les piétons dans les angles morts Figure 5(2). conduire des vélos Le fait de ne pas éviter à temps une collision a provoqué une collision

Figure 5(2). conduire des vélos Le fait de ne pas éviter à temps une collision a provoqué une collision

Résumé

Ce travail contribue au développement de méthodes de conduite autonome collaborative en construisant une plateforme de simulation V2Xverse, et propose un nouveau système de conduite autonome de bout en bout. Parmi eux, V2Xverse est une plateforme de simulation de conduite collaborative V2X qui prend en charge les tests de conduite en boucle fermée. Cette plateforme fournit un canal de développement complet pour le développement de systèmes de conduite autonome collaboratifs dans le but d'améliorer les performances de conduite finales. Il convient de mentionner que V2Xverse prend également en charge le déploiement d'une variété de systèmes de conduite autonome existants pour un seul véhicule, ainsi que la formation et les tests de conduite en boucle fermée d'une variété de méthodes de détection collaborative existantes. Dans le même temps, cet article propose un nouveau système de conduite autonome collaboratif de bout en bout, CoDriving, qui améliore les performances de conduite et optimise l'efficacité de la communication en partageant des informations clés sur la perception de la conduite. Une évaluation complète de l'ensemble du système de conduite montre que CoDriving est nettement meilleur que le système de conduite autonome pour un seul véhicule, sur différentes bandes passantes de communication. Les chercheurs de cet article estiment que la plateforme V2Xverse et le système CoDriving offrent des solutions potentielles pour une conduite autonome plus fiable.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1673

1673

14

14

1429

1429

52

52

1333

1333

25

25

1278

1278

29

29

1257

1257

24

24

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

La technologie de détection et de reconnaissance des visages est déjà une technologie relativement mature et largement utilisée. Actuellement, le langage d'application Internet le plus utilisé est JS. La mise en œuvre de la détection et de la reconnaissance faciale sur le front-end Web présente des avantages et des inconvénients par rapport à la reconnaissance faciale back-end. Les avantages incluent la réduction de l'interaction réseau et de la reconnaissance en temps réel, ce qui réduit considérablement le temps d'attente des utilisateurs et améliore l'expérience utilisateur. Les inconvénients sont les suivants : il est limité par la taille du modèle et la précision est également limitée ; Comment utiliser js pour implémenter la détection de visage sur le web ? Afin de mettre en œuvre la reconnaissance faciale sur le Web, vous devez être familier avec les langages et technologies de programmation associés, tels que JavaScript, HTML, CSS, WebRTC, etc. Dans le même temps, vous devez également maîtriser les technologies pertinentes de vision par ordinateur et d’intelligence artificielle. Il convient de noter qu'en raison de la conception du côté Web

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.