Périphériques technologiques

Périphériques technologiques

IA

IA

Comment utiliser le chat de Nvidia avec le chatbot RTX AI sur votre ordinateur

Comment utiliser le chat de Nvidia avec le chatbot RTX AI sur votre ordinateur

Comment utiliser le chat de Nvidia avec le chatbot RTX AI sur votre ordinateur

Nvidia a lancé Chat with RXT, un chatbot IA qui fonctionne sur votre PC et offre des fonctionnalités similaires à ChatGPT et bien plus encore ! Tout ce dont vous avez besoin est un GPU Nvidia RTX et vous êtes prêt à commencer à utiliser le nouveau chatbot IA de Nvidia.

Qu'est-ce que Nvidia Chat avec RTX ?

Nvidia Chat with RTX est un logiciel d'IA qui vous permet d'exécuter un grand modèle de langage (LLM) localement sur votre ordinateur. Ainsi, au lieu d'aller en ligne pour utiliser un chatbot IA comme ChatGPT, vous pouvez utiliser Chat avec RTX hors ligne quand vous le souhaitez.

Chat avec RTX utilise TensorRT-LLM, l'accélération RTX et un Mistral 7-B LLM quantifié pour fournir des performances rapides et des réponses de qualité comparables à celles des autres chatbots IA en ligne. Il fournit également une génération augmentée par récupération (RAG), permettant au chatbot de lire vos fichiers et d'activer des réponses personnalisées basées sur les données que vous fournissez. Cela vous permet de personnaliser le chatbot pour offrir une expérience plus personnelle.

Si vous souhaitez essayer Nvidia Chat avec RTX, voici comment le télécharger, l'installer et le configurer sur votre ordinateur.

Comment télécharger et installer Chat avec RTX

Nvidia a rendu l'exécution d'un LLM localement sur votre ordinateur beaucoup plus facile. Pour exécuter Chat avec RTX, il vous suffit de télécharger et d’installer l’application, comme vous le feriez avec n’importe quel autre logiciel. Cependant, Chat with RTX nécessite certaines spécifications minimales pour être installé et utilisé correctement.

GPU RTX série 30 ou série 40 16 Go de RAM 100 Go d'espace mémoire libre Windows 11Si votre PC répond à la configuration minimale requise, vous pouvez continuer et installer l'application.

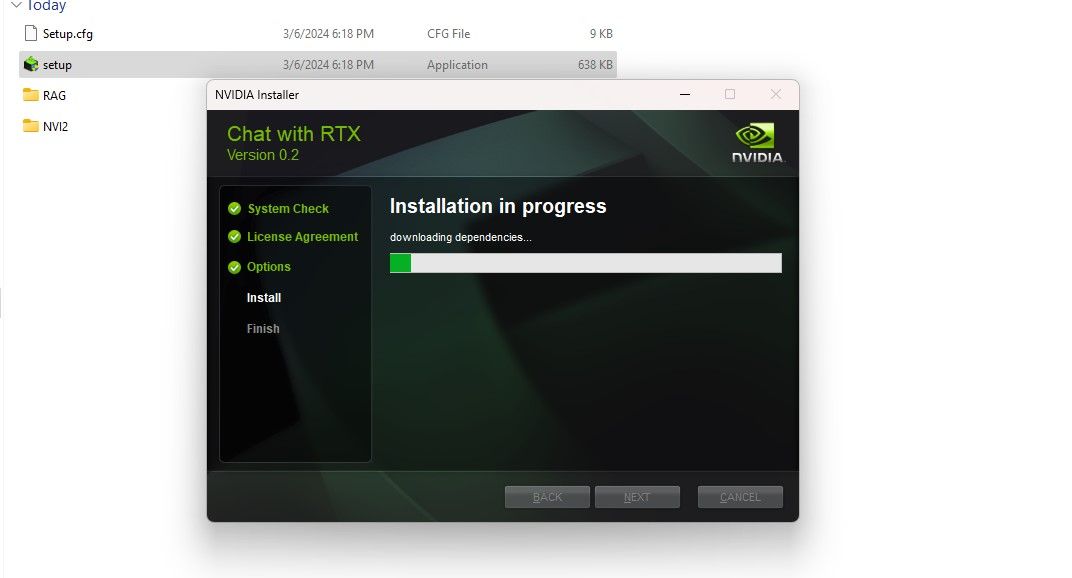

Étape 1 : Téléchargez le fichier ZIP Chat avec RTX.Téléchargement : Chat avec RTX (téléchargement gratuit – 35 Go)Étape 2 : Extrayez le fichier ZIP en cliquant avec le bouton droit et en sélectionnant un outil d'archivage de fichiers comme 7Zip ou en double-cliquant sur le fichier. et en sélectionnant Extraire tout. Étape 3 : Ouvrez le dossier extrait et double-cliquez sur setup.exe. Suivez les instructions à l'écran et cochez toutes les cases pendant le processus d'installation personnalisée. Après avoir cliqué sur Suivant, le programme d'installation téléchargera et installera le LLM et toutes les dépendances.

L'installation de Chat with RTX prendra un certain temps car elle télécharge et installe une grande quantité de données. Après le processus d'installation, appuyez sur Fermer et vous avez terminé. Il est maintenant temps pour vous d'essayer l'application.

Comment utiliser Nvidia Chat avec RTX

Bien que vous puissiez utiliser Chat avec RTX comme un chatbot IA en ligne classique, je vous suggère fortement de vérifier sa fonctionnalité RAG, qui vous permet de personnaliser sa sortie en fonction des fichiers auxquels vous donnez accès.

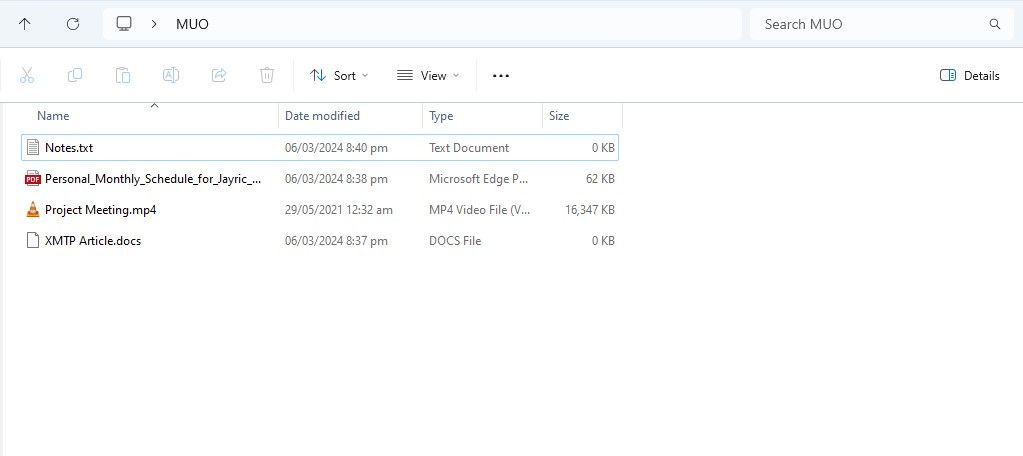

Étape 1 : Créer un dossier RAG

Pour commencer à utiliser RAG sur Chat avec RTX, créez un nouveau dossier pour stocker les fichiers que vous souhaitez que l'IA analyse.

Après la création, placez vos fichiers de données dans le dossier. Les données que vous stockez peuvent couvrir de nombreux sujets et types de fichiers, tels que des documents, des PDF, du texte et des vidéos. Cependant, vous souhaiterez peut-être limiter le nombre de fichiers que vous placez dans ce dossier afin de ne pas affecter les performances. Plus de données à rechercher signifie que Chat avec RTX mettra plus de temps à renvoyer des réponses à des requêtes spécifiques (mais cela dépend également du matériel).

Maintenant que votre base de données est prête, vous pouvez configurer Chat avec RTX et commencer à l'utiliser pour répondre à vos questions et requêtes.

Étape 2 : Configurer l'environnement

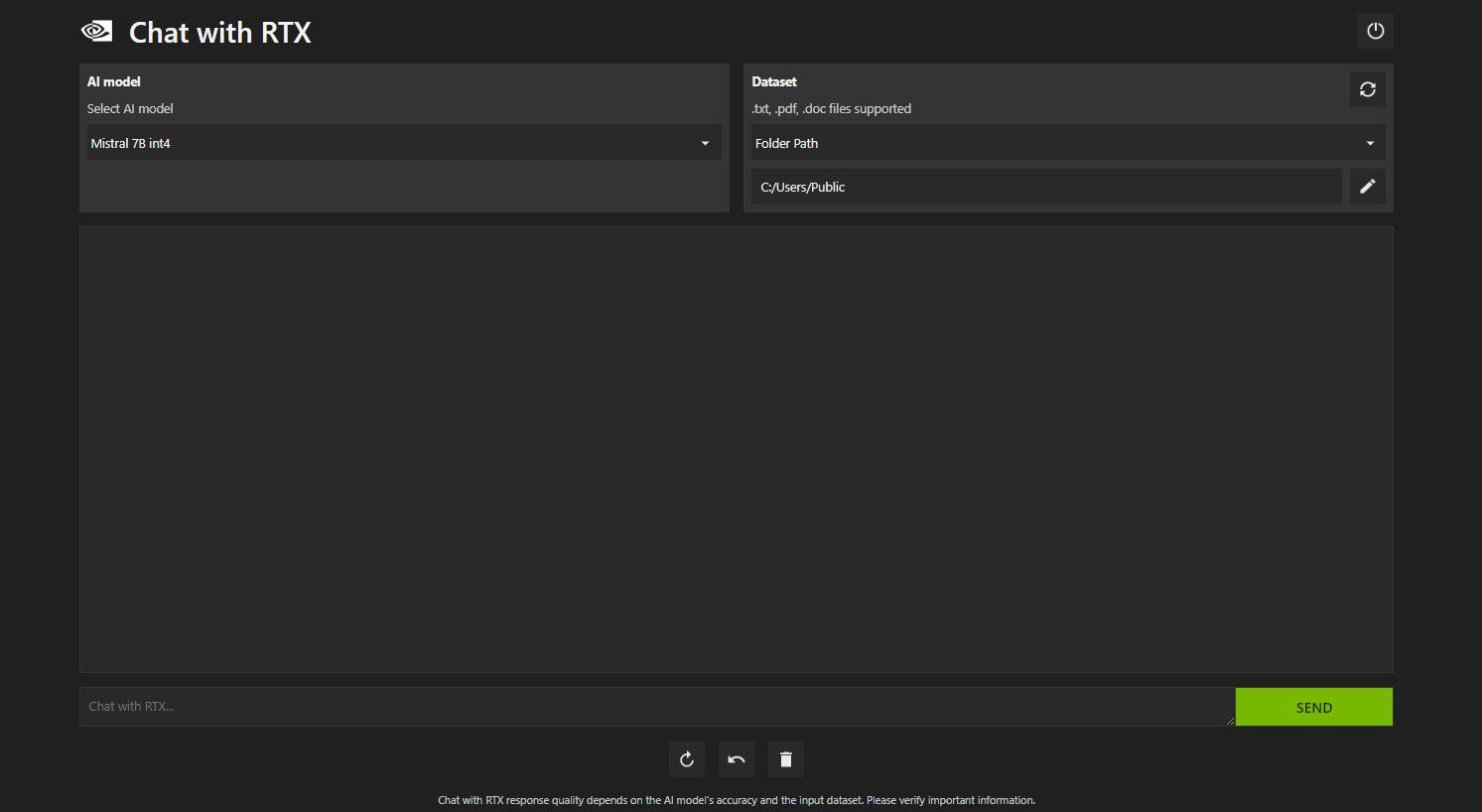

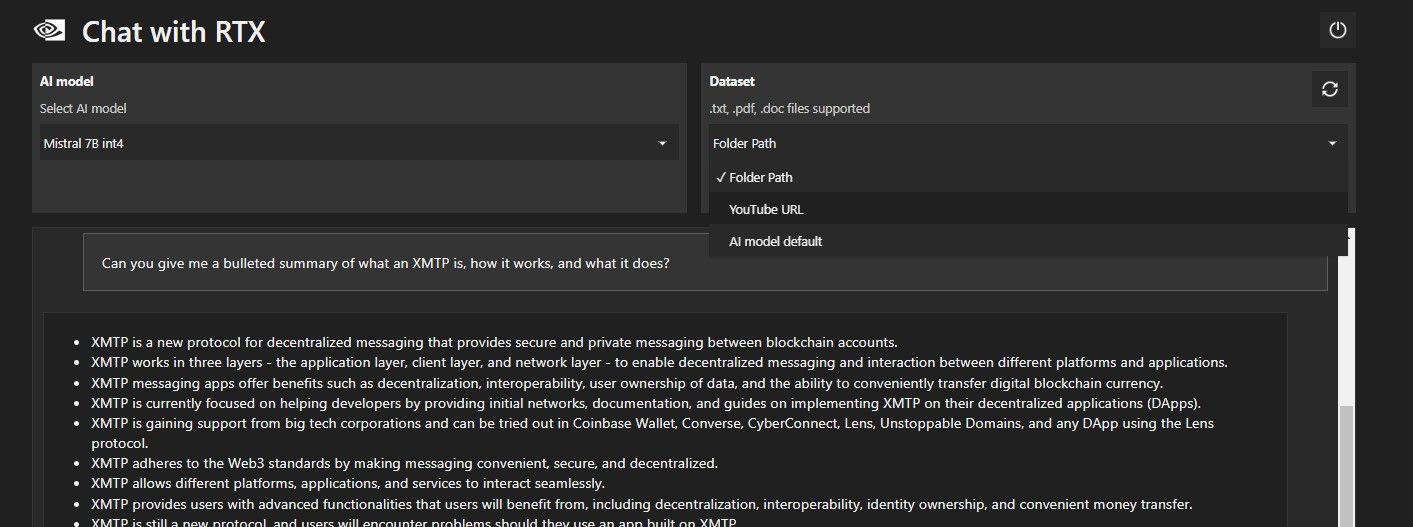

Ouvrez le chat avec RTX. Cela devrait ressembler à l’image ci-dessous.

Sous Ensemble de données, assurez-vous que l'option Chemin du dossier est sélectionnée. Cliquez maintenant sur l'icône d'édition ci-dessous (l'icône en forme de stylo) et sélectionnez le dossier contenant tous les fichiers que vous souhaitez que Chat with RTX lise. Vous pouvez également changer de modèle d'IA si d'autres options sont disponibles (au moment de la rédaction, seul Mistral 7B est disponible).

Vous êtes maintenant prêt à utiliser Chat avec RTX.

Étape 3 : Posez vos questions en discutant avec RTX !

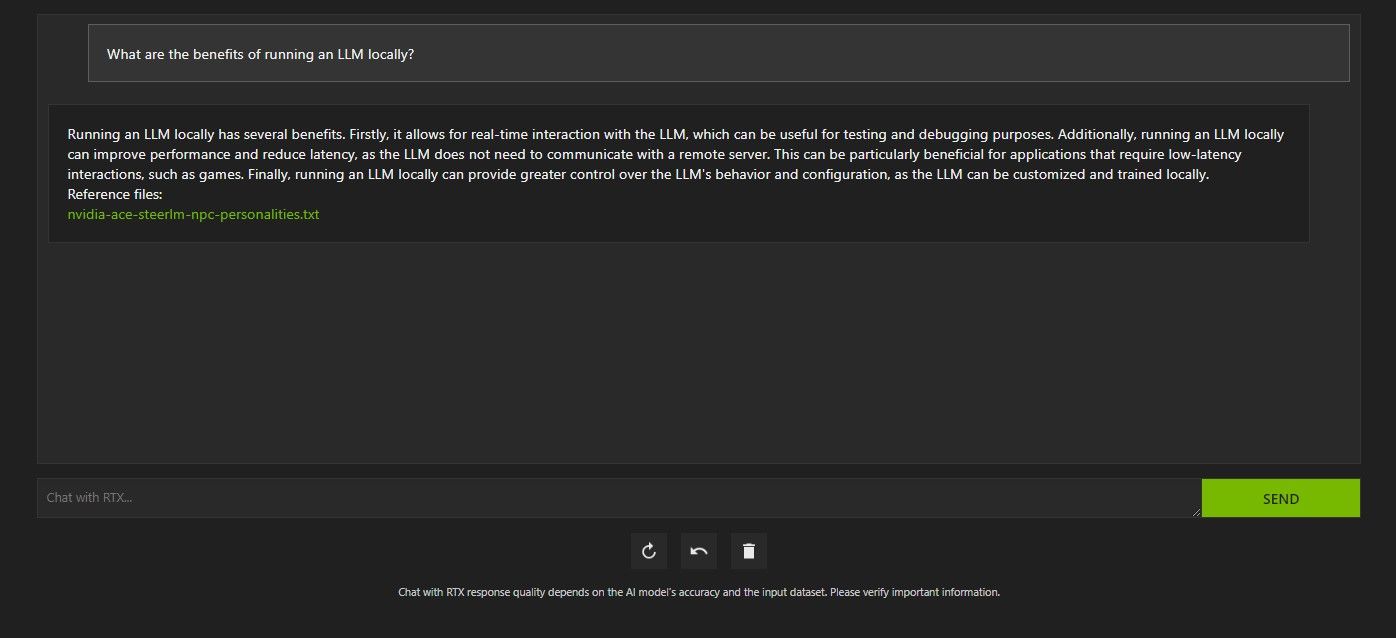

Il existe plusieurs façons d'interroger Chat avec RTX. La première consiste à l’utiliser comme un chatbot IA classique. J'ai interrogé Chat avec RTX sur les avantages de l'utilisation d'un LLM local et j'ai été satisfait de sa réponse. Ce n'était pas très approfondi, mais suffisamment précis.

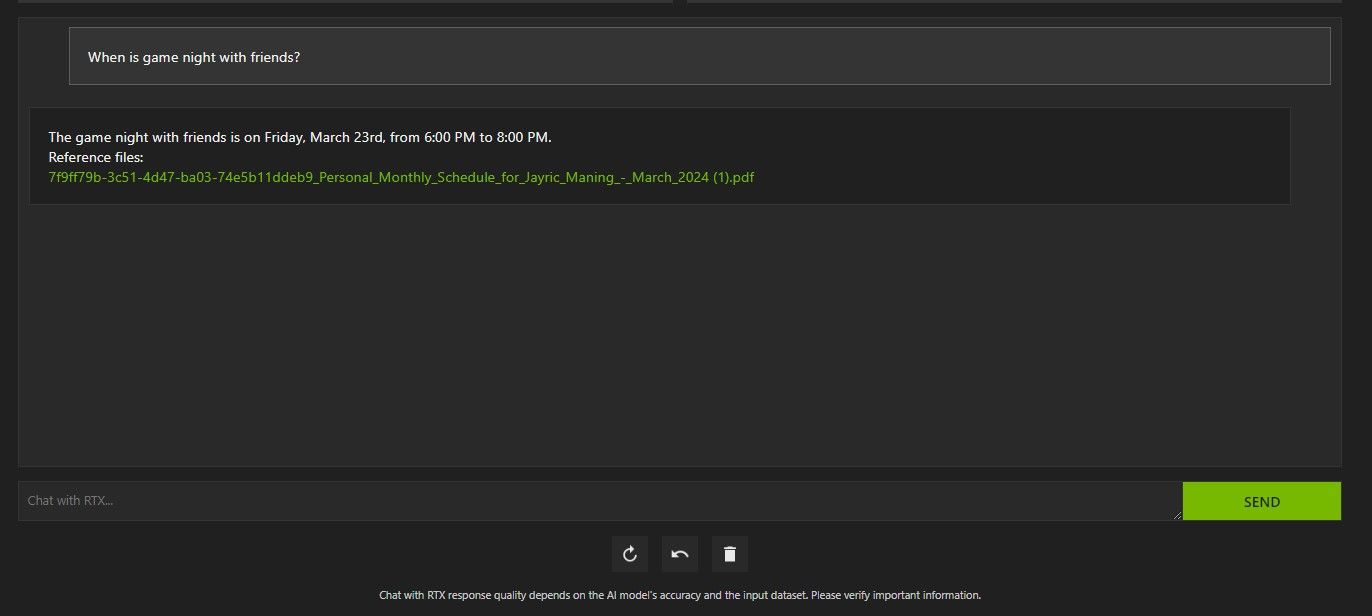

Mais comme Chat with RTX est capable de RAG, vous pouvez également l'utiliser comme assistant personnel d'IA.

Ci-dessus, j'ai utilisé Chat avec RTX pour me renseigner sur mon emploi du temps. Les données provenaient d'un fichier PDF contenant mon emploi du temps, mon calendrier, mes événements, mon travail, etc. Dans ce cas, Chat with RTX a extrait les données de calendrier correctes des données ; vous devrez garder vos fichiers de données et vos dates de calendrier à jour pour que des fonctionnalités comme celle-ci fonctionnent correctement jusqu'à ce qu'il y ait des intégrations avec d'autres applications.

Il existe de nombreuses façons d'utiliser le chat avec le RAG de RTX à votre avantage. Par exemple, vous pouvez l'utiliser pour lire des documents juridiques et en faire un résumé, générer du code pertinent pour le programme que vous développez, obtenir des points forts d'une vidéo que vous êtes trop occupé pour regarder, et bien plus encore !

Étape 4 : Fonctionnalité bonus

En plus de votre dossier de données local, vous pouvez utiliser Chat avec RTX pour analyser les vidéos YouTube. Pour ce faire, sous Ensemble de données, remplacez le chemin du dossier par l'URL YouTube.

Copiez l'URL YouTube que vous souhaitez analyser et collez-la sous le menu déroulant. Alors demandez !

Le chat avec l'analyse vidéo YouTube de RTX était plutôt bon et fournissait des informations précises, il pourrait donc être utile pour la recherche, l'analyse rapide, et plus encore.

Le chat de Nvidia avec RTX est-il bon ?

ChatGPT fournit la fonctionnalité RAG. Certains chatbots IA locaux ont une configuration système nettement inférieure. Alors, Nvidia Chat avec RTX vaut-il la peine d’être utilisé ?

La réponse est oui ! Le chat avec RTX vaut la peine d'être utilisé malgré la concurrence.

L'un des principaux arguments de vente de l'utilisation de Nvidia Chat avec RTX est sa capacité à utiliser RAG sans envoyer vos fichiers à un serveur tiers. La personnalisation des GPT via des services en ligne peut exposer vos données. Mais comme Chat with RTX s'exécute localement et sans connexion Internet, l'utilisation de RAG sur Chat with RTX garantit que vos données sensibles sont en sécurité et accessibles uniquement sur votre PC.

Comme pour les autres chatbots IA exécutés localement exécutant Mistral 7B, Chat with RTX fonctionne mieux et plus rapidement. Bien qu'une grande partie de l'amélioration des performances provienne de l'utilisation de GPU haut de gamme, l'utilisation de l'accélération Nvidia TensorRT-LLM et RTX a rendu l'exécution de Mistral 7B plus rapide sur Chat avec RTX par rapport à d'autres méthodes d'exécution d'un LLM optimisé pour le chat.

Il est à noter que la version Chat avec RTX que nous utilisons actuellement est une démo. Les versions ultérieures de Chat with RTX seront probablement plus optimisées et offriront des améliorations de performances.

Et si je n'ai pas de GPU RTX série 30 ou 40 ?

Discuter avec RTX est un moyen simple, rapide et sécurisé d'exécuter un LLM localement sans avoir besoin d'une connexion Internet. Si vous souhaitez également exécuter un LLM ou local mais que vous ne possédez pas de GPU RTX séries 30 ou 40, vous pouvez essayer d'autres façons d'exécuter un LLM localement. Deux des plus populaires seraient GPT4ALL et Text Gen WebUI. Essayez GPT4ALL si vous souhaitez une expérience plug-and-play exécutant localement un LLM. Mais si vous êtes un peu plus enclin à la technique, l'exécution de LLM via Text Gen WebUI offrira un meilleur réglage et une meilleure flexibilité.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1667

1667

14

14

1426

1426

52

52

1328

1328

25

25

1273

1273

29

29

1255

1255

24

24

10 extensions de codage générateur AI dans le code vs que vous devez explorer

Apr 13, 2025 am 01:14 AM

10 extensions de codage générateur AI dans le code vs que vous devez explorer

Apr 13, 2025 am 01:14 AM

Hé là, codant ninja! Quelles tâches liées au codage avez-vous prévues pour la journée? Avant de plonger plus loin dans ce blog, je veux que vous réfléchissiez à tous vos malheurs liés au codage - les énumérez. Fait? - Let & # 8217

GPT-4O VS OpenAI O1: Le nouveau modèle Openai vaut-il le battage médiatique?

Apr 13, 2025 am 10:18 AM

GPT-4O VS OpenAI O1: Le nouveau modèle Openai vaut-il le battage médiatique?

Apr 13, 2025 am 10:18 AM

Introduction Openai a publié son nouveau modèle basé sur l'architecture «aux fraises» très attendue. Ce modèle innovant, connu sous le nom d'O1, améliore les capacités de raisonnement, lui permettant de réfléchir à des problèmes Mor

PIXTRAL-12B: Mistral AI & # 039; s Modèle multimodal - Analytics Vidhya

Apr 13, 2025 am 11:20 AM

PIXTRAL-12B: Mistral AI & # 039; s Modèle multimodal - Analytics Vidhya

Apr 13, 2025 am 11:20 AM

Introduction Mistral a publié son tout premier modèle multimodal, à savoir le pixtral-12b-2409. Ce modèle est construit sur les 12 milliards de paramètres de Mistral, Nemo 12b. Qu'est-ce qui distingue ce modèle? Il peut maintenant prendre les deux images et Tex

Comment ajouter une colonne dans SQL? - Analytique Vidhya

Apr 17, 2025 am 11:43 AM

Comment ajouter une colonne dans SQL? - Analytique Vidhya

Apr 17, 2025 am 11:43 AM

Instruction ALTER TABLE de SQL: Ajout de colonnes dynamiquement à votre base de données Dans la gestion des données, l'adaptabilité de SQL est cruciale. Besoin d'ajuster votre structure de base de données à la volée? L'énoncé de la table alter est votre solution. Ce guide détaille l'ajout de Colu

Comment construire des agents d'IA multimodaux à l'aide d'AGNO Framework?

Apr 23, 2025 am 11:30 AM

Comment construire des agents d'IA multimodaux à l'aide d'AGNO Framework?

Apr 23, 2025 am 11:30 AM

Tout en travaillant sur une IA agentique, les développeurs se retrouvent souvent à naviguer dans les compromis entre la vitesse, la flexibilité et l'efficacité des ressources. J'ai exploré le cadre de l'IA agentique et je suis tombé sur Agno (plus tôt c'était Phi-

Au-delà du drame de lama: 4 nouvelles références pour les modèles de grande langue

Apr 14, 2025 am 11:09 AM

Au-delà du drame de lama: 4 nouvelles références pour les modèles de grande langue

Apr 14, 2025 am 11:09 AM

Benchmarks en difficulté: une étude de cas de lama Début avril 2025, Meta a dévoilé sa suite de modèles Llama 4, avec des métriques de performance impressionnantes qui les ont placés favorablement contre des concurrents comme GPT-4O et Claude 3.5 Sonnet. Au centre du launc

Openai change de mise au point avec GPT-4.1, priorise le codage et la rentabilité

Apr 16, 2025 am 11:37 AM

Openai change de mise au point avec GPT-4.1, priorise le codage et la rentabilité

Apr 16, 2025 am 11:37 AM

La version comprend trois modèles distincts, GPT-4.1, GPT-4.1 Mini et GPT-4.1 Nano, signalant une évolution vers des optimisations spécifiques à la tâche dans le paysage du modèle grand langage. Ces modèles ne remplacent pas immédiatement les interfaces orientées utilisateur comme

Comment les jeux de TDAH, les outils de santé et les chatbots d'IA transforment la santé mondiale

Apr 14, 2025 am 11:27 AM

Comment les jeux de TDAH, les outils de santé et les chatbots d'IA transforment la santé mondiale

Apr 14, 2025 am 11:27 AM

Un jeu vidéo peut-il faciliter l'anxiété, se concentrer ou soutenir un enfant atteint de TDAH? Au fur et à mesure que les défis de la santé augmentent à l'échelle mondiale - en particulier chez les jeunes - les innovateurs se tournent vers un outil improbable: les jeux vidéo. Maintenant l'un des plus grands divertissements du monde Indus